1、首先要找到wordcount的源代码,在http://svn.apache.org/repos/asf/hadoop/中,用svn客户端check out下来,找到svn.apache.org_repos_asf\hadoop\hadoop-mapreduce-project\hadoop-mapreduce-examples\src\main\java\org\apache\hadoop\examples\WordCount.java

2、创建文件夹并且把wordcount文件拷出来:

mkdir playground

mkdir playground/src

mkdir playground/classes

cp src/examples/org/apache/hadoop/examples/WordCount.java playground/src/WordCount.java

3、在hadoop框架中编译和执行这个副本

javac -classpath hadoop-core-1.0.1.jar:lib/commons-cli-1.2.jar -d playground/classes/ playground/src/WordCount.java

jar -cvf playground/wordcount.jar -C playground/classes/ .

- 标明清单(manifest)

- 增加:org/(读入= 0) (写出= 0)(存储了 0%)

- 增加:org/apache/(读入= 0) (写出= 0)(存储了 0%)

- 增加:org/apache/hadoop/(读入= 0) (写出= 0)(存储了 0%)

- 增加:org/apache/hadoop/examples/(读入= 0) (写出= 0)(存储了 0%)

- 增加:org/apache/hadoop/examples/WordCount.class(读入= 1911) (写出= 996)(压缩了 47%)

- 增加:org/apache/hadoop/examples/WordCount$IntSumReducer.class(读入= 1789) (写出= 746)(压缩了 58%)

- 增加:org/apache/hadoop/examples/WordCount$TokenizerMapper.class(读入= 1903) (写出= 819)(压缩了 56%)

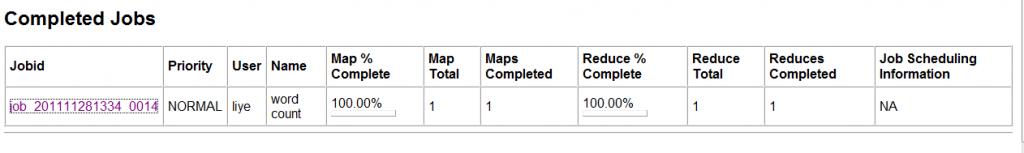

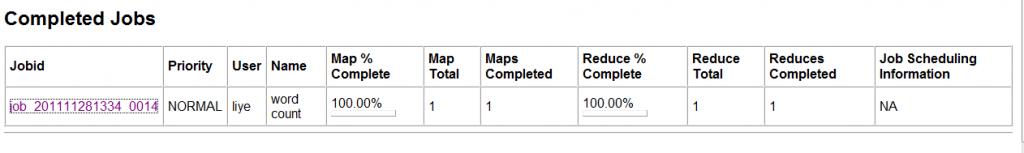

4、运行你的程序,出现如下信息说明执行成功:

$ bin/hadoop jar playground/wordcount.jar org.apache.hadoop.examples.WordCount input my_output

- 11/12/05 21:33:30 INFO input.FileInputFormat: Total input paths to process : 1

- 11/12/05 21:33:31 INFO mapred.JobClient: Running job: job_201111281334_0014

- 11/12/05 21:33:32 INFO mapred.JobClient: map 0% reduce 0%

- 11/12/05 21:33:41 INFO mapred.JobClient: map 100% reduce 0%

- 11/12/05 21:33:53 INFO mapred.JobClient: map 100% reduce 100%

- 11/12/05 21:33:55 INFO mapred.JobClient: Job complete: job_201111281334_0014

- 11/12/05 21:33:55 INFO mapred.JobClient: Counters: 17

- 11/12/05 21:33:55 INFO mapred.JobClient: Job Counters

- 11/12/05 21:33:55 INFO mapred.JobClient: Launched reduce tasks=1

- 11/12/05 21:33:55 INFO mapred.JobClient: Launched map tasks=1

- 11/12/05 21:33:55 INFO mapred.JobClient: Data-local map tasks=1

- 11/12/05 21:33:55 INFO mapred.JobClient: FileSystemCounters

- 11/12/05 21:33:55 INFO mapred.JobClient: FILE_BYTES_READ=25190

- 11/12/05 21:33:55 INFO mapred.JobClient: HDFS_BYTES_READ=44253

- 11/12/05 21:33:55 INFO mapred.JobClient: FILE_BYTES_WRITTEN=50412

- 11/12/05 21:33:55 INFO mapred.JobClient: HDFS_BYTES_WRITTEN=17876

- 11/12/05 21:33:55 INFO mapred.JobClient: Map-Reduce Framework

- 11/12/05 21:33:55 INFO mapred.JobClient: Reduce input groups=1857

- 11/12/05 21:33:55 INFO mapred.JobClient: Combine output records=1857

- 11/12/05 21:33:55 INFO mapred.JobClient: Map input records=734

- 11/12/05 21:33:55 INFO mapred.JobClient: Reduce shuffle bytes=25190

- 11/12/05 21:33:55 INFO mapred.JobClient: Reduce output records=1857

- 11/12/05 21:33:55 INFO mapred.JobClient: Spilled Records=3714

- 11/12/05 21:33:55 INFO mapred.JobClient: Map output bytes=73129

- 11/12/05 21:33:55 INFO mapred.JobClient: Combine input records=7696

- 11/12/05 21:33:55 INFO mapred.JobClient: Map output records=7696

- 11/12/05 21:33:55 INFO mapred.JobClient: Reduce input records=1857

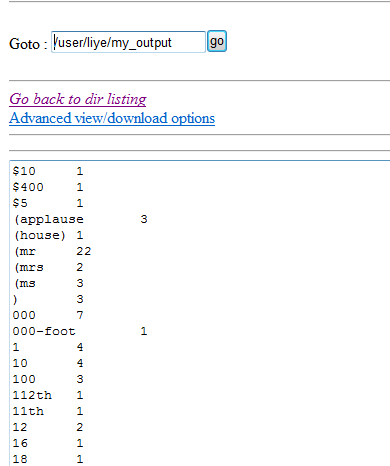

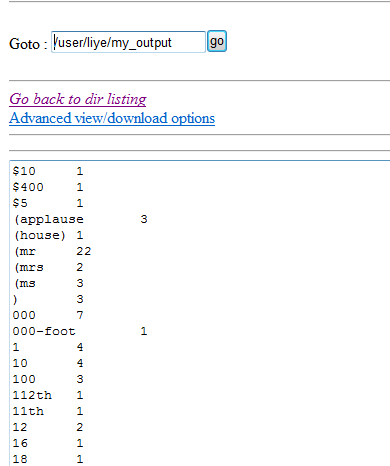

5、查看结果,在文件系统的my_output中

分享到:

相关推荐

### Hadoop运行WordCount实例详解 #### 一、Hadoop简介与WordCount程序的重要性 Hadoop 是一个由Apache基金会所开发的分布式系统基础架构。它能够处理非常庞大的数据集,并且能够在集群上运行,通过将大数据分割...

3. **运行WordCount程序**:调用Hadoop自带的Java程序`hadoop-mapreduce-examples-2.7.7.jar`,指定输入和输出参数。 ### 四、实验结果 成功运行WordCount后,可以在指定的输出文件夹(例如/output)中看到统计...

- 上述命令中,`hadoop-0.20.2-examples.jar`是Hadoop自带的例子程序集合,包含了WordCount等示例程序。 - `wordcount`表示执行WordCount任务。 - `input`和`output`分别代表输入文件夹和输出文件夹路径。 #### ...

在实际环境中,我们需要配置 Hadoop 集群,设置输入文件路径,编译并打包 WordCount 程序,最后通过 Hadoop 的 `hadoop jar` 命令提交作业到集群运行。调试时,可以查看日志输出,检查错误信息,优化性能。 通过...

本项目将详细介绍如何在Hadoop环境中成功运行WordCount程序,以及涉及到的相关知识点。 首先,`Hadoop`是一个基于Java的框架,设计用来处理和存储大规模数据。它采用了分布式计算模型,即MapReduce,将大型任务分解...

"Hadoop 1.2.1 版本下修改 WordCount 程序并编译" Hadoop 是一种基于分布式处理的大数据处理框架,其中 WordCount 程序是一个经典的示例程序,用于统计文本文件中的词频信息。在 Hadoop 1.2.1 版本下,我们可以修改...

运行WordCount程序时,Hadoop会自动将数据分发到集群的各个节点上,每个节点上的TaskTracker会执行对应的Map任务。当Map任务完成,中间结果会被排序和分区,然后传递给Reduce任务。Reduce任务最终将结果写回到HDFS,...

在linux环境下部署的Hadoop集群-WordCount运行详解。

hadoop入门例子wordcount

Hadoop开发WordCount源码程序详细讲解,每一行都带注释说明。

这是一个wordcount的一个简单实例jar包,仅仅用来做测试。...map类:org.apache.hadoop.wordcount.WordCountMapReduce$WordCountMapper reduce类 org.apache.hadoop.wordcount.WordCountMapReduce$WordCountReducer

hadoop-wordcount测试程序,jar包,单词统计的不二之选

在"wordcount"例子中,mapper接收文本行,对每一行进行分词,生成键值对(单词作为key,出现次数1作为value)。 接着是Reduce阶段,Hadoop将相同的key分组并将对应的values(出现次数)相加,从而得到每个单词的...

1.2.2运行例子步骤是在集群上运行WordCount程序,以input目录作为输入,output目录作为输出。1.2.3查看结果则是在MapReduce作业完成后,到指定的output目录下检查输出结果,通常输出结果以part-r-00000的形式存储。 ...

在标题中的"WordCount2_hadoopwordcount_"可能指的是Hadoop WordCount的第二个版本,通常是在Hadoop 2.x环境下运行。这个程序的核心任务是对输入文本进行分词,统计每个单词出现的次数,并将结果输出。在这个过程中...

例如,你可以尝试编译和运行位于`src/examples`目录下的WordCount程序,这是一个经典的Hadoop示例,用于统计文本文件中的单词出现次数。在Eclipse中,右键点击WordCount.java文件,选择“Run As” -> “Java ...

### Hadoop WordCount项目打包与部署详解 #### 一、Hadoop WordCount...通过以上步骤,可以成功地在Hadoop环境下部署并运行WordCount程序。这不仅是一个基础的数据处理练习,也是深入了解Hadoop生态系统的重要一步。

### Hadoop-1.2.1 运行WordCount实例详解 #### 一、环境准备与搭建 在开始运行WordCount实例之前,首先确保已经按照之前的步骤完成了Hadoop-1.2.1环境的搭建。这包括但不限于安装JDK、配置Hadoop环境变量以及设置...

<artifactId>wordcount <version>0.0.1-SNAPSHOT <packaging>jar <name>wordcount <url>http://maven.apache.org</url> <project.build.sourceEncoding>UTF-8 <groupId>org.apache.hadoop ...

在Map阶段,Hadoop将大文件分割成多个小块(Block),并分别在集群的不同节点上运行Map任务。对于WordCount,每个Map任务读取输入数据,通常是文本文件的一行。然后,它将每一行拆分为单词(以空格、标点符号等为...