ńö▒õ║Änamenode µś»HDFSńÜäÕż¦Ķäæ’╝īĶĆīĶ┐ÖõĖ¬Õż¦ĶäæÕÅłµś»ÕŹĢńé╣’╝īÕ”éµ×£Õż¦ĶäæÕć║ńÄ░µĢģķÜ£’╝īÕłÖµĢ┤õĖ¬ÕłåÕĖāÕ╝ÅÕŁśÕé©ń│╗ń╗¤Õ░▒ńś½ńŚ¬õ║åŃĆéHA’╝łHigh Available’╝ēµ£║ÕłČÕ░▒µś»ńö©µØźĶ¦ŻÕå│Ķ┐ÖµĀĘõĖĆõĖ¬ķŚ«ķóśńÜäŃĆéńó░Õł░Ķ┐Öõ╣łõĖ¬ķŚ«ķóś’╝īķ”¢Õģłµ£¼ĶāĮńÜäµā│Õł░ńÜäÕ░▒µś»ÕåŚõĮÖÕżćõ╗Į’╝īµłæõ╗¼õ╗ŖÕż®Ķ”üĶ«©Ķ«║ńÜ䵜»avatarnodeŃĆé

┬Ā

õĖĆŃĆüķŚ«ķóśµÅÅĶ┐░

ńö▒õ║Änamenode µś»HDFSńÜäÕż¦Ķäæ’╝īĶĆīĶ┐ÖõĖ¬Õż¦ĶäæÕÅłµś»ÕŹĢńé╣’╝īÕ”éµ×£Õż¦ĶäæÕć║ńÄ░µĢģķÜ£’╝īÕłÖµĢ┤õĖ¬ÕłåÕĖāÕ╝ÅÕŁśÕé©ń│╗ń╗¤Õ░▒ńś½ńŚ¬õ║åŃĆéHA’╝łHigh Available’╝ēµ£║ÕłČÕ░▒µś»ńö©µØźĶ¦ŻÕå│Ķ┐ÖµĀĘõĖĆõĖ¬ķŚ«ķóśńÜäŃĆéńó░Õł░Ķ┐Öõ╣łõĖ¬ķŚ«ķóś’╝īķ”¢Õģłµ£¼ĶāĮńÜäµā│Õł░ńÜäÕ░▒µś»ÕåŚõĮÖÕżćõ╗Į’╝īÕżćõ╗ĮńÜäµ¢╣Õ╝ŵ£ēÕŠłÕżÜń¦Ź’╝īÕēŹĶŠłõ╗¼Ķ«ŠĶ«ĪńÜäµ£ēÕģāµĢ░µŹ«Õżćõ╗Įµ¢╣µĪł’╝īsecondary namenodeõ╗źÕÅŖavatarnodeńŁēµ¢╣µĪłŃĆéĶĆīĶ┐Öõ║øµ¢╣µĪłõĖŁµ£Ćµ£ēõ╝śÕŖ┐ńÜäĶć¬ńäȵś»ĶāĮÕż¤Ķ«®HDFSõ╗źµ£Ćń¤ŁńÜ䵌ČķŚ┤Õ«īµłÉµĢģķÜ£ÕłćµŹóńÜäµ¢╣µĪłŃĆéõ╣¤Õ░▒µś»µłæõ╗¼õ╗ŖÕż®Ķ”üĶ«©Ķ«║ńÜäavatarnodeŃĆé

õ║īŃĆüÕ¤║µ£¼ń╗ōµ×ä

primary’╝ÜĶ┤¤Ķ┤ŻµŁŻÕĖĖõĖÜÕŖĪnamenode’╝īõ╣¤Õ░▒µś»õĖ║clientµÅÉõŠøÕģāµĢ░µŹ«µ¤źĶ»óÕÆīµōŹõĮ£ŃĆé

standby’╝ÜńāŁÕżćńÜänamenode’╝īÕ«īÕģ©Õżćõ╗ĮprimaryńÜäÕģāµĢ░µŹ«’╝īÕ╣ČÕ»╣primaryÕüÜcheckpoint’╝łõĖĆń¦ŹÕģāµĢ░µŹ«µīüõ╣ģÕī¢µ£║ÕłČ’╝īÕÉÄķØóõ╝Üõ╗ŗń╗ŹÕł░’╝ēŃĆé

NFS’╝ÜńĮæń╗£µ¢ćõ╗ȵ£ŹÕŖĪÕÖ©’╝īprimaryõ╝ÜÕ░åµŚźÕ┐ŚÕ«×µŚČÕÉīµŁźõĖĆõ╗ĮÕł░Ķ»źµ£ŹÕŖĪÕÖ©’╝īµØźõ┐ØĶ»üprimaryÕć║µĢģķÜ£µŚČÕżćõ╗ĮÕģāµĢ░µŹ«ńÜäÕ«īµĢ┤µĆ¦ŃĆé

õĖēŃĆüµĢ░µŹ«µīüõ╣ģÕī¢µ£║ÕłČŌĆöŌĆöcheckpoint

primaryń«ĪńÉåńØƵēƵ£ēńÜäÕģāµĢ░µŹ«’╝īķĆÜÕĖĖÕģāµĢ░µŹ«ķāĮõ┐ØÕŁśÕ£©ÕåģÕŁśķćī’╝īĶ┐ÖµĀĘÕ»╣ÕģāµĢ░µŹ«ńÜäĶ«┐ķŚ«ĶāĮÕż¤ķ½śµĢłŃĆéõĮåµś»µ£ēõĖ¬ķÜɵ鯒╝īÕ░▒µś»Õ”éµ×£primaryĶŖéńé╣Õ«Ģµ£║õ║å’╝īµł¢ĶĆģµÄēńöĄõ║å’╝īķéŻõ╣łµēƵ£ēńÜäÕģāµĢ░µŹ«Õ░▒õĖĆÕÄ╗õĖŹÕżŹĶ┐öõ║åŃĆéÕ”éµ×£µłæõ╗¼ĶāĮÕż¤µŖŖÕģāµĢ░µŹ«Õ£©ÕåģÕŁśķćīõ┐ØÕŁśõĖĆõ╗Į’╝īÕÉīµŚČÕ£©ńĪ¼ńøśõĖŖõ╣¤õ┐ØÕŁśõĖĆõ╗Į’╝īķéŻõ╣łÕŹ│õĮ┐µÄēńöĄõ╣¤ĶāĮÕ░åµĢ░µŹ«ÕåŹµüóÕżŹĶ┐ćµØźŃĆé

checkpointµ£║ÕłČÕ░▒µś»Õ░åÕģāµĢ░µŹ«Õ«×µŚČÕ£©ńĪ¼ńøśõĖŖõ┐ØÕŁśõĖĆõ╗ĮńÜäµ£║ÕłČŃĆé

ķ”¢Õģłõ╗ŗń╗ŹÕćĀõĖ¬Õģ│ķö«µ”éÕ┐Ą’╝Ü

edits’╝ܵŚźÕ┐Śµ¢ćõ╗Č’╝īĶ«░ÕĮĢÕ╝ĢÕÅæÕģāµĢ░µŹ«µö╣ÕÅśńÜäµōŹõĮ£ŃĆé

fsimage’╝ÜÕģāµĢ░µŹ«ńÜäķĢ£Õāŵ¢ćõ╗Č’╝īÕÅ»õ╗źńÉåĶ¦ŻõĖ║ÕģāµĢ░µŹ«õ┐ØÕŁśÕ£©ńŻüńøśõĖŖńÜäõĖĆõĖ¬Õē»µ£¼ŃĆé

ķŚ«ķóś1’╝Üfsimageõ╗ŻĶĪ©ńÜ䵜»µ¤ÉõĖƵŚČÕł╗ńÜäÕģāµĢ░µŹ«ķĢ£ÕāÅ’╝īÕģāµĢ░µŹ«Õ£©õĖŹµ¢Łµö╣ÕÅś’╝īķéŻõ╣łĶ┐ÖõĖ¬ķĢ£Õāŵś»Õ”éõĮĢÕ«×µŚČµø┤µ¢░ńÜäÕæó’╝¤

ķŚ«ķóś2’╝ÜÕ”éõĮĢÕ£©õ┐ØĶ»üprimary namenodeµŁŻÕĖĖÕ»╣Õż¢µ£ŹÕŖĪńÜäµāģÕåĄõĖŗńö¤µłÉfsimage’╝¤

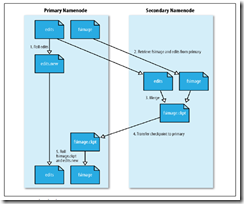

checkpointµŁźķ¬żÕ”éõĖŗ’╝Ü

ń¼¼õĖƵŁź’╝Üsecondary namenodeĶ»Ęµ▒énamenodeÕü£µŁóõĮ┐ńö©edits’╝īµÜ鵌ČĶ«░ÕĮĢÕ£©edits.newµ¢ćõ╗ČõĖŁ

ń¼¼õ║īµŁź’╝Üsecondary namenodeõ╗ÄnamenodeÕżŹÕłČfsimageŃĆüeditsÕł░µ£¼Õ£░

ń¼¼õĖēµŁź’╝Üsecondary namenodeÕÉłÕ╣ČfsimageŃĆüeditsõĖ║fsimage.ckpt

ń¼¼ÕøøµŁź’╝Üsecondary namenodeÕÅæķĆüfsimage.ckptÕł░namenode

ń¼¼õ║öµŁź’╝Ünamenodeńö©µ¢░ńÜäfsimageĶ”åńø¢µŚ¦ńÜäfsimage’╝īńö©µ¢░ńÜäeditsĶ”åńø¢µŚ¦ńÜäedits

ń¼¼ÕģŁµŁź’╝ܵø┤µ¢░checkpointµŚČķŚ┤

Õł░Ķ┐Öķćīfsimageµø┤µ¢░Õ«īµ»Ģ’╝īÕŹ│õ┐ØĶ»üõ║åprimaryµŁŻÕĖĖµ£ŹÕŖĪ’╝īõ╣¤Õ«īµłÉõ║åfsimageńÜäµø┤µ¢░

ÕøøŃĆüavatarnodeÕģāµĢ░µŹ«ńÜäõĖĆĶć┤µĆ¦

checkpointÕŬµś»õ┐ØĶ»üõ║åÕģāµĢ░µŹ«ńÜäµīüõ╣ģÕī¢’╝īõĮåµś»Õ”éµ×£primaryÕć║ńÄ░µĢģķÜ£’╝īõ┐«ÕżŹÕÉÄĶ┐śµś»Ķ”üĶŖ▒Õż¦ķćÅńÜ䵌ČķŚ┤µØźÕŖĀĶĮĮfsimage’╝īÕ”éõĮĢĶ«®standbyÕ£©ÕåģÕŁśõĖŁÕ░▒ÕÆīprimaryõ┐صīüÕģāµĢ░µŹ«ÕÉīµŁź’╝īÕ░▒µś»õĖĆõĖ¬ķ½śÕÅ»ńö©ńÜäHDFSķ£ĆĶ”üĶ¦ŻÕå│ńÜäķŚ«ķóśŃĆé

namenodeńÜäÕģāµĢ░µŹ«ÕģČÕ«×Õīģµŗ¼õĖżõĖ¬ķā©Õłå’╝Ü

ń¼¼õĖĆķā©Õłå’╝Üńø«ÕĮĢµĀæ’╝īńø«ÕĮĢµĀæń«ĪńÉåńØĆHDFSõĖŁÕŁśÕé©ńÜäµēƵ£ēńÜäµ¢ćõ╗Čõ┐Īµü»ŃĆé

ń¼¼õ║īķā©Õłå’╝ÜÕØŚµĢ░µŹ«ÕÆīdatanodeńÜäÕ»╣Õ║öÕģ│ń│╗

ÕŬĶ”üĶāĮÕż¤õ┐ØĶ»üõ╗źõĖŖõĖżķā©ÕłåńÜäµĢ░µŹ«õĖĆĶć┤õ║å’╝īķéŻõ╣łÕģāµĢ░µŹ«ńÜäõĖĆĶć┤µĆ¦ķŚ«ķóśÕ░▒Ķ¦ŻÕå│õ║åŃĆé

ń¼¼õĖĆķā©Õłå’╝ÜprimaryÕ░åµŚźÕ┐ŚÕ«×µŚČÕÉīµŁźÕł░NFSõĖŖ’╝īĶĆīstandbyÕÅ»õ╗źÕ«×µŚČĶ»╗ÕÅ¢NFSõĖŖńÜ䵌źÕ┐Ś’╝īķĆÜĶ┐浌źÕ┐ŚÕø×µöŠ’╝īÕÅ»õ╗źĶ¦ŻÕå│ńø«ÕĮĢµĀæõ┐Īµü»õĖĆĶć┤ńÜäķŚ«ķóśŃĆé

ń¼¼õ║īķā©Õłå’╝ÜÕ┐½µĢ░µŹ«ÕÆīdatanodeńÜäÕ»╣Õ║öÕģ│ń│╗’╝īµś»µēƵ£ēdatanodeµā│namenodeµ▒ćµŖźµĆ╗ń╗ōÕć║µØźńÜä’╝īķéŻõ╣łĶ«®µēƵ£ēńÜädatanodeÕÉæõĖżõĖ¬namenodeµ▒ćµŖź’╝īÕ░▒ÕÅ»õ╗źĶ¦ŻÕå│ÕØŚµĢ░µŹ«ÕÆīdatanodeńÜäÕ»╣Õ║öÕģ│ń│╗õĖĆĶć┤µĆ¦ķŚ«ķóśŃĆé

ķŚ«ķóś’╝ܵ¢░Õ╝ĢÕģźńÜäNFSõ╝ÜÕĖ”µØźµ¢░ńÜäÕŹĢńé╣ķŚ«ķóśŃĆ鵏«facebookÕĘźń©ŗÕĖłń╗¤Ķ«Ī’╝īĶ┐ÖõĖ¬ÕŹĢńé╣µĢģķÜ£ńÄćķØ×ÕĖĖõ╣ŗõĮÄ’╝īõ╗¢õ╗¼Õ£©ÕøøÕ╣┤õĖŁõ╣ŗńó░Õł░õĖƵ¼ĪŃĆé

Õł░Ķ┐ÖķćīavatarnodeÕĤńÉåÕ¤║µ£¼Ķ«▓Õ«ī’╝īõĮåµś»Õ«×ķÖģÕ║öńö©õĖŁĶ┐śÕŁśÕ£©ÕćĀõĖ¬ķŚ«ķóś’╝Ü

1ŃĆüHDFSµś»Õ”éõĮĢÕ┐½ķƤµŻĆµĄŗÕł░primaryÕć║ńÄ░µĢģķÜ£ńÜä’╝¤

2ŃĆüstandbyµś»Õ”éõĮĢĶ┐ģķƤõ╗ÄÕżćńö©µ£║ÕłćµŹóÕł░primaryńÜä’╝¤

ŃĆÉĶ┤Żõ╗╗ń╝¢ĶŠæ’╝Üblack.dot┬ĀTEL’╝Ü’╝ł010’╝ē68476606ŃĆæ

ńøĖÕģ│µÄ©ĶŹÉ

ĶĄĀķĆüjarÕīģ’╝Ühadoop-hdfs-client-2.9.1.jar ĶĄĀķĆüÕĤAPIµ¢ćµĪŻ’╝Ühadoop-hdfs-client-2.9.1-javadoc.jar ĶĄĀķĆüµ║Éõ╗ŻńĀü’╝Ühadoop-hdfs-client-2.9.1-sources.jar ÕīģÕɽń┐╗Ķ»æÕÉÄńÜäAPIµ¢ćµĪŻ’╝Ühadoop-hdfs-client-2.9.1-javadoc-...

ĶĄĀķĆüjarÕīģ’╝Ühadoop-hdfs-2.7.3.jar’╝ø ĶĄĀķĆüÕĤAPIµ¢ćµĪŻ’╝Ühadoop-hdfs-2.7.3-javadoc.jar’╝ø ĶĄĀķĆüµ║Éõ╗ŻńĀü’╝Ühadoop-hdfs-2.7.3-sources.jar’╝ø ĶĄĀķĆüMavenõŠØĶĄ¢õ┐Īµü»µ¢ćõ╗Č’╝Ühadoop-hdfs-2.7.3.pom’╝ø ÕīģÕɽń┐╗Ķ»æÕÉÄńÜäAPIµ¢ćµĪŻ’╝Ühadoop...

ĶĄĀķĆüjarÕīģ’╝Ühadoop-hdfs-2.9.1.jar ĶĄĀķĆüÕĤAPIµ¢ćµĪŻ’╝Ühadoop-hdfs-2.9.1-javadoc.jar ĶĄĀķĆüµ║Éõ╗ŻńĀü’╝Ühadoop-hdfs-2.9.1-sources.jar ÕīģÕɽń┐╗Ķ»æÕÉÄńÜäAPIµ¢ćµĪŻ’╝Ühadoop-hdfs-2.9.1-javadoc-APIµ¢ćµĪŻ-õĖŁµ¢ć(ń«ĆõĮō)ńēł.zip Õ»╣Õ║ö...

ĶĄĀķĆüjarÕīģ’╝Ühadoop-hdfs-client-2.9.1.jar’╝ø ĶĄĀķĆüÕĤAPIµ¢ćµĪŻ’╝Ühadoop-hdfs-client-2.9.1-javadoc.jar’╝ø ĶĄĀķĆüµ║Éõ╗ŻńĀü’╝Ühadoop-hdfs-client-2.9.1-sources.jar’╝ø ĶĄĀķĆüMavenõŠØĶĄ¢õ┐Īµü»µ¢ćõ╗Č’╝Ühadoop-hdfs-client-2.9.1.pom’╝ø...

Õ£©Õż¦µĢ░µŹ«µŖƵ£»ķóåÕ¤¤’╝īHadoop ÕłåÕĖāÕ╝ŵ¢ćõ╗Čń│╗ń╗¤’╝łHDFS’╝ēµś»µĀĖÕ┐āń╗äõ╗Čõ╣ŗõĖĆ’╝īÕ«āõĖ║Õż¦Ķ¦äµ©ĪµĢ░µŹ«ÕŁśÕ驵ÅÉõŠøõ║åÕÅ»µē®Õ▒ĢÕÆīķ½śÕ«╣ķöֵƦńÜäĶ¦ŻÕå│µ¢╣µĪłŃĆéµ£¼Õ«×ķ¬īµŖźÕæŖõĖ╗Ķ”üÕģ│µ│©HDFSńÜäÕĖĖńö©µōŹõĮ£ÕæĮõ╗ż’╝īĶ┐Öõ║øÕæĮõ╗żµś»ń«ĪńÉåÕæśÕÆīµĢ░µŹ«Õłåµ×ÉÕĖłµŚźÕĖĖÕĘźõĮ£õĖŁõĖŹÕÅ»µł¢ń╝║...

Õ£©Ranger 2.0.0-SNAPSHOTńēłµ£¼õĖŁ’╝īÕīģÕɽõ║åÕ»╣HadoopÕłåÕĖāÕ╝ŵ¢ćõ╗Čń│╗ń╗¤’╝łHDFS’╝ēńÜäµÅÆõ╗ȵö»µīü’╝īĶ┐ÖõĖ¬ÕÉŹõĖ║ŌĆ£ranger-2.0.0-SNAPSHOT-hdfs-pluginŌĆØńÜäÕÄŗń╝®ÕīģµŁŻµś»ńö©õ║ÄÕ«×ńÄ░Ķ┐ÖõĖĆÕŖ¤ĶāĮńÜäµĀĖÕ┐āń╗äõ╗ČŃĆé õĖĆŃĆüRangerµ”éĶ┐░ RangerµÅÉõŠøõ║åõĖĆń¦Ź...

ĶĄĀķĆüjarÕīģ’╝Ühadoop-hdfs-2.7.3.jar’╝ø ĶĄĀķĆüÕĤAPIµ¢ćµĪŻ’╝Ühadoop-hdfs-2.7.3-javadoc.jar’╝ø ĶĄĀķĆüµ║Éõ╗ŻńĀü’╝Ühadoop-hdfs-2.7.3-sources.jar’╝ø ĶĄĀķĆüMavenõŠØĶĄ¢õ┐Īµü»µ¢ćõ╗Č’╝Ühadoop-hdfs-2.7.3.pom’╝ø ÕīģÕɽń┐╗Ķ»æÕÉÄńÜäAPIµ¢ćµĪŻ’╝Ühadoop...

ĶĄĀķĆüjarÕīģ’╝Ühadoop-hdfs-2.6.5.jar’╝ø ĶĄĀķĆüÕĤAPIµ¢ćµĪŻ’╝Ühadoop-hdfs-2.6.5-javadoc.jar’╝ø ĶĄĀķĆüµ║Éõ╗ŻńĀü’╝Ühadoop-hdfs-2.6.5-sources.jar’╝ø ĶĄĀķĆüMavenõŠØĶĄ¢õ┐Īµü»µ¢ćõ╗Č’╝Ühadoop-hdfs-2.6.5.pom’╝ø ÕīģÕɽń┐╗Ķ»æÕÉÄńÜäAPIµ¢ćµĪŻ’╝Ühadoop...

1. **ńÉåĶ¦ŻHDFSńÜäĶ¦ÆĶē▓**’╝ÜHDFSõĮ£õĖ║HadoopńÜäµĀĖÕ┐āń╗äõ╗Čõ╣ŗõĖĆ’╝īõĖ╗Ķ”üĶ┤¤Ķ┤ŻÕŁśÕ驵ĄĘķćŵĢ░µŹ«ŃĆéńÉåĶ¦ŻÕģČÕ£©Hadoopńö¤µĆüõĖŁńÜäõĮŹńĮ«Õ»╣õ║ĵÄīµÅĪµĢ┤õĖ¬Õż¦µĢ░µŹ«ÕżäńÉåµĄüń©ŗĶć│Õģ│ķćŹĶ”üŃĆé 2. **ńå¤ń╗āõĮ┐ńö©ShellÕæĮõ╗ż**’╝ÜķĆÜĶ┐ćõĖĆń│╗ÕłŚShellÕæĮõ╗żńÜäÕŁ”õ╣ĀõĖÄÕ«×ĶĘĄ’╝ī...

ĶĄĀķĆüjarÕīģ’╝Ühadoop-hdfs-2.5.1.jar’╝ø ĶĄĀķĆüÕĤAPIµ¢ćµĪŻ’╝Ühadoop-hdfs-2.5.1-javadoc.jar’╝ø ĶĄĀķĆüµ║Éõ╗ŻńĀü’╝Ühadoop-hdfs-2.5.1-sources.jar’╝ø ĶĄĀķĆüMavenõŠØĶĄ¢õ┐Īµü»µ¢ćõ╗Č’╝Ühadoop-hdfs-2.5.1.pom’╝ø ÕīģÕɽń┐╗Ķ»æÕÉÄńÜäAPIµ¢ćµĪŻ’╝Ühadoop...

ĶĄĀķĆüjarÕīģ’╝Ühadoop-hdfs-2.9.1.jar’╝ø ĶĄĀķĆüÕĤAPIµ¢ćµĪŻ’╝Ühadoop-hdfs-2.9.1-javadoc.jar’╝ø ĶĄĀķĆüµ║Éõ╗ŻńĀü’╝Ühadoop-hdfs-2.9.1-sources.jar’╝ø ĶĄĀķĆüMavenõŠØĶĄ¢õ┐Īµü»µ¢ćõ╗Č’╝Ühadoop-hdfs-2.9.1.pom’╝ø ÕīģÕɽń┐╗Ķ»æÕÉÄńÜäAPIµ¢ćµĪŻ’╝Ühadoop...

ĶĄĀķĆüjarÕīģ’╝Ühadoop-hdfs-2.5.1.jar’╝ø ĶĄĀķĆüÕĤAPIµ¢ćµĪŻ’╝Ühadoop-hdfs-2.5.1-javadoc.jar’╝ø ĶĄĀķĆüµ║Éõ╗ŻńĀü’╝Ühadoop-hdfs-2.5.1-sources.jar’╝ø ĶĄĀķĆüMavenõŠØĶĄ¢õ┐Īµü»µ¢ćõ╗Č’╝Ühadoop-hdfs-2.5.1.pom’╝ø ÕīģÕɽń┐╗Ķ»æÕÉÄńÜäAPIµ¢ćµĪŻ’╝Ühadoop...

ĶĄĀķĆüjarÕīģ’╝Ühadoop-hdfs-2.6.5.jar’╝ø ĶĄĀķĆüÕĤAPIµ¢ćµĪŻ’╝Ühadoop-hdfs-2.6.5-javadoc.jar’╝ø ĶĄĀķĆüµ║Éõ╗ŻńĀü’╝Ühadoop-hdfs-2.6.5-sources.jar’╝ø ĶĄĀķĆüMavenõŠØĶĄ¢õ┐Īµü»µ¢ćõ╗Č’╝Ühadoop-hdfs-2.6.5.pom’╝ø ÕīģÕɽń┐╗Ķ»æÕÉÄńÜäAPIµ¢ćµĪŻ’╝Ühadoop...

OBSA-HDFSµÅÆõ╗ȵś»Õģ│ķö«ń╗äõ╗Č’╝īÕ«āµÅÉõŠøõ║åõĖĆõĖ¬µÄźÕÅŻ’╝īõĮ┐ÕŠŚSparkŃĆüMapReduceŃĆüHiveÕÆīHBaseńŁēÕż¦µĢ░µŹ«Ķ«Īń«ŚÕĘźÕģĘĶāĮÕż¤õĖÄOBSÕ»╣Ķ▒ĪÕŁśÕ驵ŚĀń╝ØÕ»╣µÄź’╝īõ╗ÄĶĆīÕ«×ńÄ░µĢ░µŹ«µ╣¢ńÜäµ”éÕ┐Ą’╝īÕŹ│õ╗źõĮĵłÉµ£¼ŃĆüķ½śµē®Õ▒ĢµĆ¦ńÜäõ║æÕŁśÕé©õĮ£õĖ║Õż¦µĢ░µŹ«Õłåµ×ÉńÜäÕ¤║ńĪĆŃĆé...

Ķ¦ÆĶē▓ÕÅśķćÅhdfs_version - HDFS ńēłµ£¼hdfs_cloudera_distribution - Cloudera ÕÅæĶĪīńēł’╝łķ╗śĶ«ż’╝Ü cdh5.4 ’╝ē hdfs_conf_dir - HDFS ńÜäķģŹńĮ«ńø«ÕĮĢ’╝łķ╗śĶ«ż’╝Ü /etc/hadoop/conf ’╝ē hdfs_namenode - ńĪ«Õ«ÜĶŖéńé╣µś»ÕÉ”õĖ║ HDFS NameNode ...

Õ£© Doris õĖŁ’╝īHDFS Broker Ķ┤¤Ķ┤ŻĶ»╗ÕÅ¢ÕÆīÕåÖÕģźµĢ░µŹ«Õł░ HDFS’╝īµÅÉõŠøõ║åõĖĆń¦Źķ½śµĢłńÜäµĢ░µŹ«Õ»╝ÕģźÕÆīµ¤źĶ»óµ£║ÕłČŃĆé"hdfs_broker.zip" µ¢ćõ╗ȵś»ÕĘ▓ń╗ÅõĮ┐ńö© Java 8 ń╝¢Ķ»æÕźĮńÜä HDFS Broker’╝īÕÅ»õ╗źńø┤µÄźÕ£©ńøĖÕ║öńÜäńÄ»ÕóāõĖŁķā©ńĮ▓õĮ┐ńö©ŃĆé 1. **Apache ...

elasticsearch5.5.0Õżćõ╗ĮµüóÕżŹµÅÆõ╗Črepository-hdfs’╝īķ£ĆĶ”üńÜäÕÅ»õ╗źĶć¬ĶĪīõĖŗĶĮĮ’╝īõ╣¤ÕÅ»ÕÄ╗Õ«śńĮæõĖŗĶĮĮ https://artifacts.elastic.co/downloads/elasticsearch-plugins/repository-hdfs/repository-hdfs-5.5.0.zip

hadoop-hdfs-2.4.1.jar

* µĢ░µŹ«ÕżŹÕłČ’╝ÜõĖ║õ║åµÅÉķ½śµĢ░µŹ«ńÜäÕÅ»ķØĀµĆ¦’╝īHDFS õĮ┐ńö©µĢ░µŹ«ÕżŹÕłČµ£║ÕłČ’╝īõĖĆõĖ¬ÕØŚÕÅ»õ╗źĶó½ÕżŹÕłČÕł░ÕżÜõĖ¬ DataNode õĖŖŃĆé * µ¢ćõ╗Čń│╗ń╗¤’╝ÜHDFS µÅÉõŠøõ║åõĖĆõĖ¬µ¢ćõ╗Čń│╗ń╗¤µÄźÕÅŻ’╝īÕģüĶ«Ėńö©µłĘõĮ┐ńö©µĀćÕćåńÜäµ¢ćõ╗ȵōŹõĮ£µØźĶ«┐ķŚ« HDFS õĖŁńÜäµ¢ćõ╗ČŃĆé Java-HDFS ...

µ£¼µ¢ćÕ░åĶ»”ń╗åõ╗ŗń╗ŹHadoopÕÅŖÕģȵĀĖÕ┐āń╗äõ╗Čõ╣ŗõĖĆHDFS’╝łHadoop Distributed File System’╝ēńÜäńøĖÕģ│ń¤źĶ»åńé╣ŃĆé #### Hadoopµ”éĶ┐░ Hadoopńö▒ApacheÕ¤║ķćæõ╝ÜÕ╝ĆÕÅæń╗┤µŖż’╝īÕģČńø«µĀ浜»õĖ║õ║åĶ¦ŻÕå│Õż¦µĢ░µŹ«ÕżäńÉåķŚ«ķóś’╝īõĮ┐ńö©µłĘĶāĮÕż¤Õ£©ķøåńŠżõĖŖÕżäńÉåPBń║¦Õł½ńÜä...