зљСзЂЩињРиР•дЇЇеСШеѓєдЇОж≠їйУЊињЩдЄ™ж¶ВењµдЄАеЃЪдЄНйЩМзФЯпЉМзљСзЂЩзЪДдЄАдЇЫжХ∞жНЃеИ†йЩ§жИЦй°µйЭҐжФєзЙИз≠ЙйГљеЃєжШУеИґйА†ж≠їйУЊпЉМељ±еУНзФ®жИЈдљУй™МдЄНиѓіпЉМињЗе§ЪзЪДж≠їйУЊињШдЉЪељ±еУНеИ∞зљСзЂЩзЪДжХідљУжЭГйЗНжИЦжОТеРНгАВ

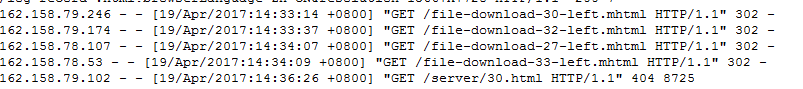

зЩЊеЇ¶зЂЩйХњеє≥еП∞жПРдЊЫзЪДж≠їйУЊжПРдЇ§еЈ•еЕЈ,еПѓе∞ЖзљСзЂЩе≠ШеЬ®зЪДж≠їйУЊ(еНПиЃЃж≠їйУЊгАБ404й°µйЭҐ)ињЫи°МжПРдЇ§,еПѓењЂйАЯеИ†йЩ§ж≠їйУЊ,еЄЃеК©зљСзЂЩseoдЉШеМЦгАВеЬ®жПРдЇ§ж≠їйУЊзЪДжЦЗдїґдЄ≠йАРдЄ™жЙЛеК®е°ЂеЖЩж≠їйУЊзЪДиѓЭ姙鯿зГ¶пЉМеЈ•дљЬдЄ≠жИСдїђжПРеА°е§НжЭВиЗ™еК®еМЦпЉМжЙАдї•жЬђжЦЗжИСдїђдЄАиµЈдЇ§жµБеИЖдЇЂApacheжЬНеК°дЄ≠йАЪињЗshellиДЪжЬђжХізРЖзљСзЂЩж≠їйУЊпЉМдЊњдЇОжИСдїђжПРдЇ§гАВ

1.йЕНзљЃApacheиЃ∞ељХжРЬ糥еЉХжУО

ApacheжШѓзЫЃеЙНзљСзЂЩеїЇиЃЊжЬАдЄЇдЄїжµБзЪДwebжЬНеК°пЉМдљЖжШѓapacheзЪДжЧ•ењЧжЦЗдїґйїШиЃ§жШѓдЄНиЃ∞ељХзЩЊеЇ¶гАБи∞Јж≠Мз≠ЙеРДе§ІжРЬ糥еЉХжУОзЪДзИђеПЦз®ЛеЇПзЪДпЉМжЙАдї•й¶ЦеЕИйЬАи¶БжИСдїђиЃЊзљЃApacheзЪДйЕНзљЃжЦЗдїґгАВ

жЙЊеИ∞ApacheзЪДйЕНзљЃжЦЗдїґhttpd.confпЉМеЬ®йЕНзљЃжЦЗдїґдЄ≠жЙЊеИ∞дЄЛйЭҐдЄ§и°МпЉЪ

CustomLog "logs/access_log" common #CustomLog "logs/access_log" combined

йїШиЃ§йЗЗзФ®зЪДжШѓcommonпЉМињЩйЗМжИСдїђеП™йЬАи¶Бе∞ЖcommonињЩдЄАи°МеЙНйЭҐеК†#ж≥®йЗКжОЙ,зДґеРОе∞ЖcombinedињЩдЄАи°МеЙНзЪД#еОїжОЙеН≥еПѓгАВзДґеРОдњЭе≠ШйЗНеРѓApacheжЬНеК°гАВ

ж≥®пЉЪе¶ВжЮЬдљ†зЪДжЬНеК°еЩ®дЄКжЈїеК†дЇЖе§ЪдЄ™зЂЩзВєпЉМжѓПдЄ™зЂЩзВєжЬЙеНХзЛђзЪДйЕНзљЃжЦЗдїґпЉМеИЩжИСдїђеП™йЬАи¶БеЬ®зЫЄеЇФзЂЩзВєзЪДйЕНзљЃжЦЗдїґдЄ≠иЃЊзљЃCustomLogй°єеН≥еПѓпЉМдЊЛе¶ВпЉЪ

vim /usr/local/apache/conf/vhost/www.chanzhi.org.conf

ServerAdmin [email protected] DocumentRoot "/data/wwwroot/www.chanzhi.org"

ServerName www.chanzhi.org

ServerAlias chanzhi.org

ErrorLog "/data/wwwlogs/www.chanzhi.org_error_apache.log"

CustomLog "/data/wwwlogs/www.chanzhi.org_apache.log" combined

<directory "="" data="" wwwroot="" www.chanzhi.org"="">

SetOutputFilter DEFLATE

Options FollowSymLinks ExecCGI

Require all granted

AllowOverride All

Order allow,deny

Allow from all

DirectoryIndex index.html index.php

дЄЛйЭҐжШѓйЕНзљЃеЙНеРОзЪДзљСзЂЩжЧ•ењЧиЃ∞ељХж†ЉеЉПпЉЪ

йЕНзљЃеЙНпЉЪ

йЕНзљЃеРОпЉЪ

2.зЉЦеЖЩshellиДЪжЬђ

жИСдїђйАЪињЗshellиДЪжЬђиОЈеПЦзљСзЂЩжЧ•ењЧдЄ≠жМЗеЃЪзИђиЩЂзЪДжКУеПЦиЃ∞ељХпЉМзДґеРОж±ЗжАїеИ∞дЄАдЄ™жЦЗдїґдЄ≠пЉМдЊњдЇОеРОжЬЯдљњзФ®гАВдї£з†Бе¶ВдЄЛпЉМжѓФе¶ВдњЭе≠ШдЄЇdeathlink.sh

#!/bin/bash

#еИЭеІЛеМЦеПШйЗП

#еЃЪдєЙиЬШиЫЫUAдњ°жБѓпЉИйїШиЃ§жШѓзЩЊеЇ¶иЬШиЫЫпЉЙ

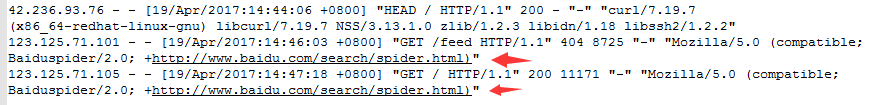

UA='+http://www.baidu.com/search/spider.html'

#еЙНдЄА姩зЪДжЧ•жЬЯпЉИapacheжЧ•ењЧпЉЙ

DATE=`date +%Y%m%d -d "1 day ago"`

#еЃЪдєЙжЧ•ењЧиЈѓеЊД

logfile=/data/wwwlogs/www.chanzhi.org_apache.log-${DATE}.log

#еЃЪдєЙж≠їйУЊжЦЗдїґе≠ШжФЊиЈѓеЊД

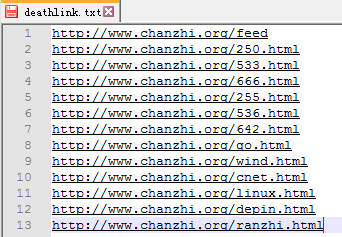

deathfile=/data/wwwroot/www.chanzhi.org/deathlink.txt

#еЃЪдєЙзљСзЂЩиЃњйЧЃеЬ∞еЭА

website=http://www.chanzhi.org

#еИЖжЮРжЧ•ењЧеєґдњЭе≠Шж≠їйУЊжХ∞жНЃ

for url in `awk -v str="${UA}" '$9=="404" && $15~str {print $7}' ${logfile}`

do

grep -q "$url" ${deathfile} || echo ${website}${url} >>${deathfile}

done

е§ІеЃґеЬ®дљњзФ®иѓ•иДЪжЬђжЧґпЉМж†єжНЃиЗ™еЈ±жЬНеК°еЩ®жГЕеЖµи∞ГжХідЄЛиЈѓеЊДеТМе≠ЧжЃµеН≥еПѓпЉМзДґеРОжЙІи°МиДЪжЬђ,пЉЪ

bash deathlink.sh

3.жПРдЇ§ж≠їйУЊ

жЙІи°МдЄКйЭҐиДЪжЬђжЧґеАЩпЉМе∞±дЉЪеЬ®жМЗеЃЪзЫЃељХдЄЛзФЯжИРеМЕеРЂжЙАжЬЙиОЈеПЦзЪД404й°µйЭҐйУЊжО•зЪДжЦЗдїґпЉМжѓПдЄ™ињЮжО•еН†дЄАи°МгАВдЊЛе¶ВпЉЪ

жЬАеРОеЬ®зЂЩйХњеє≥еП∞жПРдЇ§ж≠їйУЊй°µйЭҐдЄ≠пЉМе°ЂеЖЩиЗ™еЈ±зЪДж≠їйУЊжЦЗдїґеЬ∞еЭАеН≥еПѓпЉМдЊЛе¶ВпЉЪ

зЩЊеЇ¶еЬ®еЃ°ж†ЄйАЪињЗдєЛеРОпЉМдЉЪе∞ЖеЈ≤зїПжФґељХзЪД姱жХИйУЊжО•еИ†йЩ§пЉМдї•йБњеЕН姱жХИй°µйЭҐйУЊжО•еѓєзљСзЂЩйА†жИРдЄНиЙѓзЪДељ±еУНгАВ

жАїзїУпЉЪ

жЬђжЦЗеТМе§ІеЃґеИЖдЇЂдЇЖеЬ®ApacheжЬНеК°зОѓеҐГдЄЛпЉМе¶ВдљХеИ©зФ®shellиДЪжЬђиЗ™еК®иОЈеПЦзЩЊеЇ¶иЬШиЫЫз≠ЙзИђиЩЂжКУеПЦзЪДж≠їйУЊпЉМеєґзФЯжИРж±ЗжАїжЦЗдїґжПРдЇ§зїЩжРЬ糥еЉХжУОгАВе¶ВжЮЬе§ІеЃґињШжЬЙеЕґдїЦжЫіе•љзЪДжЦєж≥ХжИЦиАЕзЦСйЧЃпЉМ搥ињОдЄАиµЈеИЖдЇЂдЇ§жµБгАВ

зЫЄеЕ≥жО®иНР

### ApacheдЄЛйАЪињЗShellиДЪжЬђжПРдЇ§зљСзЂЩ404ж≠їйУЊзЪДжЦєж≥Х #### дЄАгАБеЉХи®А еЬ®зљСзЂЩзїіжК§ињЗз®ЛдЄ≠пЉМзїПеЄЄдЉЪйБЗеИ∞зФ±дЇОеРДзІНеОЯеЫ†еѓЉиЗізЪДж≠їйУЊйЧЃйҐШгАВињЩдЇЫж≠їйУЊдЄНдїЕељ±еУНзФ®жИЈдљУй™МпЉМињШдЉЪеѓєзљСзЂЩзЪДжХідљУжЭГйЗНеТМжРЬ糥еЉХжУОдЉШеМЦпЉИSEOпЉЙдЇІзФЯиіЯйЭҐељ±еУНгАВ...

еЬ®ињЩдЄ™ж°ИдЊЛдЄ≠пЉМжИСдїђиЃ®иЃЇдЇЖдЄАдЄ™дЄУйЧ®зФ®дЇОиЗ™еК®ж£АжµЛеТМжПРдЇ§зљСзЂЩ404йФЩиѓѓйУЊжО•пЉИж≠їйУЊпЉЙеИ∞жРЬ糥еЉХжУОзЪДShellиДЪжЬђгАВињЩдЄ™иДЪжЬђзЙєеИЂеЕ≥ж≥®зЩЊеЇ¶жРЬ糥еЉХжУОпЉМеЫ†дЄЇеЬ®дЄ≠еЫљпЉМзЩЊеЇ¶жШѓжЬАдЄїи¶БзЪДжРЬ糥еЉХжУОдєЛдЄАгАВ иДЪжЬђзЪДдЄїи¶БеКЯиГљжШѓжѓП姩еИЖжЮРNginx...

4. **жПРдЇ§ж≠їйУЊжЦЗдїґ**пЉЪеЬ®зљСзЂЩж†єзЫЃељХдЄЛеИЫеїЇдЄАдЄ™.sitemap.xmlжЦЗдїґпЉМеИЧеЗЇжЙАжЬЙж≠їйУЊпЉМеєґеРСжРЬ糥еЉХжУОжПРдЇ§пЉМеСКзЯ•еЃГдїђињЩдЇЫйУЊжО•еЈ≤姱жХИгАВ **жАїзїУпЉЪ**зљСзЂЩж≠їйУЊж£АжµЛеЈ•еЕЈжШѓSEOеЈ•дљЬдЄ≠дЄНеПѓжИЦзЉЇзЪДиЊЕеК©жЙЛжЃµпЉМеЃГеЄЃеК©жИСдїђеПСзО∞еєґиІ£еЖ≥ељ±еУН...

еЬ®жЮДеїЇеТМзїіжК§е§ІеЮЛзљСзЂЩжЧґпЉМж≠їйУЊж£АжµЛжШѓдЄАй°єиЗ≥еЕ≥йЗНи¶БзЪДдїїеК°гАВж≠їйУЊпЉМеН≥жЧ†жХИйУЊжО•пЉМжШѓжМЗйВ£дЇЫжЫЊзїПжЬЙжХИдљЖзО∞еЬ®жЧ†ж≥ХиЃњйЧЃзЪДURLгАВеЃГдїђеПѓиГљжШѓзФ±дЇОй°µйݥ襀еИ†йЩ§гАБURLжФєеПШжИЦжЬНеК°еЩ®йЧЃйҐШеѓЉиЗізЪДгАВж≠їйУЊдЄНдїЕељ±еУНзФ®жИЈдљУй™МпЉМињШеПѓиГљеѓєзљСзЂЩзЪД...

жАїзїУпЉМйАЪињЗзЉЦеЖЩеТМдљњзФ®ShellиДЪжЬђињЫи°МзљСзЂЩжЧ•ењЧеИЖжЮРпЉМжИСдїђеПѓдї•ењЂйАЯиОЈеПЦеИ∞еЕ≥йФЃжАІиГљжМЗж†ЗпЉМдїОиАМжЫіе•љеЬ∞дЇЖиІ£зљСзЂЩзЪДињРи°МзКґеЖµгАБдЉШеМЦзФ®жИЈдљУй™МгАБињљиЄ™жљЬеЬ®йЧЃйҐШпЉМеєґдЄЇеЖ≥з≠ЦжПРдЊЫжЬЙеКЫзЪДжХ∞жНЃжФѓжМБгАВињЩдЄ™иДЪжЬђзЪДзБµжіїжАІеТМеЃЮзФ®жАІдљњеЕґжИРдЄЇ...

**ж≠£жЦЗ** еЬ®дЇТиБФзљСдЄЦзХМдЄ≠пЉМзљСзЂЩзЪДеБ•еЇЈзКґеЖµжШѓиЗ≥еЕ≥йЗНи¶БзЪДпЉМзЙєеИЂжШѓеѓєдЇОSEOпЉИжРЬ糥еЉХжУОдЉШеМЦпЉЙиАМи®АгАВ...йАЪињЗдљњзФ®XenuпЉМзљСзЂЩзЃ°зРЖеСШеПѓдї•еПКжЧґеПСзО∞еєґиІ£еЖ≥ж≠їйУЊйЧЃйҐШпЉМз°ЃдњЭзљСзЂЩзЪДеБ•еЇЈињРи°МпЉМињЫиАМжПРйЂШжРЬ糥еЉХжУОзЪДеПЛе•љеЇ¶еТМзФ®жИЈдљУй™МгАВ

ињЩдЄ™еРНдЄЇ"apache_Log_analysis.rar_python log_shell"зЪДеОЛзЉ©еМЕеМЕеРЂдЇЖдЄАдЄ™еЃЮдЊЛпЉМжЉФз§ЇдЇЖе¶ВдљХзїУеРИдљњзФ®shellиДЪжЬђеТМPythonжЭ•е§ДзРЖApacheжЬНеК°еЩ®зЪДжЧ•ењЧжХ∞жНЃгАВдЄЛйЭҐжИСдїђе∞Жиѓ¶зїЖжОҐиЃ®ињЩдЄ™дЄїйҐШгАВ й¶ЦеЕИпЉМApacheжЬНеК°еЩ®зЪДжЧ•ењЧжЦЗдїґ...

йАЪињЗдљњзФ®ињЩдЄ™еЈ•еЕЈпЉМдљ†еПѓдї•ењЂйАЯгАБжЦєдЊњеЬ∞еИЫеїЇдЄАдЄ™еМЕеРЂж≠їйУЊзЪДXMLжЦЗдїґпЉМдї•дЊњжПРдЇ§зїЩзЩЊеЇ¶ињЫи°Ме§ДзРЖгАВ дљњзФ®ж≠•й™§е§ІиЗіе¶ВдЄЛпЉЪ 1. **ињРи°Миљѓдїґ**пЉЪиІ£еОЛдЄЛиљљзЪД"зЩЊеЇ¶ж≠їйУЊxmlзФЯжИРеЩ®.rar"пЉМжЙЊеИ∞еєґињРи°М"зЩЊеЇ¶ж≠їйУЊxmlзФЯжИРеЩ®.exe"жЦЗдїґгАВ...

жАїзїУжЭ•иѓіпЉМйАЪињЗshellиДЪжЬђйЕНеРИ`curl`еСљдї§пЉМжИСдїђеПѓдї•йЂШжХИеЬ∞ж£АжµЛзљСзЂЩзЪД404йФЩиѓѓй°µйЭҐеТМз©Їй°µйЭҐпЉМдїОиАМжПРйЂШзљСзЂЩзЪДеПѓзФ®жАІеТМSEOжАІиГљгАВињЩзІНжЦєж≥ХйАВзФ®дЇОеЕЈжЬЙе§ІйЗПй°µйЭҐзЪДзљСзЂЩпЉМиГље§ЯењЂйАЯеЃЪдљНйЧЃйҐШпЉМдЄЇзљСзЂЩзїіжК§жПРдЊЫдЊњеИ©гАВеЬ®еЃЮйЩЕеЇФзФ®дЄ≠...

жАїдєЛпЉМвАЬењЂйАЯжߕ胥ж≠їйУЊеЈ•еЕЈвАЭжШѓзљСзЂЩзЃ°зРЖеСШеТМSEOдЄУдЄЪдЇЇеСШдЄНеПѓжИЦзЉЇзЪДиЊЕеК©еЈ•еЕЈпЉМйАЪињЗеЃГиГље§ЯжЬЙжХИзЃ°зРЖеТМдЉШеМЦзљСзЂЩзЪДйУЊжО•зїУжЮДпЉМжПРйЂШзљСзЂЩзЪДжХідљУиі®йЗПеТМжРЬ糥еЉХжУОеПЛе•љеЇ¶гАВж≠£з°ЃеЬ∞дљњзФ®ињЩз±їеЈ•еЕЈпЉМе∞ЖжЬЙеК©дЇОзљСзЂЩзЪДйХњжЬЯеПСе±ХеТМжИРеКЯгАВ

еЯЇдЇОpythonеЉАеПСзЪДж£АжµЛзљСзЂЩж≠їйУЊз®ЛеЇП иЃЊиЃ°дЄАдЄ™з≥їзїЯпЉМиЗ™еК®еЃМжИРеѓєдЇОжЙЛжЬЇжРЬзЛР(http://m.sohu.com/ )з≥їзїЯеПѓйЭ†жАІзЪДж£АжµЛгАВеЕЈдљУи¶Бж±ВпЉЪ еЃЪжЧґйАТељТж£АжµЛжЙАжЬЙm.sohu.comеЯЯеРНзЪДй°µйЭҐдї•еПКињЩдЇЫй°µйЭҐдЄКзЪДйУЊжО•зЪДеПѓиЊЊжАІпЉМеН≥жЬЙж≤°жЬЙеЗЇзО∞дЄН...

4. **жЙєйЗПе§ДзРЖ**пЉЪеЕБиЃЄзФ®жИЈжЙєйЗПжПРдЇ§ж≠їйУЊиЗ≥жРЬ糥еЉХжУОзЪДWebmasterеЈ•еЕЈпЉМиѓЈж±ВеИ†йЩ§жИЦжЫіжЦ∞糥еЉХгАВ 5. **иЗ™еЃЪдєЙиЃЊзљЃ**пЉЪзФ®жИЈеПѓдї•иЃЊеЃЪжЙЂжППиІДеИЩпЉМе¶ВдїЕжЙЂжППзЙєеЃЪзЫЃељХгАБжОТйЩ§жЯРдЇЫURLз≠ЙпЉМжПРйЂШжЙЂжППжХИзОЗгАВ 6. **еЃЪжЧґж£АжµЛ**пЉЪиЃЊзљЃ...

ж≠їйУЊж£АжµЛеЈ•еЕЈйАЪињЗж®°жЛЯжµПиІИеЩ®иѓЈж±ВзљСзЂЩзЪДжѓПдЄ™й°µйЭҐпЉМиЃ∞ељХдЄЛињФеЫЮзЪДзКґжАБз†БгАВеЄЄиІБзЪДйФЩиѓѓзКґжАБз†БеМЕжЛђ404пЉИжЬ™жЙЊеИ∞пЉЙгАБ410пЉИж∞ЄдєЕеИ†йЩ§пЉЙгАБ500пЉИжЬНеК°еЩ®еЖЕйГ®йФЩиѓѓпЉЙз≠ЙпЉМињЩдЇЫйГљжШѓеПѓиГљзЪДж≠їйУЊж†ЗењЧгАВеЈ•еЕЈдЉЪе∞ЖињЩдЇЫзКґжАБз†БеѓєеЇФзЪДйУЊжО•жХізРЖ...

йАЪињЗзЉЦеЖЩиДЪжЬђжИЦиАЕдљњзФ®зО∞жИРзЪДиљѓдїґпЉМзФ®жИЈеПѓдї•еЃЪжЬЯињРи°Мж£АжµЛпЉМйБњеЕНжЙЛеК®ж£АжЯ•зЪДзєБзРРеЈ•дљЬгАВ 4. **жХИзОЗдЉШеМЦ**пЉЪдЄЇдЇЖжПРйЂШж£АжµЛйАЯеЇ¶пЉМеПѓдї•йЗЗзФ®е§ЪзЇњз®ЛжИЦеЉВж≠•е§ДзРЖжКАжЬѓпЉМеРМжЧґеѓєе§ЪдЄ™йУЊжО•еПСиµЈиѓЈж±ВгАВж≠§е§ЦпЉМињШеПѓдї•йАЪињЗзЉУе≠ШеЈ≤ж£АжµЛињЗзЪД...

**Xenuж£АжЯ•ж≠їйУЊеЈ•еЕЈиѓ¶иІ£** Xenu's Link SleuthпЉИзЃАзІ∞...йАЪињЗеЃЪжЬЯдљњзФ®XenuпЉМеПѓдї•жЬЙжХИеЬ∞еПСзО∞еєґиІ£еЖ≥зљСзЂЩзЪДж≠їйУЊйЧЃйҐШпЉМжПРйЂШзљСзЂЩзЪДеПѓзФ®жАІеТМжРЬ糥еЉХжУОжОТеРНпЉМдЄЇзФ®жИЈжПРдЊЫжЫіе•љзЪДжµПиІИдљУй™МпЉМеРМжЧґдєЯжЬЙеК©дЇОеїЇзЂЛеТМдњЭжМБиЙѓе•љзЪДзљСзїЬ嚥豰гАВ

4. жЫіжЦ∞XMLзЂЩзВєеЬ∞еЫЊпЉЪеЬ®жЄЕйЩ§ж≠їйУЊеРОпЉМжЫіжЦ∞еєґжПРдЇ§XMLзЂЩзВєеЬ∞еЫЊпЉМеСКзЯ•жРЬ糥еЉХжУОжЦ∞зЪДзљСзЂЩзїУжЮДгАВ 5. еЃЪжЬЯж£АжµЛпЉЪеїЇзЂЛеЃЪжЬЯж£АжµЛжЬЇеИґпЉМйШ≤ж≠Ґж≠їйУЊеЖНжђ°еЗЇзО∞гАВ дЇФгАБж≠їйУЊеЈ•еЕЈзЪДдљњзФ®ж≠•й™§ 1. дЄЛиљљеєґиІ£еОЛ"жФґељХж≠їйУЊдЄАйФЃж£АжµЛ-1.2.zip"пЉМ...

зљСзЂЩж≠їйУЊеТМжЧ†жХИйУЊжО•жШѓзљСй°µдЉШеМЦдЄ≠зЪДйЗНи¶Бж¶ВењµпЉМеЃГдїђеѓєжРЬ糥еЉХжУОдЉШеМЦпЉИSEOпЉЙдї•еПКзФ®жИЈдљУй™МжЬЙзЭАзЫіжО•зЪДељ±еУНгАВж≠їйУЊпЉМеН≥еЈ≤зїП姱жХИжЧ†ж≥ХиЃњйЧЃзЪДйУЊжО•пЉМеПѓиГљжШѓзФ±дЇОй°µйݥ襀еИ†йЩ§гАБURLжЫіжФєжИЦиАЕжЬНеК°еЩ®йЧЃйҐШз≠ЙеОЯеЫ†еѓЉиЗігАВжЧ†жХИйУЊжО•еИЩеМЕжЛђ404...

жАїзїУжЭ•иѓіпЉМXenuж≠їйУЊж£АжЯ•еЈ•еЕЈжШѓзљСзЂЩзЃ°зРЖеСШењЕе§ЗзЪДеИ©еЩ®пЉМйАЪињЗеЃЪжЬЯдљњзФ®XenuињЫи°Мж£АжЯ•еТМзїіжК§пЉМеПѓдї•жЬЙжХИеЬ∞дњЭжМБзљСзЂЩзЪДйУЊжО•зїУжЮДжХіжіБпЉМжПРеНЗзљСзЂЩзЪДжХідљУиі®йЗПгАВеѓєдЇОдїїдљХйЗНиІЖзљСзЂЩдЉШеМЦзЪДдЇЇжЭ•иѓіпЉМжОМжП°еТМеИ©зФ®XenuињЩж†ЈзЪДеЈ•еЕЈйГљжШѓиЗ≥еЕ≥...

жАїзїУжЭ•иѓіпЉМ"ж≠їйУЊжµЛиѓХзљСзЂЩеЬ∞еЭАsdafsf"ињЩдЄ™ж†ЗйҐШжПРз§ЇдЇЖжИСдїђеЕ≥ж≥®зЪДйЗНзВєеЬ®дЇОе¶ВдљХйАЪињЗжЬЙжХИзЪДеЈ•еЕЈеТМжЦєж≥ХжЭ•зЃ°зРЖеТМдЉШеМЦзљСзЂЩзЪДйУЊжО•зїУжЮДпЉМдї•жПРеНЗзФ®жИЈдљУй™МеТМжРЬ糥еЉХжУОдЉШеМЦзЪДжХИжЮЬгАВиАМ"ж≠їйУЊжµЛиѓХеЈ•еЕЈ"зЪДжЦЗдїґеРНеИЩжМЗеЗЇдЇЖиІ£еЖ≥ињЩдЄ™йЧЃйҐШзЪД...