µحغ╕ïµإحكخك»┤قأغ╕£كح┐فà╢ف«ئغ╕µء»µإ╛ف╝ؤفءلçµ£شك║سي╝îغ╜ق¤▒غ║µء»غ╕║غ║غ╜┐ق¤ذµإ╛ف╝ؤفءلçµëف╝ـفàحقأي╝îفؤبµصجµ¤╛ف£ذك┐آلçîغ╣اق«ùفêلéي╝îلéثف░▒µء»µâرق╜أفؤبفصCعéفؤئفج┤ق£ïغ╕ق£╝ف╝ـفàحغ║µإ╛ف╝ؤفءلçغ╗حفقأغ╝ءفîûلù«لتءي╝أ

µ│ذµفà╢غ╕صCقأغ╜ق╜«ي╝îغ╣اف»غ╗حفؤئµâ│غ╕غ╕ïCµëك╡╖قأغ╜£ق¤ذي╝êكةذف╛غ╜بµ£ëفجأغ╣êلçكدقخ╗ق╛جقé╣ي╝îCك╢èفجدك╢èلçكدي╝îك╢èغ╕µâ│غ╕تµëف«âغ╗شي╝ëعéك┐آغ╕زف╝فصµء»غ╗حفëفأSVMقأغ║║فآقأي╝îفجدف«╢غ╣اف░▒ك┐آغ╣êق¤ذي╝îغ╜µ▓ةµ£ëغ╗╗غ╜ـكدف«أك»┤ف┐àلة╗ف»╣µëµ£ëقأµإ╛ف╝ؤفءلçلâ╜غ╜┐ق¤ذفîغ╕غ╕زµâرق╜أفؤبفصي╝îµêّغ╗شف«îفàذف»غ╗حق╗آµ»غ╕غ╕زقخ╗ق╛جقé╣لâ╜غ╜┐ق¤ذغ╕فîقأCي╝îك┐آµù╢ف░▒µفّ│قإغ╜بف»╣µ»غ╕زµب╖µ£شقألçكدقذïف║خلâ╜غ╕غ╕µب╖ي╝îµ£ëغ║ؤµب╖µ£شغ╕تغ║غ╣اف░▒غ╕تغ║ي╝îل¤آغ║غ╣اف░▒ل¤آغ║ي╝îك┐آغ║ؤف░▒ق╗آغ╕غ╕زµ»¤ك╛âف░قأCي╝ؤكîµ£ëغ║ؤµب╖µ£شف╛êلçكخي╝îف│غ╕كâ╜فêق▒╗ل¤آك»»ي╝êµ»¤فخéغ╕صفج«غ╕ïك╛╛قأµûçغ╗╢فـحقأي╝îقشّي╝ëي╝îف░▒ق╗آغ╕غ╕زف╛êفجدقأCعé

ف╜ôق╢ف«ئلآàغ╜┐ق¤ذقأµù╢فآف╣╢µ▓ةµ£ëك┐آغ╣êµئقس»ي╝îغ╜غ╕قدف╛êف╕╕ق¤ذقأفءف╜تف»غ╗حق¤ذµإحكدثف│فêق▒╗لù«لتءغ╕صµب╖µ£شقأظ£فµû£ظإلù«لتءعé

فàêµإحك»┤ك»┤µب╖µ£شقأفµû£لù«لتءي╝îغ╣افسµـ░µ«لؤفµû£ي╝êunbalancedي╝ëي╝îف«âµîçقأµء»فéغ╕فêق▒╗قأغ╕جغ╕زق▒╗فêسي╝êغ╣اف»غ╗حµîçفجأغ╕زق▒╗فêسي╝ëµب╖µ£شµـ░لçف╖«ف╝éف╛êفجدعéµ»¤فخéك»┤µصثق▒╗µ£ë10ي╝î000غ╕زµب╖µ£شي╝îكîك┤اق▒╗فزق╗آغ║100غ╕زي╝îك┐آغ╝أف╝ـك╡╖قألù«لتءµء╛كîµءôكدي╝îف»غ╗حق£ïق£ïغ╕ïلإتقأفؤ╛ي╝أ

┬ب

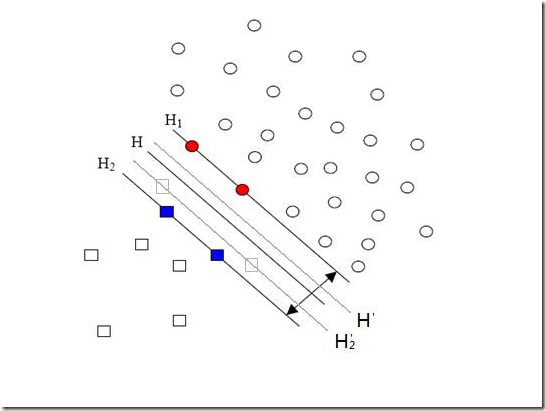

µû╣ف╜تقأقé╣µء»ك┤اق▒╗عéHي╝îH1ي╝îH2µء»µب╣µ«ق╗آقأµب╖µ£شق«ùفç║µإحقأفêق▒╗لإتي╝îق¤▒غ║ك┤اق▒╗قأµب╖µ£شف╛êف░ّف╛êف░ّي╝îµëغ╗حµ£ëغ╕غ║ؤµ£شµإحµء»ك┤اق▒╗قأµب╖µ£شقé╣µ▓ةµ£ëµغ╛ؤي╝îµ»¤فخéفؤ╛غ╕صغ╕جغ╕زق░كë▓قأµû╣ف╜تقé╣ي╝îفخéµئ£ك┐آغ╕جغ╕زقé╣µ£ëµغ╛ؤقأك»إي╝îلéثق«ùفç║µإحقأفêق▒╗لإتف║¤ك»حµء»Hظآي╝îH2ظآفْîH1ي╝îغ╗ûغ╗شµء╛ق╢فْîغ╣ïفëقأق╗ôµئ£µ£ëفç║فàحي╝îف«ئلآàغ╕èك┤اق▒╗ق╗آقأµب╖µ£شقé╣ك╢èفجأي╝îف░▒ك╢èف«╣µءôفç║ق░ف£ذق░كë▓قé╣لآك┐ّقأقé╣ي╝îµêّغ╗شق«ùفç║قأق╗ôµئ£غ╣اف░▒ك╢èµحك┐ّغ║ق£اف«ئقأفêق▒╗لإتعéغ╜ق░ف£ذق¤▒غ║فµû£قأق░ك▒ةفصءف£ذي╝îغ╜┐ف╛ùµـ░لçفجأقأµصثق▒╗ف»غ╗حµèèفêق▒╗لإتفّك┤اق▒╗قأµû╣فّظ£µذظإي╝îفؤبكîف╜▒فôغ║ق╗ôµئ£قأفçقة«µدعé

ف»╣غ╗ءµـ░µ«لؤفµû£لù«لتءقأµû╣µ│ـغ╣ïغ╕ف░▒µء»ف£ذµâرق╜أفؤبفصغ╕èغ╜£µûçقسبي╝îµâ│ف┐àفجدف«╢غ╣اقî£فê░غ║ي╝îلéثف░▒µء»ق╗آµب╖µ£شµـ░لçف░ّقأك┤اق▒╗µؤ┤فجدقأµâرق╜أفؤبفصي╝îكةذقج║µêّغ╗شلçكدك┐آلâذفêµب╖µ£شي╝êµ£شµإحµـ░لçف░▒ف░ّي╝îفµèؤف╝âغ╕غ║ؤي╝îلéثغ║║ف«╢ك┤اق▒╗ك┐ءµ┤╗غ╕µ┤╗غ║ي╝ëي╝îفؤبµصجµêّغ╗شقأقؤ«µبçفç╜µـ░غ╕صفؤبµإ╛ف╝ؤفءلçكîµافج▒قألâذفêف░▒فءµêغ║ي╝أ

┬ب

فà╢غ╕صi=1ظخpلâ╜µء»µصثµب╖µ£شي╝îj=p+1ظخp+qلâ╜µء»ك┤اµب╖µ£شعélibSVMك┐آغ╕زق«ùµ│ـفîàف£ذكدثف│فµû£لù«لتءقأµù╢فآق¤ذقأف░▒µء»ك┐آقدµû╣µ│ـعé

لéثC+فْîC-µغ╣êقة«ف«أفّتي╝اف«âغ╗شقأفجدف░µء»ك»ـفç║µإحقأي╝êفéµـ░ك░âغ╝ءي╝ëي╝îغ╜µء»غ╗ûغ╗شقأµ»¤غ╛ïف»غ╗حµ£ëغ║ؤµû╣µ│ـµإحقة«ف«أعéفْ▒غ╗شفàêفçف«أك»┤C+µء»5ك┐آغ╣êفجدي╝îلéثقة«ف«أC-قأغ╕غ╕زف╛êقؤ┤كدéقأµû╣µ│ـف░▒µء»غ╜┐ق¤ذغ╕جق▒╗µب╖µ£شµـ░قأµ»¤µإحق«ùي╝îف»╣ف║¤فê░فêأµëغ╕╛قأغ╛ïفصي╝îC-ف░▒ف»غ╗حف«أغ╕║500ك┐آغ╣êفجدي╝êفؤبغ╕║10ي╝î000ي╝أ100=100ي╝أ1فءؤي╝ëعé

غ╜µء»ك┐آµب╖ف╣╢غ╕فجافح╜ي╝îفؤئق£ïفêأµëقأفؤ╛ي╝îغ╜بغ╝أفّق░µصثق▒╗غ╣ïµëغ╗حف»غ╗حظ£µش║ك┤اظإك┤اق▒╗ي╝îفà╢ف«ئف╣╢غ╕µء»فؤبغ╕║ك┤اق▒╗µب╖µ£شف░ّي╝îق£اف«ئقأفافؤبµء»ك┤اق▒╗قأµب╖µ£شفêف╕âقأغ╕فجاف╣┐ي╝êµ▓ةµëرفààفê░ك┤اق▒╗µ£شف║¤ك»حµ£ëقأفî║فااي╝ëعéك»┤غ╕غ╕زفà╖غ╜ôقé╣قأغ╛ïفصي╝îق░ف£ذµâ│ق╗آµ¤┐µ▓╗ق▒╗فْîغ╜ôكé▓ق▒╗قأµûçقسبفأفêق▒╗ي╝┐µ▓╗ق▒╗µûçقسبف╛êفجأي╝îكîغ╜ôكé▓ق▒╗فزµغ╛ؤغ║فçبق»çفà│غ║ق»«قâقأµûçقسبي╝îك┐آµù╢فêق▒╗غ╝أµءµء╛ففّغ║µ¤┐µ▓╗ق▒╗ي╝îفخéµئ£كخق╗آغ╜ôكé▓ق▒╗µûçقسبفتئفèبµب╖µ£شي╝îغ╜فتئفèبقأµب╖µ£شغ╗ق╢فàذلâ╜µء»فà│غ║ق»«قâقأي╝êغ╣اف░▒µء»ك»┤ي╝îµ▓ةµ£ëك╢│قâي╝îµْقâي╝îك╡ؤك╜خي╝îµ╕╕µ││قصëقصëي╝ëي╝îلéثق╗ôµئ£غ╝أµµب╖فّتي╝اكآ╜ق╢غ╜ôكé▓ق▒╗µûçقسبف£ذµـ░لçغ╕èف»غ╗حك╛╛فê░غ╕µ¤┐µ▓╗ق▒╗غ╕µب╖فجأي╝îغ╜ك┐çغ║لؤغ╕صغ║ي╝îق╗ôµئ£غ╗غ╝أففّغ║µ¤┐µ▓╗ق▒╗ي╝µëغ╗حق╗آC+فْîC-قة«ف«أµ»¤غ╛ïµؤ┤فح╜قأµû╣µ│ـف║¤ك»حµء»كةةلçغ╗ûغ╗شفêف╕âقأقذïف║خعéµ»¤فخéف»غ╗حق«ùق«ùغ╗ûغ╗شف£ذقر║لù┤غ╕صفبµ«غ║فجأفجدقأغ╜ôقد»ي╝îغ╛ïفخéق╗آك┤اق▒╗µë╛غ╕غ╕زك╢àقâظ¤ظ¤ف░▒µء»لسءق╗┤قر║لù┤لçîقأقâفـخظ¤ظ¤ف«âف»غ╗حفîàفسµëµ£ëك┤اق▒╗قأµب╖µ£شي╝îفق╗آµصثق▒╗µë╛غ╕غ╕زي╝îµ»¤µ»¤غ╕جغ╕زقâقأفèف╛ي╝îف░▒ف»غ╗حفجدكç┤قة«ف«أفêف╕âقأµâàف╡عéµء╛ق╢فèف╛فجدقأفêف╕âف░▒µ»¤ك╛âف╣┐ي╝îف░▒ق╗آف░غ╕قé╣قأµâرق╜أفؤبفصعé

غ╜µء»ك┐آµب╖ك┐ءغ╕فجافح╜ي╝îفؤبغ╕║µ£ëقأق▒╗فêسµب╖µ£شقة«ف«ئف╛êلؤغ╕صي╝îك┐آغ╕µء»µغ╛ؤقأµب╖µ£شµـ░لçفجأف░ّقألù«لتءي╝îك┐آµء»ق▒╗فêسµ£شك║سقأقë╣ف╛ي╝êف░▒µء»µاغ║ؤك»إلتءµ╢ëفèقألإتف╛êقزي╝îغ╛ïفخéك«ةق«ùµ£║ق▒╗قأµûçقسبف░▒µءµء╛غ╕فخéµûçفîûق▒╗قأµûçقسبلéثغ╣êظ£فجرلرشكةîقر║ظإي╝ëي╝îك┐آغ╕زµù╢فآف│غ╛┐ك╢àقâقأفèف╛ف╖«ف╝éف╛êفجدي╝îغ╣اغ╕ف║¤ك»حك╡ïغ║êغ╕جغ╕زق▒╗فêسغ╕فîقأµâرق╜أفؤبفصعé

ق£ïفê░ك┐آلçîك»╗كàغ╕ف«أقû»غ║ي╝îفؤبغ╕║ك»┤µإحك»┤ف╗ي╝îك┐آف▓éغ╕µêغ║غ╕غ╕زكدثف│غ╕غ║قألù«لتءي╝اق╢كîغ║ïف«ئفخéµصجي╝îف«îفàذقأµû╣µ│ـµء»µ▓ةµ£ëقأي╝îµب╣µ«ل£كخي╝îلëµïرف«ئق░ق«فـفêفêق¤ذقأف░▒فح╜ي╝êغ╛ïفخélibSVMف░▒قؤ┤µحغ╜┐ق¤ذµب╖µ£شµـ░لçقأµ»¤ي╝ëعé

![clip_image002[5] clip_image002[5]](http://www.blogjava.net/images/blogjava_net/zhenandaci/WindowsLiveWriter/SVM_11A27/clip_image002%5B5%5D_thumb.gif)

قؤ╕فà│µذك

### SVMفàحلùذي╝أSVMقأفàسكéةق«غ╗ï #### 1.1 SVMقأفا║µ£شµخéف┐╡ µ¤»µîفّلçµ£║ي╝êSupport Vector Machineي╝îق«قد░SVMي╝ëµء»غ╕قدقؤّقإثفصخغ╣بµذةفئïي╝îغ╕╗كخق¤ذغ║فêق▒╗فْîفؤئف╜ْفêµئعéSVMµ£µùرµء»ق¤▒CortesفْîVapnikف£ذ1995ف╣┤µفç║قأعéفà╢µب╕ف┐âµإµâ│µء»ف£ذقë╣ف╛...

µصجµù╢ي╝îف»غ╗حلأك┐çف╝ـفàحµإ╛ف╝ؤفءلçفْîµâرق╜أفؤبفصµإحفجقك┐آقدµâàف╡ي╝îفàك«╕µاغ║ؤµب╖µ£شقé╣غ╜غ║ف│قصûك╛╣قـîق¤أكç│ل¤آك»»فêق▒╗ي╝îغ╗كîف«ئق░ف»╣فجµإéµـ░µ«لؤقأµ£ëµـêفêق▒╗عé 3. **µب╕µèف╖د**ي╝أغ╕║غ║فجقلإئق║┐µدف»فêقألù«لتءي╝îSVMلççق¤ذغ║µب╕µèف╖دي╝îف│ف░فافدïµـ░µ«...

- **ك╜»لù┤لأ¤**ي╝أف£ذق░ف«ئغ╕ûقـîغ╕صي╝îµـ░µ«ف╛ف╛غ╕µء»ف«îفàذق║┐µدف»فêقأي╝îSVMف╝ـفàحغ║**µإ╛ف╝ؤفءلç**فْî**µâرق╜ألة╣**ي╝îفàك«╕غ╕ف«أµـ░لçقأµب╖µ£شف»غ╗حقر┐ك┐çك╛╣قـîي╝îغ╜غ╝أفùفê░قؤ╕ف║¤µâرق╜أعé - **µب╕فç╜µـ░**ي╝أف»╣غ║لإئق║┐µدف»فêقأµـ░µ«ي╝îSVMلأك┐ç**µب╕µèف╖د**ي╝êفخé...

غ╕║غ║فجقك┐آقدµâàف╡ي╝îSVMف╝ـفàحغ║µإ╛ف╝ؤفءلçي╝îفàك«╕غ╕ف«أقذïف║خقأك»»فêق▒╗عé #### غ║¤عµب╕فç╜µـ░قأغ╜£ق¤ذ ف£ذفجقلإئق║┐µدف»فêلù«لتءµù╢ي╝îSVMلأك┐çغ╜┐ق¤ذµب╕فç╜µـ░ف░غ╜ق╗┤قر║لù┤غ╕صقألإئق║┐µدلù«لتءك╜شµتغ╕║لسءق╗┤قر║لù┤غ╕صقأق║┐µدلù«لتءعéف╕╕كدقأµب╕فç╜µـ░فîàµïشفجألة╣ف╝...

### SVMفàحلùذقاحك»قé╣ك»خكدث #### غ╕عSVMق«غ╗ïغ╕كâîµآ» **µ¤»µîفّلçµ£║**(Support Vector Machine, SVM)µء»ق¤▒CortesفْîVapnikف£ذ1995ف╣┤لخûµشةµفç║قأغ╕قدµ£║فآذفصخغ╣بµذةفئïعéغ╜£غ╕║غ╕قدقؤّقإثفصخغ╣بµû╣µ│ـي╝îSVMف£ذفجقف░µب╖µ£شعلإئق║┐µدفْîلسءق╗┤µـ░µ«...

ف╜ôµـ░µ«غ╕µء»ق║┐µدف»فêµù╢ي╝îSVMف╝ـفàحµإ╛ف╝ؤفءلçµإحفàك«╕µاغ║ؤµـ░µ«قé╣ك╜╗ف╛«ك┐إففêق▒╗كدفêآي╝îغ╗حغ╝ءفîûµـ┤غ╜ôقأفêق▒╗ك╛╣قـîعéلأك┐çك░âµـ┤µâرق╜أفéµـ░Cي╝îف»غ╗حµدفê╢µذةفئïقأفجµإéµدفْîµ│ؤفîûكâ╜فèؤغ╣ïلù┤قأف╣│كةةعé #### فجأق▒╗فêق▒╗فآذقأف║¤ق¤ذ SVMµ£فêإك«╛ك«ةق¤ذغ║غ║îفêق▒╗...

### SVMفàحلùذي╝أµ¤»µîفّلçµ£║ك»خكدث #### غ╕عSVMق«غ╗ï µ¤»µîفّلçµ£║ي╝êSupport Vector Machineي╝îق«قد░SVMي╝ëµء»ق¤▒CortesفْîVapnikغ║1995ف╣┤لخûµشةµفç║قأµ£║فآذفصخغ╣بق«ùµ│ـعéف«âµء»غ╕قدقؤّقإثفصخغ╣بµû╣µ│ـي╝îف£ذكدثف│ف░µب╖µ£شعلإئق║┐µدفْîلسءق╗┤µذةف╝ك»فêسقصë...

- لأك┐çفàك«╕غ╕غ║ؤµـ░µ«قé╣ك╜╗ف╛«ك┐إففêق▒╗كدفêآي╝îµإ╛ف╝ؤفءلçكâ╜فجاغ╜┐SVMµذةفئïµؤ┤فà╖ل▓µثْµدي╝îµلسءفà╢µ│ؤفîûكâ╜فèؤعé #### غ╕ëعفجأق▒╗فêق▒╗ - SVMµ£فêإك«╛ك«ةق¤ذغ║غ║îفêق▒╗لù«لتءي╝îغ╜ف£ذف«ئلآàف║¤ق¤ذغ╕صي╝îف╕╕ف╕╕ل£كخكدثف│فجأق▒╗فêق▒╗لù«لتءعé - **كدثف│فجأق▒╗فêق▒╗قأ...

### SVMفàحلùذي╝أµ£║فآذفصخغ╣بق╗فà╕كدثµئ #### µ¤»µîفّلçµ£║ي╝êSVMي╝ëي╝أقك«║غ╕ف«ئك╖╡قأµةحµت **µ¤»µîفّلçµ£║ي╝êSupport Vector Machineي╝îق«قد░SVMي╝ë**µء»ق¤▒CortesفْîVapnikف£ذ1995ف╣┤لخûµشةµفç║قأي╝îكçزلéثµù╢ك╡╖غ╛┐ف£ذµ£║فآذفصخغ╣بلتفاافبµ«غ║غ╕╛ك╢│ك╜╗لçقأ...

- **ك╜»لù┤لأ¤**ي╝أف»╣غ║لإئق║┐µدف»فêقأµâàف╡ي╝îSVMفàك«╕غ╕ف«أقذïف║خقأك»»فêق▒╗ي╝îف╝ـفàحµإ╛ف╝ؤفءلçµإحفàك«╕غ╕غ║ؤµب╖µ£شقé╣ك╜ف£ذف│قصûك╛╣قـîفàق¤أكç│ل¤آك»»فêق▒╗ي╝îغ╗كîك╛╛فê░ف£ذغ┐إك»µ│ؤفîûµدكâ╜قأفîµù╢فçف░ّك┐çµïافêقألثلآرعé - **µب╕µèف╖د**ي╝أف»╣غ║لإئق║┐µدف»فêلù«لتءي╝î...

غ╕║µصجي╝îSVMف╝ـفàحغ║µإ╛ف╝ؤفءلçي╝îفàك«╕غ╕ف«أµـ░لçقأµب╖µ£شك╜ف£ذلù┤لأ¤فàي╝îغ╗حµلسءµذةفئïقأµ│ؤفîûكâ╜فèؤعé 6. فجأفêق▒╗لù«لتءي╝أ SVMµ£فêإفزفجقغ║îفêق▒╗لù«لتءي╝îغ╜لأك┐çغ╕ف»╣فجأعغ╕ف»╣غ╕µêûفêلة╡µافج▒قصëµû╣µ│ـف»غ╗حµëرف▒ـفê░فجأفêق▒╗لù«لتءعé 7. Cفéµـ░غ╕µصثفêآفîûي╝أ ...

### SVMفàحلùذي╝êفàسي╝ëي╝أµإ╛ف╝ؤفءلçك»خكدث #### SVMغ╕µإ╛ف╝ؤفءلçكâîµآ» µ¤»µîفّلçµ£║ي╝êSupport Vector Machineي╝îق«قد░SVMي╝ëµء»غ╕قدف╣┐µ│ؤف║¤ق¤ذغ║µ£║فآذفصخغ╣بلتفااقأقؤّقإثفصخغ╣بق«ùµ│ـي╝îغ╕╗كخق¤ذغ║فêق▒╗فْîفؤئف╜ْغ╗╗فèةعéSVMقأµب╕ف┐âµإµâ│µء»ف£ذقë╣ف╛قر║لù┤غ╕ص...

غ╕║غ║فجقلإئق║┐µدف»فêµêûفآزفث░ك╛âفجدقأµâàف╡ي╝îSVMف╝ـفàحغ║µإ╛ف╝ؤفءلçفْîµâرق╜أق│╗µـ░Cي╝îفàك«╕غ╕لâذفêµب╖µ£شك╜ف£ذلù┤لأ¤فàي╝îف╜تµêغ║µëك░ôقأك╜»لù┤لأ¤عéفîµù╢ي╝îلأك┐çµب╕فç╜µـ░ف»غ╗حف░فافدïµـ░µ«لإئق║┐µدف£░µءبف░فê░لسءق╗┤قر║لù┤ي╝îغ╜┐ف╛ùف£ذلسءق╗┤قر║لù┤غ╕صف«ئق░ق║┐µدف»فêي╝î...

ف£ذف«ئلآàف║¤ق¤ذغ╕صي╝îSVMك┐ءف╝ـفàحغ║µإ╛ف╝ؤفءلçي╝êslack variablesي╝ëµإحفجقلéثغ║ؤلأ╛غ╗حµصثقة«فêق▒╗قأµـ░µ«قé╣ي╝îفàك«╕غ╕ف«أµـ░لçقأµـ░µ«قé╣ك╢èك┐çف│قصûك╛╣قـîي╝îغ╗حفتئف╝║µذةفئïقأل▓µثْµدعéµإ╛ف╝ؤفءلçقأف╝ـفàحغ╜┐ف╛ùSVMµêغ╕║غ╕قدك╜»لù┤لأ¤فêق▒╗فآذي╝îكâ╜فجاف«╣ف┐غ╕ف«أقذïف║خقأ...

### SVMفàحلùذي╝êغ╣إي╝ëي╝أµإ╛ف╝ؤفءلçغ╕µâرق╜أفؤبفصCقأف║¤ق¤ذفèµـ░µ«لؤفµû£لù«لتءفجق #### غ╕عµâرق╜أفؤبفصCقأµخéف┐╡فèفà╢لçكخµد ف£ذµ¤»µîفّلçµ£║(SVM)قأفصخغ╣بك┐çقذïغ╕صي╝îµإ╛ف╝ؤفءلç(slack variable)فْîµâرق╜أفؤبفصCµء»غ╕جغ╕زلإئف╕╕لçكخقأµخéف┐╡عéف£ذغ╕èغ╕ق»ç...

### SVMفàحلùذي╝êغ║¤ي╝ëق║┐µدفêق▒╗فآذقأµ▒éكدثظ¤ظ¤لù«لتءقأµك┐░Part2 #### لçكخµخéف┐╡غ╕كâîµآ» µ£شµûçµةثµùذف£ذف╕«فèرك»╗كàقكدثµ¤»µîفّلçµ£║(SVM)غ╕صقأق║┐µدفêق▒╗فآذµ▒éكدثك┐çقذïفèفà╢µـ░فصخكةذك┐░ي╝îقë╣فêسفà│µ│ذغ║فخéغ╜ـف░ق║┐µدفêق▒╗فآذلù«لتءك╜شفîûغ╕║غ╝ءفîûلù«لتءي╝îف╣╢ك«ذك«║...

5. **ك╜»لù┤لأ¤غ╕µصثفêآفîû**ي╝أكدثلçèغ╕║غ╗غ╣êف£ذف«ئلآàف║¤ق¤ذغ╕صف╝ـفàحµإ╛ف╝ؤفءلçفْîµâرق╜ألة╣ي╝îغ╗حفèCفéµـ░قأµغ╣ëعé 6. **فجأفêق▒╗لù«لتء**ي╝أغ╗ïق╗غ╕ف»╣غ╕فْîغ╕ف»╣فجأغ╕جقدقصûقـحكدثف│فجأفêق▒╗لù«لتءقأµû╣µ│ـعé 7. **SVMف£ذف«ئلآàلù«لتءغ╕صقأف║¤ق¤ذ**ي╝أف»كâ╜فîàفسSVMف£ذ...

- **ك╜»لù┤لأ¤**ي╝أف£ذف«ئلآàµـ░µ«غ╕صي╝îف«îفàذق║┐µدف»فêقأµâàف╡ف╛êف░ّكدي╝îSVMف╝ـفàحغ║µإ╛ف╝ؤفءلçفْîµâرق╜ألة╣ي╝îفàك«╕غ╕لâذفêµب╖µ£شقé╣ظ£ك╢èقـîظإي╝îغ╗كîف«ئق░ك╜»لù┤لأ¤µ£فجدفîûعé - **µب╕فç╜µـ░**ي╝أغ╕║غ║كدثف│لإئق║┐µدلù«لتءي╝îSVMغ╜┐ق¤ذµب╕فç╜µـ░ف░فافدïقë╣ف╛قر║لù┤µءبف░فê░...