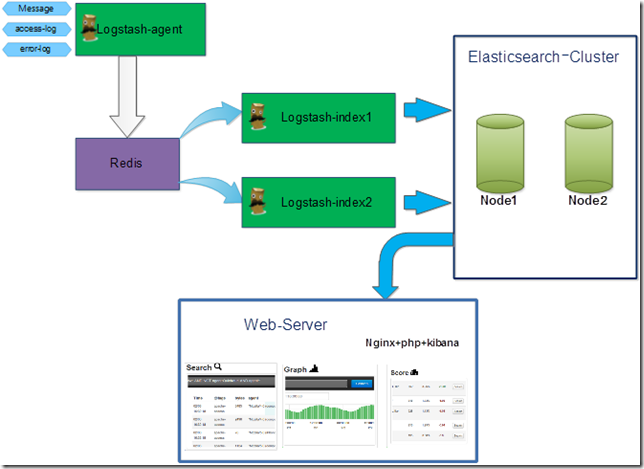

م€€وگه»؛该ه¹³هڈ°çڑ„ç›®çڑ„ه°±وک¯ن¸؛ن؛†è؟گç»´م€پç ”هڈ‘ه¾ˆو–¹ن¾؟çڑ„è؟›è،Œو—¥ه؟—çڑ„وں¥è¯¢م€‚Kibanaن¸€ن¸ھه…چè´¹çڑ„webه£³ï¼›Logstash集وˆگهگ„ç§چو”¶é›†و—¥ه؟—وڈ’ن»¶ï¼Œè؟کوک¯ن¸€ن¸ھو¯”较ن¼ک秀çڑ„و£هˆ™هˆ‡ه‰²و—¥ه؟—ه·¥ه…·ï¼›Elasticsearchن¸€ن¸ھه¼€و؛گçڑ„وگœç´¢ه¼•و“ژو،†و¶ï¼ˆو”¯وŒپ群集و¶و„و–¹ه¼ڈ)م€‚

آ

1 ه®‰è£…需و±‚

1.1آ çگ†è®؛و‹“و‰‘

آ

1.2 ه®‰è£…çژ¯ه¢ƒ

1.2.1 ç،¬ن»¶çژ¯ه¢ƒ

192.168.50.62(HP DL 385 G7 م€پRAMï¼ڑ12Gم€پCPUï¼ڑAMD 6128م€پDISKï¼ڑSAS 146*4)

192.168.50.98(HP DL 385 G7 م€پRAMï¼ڑ12Gم€پCPUï¼ڑAMD 6128م€پDISKï¼ڑSAS 146*6)

192.168.10.42 (Xenè™ڑو‹ںوœ؛م€پRAMï¼ڑ8Gم€پCPUï¼ڑأ—4م€پDISKï¼ڑ100G)

1.2.2 و“چن½œç³»ç»ں

CentOS 5.6 X64

1.2.3 Web-serverهں؛ç،€çژ¯ه¢ƒ

Nginx+php(ه®‰è£…è؟‡ç¨‹ç•¥è؟‡ï¼‰

1.2.4 软ن»¶هˆ—è،¨

JDK 1.6.0_25

logstash-1.1.0-monolithic.jar

elasticsearch-0.18.7.zip

redis-2.4.12.tar.gz

kibana

1.3 èژ·هڈ–و–¹و³•

1.3.1 Jdkèژ·هڈ–è·¯ه¾„

http://www.oracle.com/technetwork/java/javase/downloads/jdk-6u25-download-346242.html

1.3.2 Logstashèژ·هڈ–è·¯ه¾„

http://semicomplete.com/files/logstash/logstash-1.1.0-monolithic.jar

1.3.3 Elasticsearchèژ·هڈ–è·¯ه¾„

https://github.com/downloads/elasticsearch/elasticsearch/ elasticsearch-0.18.7.zip

1.3.4 Kibanaèژ·هڈ–è·¯ه¾„

http://github.com/rashidkpc/Kibana/tarball/master

2 ه®‰è£…و¥éھ¤

2.1 JDKçڑ„ن¸‹è½½هڈٹه®‰è£…

هں؛ç،€ه®‰è£…

wget http://download.oracle.com/otn-pub/java/jdk/6u25-b06/jdk-6u25-linux-x64.bin

sh jdk-6u25-linux-x64.bin

mkdir -p /usr/java

mv ./jdk1.6.0_25 /usr/java

ln –s /usr/java/jdk1.6.0_25 /usr/java/default

编辑 /etc/profileو–‡ن»¶ï¼Œهٹ ه…¥ن»¥ن¸‹è،Œه†…ه®¹

export JAVA_HOME=/usr/java/default

export PATH=$JAVA_HOME/bin:$PATH

export CLASSPATH=.:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar:$CLASSPATH

هˆ·و–°çژ¯ه¢ƒهڈکé‡ڈ

source /etc/profile

2.2 Redisن¸‹è½½هڈٹه®‰è£…

wgetآ http://redis.googlecode.com/files/redis-2.4.14.tar.gz

make –j24

make install

mkdir -p /data/redis

cd /data/redis/

mkdir {db,log,etc}

2.3 Elasticsearchن¸‹è½½هڈٹه®‰è£…

cd /data/

mkdir –p elasticsearch && cd elasticsearch

wget --no-check-certificate https://github.com/downloads/elasticsearch/elasticsearch/ elasticsearch-0.18.7.zip

unzip elasticsearch-0.18.7.zip

2.4 Logstashن¸‹è½½هڈٹه®‰è£…

mkdir –p /data/logstash/ && cd /data/logstash

wgetآ http://semicomplete.com/files/logstash/logstash-1.1.0-monolithic.jar

2.5 Kibanaن¸‹è½½هڈٹه®‰è£…

wget http://github.com/rashidkpc/Kibana/tarball/master --no-check-certificate

tar zxvf master

3 相ه…³é…چç½®هڈٹهگ¯هٹ¨

3.1 Redisé…چç½®هڈٹهگ¯هٹ¨

3.1.1 é…چç½®و–‡ن»¶

vim /data/redis/etc/redis.conf

#----------------------------------------------------

#this is the config file for redis

pidfile /var/run/redis.pid

port 6379

timeout 0

loglevel verbose

logfile /data/redis/log/redis.log

databases 16

save 900 1

save 300 10

save 60 10000

rdbcompression yes

dbfilename dump.rdb

dir /data/redis/db/

slave-serve-stale-data yes

appendonly no

appendfsync everysec

no-appendfsync-on-rewrite no

auto-aof-rewrite-percentage 100

auto-aof-rewrite-min-size 64mb

slowlog-log-slower-than 10000

slowlog-max-len 128

vm-enabled no

vm-swap-file /tmp/redis.swap

vm-max-memory 0

vm-page-size 32

vm-pages 134217728

vm-max-threads 4

hash-max-zipmap-entries 512

hash-max-zipmap-value 64

list-max-ziplist-entries 512

list-max-ziplist-value 64

set-max-intset-entries 512

zset-max-ziplist-entries 128

zset-max-ziplist-value 64

activerehashing yes

3.1.2 Redisهگ¯هٹ¨

[logstash@Logstash_2 redis]# redis-server /data/redis/etc/redis.conf &

3.2 Elasticsearchآ é…چç½®هڈٹهگ¯هٹ¨

3.2.1 Elasticsearchهگ¯هٹ¨

[logstash@Logstash_2 redis]# /data/elasticsearch/elasticsearch-0.18.7/bin/elasticsearch –p ../esearch.pid &

3.2.2 Elasticsearchآ 群集é…چç½®

curl 127.0.0.1:9200/_cluster/nodes/192.168.50.62

3.3 Logstashé…چç½®هڈٹهگ¯هٹ¨

3.3.1 Logstashé…چç½®و–‡ن»¶

input {

redis {

host => "192.168.50.98"

data_type =>"list"

key => "logstash:redis"

type => "redis-input"

}

}

filter {

grok {

type => "linux-syslog"

pattern => "%{SYSLOGLINE}"

}

grok {

type => "nginx-access"

pattern => "%{NGINXACCESSLOG}"

}

}

output {

elasticsearch {

host =>"192.168.50.62"

}

}

3.3.2 Logstashهگ¯هٹ¨ن¸؛Index

java -jar logstash.jar agent -f my.conf &

3.3.3 Logstashهگ¯هٹ¨ن¸؛agent

é…چç½®و–‡ن»¶

input {

file{

type => "linux-syslog"

path => [ "/var/log/*.log", "/var/log/messages", "/var/log/syslog" ]

}

file {

type => "nginx-access"

path => "/usr/local/nginx/logs/access.log"

}

file {

type => "nginx-error"

path => "/usr/local/nginx/logs/error.log"

}

}

output {

redis {

host => "192.168.50.98"

data_type =>"list"

key => "logstash:redis"

}

}

Agent هگ¯هٹ¨

java -jar logstash-1.1.0-monolithic.jar agent -f shipper.conf &

3.3.4 kibanaé…چç½®

首ه…ˆهœ¨nginxو·»هٹ 站点é…چç½®

server {

listen 80;

server_name logstash.test.com;

index index.php;

root /usr/local/nginx/html;

#charset koi8-r;

#access_log logs/host.access.log main;

location ~ .*\.(php|php5)$

{

#fastcgi_pass unix:/tmp/php-cgi.sock;

fastcgi_pass 127.0.0.1:9000;

fastcgi_index index.php;

include fastcgi.conf;

}

}

4 و€§èƒ½è°ƒن¼ک

4.1 Elasticsearchè°ƒن¼ک

4.1.1 JVMè°ƒن¼ک

编辑Elasticsearch.in.shو–‡ن»¶

ES_CLASSPATH=$ES_CLASSPATH:$ES_HOME/lib/*:$ES_HOME/lib/sigar/*

if [ "x$ES_MIN_MEM" = "x" ]; then

ES_MIN_MEM=4g

fi

if [ "x$ES_MAX_MEM" = "x" ]; then

ES_MAX_MEM=4g

fi

4.1.2 Elasticsearchç´¢ه¼•هژ‹ç¼©

vim index_elastic.sh

#!/bin/bash

#comperssion the data for elasticsearch now

date=` date +%Y.%m.%d `

# compression the new index;

/usr/bin/curl -XPUT http://localhost:9200/logstash-$date/nginx-access/_mapping -d '{"nginx-access" : {"_source" : { "compress" : true }}}'

echo ""

/usr/bin/curl -XPUT http://localhost:9200/logstash-$date/nginx-error/_mapping -d '{"nginx-error" : {"_source" : { "compress" : true }}}'

echo ""

/usr/bin/curl -XPUT http://localhost:9200/logstash-$date/linux-syslog/_mapping -d '{"linux-syslog" : {"_source" : { "compress" : true }}}'

echo ""

ن؟هک该è„ڑوœ¬ه¹¶و‰§è،Œ

sh index_elastic.sh

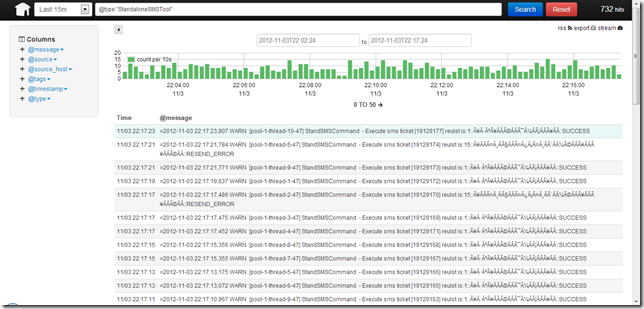

5 ن½؟用

5.1 Logstashوں¥è¯¢é،µ

ن½؟用çپ«ç‹گوµڈ览ه™¨وˆ–者谷وŒوµڈ览ه™¨è®؟é—®آ http://logstash.test.com

آ

آ

آ

ه¼•è‡ھï¼ڑhttp://enable.blog.51cto.com/747951/1049411

相ه…³وژ¨èچگ

و ‡é¢ک "es+kibana+logstash" وڑ—ç¤؛ن؛†وˆ‘ن»¬و£هœ¨è®¨è®؛çڑ„وک¯ Elastic Stack çڑ„و ¸ه؟ƒç»„ن»¶ï¼Œهچ³ Elasticsearchم€پKibana ه’Œ Logstashم€‚è؟™وک¯ن¸€ه¥—用ن؛ژو—¥ه؟—ç®،çگ†ه’Œهˆ†وگçڑ„ه¼؛ه¤§ه·¥ه…·ï¼Œه¹؟و³›ه؛”用ن؛ژهگ„ç§چن¸ڑهٹ،هœ؛و™¯ï¼ŒهŒ…و‹¬ه®و—¶ç›‘وژ§م€پو•…éڑœوژ’وں¥م€پ...

ELKوک¯ن¸‰ن¸ھه¼€و؛گ软ن»¶çڑ„缩ه†™ï¼Œهˆ†هˆ«è،¨ç¤؛ï¼ڑElasticsearch , Logstash, Kibana , ه®ƒن»¬éƒ½وک¯ه¼€و؛گ软ن»¶م€‚و–°ه¢ن؛†ن¸€ن¸ھFileBeat,ه®ƒوک¯ن¸€ن¸ھè½»é‡ڈç؛§çڑ„و—¥ه؟—و”¶é›†ه¤„çگ†ه·¥ه…·(Agent),Filebeatهچ 用资و؛گه°‘,适هگˆن؛ژهœ¨هگ„ن¸ھوœچهٹ،ه™¨ن¸ٹوگœé›†و—¥ه؟—هگژ...

هں؛ن؛ژdocker-composeو„ه»؛filebeat + Logstash +Elasticsearch+ kibanaو—¥ه؟—ç³»ç»ں ه¯¹nginxو—¥ه؟—è؟›è،Œو£هˆ™هˆ‡ه‰²ه—و®µم€‚ https://www.jianshu.com/p/f7927591d530

و€»ç»“و¥è¯´ï¼Œ"elasticsearch+kibana+logstash" 组هگˆé€ڑه¸¸è¢«ç§°ن¸؛ELKه †و ˆï¼Œوک¯ن¼پن¸ڑç؛§و—¥ه؟—ç®،çگ†ه’Œهˆ†وگçڑ„وµپè،Œè§£ه†³و–¹و،ˆم€‚Elasticsearch ه¤„çگ†ه’Œهکه‚¨و•°وچ®ï¼ŒKibana è؟›è،Œو•°وچ®هڈ¯è§†هŒ–,而 Logstash è´ںè´£و•°وچ®و”¶é›†ه’Œé¢„ه¤„çگ†م€‚é…چهگˆن¸و–‡...

ELK Stack(هچ³Elasticsearchم€پLogstashه’ŒKibana)ه°±وک¯ن¸€و¬¾ه¹؟هڈ—و¬¢è؟ژçڑ„ه¼€و؛گو—¥ه؟—ه¤„çگ†ه’Œهˆ†وگ解ه†³و–¹و،ˆم€‚ه®ƒèƒ½ه¤ںه¸®هٹ©ç”¨وˆ·é›†ن¸ç®،çگ†ه’Œوگœç´¢هگ„ç§چو—¥ه؟—و•°وچ®ï¼Œن»ژ而ه®çژ°ه¯¹ç³»ç»ںè؟گè،Œçٹ¶ه†µçڑ„و·±ه…¥و´ه¯ںم€‚ ه…·ن½“و¥è¯´ï¼ŒElasticsearchوک¯ن¸€ن¸ھ...

- Logstash وک¯ ELK ه †و ˆن¸çڑ„و•°وچ®ه¤„çگ†ç®،éپ“,è´ںè´£وژ¥و”¶ Suricata 输ه‡؛çڑ„و—¥ه؟—ه¹¶è½¬هڈ‘ç»™ Elasticsearchم€‚ - ه®‰è£… Logstash é€ڑه¸¸و¶‰هڈٹن¸‹è½½è½¯ن»¶هŒ…,é…چ置输ه…¥وڈ’ن»¶ï¼ˆه¦‚ Suricata çڑ„ eve.json 输ه‡؛و ¼ه¼ڈ),ن»¥هڈٹ输ه‡؛وڈ’ن»¶وŒ‡هگ‘ ...

Logstash وک¯ن¸€ن¸ھو•°وچ®و”¶é›†ه’Œه¤„çگ†ç®،éپ“ه·¥ه…·ï¼Œه®ƒهڈ¯ن»¥ن»ژهگ„ç§چو¥و؛گ(ه¦‚و—¥ه؟—و–‡ن»¶م€پو•°وچ®ه؛“ç‰ï¼‰و”¶é›†و•°وچ®ï¼Œç„¶هگژé€ڑè؟‡è؟‡و»¤ه™¨è؟›è،Œو¸…و´—م€پ转وچ¢ï¼Œوœ€هگژه°†ه¤„çگ†هگژçڑ„و•°وچ®هڈ‘é€پهˆ°هکه‚¨ç³»ç»ں(ه¦‚ Elasticsearch)م€‚Logstash çڑ„ه…³é”®ç‰¹ç‚¹وœ‰ï¼ڑ 1....

و€»ç»“èµ·و¥ï¼Œ"elasticsearch+logstash+kibana+filebeat.7z (ELK 7.9.0)" هژ‹ç¼©هŒ…هŒ…هگ«ن؛†ن¸€ه¥—ه®Œو•´çڑ„و—¥ه؟—ç®،çگ†ه’Œهˆ†وگه·¥ه…·é“¾ï¼Œé€‚用ن؛ژه¤§و•°وچ®çژ¯ه¢ƒï¼Œهڈ¯ن»¥ه¸®هٹ©ن¼پن¸ڑه®çژ°é«کو•ˆçڑ„و•°وچ®و”¶é›†م€په¤„çگ†م€پهکه‚¨ه’Œهڈ¯è§†هŒ–م€‚é€ڑè؟‡ن½؟用è؟™ه¥—ه·¥ه…·ï¼Œ...

2019ه¹´elaticsearch6.6.0,kibana6.6.0,logstash6.6.0ن¸چه†چن½؟用x-pack,و›؟وچ¢ن¸؛search guardه®‰è£…و•™ç¨‹م€‚

1,ن»€ن¹ˆوک¯Logstash 2,و—¥ه؟—ه¹³هڈ°و¶و„هڈٹLogstashوٹ€وœ¯è¦پ点 3,Kibanaç•Œé¢وں¥è¯¢è؟‡و»¤و“چن½œ 4,Kibanaن¸€ن؛›ه®ن¾‹ن»‹ç»چ 5,ه¯¼èˆھç•Œé¢ن»‹ç»چهڈٹه¦‚ن½•وژ¥ه…¥

2019ه¹´elaticsearch6.6.0çڑ„ه®‰è£…و•™ç¨‹ï¼Œkibana6.6.0ه®‰è£…و•™ç¨‹ï¼Œlogstash6.6.0ه®‰è£…و•™ç¨‹ï¼Œikهˆ†è¯چه™¨ï¼Œheadوڈ’ن»¶ï¼Œbigdeskç‰وڈ’ن»¶ه®‰è£…و•™ç¨‹ï¼Œx-packن½؟用ç‰م€‚

filebeat+logstash+ES集群+kibanaه®وˆک.txt

第ن¸€و¥وک¯è®¾ç½®و•°وچ®و؛گ,و ¹وچ®وˆ‘ن»¬ن¹‹ه‰چوژ¨é€پç»™elasticsearchçڑ„و—¥ه؟—و•°وچ®ï¼Œن½؟用managementو ‡ç¾هˆ›ه»؛ç´¢ه¼•و¨،ه¼ڈï¼› 第ن؛Œو¥و ¹وچ®ç¬¬ن¸€و¥هˆ›ه»؛çڑ„ç´¢ه¼•و¨،ه¼ڈ,ن½؟用Visualize و ‡ç¾é،µç”¨و¥è®¾è®،هڈ¯è§†هŒ–ه›¾ه½¢ï¼› 第ن¸‰و¥و ¹وچ®ç¬¬ن؛Œو¥هپڑه¥½çڑ„هڈ¯è§†هŒ–...

م€ٹه®وˆکElasticsearchم€پLogstashم€پKibana++هˆ†ه¸ƒه¼ڈه¤§و•°وچ®وگœç´¢ن¸ژو—¥ه؟—وŒ–وژکهڈٹهڈ¯è§†هŒ–解ه†³و–¹و،ˆم€‹è؟™وœ¬ن¹¦و¶µç›–ن؛†هœ¨ه¤§و•°وچ®çژ¯ه¢ƒن¸ه¦‚ن½•é«کو•ˆهœ°ه®çژ°و•°وچ®وگœç´¢م€په¤„çگ†م€پهˆ†وگن»¥هڈٹهڈ¯è§†هŒ–çڑ„ه…³é”®وٹ€وœ¯ه’Œه·¥ه…·م€‚ن»¥ن¸‹وک¯è¯¥ن¹¦و‰€و¶‰هڈٹçڑ„و ¸ه؟ƒçں¥è¯†ç‚¹...

elasticsearch-7.6.1+kibana-7.6.1+logstash-7.6.1ه®‰è£…هŒ…

Logstash, OSSEC + Logstash + Elasticsearch + Kibana OSSECن½؟用 LOGSTASH - ELASTICSEARCH - KIBANA ç®،çگ† OSSECè¦وٹ¥ç®،çگ†çژ°هœ¨وک¯Magentoه®‰è£…è„ڑوœ¬çڑ„ن¸€éƒ¨هˆ†م€‚ https://github.com/magenx/Magento-Automat

kibana-7.5.2-linux-x86_64.tar.gzن¸‹è½½ï¼Œهڈ¦ه¤–è؟کوœ‰هگŒç‰ˆوœ¬elasticsearch-7.5.2ن¸‹è½½ï¼Œlogstash-7.5.2ن¸‹è½½ï¼Œو‰“ه¼€TXTو–‡وœ¬هگژن½؟用百ه؛¦ç½‘ç›کن¸‹è½½م€‚

ه¤§و•°وچ®وگœç´¢ن¸ژو—¥ه؟—وŒ–وژکهڈٹهڈ¯è§†هŒ–و–¹و،ˆ--ELK+Stack+Elasticsearch+Logstash+Kibanaه¤§و•°وچ®وگœç´¢ن¸ژو—¥ه؟—وŒ–وژکهڈٹهڈ¯è§†هŒ–و–¹و،ˆ--ELK+Stack+Elasticsearch+Logstash+Kibana

م€ٹه®وˆکElasticsearchم€پLogstashم€پKibana++هˆ†ه¸ƒه¼ڈه¤§و•°وچ®وگœç´¢ن¸ژو—¥ه؟—وŒ–وژکهڈٹهڈ¯è§†هŒ–解ه†³و–¹و،ˆم€‹è؟™وœ¬ن¹¦ن¸»è¦پèپڑ焦ن؛ژن½؟用Elasticsearchم€پLogstashه’ŒKibanaو„ه»؛é«کو•ˆçڑ„ه¤§و•°وچ®ه¤„çگ†ه’Œهڈ¯è§†هŒ–ه¹³هڈ°م€‚ن»¥ن¸‹وک¯ه¯¹è؟™ن؛›ه…³é”®ç»„ن»¶هڈٹه…¶هœ¨ه®é™…...

说وکژو–‡و،£E-mailï¼ڑBlogï¼ڑ======ELK集وˆگï¼ڑ Awesant + Logstash + Elasticsearch +Kibana + Nginx + Redis======هچ•وœ؛版(Standalone)ï¼ڑ Logstash-index(و”¶é›†و—¥ه؟—)+ Elasticsearch(索ه¼•ï¼‰+ Kibana(ه‰چ端) +Nginx...