ÈÉëÊòÄÁºñËëóÔºåÊñáÂ≠ó˵ÑÊñôÊù•Ëᙉ∫éºÝÂ∏Ü„ÄÅÁôΩ‰øäÂçé„ÄÅÂàòÈ£ûÂÆቪ•ÂèäÁΩëÁªú˵ÑÊñô Âàõª∫‰∫é2015/10/21 ÊúÄÂêéÊõ¥Êñ∞‰∫é2015/10/29

关键词:Docker,容器,持续集成,持续发布,CI,私有云

本文档适用人员:广义上的技术人员

提纲:

- 集装箱还是卷挂载?

- Host Networking 还是 Bridge Networking?

- 容器要固定IP吗?

- 容器内部如何获取宿主机的IP?

- 待续

¬Ý ȶñÂÖàÔºå‰ΩÝ˶ÅÊòéÁôΩÂÆπÂô®Âπ∂‰∏çÊòØËôöÊãüÊú∫ÔºåËôΩÁÑ∂ÂÆÉÂè؉ª•ËߣÂÜ≥ËôöÊãüÊú∫ËÉΩ§üËߣÂÜ≥ÁöÑÈóÆÈ¢òÔºåÂêåÊó∂‰πüËÉΩ§üËߣÂÜ≥ËôöÊãüÊú∫Á∫é˵ÑÊ∫ê˶ÅʱÇËøáÈ´òËÄåÊóÝÊ≥ïËߣÂÜ≥ÁöÑÈóÆÈ¢òÔºå‰ΩÜÂÆÉÁúüÁöщ∏çÊòØËôöÊãüÊú∫„Äljª•ÂæÄÊà뉪¨ÁöѺÄÂèë„ÄÅÈÖçÁΩÆÁÆ°ÁêÜ„ÄÅÈÉ®ÁΩ≤ÂèëÂ∏É„ÄÅÁõëÊéßÊä•Ë≠¶ÊÄùË∑ØÈÉΩ˶ÅË∑üÁùÄÂèò„ÄÇ

¬Ý ÂÖ∂ʨ°Ôºå‰∏ĺÄÂßãÊ≥®ÂÆöÂè™Êúâ‰∏ÄÂ∞ëÈÉ®ÂàÜÂ∑•Á®ãËøÅÁߪÂà∞ÂÆπÂô®ÁßÅÊúâ‰∫ë‰∏äÔºåÊó¢ÁÑ∂ËøòÊúâ§ß§öÊï∞Â∫îÁî®ÊúçÂä°ËøòÂú®ËôöÊãüÊú∫ÊàñÁâ©ÁêÜÊú∫‰∏äÔºåÈÇ£‰πàÂÆɉª¨‰πãÈó¥Â¶Ç‰ΩïÈÄöËÆØÂ∞±Êàê‰∫܉∏ĉ∏™ÂøÖÈ°ªËߣÂÜ≥ÁöÑÈóÆÈ¢ò„ÄÇ

¬Ý ÈÇ£‰πàÔºåÊà뉪¨Âú®ÊûѪ∫Âü∫‰∫éÂÆπÂô®ÁöÑÁßÅÊúâ‰∫뉪•ÂèäÁõ∏Â∫îÁöÑÊåÅÁª≠ÂèëÂ∏ÉÊó∂ÔºåÈÅáÂà∞Âπ∂ËߣÂÜ≥‰∫ÜÂ왉∫õÈóÆÈ¢òÂë¢Ôºü

¬Ý

0x00¬ÝÈõÜË£ÖÁƱËøòÊòØÂç∑ÊåÇËΩΩÔºü

¬Ý ÂÖàÊäõÂá∫ÈóÆÈ¢òÔºå‰∏ãÈù¢Ëøô‰∏™ÈÄâÊã©È¢ò‰ΩÝÊÄé‰πàÈÄâÔºö

|

¬Ý

¬Ý¬Ý![]()

¬Ý

¬Ý

¬Ý ‰∏ÄËâòÈ≤∏ȱºÂ§ßËàπÔºåËΩΩÁùÄÊóÝÊï∞ÈõÜË£ÖÁƱ„ÄÇÊìç‰ΩúÁ≥ªÁªüÂ∞±ÊòØËøôËâòË¥ßËΩÆÔºåÊØè‰∏ĉ∏™ÂÆπÂô®Â∞±Êò؉∏ĉ∏™ÈõÜË£ÖÁƱԺå‰∫§‰ªòËøêË°åÁéآɶÇÂêåʵ∑Ëøê„ÄǧßÂÆ∂Áü•ÈÅìÂêóÔºåÈõÜË£ÖÁƱÁöÑËã±ÊñáÂçïËØçÂ∞±ÊòØ containerÔºÅ

¬Ý ÈõÜË£ÖÁƱÊú≪ĉπà•Ω§ÑÔºü

- ËßÑÊݺÊÝáÂáÜÔºåÂú®Ê∏ØÂè£ÂíåËàπ‰∏äÂè؉ª•Â±ÇÂèÝÊëÜÊîæÔºåËäÇÁúŧßÈáèÁ©∫Èó¥Ôºå

- 可以进行快速装卸,并可从一种运输工具方便地换装到另一种运输工具,

- 途中转运不用移动箱内货物,就可以直接换装,

- 货物的装满和卸空很方便。

¬Ý

¬Ý ÈÇ£‰πàÔºå‰∏äÈù¢ÁöÑÈÄâÊã©È¢ò¶ljΩïÂõûÁ≠îÂë¢Ôºü

¬Ý Ë߶ÊéßÁßëÊäÄËøêÁª¥Ë¥üË¥£‰∫∫ËêßÁî∞ÂõΩËƧ‰∏∫ÔºåÊä䉪£ÁÝÅÊîæÂú®ÂÆø‰∏ªÊú∫‰∏äÔºåËÆ©ÂÆπÂô®ÈÄöËøáÂç∑ÁªÑÊòÝÂ∞ÑÊù•ËتÂèñÔºå‰∏çª∫ËÆÆÈááÁî®ËøôÁßçÊñπÊ°àÔºåÂéüÂõÝÊòØÔºåÂ∞܉ª£ÁÝÅÊãÜÂàÜÂá∫ÂÆπÂô®ÔºåËøôËøùËÉå‰∫Ü Docker ÁöÑÈõÜË£ÖÁƱÂéüÂàôÔºö

- 从货运工人角度考虑,整体才是最经济的。

- Ëøô‰πüÂغËá¥Ë£ÖÂç∏§çÊùÇÂ∫¶Â¢ûÂäÝ„ÄǬÝ

¬Ý ÊàñËÄÖËØ¥ÔºåÂÆπÂô®Êó∂‰ª£Ôºå‰∏ÄÂàáÁâàÊú¨ÂåñÔºåÊäõºÉËøáÂéªÊñቪ∂ÂàÜÂèëÁöÑÊÄùÊÉ≥ÔºåÊâçÊòØÊ≠£ÈÄîÔºåËøôÊÝ∑‰πüÊâçËÉΩÂÆûÁé∞ÁúüÊ≠£ÊÑè‰πâ‰∏äÁöÑÂÆπÂô®Á∫ßËøÅÁߪ„ÄÇ

¬Ý

¬Ý Êà뉪¨ÊòØÊÄé‰πàËÄÉËôëÁöÑÂë¢Ôºü

¬Ý ÂÅáÂÆöÊò؉ª£ÁÝÅÂíå Image ÂàܺÄÁöÑÂú∫ÊôØÔºå‰∏ªË¶ÅÊúâ‰∏§ÁßçÂÆûÁé∞ÊñπºèÔºö

- ‰ª£ÁÝÅÊîæÂà∞ slave ËäÇÁÇπÁöÑÊú¨Âú∞Á£ÅÁõòÔºöÈÇ£‰πàÂøÖÈ°ªË¶ÅÊúâ‰∏ÄÁßçÊú∫Âà∂ÔºåÊù•Á°Æ‰øùÊØèÂè∞ slave ‰∏䉪£ÁÝÅÂåÖÁâàÊú¨Áöщ∏ÄËá¥ÊÄßÔºåËÄå‰∏îÂØπ‰∫éÁ£ÅÁõòÁ©∫Èó¥ÂíåÁΩëÁªúÂàÜÂèëÊù•ËÆ≤‰πüÊò؉∏ÄÁßçʵ™Ë¥πÔºàËÄÉËôë‰∏ĉ∏ã 100 Âè∞ slaveÔºåÂÖ∂‰∏≠ÂèØËÉΩÂè™Êúâ 10 Âè∞ÈúÄ˶ÅËøêË°åËøô‰∏™ÁâàÊú¨Áöщª£ÁÝÅÔºâ¬Ý

- ‰ª£ÁÝÅÊîæÂà∞ÂàÜÂ∏ɺèÂÖ±‰∫´Êñቪ∂Á≥ªÁªüÔºà如 cephÔºâÔºöÂÆÉÂÄíÊòØËߣÂÜ≥‰∫ÜÊï∞ÊçÆËøáÂ∫¶ÂÜó‰Ωô‰ª•Âèä‰∏ÄËá¥ÊÄßÁöÑÈóÆÈ¢òÔºå‰ΩÜÂàÜÂ∏ɺèÂÖ±‰∫´Êñቪ∂Á≥ªÁªüÊú¨Ë∫´Êàê‰∏∫‰∫Ü„ÄéÂçïÁÇπ„ÄèÔºåËôΩÁÑ∂Âè؉ª•ËÆæÁΩƧö‰∏™ÂâØÊú¨„ÄÇÂÆÉÁöÑÊÄßËÉΩÂíåÂèØÈùÝÊÄßÈÉΩÂøÖÈ°ªÂæóÂà∞ÂÖÖÂà܉øùÈöúÊâçË°å„ÄǬÝ

¬Ý

¬Ý Âú®ÂÆπÂô®‰∫ë‰πãÂâçÔºåÊà뉪¨ÈááÁî®ÁöÑÊòØÂü∫‰∫é OpenStack ÁöÑËôöÊãüÊú∫ÁÆ°ÁêÜÊñπÊ°à„ÄÇÂú®Á∫ø‰∏ãÁéØ¢ÉÁî® OpenStack Êó∂ÔºåÊà뉪¨Â∞ÜÊâÄÊúâÁöÑËôöÊãüÊú∫ÊîæÁΩÆÂà∞ cephÔºàÊ≥®ÔºöLinux PB Á∫ßÂàÜÂ∏ɺèÊñቪ∂Á≥ªÁªüԺ⠉∏äÔºå‰ΩÜÊòØÁ∫éÁ∫ø‰∏ã ceph ËäÇÁÇπ§™Â∞ëÔºåÂçïËäÇÁÇπÂá∫ÈóÆÈ¢òÊó∂ÂΩ±ÂìçËæɧ߄ÄÇÊØèʨ° ceph Âá∫Áé∞ÈóÆÈ¢òÔºåÊâÄÊúâÁöÑËôöÊãüÊú∫ÈÉΩÁâπÂà´ÊÖ¢„ÄÇ

¬Ý Êù•Âà∞‰∫ÜÂÆπÂô®Êó∂‰ª£Ôºå¶ÇÊûúËøòÊä䉪£ÁÝÅÊîæÁΩÆÂà∞ ceph ‰∏äÔºåÂØπ ceph Áöщæù˵ñ§™È´ò‰∫ÜÔºåceph ‰∏ÄÊó¶ÊúâÈóÆÈ¢òÔºåÊúâÂèØËÉΩ‰ΩøÁ∫Ü ceph ÁöÑÊâÄÊúâÂÆπÂô®ÈÉΩ‰ºöÂá∫ÈóÆÈ¢ò „ÄÇÁ∫ø‰∏ä‰∏öÂä°‰∏ªË¶ÅËÄÉËôëÁöÑÊòØÊÄßËÉΩÔºàÂÆπÂô®Êú¨Âú∞Ëøê˰剪£ÁÝÅ vs ÈÄöËøáÁΩëÁªúËé∑Âèñ‰ª£ÁÝÅÔºâÂíåÂèØÈùÝÊÄßÔºàÊØè‰∏™ slave ÈÉΩÊú¨Âú∞ËøêË°åÂÆπÂô® vs ÊâÄÊúâÂÆπÂô®‰æù˵ñÂÖ±‰∫´Êñቪ∂Á≥ªÁªüÔºâÔºåÁªìËÆ∫‰∏çË®ÄËÄåÂñª„ÄÇÊâĉª•‰∏ĺÄÂßãÂÜ≥Á≠ñÊó∂ÔºåÊ≤°Êï¢Êä䉪£ÁÝÅÊîæÂú® ceph ‰∏äÔºåËÄåÊòØÊîæÂú®ÈïúÂÉèÈáå„ÄÇÊâĉª•Êà뉪¨ÈÄâÁöÑÊòØÊñπÊ°à2Ժ剪£ÁÝÅÂú®ÈïúÂÉèÈáå„ÄÇ

¬Ý Âú®Êà뉪¨ÁöÑÂú∫ÊôØÈáåÔºåÈïúÂÉ艺öË¢´‰∏ãËΩΩÂà∞ mesos slave Áâ©ÁêÜÊú∫ÁöÑÊú¨Âú∞Á£ÅÁõò‰∏äÔºåÊâĉª•ÂêØÂä®ÂÆπÂô®Êó∂ËتÁöÑÊòØÊú¨Âú∞Á£ÅÁõò„ÄÇ

¬Ý

¬Ý §öËØ¥‰∏ÄÂè•ÔºåQunar Á≠âÂÖ¨Âè∏Âú®2014Âπ¥ÈÄâÊã©ÁöÑÊòØÂç∑ÊåÇËΩΩÊñπÊ°àÔºå‰∏öÁïå‰πüÊúâ‰∫∫ËƧ‰∏∫ÔºåËøô‰∫ãÂÑøÂæóÂàÜÁéØ¢ÉÂÖ∑‰ΩìÈóÆÈ¢òÂÖ∑‰ΩìÂàÜÊûêÔºåºÄÂèëÈõÜÊàêÁéØ¢ÉÂíåÁîü‰∫ßÁéØ¢ÉÂèØËÉΩÂ∞±‰∏ç‰∏ÄÊÝ∑„ÄÇ

¬Ý

0x01¬ÝHost Networking ËøòÊòØ Bridge NetworkingÔºü

网络基础

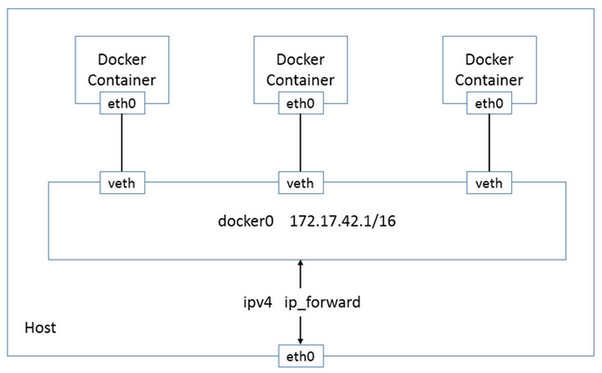

¬Ý Docker Áé∞ÊúâÁöÑÁΩëÁªúÊ®°Âûã‰∏ªË¶ÅÊòØÈÄöËøá‰ΩøÁî® Network namespace„ÄÅLinux Bridge„ÄÅiptables„ÄÅveth pair Á≠âÊäÄÊúØÂÆûÁé∞ÁöÑ„ÄÇÔºàÂá∫§Ñ8Ôºâ- Network namespaceÔºöÂÆɉ∏ªË¶ÅÊèê‰æõ‰∫ÜÁΩëÁªú˵ÑÊ∫êÁöÑÈöîÁ¶ªÔºåÂåÖÊã¨ÁΩëÁªúËÆæ§á„ÄÅIPv4/IPv6 ÂçèËÆÆÊÝà„ÄÅIP Ë∑ØÁî±Ë°®„ÄÅÈò≤ÁŴ¢ô„ÄÅ/proc/net ÁõÆÂΩï„ÄÅ/sys/class/net ÁõÆÂΩï„ÄÅÁ´ØÂè£ÔºàsocketÔºâÁ≠â„ÄÇ

- Linux Bridge:功能相当于物理交换机,为连在其上的设备(容器)转发数据帧,如 docker0 网桥。

- Iptables:主要为容器提供 NAT 以及容器网络安全。

- veth pair:两个虚拟网卡组成的数据通道。在 Docker 中,用于连接 Docker 容器和 Linux Bridge。一端在容器中作为 eth0 网卡,另一端在 Linux Bridge 中作为网桥的一个端口。

¬Ý

容器的网络模式

¬Ý¬Ý Áî®Êù•ËÆæÁΩÆÁΩëÁªúÊé•Âè£ÁöÑ docker run --net ÂëΩ‰ª§ÔºåÂÆÉÁöÑÂèØÁî®ÂèÇÊï∞ÊúâÂõõ‰∏™Ôºö

- none:关闭了 container 内的网络连接。容器有独立的 Network namespace,但并没有对其进行任何网络设置,如分配 veth pair 和网桥连接,配置 IP 等。

- bridge:通过 veth 接口来连接其他 container。这是 docker 的默认选项。

- hostÔºöÂÖÅËÆ∏ container ‰ΩøÁî® host ÁöÑÁΩëÁªúÂÝÜÊÝà‰ø°ÊÅØ„ÄÇÂÆπÂô®ÂíåÂÆø‰∏ªÊú∫ÂÖ±‰∫´ Network namespace„ÄÇ

- containerÔºö‰ΩøÁî®Âè¶Â§ñ‰∏ĉ∏™ container ÁöÑÁΩëÁªúÂÝÜÊÝà‰ø°ÊÅØ„ÄÇkubernetes ‰∏≠ÁöÑ pod Â∞±Êòاö‰∏™ÂÆπÂô®ÂÖ±‰∫´‰∏ĉ∏™ Network namespace„ÄÇ

¬Ý Âú® docker ȪòËƧÁöÑÁΩëÁªúÁéØ¢ɉ∏ãÔºåÂçïÂè∞‰∏ªÊú∫‰∏äÁöÑÂÆπÂô®Âè؉ª•ÈÄöËøá docker0 ÁΩëÊ°•Áõ¥Êé•ÈÄö‰ø°Ôºå¶lj∏ãÂõæÔºàÂõæ‰ΩúËÄÖÂÜØÊòéÊåØÔºâÊâÄÁ§∫Ôºö

¬Ý

¬Ý

¬Ý

¬Ý¬ÝËÄå‰∏çÂêå‰∏ªÊú∫‰∏äÁöÑÂÆπÂô®‰πãÈó¥Âè™ËÉΩÈÄöËøáÂú®‰∏ªÊú∫‰∏äÂÅöÁ´ØÂè£ÊòÝÂ∞ÑËøõË°åÈÄö‰ø°„ÄÇËøôÁßçÁ´ØÂè£ÊòÝÂ∞ÑÊñπºèÂØπÈõÜÁæ§Â∫îÁî®Êù•ËØ¥Êûʼn∏çÊñπ‰æø„ÄÇÔºàÂá∫§Ñ8ÔºâÊà뉪¨ÈáçÁÇπ˶ÅËߣÂÜ≥Ëøô‰∏™ÈóÆÈ¢ò„ÄÇ

¬Ý

¬Ý ÂÖàÁúã‰∏ĉ∏ãÂÖ∂‰ªñÂ≠¶ÁîüÊÄé‰πàÂÅöËøôÈÅìÈÄâÊã©È¢òÁöÑÔºö

|

公司

|

网络方案

|

备注

|

|

网易(2014)

|

tinc+quagga+pipework

|

Pipework 是对 Docker Bridge 的扩展,它由 200 多行 shell 脚本实现。通过使用 ip、brctl、ovs-vsctl 等命令来为 Docker 容器配置自定义的网桥、网卡、路由等。

|

|

CoreOS(2014)

|

flannel

|

flannel 属于隧道方案,UDP 广播,VxLan。

|

| 大众点评网(2015) |

Bridge Networking 工作在 level 2 的模式,使公共 IP 得以暴露出来,这部分是做了定制的

|

¬Ý

|

| 汽车之家(2015) |

Bridge Networking

|

¬Ý

|

|

去哪儿(2015)

|

Host Networking

|

『大吞吐量平台下,bridge 模式性能测试都偏低,于是选择了 host 模式』——20150915,徐磊

|

|

芒果TV(2015)

|

Macvlan

|

属于路由方案。『从逻辑和 Kernel 层来看隔离性和性能最优的方案,基于二层隔离,所以需要二层路由器支持,大多数云服务商不支持,所以混合云上比较难以实现』——20150505,彭哲夫

|

|

新浪微博(2015)

|

Host Networking

|

¬Ý

|

¬Ý

¬Ý ÂÖàËØ¥‰∏ĉ∏ã host Ê®°Âºè„ÄÇ

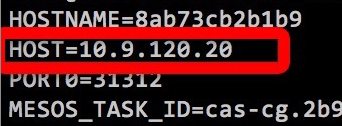

¬Ý ÂÆπÂô®ÁöÑÁΩëÁªúÁõ¥Êé•Âíå§ñÈÉ®ÁΩëÁªúÊâìÈÄöÔºåËߣÂÜ≥‰∫܉∏çÂêå slave Áâ©ÁêÜÊú∫‰πãÈó¥ÂÆπÂô®‰∫íËÅî‰∫íÈÄöÁöÑÈóÆÈ¢òÔºåÂáèÂ∞ë‰∫Ü NAT ËΩ¨Êç¢ÁöÑÊçüËÄóÔºå‰ΩÜÈúÄ˶ÅËá™Ë°åÊù•Áª¥Êä§ÂÆπÂô®ÁöÑ IP Âú∞ÂùÄÂíåÁ´ØÂè£ÔºåÂê¶Âàô‰ºöÂÜ≤Á™ÅÔºåËøô¢ûÂä݉∫ÜÁÆ°Áê܉∏äÁöѧçÊùÇÂ∫¶„ÄÇËØ∑ËÄÉËôëËøô‰∏™Âú∫ÊôØÔºöÂú®Âêå‰∏ĉ∏™ slave Áâ©ÁêÜÊú∫‰∏äËøêË°å‰∏§‰∏™ 80 Á´ØÂè£ Nginx ÂÆπÂô®ÁöÑÊÉÖÂܵԺåÈô§ÈùûÂàÜÈÖç‰∏§‰∏™‰∏çÂêåÁöÑ IP Âú∞ÂùÄÔºåËøôÁßçÊñπÊ°àÊà뉪¨‰πãÂâçÂú® shipyard ÊñπÊ°à‰∏≠‰ΩøÁî®Ëøá„ÄÇ

¬Ý Êñ∞ʵ™ÂæÆÂçöÂú®„Ää§ßËßÑÊ®°DockerÈõÜÁæ§Âä©ÂäõÂæÆÂçöËøéÊé•Êò•ÊôöÂ≥∞ÂĺÊåëÊàò„Äã‰∏ÄÊñá‰∏≠ÊõæÁªè‰ªãÁªçËøáÔºö

Docker ÈÉ®ÁΩ≤Ë¢´ËØüÁóÖÊúħöÂ∞±ÊòØÁΩëÁªúÔºåÂπ≥Âè∞ÁõÆÂâçÈááÁî®ÁöÑÊòØ host Ê®°ÂºèÔºå‰∏∫‰ªÄ‰πàÊ≤°ÊúâÈááÁî® NAT ÊàñËÄÖ Bridge Âë¢ÔºüÁ∫éÊ∂âÂèäÁöÑÊäÄÊúØÁªÜËäÇÊØîËæÉÁπÅÂÜóÔºåËøôÈá剪ÖÂà܉∫´‰∏ĉ∫õË∏©ËøáÁöÑÂùë„Äljæã如 NAT ‰ΩøÁî® iptables Â∫ï±ÇʵÅÈáèËΩ¨Âèë‰æùÈùÝÂÜÖÊÝ∏ netfilter Ê®°ÂùóÔºåÂÖ∂ȪòËƧ‰ªÖ‰øùÊåÅ 65536 ‰∏™ÈìæÊé•ÔºåÂú®ÊúçÂä°Êúâ§ßÈáèÈìæÊé•ÁöÑÂú∫Êô؉∏ãԺ剺öÂá∫Áé∞§ßÈáèÊãíÁªùÈìæÊé•ÁöÑÁé∞˱°„ÄÇÂÜç如 Bridge ÁöÑ MAC Âú∞ÂùÄȪòËƧÊòØÈÄâÊã©ÂÖ∂Â≠êÊé•Â裉∏≠ÊúÄÂÖàÁöщ∏ĉ∏™ÔºåËøôÊÝ∑Â∞±‰ºöÂغË᥉∏ĉ∏™ÂÆø‰∏ªÊú∫‰∏ã§ö‰∏™ÂÆπÂô®ÂêØÂÅúÊó∂Âá∫Áé∞ÁΩëÁªúÁû¨Êñ≠„ÄÇËøòÊúâÂæà§öÈóÆÈ¢ò‰∏ç‰∏ĉ∏ÄÂàó‰∏æÔºåÂπ≥Âè∞Êú™Êù•ËÆ°ÂàíÈááÁî® vlanif ÁöÑÊñπÊ°àÊù•ËߣÂÜ≥ÂÆπÂô®ÁΩëÁªúÈÉ®ÁΩ≤ÈöæÈ¢ò„ÄÇ

¬Ý

¬Ý ÂÜçÁúã bridge Ê®°ÂºèÔºåÂÆÉÊòØ docker ȪòËƧÁöÑÁΩëÁªúÊ®°ÂºèÔºå‰∏∫‰∫ÜËߣÂÜ≥ÂÆπÂô®Èó¥‰∫íÈÄöÈóÆÈ¢òÔºåÈÄöÂ∏∏Êúâ‰∏§ÁßçËߣÂÜ≥ÊñπÊ°àÔºö

- ÈááÁî® SDNÔºàËΩ؉ª∂ÂÆö‰πâÁΩëÁªúÔºâ ÊäÄÊúØÔºå如 flannelÔºåweave Á≠âÔºåÁõ¥Êé•Â∞ÜÂÆπÂô®ÂÜÖÁΩëÊâìÈÄöÔºõ¬Ý

- ÈááÁî® NATÔºàÁΩëÁªúÂú∞ÂùÄËΩ¨Êç¢Ôºâ ÊäÄÊúØÔºåÁõ¥Ê镉ΩøÁî® slave ‰∏ªÊú∫ÁöÑ IP Âú∞Âùĉ∫íÈÄö„ÄǬÝ

¬Ý Êà뉪¨ËƧ‰∏∫Ôºåbridge Ê®°ÂºèÂäÝ NAT ÊñπºèÔºåÊòØÂΩìÂâç mesos+marathon ÊîØÊåÅÁöÑÊúÄ•ΩÁöÑÊ®°ÂºèÔºàÈááÁî®ÁöÑÊòØ container portÔºåhost portÔºåservice port ÁöÑÂØπÂ∫îÂÖ≥Á≥ªÔºâ„ÄÇÊà뉪¨ÁöÑÂÆπÂô®‰∫ë‰∏ªË¶ÅÊûѪ∫‰∫é mesos+marathon ‰πã‰∏äÔºåÂ∞ÅË£Ö‰∫ÜÊà뉪¨Áöщ∏öÂä°ÈĪËæëÔºåÈááÁ∏ĉ∫õÊñπºèËߣÂÜ≥‰∫ÜÂÆπÂô®‰∏éÁé∞Â≠òÈùûÂÆπÂô®Êû∂ÊûщπãÈó¥Áöщ∫íÈÄöÈóÆÈ¢òÔºå¬Ý如 consul ÁöÑÊúçÂä°Ê≥®ÂÜåÂíåÂèëÁé∞Êú∫Âà∂Ôºådubbo ÁöÑÂ∫îÁî®Ê≥®ÂÜåÂíåÂèëÁé∞Êú∫Âà∂Á≠â„ÄǬÝ

¬Ý

¬Ý¬ÝÊúÄÁªàÊà뉪¨ÈÄâÊ㩉∫Ü Bridge Networking„ÄÇ

Docker网络模型以后如何发展

¬Ý Libnetwork ÊòØ Docker ÂÆòÊñπ 2015Âπ¥ÂàùÊé®Âá∫ÁöÑÈ°πÁõÆÔºåÊó®Âú®Â∞Ü Docker ÁöÑÁΩëÁªúÂäüËÉΩ‰ªé Docker ÊÝ∏Âøɉª£ÁÝʼn∏≠ÂàÜÁ¶ªÂá∫ÂéªÔºåÂΩ¢Êàê‰∏ĉ∏™ÂçïÁã¨ÁöÑÂ∫ì„ÄÇ Libnetwork ‰ª•Êè퉪∂ÁöÑÂΩ¢Âºè‰∏∫ Docker Êèê‰æõÁΩëÁªúÂäüËÉΩÔºå‰ΩøÂæóÁî®Êà∑Âè؉ª•ÊÝπÊçÆËá™Â∑±ÁöÑÈúÄʱÇÂÆûÁé∞Ëá™Â∑±ÁöÑ Driver Êù•Êèê‰æõ‰∏çÂêåÁöÑÁΩëÁªúÂäüËÉΩ„ÄÇ Libnetwork ÊâÄ˶ÅÂÆûÁé∞ÁöÑÁΩëÁªúÊ®°ÂûãÂü∫Êú¨ÊòØËøôÊÝ∑ÁöÑÔºö Áî®Êà∑Âè؉ª•Âàõª∫‰∏ĉ∏™Êàñ§ö‰∏™ÁΩëÁªúÔºà‰∏ĉ∏™ÁΩëÁªúÂ∞±Êò؉∏ĉ∏™ÁΩëÊ°•ÊàñËÄÖ‰∏ĉ∏™ VLAN ÔºâÔºå‰∏ĉ∏™ÂÆπÂô®Âè؉ª•ÂäÝÂÖ•‰∏ĉ∏™Êàñ§ö‰∏™ÁΩëÁªú„ÄÇ Âêå‰∏ĉ∏™ÁΩëÁªú‰∏≠ÂÆπÂô®Âè؉ª•ÈÄö‰ø°Ôºå‰∏çÂêåÁΩëÁªú‰∏≠ÁöÑÂÆπÂô®ÈöîÁ¶ª„ÄÇ Docker ÁΩëÁªúÁöÑÂèë±•ÂêéÂ∞±ÈÉΩÂú®Ëøô‰∏™È°πÁõƉ∏ä‰∫Ü„ÄÇ

¬Ý

0x02¬ÝÂÆπÂô®Ë¶ÅÂõ∫ÂÆöIPÂêóÔºü

¬Ý ȪòËƧÊÉÖÂܵ‰∏ãÔºåÂΩì docker ÂêØÂä®Êó∂ÔºåÂÆɉºöÂú®ÂÆø‰∏ªÊú∫Âô®‰∏äÂàõª∫‰∏ĉ∏™Âêç‰∏∫ docker0 ÁöÑËôöÊãüÁΩëÁªúÊé•Â裄ÄÇÂÆɉºö‰ªé RFC 1918 ÂÆö‰πâÁöÑÁßÅÊúâÂú∞Âùĉ∏≠ÈöèÊú∫ÈÄâÊ㩉∏ĉ∏™‰∏ªÊú∫‰∏çÁî®ÁöÑÂú∞ÂùÄÂíåÂ≠êÁΩëÊé©ÁÝÅÔºåÂπ∂Â∞ÜÂÆÉÂàÜÈÖçÁªô docker0„ÄÇÔºàÂá∫§Ñ9ÔºâÊâĉª•ÔºåÂÆπÂô®ÁöÑ IP ÊòØÂä®ÊÄÅÂèòÂåñÁöÑ„ÄÇ

¬Ý ‰∫éÊò؉πé§ßÂÆ∂‰∏ĺÄÂßãÊé•Ë߶ Docker Â∞±Á∫∑Á∫∑ÊèêÂá∫ÁªôÂÆπÂô®ÂàÜÈÖçÈùôÊÄÅ IP ÁöÑÈúÄʱDŽÄÇÁúã‰∏ĉ∏ãÂêѧßÂÖ¨Âè∏ÂÆπÂô®‰∫ëÊäÄÊúØÊÝàÂØπÊØîÔºåÂáÝÂÆ∂ÂéÜÂè≤ÂåÖË¢±ËæÉÈáçÁöÑÂÖ¨Âè∏ÈÉΩÈÄâÊ㩉∏çËÆ©‰∏ä±ÇÂ∫îÁî®ÊÑüÁü•Âà∞Â∫ï±ÇÊòØ VM ËøòÊòØÂÆπÂô®Ôºå¶Ç360/ÁÇπËØÑ/ʱΩËΩ¶‰πãÂÆ∂ÔºåÈÉΩÊîπ‰∫Üdocker ‰ª£ÁÝÅÔºåÂõ∫ÂÆö‰∫ÜÂÆπÂô® IP„ÄÇ

¬Ý docker ÂÆòÊñπÂØπÊ≠§ÈúÄʱÇÁöÑÊÄÅÂ∫¶ÊòØÔºåDocker maintainers prefers a more abstract way to separate user intent from operational intent. Based on this feedback and various other discussions on a flexible ip address management, we feel that having a pluggable IPAM will help a great deal.

¬Ý

If you’re using named Docker instances, then adding the IP address 10.40.33.21 to a Docker instance bind is as simple as:

pipework br0 bind 10.40.33.21/24If you want to route out of 10.40.33.1, change it to:

pipework br0 bind 10.40.33.21/24@10.40.33.1(出处:https://opsbot.com/advanced-docker-networking-pipework/)

¬Ý ËøôÊÝ∑ÁöÑËØùÔºåÈúÄ˶ÅÂú®ÂÆπÂô®ÂêØÂä®ÂêéÂú®ÂÆø‰∏ªÊú∫‰∏äËøêË°å pipework Êù•ËÆæÁΩÆÂÆπÂô®ÁöÑ ipÔºåËøôÊÝ∑Â∞±Â¢ûÂä݉∫ÜËá™Âä®ÂåñÁöÑÈöæÂ∫¶„ÄÇ

¬Ý

¬Ý Êà뉪¨ÁöÑËÄÉËôëÊòØÔºåÁ¨¨‰∏ÄÔºåÂÆπÂô®Â∫îËØ•ÊòØÊóÝÁä∂ÊÄÅÁöÑÔºåÂàÜÈÖçÂõ∫ÂÆö IP ËøùËÉå‰∫ÜËøô‰∏™ÁêÜÂøµÔºåÁ¨¨‰∫åÔºåDocker ÂàöÂá∫Êù•‰∏ĉ∏§Âπ¥ÔºåËøòÂú®È£ûÈÄüÂèë±ï‰∏≠ÔºåÁé∞Âú®‰ΩÝÊîπ‰∫ÜÂÜÖÊÝ∏‰ª£ÁÝÅÔºåÂ∞ÜÊù•ÂÆɧßÁâàÊú¨ÂçáÁ∫ßÔºå‰ΩÝÊÄé‰πàË∑üÈöèÔºüÁ¨¨‰∏âÔºå‰ΩøÁî®Âõ∫ÂÆö IP Âæà§ßÁ®ãÂ∫¶‰∏äÊò؉∏∫‰∫ÜËÆ©ÊäÄÊú؉∫∫ÂëòËÉΩÂÉ艪•Ââç‰∏ÄÊÝ∑Áõ¥Êé•ÁôªÂΩïËôöÊãüÊú∫Êìç‰ΩúÔºå‰ΩÜÊà뉪¨ÁöÑÊåÅÁª≠ÈõÜÊàêÁÆ°ÁêÜÂπ≥Âè∞Èáå‰ΩøÁî® webconsole ‰πüËÉΩÁôªÂà∞ÂÆπÂô®ÈáåÈù¢Êìç‰Ωú„ÄÇ

¬Ý

¬Ý Êà뉪¨ÁöÑÂÆûË∑µÊòØÔºöȶñÂÖàÔºåÊà뉪¨ÂÜÖÈÉ®Ë∞ÉÁî®ÈÉΩ˵∞ÂÜÖÈÉ®ÂüüÂêçÔºåÊúâ‰∏ìÈó®ÁöÑ DNS ServerÔºåÂÖ∂ʨ°ÔºåÊà뉪¨ÂæàÊ󩉪•ÂâçÂ∞±ÂºïÂÖ•‰∫ÜÊúçÂä°Ê≤ªÁêÜÊ°ÜÊû∂ DubboÔºåÂü∫Êú¨ÂÅöÂà∞‰∫ÜÊúçÂä°ÁöÑÊ≥®ÂÜåÂíåÂèëÁé∞„ÄÇÂÜçʨ°ÔºåÊà뉪¨Âú®ÂÆπÂô®‰∫ëÈáåºïÂÖ•‰∫Ü consul ÁöÑÊ≥®ÂÜåÂíåÂèëÁé∞ÊúçÂä°ÔºåÈÖçÂêà slave ËäÇÁÇπ‰∏äÁöÑ registrator ÂÆπÂô®Ôºå‰ª•Âèä haproxy Âíå consul-template ÁªÑ‰ª∂ÔºåÂÆûÁé∞‰∫ÜÂÆåÊï¥ÁöÑÂÆπÂô®ÊúçÂä°ÁöÑÊ≥®ÂÜåÂíåÂèëÁé∞Êû∂ÊûÑ„ÄǬݬÝ

¬Ý Á¨¨‰∏ÄÔºådubbo ËÉΩÂ∏ÆÊà뉪¨ËߣÂÜ≥‰ªÄ‰πàÂÆπÂô®ÈóÆÈ¢òÔºö

¬Ý ËøõÈ©ªÂÆπÂô®‰∫ëÂêé java Â∑•Á®ã‰πãÈó¥ÁöÑË∞ÉÁî®ÔºöÁõ¥Êé•Â∞ÜÁâ©ÁêÜÊú∫ÁöÑ ip ÂíåÂÆπÂô® java Â∑•Á®ãÂØπ§ñÊèê‰æõÁöÑÈöèÊú∫Á´ØÂè£ÔºåÊ≥®ÂÜåÂà∞ dubbo Èáå„Äljæã¶ÇÔºå ÂÆπÂô® javaA ˶ÅË∞ÉÁî®ÂÆπÂô® javaBÔºåÂÆπÂô® javaB Â∑≤ÁªèÂ∞ÜÂÆÉÂØπ§ñÊèê‰æõÁöÑ ip ÂíåÈöèÊú∫Á´ØÂè£Ê≥®ÂÜåÂà∞‰∫Ü dubbo ÈáåÔºåÂÆπÂô® javaA Âè؉ª•‰ªé dubbo ÈáåÊâæÂà∞ÂÆπÂô® javaB Áõ∏ÂÖ≥Áöщø°ÊÅØÁõ¥Êé•Ë∞ÉÁÄÇ

¬Ý Á¨¨‰∫åÔºådubbo ‰∏çËÉΩËߣÂÜ≥ÁöÑÈóÆÈ¢òÊúâÔºö

- Êà뉪¨ÁöÑÁ∫ø‰∏äËøòÊúâ php ÊàñËÄÖÂÖ∂‰ªñºÄÂèëËØ≠Ë®ÄÁöÑÂ∫îÁî®ÔºåÂÆÉÊÄé‰πàË∞ÉÁî®ÂÆπÂô®ÂåñÁöÑ java Â∑•Á®ãÂë¢Ôºü¬Ý

- ÂÆπÂô®ÂåñÁöÑÂ∑•Á®ã¶ljΩïÂØπ§ñÁΩëÊèê‰æõÊúçÂä° Ôºå¶ljΩïÊääÂÆÉÊîæÂÖ• nginx Âíå F5‰∏≠Âë¢Ôºü¬Ý

¬Ý Âü∫‰∫鉪•‰∏ä‰∏§‰∏™ÈúÄʱDŽÄʼnª•ÂèäÂêå‰∏ĉ∏™Â∑•Á®ãÁöÑÂÆπÂô®‰πü˶ÅÂÅöË¥üËΩΩÂùáË°° ÔºåÊà뉪¨ÂºïÂÖ•‰∫Ü consul ¬Ý+ consul-template ¬Ý+ registrator + haproxyÔºåÊù•ÂÅöÊúçÂä°Ê≥®ÂÜåÂíåÂèëÁé∞„ÄÇ

¬Ý

¬Ý ÂÆûÊñΩËضÁªÜʵÅÁ®ã¶lj∏ãÔºö

第一步,每一台 slave 节点上都会启动一个 registrator 的容器,该容器检测 docker 引擎的 unix socket 地址:/var/run/docker.sock,从中获得该 slave 上所有容器的启动、停止以及其他运行时相关的信息;

第二步,registrator 容器同时会把它获取的其他容器的信息(IP、端口等)注册到 consul 集群中,服务信息如下面的输出:

curl 172.28.128.3:8500/v1/catalog/service/python-micro-service[¬Ý {¬Ý ¬Ý "Node":"host-1",¬Ý ¬Ý "Address":"172.28.128.3",¬Ý ¬Ý "ServiceID":"registrator:service1:5000",¬Ý ¬Ý "ServiceName":"python-micro-service",¬Ý ¬Ý "ServiceTags":null,¬Ý ¬Ý "ServicePort":49154¬Ý }]

第三步,consul-template 组件从 consul 中获得所有容器注册的服务信息,应用相应的规则(如,区分为镜像环境和生产环境)后,将容器提供的服务信息写入 haproxy 中,并 reload haproxy 以生效配置。

第四步,client 端通过 DNS 中注册的域名指向 haproxy 的地址,访问到具体提供服务的容器。

¬Ý

0x03¬ÝÂÆπÂô®ÂÜÖÈɮ¶ljΩïËé∑ÂèñÂÆø‰∏ªÊú∫ÁöÑIPÔºü

¬Ý ÂÆπÂô®ÂêØÂä®ÂêéÔºåÂÆø‰∏ªÊú∫ IP ‰ºöË¢´ÂÜôÂÖ•ÂÆπÂô®ÁöÑÁéØ¢ÉÂèòÈáèÈáå„ÄÇ

¬Ý

¬Ý ÂÆπÂô®ÂÜÖÁöÑÁ®ãÂ∫èÂè؉ª•‰ªéÁéØ¢ÉÂèòÈáèÈáåËتÂèñ„ÄÇ

¬Ý

——未完待续——

¬Ý

附录A:参考资源

1,知乎Docker话题,http://www.zhihu.com/topic/19950993;

2,2015,Docker终极指南(原作者German Jaber);

3,2015,Docker持续部署图文详解;

4,2015,使用Docker搭建Java Web运行环境;

5Ôºå2015Ôºådockone‰∏äÂØπ‰ª£ÁÝÅÊîæÈáåÈù¢ËøòÊòاñÈù¢ÁöÑËÆ®ËÆ∫Ôºõ

6,2013,dockerfile最佳实践;

7,2015,集群规模下日志处理和网络方案;

8,2015,Docker网络详解及Libnetwork前瞻;

9,docker官网讲网络配置,中文译稿;

¬Ý

ÈôÑÂΩïCÔºö

ÁõÆÂâçÔºåÊà뉪¨ÂÆπÂô®ÁÆ°ÁêÜÈõÜÁæ§ÁöÑÊäÄÊúØÊÝàÂåÖÊ㨉ª•‰∏ãÂÜÖÂÆπÔºö

- mesos(资源调度)

- marathon(服务编排)

- chronos(分布式计划任务)

- docker(容器引擎)

- consul+registrator(服务注册和发现)

- haproxy(负载均衡)

- prometheus(服务监控)

- nagios/zabbix(节点监控)

- salt(节点配置管理)

- cobbler(节点自动化装机)

- ELK(日志收集分析)

窝窝持续集成管理平台在这些技术的基础上,实现了我们的集群管理、容器管理、应用管理等业务流程。

ʨ¢ËøéËÆ¢ÈòÖÊàëÁöÑÂæƉø°ËÆ¢ÈòÖÂè∑„ÄéËÄÅÂÖµÁ¨îËÆ∞„ÄèÔºåËØ∑Êâ´Êèè‰∫åÁª¥ÁÝÅÂÖ≥Ê≥®Ôºö

¬Ý

-EOF-

相关推荐

5. **Ê∑∑Âêà‰∫ë**Ôºö‰ºÅ‰∏öÂæÄÂæÄÈúÄ˶ÅÂú®ÂÖ¨Êúâ‰∫ëÂíåÁßÅÊúâ‰∫ë‰πãÈó¥ËøõË°åÁŵʥªÂàáÊç¢ÔºåÂõÝÊ≠§Ê∑∑Âêà‰∫ëËߣÂÜ≥ÊñπÊ°àÊàê‰∏∫ÂøÖ˶ÅԺ剪•‰øùËØÅÊï∞ÊçÆÂÆâÂÖ®ÂíåÂêàËßÑÊÄß„ÄÇ Âú®"ÈòøÈáåË∞ê‰∫ëËÅîÂêàÂÆπÂô®‰∫ëËߣÂÜ≥ÊñπÊ°à"‰∏≠ÔºåÈáçÁÇπ‰ªãÁªç‰∫܉ª•‰∏ãÂá݉∏™ÊñπÈù¢Ôºö 1. **Á®≥ÂÆöÁöÑÈòøÈáå‰∫ëÂ∫ïÂ∫ß**Ôºö...

‰ºÅ‰∏öÂÆπÂô®‰∫ëÁöÑÂ∫îÁî®Ê≠£Âú®Êàê‰∏∫Áé∞‰ª£ITÂü∫Á°ÄËÆæÊñΩÁöÑÊÝ∏ÂøÉÁªÑÊàêÈÉ®ÂàÜÔºåÂÆɉ∏∫‰ºÅ‰∏öÊèê‰æõ‰∫ÜÈ´òÂ∫¶ÂèØÊâ©Â±ï„ÄÅÁŵʥª‰∏îÈ´òÊïàÁöÑËߣÂÜ≥ÊñπÊ°à„ÄÇÁßÅÊúâPaaSÔºàPlatform as a ServiceÔºâÂπ≥Âè∞Êò؉ºÅ‰∏öËΩ¨ÂêëÂÆπÂô®‰∫ëÁöÑÂÖ≥ÈîÆÈ©±Âä®ÂäõÔºå‰∏ªË¶ÅÂá∫‰∫éÂØπÊ∑∑Âêà‰∫ëÁ≠ñÁï•„ÄÅÁé∞ÊúâÂèäÊñ∞...

私有云和容器技术在其中发挥关键作用,确保了开发、测试和生产环境的一致性。通过使用Docker,可以构建开发环境、功能测试环境、集成测试环境和生产环境,确保每个阶段的环境一致性。 **持续集成/持续部署(CI/CD)...

【网易蜂巢公有容器云架构之路】是一个深入探讨云架构和容器技术的专题,主要关注如何通过容器云架构提升DevOps效率和实现微服务化的转型。以下是对该主题的详细解析: ### 1. 背景说明 在2012年,网易开始建设...

ÊÝáÈ¢òÔºö‰∏≠ÂõΩÂÆπÂô®‰∫ëÂ∏ÇÂú∫ÁÝîÁ©∂Êä•ÂëäÁ≤æÂìÅÊä•Âëä2020 ÊèèËø∞ÔºöÊú¨Êä•ÂëäÁî±ËâæÁëûÂí®ËØ¢ÁÝîÁ©∂Èô¢Ëᙉ∏ªÁÝîÁ©∂ÂèäÁªòÂà∂ÔºåËضÁªÜ...ÈöèÁùÄÂÆπÂô®ÊäÄÊúØÁöÑËøõ‰∏ÄÊ≠•ÊàêÁÜüÂíåÂÆâÂÖ®ÈóÆÈ¢òÁöÑËߣÂÜ≥Ժ剪•ÂèäKubernetesÁ≠âÁºñÊéíÂ∑•ÂÖ∑ÁöÑÂèë±ïÔºåÂÆπÂô®‰∫ëÂ∏ÇÂú∫ÊúâÊúõ‰øùÊåÅÂø´ÈÄü¢ûÈïøÁöÑÊÄÅÂäø„ÄÇ

Âú®‰∫ëÂéüÁîüÊû∂Êûщ∏ãÂÆûÁé∞ÊåÅÁª≠‰∫§‰ªòÈúÄ˶ÅÈù¢ÂØπ‰∏ÄÁ≥ªÂàóÁöÑÊåëÊàòÂíåÊú∫ÈÅáÔºåÂÖ∂‰∏≠ÂåÖÊã¨ÊúçÂä°ÁàÜÁÇ∏„ÄŧçÊùÇÊãìÊâë„ÄÅÁéØ¢ÉËßÑÊ®°Â∫û§߄ÄÅËÅîË∞ÉʵãËØïÊàêÊú¨È´òÊòljª•ÂèäÈ´òÈ¢ëÂèëÂ∏ÉÂ∏¶Êù•ÁöÑÂõûÂΩíÂ∑•‰ΩúÈáè§ßÁ≠âÈóÆÈ¢ò„ÄÇÂêåÊó∂ÔºåÊÝáÂáÜÂåñÁöÑÊäÄÊúØÊû∂ÊûÑ„Äʼn∏öÂä°ÂíåÂü∫Á°ÄËÆæÊñΩËߣËĶ„ÄÅÊòìËßÇʵã...

本周的TMT行业周报聚焦了2020年第30期的重要动态,主要关注了阿里巴巴集团发布的“云电脑”这一创新技术,以及持续升温的云计算领域。这两大话题不仅展示了科技巨头在技术领域的最新探索,也揭示了未来IT行业的趋势...

在架构方面,文档提出了一个多层次的服务架构,包括协作层、基础服务层、基础设施层和容器层。为了适应不同云环境,文档强调了公有云与私有云技术选型的一致性,列举了阿里云、EC2、Docker、Kubernetes、Flannel、...

### ÈáëËù∂‰∫ëËãçÁ©πV1.5Á≥ªÁªüÈÉ®ÁΩ≤ÊâãÂÜå_ÈùûÂÆπÂô®Áâà_V1.0 #### ‰∏Ä„ÄÅÁ≥ªÁªüʶÇËø∞ ÈáëËù∂‰∫ëËãçÁ©πV1.5Á≥ªÁªüÊò؉∏ÄʨæÂü∫‰∫é‰∫ëÂéüÁîüÊû∂ÊûÑËÆæËÆ°ÁöщºÅ‰∏öÁ∫ßÁÆ°ÁêÜËΩ؉ª∂ÔºåÂÖ∂ÊÝ∏ÂøÉÁâπÁÇπ...Ê≠§Â§ñÔºåÊåÅÁª≠ÂÖ≥Ê≥®ÂÆòÊñπÂèëÂ∏ÉÁöÑÊúÄÊñ∞ÊñáÊ°£ÂíåÊäÄÊúØÊîØÊåʼnø°ÊÅ؉πüÊòØÈùûÂ∏∏Èáç˶ÅÁöÑ„ÄÇ

本文将深入探讨如何利用Kubernetes构建和管理容器服务,以及其在360私有云平台HULK中的实践。 **一、容器服务介绍** 容器服务是基于Kubernetes构建的一种云服务,它能够快速部署和管理容器化的应用程序,提供弹性...

ËØ•Âπ≥Âè∞ÁöÑÊÝ∏ÂøÉÁâπÁÇπÊòØÈááÁÄú2+1‚ÄùÊ®°ÂºèÔºåÂç≥ÁªìÂêàÁßÅÊúâ‰∫ë„ÄÅÂÖ¨Êúâ‰∫ëÂíå‰∏ìÊúâ‰∫ëÔºåËæìÂá∫ÂÖ®ÊÝà‰∫ëÊúçÂä°Ôºå‰ª•Êª°Ë∂≥‰∏çÂêåÂÆ¢Êà∑Âú®‰∏çÂêåÂú∫Êô؉∏ãÁöÑÈúÄʱDŽÄÇÈÄöËøáËøôÁßçÊ®°ÂºèÔºåÂπ≥ÂÆâ‰∫ëÂÆûÁé∞‰∫ܧöÂÖÉÂåñÁöÑÊúçÂä°Âèë±ïÔºåÊûѪ∫‰∫܉∏∞ÂØåÁöщ∫ëÁîüÊÄÅÁ≥ªÁªü„ÄÇ ÂÆπÂô®ÊäÄÊúØÂú®Âπ≥ÂÆâ...

随着公有云和私有云的普及,云原生已成为构建现代应用架构的主流方式,不仅适用于Java应用,也适用于各种编程语言和架构。 CNCF(Cloud Native Computing Foundation)等组织推动了云原生生态的发展,Kubernetes...

„ÄêÂÆπÂô®ÊäÄÊúØ„ÄëÊò؉∏ÄÁßçËΩªÈáèÁ∫ßÁöÑËôöÊãüÂåñÊäÄÊúØÔºåÂÆÉÈÄöËøáÊìç‰ΩúÁ≥ªÁªüÁ∫ßÂà´ÁöÑÈöîÁ¶ªÔºå‰ΩøÂæóÂ∫îÁî®Á®ãÂ∫èÂè؉ª•Âú®Áã¨Á´ãÁöÑÂÆπÂô®‰∏≠ËøêË°åÔºåËÄåÊóÝÈúÄÂÖ≥ÂøÉÂ∫ï±ÇÊìç‰ΩúÁ≥ªÁªüÂíåÂÖ∂‰ªñÂ∫îÁî®ÁöÑÂπ≤Êâ∞„ÄÇÂÆπÂô®ÊäÄÊúØÊûŧßÂú∞ÊèêÂçá‰∫ÜËΩ؉ª∂ÁöÑÈÉ®ÁΩ≤ÈÄüÂ∫¶ÂíåÁŵʥªÊÄßÔºå‰ΩøÂæó‰ºÅ‰∏öËÉΩ§üÊõ¥ÂäÝ...

Rancher 1.0ÊîØÊåÅÁõÆÂâçʵÅË°åÁöÑÂÆπÂô®ÁºñÊéíÂíåË∞ÉÂ∫¶Ê°ÜÊû∂ÔºåÂåÖÊã¨Docker SwarmÂíåKubernetesÔºåÊó®Âú®‰∏∫‰ºÅ‰∏öÊèê‰æõ‰∏ĉ∏™ÂºÄÁƱÂç≥Áî®ÁöÑËߣÂÜ≥ÊñπÊ°àÔºå‰ΩøÂæóºÄÂèëËÄÖÂíåËøêÁª¥‰∫∫ÂëòËÉΩ‰∏ìÊ≥®‰∫éÂ∫îÁî®ÁöѺÄÂèëÂíå‰∏öÂä°ÁöÑÊîπÂñÑÔºåËÄåÊóÝÈúÄÂÖ≥Ê≥®Â∫ï±ÇÂü∫Á°ÄËÆæÊñΩÁöÑÈõÜÊàêÂíåÁÆ°ÁêÜ...

‰∫ëÂéüÁîüÁöÑʶÇÂøµÂº∫Ë∞ÉËΩªÈáèÁ∫ßÁöÑÂ∞ÅË£Ö„ÄÅÊùæÊï£ËĶÂêà‰ª•ÂèäÈ´òÊïàÁöÑËá™Âä®ÂåñʵÅÁ®ãÔºåËøô‰ΩøÂæóÂ∫îÁî®Á®ãÂ∫èËÉΩ§üÂú®ÂêÑÁßç‰∫ëÁéØ¢ɉ∏≠ÊóÝÁºùËøêË°åÔºåÂåÖÊã¨ÁßÅÊúâ‰∫ë„ÄÅÂÖ¨Êúâ‰∫ë„ÄÅÊ∑∑Âêà‰∫ëÂíå§ö‰∫ëÂú∫ÊôØ„ÄÇ ‰∫ëÂéüÁîüÊäÄÊúØÁöÑÊÝ∏ÂøÉÁªÑÊàêÈÉ®ÂàÜÂåÖÊã¨Ôºö 1. ÂÆπÂô®ÔºàContainersÔºâÔºö...

从物理环境到虚拟环境,再到私有云和托管云,最后到公有云,这些变化都是由业务模式驱动的技术转型所驱动的。在容器化的环境中,应用编排变得至关重要,用于管理服务发现、配置管理、健康检查、弹性伸缩和灰度发布等...

- ËØ•ÂÖ¨Âè∏ÁöÑÁõÆÊÝáÊòت∫Á´ã‰∏ĉ∏™ÈÄöÁî®ÊÄßÁöÑÂÆπÂô®‰∫ëÂπ≥Âè∞ÔºåÊï¥ÂêàCaaSÔºàÂÆπÂô®Âç≥ÊúçÂä°ÔºâÂíåIaaSÔºàÂü∫Á°ÄËÆæÊñΩÂç≥ÊúçÂä°Ôºâ„ÄÇ - Âπ≥Âè∞ÈááÁ∫ÜRancherÊù•ÁÆ°ÁêÜÂÆπÂô®ÊúçÂä°Ôºå‰∏éDockerÂíå CentOS 7Êìç‰ΩúÁ≥ªÁªüÁõ∏ÁªìÂêàÔºåÊèê‰æõ‰∫܉∏ĉΩìÂåñÁöщ∫ëÊúçÂä°ÔºåÂåÖÊ㨉∏ªÊú∫„ÄÅ...

Ê∑∑Âêà‰∫ëÁÆ°ÁêÜÂπ≥Âè∞Êï¥Âêà‰∫ÜÁßÅÊúâ‰∫ëÂíåÂÖ¨Êúâ‰∫ëÁöщºòÂäøÔºåÂÖÅËÆ∏‰ºÅ‰∏öÂú®‰øùÊåÅÊï∞ÊçÆÂÆâÂÖ®ÊÄßÁöÑÂêåÊó∂Ôºå‰∫´ÂèóÂà∞‰∫ëËÆ°ÁÆóÁöщæøÊç∑ÊÄß„ÄÇ È¶ñÂÖàԺ剺ʼn∏öÁ∫ßÂÆπÂô®‰∫ëÂπ≥Âè∞ÊòØÊ∑∑Âêà‰∫ëÁÆ°ÁêÜÁöÑÊÝ∏ÂøÉÔºåÂÆÉÊèê‰æõ‰∫ÜÊ∑∑Âêà‰∫ëʱÝÂåñÁÆ°ÁêÜÔºåËøôÊÑèÂë≥ÁùĉºÅ‰∏öÂè؉ª•Áªü‰∏ÄÁÆ°ÁêÜÂàÜÂ∏ÉÂú®‰∏çÂêå...