有时候我们在用,但是却不知道为什么。就像苹果砸到我们头上,这或许已经是很自然的事情了,但是牛顿却发现了地球的万有引力。ok了,希望通过了解MapReduce,我们能够写出更好的MapReduce例子。

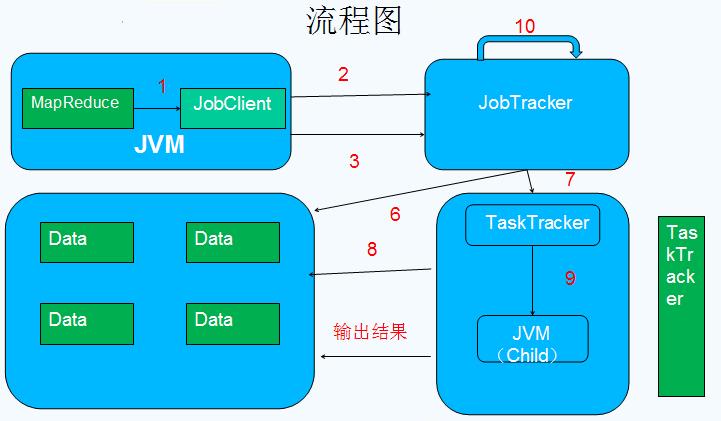

第一部分:MapReduce工作原理

<ignore_js_op style="word-wrap: break-word;">

<ignore_js_op style="word-wrap: break-word;">

MapReduce 角色

•Client :作业提交发起者。

•JobTracker: 初始化作业,分配作业,与TaskTracker通信,协调整个作业。

•TaskTracker:保持JobTracker通信,在分配的数据片段上执行MapReduce任务。

提交作业

•在作业提交之前,需要对作业进行配置

•程序代码,主要是自己书写的MapReduce程序。

•输入输出路径

•其他配置,如输出压缩等。

•配置完成后,通过JobClinet来提交

作业的初始化

•客户端提交完成后,JobTracker会将作业加入队列,然后进行调度,默认的调度方法是FIFO调试方式。

任务的分配

•TaskTracker和JobTracker之间的通信与任务的分配是通过心跳机制完成的。

•TaskTracker会主动向JobTracker询问是否有作业要做,如果自己可以做,那么就会申请到作业任务,这个任务可以使Map也可能是Reduce任务。

任务的执行

•申请到任务后,TaskTracker会做如下事情:

•拷贝代码到本地

•拷贝任务的信息到本地

•启动JVM运行任务

状态与任务的更新

•任务在运行过程中,首先会将自己的状态汇报给TaskTracker,然后由TaskTracker汇总告之JobTracker。

•任务进度是通过计数器来实现的。

作业的完成

•JobTracker是在接受到最后一个任务运行完成后,才会将任务标志为成功。

•此时会做删除中间结果等善后处理工作。

第二部分:错误处理

任务失败

•MapReduce在设计之出,就假象任务会失败,所以做了很多工作,来保证容错。

•一种情况: 子任务失败

•另一种情况:子任务的JVM突然退出

•任务的挂起

TaskTracker失败

•TaskTracker崩溃后会停止向Jobtracker发送心跳信息。

•Jobtracker会将该TaskTracker从等待的任务池中移除。并将该TaskTracker上的任务,移动到其他地方去重新运行。

•TaskTracker可以被JobTracker放入到黑名单,即使它没有失败。

JobTracker失败

•单点故障,Hadoop新的0.23版本解决了这个问题。

第三部分:作业调度

FIFO

Hadoop 中默认的调度器,它先按照作业的优先级高低,再按照到达时间的先后选 择被执行的作业

公平调度器

为任务分配资源的方法,其目的是随着时间的推移,让提交的作业获取等量的集 群共享资源,让用户公平地共享集群。具体做法是:当集群上只有一个任务在运行 时,它将使用整个集群,当有其他作业提交时,系统会将TaskTracker节点空间的时 间片分配给这些新的作业,并保证每个任务都得到大概等量的CPU时间。

容量调度器

支持多个队列,每个队列可配置一定的资源量,每个队列采用 FIFO 调度策略,为 了防止同一个用户的作业独占队列中的资源,该调度器会对同一用户提交 的作业所 占资源量进行限定。调度时,首先按以下策略选择一个合适队列:计算每个队列中正在运行的任务数与其应该分得的计算资源之间的比值,选择一个该比值 最小的队 列;然后按以下策略选择该队列中一个作业:按照作业优先级和提交时间顺序选择 ,同时考虑用户资源量限制和内存限制。但是不可剥夺式

配置公平调度器

1.修改mapred-stie.xml 加入如下内容

<property>

<name>mapred.jobtracker.taskScheduler</name>

<value>org.apache.hadoop.mapred.FairScheduler</value>

</property>

<property>

<name>mapred.fairscheduler.allocation.file</name>

<value>/opt/hadoop/conf/allocations.xml</value>

</property>

<property>

<name>mapred.fairscheduler.poolnameproperty</name>

<value>pool.name</value>

</property>

2 . 在 Hadoop conf 下创建

allocations.xml

内容为

<?xml version="1.0"?>

<alloctions>

</alloctions>

样例:

<pool name="sample_pool">

<minMaps>5</minMaps>

<minReduces>5</minReduces>

<weight>2.0</weight>

</pool>

<user name="sample_user">

<maxRunningJobs>6</maxRunningJobs>

</user>

<userMaxJobsDefault>3</userMaxJobsDefault>

3. 重启 JobTracker

4. 访问 http://jobTracker:50030/scheduler , 查看 FariScheduler 的 UI

5 . 提交任务测试

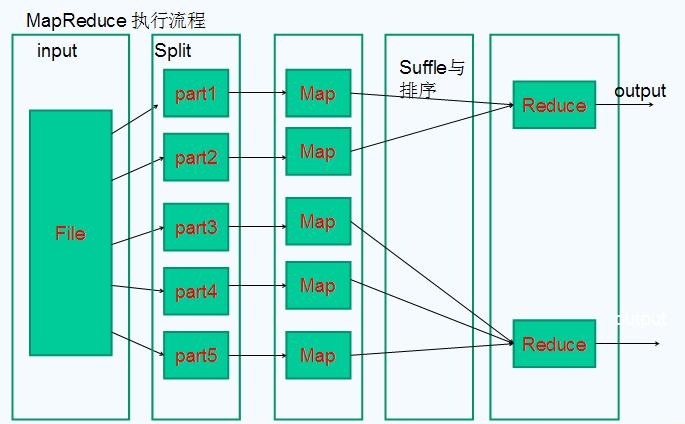

第四部分:Shuffle与排序

Mapreduce 的 map 结束后,把数据重新组织,作为 reduce 阶段的输入,该过程称 之为 shuffle--- 洗牌。

而数据在 Map 与 Reduce 端都会做排序。

Map

• Map 的输出是由collector控制的

• 我们从collect函数入手

Reduce

•reduce的Shuffle过程,分成三个阶段:复制Map输出、排序合并、reduce处理。

•主要代码在reduce的 run函数

Shuffle优化

•首先Hadoop的Shuffle在某些情况并不是最优的,例如,如果需要对2集合合并,那么其实排序操作时不需要的。

•我们可以通过调整参数来优化Shuffle

•Map端

•io.sort.mb

•Reduce端

•mapred.job.reduce.input.buffer.percent

第五部分:任务的执行时的一些特有的概念

推测式执行

•每一道作业的任务都有运行时间,而由于机器的异构性,可能会会造成某些任务会比所有任务的平均运行时间要慢很多。

•这时MapReduce会尝试在其他机器上重启慢的任务。为了是任务快速运行完成。

•该属性默认是启用的。

JVM重用

•启动JVM是一个比较耗时的工作,所以在MapReduce中有JVM重用的机制。

•条件是统一个作业的任务。

•可以通过mapred.job.reuse.jvm.num.tasks定义重用次数,如果属性是-1那么为无限制。

跳过坏记录

•数据的一些记录不符合规范,处理时抛出异常,MapReduce可以讲次记录标为坏记录。重启任务时会跳过该记录。

•默认情况下该属性是关闭的。

任务执行环境

•Hadoop为Map与Reduce任务提供运行环境。

•如:Map可以知道自己的处理的文件

•问题:多个任务可能会同时写一个文件

•解决办法:将输出写到任务的临时文件夹。目录为:{mapred.out. put.dir}/temp/${mapred.task.id}

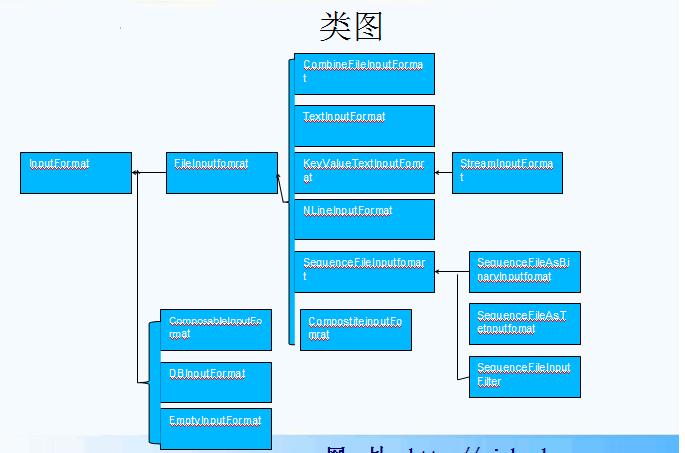

第六部分:MapReduce的类型与格式

类型

•MapReduce的类型 使用键值对作为输入类型(key,value)•输入输出的数据类型是通过输入输出的格式进行设定的。

输入格式

•输入分片与记录

•文件输入

•文本输入

•二进制输入

•多文件输入

•数据库格式的输入

输入分片与记录

•Hadoop通过InputSplit表示分片。

•一个分片并不是数据本身,而是对分片数据的引用。

•InputFormat接口负责生成分片

<ignore_js_op style="word-wrap: break-word;">

文件输入

•实现类:FileInputFormat

•通过文件作为输入源的基类。

•四个方法:

•addInputPath()

•addInputPaths()

•setInputPath()

•setInputPaths()

•FileInputFormat会按HDFS块的大小来分割文件

•避免分割

•继承FileInputFormat 重载isSplitable()

•return false

文本输入

•实现类:TextInputFormat

•TextInputFormat 是默认的输入格式。

•包括:

•KeyValueTextInputFormat

•NLineInputFormat

•XML

•输入分片与HDFS块之间的关系

•TextInputFormat的某一条记录可能跨块存在

二进制输入

•实现类:SequenceFileInputFormat

•处理二进制数据

•包括:

•SequenceFileAsTextInputFormat

•SequenceFileAsBinaryInputFormat

多文件输入

•实现类:MultipleInputs

•处理多种文件输入

•包括:

•addInputPath

数据库输入

•实现类:DBInputFormat

•注意使用,因为连接过多,数据库无法承受。

输出格式

•文本输出

•二进制输出

•多文件输出

•数据库格式的输出

文本输出

•实现类:TextOutputFormat

•默认的输出方式

• 以 "key \t value" 的方式输出

二进制输出

•基类: SequenceFileOutputFormat

•实现类: SequenceFileAsTextOutputFormat

MapFileOutputFormat

SequenceFileAsBinaryOutputFormat

多文件输出

•MutipleOutputFormat•MutipleOutputs

•两者的不同在于MutipleOutputs可以产生不同类型的输出

数据库格式输出• 实现类DBOutputFormat

原帖地址:http://www.aboutyun.com/thread-6723-1-1.html

相关推荐

Hadoop介绍,HDFS和MapReduce工作原理

**3.1 MapReduce工作流程** 1. **提交阶段**:客户端将应用程序(包括map和reduce代码以及输入数据)打包成JAR文件,并提交给JobTracker(在YARN中是ResourceManager)。 2. **作业初始化**:JobTracker解析JobConf...

MapReduce作为大数据处理领域的一个重要概念,其工作原理和应用场景对于理解现代分布式计算体系至关重要。无论是数据科学家、软件工程师还是系统架构师,了解和掌握MapReduce都能提供一个很好的基础,以便更好地处理...

### MapReduce原理详解 #### 一、MapReduce与Hadoop概述 MapReduce是Apache Hadoop项目的核心组件之一,主要用于处理大规模数据集的分布式计算。它不仅是一种编程模型,还是一套支持这种模型的软件框架。MapReduce...

### MapReduce工作原理详解 #### 一、MapReduce概述与特性 MapReduce是一种分布式计算模型,主要用于处理大规模数据集。该技术由Google首先提出,并在Hadoop中得到了广泛应用。MapReduce的基本思想是将大规模的...

以下是MapReduce的工作原理、核心概念以及其在大数据处理中的应用。 **一、MapReduce工作流程** MapReduce的工作流程主要分为三个阶段:Map阶段、Shuffle阶段(也称为排序和分区)和Reduce阶段。 1. **Map阶段**...

分布式处理系统,适合集群式处理。提高运行效率以及容错率

Hadoop MapReduce原理是分布式计算框架的核心技术之一,其设计理念是为了在普通的商用硬件集群上处理大数据问题。MapReduce的主要思想是将任务分解为两个阶段:Map阶段和Reduce阶段。在传统MapReduce中,系统架构...

本文将深入浅出地解析MapReduce的工作原理,帮助读者理解这一强大的大数据处理模型。 MapReduce是由Google在2004年提出的一种并行计算模型,其设计灵感来源于函数式编程中的映射(map)和归并(reduce)操作。...

MapReduce 原理 MapReduce 的定义和架构 MapReduce 是一个使用简易的软件框架,基于它写出来的应用程序能够运行在由上千个商用机器组成的大型集群上,并以一种可靠容错的式并行处理上 T 级别的数据集。 MapReduce...

MapReduce工作原理详解 Hadoop是一个开源的分布式计算框架,起源于Apache项目,专注于大规模数据的分布式存储和处理。它的核心特性包括可扩展性、经济性、高效性和可靠性,使得处理PB级别的数据变得可能,同时利用...

通过《Hadoop技术内幕:深入解析MapReduce架构设计与实现原理》这本书,读者不仅可以了解到MapReduce的基本工作原理,还能学习到如何设计和优化MapReduce作业,以及如何在实际项目中应用MapReduce解决复杂问题。...

本章节将深入讲解 MapReduce 的运行机制和底层原理,以及 YARN 的介绍。MapReduce 是 Hadoop 最核心的组件之一,是一个分布式计算框架,用于处理大规模数据集。在本章节中,我们将详细介绍 MapReduce 的工作原理、...

MapReduce原理 MapReduce执行过程可以分为两个阶段:Map阶段和Reduce阶段。 Map阶段 在Map阶段,框架使用InputFormat类的子类把输入文件(夹)划分为很多InputSplit,默认,每个HDFS的block对应一个InputSplit。...

深入 剖析 了 Hadoop ... 书中 不仅 详细 介绍 了 MapReduce 各个 组件 的 内部 实现 原理, 而且 结合 源 代码 进行 了 深入 的 剖析, 使 读者 可以 快速 全面 地 掌握 Hadoop MapReduce 设计 原理 和 实现 细节。

### MapReduce原理实现分析 #### 一、MapReduce概述与工作流程 MapReduce是一种编程模型,主要用于处理大规模数据集的并行运算。该模型由Google提出,并被广泛应用于分布式计算领域。Hadoop作为开源框架之一,实现...

### Hadoop技术内幕:深入解析MapReduce架构设计与实现原理 #### 一、Hadoop及其重要性 Hadoop是一个开放源代码的分布式计算框架,它能够处理大量的数据集,并通过集群提供高性能的数据处理能力。随着大数据时代的...

Hadoop MapReduce是一种分布式编程模型,用于处理大数据集。它将数据集分割为小部分,这些小部分可以由不同的计算机并行计算,最后合并计算结果。MapReduce的编程接口包括Map和Reduce两个函数,Map处理数据的映射,...

最后从实际应用的角度深入讲解了Hadoop的性能优化、安全机制、多用户作业调度器和下一代MapReduce框架等高级主题和内容。本书适合Hadoop的二次开发人员、应用开发工程师、运维工程师阅读。 hadoop技术内幕 深入解析...