Author:жФЊзњБпЉИжЦЗеИЭпЉЙ

Date:2010/4/2

ињЗеєіеИ∞зО∞еЬ®ињШж≤°жЬЙжЫіжЦ∞ињЗblogпЉМе∞±еТМеєіеЙНиѓізЪДдЄАж†ЈпЉМеИ∞дЇЖжЈШеЃЭе∞±и¶БзЬЯзЪДиЄПеЃЮеБЪеЃЮдЇЛдЇЖпЉИиµЈз†БQ3еЙНпЉЙгАВеТМдї•еЙНеЬ®йШњиљѓдЄНеРМзЪДжШѓзО∞еЬ®жЫіеК†еЕ≥ж≥®дЇІеУБзЪДиЃЊиЃ°еТМеЃЮзО∞пЉМеѓєдЇОжЦ∞жКАжЬѓзЪДе∞ЭиѓХзЉЇе∞СдЇЖдЄАдЇЫз©ЇйЧіеТМжЧґйЧігАВеПѓдї•жЛњз®ЛеЇПеСШеѓєжЦ∞жКАжЬѓзЪДињљж±ВеБЪдЄ™з±їжѓФпЉМе∞±е•љжѓФзїУе©ЪеЙНзЪДжµ™жЉЂпЉМиАМеИ∞дЇЖдљ†зЬЯзЪДзїУе©ЪжЬЙдЇЖеЃґеЇ≠еТМе∞Пе≠©пЉМйВ£йЬАи¶БзЪДжШѓжЫіе§ЪзЪДиі£дїїжДЯеТМеК°еЃЮзЪДеЈ•дљЬгАВељУзДґе¶ВжЮЬзФЯжіїжИРдЄЇдЄАзІНзФЯе≠ШпЉМйВ£дєИе∞±е§±еОїдЇЖжДПдєЙпЉМе¶ВдљХеЬ®иі£дїїеТМжµ™жЉЂдєЛйЧіжЙЊеИ∞еє≥и°°зВєпЉМжШѓдЄАдЄ™жКАжЬѓдЇЇеСШжИРйХњзЪДжМСжИШгАВжИСдїђдЄНеПѓиГљж∞ЄињЬжШѓдЄАдЄ™йХњдЄНе§ІзЪДе∞Пе≠©пЉМдєЯдЄНдЉЪжШѓиАБж∞Фж®™зІЛзЪДдЄ≠еєізФЈдЇЇгАВжЬЙзВєеЇЯиѓЭдЇЖпЉМи®АељТж≠£дЉ†пЉМи∞ИдЄАдЄЛињЩеєіеРОзЯ≠зЯ≠зЪДдЄАдЄ™е§ЪжЬИзЪДеЈ•дљЬењГеЊЧпЉМдЄАзВєеИЖдЇЂпЉМдЄАзВєиЃ∞ељХгАВ

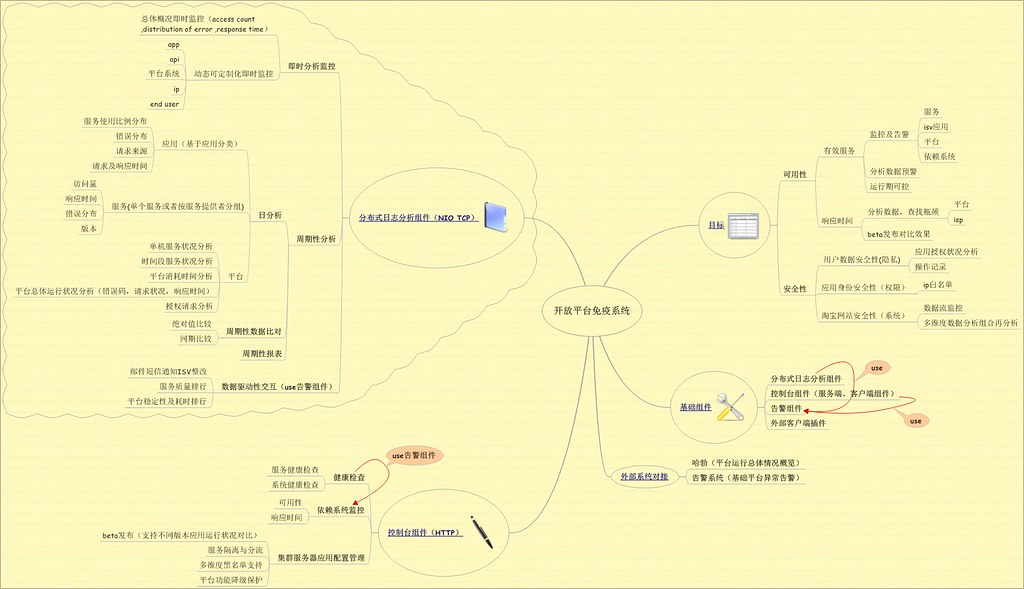

з≥їзїЯйАПжШОеМЦ

еОїеєіе∞±еК†еЕ•дЇЖжЈШеЃЭзЪДиЩЪжЛЯе∞ПзїДпЉИз®≥еЃЪжАІе∞ПзїДпЉЙпЉМеРМжЧґеЬ®еЉАжФЊеє≥еП∞еЫҐйШЯеЖЕжЬАе§ІзЪДдЄАдЄ™иБМиі£дєЯжШѓз®≥еЃЪжАІгАВеѓєдЇОеЃҐжИЈжЭ•иѓіеєґдЄНеЕ≥ењГдљ†зЪДжКАжЬѓеЃЮзО∞жШѓе¶ВдљХfancyпЉМеѓєдїЦжЭ•иѓіиГље§ЯењЂйАЯгАБз®≥еЃЪгАБжЦєдЊњзЪДжї°иґ≥дїЦзЪДйЬАж±Ве∞±жШѓдЄАдЄ™е•љзљСзЂЩпЉМдЄАдЄ™е•љз≥їзїЯпЉМдЄАе•Че•љжЬНеК°гАВеЫ†ж≠§з®≥еЃЪпЉМйЂШжХИжИРдЄЇдЇЖжЈШеЃЭдЄїзЂЩеТМеЉАжФЊеє≥еП∞зЪДж†єжЬђгАВеЙН䪧姩зЬЛдЇЖйїДи£≥еЬ®infoqзЪДдЄАдЇЫеЕ≥дЇОжЈШеЃЭжКАжЬѓе±ХжЬЫзЪДжЦЗзЂ†пЉМе∞±дЄ§дЄ™е≠ЧвАЬеЃЮеЬ®вАЭпЉМж≤°жЬЙеХ•жљЃжµБзЪДиѓНж±ЗпЉМж≤°жЬЙеЊИзВЂзЪДжКАжЬѓжО®иНРпЉМжЬЙзЪДе∞±жШѓе¶ВдљХзФ®жЬАжЬЙжХИзЪДжЙЛжЃµжї°иґ≥зФ®жИЈйЬАж±ВгАВ

иЃ∞еЊЧеЬ®жЬАињСдЄАжђ°з®≥еЃЪе∞ПзїДдЉЪиЃЃдЄКе§ІеЃґи∞ИеИ∞дЇЖињЩдЇЫеєіеПСе±ХеЄ¶жЭ•зЪДйЧЃйҐШпЉМеЕґеЃЮжИСдїђеЬ®иІ£еЖ≥йЧЃйҐШзЪДеРМжЧґдєЯеЬ®дЄНжЦ≠еЬ∞еЉХеЕ•йЧЃйҐШпЉМеРМжЧґеЬ®иІДж®°еМЦзЪДй©±дљњдЄЛпЉМдЄНжЦ≠еЬ∞йЗЗзФ®жЭЊиА¶еРИеПКеОїдЄ≠ењГеМЦзЪДиЃЊиЃ°пЉМдљЖжШѓеЄ¶жЭ•зЪДйЧЃйҐШе∞±жШѓз≥їзїЯе§НжЭВеЇ¶зЪДдЄНжЦ≠еҐЮеК†пЉМеРМжЧґз≥їзїЯйЧізЪДдЇ§дЇТеТМдЊЭиµЦдєЯеПШеЊЧиґКжЭ•иґКе§НжЭВеТМжЈЈж≤МгАВжИСеЬ®Q1зЪДеЈ•дљЬиЃ°еИТдЄ≠пЉМе§ІйГ®еИЖзЪДеЈ•дљЬдЄЇдЇЖдЄАдЄ™зЫЃж†ЗпЉЪз≥їзїЯйАПжШОеМЦгАВ

з≥їзїЯйАПжШОеМЦиГље§ЯдЄЇжµЈйЗПиѓЈж±ВзЪДз≥їзїЯеЄ¶жЭ•дїАдєИпЉЯ

1пЉОеЃЮеЃЮеЬ®еЬ®зЪДжАІиГљдЉШеМЦгАВ

2пЉОзЃАеНХжЬЙжХИзЪДйЧЃйҐШжОТжЯ•еТМеЃЪдљНгАВ

3пЉОз≥їзїЯй£ОйЩ©йҐДи≠¶гАВ

4пЉОжЬЙжХИеЬ∞з≥їзїЯеБ•еЇЈзЫСжОІеТМдЄЪеК°еБ•еЇЈзЫСжОІгАВ

ињЗеОїжИСдїђжАїеЬ®зЇњдЄЛеБЪеРДзІНеОЛеКЫжµЛиѓХпЉМеРМжЧґеѓєдЇОдЄАдЇЫдЉШеМЦз≠ЦзХ•дєЯйГљжШѓйАЪињЗзЇњдЄЛжЭ•й™МиѓБпЉМдљЖжШѓеЃЮйЩЕзЪДдЄЪеК°еЬЇжЩѓеЊАеЊАдЉЪеТМеЕЈдљУзЪДжХ∞жНЃзЫЄеЕ≥пЉМиАМзЇњдЄЛжЧ†ж≥ХеБЪеИ∞зЪДе∞±жШѓжХ∞жНЃж®°жЛЯгАВеЬ®еЉАжФЊеє≥еП∞з≥їзїЯеЯЇз°Аж°ЖжЮґйЗНжЮДдї•еРОпЉМй¶ЦеЕИжШѓйЗЗзФ®дЇЖзЃ°йБУйУЊзЪДжПТжЛФж®°еЉПпЉМзЫіжО•йАЪињЗеѓєељУеЙНињРи°МжХ∞жНЃзЪДеЬ®зЇњеИЖжЮРе∞±еПѓдї•зЬЛеЗЇз≥їзїЯжґИиАЧзЪДзОѓиКВпЉМеРМжЧґеК†дЄКжОІеИґеП∞еѓєйЫЖзЊ§еНХеП∞жЬЇеЩ®зЪДйЕНзљЃжО®йАБпЉМињЩж†ЈжѓФеѓєдЄ§еП∞дЄНеРМе§ДзРЖз≠ЦзХ•зЪДжЬНеК°еЩ®е∞±иГље§ЯеЊИжШОжШЊзЬЛеЗЇжАІиГљдЉШеМЦзЪДжХИжЮЬдї•еПКеРОзї≠зЪДжФєињЫзВєгАВдЄЊдЄ™дЊЛе≠РпЉМеЬ®жИСдїђдЄЪеК°жЦєйЬАж±ВдЄ≠и¶Бж±ВеѓєжЯРдЄАйГ®еИЖдЄЪеК°жХ∞жНЃеОїжОЙжЬђеЬ∞зЉУе≠ШпЉМеЕ®йГ®еРѓзФ®зЇѓз≤єзЪДйЫЖдЄ≠еЉПзЉУе≠ШпЉМжИСдїђйАЪињЗжЙєжђ°зЪДеЕ≥йЧ≠жЬђеЬ∞зЉУе≠ШпЉМжѓФеѓєдЇЖиЗ™иЇЂз≥їзїЯеТМе§ЦйГ®дЊЭиµЦз≥їзїЯзЪДеОЛеКЫеҐЮйХњжГЕеЖµпЉМељУ3/4зЪДжЬЇзЊ§жЬЇеЩ®йЗЗзФ®зЇѓйЫЖдЄ≠еЉПзЉУе≠ШзЪДжЧґеАЩпЉМдЄ§жЦєжЬНеК°еЩ®йГљеЗЇзО∞дЇЖloadиЊГйЂШзЪДйЧЃйҐШпЉМеЫ†ж≠§иАГиЩСйЗЗзФ®жЫізїЖз≤ТеЇ¶зЪДдЄЪеК°жХ∞жНЃжЭ•еЖ≥еЃЪжШѓеР¶еРѓзФ®жЬђеЬ∞зЉУе≠ШпЉМжї°иґ≥дЇЖзФ®жИЈиѓЈж±ВпЉМеРМжЧґдєЯе§Іе§ІйЩНдљОдЇЖеПМжЦєзЪДеОЛеКЫжГЕеЖµпЉМеРМжЧґзФ±дЇОдЄЪеК°жХ∞жНЃйЕНзљЃеПѓињРи°МжЬЯжО®йАБпЉМеЫ†ж≠§йЪПзЭАеОЛеКЫзЪДеҐЮе§ІеПѓдї•еЬ®зЇњи∞ГжХіз≠ЦзХ•гАВ

еЬ®жЦ∞жЮґжЮДдЄКзЇњеРОпЉМеПСзО∞ињРи°МдЄАжЃµжЧґйЧідЉЪжЬЙвАЬеЖЕе≠Шж≥ДйЬ≤вАЭзЪДйЧЃйҐШпЉМ64дљНжЬЇеЩ®жЬАеРО3дЄ™GзЪДеЖЕе≠ШйÚ襀еРГеЕЙгАВељУжЧґе∞±жШѓжЛЕењГжЦ∞жЮґжЮДеПѓиГљдЇІзФЯдЄАдЇЫйЧЃйҐШпЉМеЫ†ж≠§еЕБиЃЄз≥їзїЯйАЪињЗжОІеИґеП∞еИЗжНҐжЦ∞иАБеЉХжУОгАВзЇњдЄКдЄАеП∞жЦ∞еЉХжУОзЪДжЬНеК°еЩ®иЈСдЇЖдЄАжЃµжЧґеАЩе∞±жККеЖЕе≠ШdumpеЗЇжЭ•пЉМзДґеРОжЛЦеИ∞зЇњдЄЛеИЖжЮРпЉМеПСзО∞жЬЙе§ІйЗПзЪДtomcatзЪДSession襀дњЭе≠ШеЬ®ManagerдЄ≠ж≤°жЬЙ襀йЗКжФЊпЉИ1.7GпЉЙпЉМзДґеРОйАЪињЗзЇњдЄЛеНЄиљљзЃ°йБУеБЪжµЛиѓХпЉМжЬАзїИеПСзО∞жШѓзФ±дЇОеЕґдЄ≠дЄАдЄ™зЃ°йБУйЬАи¶БеЬ®ињРи°МжЬЯиОЈеПЦеИ∞springзЪДеЃєеЩ®пЉМеОїжОЙзФ®дЇЖrequest.getsession().getContextжЦєж≥ХпЉМзїУжЮЬеЃєеЩ®еИЫеїЇдЇЖжЬЙжХИжЬЯдЄЇ30еИЖйТЯзЪДsessionпЉМеѓєдЇОеє≥еП∞ињЩдєИе§ІзЪДиЃњйЧЃйЗПпЉМеЕґеЃЮињЩзІНйЭЮеЖЕе≠Шж≥ДйЬ≤зЪДйЧЃйҐШпЉМдєЯиґ≥дї•дљњеЊЧйЂШеОЛеКЫдЄЛOOMгАВ

йАПжШОеМЦеП¶дЄАжЦєйЭҐе∞±жШѓйЬАи¶БеѓєдЊЭиµЦз≥їзїЯеПКиЗ™иЇЂзЪДеБ•еЇЈзКґеЖµжЬЙжЙАдЇЖиІ£гАВељУеЙНTOPеЬ®ињЩжЦєйЭҐдЄїи¶БеБЪзЪДеЈ•дљЬ襀еЃЪдєЙжИРдЄЇеЕНзЦЂз≥їзїЯпЉМеЕґдЄїи¶БзЪДиБМиі£

жµБз®ЛзЃ°йБУеМЦ

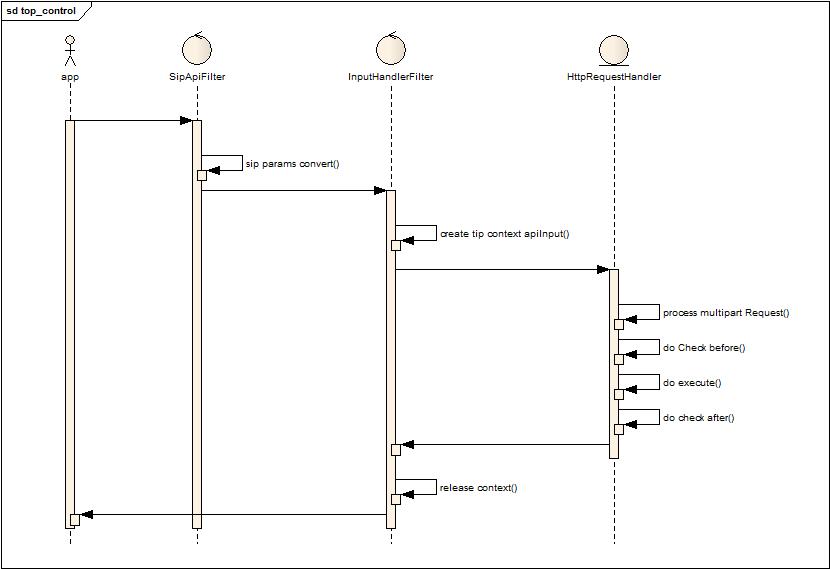

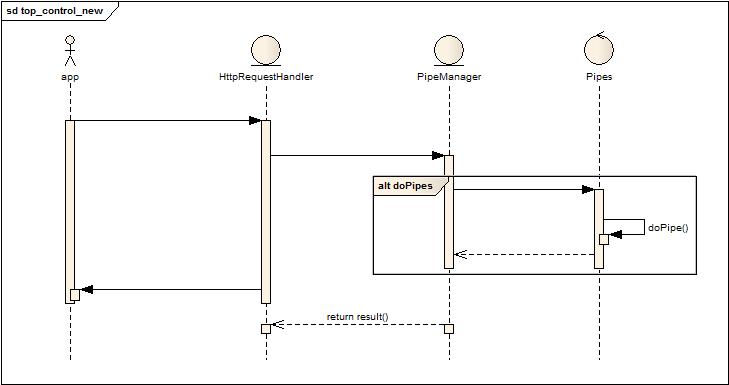

ињЩдЇЫеєідЄАзЫійГљеЬ®и∞ИйЭҐеРСжЬНеК°пЉМж®°еЭЧеМЦпЉМињЩдЇЫж¶ВењµгАВдљЖжШѓе∞±еЕґзЫЃж†ЗжЭ•иѓіпЉМе∞±жШѓеЄМжЬЫиГље§ЯиЃ©иЃЊиЃ°иАЕжЫіе§ЪзЪДиАГиЩСжµБз®ЛдєЛйЧізЪДжЭЊиА¶еРИпЉМжЧ†дЊЭиµЦгАВеЫ†дЄЇдЄАжЧ¶жЬНеК°дєЛйЧіж≤°жЬЙињЗе§ЪзЪДдЊЭиµЦпЉМжЬНеК°жЬђиЇЂж≤°жЬЙдЄ≠йЧізКґжАБпЉМйВ£дєИдїїеК°е∞±еПѓдї•еєґи°Ме§ДзРЖпЉМдЄАжЧ¶еєґи°Ме§ДзРЖпЉМйВ£дєИеѓєдЇОжµБз®ЛзЪДеЕ≥йФЃиЈѓеЊДдЉШеМЦе∞±жЬЙеЊИе§ІзЪДеЄЃеК©гАВ

дЄЛйЭҐжШѓйЗНжЮДеЙНеТМйЗНжЮДеРОзЪДдЄ§дЄ™жµБз®ЛеѓєжѓФпЉЪ

иАБж°ЖжЮґжµБз®ЛпЉЪ

жЦ∞ж°ЖжЮґжµБз®ЛпЉЪ

еЕЈдљУзЪДж°ЖжЮґз±їеЫЊе¶ВдЄЛпЉЪ

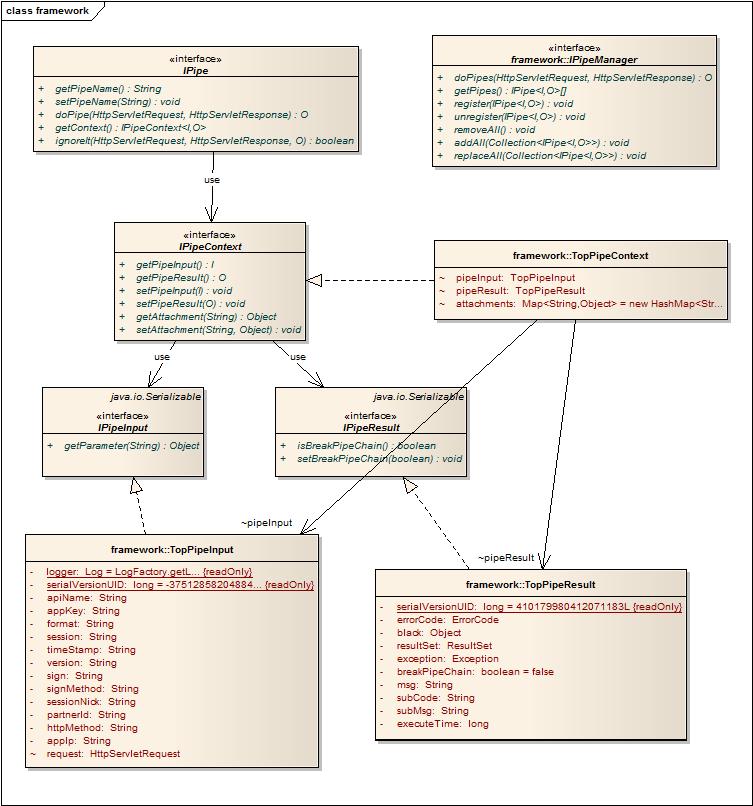

зЬЛдЇЖдї•еРОпЉМеПѓиГљеЊИе§ЪеРМе≠¶дЉЪиѓіпЉМеЕґеЃЮе∞±йВ£дєИзЃАеНХдЄАдЄ™иЃЊиЃ°дєИпЉМдљЖеЕґеЃЮз≥їзїЯзЪДиЃЊиЃ°зЫЃж†Зе∞±жШѓзФ®зЃАеНХзЪДиЃЊиЃ°жЭ•жї°иґ≥е§НжЭВзЪДйЬАж±ВгАВеЕґеЃЮеѓєдЇОеЉАжФЊеє≥еП∞жЭ•иѓіпЉМеЖНе§НжЭВзЪДдЄЪеК°йГљжШѓеПѓдї•жКљи±°жИРзЃ°йБУпЉМеРМжЧґе§ІйГ®еИЖжГЕеЖµдЄЛйГљжШѓжЧ†зКґжАБзЪДжЬНеК°зЃ°йБУпЉМеЯЇдЇОдЄЪеК°зЪДдЄНеРМйЬАж±ВпЉМзЃ°йБУзЪДжЙІи°МдЉЪжЬЙжЙАдЄНеРМгАВ

ињЩйЗМиЃЊиЃ°зЪДеЗ†дЄ™еОЯеИЩпЉЪ

1. зЃ°йБУдєЛйЧіжЧ†еЕ≥иБФжАІгАВзЃ°йБУдЄОзЃ°йБУдєЛйЧіеЃМеЕ®ж≤°жЬЙдїїдљХеЕ≥иБФпЉМеЫ†дЄЇеЬ®зЃ°йБУзЬЛжЭ•е∞±еП™жЬЙиЊУеЕ•еТМиЊУеЗЇзЪДжХ∞жНЃжµБпЉМеЕґдїЦзЃ°йБУеѓєдЇОеЃГжЭ•иѓіжШѓйАПжШОзЪДгАВзЛђзЂЛжАІйЩНдљОдЄЪеК°иА¶еРИеЇ¶пЉМжФѓжМБињРи°МжЬЯеПШжЫігАВ

2. зЃ°йБУдєЛйЧійАЪињЗдЄКдЄЛжЦЗзЪДжЦєеЉПдЇ§дЇТжХ∞жНЃпЉМеЗПе∞СжХ∞жНЃиЊУеЕ•еЄ¶жЭ•зЪДйАВйЕНдЊЭиµЦгАВ

3. дЄЪеК°е§ДзРЖжЭГеПКжµБз®ЛдЄ≠жЦ≠жЭГдЇ§зїЩзЃ°йБУпЉМзЃ°йБУеПѓдї•йАЪињЗеЃЮзО∞ignoreitжЭ•еИ§жЦ≠жШѓеР¶и¶Бе§ДзРЖж≠§жђ°иѓЈж±ВпЉМдєЯеПѓдї•еЬ®IPipeResultдЄ≠иЃЊзљЃisBreakPipeChainжЭ•дЄїеК®дЄ≠жЦ≠жµБз®ЛгАВпЉИеѓєдЇОиµДжЇРеЫЮжФґжЬАе•љдЄНи¶БдЇ§зїЩдЄАдЄ™зЃ°йБУжЙІи°МпЉМеЫ†дЄЇйЪПжЧґеПѓиГљеЫ†дЄЇжµБз®ЛдЄ≠жЦ≠иАМж≤°жЬЙ襀жЙІи°МеИ∞пЉЙ

4. зЃ°йБУиЃЊиЃ°е∞љйЗПдЄЇжЧ†зКґжАБпЉМзЇњз®ЛеЃЙеЕ®пЉМдЊњдЇОжЙ©е±ХпЉМйШ≤ж≠ҐдЇІзФЯиµДжЇРзЂЮдЇЙеЄ¶жЭ•зЪДе§ДзРЖзУґйҐИгАВ

5. зЫСжОІзЃ°йБУжЙІи°МзКґеЖµпЉМењЕи¶БжЧґиЗ™еК®йЩНзЇІеНЄиљљзЃ°йБУпЉМдњЭжК§з≥їзїЯз®≥еЃЪжАІгАВ

жЧ©еЕИиАГиЩСжШѓеР¶иГље§ЯеРѓеК®зЇњз®Л汆жЭ•жЙІи°МзЃ°йБУйУЊпЉМињЩдєИеБЪзЪДзЫЃж†ЗжШѓиГље§ЯжОІеИґиґЕжЧґжЙІи°МзЪДзЃ°йБУйУЊпЉМйБњеЕНз≥їзїЯзЪДдЄНз®≥еЃЪжАІгАВдљЖжЬАе§ІзЪДйЧЃйҐШе∞±жШѓзЇњз®ЛеИЗжНҐдї£дїЈдї•еПКзЇњз®Л汆зЪДеЃєйЗПйЧЃйҐШпЉМеЫ†ж≠§дљЬ皥пЉМжФєдЄЇдЇЛеРОиЃ∞ељХйЩНзЇІе§ДзРЖгАВ

еЃЙеЕ®ињШжШѓеЃЙеЕ®

еЉАжФЊеє≥еП∞жИРзЂЛдєЛеИЭпЉМе∞±и¶БйЭҐеѓєзЭАеЃЙеЕ®зЪДйЧЃйҐШпЉМдЄїзЂЩжЬЙеЊИе§ЪзЪДзЇ¶жЭЯеТМйЩРеИґпЉМдљЖжШѓеЉАжФЊеє≥еП∞жИРдЄЇжЈШеЃЭеѓєе§ЦзЪДз™ЧеП£пЉМдЄЇдЇЖдЄЪеК°йЬАи¶БпЉМдљЬдЇЖењЕи¶БзЪД嶕еНПпЉМдљЖжШѓеЃЙеЕ®жЦєйЭҐдєЯжШѓдЄАзЫіеЬ®жКУзЪДдЇЛжГЕгАВжЬАињСе∞±е§ДзРЖжЈШеЃЭиЃњеЃҐеЇФзФ®зЪДйЧЃйҐШпЉМжЬЙдЇЫиљѓдїґеЉАеПСиАЕе∞±еИ©зФ®302иљђиЈ≥зЪДжЦєеЉПпЉМеЬ®еХЖеУБжИЦиАЕеЇЧйУЇзЪДй°µйЭҐдЄКзХЩзЧХињєпЉМжЭ•иОЈеПЦиЃњеЃҐдњ°жБѓпЉМеПѓи∞УзФ®е∞љењГжАЭпЉМе∞БдЄАдЄ™жЉПжіЮжЙЊдЄАдЄ™жЉПжіЮгАВеѓєдЇОињЩзІНиљђиЈ≥жЭ•иОЈеПЦиЃњеЃҐдњ°жБѓпЉМзЃАеНХзЪДе§ДзРЖе∞±ињЩдЇЫпЉМз¶Бж≠ҐgetиѓЈж±ВпЉИзФ±дЇОйГљжШѓй°µйЭҐеЫЊзЙЗзЪДgetиѓЈж±ВиљђиЈ≥пЉМеЫ†ж≠§жЧ†ж≥ХзЃАеНХзЪДеПШжИРpostиѓЈж±ВпЉЙпЉМзДґеРОе¶ВжЮЬжШѓpostйЬАи¶БеК†дЄКеК®жАБдЉЪиѓЭз†БзЪДж†°й™МпЉМжЬАеРОеЬ®еК†дЄКеѓєдЇОиѓЈж±ВзЪДreferж£АжЯ•пЉМжЭ•е±ПиФљињЩз±їзЪДйЧЃйҐШгАВдЄНињЗеѓєдЇОйТУй±ЉзљСзЂЩпЉМзЬЯзЪДж≤°жЬЙеՕ姙啚зЪДе§ДзРЖжЦєеЉПпЉМдЄ™дЇЇжДЯиІЙжЬАйЭ†и∞±зЪДе∞±жШѓеЖЩжµПиІИеЩ®зЪДжПТдїґгАВ

ж†Зз≠ЊеМЦеЉАжФЊ

еЉАжФЊеє≥еП∞зО∞еЬ®йГљжШѓжХ∞жНЃжЬНеК°еЉАжФЊпЉМеЊИе§ЪеЬЇжЩѓдЄЛдЉЪжЬЙж†Зз≠ЊеМЦеЉАжФЊзЪДйЬАж±ВгАВињШжШѓзЬЛеЫЊиѓіиѓЭеРІпЉЪ

еЙ©дЄЛзЪДе∞±жШѓеЯЇдЇОMap-ReduceзЪДеПѓйЕНзљЃеИЖжЮРеЉХжУОзЪДдЉШеМЦпЉМељУеЙНжФѓжМБжЦЗдїґжХ∞жНЃжЇРеТМжХ∞жНЃеЇУжХ∞жНЃжЇРпЉМжФѓжМБеҐЮйЗПеИЖжЮРеТМз¶їзЇњдЄАжђ°жАІеИЖжЮРпЉМеИЖжЮРж®°еЮЛињРи°МжЬЯеПѓжФєеПШпЉМжПРдЊЫеЃЮжЧґзЪДзЫСжОІйҐДи≠¶гАВ姙жЩЪдЇЖпЉМжЬАеРОиіідЄАдЄ™еЉАжФЊеє≥еП∞зЪДжКАжЬѓељУеЙНжАїдљУжЮґжЮДеЫЊпЉЪ

еИЖдЇЂеИ∞пЉЪ

зЫЄеЕ≥жО®иНР

еЬ®ињЩдїљзФ≥дЄЗеЃПжЇРеЗЇеЕЈзЪДиЃ°зЃЧжЬЇи°МдЄЪ2020еєіжК•еПК2021еєізђђдЄАе≠£еЇ¶е≠£жК•еЫЮй°ЊдЄ≠пЉМжПРдЊЫдЇЖеѓєиЃ°зЃЧжЬЇи°МдЄЪдЄЪзї©еИЖжЮРзЪДжЈ±еЕ•жіЮеѓЯеТМеѓєжЬ™жЭ•еПСе±ХзЪДйҐДжµЛгАВдї•дЄЛжШѓдїОзїЩеЃЪжЦЗдїґдЄ≠жПРеПЦзЪДдЄ∞еѓМзЯ•иѓЖзВєпЉЪ й¶ЦеЕИпЉМжЦЗж°£жПРеИ∞дЇЖиЃ°зЃЧжЬЇи°МдЄЪдЄ≠зЇ¶270еЃґеЕђеПЄ...

еЬ®зї©жХИеПНй¶ИйЭҐи∞ИдЄ≠пЉМдЄКдЄЛзЇІеПМжЦєеЫЮй°ЊдЇЖињЗеЊАзї©жХИи°®зО∞пЉМиЃ®иЃЇдЇЖеЊЕжФєињЫзЪДйЧЃйҐШзВєеПКжФєињЫжО™жЦљпЉМеєґжОҐиЃ®дЇЖеСШеЈ•зЪДдЄ™дЇЇеЈ•дљЬжГ≥ж≥ХеТМеѓєйГ®йЧ®зЃ°зРЖзЪДеїЇиЃЃгАВ еЬ®зї©жХИз≠ЙзЇІжЦєйЭҐпЉМжЦЗж°£дЄ≠иѓ¶зїЖдїЛзїНдЇЖеЯЇдЇОе≤ЧдљН展иБМжГЕеЖµзЪДзї©жХИз≠ЙзЇІељТе±Юж†ЗеЗЖпЉМеєґе∞Ж...

иЃ°зЃЧжЬЇи°МдЄЪ2020еєіжК•жЪ®2021Q1е≠£жК•еЫЮй°ЊпЉЪдЄЪзї©йЯІжАІдЄОйХњжЬЯдЄїдєЙпЉБ.rar

дЄАгАБ2021Q1йУґи°МзРЖ賥еЄВеЬЇеЫЮй°Њ 1. еЄВеЬЇиІДж®°пЉЪ2021еєідЄАе≠£еЇ¶пЉМжИСеЫљйУґи°МзРЖ賥еЄВеЬЇиІДж®°зїІзї≠дњЭжМБз®≥еЃЪеҐЮйХњпЉМеПНжШ†еЗЇжКХиµДиАЕеѓєз®≥еБ•жКХиµДзЪДйЬАж±ВжМБзї≠еҐЮеЉЇгАВйУґи°МзРЖ賥䯲еУБеЗ≠еАЯеЕґзЫЄеѓєиЊГйЂШзЪДжФґзЫКеТМй£ОйЩ©еПѓжОІжАІпЉМеРЄеЉХдЇЖе§ІйЗПиµДйЗСжµБеЕ•гАВ 2...

Q1CгАБQ1RгАБQ1NгАБQ1Sз≥їеИЧ иљѓдїґеНЗзЇІжЦєж≥ХеПКж≠•й™§ зђђ1ж≠•пЉМеОЛзЉ©еМЕиІ£еОЛпЉМе∞ЖpkgгАБzipеНЗзЇІз®ЛеЇПжЛЈиіЭеИ∞UзЫШж†єзЫЃељХ зђђ2ж≠•пЉМеЬ®еЕ≥жЬЇжГЕеЖµдЄЛпЉМе∞ЖUзЫШжПТеЕ•USB жО•еП£гАВ зђђ3ж≠•пЉМеЉАжЬЇпЉМиЗ™еК®ињЫеЕ•еНЗзЇІж®°еЉПгАВ зђђ4ж≠•пЉМеНЗзЇІеЃМжИРеРОзФµиІЖдЉЪиЗ™еК®йЗНеРѓ...

Q1CгАБQ1RгАБQ1NгАБQ1Sз≥їеИЧ иљѓдїґеНЗзЇІжЦєж≥ХеПКж≠•й™§ зђђ1ж≠•пЉМеОЛзЉ©еМЕиІ£еОЛпЉМе∞ЖpkgгАБzipеНЗзЇІз®ЛеЇПжЛЈиіЭеИ∞UзЫШж†єзЫЃељХ зђђ2ж≠•пЉМеЬ®еЕ≥жЬЇжГЕеЖµдЄЛпЉМе∞ЖUзЫШжПТеЕ•USB жО•еП£гАВ зђђ3ж≠•пЉМеЉАжЬЇпЉМиЗ™еК®ињЫеЕ•еНЗзЇІж®°еЉПгАВ зђђ4ж≠•пЉМеНЗзЇІеЃМжИРеРОзФµиІЖдЉЪиЗ™еК®йЗНеРѓ...

и°МдЄЪ-еЯЇйЗСеЄВеЬЇжЈ±еЇ¶жК•еСКпЉЪ2021Q1еЯЇйЗСеЄВеЬЇдЄЪзї©еЫЮй°Њ.rar

еИ©зОЗеАЇдЊЫзїЩ2022Q1еЫЮй°ЊдЄОQ2е±ХжЬЫпЉЪQ1еПСи°МйЗПеИЫеОЖеП≤еРМжЬЯжЦ∞йЂШпЉМQ2жФњеЇЬеАЇеЗАиЮНиµДе§ІиЗіеЬ®2дЄЗдЇњ.pdf

з¶ЊеЈЭиЗ™еК®еМЦжКАжЬѓжЬЙйЩРеЕђеПЄжО®еЗЇзЪДHCFA Q1з≥їеИЧPACпЉИProgrammable Automation ControllerпЉЙжШѓйЭҐеРСеЈ•дЄЪиЗ™еК®еМЦйҐЖеЯЯзЪДдЄАжђЊйЂШжАІиГљжОІеИґеЩ®гАВPACдљЬдЄЇзїЉеРИдЇЖPLCпЉИеПѓзЉЦз®ЛйАїиЊСжОІеИґеЩ®пЉЙдЄОSCADAпЉИSupervisory Control and Data ...

20210402-賥䜰иѓБеИЄ-еЯЇйЗСеЄВеЬЇжЈ±еЇ¶жК•еСКпЉЪ2021Q1еЯЇйЗСеЄВеЬЇдЄЪзї©еЫЮй°Њ.pdf

жК•еСКж†ЗйҐШпЉЪвАЬ2020еєіQ1еМЧдЇђжИњеЬ∞дЇІеЄВеЬЇеЫЮй°Њ2020з≤ЊеУБжК•еСКвАЭ жК•еСКжППињ∞пЉЪињЩдїљжК•еСКиБЪзД¶дЇО2020еєізђђдЄАе≠£еЇ¶еМЧдЇђжИњеЬ∞дЇІеЄВеЬЇзЪДеРДй°єеЕ≥йФЃжМЗж†ЗеТМеК®жАБпЉМжЧ®еЬ®дЄЇжКХиµДиАЕгАБеЉАеПСеХЖгАБжФњз≠ЦеИґеЃЪиАЕдї•еПКеЕ≥ж≥®жИњеЬ∞дЇІи°МдЄЪзЪДеЕђдЉЧжПРдЊЫиѓ¶еЃЮзЪДжХ∞жНЃ...

20210402-еЕЙе§ІиѓБеИЄ-еИ©зОЗеАЇдЊЫзїЩ2021Q1еЫЮй°ЊдЄОQ2е±ХжЬЫпЉЪдЇМе≠£еЇ¶дЊЫзїЩзЫЄеѓєйЫЖдЄ≠дљЖ4жЬИжЧ†ењІ.pdf

20210508-зФ≥дЄЗеЃПжЇР-иЃ°зЃЧжЬЇи°МдЄЪеС®жК•пЉЪдЄ§е§ІQ1жЈ±еЇ¶еЫЮй°ЊпЉМдњ°жБѓеЃЙеЕ®дЄОиЃ°зЃЧжЬЇжХідљУпЉБ.pdf

DS90UB948Q1жФѓжМБзЪДFPD-Link IIIжО•еП£жКАжЬѓиГље§ЯеЬ®еЗПе∞СдЇТињЮе∞ЇеѓЄеТМйЗНйЗПзЪДеРМжЧґзЃАеМЦз≥їзїЯиЃЊиЃ°пЉМињЩдљњеЊЧеЃГжИРдЄЇеѓєиЃЊиЃ°зБµжіїжАІжЬЙйЂШеЇ¶и¶Бж±ВзЪДиљ¶иљљз≥їзїЯиЃЊиЃ°иАЕзЪДзРЖжГ≥йАЙжЛ©гАВйАЪињЗдљњзФ®еНХйАЪйБУжИЦеПМйАЪйБУйЕНзљЃпЉМDS90UB948Q1иГље§ЯињЫдЄАж≠•жПРйЂШиЃЊиЃ°...

гАРжЈ±еЇ¶з†Фз©ґпЉЪ2022Q1дЄ≠еЫљETFеЄВеЬЇзЫШзВєеЫЮй°ЊгАС дЄ≠еЫљзЪДдЇ§жШУжЙАдЇ§жШУеЯЇйЗСпЉИETFпЉЙеЄВеЬЇеЬ®2022еєізђђдЄАе≠£еЇ¶зїПеОЖдЇЖдЄАжЃµж≥ҐеК®зЪДжЧґжЬЯгАВжК•еСКжМЗеЗЇпЉМ2022Q1жЦ∞жИРзЂЛдЇЖ39еП™ETFпЉМеЕґдЄ≠еМЕжЛђ34еП™иВ°з•®еЮЛETFгАБ4еП™еХЖеУБеЮЛETFеТМ1еП™иЈ®еҐГеЮЛETFгАВе∞љзЃ°жЦ∞...

йЂШеКЫеЫљйЩЕ-жИРйГљ2020Q1зЙ©жµБдїУеВ®еЄВеЬЇеЫЮй°ЊеПКе±ХжЬЫ-2020.5-3й°µз≤ЊеУБжК•еСК.pdf

дїК姩жИСдїђи¶БжОҐиЃ®зЪДжШѓпЉМдЄУдЄЇдЄГељ©иЩєE708 Q1еє≥жЭњзФµиДСиЃЊиЃ°зЪДеЃШжЦєеНЗзЇІеЈ•еЕЈвАФвАФдЄГељ©иЩєеє≥жЭњзФµиДСеЃШжЦєеЈ•еЕЈE708 Q1_SV3.09_CQL_20131126гАВињЩжђЊеЈ•еЕЈзЪДиѓЮзФЯдЄНдїЕжПРеНЗдЇЖиЃЊе§ЗжАІиГљеТМзФ®жИЈдљУй™МпЉМжЫіжШѓеЬ®иљѓдїґжЫіжЦ∞дЄОзїіжК§жЦєйЭҐдЄЇзФ®жИЈеЄ¶жЭ•дЇЖжЮБ...