目前在Java中存在两种锁机制:synchronized和Lock,Lock接口及其实现类是JDK5增加的内容,其作者是大名鼎鼎的并发专家Doug Lea。本文并不比较synchronized与Lock孰优孰劣,只是介绍二者的实现原理。

数据同步需要依赖锁,那锁的同步又依赖谁?synchronized给出的答案是在软件层面依赖JVM,而Lock给出的方案是在硬件层面依赖特殊的CPU指令,大家可能会进一步追问:JVM底层又是如何实现synchronized的?

本文所指说的JVM是指Hotspot的6u23版本,下面首先介绍synchronized的实现:

synrhronized关键字简洁、清晰、语义明确,因此即使有了Lock接口,使用的还是非常广泛。其应用层的语义是可以把任何一个非null对象作为"锁",当synchronized作用在方法上时,锁住的便是对象实例(this);当作用在静态方法时锁住的便是对象对应的Class实例,因为Class数据存在于永久带,因此静态方法锁相当于该类的一个全局锁;当synchronized作用于某一个对象实例时,锁住的便是对应的代码块。在HotSpot JVM实现中,锁有个专门的名字:对象监视器。1. 线程状态及状态转换

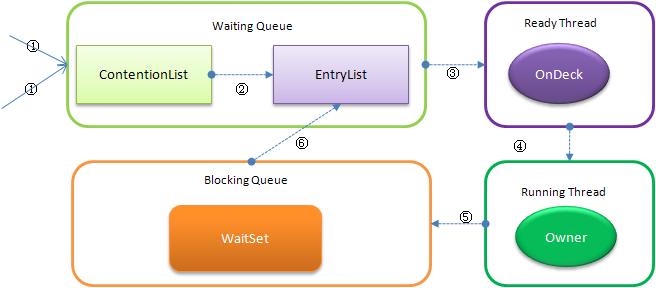

当多个线程同时请求某个对象监视器时,对象监视器会设置几种状态用来区分请求的线程:

- Contention List:所有请求锁的线程将被首先放置到该竞争队列

- Entry List:Contention List中那些有资格成为候选人的线程被移到Entry List

- Wait Set:那些调用wait方法被阻塞的线程被放置到Wait Set

- OnDeck:任何时刻最多只能有一个线程正在竞争锁,该线程称为OnDeck

- Owner:获得锁的线程称为Owner

- !Owner:释放锁的线程

下图反映了个状态转换关系:

新请求锁的线程将首先被加入到ConetentionList中,当某个拥有锁的线程(Owner状态)调用unlock之后,如果发现EntryList为空则从ContentionList中移动线程到EntryList,下面说明下ContentionList和EntryList的实现方式:

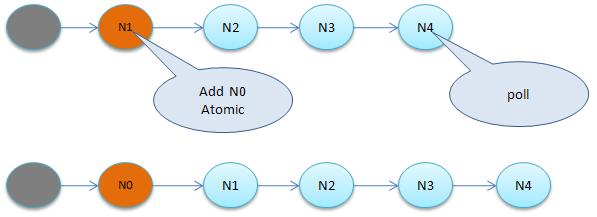

1.1 ContentionList虚拟队列

ContentionList并不是一个真正的Queue,而只是一个虚拟队列,原因在于ContentionList是由Node及其next指针逻辑构成,并不存在一个Queue的数据结构。ContentionList是一个后进先出(LIFO)的队列,每次新加入Node时都会在队头进行,通过CAS改变第一个节点的的指针为新增节点,同时设置新增节点的next指向后续节点,而取得操作则发生在队尾。显然,该结构其实是个Lock-Free的队列。

因为只有Owner线程才能从队尾取元素,也即线程出列操作无争用,当然也就避免了CAS的ABA问题。

1.2 EntryList

EntryList与ContentionList逻辑上同属等待队列,ContentionList会被线程并发访问,为了降低对ContentionList队尾的争用,而建立EntryList。Owner线程在unlock时会从ContentionList中迁移线程到EntryList,并会指定EntryList中的某个线程(一般为Head)为Ready(OnDeck)线程。Owner线程并不是把锁传递给OnDeck线程,只是把竞争锁的权利交给OnDeck,OnDeck线程需要重新竞争锁。这样做虽然牺牲了一定的公平性,但极大的提高了整体吞吐量,在Hotspot中把OnDeck的选择行为称之为“竞争切换”。

OnDeck线程获得锁后即变为owner线程,无法获得锁则会依然留在EntryList中,考虑到公平性,在EntryList中的位置不发生变化(依然在队头)。如果Owner线程被wait方法阻塞,则转移到WaitSet队列;如果在某个时刻被notify/notifyAll唤醒,则再次转移到EntryList。

2. 自旋锁

那些处于ContetionList、EntryList、WaitSet中的线程均处于阻塞状态,阻塞操作由操作系统完成(在Linxu下通过pthread_mutex_lock函数)。线程被阻塞后便进入内核(Linux)调度状态,这个会导致系统在用户态与内核态之间来回切换,严重影响锁的性能

缓解上述问题的办法便是自旋,其原理是:当发生争用时,若Owner线程能在很短的时间内释放锁,则那些正在争用线程可以稍微等一等(自旋),在Owner线程释放锁后,争用线程可能会立即得到锁,从而避免了系统阻塞。但Owner运行的时间可能会超出了临界值,争用线程自旋一段时间后还是无法获得锁,这时争用线程则会停止自旋进入阻塞状态(后退)。基本思路就是自旋,不成功再阻塞,尽量降低阻塞的可能性,这对那些执行时间很短的代码块来说有非常重要的性能提高。自旋锁有个更贴切的名字:自旋-指数后退锁,也即复合锁。很显然,自旋在多处理器上才有意义。

还有个问题是,线程自旋时做些啥?其实啥都不做,可以执行几次for循环,可以执行几条空的汇编指令,目的是占着CPU不放,等待获取锁的机会。所以说,自旋是把双刃剑,如果旋的时间过长会影响整体性能,时间过短又达不到延迟阻塞的目的。显然,自旋的周期选择显得非常重要,但这与操作系统、硬件体系、系统的负载等诸多场景相关,很难选择,如果选择不当,不但性能得不到提高,可能还会下降,因此大家普遍认为自旋锁不具有扩展性。

对自旋锁周期的选择上,HotSpot认为最佳时间应是一个线程上下文切换的时间,但目前并没有做到。经过调查,目前只是通过汇编暂停了几个CPU周期,除了自旋周期选择,HotSpot还进行许多其他的自旋优化策略,具体如下:

- 如果平均负载小于CPUs则一直自旋

- 如果有超过(CPUs/2)个线程正在自旋,则后来线程直接阻塞

- 如果正在自旋的线程发现Owner发生了变化则延迟自旋时间(自旋计数)或进入阻塞

- 如果CPU处于节电模式则停止自旋

- 自旋时间的最坏情况是CPU的存储延迟(CPU A存储了一个数据,到CPU B得知这个数据直接的时间差)

- 自旋时会适当放弃线程优先级之间的差异

那synchronized实现何时使用了自旋锁?答案是在线程进入ContentionList时,也即第一步操作前。线程在进入等待队列时首先进行自旋尝试获得锁,如果不成功再进入等待队列。这对那些已经在等待队列中的线程来说,稍微显得不公平。还有一个不公平的地方是自旋线程可能会抢占了Ready线程的锁。自旋锁由每个监视对象维护,每个监视对象一个。

3. 偏向锁

在JVM1.6中引入了偏向锁,偏向锁主要解决无竞争下的锁性能问题,首先我们看下无竞争下锁存在什么问题:

现在几乎所有的锁都是可重入的,也即已经获得锁的线程可以多次锁住/解锁监视对象,按照之前的HotSpot设计,每次加锁/解锁都会涉及到一些CAS操作(比如对等待队列的CAS操作),CAS操作会延迟本地调用,因此偏向锁的想法是一旦线程第一次获得了监视对象,之后让监视对象“偏向”这个线程,之后的多次调用则可以避免CAS操作,说白了就是置个变量,如果发现为true则无需再走各种加锁/解锁流程。但还有很多概念需要解释、很多引入的问题需要解决:

3.1 CAS及SMP架构

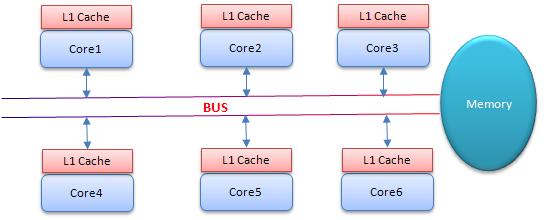

CAS为什么会引入本地延迟?这要从SMP(对称多处理器)架构说起,下图大概表明了SMP的结构:

其意思是所有的CPU会共享一条系统总线(BUS),靠此总线连接主存。每个核都有自己的一级缓存,各核相对于BUS对称分布,因此这种结构称为“对称多处理器”。

而CAS的全称为Compare-And-Swap,是一条CPU的原子指令,其作用是让CPU比较后原子地更新某个位置的值,经过调查发现,其实现方式是基于硬件平台的汇编指令,就是说CAS是靠硬件实现的,JVM只是封装了汇编调用,那些AtomicInteger类便是使用了这些封装后的接口。

Core1和Core2可能会同时把主存中某个位置的值Load到自己的L1 Cache中,当Core1在自己的L1 Cache中修改这个位置的值时,会通过总线,使Core2中L1 Cache对应的值“失效”,而Core2一旦发现自己L1 Cache中的值失效(称为Cache命中缺失)则会通过总线从内存中加载该地址最新的值,大家通过总线的来回通信称为“Cache一致性流量”,因为总线被设计为固定的“通信能力”,如果Cache一致性流量过大,总线将成为瓶颈。而当Core1和Core2中的值再次一致时,称为“Cache一致性”,从这个层面来说,锁设计的终极目标便是减少Cache一致性流量。

而CAS恰好会导致Cache一致性流量,如果有很多线程都共享同一个对象,当某个Core CAS成功时必然会引起总线风暴,这就是所谓的本地延迟,本质上偏向锁就是为了消除CAS,降低Cache一致性流量。

Cache一致性:

上面提到Cache一致性,其实是有协议支持的,现在通用的协议是MESI(最早由Intel开始支持),具体参考:http://en.wikipedia.org/wiki/MESI_protocol,以后会仔细讲解这部分。

Cache一致性流量的例外情况:

其实也不是所有的CAS都会导致总线风暴,这跟Cache一致性协议有关,具体参考:http://blogs.oracle.com/dave/entry/biased_locking_in_hotspot

NUMA(Non Uniform Memory Access Achitecture)架构:

与SMP对应还有非对称多处理器架构,现在主要应用在一些高端处理器上,主要特点是没有总线,没有公用主存,每个Core有自己的内存,针对这种结构此处不做讨论。

3.2 偏向解除

偏向锁引入的一个重要问题是,在多争用的场景下,如果另外一个线程争用偏向对象,拥有者需要释放偏向锁,而释放的过程会带来一些性能开销,但总体说来偏向锁带来的好处还是大于CAS代价的。

4. 总结

关于锁,JVM中还引入了一些其他技术比如锁膨胀等,这些与自旋锁、偏向锁相比影响不是很大,这里就不做介绍。

通过上面的介绍可以看出,synchronized的底层实现主要依靠Lock-Free的队列,基本思路是自旋后阻塞,竞争切换后继续竞争锁,稍微牺牲了公平性,但获得了高吞吐量。下面会继续介绍JVM锁中的Lock(深入JVM锁2-Lock)。

相关推荐

了解 JVM 锁机制中的 synchronized 和 Lock 实现...因此,了解 JVM 锁机制中的 synchronized 和 Lock 实现原理对于理解 Java 并发编程非常重要。了解这些原理可以帮助开发者更好地选择锁机制,提高程序的性能和可靠性。

- 同步机制:掌握synchronized关键字,了解锁的概念,包括可重入锁、死锁、活锁和饥饿状态。 - 线程池:熟悉ExecutorService和ThreadPoolExecutor,以及线程池的配置和优化。 - 并发工具类:了解...

在 JVM 中,偏斜锁、轻量级锁、重量级锁是三种不同的锁机制。它们的使用场景和实现原理不同,以适应不同的应用场景。 synchronized 关键字的优化 在不同的JDK版本中,synchronized 关键字的实现原理不同,以适应...

在深入探讨Java虚拟机(JVM)如何处理线程间的资源同步与交互机制之前,我们先来明确几个关键概念:线程、多线程、同步、并发以及它们在Java中的实现方式。Java作为一种广泛应用于分布式系统开发的编程语言,其内部...

综上所述,Synchronized关键字是Java并发编程中的一个重要组成部分,通过对其实现机制的理解以及JVM对其优化策略的掌握,可以更有效地在多线程环境中使用Synchronized来保证数据的一致性和安全性。

Java提供了多种并发工具和机制,如synchronized关键字、volatile关键字、各种锁机制、以及java.util.concurrent包下的并发类和接口。 描述中提到了一个博文链接,尽管没有给出具体内容,但根据标题,我们可以推测该...

综上,`synchronized`关键字是Java中实现线程同步的关键,通过多种优化策略提升了并发性能,并提供了不同级别的锁机制来适应不同的场景需求。理解并熟练掌握`synchronized`的使用对于编写高性能、线程安全的Java程序...

Java并发编程中的synchronized关键字是实现线程安全的重要工具,它提供了一种互斥访问机制,确保了共享数据在同一时刻只能被一个线程访问。synchronized关键字有三种主要的应用方式: 1. 修饰实例方法:当...

本章“jdk6.0从入门到精通-----chapter8并发多线程(1)”着重讲解了Java 6中关于多线程的基本知识和实践技巧。通过源码下载,读者可以更直观地理解多线程的实现方式。 首先,我们要理解什么是多线程。在单线程环境...

7. **多线程与并发**:讲解JVM中的线程创建、同步机制(如synchronized、Lock),以及并发容器(如ConcurrentHashMap)的实现原理。 8. **类文件结构**:分析.class文件的组成,包括魔数、版本号、常量池、访问标志...

本文将全面介绍Java并发编程的基础知识、JVM同步原语、线程安全、低级并发工具、线程安全容器、高级线程协作工具以及Executor服务。 1. **基础知识** - **并发与并行**:并发是指多个任务在同一时间段内交替执行,...

锁机制是Java实现同步的主要手段,其中synchronized关键字扮演了核心角色。 synchronized可以用于修饰方法或代码块,两者在锁的粒度上有区别。同步方法的锁粒度较大,整个方法体被视为同步区域,而同步代码块则更细...

- **锁优化**:了解synchronized、Lock接口及其实现,以及乐观锁、读写锁等并发控制策略。 通过学习这些知识点,并结合《实战Java虚拟机——JVM故障诊断与性能优化》的源码,开发者能够更深入地理解JVM的工作机制...

线程同步和锁机制,如synchronized关键字和Lock接口,是Java并发编程的基础。 通过深入学习"java课件-7-JVM",开发者可以更好地理解Java程序的运行机制,优化代码性能,解决内存泄漏和线程安全问题,从而提升软件...

本文主要讨论了四种锁类型:乐观锁、悲观锁、自旋锁以及Java中的synchronized同步锁,并深入解析了synchronized锁的内部机制,包括其核心组件、实现方式以及锁的状态。 1. **乐观锁**:乐观锁假设在多线程环境下,...

- **锁机制**:深入学习ReentrantLock(可重入锁)、公平锁与非公平锁、读写锁等高级锁的用法。 - **原子操作与CAS**:了解Atomic类和Compare and Swap(CAS)无锁编程模型,以及它们在高并发下的优势。 3. **...

总的来说,Java的`synchronized`通过对象头的Mark Word和Monitor对象实现了线程安全的同步机制,同时引入了偏向锁、轻量级锁和自旋锁等优化手段,以平衡性能和线程安全性。理解这些锁的工作原理对于编写高性能的并发...

- **锁优化**:使用`synchronized`关键字的粒度控制,或者使用`ReentrantLock`等高级锁,可以提高并发性能。 - **并发容器**:如`ConcurrentHashMap`和`CopyOnWriteArrayList`等,设计为线程安全,比传统同步容器...

7-1 同步容器与并发容器.mp4 7-2 同步容器.mp4 7-3 并发容器.mp4 7-4 LinkedBlockingQueue的使用及其源码探秘.mp4 8-1 CountDownLatch的使用及其源码探秘.mp4 8-2 CyclicBarrier的使用及其源码探秘.mp4 8-3 ...

- 官方提供的JVM并发编程源代码可以帮助我们深入了解JVM如何实现并发,包括线程调度、内存模型的细节以及同步原语的实现。 - 通过分析源代码,可以学习到如何高效地编写并发程序,提升性能和稳定性。 通过深入...