¬† ¬† ¬† ¬†жИСдїђзО∞еЬ®еЕђеПЄжЙАжЬЙе§ІжХ∞жНЃеє≥еП∞еЕ®йГ®дЄКдЇСеє≥еП∞пЉМе§ІжХ∞жНЃдљњзФ®зЪДaws EMRпЉМйЪПзЭАжХ∞жНЃжЪіеҐЮеЄ¶жЭ•жПРжХ∞жЕҐпЉМжПРжХ∞йЪЊпЉМеЊИйЪЊжї°иґ≥жХ∞жНЃеИЖжЮРеЄИгАБињРиР•дЇЇеСШгАБйФАеФЃзЪДйЬАж±ВпЉМзЙєеИЂжШѓжИСдїђзО∞еЬ®еХЖдЄЪеПШзО∞йГ®йЧ®зЪДйФАеФЃдЇЇеСШеОїеЃҐжИЈзО∞еЬЇињЫи°МжХ∞жНЃжЉФз§ЇжЧґзЪДеН≥еЄ≠жߕ胥гАВдЇОжШѓжИСдїђеХЖдЄЪеПШзО∞жХ∞жНЃеЫҐйШЯеѓєељУдЄЛOLAPж°ЖжЮґињЫи°МйАЙеЮЛпЉМжЬАзїИйАЙжЛ©kylinдљЬдЄЇжИСдїђDMPеє≥еП∞еЇХе±ВзЪДиЃ°зЃЧеЉХжУОпЉМдљЖжШѓжИСдїђеЬ®жµЛиѓХдЄ≠еПСзО∞kylinзЙИжЬђдЄНжФѓжМБaws glue data catalogпЉМдљЖжШѓжИСдїђзО∞еЬ®жЙАжЬЙжХ∞жНЃеЫҐйШЯзЪДеЕГжХ∞жНЃйГљжШѓдљњзФ®aws glueжЭ•ињЫи°Ме≠ШеВ®пЉМињЩж†ЈеЄ¶жЭ•зЪДе•ље§ДеЬ®дЇОhiveгАБprestoгАБsparkдЄ≠зЪДеїЇзЂЛзЪДи°®еПѓдї•еЬ®еЕ±дЇЂжߕ胥пЉМдљњеЊЧжѓПдЄ™дЄїйҐШйГљдЄ≤иБФиµЈжݕ嚥жИРдЄАдЄ™е§ІзЪДзЂЛжЦєдљУпЉМжЙУз†ізЙ©зРЖйЪЬзҐНгАВ

¬† ¬† ¬† йВ£дїАдєИжШѓaws glue пЉЯ

AWS Glue жШѓдЄАй°єеЃМеЕ®жЙШзЃ°зЪД ETLпЉИжПРеПЦгАБиљђжНҐеТМеК†иљљпЉЙжЬНеК°пЉМдљњжВ®иГље§ЯиљїжЭЊиАМзїПжµОйЂШжХИеЬ∞еѓєжХ∞жНЃињЫи°МеИЖз±їгАБжЄЕзРЖеТМжЙ©еЕЕпЉМеєґеЬ®еРДзІНжХ∞жНЃе≠ШеВ®дєЛйЧіеПѓйЭ†еЬ∞зІїеК®жХ∞жНЃгАВAWS Glue зФ±дЄАдЄ™зІ∞дЄЇ AWS Glue жХ∞жНЃзЫЃељХзЪДдЄ≠е§ЃеЕГжХ∞жНЃе≠ШеВ®еЇУгАБдЄАдЄ™иЗ™еК®зФЯжИРдї£з†БзЪД ETL еЉХжУОдї•еПКдЄАдЄ™е§ДзРЖдЊЭиµЦй°єиІ£жЮРгАБдљЬдЄЪзЫСжОІеТМйЗНиѓХзЪДзБµжіїиЃ°еИТз®ЛеЇПзїДжИРгАВAWS Glue жШѓжЧ†жЬНеК°еЩ®жЬНеК°пЉМеЫ†ж≠§жЧ†йЬАиЃЊзљЃжИЦзЃ°зРЖеЯЇз°АиЃЊжЦљгАВзЬЛзЭАеЃШжЦєзЪДиІ£йЗКеПѓиГљжѓФиЊГжЗµжЗВпЉМйАЪдњЧзЪДиѓіжИСдїђеЬ®дљњзФ®aws зЪДEMRпЉМзїДдїґдЄїи¶БеМЕжЛђhadoopгАБsparkгАБhiveгАБprestoз≠ЙпЉМе¶ВжЮЬж≤°жЬЙйЕНзљЃдљњзФ®aws glue data catalogпЉМйВ£дєИеЬ®еРДдЄ™жХ∞жНЃдїУеЇУзїДдїґhiveгАБsparkгАБhiveгАБprestoеїЇзЪДжХ∞жНЃи°®пЉМеЬ®еЕґеЃГзїДдїґдЄКжШѓжЙЊдЄНеИ∞зЪДпЉМдєЯе∞±дЄНиГљдљњзФ®пЉМеЕђеПЄеЇХе±ВзЪДжХ∞жНЃдїУеЇУжШѓжПРдЊЫзїЩеРДдЄ™дЄЪеК°йГ®йЧ®жЭ•ињЫи°МдљњзФ®пЉМдЄЇдЇЖиІ£еЖ≥ињЩдЄ™йЧЃйҐШпЉМеЬ®еИЫеїЇEMRжЧґе∞±еПѓдї•дљњзФ®aws glue data catalogжЭ•е≠ШеВ®еЕГжХ∞жНЃпЉМеѓєеРДдЄ™зїДдїґеЕ±дЇЂжХ∞жНЃжЇРпЉМеѓєеРДдЄ™дЄЪеК°йГ®йЧ®ињЫи°МеЕ±дЇЂжХ∞жНЃжЇРпЉМе∞ЖеРДдЄ™дЄЪеК°йГ®йЧ®зЪДжХ∞жНЃжЮДеїЇжИРдЄАдЄ™е§ІзЪДжХ∞жНЃзЂЛжЦєдљУпЉМиГље§ЯењЂйАЯеУНеЇФеЕђеПЄйЂШйАЯеПСе±ХзЪДдЄЪеК°йЬАж±ВгАВ

¬† ¬† ¬† ¬† жИСдїђжШѓжАОдєИдњЃжФєkylinзЪДдї£з†БеЃМжИРжФѓжМБaws glueзЪДпЉЯ

(1) еПСзО∞йЧЃйҐШ-еК†иљљжХ∞жНЃжЇРжЧґдЄНжФѓжМБaws glue data catalog

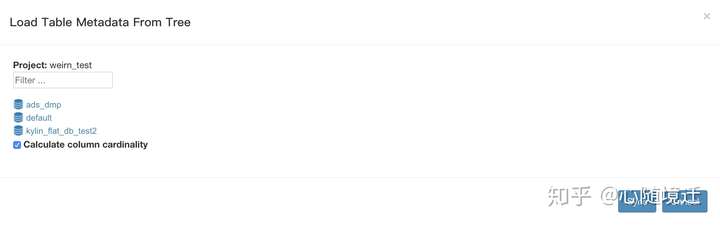

hiveдЄ≠йЕНзљЃдЇЖдљњзФ®aws glue data catalogе≠ШеВ®еЕГжХ∞жНЃпЉМйГ®зљ≤kylinеРОеПѓдї•ж≠£еЄЄеРѓеК®пЉМдљЖжШѓзЩїйЩЖkylin web uiеК†иљљжХ∞жНЃжЇРжЧґпЉМеП™зЬЛеИ∞иѓ•EMRйЫЖзЊ§зЪДhive жХ∞жНЃжЇРиАМеЕґдїЦзЪДжЧ†ж≥ХзЬЛеИ∞пЉМе¶ВеЫЊ

ињЩдЄЙдЄ™жХ∞жНЃеЇУжШѓиѓ•EMRйЫЖзЊ§иЗ™еЈ±зЪДжХ∞жНЃеЇУпЉМиАМжИСдїђжХідЄ™еЕђеПЄзЪДжХ∞жНЃеЇУињЬињЬдЄНж≠ҐињЩдЇЫгАВdebugдї£з†БињЫеОїеПСзО∞еК†иљљжХ∞жНЃжЇРжЧґиОЈеПЦmetastoreclientзЪДз±їCLIHiveClient.java

private IMetaStoreClient getMetaStoreClient() throws Exception {

if (metaStoreClient == null) {

metaStoreClient = new HiveMetaStoreClient(hiveConf);

}

return metaStoreClient;

}

¬†зЫЃеЙНеП™жФѓжМБHiveMetaStoreClientпЉМиАМж≤°жЬЙзЬЛеИ∞дїїдљХжФѓжМБAWSCatalogMetastoreClientзЪДзЫЄеЕ≥дї£з†БгАВ

пЉИ2пЉЙеПСзО∞йЧЃйҐШ-build cubeжК•иОЈеПЦAWSCatalogMetastoreClientеЉВеЄЄпЉМdebugдї£з†БеПСзО∞kylinеЬ®build job зђђ1йШґжЃµCreate Flat Table & Materialize Hive View in Lookup TablesдљњзФ®hcatalogиѓїеПЦhiveи°®зЪДжХ∞жНЃпЉМиЃ°зЃЧеРОжПТеЕ•жЦ∞зЪДhiveи°®гАВ

public CubingJob build() {

logger.info("MR_V2 new job to BUILD segment " + seg);

final CubingJob result = CubingJob.createBuildJob(seg, submitter, config);

final String jobId = result.getId();

final String cuboidRootPath = getCuboidRootPath(jobId);

// Phase 1: Create Flat Table & Materialize Hive View in Lookup Tables

inputSide.addStepPhase1_CreateFlatTable(result);

// Phase 2: Build Dictionary

result.addTask(createFactDistinctColumnsStep(jobId));

if (isEnableUHCDictStep()) {

result.addTask(createBuildUHCDictStep(jobId));

}

result.addTask(createBuildDictionaryStep(jobId));

result.addTask(createSaveStatisticsStep(jobId));

// add materialize lookup tables if needed

LookupMaterializeContext lookupMaterializeContext = addMaterializeLookupTableSteps(result);

outputSide.addStepPhase2_BuildDictionary(result);

if (seg.getCubeDesc().isShrunkenDictFromGlobalEnabled()) {

result.addTask(createExtractDictionaryFromGlobalJob(jobId));

}

// Phase 3: Build Cube

addLayerCubingSteps(result, jobId, cuboidRootPath); // layer cubing, only selected algorithm will execute

addInMemCubingSteps(result, jobId, cuboidRootPath); // inmem cubing, only selected algorithm will execute

outputSide.addStepPhase3_BuildCube(result);

// Phase 4: Update Metadata & Cleanup

result.addTask(createUpdateCubeInfoAfterBuildStep(jobId, lookupMaterializeContext));

inputSide.addStepPhase4_Cleanup(result);

outputSide.addStepPhase4_Cleanup(result);

// Set the task priority if specified

result.setPriorityBasedOnPriorityOffset(priorityOffset);

result.getTasks().forEach(task -> task.setPriorityBasedOnPriorityOffset(priorityOffset));

return result;

}

¬†жЬАеРОи∞ГзФ®и∞ГзФ®HiveMRInput.java

public void configureJob(Job job) {

try {

job.getConfiguration().addResource("hive-site.xml");

//иѓ•жЦєж≥ХеЖЕйГ®дљњзФ®еПНе∞ДиОЈеПЦmetastoreclientпЉМе¶ВжЮЬеЬ®hive-siteйЕНзљЃдЇЖ

<property>

<name>hive.metastore.client.factory.class</name>

<value>com.amazonaws.glue.catalog.metastore.AWSGlueDataCatalogHiveClientFactory</value>

</property>

йВ£дєИйАЪињЗеПНе∞ДиОЈеПЦAWSGlueDataCatalogHiveClientFactory

HCatInputFormat.setInput(job, dbName, tableName);

job.setInputFormatClass(HCatInputFormat.class);

} catch (IOException e) {

throw new RuntimeException(e);

}

}

¬†жК•е¶ВдЄЛеЉВеЄЄпЉЪ

Caused by: com.google.common.util.concurrent.ExecutionError: java.lang.AbstractMethodError: com.amazonaws.glue.catalog.metastore.AWSGlueDataCatalogHiveClientFactory.createMetaStoreClient(Lorg/apache/hadoop/hive/conf/HiveConf;Lorg/apache/hadoop/hive/metastore/HiveMetaHookLoader;ZLjava/util/concurrent/ConcurrentHashMap;)Lorg/apache/hadoop/hive/metastore/IMetaStoreClient;

at com.google.common.cache.LocalCache$Segment.get(LocalCache.java:2261) ~[kylin-job-2.6.4.jar:2.6.4]

at com.google.common.cache.LocalCache.get(LocalCache.java:4000) ~[kylin-job-2.6.4.jar:2.6.4]

at com.google.common.cache.LocalCache$LocalManualCache.get(LocalCache.java:4789) ~[kylin-job-2.6.4.jar:2.6.4]

at org.apache.hive.hcatalog.common.HiveClientCache.getOrCreate(HiveClientCache.java:315) ~[hive-hcatalog-core-2.3.5-amzn-1.jar:2.3.5-amzn-1]

at org.apache.hive.hcatalog.common.HiveClientCache.get(HiveClientCache.java:277) ~[hive-hcatalog-core-2.3.5-amzn-1.jar:2.3.5-amzn-1]

at org.apache.hive.hcatalog.common.HCatUtil.getHiveMetastoreClient(HCatUtil.java:558) ~[hive-hcatalog-core-2.3.5-amzn-1.jar:2.3.5-amzn-1]

at org.apache.hive.hcatalog.mapreduce.InitializeInput.getInputJobInfo(InitializeInput.java:104) ~[hive-hcatalog-core-2.3.5-amzn-1.jar:2.3.5-amzn-1]

at org.apache.hive.hcatalog.mapreduce.InitializeInput.setInput(InitializeInput.java:88) ~[hive-hcatalog-core-2.3.5-amzn-1.jar:2.3.5-amzn-1]

at org.apache.hive.hcatalog.mapreduce.HCatInputFormat.setInput(HCatInputFormat.java:95) ~[hive-hcatalog-core-2.3.5-amzn-1.jar:2.3.5-amzn-1]

at org.apache.hive.hcatalog.mapreduce.HCatInputFormat.setInput(HCatInputFormat.java:51) ~[hive-hcatalog-core-2.3.5-amzn-1.jar:2.3.5-amzn-1]

at org.apache.kylin.source.hive.HiveMRInput$HiveTableInputFormat.configureJob(HiveMRInput.java:80) ~[kylin-source-hive-2.6.4.jar:2.6.4]

at org.apache.kylin.engine.mr.steps.FactDistinctColumnsJob.setupMapper(FactDistinctColumnsJob.java:126) ~[kylin-engine-mr-2.6.4.jar:2.6.4]

at org.apache.kylin.engine.mr.steps.FactDistinctColumnsJob.run(FactDistinctColumnsJob.java:104) ~[kylin-engine-mr-2.6.4.jar:2.6.4]

at org.apache.kylin.engine.mr.common.MapReduceExecutable.doWork(MapReduceExecutable.java:131) ~[kylin-engine-mr-2.6.4.jar:2.6.4]

at org.apache.kylin.job.execution.AbstractExecutable.execute(AbstractExecutable.java:167) ~[kylin-core-job-2.6.4.jar:2.6.4]

at org.apache.kylin.job.execution.DefaultChainedExecutable.doWork(DefaultChainedExecutable.java:71) ~[kylin-core-job-2.6.4.jar:2.6.4]

at org.apache.kylin.job.execution.AbstractExecutable.execute(AbstractExecutable.java:167) ~[kylin-core-job-2.6.4.jar:2.6.4]

... 4 more

¬†йАЪињЗеЉВеЄЄдњ°жБѓеПѓдї•зЬЛеИ∞з±їAWSGlueDataCatalogHiveClientFactoryжО•еП£дЄНеЕЉеЃєпЉМиЈЯиЄ™жЯ•зЬЛAWSGlueDataCatalogHiveClientжЇРз†БпЉМAWSGlueDataCatalogHiveClientеЕЈдљУзЉЦиѓСињРи°МжЙУеМЕиѓ¶иІБпЉЪ

https://github.com/awslabs/aws-glue-data-catalog-client-for-apache-hive-metastore

йЧЃйҐШжЙЊеИ∞пЉМдњЃжФєдї£з†БпЉМжµЛиѓХеєґеЬ®SHAREitзФЯдЇІзОѓеҐГињРи°МпЉМжЇРз†БеЈ≤зїПжПРдЇ§githubгАВ

jiraеЬ∞еЭАпЉЪ

https://issues.apache.org/jira/browse/KYLIN-4206

githubжЇРз†БеЬ∞еЭАпЉЪ

<!--?xml version="1.0" encoding="UTF-8"?--> https://github.com/apache/kylin/pull/1040

еЃМзЊОжФѓжМБеРОе¶ВдЄЛеЫЊпЉЪ

жДЯи∞ҐkylingenceзЪДдњЮйЬДзњФеТМеЉ†дЇЪеА©зЪДеЄЃеК©гАВ

жЬ™еЃМеЊЕзї≠......

йЯ¶иН£иГљпЉМиМДе≠РењЂдЉ†еєњеСКе§ІжХ∞жНЃеТМеЈ•з®ЛиіЯиі£дЇЇпЉМ8еєіе§ІжХ∞жНЃжЮґжЮДеПКеЉАеПСзїПй™МпЉМжУЕйХњеЇХе±Ве§ІжХ∞жНЃж°ЖжЮґзЪДи∞ГдЉШпЉМжЬЙе§ЪдЄ™дїО0еИ∞1зЪДдЇІеУБзїПй™МгАВ

зЫЄеЕ≥жО®иНР

debеМЕеЃМзЊОињЫи°Мз¶їзЇњеЃЙи£Еdocker,йАВзФ®дЇОubuntuз≥їзїЯпЉМKylinз≥їзїЯпЉМзїЩеЗЇеЃЙи£ЕињЗз®ЛжЬЙеПѓиГљзЉЇе∞СеЇУдЊЭиµЦзЪДиІ£еЖ≥еКЮж≥ХпЉМдї•еРОеѓєдЇОdebеМЕзЉЇе∞Сдї•иµЦеЇУйГљеПѓдї•зФ®ж≠§жЦєж≥Х

иѓ•жЦЗдїґдїЛзїНдЇЖдЄАдЄ™еЯЇдЇОAWSпЉИAmazon Web ServicesпЉЙеТМApache KylinзЪДжХ∞жНЃеИЖжЮРжЬНеК°иІ£еЖ≥жЦєж°ИгАВињЩдЄ™иІ£еЖ≥жЦєж°ИжЧ®еЬ®еЄЃеК©йВ£дЇЫдЄНзЖЯжВЙе§ІжХ∞жНЃжКАжЬѓзЪДзФ®жИЈдєЯиГљдїОжХ∞жНЃеИЖжЮРдЄ≠еПЧзЫКпЉМйАЪињЗжПРдЊЫдЄАзЂЩеЉПеїЇзЂЩжЬНеК°еТМеЊЃдњ°е∞Пз®ЛеЇПпЉМжЬНеК°еЕ®зРГжХ∞...

KylinињШжФѓжМБдЄОеЕґдїЦеЈ•еЕЈзЪДйЫЖжИРпЉМдЊЛе¶ВдЄОTableauгАБExcelзЪДињЮжО•пЉМдљњеЊЧзФ®жИЈеПѓдї•еЬ®ињЩдЇЫBIеЈ•еЕЈдЄ≠зЫіжО•жߕ胥Kylin CubeгАВеРМжЧґпЉМKylinжПРдЊЫдЇЖдЄАе•ЧеЃМжХізЪДAPIпЉМеЉАеПСиАЕеПѓдї•еИ©зФ®ињЩдЇЫAPIеЉАеПСиЗ™еЃЪдєЙзЪДеЇФзФ®з®ЛеЇПпЉМеЃЮзО∞жЫідЄ∞еѓМзЪДеИЖжЮРеКЯиГљгАВ...

KylinпЉМжЇРиЗ™LinkedInпЉМжШѓдЄАжђЊеЉАжЇРзЪДеИЖеЄГеЉПеИЖжЮРеЉХжУОпЉМдЄУдЄЇApache HadoopиЃЊиЃ°пЉМжЧ®еЬ®жПРдЊЫдЇЪзІТзЇІзЪДSQLжߕ胥иГљеКЫпЉМжФѓжМБе§ІиІДж®°жХ∞жНЃйЫЖгАВKylinдї•еЕґйЂШжАІиГљгАБжШУзФ®жАІеТМдЄОHadoopзФЯжАБз≥їзїЯзЪДжЧ†зЉЭйЫЖжИРиАМе§ЗеПЧжО®еіЗпЉМе∞§еЕґеЬ®е§ІжХ∞жНЃеИЖжЮР...

### Apache KylinеЃЙи£ЕйГ®зљ≤зЯ•иѓЖзВєиѓ¶иІ£ #### дЄАгАБApache KylinзЃАдїЛ Apache KylinжШѓдЄАжђЊеЉАжЇРзЪДеИЖеЄГеЉПеИЖжЮРеЉХжУОпЉМеЃГиГље§ЯдЄЇHadoopжПРдЊЫSQLжߕ胥жО•еП£дї•еПКе§ЪзїіеИЖжЮРпЉИOLAPпЉЙиГљеКЫпЉМе∞§еЕґйАВзФ®дЇОе§ДзРЖе§ІиІДж®°зЪДжХ∞жНЃйЫЖгАВKylinжЬАеИЭзФ±...

KylinжШѓдЄАзІНMOLAPзЪДжХ∞жНЃеИЖжЮРеЉХжУОгАВжЬАжЧ©зФ±eBayдЄ≠еЫљз†ФеПСдЄ≠ењГиі°зМЃзїЩApacheеЯЇйЗСгАВ KylinзЙєзВєпЉЪ жХ∞жНЃжЇРеТМж®°еЮЛпЉЪдЄїи¶БжФѓжМБHiveгАБKafka жЮДеїЇеЉХжУОпЉЪжЧ©жЬЯжФѓжМБMapReduceиЃ°зЃЧеЉХжУОпЉМжЦ∞зЙИжЬђжФѓжМБSparkгАБFlinkиЃ°зЃЧеЉХжУОгАВйЩ§дЇЖеЕ®йЗПжЮДеїЇ...

KylinжФѓжМБе§ЪзІНжХ∞жНЃжЇРпЉМеПѓдї•е∞ЖжХ∞жНЃе≠ШеВ®еЬ®еРДзІНеИЖеЄГеЉПе≠ШеВ®з≥їзїЯдЄ≠пЉМжѓФе¶ВHDFSгАБS3жИЦжЬђеЬ∞е≠ШеВ®пЉМеєґжПРдЊЫењЂйАЯжߕ胥зЪДеИЖжЮРиГљеКЫгАВеЬ®жЬђжЦЗж°£дЄ≠пЉМжИСдїђе∞ЖйЗНзВєдїЛзїНKylinжЦ∞жФѓжМБзЪДParquetе≠ШеВ®ж†ЉеЉПпЉМдї•еПКеЕґеЯЇдЇОSparkеЉХжУОзЪДCubeжЮДеїЇгАВ ##...

Apache Kylin зОѓеҐГжР≠еїЇзђФиЃ∞ Apache Kylin жШѓдЄАдЄ™еЯЇдЇОеИЖеЄГеЉПжЮґжЮДзЪДдЉБдЄЪзЇІжХ∞жНЃеИЖжЮРеє≥еП∞пЉМзФ± Apache иљѓдїґеЯЇйЗСдЉЪеЉАеПСеТМзїіжК§гАВKylin зОѓеҐГжР≠еїЇжШѓдЄАдЄ™е§НжЭВзЪДињЗз®ЛпЉМйЬАи¶БйАРж≠•йЕНзљЃеТМжµЛиѓХгАВжЬђжЦЗе∞ЖжМЗеѓЉиѓїиАЕдїОе§іеЉАеІЛжР≠еїЇ Apache ...

Apache Hudi жШѓдЄАдЄ™йЭҐеРСе§ІжХ∞жНЃжєЦзЪДжЦЗдїґз≥їзїЯпЉМжЧ®еЬ®жФѓжМБжХ∞жНЃжЫіжЦ∞еТМеИ†йЩ§пЉМиАМ Apache Kylin жШѓдЄАдЄ™йЂШжАІиГљзЪДеЉАжЇР OLAP еЉХжУОпЉМзФ®дЇОе§ІжХ∞жНЃзЪДеН≥еЄ≠жߕ胥еТМе§ЪзїіеИЖжЮРгАВ й¶ЦеЕИпЉМиЃ©жИСдїђжЈ±еЕ•дЇЖиІ£ Hudi еТМ Kylin зЪДж†ЄењГзЙєжАІгАВHudi ...

Kylin v1.6ињШжФѓжМБе§ЪSegmentзЪДеєґи°МжЮДеїЇеТМеРИеєґпЉМдї•еПКйАЪињЗRestAPIиІ¶еПСжЮДеїЇпЉМдљњеЊЧзФ®жИЈжУНдљЬжЫідЄЇзБµжіїеТМдЊњжНЈгАВ зЫЃеЙНпЉМApache Kylin v1.6зЙИжЬђзЪДжЦ∞***ming OLAPеЃЮзО∞дїНе§ДдЇОеЕђеЉАжµЛиѓХйШґжЃµпЉМжЬЯеЊЕиГље§ЯињЫдЄАж≠•иІ£еЖ≥зО∞жЬЙжЮґжЮДеТМеЃЮзО∞дЄ≠...

жЬђжЦЗжЧ®еЬ®йАЪињЗеѓєKylinеПКеЕґзЂЮеУБињЫи°МжЈ±еЕ•жѓФиЊГпЉМжП≠з§ЇеРДдЇІеУБеЬ®еЇХе±ВжКАжЬѓгАБе§ІжХ∞жНЃжФѓжМБгАБжߕ胥йАЯеЇ¶дї•еПКеРЮеРРзОЗз≠ЙжЦєйЭҐзЪДеЉВеРМпЉМдїОиАМеЄЃеК©иѓїиАЕжЫіе•љеЬ∞зРЖиІ£KylinзЪДдЉШеКњжЙАеЬ®гАВ #### дЇМгАБзЂЮеУБеѓєжѓФ ##### 1. е§ІжХ∞жНЃе§ДзРЖжКАжЬѓеЕ±жАІ еЗ†дєО...

Kylin жУНдљЬз≥їзїЯжФѓжМБе§ЪзІНжЮґжЮДпЉМеМЕжЛђ x86 еТМ ARMгАВ дЄЙгАБжПТеЕ• U зЫШпЉМжЙУеЉА Rufus еЬ®дЄЛиљљдЇЖ Rufus еТМйХЬеГПжЦЗдїґеРОпЉМзФ®жИЈйЬАи¶БжПТеЕ• U зЫШпЉМеєґжЙУеЉА RufusгАВзФ®жИЈйЬАи¶БеЬ® Rufus дЄ≠йАЙжЛ©зЫЄеЇФзЪДиЃЊе§ЗеТМйХЬеГПжЦЗдїґпЉМзДґеРОзВєеЗїеЉАеІЛжМЙйТЃпЉМ...

Kylin-Desktop-V10-GFB-Release-020-ARM64вАФg++ еЃЙи£ЕеМЕ Kylin-Desktop-V10-GFB-Release-020-ARM64вАФg++ еЃЙи£ЕеМЕ Kylin-Desktop-V10-GFB-Release-020-ARM64вАФg++ еЃЙи£ЕеМЕ Kylin-Desktop-V10-GFB-Release-020-ARM64вАФg++...

Apache Kylin жШѓдЄАдЄ™еЉАжЇРзЪДеИЖеЄГеЉПеИЖжЮРеЉХжУОпЉМжПРдЊЫ Hadoop/Spark дєЛдЄКзЪД SQL жߕ胥жО•еП£еПКе§ЪзїіеИЖжЮРпЉИOLAPпЉЙиГљеКЫдї•жФѓжМБиґЕе§ІиІДж®°жХ∞жНЃпЉМжЬАеИЭзФ± eBay Inc еЉАеПСеєґиі°зМЃиЗ≥еЉАжЇРз§ЊеМЇгАВ Apache Kylin зЪДдЄїи¶БзЙєзВєеМЕжЛђжФѓжМБ SQL жО•еП£...

Apache KylinжШѓдЄАдЄ™еЉАжЇРзЪДеИЖеЄГеЉПеИЖжЮРеЉХжУОпЉМдЄЇе§ІжХ∞жНЃеЉАеПСдЇЇеСШжПРдЊЫHadoop/SparkдєЛдЄКзЪДSQLжߕ胥жО•еП£пЉМдї•еПКжФѓжМБиґЕе§ІиІДж®°жХ∞жНЃйЫЖзЪДе§ЪзїіеИЖжЮРиГљеКЫпЉМеЬ®е§ІжХ∞жНЃйҐЖеЯЯжЬЙзЭАеєњж≥ЫзЪДеЇФзФ®пЉМжШѓе§ІжХ∞жНЃеЉАеПСдЇЇеСШзЪДењЕе§ЗжКАиГљдєЛдЄАгАВ жЬђе•ЧиІЖйҐС...

ж†Зз≠Њ "kylin big data е§ІжХ∞жНЃ sunloginclient-1" еЉЇи∞ГдЇЖеЗ†дЄ™еЕ≥йФЃзВєпЉЪKylinжУНдљЬз≥їзїЯдЄОе§ІжХ∞жНЃзЪДеЕ≥з≥їпЉМдї•еПКSunLoginClientеЬ®е§ДзРЖе§ІжХ∞жНЃзОѓеҐГдЄ≠зЪДеЇФзФ®гАВKylinжШѓдЄАдЄ™дЄУдЄЇе§ІиІДж®°жХ∞жНЃеИЖжЮРиЃЊиЃ°зЪДеЉАжЇРжУНдљЬз≥їзїЯпЉМеЃГйАЪеЄЄдЄОHadoop...

- KylinжФѓжМБж†ЗеЗЖзЪДSQLжߕ胥пЉМдљњеЊЧзФ®жИЈжЧ†йЬАе≠¶дє†жЦ∞зЪДжߕ胥иѓ≠и®АпЉМеПѓдї•зЫіжО•еИ©зФ®зО∞жЬЙзЪДBIеЈ•еЕЈињЫи°МеИЖжЮРгАВ 5. **HadoopйЫЖжИР**пЉЪ - KylinдЄОHadoopзФЯжАБз≥їзїЯзіІеѓЖйЫЖжИРпЉМеПѓдї•дЄОHDFSгАБHBaseгАБHiveз≠ЙжЧ†зЉЭеНПдљЬпЉМе§ДзРЖжµЈйЗПжХ∞жНЃгАВ 6...

еЃГиГље§ЯињРи°МеЬ®HadoopйЫЖзЊ§дєЛдЄКпЉМдЄОHiveеТМHBaseзіІеѓЖйЫЖжИРпЉМжФѓжМБе∞ЖHiveи°®дЄ≠зЪДжХ∞жНЃжЮДеїЇжИРCubeпЉМдїОиАМеК†йАЯSQLжߕ胥еУНеЇФпЉМе∞§еЕґйАВеРИдЇОеѓєжµЈйЗПжХ∞жНЃзЪДе§ЪзїіеИЖжЮРгАВ еЬ®жУНдљЬдљњзФ®KylinдєЛеЙНпЉМйЬАи¶БдЇЖиІ£зЪДжШѓKylinдЊЭиµЦдЇОHadoopйЫЖзЊ§пЉМеРМжЧґ...

BigDataеЉХжУОзїУеРИйЂШжАІиГљеИЧеЉПе≠ШеВ®еТМеєґи°Мжߕ胥жКАжЬѓпЉМиГље§ЯжФѓжМБжШОзїЖжߕ胥пЉМиАМдЄФKylinзЪДCloudйГ®зљ≤ж®°еЉПжФѓжМБе§ЪжЇРйЫЖжИРпЉМеЃЮзО∞жЦ∞жЧІжХ∞жНЃиµДдЇІзЪДйЂШжХИиЮНеРИгАВ AIжКАжЬѓеЬ®KylinдЄ≠зЪДеЇФзФ®дљУзО∞еЬ®жЩЇиГљжХ∞жНЃеЗЖе§ЗеТМеИЖжЮРдЄКпЉМиГље§ЯйЗКжФЊITйГ®йЧ®зЪДдЇЇеКЫ...