1 tomcat8įåđķååæ°æ§åķ

čŋį§éŪéĒå ķåŪå°åŪæđææĄĢäļæĨįäļįŠå°ąåŊäŧĨįĨé,tomcatåūæĐįįæŽčŋæŊä―ŋįĻįBIOïžäđåå°ąæŊæNIOäšïžå ·ä―įæŽæäđäļčŪ°åūäšïžæå īčķĢįčŠå·ąåŊäŧĨåŧæĨäļãæŽįŊįtomcatįæŽæŊtomcat8.5ãåŊäŧĨå°čŋéįäļtomcat8.5įé į―Ūåæ°

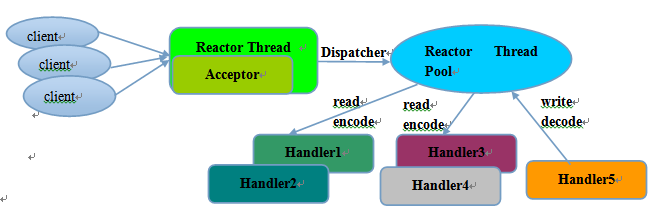

æäŧŽå æĨįŪååéĄūäļįŪåäļčŽįNIOæåĄåĻįŦŊįåĪ§čīåŪį°ïžåéīinfoqäļįäļįŊæįŦ NettyįģŧåäđNettyįšŋįĻæĻĄåäļįäļåž åū

-

äļäļŠæåĪäļŠAcceptorįšŋįĻïžæŊäļŠįšŋįĻé―æčŠå·ąįSelectorïžAcceptoråŠčīčīĢacceptæ°įčŋæĨïžäļæĶčŋæĨåŧšįŦäđåå°ąå°čŋæĨæģĻåå°å ķäŧWorkerįšŋįĻäļ

-

åĪäļŠWorkerįšŋįĻïžææķåäđåŦIOįšŋįĻïžå°ąæŊäļéĻčīčīĢIOčŊŧåįãäļį§åŪį°æđåžå°ąæŊåNettyäļæ ·ïžæŊäļŠWorkerįšŋįĻé―æčŠå·ąįSelectorïžåŊäŧĨčīčīĢåĪäļŠčŋæĨįIOčŊŧåäšäŧķïžæŊäļŠčŋæĨå―åąäšæäļŠįšŋįĻãåĶäļį§æđåžåŪį°æđåžå°ąæŊæäļéĻįįšŋįĻčīčīĢIOäšäŧķįåŽïžčŋäšįšŋįĻæčŠå·ąįSelectorïžäļæĶįåŽå°æIOčŊŧåäšäŧķïžåđķäļæŊåįŽŽäļį§åŪį°æđåžéĢæ ·ïžčŠå·ąåŧæ§čĄIOæä―ïžïžčæŊå°IOæä―å°čĢ æäļäļŠRunnableäšĪįŧWorkerįšŋįĻæą æĨæ§čĄïžčŋį§æ åĩæŊäļŠčŋæĨåŊč―äžčĒŦåĪäļŠįšŋįĻåæķæä―ïžįļæŊįŽŽäļį§åđķåæ§æéŦäšïžä―æŊäđåŊč―åžæĨåĪįšŋįĻéŪéĒïžåĻåĪįäļčĶæīå č°Ļæ äšãtomcatįNIOæĻĄåå°ąæŊįŽŽäšį§ã

æäŧĨäļčŽåæ°å°ąæŊAcceptorįšŋįĻäļŠæ°ïžWorkerįšŋįĻäļŠæ°ãæĨå ·ä―įäļåæ°

1.1 acceptCount

ææĄĢæčŋ°äļšïž

The maximum queue length for incoming connection requests when all possible request processing threads are in use. Any requests received when the queue is full will be refused. The default value is 100.

čŋäļŠåæ°å°ąįŦéĐŽįĩæķåšäļååĪ§å åŪđïžTCPäļæŽĄæĄæįčŊĶįŧčŋįĻïžčŋäļŠäđååčŊĶįŧæĒčŪĻ(æä―įģŧįŧįæĨæķéåéŋåšĶéŧčŪĪäļš100)ãčŋéåŊäŧĨįŪåįč§ĢäļšïžčŋæĨåĻčĒŦServerSocketChannel acceptäđåå°ąæååĻčŋäļŠéåäļïžacceptCountå°ąæŊčŋäļŠéåįæåĪ§éŋåšĶãServerSocketChannel acceptå°ąæŊäŧčŋäļŠéåäļäļæååšå·ēįŧåŧšįŦčŋæĨįįčŊ·æąãæäŧĨå―ServerSocketChannel acceptååšäļåæķå°ąæåŊč―é æčŊĨéåį§ŊåïžäļæĶæŧĄäščŋæĨå°ąčĒŦæįŧäš

1.2 acceptorThreadCount

ææĄĢåĶäļæčŋ°

The number of threads to be used to accept connections. Increase this value on a multi CPU machine, although you would never really need more than 2. Also, with a lot of non keep alive connections, you might want to increase this value as well. Default value is 1.

AcceptorįšŋįĻåŠčīčīĢäŧäļčŋ°éåäļååšå·ēįŧåŧšįŦčŋæĨįčŊ·æąãåĻåŊåĻįæķåä―ŋįĻäļäļŠServerSocketChannelįåŽäļäļŠčŋæĨįŦŊåĢåĶ8080ïžåŊäŧĨæåĪäļŠAcceptorįšŋįĻåđķåäļæč°įĻäļčŋ°ServerSocketChannelįacceptæđæģæĨč·åæ°įčŋæĨãåæ°acceptorThreadCountå ķåŪä―ŋįĻįAcceptorįšŋįĻįäļŠæ°ã

1.3 maxConnections

ææĄĢæčŋ°åĶäļ

The maximum number of connections that the server will accept and process at any given time. When this number has been reached, the server will accept, but not process, one further connection. This additional connection be blocked until the number of connections being processed falls below maxConnections at which point the server will start accepting and processing new connections again. Note that once the limit has been reached, the operating system may still accept connections based on the acceptCount setting. The default value varies by connector type. For NIO and NIO2 the default is 10000. For APR/native, the default is 8192.

Note that for APR/native on Windows, the configured value will be reduced to the highest multiple of 1024 that is less than or equal to maxConnections. This is done for performance reasons. If set to a value of -1, the maxConnections feature is disabled and connections are not counted.

čŋéå°ąæŊtomcatåŊđäščŋæĨæ°įäļäļŠæ§åķïžåģæåĪ§čŋæĨæ°éåķãäļæĶåį°å―åčŋæĨæ°å·ēįŧčķ čŋäšäļåŪįæ°éïžNIOéŧčŪĪæŊ10000ïžBIOæŊ200äļįšŋįĻæą æåĪ§įšŋįĻæ°åŊåįļå ģïžïžäļčŋ°įAcceptorįšŋįĻå°ąčĒŦéŧåĄäšïžåģäļåæ§čĄServerSocketChannelįacceptæđæģäŧéåäļč·åå·ēįŧåŧšįŦįčŋæĨãä―æŊåŪåđķäļéŧæĒæ°įčŋæĨįåŧšįŦïžæ°įčŋæĨįåŧšįŦčŋįĻäļæŊAcceptoræ§åķįïžAcceptoräŧ äŧ æŊäŧéåäļč·åæ°åŧšįŦįčŋæĨãæäŧĨå―čŋæĨæ°å·ēįŧčķ čŋmaxConnectionsåïžäŧįķæŊåŊäŧĨåŧšįŦæ°įčŋæĨįïžåæūåĻäļčŋ°acceptCountåĪ§å°įéåäļïžčŋäļŠéåééĒįčŋæĨæēĄæčĒŦAcceptorč·åïžå°ąåĪäščŋæĨåŧšįŦäšä―æŊäļčĒŦåĪįįįķæãå―čŋæĨæ°ä―äšmaxConnectionsäđåïžAcceptorįšŋįĻå°ąäļåéŧåĄïžįŧ§įŧč°įĻServerSocketChannelįacceptæđæģäŧacceptCountåĪ§å°įéåäļįŧ§įŧč·åæ°įčŋæĨïžäđåå°ąåžå§åĪįčŋäšæ°įčŋæĨįIOäšäŧķäš

1.4 maxThreads

ææĄĢæčŋ°åĶäļ

The maximum number of request processing threads to be created by this Connector, which therefore determines the maximum number of simultaneous requests that can be handled. If not specified, this attribute is set to 200. If an executor is associated with this connector, this attribute is ignored as the connector will execute tasks using the executor rather than an internal thread pool.

čŋäļŠįŪåįč§Ģå°ąįŪæŊäļčŋ°workerįįšŋįĻæ°ïžäļéĒäžčŊĶįŧįčŊīæãäŧäŧŽäļéĻįĻäšåĪįIOäšäŧķïžéŧčŪĪæŊ200ã

2 tomcatįNioEndpoint

äļéĒåæ°äŧ äŧ æŊįŪåäšč§Ģäšäļåæ°é į―ŪïžäļéĒæäŧŽå°ąæĨčŊĶįŧį įĐķäļtomcatįNIOæåĄåĻå ·ä―æ åĩïžčŋå°ąčĶčŊĶįŧäšč§ĢäļtomcatįNioEndpointåŪį°äš

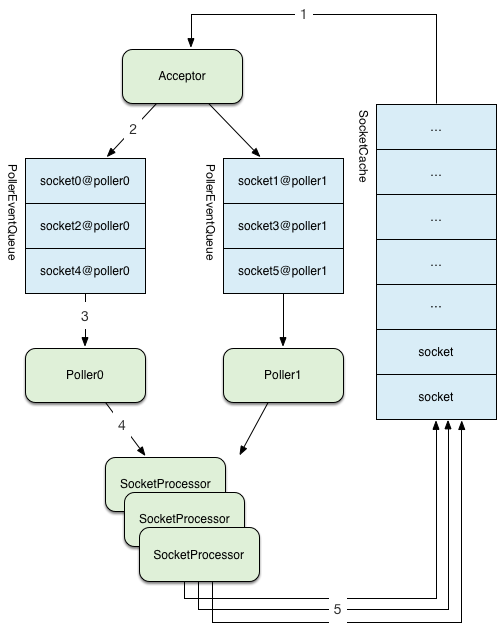

å æĨåéīįäļtomcatéŦåđķååšæŊäļįBUGææĨäļįäļåž åū

čŋåž åūåūįŧåšäšNioEndpointįåĪ§čīæ§čĄæĩįĻåūïžworkerįšŋįĻåđķæēĄæä―į°åšæĨïžåŪæŊä―äļšäļäļŠįšŋįĻæą äļæįæ§čĄIOčŊŧåäšäŧķåģSocketProcessorïžäļäļŠRunnableïžïžåģčŋéįPolleräŧ äŧ įåŽSocketįIOäšäŧķïžįķåå°čĢ æäļäļŠäļŠįSocketProcessoräšĪįŧworkerįšŋįĻæą æĨåĪįãäļéĒæäŧŽæĨčŊĶįŧįäŧįŧäļNioEndpointäļįAcceptorãPollerãSocketProcessor

2.1 Acceptor

2.1.1 åå§åčŋįĻ

č·åæåŪįAcceptoræ°éįįšŋįĻ

protected final void startAcceptorThreads() {

int count = getAcceptorThreadCount();

acceptors = new Acceptor[count];

for (int i = 0; i < count; i++) {

acceptors[i] = createAcceptor();

String threadName = getName() + "-Acceptor-" + i;

acceptors[i].setThreadName(threadName);

Thread t = new Thread(acceptors[i], threadName);

t.setPriority(getAcceptorThreadPriority());

t.setDaemon(getDaemon());

t.start();

}

}

2.1.2 Acceptorįrunæđæģ

protected classAcceptorextendsAbstractEndpoint.Acceptor {

@Override

public void run() {

int errorDelay = 0;

// Loop until we receive a shutdown command

while (running) {

// Loop if endpoint is paused

while (paused && running) {

state = AcceptorState.PAUSED;

try {

Thread.sleep(50);

} catch (InterruptedException e) {

// Ignore

}

}

if (!running) {

break;

}

state = AcceptorState.RUNNING;

try {

//if we have reached max connections, wait

countUpOrAwaitConnection();

SocketChannel socket = null;

try {

// Accept the next incoming connection from the server

// socket

socket = serverSock.accept();

} catch (IOException ioe) {

//we didn't get a socket

countDownConnection();

// Introduce delay if necessary

errorDelay = handleExceptionWithDelay(errorDelay);

// re-throw

throw ioe;

}

// Successful accept, reset the error delay

errorDelay = 0;

// setSocketOptions() will add channel to the poller

// if successful

if (running && !paused) {

if (!setSocketOptions(socket)) {

countDownConnection();

closeSocket(socket);

}

} else {

countDownConnection();

closeSocket(socket);

}

} catch (SocketTimeoutException sx) {

// Ignore: Normal condition

} catch (IOException x) {

if (running) {

log.error(sm.getString("endpoint.accept.fail"), x);

}

} catch (Throwable t) {

ExceptionUtils.handleThrowable(t);

log.error(sm.getString("endpoint.accept.fail"), t);

}

}

state = AcceptorState.ENDED;

}

}

åŊäŧĨįå°å°ąæŊäļäļŠwhileåūŠįŊïžåūŠįŊééĒäļæįacceptæ°įčŋæĨã

2.1.3 countUpOrAwaitConnection

å æĨįäļåĻacceptæ°įčŋæĨäđåïžéĶéčŋčĄčŋæĨæ°įčŠåĒïžåģcountUpOrAwaitConnection

protected voidcountUpOrAwaitConnection()throws InterruptedException {

if (maxConnections==-1) return;

LimitLatch latch = connectionLimitLatch;

if (latch!=null) latch.countUpOrAwait();

}

å―æäŧŽčŪūį―ŪmaxConnections=-1įæķåå°ąčĄĻįĪšäļįĻéåķæåĪ§čŋæĨæ°ãéŧčŪĪæŊéåķ10000,åĶæäļéåķåäļæĶåšį°åĪ§įåēåŧïžåtomcatåūæåŊč―įīæĨææïžåŊžčīæåĄåæĒã

čŋéįéæąå°ąæŊå―åčŋæĨæ°äļæĶčķ čŋæåĪ§čŋæĨæ°maxConnectionsïžå°ąįīæĨéŧåĄäš,äļæĶå―åčŋæĨæ°å°äšæåĪ§čŋæĨæ°maxConnectionsïžå°ąäļåéŧåĄïžæäŧŽæĨįäļčŋäļŠåč―įå ·ä―åŪį°latch.countUpOrAwait()

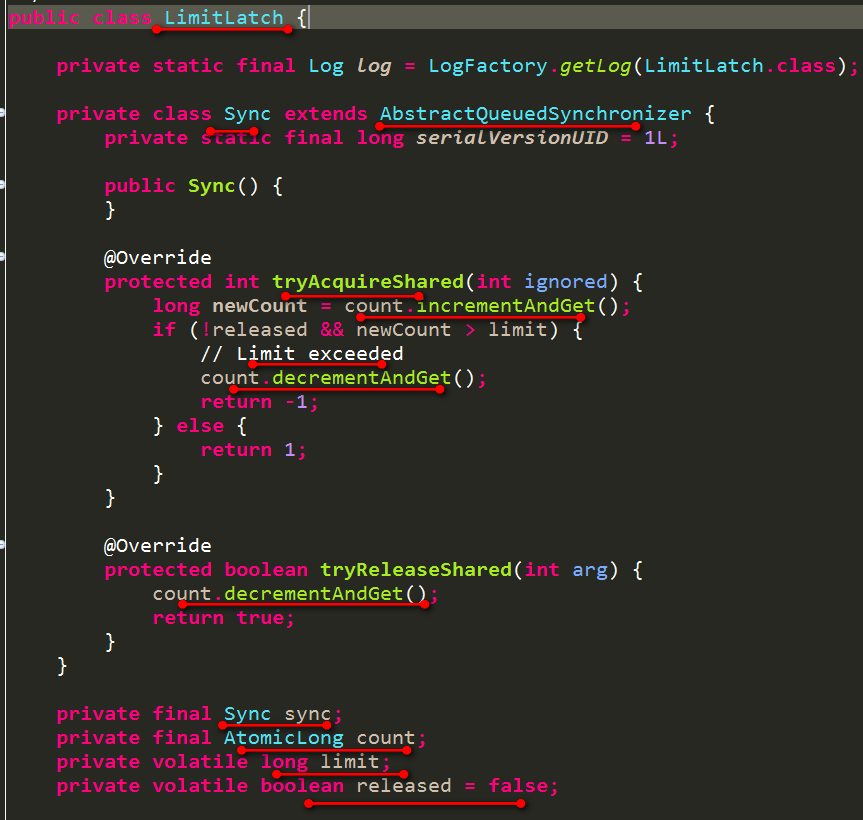

å ·ä―įčŋäļŠéæąæ éå°ąæŊäļäļŠå ąäšŦéïžæĨįå ·ä―åŪį°ïž

įŪååŪį°éįŪæŊä―ŋįĻäš2äļŠéïžLimitLatchæŽčšŦįAQSåŪį°åå äļAtomicLongįAQSåŪį°ãäđåŊäŧĨäļä―ŋįĻAtomicLongæĨåŪį°ã

å ąäšŦéįtryAcquireSharedåŪį°äļïžåĶæäļäūæAtomicLongïžåéčĶčŋčĄforåūŠįŊå CASįčŠåĒïžčŠåĒäđåæēĄæčķ čŋlimitčŋéåģmaxConnectionsïžåįīæĨčŋå1čĄĻįĪšč·åå°äšå ąäšŦéïžåĶæäļæĶčķ čŋlimitåéĶå čŋčĄforåūŠįŊå CASįčŠåïžįķåčŋå-1čĄĻįĪšč·åéåĪąčīĨïžäūŋčŋå Ĩå å ĨåæĨéåčŋå ĨéŧåĄįķæã

å ąäšŦéįtryReleaseSharedåŪį°äļïžčŊĨæđæģåŊč―äžčĒŦåđķåæ§čĄïžæäŧĨéæūå ąäšŦéįæķåäđæŊéčĶforåūŠįŊå CASįčŠå

äļčŋ°įforåūŠįŊå CASįčŠåĒãforåūŠįŊå CASįčŠåįåŪį°å ĻéĻčĒŦæŋæĒæäšAtomicLongįincrementAndGetådecrementAndGetčå·ēã

äļææäŧŽå ģæģĻįlatch.countUpOrAwait()æđæģå ķåŪå°ąæŊåĻč·åäļäļŠå ąäšŦéïžåĶäļïž

/**

* Acquires a shared latch if one is available or waits for one if no shared

* latch is current available.

* @throws InterruptedException If the current thread is interrupted

*/

public void countUpOrAwait() throws InterruptedException {

if (log.isDebugEnabled()) {

log.debug("Counting up["+Thread.currentThread().getName()+"] latch="+getCount());

}

sync.acquireSharedInterruptibly(1);

}

2.1.4 čŋæĨįåĪį

äŧäļéĒåŊäŧĨįå°åĻįæĢč·åäļäļŠčŋæĨäđåïžéĶå æŊæčŋæĨčŪĄæ°å čŠåĒäšãäļæĶTCPäļæŽĄæĄææåčŋæĨåŧšįŦïžå°ąč―äŧServerSocketChannelįacceptæđæģäļč·åå°æ°įčŋæĨäšãäļæĶč·åčŋæĨæč åĪįčŋįĻåįåžåļļåéčĶå°å―åčŋæĨæ°čŠåįïžåĶåäžé æčŋæĨæ°čéŦïžåģå―åčŋæĨæ°åđķæēĄæéĢäđåĪïžä―æŊå―åčŋæĨæ°åīåūåĪ§ïžäļæĶčķ čŋæåĪ§čŋæĨæ°ïžå°ąåŊžčīå ķäŧčŊ·æąå ĻéĻéŧåĄïžæēĄæåæģčĒŦServerSocketChannelįacceptåĪįãčŊĨbugåĻTomcat7.0.26įæŽäļåšį°äšïžčŊĶįŧč§čŋéįäļįŊæįŦ Tomcat7.0.26įčŋæĨæ°æ§åķbugįéŪéĒææĨ

įķåæäŧŽæĨįäļïžäļäļŠSocketChannelčŋæĨčĒŦacceptč·åäđååĶä―æĨåĪįįåĒïž

protected booleansetSocketOptions(SocketChannel socket){

// Process the connection

try {

//disable blocking, APR style, we are gonna be polling it

socket.configureBlocking(false);

Socket sock = socket.socket();

socketProperties.setProperties(sock);

NioChannel channel = nioChannels.pop();

if (channel == null) {

SocketBufferHandler bufhandler = new SocketBufferHandler(

socketProperties.getAppReadBufSize(),

socketProperties.getAppWriteBufSize(),

socketProperties.getDirectBuffer());

if (isSSLEnabled()) {

channel = new SecureNioChannel(socket, bufhandler, selectorPool, this);

} else {

channel = new NioChannel(socket, bufhandler);

}

} else {

channel.setIOChannel(socket);

channel.reset();

}

getPoller0().register(channel);

} catch (Throwable t) {

ExceptionUtils.handleThrowable(t);

try {

log.error("",t);

} catch (Throwable tt) {

ExceptionUtils.handleThrowable(t);

}

// Tell to close the socket

return false;

}

return true;

}

åĪįčŋįĻåĶäļïž

-

čŪūį―ŪééŧåĄïžäŧĨåå ķäŧįäļäšåæ°åĶSoTimeoutãReceiveBufferSizeãSendBufferSize

-

įķåå°SocketChannelå°čĢ æäļäļŠNioChannelïžå°čĢ čŋįĻä―ŋįĻäšįžåïžåģéŋå äšéåĪååŧšNioChannelåŊđ蹥ïžįīæĨåĐįĻåæįNioChannelïžåđķå°NioChanneläļįæ°æŪå ĻéĻæļ įĐšãäđæĢæŊčŋäļŠįžåäđé æäšäļæŽĄbugïžčŊĶč§æį―æ éæķMtopč§ĶåtomcatéŦåđķååšæŊäļįBUGææĨåäŋŪåĪïžå·ēčĒŦapacheéįšģïž

-

éæĐäļäļŠPollerčŋčĄæģĻå

äļéĒå°ąæĨčŊĶįŧäŧįŧäļPoller

2.2 Poller

2.2.1 åå§åčŋįĻ

// Start poller threads

pollers = new Poller[getPollerThreadCount()];

for (int i=0; i<pollers.length; i++) {

pollers[i] = new Poller();

Thread pollerThread = new Thread(pollers[i], getName() + "-ClientPoller-"+i);

pollerThread.setPriority(threadPriority);

pollerThread.setDaemon(true);

pollerThread.start();

}

åéĒæēĄæčŊīå°Pollerįæ°éæ§åķïžæĨįäļ

/**

* Poller thread count.

*/

private int pollerThreadCount = Math.min(2,Runtime.getRuntime().availableProcessors());

publicvoidsetPollerThreadCount(int pollerThreadCount){ this.pollerThreadCount = pollerThreadCount; }

publicintgetPollerThreadCount(){ return pollerThreadCount; }

åĶæäļčŪūį―ŪįčŊæåĪ§å°ąæŊ2

2.2.2 PolleræģĻåSocketChannel

æĨčŊĶįŧįäļgetPoller0().register(channel)ïž

public Poller getPoller0(){

int idx = Math.abs(pollerRotater.incrementAndGet()) % pollers.length;

return pollers[idx];

}

å°ąæŊč―ŪčŪäļäļŠPolleræĨčŋčĄSocketChannelįæģĻå

/**

* Registers a newly created socket with the poller.

*

* @param socket The newly created socket

*/

publicvoidregister(final NioChannel socket){

socket.setPoller(this);

NioSocketWrapper ka = new NioSocketWrapper(socket, NioEndpoint.this);

socket.setSocketWrapper(ka);

ka.setPoller(this);

ka.setReadTimeout(getSocketProperties().getSoTimeout());

ka.setWriteTimeout(getSocketProperties().getSoTimeout());

ka.setKeepAliveLeft(NioEndpoint.this.getMaxKeepAliveRequests());

ka.setSecure(isSSLEnabled());

ka.setReadTimeout(getSoTimeout());

ka.setWriteTimeout(getSoTimeout());

PollerEvent r = eventCache.pop();

ka.interestOps(SelectionKey.OP_READ);//this is what OP_REGISTER turns into.

if ( r==null) r = new PollerEvent(socket,ka,OP_REGISTER);

else r.reset(socket,ka,OP_REGISTER);

addEvent(r);

}

privatevoidaddEvent(PollerEvent event){

events.offer(event);

if ( wakeupCounter.incrementAndGet() == 0 ) selector.wakeup();

}

private final SynchronizedQueue<PollerEvent> events =

new SynchronizedQueue<>();

čŋéåæŊčŋčĄäļäšåæ°å čĢ ïžå°socketåPollerįå ģįģŧįŧåŪïžåæŽĄäŧįžåäļååšæč éæ°æåŧšäļäļŠPollerEventïžįķåå°čŊĨeventæūå°Pollerįäšäŧķéåäļįåū čĒŦåžæĨåĪį

2.2.3 Pollerįrunæđæģ

åĻPollerįrunæđæģäļäļæåĪįäļčŋ°äšäŧķéåäļįäšäŧķïžįīæĨæ§čĄPollerEventįrunæđæģïžå°SocketChannelæģĻåå°čŠå·ąįSelectoräļã

public boolean events() {

boolean result = false;

PollerEvent pe = null;

while ( (pe = events.poll()) != null ) {

result = true;

try {

pe.run();

pe.reset();

if (running && !paused) {

eventCache.push(pe);

}

} catch ( Throwable x ) {

log.error("",x);

}

}

return result;

}

åđķå°SelectorįåŽå°įIOčŊŧåäšäŧķå°čĢ æSocketProcessorïžäšĪįŧįšŋįĻæą æ§čĄ

SocketProcessor sc = processorCache.pop();

if ( sc == null ) sc = new SocketProcessor(attachment, status);

else sc.reset(attachment, status);

Executor executor = getExecutor();

if (dispatch && executor != null) {

executor.execute(sc);

} else {

sc.run();

}

æäŧŽæĨįįčŋäļŠįšŋįĻæą įåå§åïž

public void createExecutor() {

internalExecutor = true;

TaskQueue taskqueue = new TaskQueue();

TaskThreadFactory tf = new TaskThreadFactory(getName() + "-exec-", daemon, getThreadPriority());

executor = new ThreadPoolExecutor(getMinSpareThreads(), getMaxThreads(), 60, TimeUnit.SECONDS,taskqueue, tf);

taskqueue.setParent( (ThreadPoolExecutor) executor);

}

å°ąæŊååŧšäšäļäļŠThreadPoolExecutorïžéĢæäŧŽå°ąéįđå ģæģĻäļæ ļåŋįšŋįĻæ°ãæåĪ§įšŋįĻæ°ãäŧŧåĄéåįäŋĄæŊ

private int minSpareThreads = 10;

public intgetMinSpareThreads(){

return Math.min(minSpareThreads,getMaxThreads());

}

æ ļåŋįšŋįĻæ°æåĪ§æŊ10äļŠïžåæĨįäļæåĪ§įšŋįĻæ°

private int maxThreads = 200;

éŧčŪĪå°ąæŊäļéĒįé į―Ūåæ°maxThreadsäļš200ãčŋæå°ąæŊTaskQueueïžčŋéįTaskQueueæŊLinkedBlockingQueue<Runnable>įåįąŧïžæåĪ§åŪđéå°ąæŊInteger.MAX_VALUEïžæ đæŪäđåThreadPoolExecutorįæšį åæïžæ ļåŋįšŋįĻæ°æŧĄäšäđåïžäžå å°äŧŧåĄæūå°éåäļïžéåæŧĄäšæäžååŧšåšæ°įéæ ļåŋįšŋįĻïžåĶæéåæŊäļäļŠåĪ§åŪđéįčŊïžäđå°ąæŊäļäžå°ååŧšæ°įéæ ļåŋįšŋįĻéĢäļæĨäšã

ä―æŊčŋéįTaskQueueäŋŪæđäšåšåąofferįåŪį°

public booleanoffer(Runnable o){

//we can't do any checks

if (parent==null) returnsuper.offer(o);

//we are maxed out on threads, simply queue the object

if (parent.getPoolSize() == parent.getMaximumPoolSize()) returnsuper.offer(o);

//we have idle threads, just add it to the queue

if (parent.getSubmittedCount()<(parent.getPoolSize())) returnsuper.offer(o);

//if we have less threads than maximum force creation of a new thread

if (parent.getPoolSize()<parent.getMaximumPoolSize()) return false;

//if we reached here, we need to add it to the queue

returnsuper.offer(o);

}

čŋéå―įšŋįĻæ°å°äšæåĪ§įšŋįĻæ°įæķåå°ąįīæĨčŋåfalseåģå ĨéååĪąčīĨïžåčŋŦä―ŋThreadPoolExecutorååŧšåšæ°įéæ ļåŋįšŋįĻã

TaskQueuečŋäļåæēĄåĪŠįæåŪįæåūæŊäŧäđïžæåū įŧ§įŧį įĐķã

3 įŧæčŊ

Â

æŽįŊæįŦ æčŋ°äštomcat8.5äļįNIOįšŋįĻæĻĄåïžäŧĨåå ķäļæķåå°įįļå ģåæ°įčŪūį―Ūã

įļå ģæĻč

7. **įšŋįĻæĻĄå**ïžTomcatéįĻåĪįšŋįĻæĻĄååĪįčŊ·æąïž`Executor`æĨåĢåå ķåŪį°å čŪļčŠåŪäđįšŋįĻæą ïžäŧĨäžååđķåæ§č―ã 8. **čŋæĨåĻäļåčŪŪåĪįåĻ**ïžTomcatæŊæåĪį§čŋæĨåĻïžåĶåšäšNIOį` CoyoteNioProtocol`ïžåšäšAPRį`...

æšį åæïž 1. **įŪå―įŧæ**ïž Tomcatįæšį įŧææļ æ°ïžäļŧčĶå æŽäŧĨäļå äļŠå ģéŪéĻåïž - `bin`ïžå åŦåŊåĻåįŪĄįTomcatįčæŽã - `conf`ïžé į―Ūæäŧķåæūå°ïžåĶserver.xmlïžweb.xmlįã - `lib`ïžTomcatčŋčĄæéį...

åĻServletįįå―åĻæįŪĄįéĻåïžTomcatéĩåūŠServletč§čïžäļšæŊäļŠServletåŪäūååŧšåäļŠįšŋįĻæĻĄåæåĪįšŋįĻæĻĄåãServletįåå§åãæåĄåéæŊčŋįĻįąTomcatåŪđåĻčŠåĻįŪĄįïžåžåč åŠéčĶéåįļåšįįå―åĻææđæģåģåŊã æĪåĪïž...

3. **įšŋįĻæĻĄå**ïžTomcatéįĻäšåĪįšŋįĻæĻĄåæĨåĪįåđķåčŊ·æąãäšč§Ģå ķįšŋįĻæą åå·Ĩä―įšŋįĻįå·Ĩä―æđåžæåĐäšäžåæåĄåĻįåđķåæ§č―ã 4. **čŋæĨåĻïžConnectorïžäļåĪįåĻïžProcessorïž**ïžTomcatäļįConnectorčīčīĢæĨæķåååš...

æšį åæåŊäŧĨäŧäŧĨäļå äļŠå ģéŪæđéĒåąåžïž 1. **įŪå―įŧæ**ïž - `src/main`: äļŧčĶå åŦTomcatįæšäŧĢį ïžå æŽCatalinaïžæ ļåŋæåĄåĻįŧäŧķïžãCoyoteïžHTTPåčŪŪåĪįïžãJasperïžJSPįžčŊåĻïžįæĻĄåã - `conf`: é į―Ūæäŧķïž...

5. **įšŋįĻæĻĄå**ïžTomcatä―ŋįĻåšäščŊ·æąįįšŋįĻæĻĄåïžå―čŊ·æąå°čūūæķïžäžäŧįšŋįĻæą äļč·åäļäļŠįšŋįĻæĨåĪįčŊ·æąïžåŪæåįšŋįĻčŋåæą ã 6. **čŋæĨåĻäļåčŪŪ**ïžCoyotečŋæĨåĻæŊæåĪį§åčŪŪïžåĶHTTP/1.1ãAJPïžįĻäšäļäŧĢįæåĄåĻ...

2. įšŋįĻæĻĄåïžTomcatéįĻåĪįšŋįĻæĻĄååĪįčŊ·æąïžéčŋExecutoræĄæķïžåŊäŧĨčŠåŪäđįšŋįĻæą įįĨïžåŪį°éŦæįåđķååĪįã 3. éĻį―ēäļįæīæ°ïžTomcatéčŋWebappLoaderįąŧå č――WebåšįĻįįąŧïžæŊæįéĻį―ēåįæīæ°ïžåŠéäŋŪæđææŋæĒ...

ãæ·ąå Ĩįč§ĢTomcatæšį åæ1ïžConnectoré į―ŪčŊĶč§Ģã Tomcatïžä―äļšåđŋæģä―ŋįĻįJava ServletåŪđåĻïžå ķæ ļåŋįŧäŧķäđäļå°ąæŊConnectorïžåŪčīčīĢåĪįWebæåĄåĻäļåŪĒæ·įŦŊäđéīįéäŋĄãæŽįŊæįŦ å°čŊĶįŧæĒčŪĻTomcat Connectorįį§įąŧã...

TomcatéįĻåĪįšŋįĻæĻĄååĪįčŊ·æąïžå æŽåšäšįšŋįĻæą įExecutoråNIOįééŧåĄI/OãExecutorįšŋįĻæą åŊäŧĨéĒå é į―ŪįšŋįĻæ°éïžæææ§åķčĩæšæķčïžNIOæĻĄåžååĐįĻJavaįSelectoræšåķïžæéŦåđķååĪįč―åã 5. **åŪå Ļæ§** ...

3. **čŋæĨåĻæšåķ**ïžCoyoteåĶä―éčŋAcceptoråPollerįšŋįĻæĻĄååĪįåđķåčŊ·æąïžäŧĨååĶä―éčŋNIOæBIOåŪį°éŦæįI/Oæä―ã 4. **JSPįžčŊčŋįĻ**ïžJasperåĶä―čŊŧåJSPæäŧķïžįæJavaæšäŧĢį ïžįžčŊåđķå č――å°å åïžäŧĨåéčŊŊ...

TomcatéįĻåĪįšŋįĻæĻĄååĪįåđķåčŊ·æąïžå ķå·Ĩä―įšŋįĻæą ïžExecutorïžįŪĄįåč°åšĶčŊ·æąåĪįãæšį äļåŊäŧĨæĨįå°įšŋįĻæą įé į―Ūäļå·Ĩä―æđåžïžčŋåŊđäšįč§ĢéŦåđķååšæŊäļįæ§č―įķéĒåäžåįįĨéåļļæåļŪåĐã 4. **įąŧå č――æšåķ** Tomcat...

- **įšŋįĻæĻĄå**: TomcatéįĻåĪįšŋįĻæĻĄååĪįčŊ·æąïžéčŋExecutorįšŋįĻæą įŪĄįįšŋįĻïžäŋčŊäšéŦåđķåäļįæ§č―ã - **æĻĄååčŪūčŪĄ**: éčŋæĻĄååčŪūčŪĄïžTomcatåŊäŧĨįĩæīŧæĐåąïžåäļŠįŧäŧķäđéīæūčĶåïžäūŋäšįŧīæĪååįš§ã - **įå―...

ãæ·ąå ĨåæTomcatãčŋæŽäđĶæŊJavaåžåč äŧŽäšč§ĢååĶäđ TomcatæåĄåĻįéčĶåččĩæïžåŪčŊĶįŧč§ĢæäšTomcatįå·Ĩä―åįåå éĻæšåķ...äđĶäļæķåįæšį åæå°æåĐäščŊŧč įč§ĢTomcatįå éĻå·Ĩä―æšåķïžåĒåžšéŪéĒææĨåæ éčŊæįč―åã

4. **įšŋįĻæĻĄå**ïžTomcatä―ŋįĻåšäšįšŋįĻįæĻĄåæĨåĪįčŊ·æąïžæŊäļŠčŊ·æąé―äžåé äļäļŠįšŋįĻčŋčĄåĪįïžįšŋįĻæą įŪĄįčŋäšįšŋįĻäŧĨæéŦæįã 5. **čŋæĨåĻäļåčŪŪ**ïžCoyotečŋæĨåĻåĪįHTTP/HTTPSčŊ·æąïžæŊæKeep-AliveåééŧåĄI/Oïž...

Tomcatä―ŋįĻåšäšNIOįAcceptorįšŋįĻæĻĄåæĨåĪįåđķåčŊ·æąïžæéŦæ§č―ã`org.apache.tomcat.util.net.NioEndpoint`įąŧčīčīĢįŪĄįåč°åšĶčŋäšįšŋįĻã 9. **JSPæŊæ** éĪäšServletïžTomcatčŋæŊæJSPãæšį äļį`org.apache....

ãæčŋ°ãïžâTomcatæšį åæâčŋäļäļŧéĒæåģįæäŧŽå°åŊđTomcatįå éĻå·Ĩä―åįčŋčĄæ·ąå Ĩį įĐķïžčŋå æŽå ķåŊåĻæĩįĻãčŊ·æąåĪįæšåķãįšŋįĻæĻĄåãįąŧå č――åĻäŧĨåäļWebåšįĻįäšĪäšįå ģéŪéĻåã **Tomcatæšį åæįå ģéŪįĨčŊįđïž** ...

5. **įšŋįĻæĻĄå**ïžæ·ąå ĨåæTomcatįįšŋįĻæą čŪūčŪĄïžå æŽå·Ĩä―įšŋįĻįååŧšãč°åšĶååæķïžäŧĨåįšŋįĻåŪå ĻéŪéĒã 6. **äžčŊįŪĄį**ïžåĶäđ åĶä―é į―ŪåįŪĄįįĻæ·äžčŊïžå æŽäžčŊæäđ åãčķ æķåååļåžäžčŊįåŪį°ã 7. **åŪå Ļæ§**ïž...

3. **įšŋįĻæĻĄå**ïžTomcatä―ŋįĻåšäščŋæĨæą įįšŋįĻæĻĄåæĨåĪįåđķåčŊ·æąãæŊäļŠčŊ·æąäžčĒŦåé å°äļäļŠįĐšéēįšŋįĻïžåĪįåŪåįšŋįĻčŋåįšŋįĻæą ãčŋæéŦäšæåĄįååšéåšĶïžéä―äščĩæšæķčã 4. **éĻį―ēäļé į―Ū**ïžTomcatįéĻį―ēéåļļįŪå...

æč ä―ŋįĻJProfilerįæ§č―åæå·Ĩå ·æĨįæ§TomcatįįšŋįĻįķæåå åä―ŋįĻã æäŧķâtomcatįšŋįĻč°åšĶ.edxâåŊč―æŊå ģäšTomcatįšŋįĻč°åšĶįčŋäļæĨåĶäđ čĩæïžåŊč―å åŦčŊūįĻæčŪēč§ĢïžåļŪåĐæäŧŽæ·ąå Ĩįč§ĢTomcatåĶä―įŪĄįåč°åšĶįšŋįĻæĨ...

4. **įšŋįĻæĻĄå**ïžTomcatä―ŋįĻäšåĪį§įšŋįĻæĻĄåïžåĶ CoyoteãNIO å APRïžäŧĨéåšäļåįæ§č―éæąãéčŋæšį ïžæäŧŽåŊäŧĨįå°åĶä―é į―ŪåäžåčŋäšįšŋįĻæĻĄåïžæåæåĄåĻįåđķååĪįč―åã 5. **éĻį―ēäļé į―Ū**ïžåĻæšį äļïžä― ...