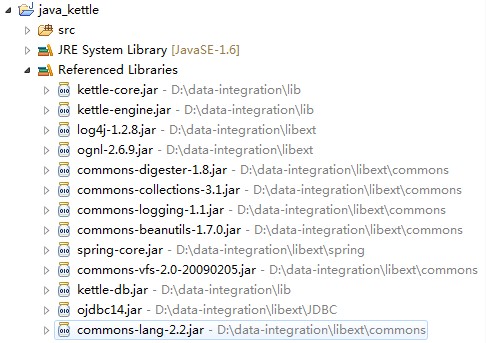

Java调用Kettle执行任务或转换,需要使用Kettle中的jar,可以先导入lib目录中的几个基本的jar,如:kettle-core.jar、kettle-db.jar、kettle-engine.jar ,其它jar根据情况进行添加,所需的jar在<kettle-home>\lib、<kettle-home>\libext下面都可以找到,本示例引用的jar如下图:

之后编写代码测试Java调用,调用前先使用Kettle的设计器设计了一个转换,取名为voucher.ktr。另外,本示例使用的是Kettle3.2的版本,据说4.1版本调用方法会有不同。

import org.pentaho.di.core.database.DatabaseMeta;

import org.pentaho.di.core.exception.KettleException;

import org.pentaho.di.core.logging.LogWriter;

import org.pentaho.di.core.util.EnvUtil;

import org.pentaho.di.job.Job;

import org.pentaho.di.job.JobEntryLoader;

import org.pentaho.di.job.JobMeta;

import org.pentaho.di.repository.Repository;

import org.pentaho.di.repository.RepositoryDirectory;

import org.pentaho.di.repository.RepositoryMeta;

import org.pentaho.di.repository.UserInfo;

import org.pentaho.di.trans.StepLoader;

import org.pentaho.di.trans.Trans;

import org.pentaho.di.trans.TransMeta;

/**

* Java调用Kettle示例代码

*

* @author 李文锴

* @since 2012-8-14 下午03:50:00

*

*/

public class KettleTest {

public static void main(String[] args) throws KettleException {

String filename = "voucher.ktr";

// callNativeTrans(filename);

// executeTrans();

// executeJobs();

callNativeTransWithParam(filename);

System.out.println("ok");

}

/**

* 调用本地的转换文件

*

* @Description:

* @param transFileName

* @throws KettleException

* @author 李文锴

* @since:2012-8-15 下午02:58:41

*/

public static void callNativeTrans(String transFileName) throws KettleException {

// 初始化

EnvUtil.environmentInit();

StepLoader.init();

// 转换元对象

TransMeta transMeta = new TransMeta(transFileName);

// 转换

Trans trans = new Trans(transMeta);

// 执行转换

trans.execute(null);

// 等待转换执行结束

trans.waitUntilFinished();

}

/**

* 调用本地的转换文件(带参数)

*

* @Description:

* @param transFileName

* @throws KettleException

* @author 李文锴

* @since:2012-8-15 下午02:58:54

*/

public static void callNativeTransWithParam(String transFileName) throws KettleException {

// 初始化

EnvUtil.environmentInit();

StepLoader.init();

// 转换元对象

TransMeta transMeta = new TransMeta(transFileName);

// 转换

Trans trans = new Trans(transMeta);

String[] params = {};

// 执行转换

trans.execute(params);

// 等待转换执行结束

trans.waitUntilFinished();

}

/**

* 执行存储在数据库资源库中的转换

*

* @Description:

* @throws KettleException

* @author 李文锴

* @since:2012-8-15 下午02:59:14

*/

public static void executeTrans() throws KettleException {

// 初始化

EnvUtil.environmentInit();

StepLoader.init();

// 日志

LogWriter log = LogWriter.getInstance("TransTest.log", true, LogWriter.LOG_LEVEL_DEBUG);

// 用户

UserInfo userInfo = new UserInfo();

userInfo.setLogin("admin");

userInfo.setPassword("admin");

// 数据库连接元对象(连接名称,不必与kettle中配置的保持一致:数据库类型:连接方式(kettle支持的连接方式):资源库IP:资源库实例名:资源库端口:资源库用户名:资源库用户密码)

DatabaseMeta connection = new DatabaseMeta("", "Oracle", "Native", "192.168.3.232", "NSDEV", "1521", "nstcsa3441", "671468");

// 资源库元对象

RepositoryMeta repinfo = new RepositoryMeta();

repinfo.setConnection(connection);

// 资源库

Repository rep = new Repository(log, repinfo, userInfo);

// 连接资源库

rep.connect("");

// 资源库目录对象

RepositoryDirectory dir = new RepositoryDirectory(rep);

// 转换元对象

TransMeta transMeta = new TransMeta(rep, "凭证(N9->EVC2)", dir);

// 转换

Trans trans = new Trans(transMeta);

// 执行转换

trans.execute(null);

// 等待转换执行结束

trans.waitUntilFinished();

}

/**

* 执行本地的任务文件

*

* @Description:

* @param jobFileName

* @throws KettleException

* @author 李文锴

* @since:2012-8-15 下午02:59:34

*/

public static void callNativeJob(String jobFileName) throws KettleException {

// 初始化

EnvUtil.environmentInit();

JobEntryLoader.init();

StepLoader.init();

// 日志

LogWriter log = LogWriter.getInstance("TransTest.log", true, LogWriter.LOG_LEVEL_DETAILED);

// job元对象

JobMeta jobMeta = new JobMeta(log, jobFileName, null);

// job

Job job = new Job(log, StepLoader.getInstance(), null, jobMeta);

jobMeta.setInternalKettleVariables(job);

// 执行job

job.execute();

// 等待job执行结束

job.waitUntilFinished();

}

/**

* 执行数据库资源库中的任务

*

* @Description:

* @throws KettleException

* @author 李文锴

* @since:2012-8-15 下午02:59:45

*/

public static void executeJobs() throws KettleException {

// 初始化

EnvUtil.environmentInit();

JobEntryLoader.init();

StepLoader.init();

// 日志

LogWriter log = LogWriter.getInstance("TransTest.log", true, LogWriter.LOG_LEVEL_DETAILED);

// 用户

UserInfo userInfo = new UserInfo();

userInfo.setLogin("admin");

userInfo.setPassword("admin");

// 数据库连接元对象

DatabaseMeta connection = new DatabaseMeta("", "Oracle", "Native", "192.168.3.232", "NSDEV", "1521", "nstcsa3441", "671468");

// 资源库元对象

RepositoryMeta repinfo = new RepositoryMeta();

repinfo.setConnection(connection);

// 资源库

Repository rep = new Repository(log, repinfo, userInfo);

// 连接资源库

rep.connect("");

// 资源库目录对象

RepositoryDirectory dir = new RepositoryDirectory(rep);

// 步骤加载对象

StepLoader steploader = StepLoader.getInstance();

// job元对象

JobMeta jobmeta = new JobMeta(log, rep, "4.账户每日余额", dir);

// job

Job job = new Job(log, steploader, rep, jobmeta);

// 执行job

job.execute();

// 等待job执行结束

job.waitUntilFinished();

}

}

本示例只能实现一次调用,暂时不知道如何通过API设定运行时间,但可以结合Spring和Quartz,设定定时调度,以便实现调度目标。

分享到:

相关推荐

### 使用Java调用Kettle设计的关键知识点 #### 一、Kettle简介与Java集成背景 Pentaho Data Integration (PDI),通常被称为Kettle,是一款开源的数据集成工具,用于ETL(Extract-Transform-Load)操作。它支持图形...

在这个过程中,我们将深入探讨如何使用Kettle创建数据库之间的转换,以及如何设置定时任务来自动化这些转换。 1. 数据库转换创建: Kettle中的转换是数据处理的核心,它由一系列步骤组成,每个步骤负责特定的数据...

通过阅读这份PDF教程,你可以了解如何使用Kettle进行数据提取、转换和加载,如何配置和调度作业,以及如何调试和优化数据处理流程。 总之,Kettle作为一款功能强大的ETL工具,为数据工程师提供了高效的数据处理和...

开发人员可以使用Pentaho Kettle的API来创建自定义的转换和作业,或者通过图形界面(PDI的Spoon工具)来设计和执行数据集成任务。 使用Pentaho Kettle时,开发者可以: - **创建ETL流程**:通过图形化界面,构建...

3. **Kitchen**:这是另一个工具,用于执行由XML或数据库描述的任务。 #### 二、Kettle插件概述 Kettle拥有丰富的内置组件,这些组件可以组成转换和作业,但有时候这些组件可能无法完全满足特定的需求。在这种情况...

### Kettle转换步骤插件开发知识点详解 #### 1. Kettle介绍 Kettle是一款开源的数据集成工具,原名PDI(Pentaho Data Integration),它由Pentaho公司维护和支持。Kettle最初是由一位荷兰程序员开发的,后来在2006...

在学习和使用Kettle API时,建议先熟悉Kettle的工作流程和数据转换概念,然后逐步学习API文档,了解各种类和方法的用法。通过实践项目,将理论知识转化为实际技能,逐步掌握Kettle API的强大功能。 总的来说,...

### Kettle的使用介绍 #### 一、Kettle概述 **1.1 来源** Kettle是一款由国外开发...通过以上详细介绍,初学者可以更好地理解和掌握Kettle这款强大的ETL工具及其基本操作,从而有效地进行数据提取、转换和加载任务。

使用Kettle需要先安装Java运行环境,至少为Java 1.6版本。Kettle本身不需传统意义上的安装,只需将下载的压缩包解压,配置好Java环境变量,即可直接运行。 **运行Spoon**: Spoon是Kettle的主要图形界面工具,可在...

1. Java环境:至少JDK 8或以上版本,因为Kettle依赖Java运行。 2. 操作系统:Windows、Linux、Unix等支持Java的系统均可。 3. 硬盘空间:根据实际工作负载和数据量来确定,一般需要预留足够的空间用于存储转换、作业...

通过深入理解Kettle的Transformation和Job,可以有效地处理大数据量的抽取、转换和加载任务,尤其在金融IT领域,对于数据的高效管理和分析具有重要意义。Kettle的灵活性和强大功能使其成为许多企业和开发者的首选ETL...

自2006年起,Kettle成为Pentaho BI Suite的一部分,旨在为用户提供高效的数据抽取、转换、加载(ETL)能力。其名称源于“Kettle E.T.T.L. Environment”的首字母缩写,寓意将各种来源的数据整合至一个“壶”中,以...

Kettle 提供了多种方式来运行转换和 Job,例如使用 Java Web Start 方式、命令行方式等。使用命令行方式可以指定转换文件的路径、执行日志的级别和日志文件的路径等。 Kettle 的设计文件可以保存在 xml 格式中或某...

Kettle是Pentaho套件中的ETL工具,完全由Java编写,因此具备跨平台特性,可以在Windows、Linux、Unix等操作系统上运行,且无需安装,使用非常便捷。Kettle的设计理念来源于“水壶”,象征着将来自不同源头的数据汇集...

例如,它可能会介绍Pentaho Kettle的工作流(Job)和转换(Transformation)两种基本构建块,以及如何通过图形化界面设计和执行数据处理流程。用户可以学习到如何创建、编辑和运行步骤(Step),如数据库连接、表...

在提供的"lib"文件夹中,开发人员将找到Kettle 7.1的所有核心库和其他依赖库,这些库对于开发自定义组件、编写Java代码或构建Kettle作业和转换是必不可少的。开发人员需要将这些库加入到他们的开发环境中,以便进行...

Spoon 是一个图形用户界面,允许用户运行转换或者任务,而 Pan 是一个数据转换引擎,可以执行多种功能,例如从不同的数据源读取、操作和写入数据。 二、kettle 的安装 要运行 kettle 工具,需要安装 Sun 公司的 ...

- **Java Web Start方式**:通过Java Web Start可以方便地部署和运行Kettle的任务。 - **命令行方式**: - **Windows环境下**:使用`kitchen.bat`命令行工具运行Kettle任务,参数间以“/”分隔,Key和Value间以“:...