дљЬиАЕпЉЪgzshun. еОЯеИЫдљЬеУБпЉМиљђиљљиѓЈж†ЗжШОеЗЇе§ДпЉБ

жЭ•жЇРпЉЪhttp://blog.csdn.net/gzshunзљСзїЬзИђиЩЂпЉИеПИ襀зІ∞дЄЇзљСй°µиЬШиЫЫпЉМзљСзїЬжЬЇеЩ®дЇЇпЉЙпЉМжШѓдЄАзІНжМЙзЕІдЄАеЃЪзЪДиІДеИЩпЉМиЗ™еК®зЪДжКУеПЦдЄЗзїізљСдњ°жБѓзЪДз®ЛеЇПжИЦиАЕиДЪжЬђгАВеП¶е§ЦдЄАдЇЫдЄНеЄЄдљњзФ®зЪДеРНе≠ЧињШжЬЙиЪВиЪБпЉМиЗ™еʮ糥еЉХпЉМж®°жЛЯз®ЛеЇПжИЦиАЕи†ХиЩЂгАВ

зљСзїЬзИђиЩЂжЬАйЗНи¶БзЪДдїїеК°пЉМе∞±жШѓдїОдЇТиБФзљСжРЬ糥еЗЇйЬАи¶БзЪДдњ°жБѓпЉМе∞ЖзљСй°µжКУеПЦдЄЛжЭ•еєґеИЖжЮРпЉМеЊИе§ЪжРЬ糥еЉХжУОпЉМжѓФе¶ВзЩЊеЇ¶пЉМи∞Јж≠МпЉМеРОеП∞йГљжЬЙдЄАеП™еЊИеЉЇжВНзЪДзљСзїЬзИђиЩЂпЉМзФ®жЭ•иЃњйЧЃдЇТиБФзљСдЄКзЪДзљСй°µпЉМеЫЊзЙЗпЉМиІЖйҐСз≠ЙеЖЕеЃєпЉМеєґеїЇзЂЛ糥еЉХжХ∞жНЃеЇУпЉМдљњзФ®жИЈиГљеЬ®зЩЊеЇ¶жРЬ糥еЉХжУОдЄ≠жРЬ糥еИ∞жВ®зљСзЂЩзЪДзљСй°µгАБеЫЊзЙЗгАБиІЖйҐСз≠ЙеЖЕеЃєгАВ

жИСдїђеЄЄиІБзЪДеЗ†дЄ™е§ІеЮЛжРЬ糥еЉХжУОеЕђеПЄзЪДзИђиЩЂеРНзІ∞пЉЪ

1.и∞Јж≠МпЉИGoogleпЉЙ -> Googlebot

2.зЩЊеЇ¶пЉИBaiduпЉЙзИђиЩЂеРНзІ∞пЉЪBaiduspider

3.йЫЕиЩОпЉИYahooпЉЙ -> Yahoo! Slurp

4.жЬЙйБУпЉИYodaoпЉЙ -> YodaoBot

5.жРЬзЛЧпЉИsogouпЉЙ -> Sogou spider

6.MSN -> msmbot

7.иЕЊиЃѓжРЬжРЬ -> Sosospider

жЬАињСжИСз™БзДґжГ≥иЗ™еЈ±еК®жЙЛеЖЩдЄАеП™е∞ПеЮЛзЪДеНЪеЃҐзИђиЩЂпЉМе∞ЖиЗ™еЈ±еЬ®CSDNеНЪеЃҐзљСзЂЩеЖЩзЪДжЦЗзЂ†зїЩжКУеПЦдЄЛжЭ•пЉМжГ≥еБЪдЄ™еНЪеЃҐе§ЗдїљеЈ•еЕЈгАВељУдЇЖиІ£еИ∞зљСзїЬзИђиЩЂзЪДзФ®йАФеРОпЉМе∞±жЭ•еК®жЙЛеЃЮзО∞дЄАдЄ™еЇФзФ®пЉМзФ®жЭ•е§ЗдїљиЗ™еЈ±еЬ®CSDNзЪДеНЪеЃҐпЉМињЩж†ЈеН≥дљњж≤°жЬЙзљСзїЬпЉМжИЦиАЕжЦЗ瀆䪥姱дЇЖпЉМжИСжЙЛе§ійГљжЬЙдЄАдЄ™е§ЗдїљгАВиЃ∞еЊЧдЄКжђ°еЬ®еЊЃеНЪзЬЛињЗCSDNеИЫеІЛдЇЇиТЛжґЫеЕИзФЯиѓізЪДдЄАеП•иѓЭпЉМдїЦжГ≥еБЪдЄАдЄ™CSDNеНЪеЃҐзФЯжИРPDFжЦЗж°£зЪДеЈ•еЕЈпЉМеЕґеЃЮйВ£дєЯзЫЄељУдЇОеѓєиЗ™еЈ±еНЪеЃҐзЪДе§ЗдїљпЉМињЩж†Је∞±иГљеЊИжЦєдЊњзЪДжµПиІИиЗ™еЈ±зЪДеЖЩзЪДжЦЗзЂ†гАВ

жИСеЖЩзЪДињЩдЄ™"blogspider"з®ЛеЇПпЉМе∞ЖдЉЪжККиЗ™еЈ±еНЪеЃҐдњ°жБѓжПРеПЦеЗЇжЭ•пЉМеєґе∞ЖжЙАжЬЙзЪДжЦЗзЂ†дЄЛиљљеИ∞жЬђеЬ∞гАВињЩйЗМеП™жШѓзЃАеНХзЪДдЄЛиљљзљСй°µиАМеЈ≤пЉМйЗМйЭҐзЪДеЫЊзЙЗжИСж≤°жЬЙдЄЛиљљпЉМйВ£еЊЧжґЙеПКеИ∞姙е§ЪзЪДдЄЬи•њгАВе¶ВжЮЬзФµиДСжЬЙзљСзїЬпЉМе∞ЖдЉЪеЊИеЃєжШУзЪДзЬЛеИ∞еНЪеЃҐйЗМйЭҐзЪДеЫЊзЙЗпЉМе¶ВжЮЬж≤°жЬЙзљСзїЬпЉМеЫЊзЙЗе∞ЖжЧ†ж≥ХжШЊз§ЇгАВ

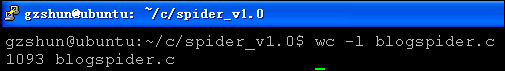

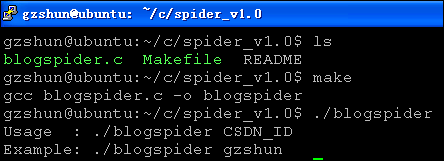

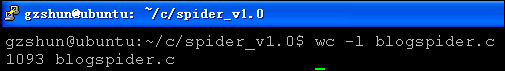

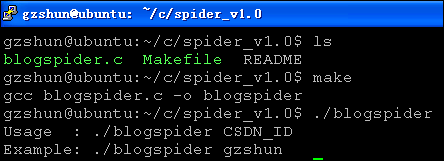

blogspiderз®ЛеЇПзФ±Cиѓ≠и®АзЉЦеЖЩзЪДпЉМеЯЇдЇОLinuxеє≥еП∞пЉМжИСзЉЦеЖЩиѓ•з®ЛеЇПзЪДзОѓеҐГе¶ВдЄЛпЉЪ

жЬђдЇЇеЬ®puttyзїИзЂѓжµЛиѓХз®ЛеЇПпЉМеПѓдї•ж≠£з°ЃзЪДжШЊз§ЇдЄ≠жЦЗпЉМи¶БиЃЊзљЃдЄЇUTF-8пЉМжИЦиАЕGB2312пЉМе¶ВжЮЬжШЊз§Їдє±з†БпЉМеИЗжНҐдЄАдЄЛе≠Чзђ¶йЫЖиѓХиѓХгАВ

дЄА.blogspiderзЪДеКЯиГљзЃАдїЛпЉЪ

1.иОЈеПЦеНЪеЃҐзЪДеЯЇжЬђдњ°жБѓ:

еНЪеЃҐж†ЗйҐШ

еНЪеЃҐиЃњйЧЃйЗП

еНЪеЃҐзІѓеИЖ

еНЪеЃҐжОТеРН

еНЪеЃҐеОЯеИЫжЦЗзЂ†жХ∞йЗП

еНЪеЃҐиљђиљљжЦЗзЂ†жХ∞йЗП

еНЪеЃҐиѓСжЦЗжЦЗзЂ†жХ∞йЗП

еНЪеЃҐиѓДиЃЇжХ∞йЗП

2.дЄЛиљљеНЪеЃҐеИ∞жЬђеЬ∞:

еНЪеЃҐдЄїйҐШ

еНЪеЃҐеПСи°®жЧ•жЬЯ

еНЪеЃҐйШЕиѓїжђ°жХ∞

еНЪеЃҐиѓДиЃЇжђ°жХ∞

дЇМ.blogspiderжґЙеПКеИ∞зЪДзЯ•иѓЖзВє:

1.жЦЗдїґI/O

2.зљСзїЬзЉЦз®Лsocket

3.жХ∞жНЃзїУжЮД-йУЊи°®

4.еЖЕе≠ШеИЖйЕНдЄЙ.blogspiderз®ЛеЇПжЙІи°МжµБз®Л:

дї•жИСзЪДеНЪеЃҐдЄЇдЊЛпЉЪ

1.е∞Ж"http://blog.csdn.net/gzshun"дЄїй°µдЄЛиљљеИ∞жЬђеЬ∞

2.еИЖжЮРиѓ•дЄїй°µпЉМиОЈеПЦеИ∞еНЪеЃҐзЪДURL

3.е∞ЖеНЪеЃҐзЪДURLжЈїеК†еИ∞зИђиЩЂйУЊи°®

4.йБНеОЖзИђиЩЂйУЊи°®пЉМе∞ЖеНЪеЃҐдЄЛиљљеИ∞жЬђеЬ∞

5.е∞ЖдЄЛиљљжЧ•ењЧдњЭе≠ШеЬ®gzshun.logеЫЫ.blogspiderз®ЛеЇПзЪДйЗНи¶БйГ®еИЖ:

1.зИђиЩЂйУЊи°®зЪДзїУжЮДдљУ

2.еНЪеЃҐеЯЇжЬђдњ°жБѓзїУжЮДдљУ

3.еЃЪдєЙзЪДеЗљжХ∞

4.strrstrжШѓиЗ™еЈ±еЃЮзО∞зЪДпЉМCеЇУж≤°жЬЙжПРдЊЫ

1.strrstrеЗљжХ∞пЉЪдїОдЄАдЄ™е≠Чзђ¶дЄ≤дЄ≠жЯ•жЙЊжМЗеЃЪе≠Чзђ¶дЄ≤пЉМињФеЫЮжЬАеРОдЄАжђ°еЗЇзО∞зЪДеЬ∞еЭА

з®ЛеЇПе¶ВдЄЛ:

5.еИЭеІЛеМЦзИђиЩЂйУЊи°®

6.еИЭеІЛеМЦеНЪеЃҐеЯЇжЬђдњ°жБѓзїУжЮДдљУ

дЇФ.blogspiderйБЗеИ∞зЪДйЧЃйҐШ:

1.еНЪеЃҐж†ЗйҐШе¶ВжЮЬжЬЙ'/'пЉМ'?'пЉМжИЦиАЕеЕґдїЦдЄНиІДеИЩзЪДзђ¶еПЈпЉМжЦЗдїґе∞ЖдЉЪеИЫ忯姱賕гАВ

иІ£еЖ≥жЦєж°ИпЉЪе∞ЖдЄНиІДеИЩзЪДзђ¶еПЈиµЛз©ЇпЉМеєґеЬ®еРОйЭҐињЮжО•"xxx"е≠Чзђ¶дЄ≤пЉМи°®з§ЇзЬБзХ•пЉЫ

2.еЬ®жО•еПЧзљСзЂЩжЬНеК°еЩ®еУНеЇФзЪДжЧґеАЩпЉМи¶Бе∞ЖselectеЗљжХ∞зЪДжЧґйЧіиЃЊзљЃйХњзВєпЉМжЬЙжЧґеАЩеЫ†дЄЇзљСзїЬеЈЃзЪДйЧЃйҐШпЉМе∞ЖдЉЪиґЕжЧґеѓЉиЗійААеЗЇз®ЛеЇПгАВеЬ®blogspiderйЗМйЭҐпЉМе∞ЖtimeoutиЃЊзљЃ30sгАВ

3.жЬђз®ЛеЇПеЬ®иАГиЩСеК†еЕ•е§ЪзЇњз®ЛйБНеОЖзИђиЩЂйУЊи°®пЉМзїПињЗе∞ЭиѓХпЉМињЮжО•зљСзЂЩжЬНеК°еЩ®дЉЪеЗЇзО∞зЂЮдЇЙйЧЃйҐШпЉМе∞ЖеѓЉиЗіињЮжО•еїґжЧґпЉМељ±еУНз®ЛеЇПжХИзОЗпЉМжЪВжЧґдЄНиАГиЩСгАВ

еЕ≠.blogspiderињРи°МжИ™еЫЊ:

дљњзФ®blogspiderпЉЪ

ињЩйЗМдї•дЄЛиљљжИСзЪДеНЪеЃҐдЄЇдЊЛпЉМжИСCSDNзЪДIDжШѓпЉЪgzshun, зљСеЭАжШѓпЉЪhttp://blog.csdn.net/gzshun

title : еНЪеЃҐж†ЗйҐШ

url : еНЪеЃҐзљСеЭА

date : еНЪеЃҐеПСи°®жЧ•жЬЯ

reads : еНЪеЃҐйШЕиѓїжђ°жХ∞

comments : еНЪеЃҐиѓДиЃЇжђ°жХ∞

download : еНЪеЃҐдЄЛиљљзКґжАБ

дї•дЄЛињЩеЉ†еЫЊзЙЗжШѓеЬ®windowsжЯ•зЬЛзЪДпЉМйАЪињЗsambaињЮжО•еИ∞ubuntuжЬНеК°еЩ®гАВжИСеНЪеЃҐдЄКйЭҐзЪДжЙАжЬЙжЦЗзЂ†еЈ≤зїПжИРеКЯеЬ∞дЄЛиљљеИ∞жЬђеЬ∞гАВ

жЙУеЉАдЄЛиљљеЬ®жЬђеЬ∞зЪДhtmlжЦЗдїґпЉМж≠§жЧґжЬЙзљСзїЬгАВ

жЙУеЉАдЄЛиљљеЬ®жЬђеЬ∞зЪДhtmlжЦЗдїґпЉМж≠§жЧґжЧ†зљСзїЬгАВ

иЛ•йЬАи¶БblogspiderзЪДжЇРз®ЛеЇПпЉМиѓЈзХЩдЄЛжВ®зЪДE-mailпЉИж≥®жДПи¶БеЖЩжИРжИСеРОйЭҐзЪДйВ£зІН嚥еЉПпЉМеР¶еИЩдЉЪ襀йЭЮж≥ХзљСзїЬзИђиЩЂжКУеПЦпЉЙпЉМжИЦиАЕзЫіжО•иБФз≥їжИСзЪДE-mail:gzshuns#163.com (#->@).

жЬАжЦ∞зЪДblogspiderз®ЛеЇПеЈ≤зїПдЄКдЉ†иЗ≥CSDNдЄЛиљљйҐСйБУпЉМйЬАи¶БзЪДиѓЈиЗ™и°МдЄЛиљљгАВ

дЄЛиљљеЬ∞еЭАеЬ®жИСжЬАжЦ∞еПСи°®зЪДеНЪеЃҐпЉЪ

иЗ™еЈ±еК®жЙЛзЉЦеЖЩCSDNеНЪеЃҐе§ЗдїљеЈ•еЕЈ-blogspiderжЇРз†БдЄЛиљљ(4)

еИЖдЇЂеИ∞пЉЪ

зЫЄеЕ≥жО®иНР

CSDNеНЪеЃҐе§ЗдїљеЈ•еЕЈblogspiderпЉМеПѓдї•е§ЗдїљиЗ™еЈ±жЙАжЬЙзЪДCSDNеНЪеЃҐеИ∞жЬђеЬ∞пЉМдєЯеПѓдї•е§ЗдїљеИЂдЇЇзЪДеНЪеЃҐгАВиЛ•йЬАи¶БдњЭе≠ШеИЂдЇЇзЪДжКАжЬѓеНЪеЃҐжИЦиЗ™еЈ±зЪДйЧЃйҐШпЉМblogspiderеПѓдї•еЄЃдљ†иЊЊеИ∞зЫЃзЪДгАВиЛ•blogspiderз®ЛеЇПеЗЇзО∞йЧЃйҐШпЉМеПѓдї•еЕ≥ж≥®жИСзЪДCSDNеНЪеЃҐпЉМ...

е•љжґИжБѓпЉЪCSDNеНЪеЃҐдЄЛиљљеЩ®v2.0зЙИжЬђеҐЮеК†еѓЉеЗЇPDFжЦЗдїґеКЯиГљпЉМжЦєдЊњжЯ•зЬЛеЫЊзЙЗдЄОжЦЗзЂ†гАВ еЬ®жЧ†зљСзїЬзОѓеҐГпЉМдєЯеПѓдї•зЬЛиЗ™еЈ±зЪДдЄАдЇЫжЦЗзЂ†гАВељУзДґе¶ВжЮЬжВ®еПСзО∞CSDNеНЪеЃҐзЪДдЄАдЇЫжЦЗзЂ†еАЉеЊЧжФґиЧПпЉМдљ†дєЯеПѓдї•дљњзФ®жЬђиљѓдїґиљїжЭЊзЪДдЄЛиљљеИ∞жВ®зЪДзФµиДСгАВ иѓ•зЙИжЬђ...

жИСзЪДжѓХдЄЪиЃЊиЃ°пЉМзФ®дЇОжКУеПЦзЩЊеЇ¶з©ЇйЧізЪДеНЪеЃҐдї•е§ЗдїљеИ∞жЬђеЬ∞жХ∞жНЃеЇУдЄ≠пЉМеПѓдї•дЄЛиљљеЫЊзЙЗеИ∞жЦЗдїґз≥їзїЯдЄ≠гАВ <br>дї£з†БжЛњеЗЇжЭ•дЊЫе§ІеЃґеИЖдЇЂпЉМеЄМжЬЫжЬЙдЇЇдЄАиµЈз†Фз©ґињЫж≠•гАВдЄЛйЭҐжШѓbaiduз©ЇйЧіжЙАдљњзФ®жХ∞жНЃеЇУзЪДдї£з†БпЉМи∞Ґи∞Ґ create database ...

жИСдїђеПѓдї•дљњзФ®еЃГжЭ•еҐЮеК†csdn idзЪДиЃњйЧЃжЧґйЧіпЉМињЩдєЯжШѓдЄАдЄ™еНЪеЃҐе§ЗдїљеЃЮзФ®з®ЛеЇПгАВ pythonзЙИжЬђзЪДBlogspiderжШѓеНХзЇњз®ЛзЪДпЉМдљЖеЊИзЃАеНХгАВ еПѓдї•дЄОCзЙИжЬђињЫи°МжѓФиЊГгАВ жЮДеїЇcsdnBlogSpider еПѓдї•еЬ®ubuntu 3.11.3дЄКзЉЦиѓСеТМдљњзФ®...

ScrapyжШѓдЄАдЄ™еЉЇе§ІзЪДPythonзИђиЩЂж°ЖжЮґпЉМеЃГдЄЇзљСзїЬжХ∞жНЃжКУеПЦжПРдЊЫдЇЖйЂШжХИзЪДеЈ•еЕЈеТМAPIпЉМдљњеЊЧеЉАеПСиАЕеПѓдї•дЄУж≥®дЇОзЉЦеЖЩзИђеПЦйАїиЊСпЉМиАМжЧ†йЬАеЕ≥ж≥®еЇХе±ВеЃЮзО∞гАВеЬ®ињЩдЄ™зЃАеНХзЪДScrapy demoдЄ≠пЉМжИСдїђе∞ЖжОҐиЃ®е¶ВдљХжР≠еїЇдЄАдЄ™еЯЇжЬђзЪДScrapyй°єзЫЃпЉМзРЖиІ£еЕґ...

4. **еЃЮдЊЛдї£з†Б**пЉЪдљЬиАЕжПРдЊЫдЇЖдЄАдЄ™з±ї`BlogSpider`пЉМеЕґдЄ≠еМЕеРЂеЗ†дЄ™жЦєж≥ХпЉМзФ®дЇОеЃЮзО∞зИђиЩЂзЪДеРДдЄ™еКЯиГљж®°еЭЧгАВ - **`__init__`жЦєж≥Х**пЉЪзФ®дЇОеИЭеІЛеМЦдЄАдЇЫеПШйЗПпЉМжѓФе¶ВиѓЈж±ВеЬ∞еЭАгАБиѓЈж±Ве§із≠ЙгАВ - **`send_request`жЦєж≥Х**пЉЪзФ®дЇОеПСйАБ...

class BlogSpider(Spider): # ж†ЗиѓЖеРНзІ∞ name = 'blog' # иµЈеІЛеЬ∞еЭА start_urls = ['http://www.cnblogs.com/'] def parse(self, response): sel = Selector(response) # XPathйАЙжЛ©еЩ® # йАЙжЛ©жЙАжЬЙеРЂжЬЙclass...