Sparkµ£ĆķćŹĶ”üńÜäõĖĆõĖ¬ÕŖ¤ĶāĮ’╝īÕ░▒µś»Õ£©õĖŹÕÉīµōŹõĮ£ķŚ┤’╝īµīüõ╣ģÕī¢’╝łµł¢ń╝ōÕŁś’╝ēõĖĆõĖ¬µĢ░µŹ«ķøåÕ£©ÕåģÕŁśõĖŁŃĆéÕĮōõĮĀµīüõ╣ģÕī¢õĖĆõĖ¬RDD’╝īµ»ÅõĖĆõĖ¬ń╗ōńé╣ķāĮÕ░åµŖŖÕ«āńÜäĶ«Īń«ŚÕłåÕØŚń╗ōµ×£õ┐ØÕŁśÕ£©ÕåģÕŁśõĖŁ’╝īÕ╣ČÕ£©Õ»╣µŁżµĢ░µŹ«ķøå’╝łµł¢ĶĆģĶĪŹńö¤Õć║ńÜäµĢ░µŹ«ķøå’╝ēĶ┐øĶĪīńÜäÕģČÕ«āÕŖ©õĮ£õĖŁķćŹńö©ŃĆéĶ┐ÖÕ░åõĮ┐ÕŠŚÕÉÄń╗ŁńÜäÕŖ©õĮ£(Actions)ÕÅśÕŠŚµø┤ÕŖĀĶ┐ģķƤ’╝łķĆÜÕĖĖÕ┐½10ÕĆŹ’╝ēŃĆéń╝ōÕŁśµś»ńö©Sparkµ×äÕ╗║Ķ┐Łõ╗Żń«Śµ│ĢńÜäÕģ│ķö«ŃĆé

õĮĀÕÅ»õ╗źńö©persist()µł¢cache()µ¢╣µ│ĢµØźµĀćĶ«░õĖĆõĖ¬Ķ”üĶó½µīüõ╣ģÕī¢ńÜäRDD’╝īńäČÕÉÄõĖƵŚ”ķ”¢µ¼ĪĶó½õĖĆõĖ¬ÕŖ©õĮ£’╝łAction’╝ēĶ¦”ÕÅæĶ«Īń«Ś’╝īÕ«āÕ░åõ╝ÜĶó½õ┐ØńĢÖÕ£©Ķ«Īń«Śń╗ōńé╣ńÜäÕåģÕŁśõĖŁÕ╣ČķćŹńö©ŃĆéCacheµ£ēÕ«╣ķöÖµ£║ÕłČ’╝īÕ”éµ×£RDDńÜäõ╗╗õĖĆÕłåÕī║õĖóÕż▒õ║å’╝īķĆÜĶ┐ćõĮ┐ńö©ÕĤÕģłÕłøÕ╗║Õ«āńÜäĶĮ¼µŹóµōŹõĮ£’╝īÕ«āÕ░åõ╝ÜĶó½Ķć¬ÕŖ©ķćŹń«Ś’╝łõĖŹķ£ĆĶ”üÕģ©ķā©ķćŹń«Ś’╝īÕŬĶ«Īń«ŚõĖóÕż▒ńÜäķā©Õłå’╝ēŃĆéÕĮōķ£ĆĶ”üÕłĀķÖżĶó½µīüõ╣ģÕī¢ńÜäRDD’╝īÕÅ»õ╗źńö©unpersistRDD()µØźÕ«īµłÉĶ»źÕĘźõĮ£ŃĆé

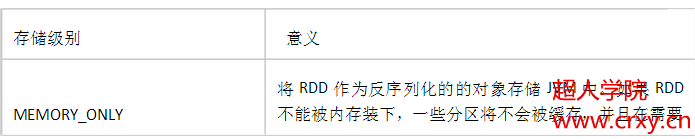

µŁżÕż¢’╝īµ»ÅõĖĆõĖ¬RDDķāĮÕÅ»õ╗źńö©õĖŹÕÉīńÜäõ┐ØÕŁśń║¦Õł½Ķ┐øĶĪīõ┐ØÕŁś’╝īõ╗ÄĶĆīÕģüĶ«ĖõĮĀµīüõ╣ģÕī¢µĢ░µŹ«ķøåÕ£©ńĪ¼ńøś’╝īµł¢ĶĆģÕ£©ÕåģÕŁśõĮ£õĖ║Õ║ÅÕłŚÕī¢ńÜäJavaÕ»╣Ķ▒Ī’╝łĶŖéń£üń®║ķŚ┤’╝ē’╝īńöÜĶć│õ║ÄĶĘ©ń╗ōńé╣ÕżŹÕłČŃĆéĶ┐Öõ║øńŁēń║¦ķĆēµŗ®’╝īµś»ķĆÜĶ┐ćÕ░åõĖĆõĖ¬org.apache.spark.storage.StorageLevelÕ»╣Ķ▒Īõ╝ĀķĆÆń╗Öpersist()µ¢╣µ│ĢĶ┐øĶĪīńĪ«Õ«ÜŃĆécache()µ¢╣µ│Ģµś»õĮ┐ńö©ķ╗śĶ«żÕŁśÕé©ń║¦Õł½ńÜäÕ┐½µŹĘµ¢╣µ│Ģ’╝īõ╣¤Õ░▒µś»StorageLevel.MEMORY_ONLY(Õ░åÕÅŹÕ║ÅÕłŚÕī¢ńÜäÕ»╣Ķ▒ĪÕŁśÕģźÕåģÕŁś’╝ēŃĆé

StorageLevelµ£ēõ║öõĖ¬Õ▒׵Ʀ’╝īÕłåÕł½µś»’╝ÜuseDisk_µś»ÕÉ”õĮ┐ńö©ńŻüńøś’╝īuseMemory_µś»ÕÉ”õĮ┐ńö©ÕåģÕŁś’╝īuseOffHeap_µś»ÕÉ”õĮ┐ńö©ÕĀåÕż¢ÕåģÕŁśÕ”é’╝ÜTachyon’╝īdeserialized_µś»ÕÉ”Ķ┐øĶĪīÕÅŹÕ║ÅÕłŚÕī¢’╝īreplication_Õżćõ╗ĮµĢ░ńø«ŃĆé

Õ«īµĢ┤ńÜäÕÅ»ķĆēÕŁśÕé©ń║¦Õł½Õ”éõĖŗ’╝Ü

┬Ā

┬Ā

ÕŁśÕé©ń║¦Õł½ńÜäķĆēµŗ®

SparkńÜäõĖŹÕÉīÕŁśÕé©ń║¦Õł½’╝īµŚ©Õ£©µ╗ĪĶČ│ÕåģÕŁśõĮ┐ńö©ÕÆīCPUµĢłńÄćµØāĶĪĪõĖŖńÜäõĖŹÕÉīķ£Ćµ▒éŃĆ鵳æõ╗¼Õ╗║Ķ««ķĆÜĶ┐ćõ╗źõĖŗńÜ䵣źķ¬żµØźĶ┐øĶĪīķĆēµŗ®’╝Ü

ŌĆóÕ”éµ×£õĮĀńÜäRDDsÕÅ»õ╗źÕŠłÕźĮńÜäõĖÄķ╗śĶ«żńÜäÕŁśÕé©ń║¦Õł½(MEMORY_ONLY)ÕźæÕÉł’╝īÕ░▒õĖŹķ£ĆĶ”üÕüÜõ╗╗õĮĢõ┐«µö╣õ║åŃĆéĶ┐ÖÕĘ▓ń╗ŵś»CPUõĮ┐ńö©µĢłńÄćµ£Ćķ½śńÜäķĆēķĪ╣’╝īÕ«āõĮ┐ÕŠŚRDDsńÜäµōŹõĮ£Õ░ĮÕÅ»ĶāĮńÜäÕ┐½ŃĆéŌĆóÕ”éµ×£õĖŹĶĪī’╝īĶ»ĢńØĆõĮ┐ńö©MEMORY_ONLY_SERÕ╣ČõĖöķĆēµŗ®õĖĆõĖ¬Õ┐½ķƤÕ║ÅÕłŚÕī¢ńÜäÕ║ōõĮ┐ÕŠŚÕ»╣Ķ▒ĪÕ£©µ£ēµ»öĶŠāķ½śńÜäń®║ķŚ┤õĮ┐ńö©ńÄćńÜäµāģÕåĄõĖŗ’╝īõŠØńäČÕÅ»õ╗źĶŠāÕ┐½Ķó½Ķ«┐ķŚ«ŃĆé

ŌĆó

Õ░ĮÕÅ»ĶāĮõĖŹĶ”üÕŁśÕé©Õł░ńĪ¼ńøśõĖŖ’╝īķÖżķØ×Ķ«Īń«ŚµĢ░µŹ«ķøåńÜäÕćĮµĢ░’╝īĶ«Īń«ŚķćÅńē╣Õł½Õż¦’╝īµł¢ĶĆģÕ«āõ╗¼Ķ┐ćµ╗ż

õ║åÕż¦ķćÅńÜäµĢ░µŹ«ŃĆéÕÉ”ÕłÖ’╝īķ揵¢░Ķ«Īń«ŚõĖĆõĖ¬ÕłåÕī║ńÜäķƤÕ║”’╝īÕÆīõĖÄõ╗ÄńĪ¼ńøśõĖŁĶ»╗ÕÅ¢Õ¤║µ£¼ÕĘ«õĖŹÕżÜÕ┐½ŃĆé

µĆ╗ń╗ō’╝ÜĶ░āńö©persist()µł¢cache()µ¢╣µ│ĢõĮ┐ńö©ńÜ䵜»MEMORY_ONLYÕŁśÕé©ń║¦Õł½’╝īÕ»╣õ║ÄÕ╣┐µÆŁÕÅśķćÅ’╝īõĮ┐ńö©ńÜ䵜»MEMORY_AND_DISKÕŁśÕé©ń║¦Õł½ŃĆéÕ”éµ×£µā│õĮ┐ńö©ÕģČõ╗¢ÕŁśÕé©ń║¦Õł½’╝īÕÅ»õ╗źĶ░āńö©persist(StroageLevel)ŃĆéMEMORY_AND_DISKÕŁśÕé©ń║¦Õł½µŚČÕĮōÕåģÕŁśĶČ│Õż¤µŚČńø┤µÄźõ┐ØÕŁśÕł░ÕåģÕŁśķś¤ÕłŚõĖŁ’╝īÕĮōÕåģÕŁśõĖŹĶČ│µŚČ’╝īÕ░åķćŖµöŠµÄēõĖŹÕ▒×õ║ÄÕÉīõĖĆõĖ¬RDDńÜäblockńÜäÕåģÕŁśŃĆé

- µĄÅĶ¦ł: 160756 µ¼Ī

-

ńżŠÕī║ńēłÕØŚ

- µłæńÜäĶĄäĶ«» ( 0)

- µłæńÜäĶ«║ÕØø ( 0)

- µłæńÜäķŚ«ńŁö ( 0)

ÕŁśµĪŻÕłåń▒╗

- 2017-05 ( 4)

- 2017-04 ( 11)

- 2017-03 ( 4)

- µø┤ÕżÜÕŁśµĪŻ...

µ£Ćµ¢░Ķ»äĶ«║

-

zhou9629’╝Ü

┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā┬Ā

spring redis µĢ┤ÕÉł -

see_you_again’╝Ü

Õø×ÕżŹõĖƵź╝’╝ܵłæõ╣¤ÕŬµś»ÕłØÕŁ”

sparkõĮ┐ńö©logback+slf4j µø┐µŹólog4j+slf4j -

wu_shao_jie’╝Ü

ÕŚ©’╝īµłæÕ£©ńö©spark-submitÕæĮõ╗żµÅÉõ║żõĮ£õĖÜńÜ䵌ČÕĆÖ’╝īÕ║öńö©ń©ŗÕ║Å ...

sparkõĮ┐ńö©logback+slf4j µø┐µŹólog4j+slf4j -

zhangfc682’╝Ü

Õ╝Ģńö©

Eclipseõ╗ŻńĀüµ©ĪµØ┐

ńøĖÕģ│µÄ©ĶŹÉ

Apache Spark µś»õĖōõĖ║Õż¦Ķ¦äµ©ĪµĢ░µŹ«ÕżäńÉåĶĆīĶ«ŠĶ«ĪńÜäÕ┐½ķƤķĆÜńö©ńÜäĶ«Īń«ŚÕ╝ĢµōÄŃĆéSparkµś»UC Berkeley AMP lab (ÕŖĀÕĘ×Õż¦ÕŁ”õ╝»ÕģŗÕł®ÕłåµĀĪńÜäAMPÕ«×ķ¬īÕ«ż)µēĆÕ╝Ƶ║ÉńÜäń▒╗Hadoop MapReduceńÜäķĆÜńö©Õ╣ČĶĪīµĪåµ×Č’╝īSpark’╝īµŗźµ£ēHadoop MapReduceµēĆÕģʵ£ēńÜäõ╝śńé╣...

RDDµīüõ╣ģÕī¢ÕÅ»õ╗źķĆÜĶ┐ćĶ░āńö©persist()µł¢cache()µ¢╣µ│ĢÕ«×ńÄ░ŃĆécache()µ¢╣µ│Ģµś»persist()µ¢╣µ│ĢńÜäń«ĆÕī¢ńēł’╝īÕ«āķ╗śĶ«żõĮ┐ńö©MEMORY_ONLYń║¦Õł½Ķ┐øĶĪīµīüõ╣ģÕī¢ŃĆéÕĮōõĮ┐ńö©persist()µ¢╣µ│ĢµŚČ’╝īÕÅ»õ╗źµīćÕ«ÜõĖŹÕÉīńÜäµīüõ╣ģÕī¢ń║¦Õł½’╝īõ╗źķĆéÕ║öńē╣Õ«ÜńÜäķ£Ćµ▒éŃĆéDataFrameńÜä...

#### ÕøøŃĆüRDDµīüõ╣ģÕī¢ õĖ║õ║åµÅÉķ½śµĆ¦ĶāĮ’╝īÕÅ»õ╗źÕ░åRDDń╝ōÕŁśÕ£©ÕåģÕŁśõĖŁõŠøÕÉÄń╗ŁµōŹõĮ£õĮ┐ńö©ŃĆéµīüõ╣ģÕī¢’╝łPersistence’╝ēµł¢ń╝ōÕŁś’╝łCaching’╝ēµōŹõĮ£ÕģüĶ«Ėńö©µłĘÕ░åRDDÕŁśÕé©Õ£©ÕåģÕŁśõĖŁµł¢ĶĆģńŻüńøśõĖŖ’╝īõ╗źÕżćÕÉÄń╗ŁńÜäĶ«Īń«ŚõĮ┐ńö©ŃĆéńö©µłĘÕÅ»õ╗źµīćÕ«ÜÕŁśÕé©ń║¦Õł½µØźµÄ¦ÕłČµĢ░µŹ«...

**õ║öŃĆüRDDµīüõ╣ģÕī¢** RDDńÜäµīüõ╣ģÕī¢µś»µīćÕ░åõĖŁķŚ┤ń╗ōµ×£ÕŁśÕé©Õ£©ÕåģÕŁśµł¢ńŻüńøśõĖŖ’╝īõ╗źõŠ┐ÕÉÄń╗ŁńÜäĶ«Īń«ŚÕÅ»õ╗źńø┤µÄźÕżŹńö©’╝īµÅÉķ½śµĢ░µŹ«ÕżäńÉåµĢłńÄćŃĆéÕ£©Õ«×ķ¬īõĖŁ’╝īÕÅ»õ╗źķĆÜĶ┐ćĶ░āńö©persist()µł¢cache()µ¢╣µ│ĢÕ«×ńÄ░RDDńÜäµīüõ╣ģÕī¢ŃĆé **ÕģŁŃĆüÕ«×ķ¬īµĆ╗ń╗ō** ķĆÜĶ┐ćÕ»╣Spark...

- **RDDµīüõ╣ģÕī¢’╝łPersist’╝ē**: Õ£©SparkõĖŁ’╝īÕÅ»õ╗źķĆÜĶ┐ćĶ░āńö©`persist`µł¢`cache`µ¢╣µ│ĢµØźń╝ōÕŁśRDD’╝īõ╗ÄĶĆīķü┐ÕģŹķćŹÕżŹĶ«Īń«ŚŃĆéķ£ĆĶ”üµ│©µäÅńÜ䵜»’╝īÕ£©Ķ░āńö©`persist`ÕÉÄõĖŹÕ║öÕåŹµ£ēÕģČõ╗¢ńÜäĶĮ¼µŹóµōŹõĮ£’╝īõ╗źķś▓µŁóµĢ░µŹ«ķøåńÜäµø┤µ¢░Õ»╝Ķć┤ń╝ōÕŁśÕż▒µĢłŃĆé - **...

- ÕŁśÕé©ńŁ¢ńĢź’╝ÜÕÅ»õ╗źķĆēµŗ®Õ░åRDDµīüõ╣ģÕī¢Õł░ÕåģÕŁśŃĆüńŻüńøśµł¢ÕÉīµŚČÕŁśÕé©’╝īõ╗źõŠ┐Õ£©ÕÉÄń╗ŁµōŹõĮ£õĖŁķćŹńö©’╝īÕćÅÕ░æĶ«Īń«ŚµłÉµ£¼ŃĆé 4. ÕłåÕī║õĖÄÕ╣ČĶĪīµĆ¦’╝Ü - RDDńÜäÕłåÕī║Õå│Õ«Üõ║åÕģČÕ£©ķøåńŠżõĖŁńÜäÕłåÕĖā’╝īµ»ÅõĖ¬ÕłåÕī║ÕÅ»õ╗źÕ£©õĖĆõĖ¬ÕĘźõĮ£ĶŖéńé╣õĖŖńŗ¼ń½ŗĶ«Īń«ŚŃĆé - ÕÅ»õ╗źķĆÜĶ┐ć`...

RDDµīüõ╣ģÕī¢ÕģüĶ«Ėµłæõ╗¼Õ░åõĖŁķŚ┤ń╗ōµ×£ń╝ōÕŁśÕł░ÕåģÕŁśµł¢ńŻüńøś’╝īõ╗źķü┐ÕģŹķćŹÕżŹĶ«Īń«Ś’╝īµÅÉķ½śµĢ┤õĮōµĆ¦ĶāĮŃĆéSparkµö»µīüÕżÜń¦Źµīüõ╣ģÕī¢ń║¦Õł½’╝īÕ”éMEMORY_ONLYŃĆüMEMORY_AND_DISKńŁē’╝īÕÅ»õ╗źµĀ╣µŹ«õ╗╗ÕŖĪķ£Ćµ▒éÕÆīĶĄäµ║ɵāģÕåĄķĆēµŗ®ÕÉłķĆéńÜäń║¦Õł½ŃĆé ń╗╝õĖŖµēĆĶ┐░’╝īĶ┐ÖõĖ¬ÕÄŗń╝®Õīģ...

* RDD µīüõ╣ģÕī¢’╝ÜRDD ńÜäµīüõ╣ģÕī¢µ£║ÕłČ * ńøæµÄ¦Õ║öńö©ń©ŗÕ║Å’╝ÜÕ”éõĮĢńøæµÄ¦ Spark Õ║öńö©ń©ŗÕ║Å * µĆ¦ĶāĮĶ░āõ╝ś’╝ÜSpark ńÜäµĆ¦ĶāĮĶ░āõ╝śµŖĆÕʦ ÕģČõ╗¢ * Copyright ÕÆī License’╝ÜSpark ńÜäńēłµØāÕÆīĶ«ĖÕÅ»õ┐Īµü» * µØźµ║É’╝ÜSpark Õ«śµ¢╣µ¢ćµĪŻńÜäµØźµ║É * Ķ«ĖÕÅ»õ┐Īµü»’╝Ü...

2. **µīüõ╣ģÕī¢**’╝Ü`cache`µ¢╣µ│Ģńö©õ║ÄÕ░åRDDµīüõ╣ģÕī¢Õł░ÕåģÕŁśõĖŁ’╝īĶ┐Öµś»õĖ║õ║åµÅÉķ½śµĢ░µŹ«ÕżäńÉåńÜäµĢłńÄć’╝īķü┐ÕģŹÕ£©ÕżÜµ¼ĪµōŹõĮ£ķŚ┤ķćŹÕżŹĶ«Īń«ŚŃĆé`persist`µ¢╣µ│ĢÕģüĶ«Ėńö©µłĘµīćիܵīüõ╣ģÕī¢ńÜäÕŁśÕé©ń║¦Õł½’╝īµ»öÕ”é`MEMORY_ONLY`ŃĆü`DISK_ONLY`ńŁēŃĆé 3. **ķØ×µīüõ╣ģÕī¢**...

Spark Õ║öńö©ń©ŗÕ║ÅķāĮńö▒õĖĆõĖ¬ķ®▒ÕŖ©ń©ŗÕ║Å(driver programe)µ×䵳ɒ╝īķ®▒ÕŖ©ń©ŗÕ║ÅÕ£©ķøåńŠżõĖŖĶ┐ÉĶĪīńö©µłĘ...ńö©µłĘÕÅ»õ╗źĶ”üµ▒é Spark Õ░å RDD µīüõ╣ģÕī¢(persist)Õł░ÕåģÕŁśõĖŁ’╝īµØźĶ«®Õ«āÕ£©Õ╣ČĶĪīĶ«Īń«ŚõĖŁ ķ½śµĢłÕ£░ķćŹńö©ŃĆéµ£ĆÕÉÄ’╝īRDDs ĶāĮÕ£©ĶŖéńé╣Õż▒Ķ┤źõĖŁĶć¬ÕŖ©Õ£░µüóÕżŹĶ┐ćµØźŃĆé

µ£¼ń»ćń¼öĶ«░õĖ╗Ķ”üµÄóĶ«©SparkõĖŁńÜäÕģ▒õ║½ÕÅśķćÅŃĆüRDDµīüõ╣ģÕī¢ŃĆücheckpointµ£║ÕłČŃĆüĶ┐ÉĶĪīµ©ĪÕ╝Åõ╗źÕÅŖõ╗╗ÕŖĪĶ░āÕ║”ńŁēńøĖÕģ│ń¤źĶ»åńé╣ŃĆé 1. **Õģ▒õ║½ÕÅśķćÅ** - **ń┤»ÕŖĀÕÖ©’╝łAccumulator’╝ē**’╝Üń┤»ÕŖĀÕÖ©µś»õĖĆń¦ŹÕŬĶāĮÕó×ÕŖĀõĖŹĶāĮÕćÅÕ░æńÜäÕģ▒õ║½ÕÅśķćÅ’╝īÕĖĖńö©õ║Äń╗¤Ķ«Īõ╗╗ÕŖĪõĖŁ...

### SparkµĆ¦ĶāĮĶ░āõ╝śõĖÄń╗Åķ¬īµĆ╗ń╗ō #### õĖĆŃĆüµĆ¦ĶāĮĶ░āõ╝śµ”éĶ┐░ Õ£©SparkńÜäÕ║öńö©Õ£║µÖ»õĖŁ’╝īµĆ¦ĶāĮĶ░āõ╝śµś»õĖĆ...µŁżÕż¢’╝īÕÉłńÉåÕ£░Õł®ńö©RDDµīüõ╣ģÕī¢ÕŖ¤ĶāĮõ╣¤µś»µÅÉķ½śµĆ¦ĶāĮńÜäķćŹĶ”üµēŗµ«Ąõ╣ŗõĖĆŃĆéķĆÜĶ┐ćõ╗źõĖŖĶ┐Öõ║øµ¢╣µ│Ģ’╝īÕÅ»õ╗źµ£ēµĢłÕ£░µÅÉÕŹćSparkÕ║öńö©ńÜäµĢ┤õĮōµĆ¦ĶāĮĶĪ©ńÄ░ŃĆé

- **RDDµīüõ╣ģÕī¢**’╝ÜķĆÜĶ┐ćµīüõ╣ģÕī¢µ£║ÕłČ’╝īRDDÕÅ»õ╗źÕ£©ÕåģÕŁśŃĆüńŻüńøśńöÜĶć│Õż¢ķā©ÕŁśÕé©õĖŁõ┐ØÕŁś’╝īõ╗źµÅÉÕŹćĶ«Īń«ŚµĆ¦ĶāĮŃĆé SparkCoreńÜäÕ«×õŠŗń╗āõ╣Āµś»ÕŁ”õ╣ĀńÜäÕģ│ķö«’╝īķĆÜĶ┐ćõ╗źõĖŗõĖēõĖ¬Õ«×õŠŗ’╝īõĮĀÕÅ»õ╗źµĘ▒ÕģźńÉåĶ¦ŻRDDńÜäÕ«×ķÖģÕ║öńö©’╝Ü 1. **Ķ«Īń«Śńŗ¼ń½ŗIPµĢ░**’╝ÜĶ┐ÖķĆÜÕĖĖ...

õĖ║õ║åµÅÉķ½śµĢłńÄć’╝īSparkÕģüĶ«ĖÕ░åRDDµīüõ╣ģÕī¢Õł░ÕåģÕŁśõĖŁ’╝īĶ┐ÖµĀĘÕ£©ÕÉÄń╗ŁńÜäĶ«Īń«ŚõĖŁÕÅ»õ╗źķćŹńö©’╝īÕćÅÕ░æķćŹÕżŹĶ«Īń«ŚŃĆ鵣żÕż¢’╝īSparkĶ┐śµÅÉõŠøõ║åÕ╣┐µÆŁÕÅśķćÅ’╝łBroadcast Variables’╝ēÕÆīń┤»ÕŖĀÕÖ©’╝łAccumulators’╝ēõĖżń¦ŹÕģ▒õ║½ÕÅśķćÅń▒╗Õ×ŗ’╝īÕēŹĶĆģńö©õ║ÄÕÉæµēƵ£ēÕĘźõĮ£ĶŖéńé╣...

7. **µīüõ╣ģÕī¢µ£║ÕłČ’╝łRDDµīüõ╣ģÕī¢’╝ē**’╝Ü - Õ£©SparkõĖŁ’╝īµīüõ╣ģÕī¢µ£║ÕłČÕÅ»õ╗źń╝ōÕŁśõĖŁķŚ┤µĢ░µŹ«’╝īķü┐ÕģŹķćŹÕżŹĶ«Īń«Ś’╝īµÅÉÕŹćµĆ¦ĶāĮŃĆé - µīüõ╣ģÕī¢ÕÅ»õ╗źķĆÜĶ┐ćĶ░āńö©RDDńÜäcache()µł¢persist()µ¢╣µ│ĢÕ«×ńÄ░’╝īńö©µłĘÕÅ»õ╗źµĀ╣µŹ«µĢ░µŹ«ńÜäõĮ┐ńö©ķóæńÄćÕÆīõĮ£õĖÜńÜäµĆ¦ĶāĮĶ”üµ▒éķĆēµŗ®...

ńö©µłĘõ╣¤ÕÅ»õ╗źĶ»Ęµ▒éSparkÕ░åRDDµīüõ╣ģÕī¢Õ£©ÕåģÕŁśõĖŁ’╝īĶ┐ÖµĀĘÕ░▒ÕÅ»õ╗źĶĘ©ÕżÜõĖ¬Õ╣ČĶĪīµōŹõĮ£ķ½śµĢłķćŹńö©ŃĆ鵣żÕż¢’╝īµ¢ćµĪŻĶ┐śõ╗ŗń╗Źõ║åÕģ│õ║ÄÕ”éõĮĢÕ£©ÕłåÕĖāÕ╝ÅńÄ»ÕóāõĖŁõ╝ĀķĆÆÕćĮµĢ░ń╗ÖSpark’╝īńÉåĶ¦ŻķŚŁÕīģ’╝łclosure’╝ēńÜäõĮ£ńö©Õ¤¤’╝īõ╗źÕÅŖÕ”éõĮĢÕ£©µ£¼Õ£░µ©ĪÕ╝ÅõĖÄķøåńŠżµ©ĪÕ╝Åõ╣ŗķŚ┤ÕłćµŹóŃĆé ...

2.6RDDµīüõ╣ģÕī¢µōŹõĮ£ 21 2.7µ│©µäÅõ║ŗķĪ╣ 23 2.7Õ╣ČĶĪīÕ║”Ķ░āõ╝ś 24 2.8ÕłåÕī║µ¢╣Õ╝Å 25 3Examle:PageRank 27 ń¼¼Õøøń½Ā Sparkń╝¢ń©ŗĶ┐øķśČ 29 1Õģ▒õ║½ÕÅśķćÅ 29 1.1ń┤»ÕŖĀÕÖ© 30 1.2Õ╣┐µÆŁÕÅśķćÅ 31 2Õ¤║õ║ÄÕłåÕī║Ķ┐øĶĪīµōŹõĮ£ 32 3õĖÄÕż¢ķā©ń©ŗÕ║ÅķŚ┤ńÜäń«Īķüō 33 4...

Ķ┐ÖķćīõĮ┐ńö©õ║å`persist`µ¢╣µ│ĢÕ░åRDDµīüõ╣ģÕī¢Õł░ÕåģÕŁśõĖŁ’╝ī`StorageLevel.MEMORY_ONLY`ĶĪ©ńż║ÕŬÕ░åµĢ░µŹ«ń╝ōÕŁśÕ£©ÕåģÕŁśõĖŁŃĆé - **3.3.2 SparkńÜäµīüõ╣ģÕī¢ń║¦Õł½** - **MEMORY_ONLY**: ÕŬń╝ōÕŁśÕł░ÕåģÕŁśõĖŁ’╝īÕĮōÕåģÕŁśõĖŹĶČ│µŚČõ╝ÜĶó½ń¦╗ķÖżŃĆé - **MEMORY_...

µ»ÅõĖ¬ RDD ÕÅ»õ╗źķĆÜĶ┐ćĶĮ¼µŹóµōŹõĮ£(Õ”é mapŃĆüfilter)õ╗ÄÕÅ”õĖĆõĖ¬ RDD ÕłøÕ╗║’╝īÕ╣ČõĖöÕÅ»õ╗źĶó½µīüõ╣ģÕī¢Õł░ÕåģÕŁśµł¢ńŻüńøśõ╗źÕŖĀķƤÕÉÄń╗ŁĶ«Īń«ŚŃĆé 2. **Õåģķā©ń╗ōµ×äõĖÄÕłåÕī║** RDD ÕłåÕī║µś»ÕģČÕåģķā©µĢ░µŹ«ńÜäķĆ╗ĶŠæÕłåń╗ä’╝īµ»ÅõĖ¬ÕłåÕī║ÕÅ»õ╗źÕ£©ķøåńŠżńÜäõĖŹÕÉīĶŖéńé╣õĖŖńŗ¼ń½ŗµē¦ĶĪī...