- æĩč§: 2638784 æŽĄ

- æĨčŠ: æå·

-

æįŦ åįąŧ

- å ĻéĻååŪĒ (1188)

- webwork (4)

- į―æ (18)

- java (103)

- hibernate (1)

- Linux (85)

- čäļååą (1)

- activeMQ (2)

- netty (14)

- svn (1)

- webx3 (12)

- mysql (81)

- css (1)

- HTML (6)

- apache (3)

- æĩčŊ (2)

- javascript (1)

- åĻå (1)

- jvm (5)

- code (13)

- åĪįšŋįĻ (12)

- Spring (18)

- webxs (2)

- python (119)

- duitang (0)

- mongo (3)

- nosql (4)

- tomcat (4)

- memcached (20)

- įŪæģ (28)

- django (28)

- shell (1)

- å·Ĩä―æŧįŧ (5)

- solr (42)

- beansdb (6)

- nginx (3)

- æ§č― (30)

- æ°æŪæĻč (1)

- maven (8)

- tonado (1)

- uwsgi (5)

- hessian (4)

- ibatis (3)

- Security (2)

- HTPP (1)

- gevent (6)

- čŊŧäđĶįŽčŪ° (1)

- Maxent (2)

- mogo (0)

- thread (3)

- æķæ (5)

- NIO (5)

- æĢå (1)

- lucene (5)

- feed (4)

- redis (17)

- TCP (6)

- test (0)

- pythonïžcode (1)

- PIL (3)

- guava (2)

- jython (4)

- httpclient (2)

- cache (3)

- signal (1)

- dubbo (7)

- HTTP (4)

- json (3)

- java socket (1)

- io (2)

- socket (22)

- hash (2)

- Cassandra (1)

- ååļåžæäŧķįģŧįŧ (5)

- Dynamo (2)

- gc (8)

- scp (1)

- rsync (1)

- mecached (0)

- mongoDB (29)

- Thrift (1)

- scribe (2)

- æåĄå (3)

- éŪéĒ (83)

- mat (1)

- classloader (2)

- javaBean (1)

- ææĄĢéå (27)

- æķæŊéå (3)

- nginxïžææĄĢéå (1)

- dboss (12)

- libevent (1)

- čŊŧäđĶ (0)

- æ°åĶ (3)

- æĩįĻ (0)

- HBase (34)

- čŠåĻåæĩčŊ (1)

- ubuntu (2)

- åđķå (1)

- sping (1)

- åūå―Ē (1)

- freemarker (1)

- jdbc (3)

- dbcp (0)

- sharding (1)

- æ§č―æĩčŊ (1)

- čŪūčŪĄæĻĄåž (2)

- unicode (1)

- OceanBase (3)

- jmagick (1)

- gunicorn (1)

- url (1)

- form (1)

- åŪå Ļ (2)

- nlp (8)

- libmemcached (1)

- č§ååžæ (1)

- awk (2)

- æåĄåĻ (1)

- snmpd (1)

- btrace (1)

- äŧĢį (1)

- cygwin (1)

- mahout (3)

- įĩåäđĶ (1)

- æšåĻåĶäđ (5)

- æ°æŪææ (1)

- nltk (6)

- pool (1)

- log4j (2)

- æŧįŧ (11)

- c++ (1)

- javaæšäŧĢį (1)

- ocr (1)

- åšįĄįŪæģ (3)

- SA (1)

- įŽčŪ° (1)

- ml (4)

- zokeeper (0)

- jms (1)

- zookeeper (5)

- zkclient (1)

- hadoop (13)

- mq (2)

- git (9)

- éŪéĒïžio (1)

- storm (11)

- zk (1)

- æ§č―äžå (2)

- example (1)

- tmux (1)

- įŊåĒ (2)

- kyro (1)

- æĨåŋįģŧįŧ (3)

- hdfs (2)

- python_socket (2)

- date (2)

- elasticsearch (1)

- jetty (1)

- æ (1)

- æą―č―Ķ (1)

- mdrill (1)

- č―Ķ (1)

- æĨåŋ (1)

- web (1)

- įžčŊåį (1)

- äŋĄæŊæĢįīĒ (1)

- æ§č―ïžlinux (1)

- spam (1)

- åšåå (1)

- fabric (2)

- guice (1)

- disruptor (1)

- executor (1)

- logback (2)

- åžæš (1)

- čŪūčŪĄ (1)

- įæ§ (3)

- english (1)

- éŪéĒčŪ°å― (1)

- Bitmap (1)

- äščŪĄįŪ (1)

- éŪéĒææĨ (1)

- highchat (1)

- mac (3)

- docker (1)

- jdk (1)

- čĄĻčūūåž (1)

- į―įŧ (1)

- æķéīįŪĄį (1)

- æķéīåšå (1)

- OLAP (1)

- Big Table (0)

- sql (1)

- kafka (1)

- md5 (1)

- springboot (1)

- spring security (1)

- Spring Boot (3)

- mybatis (1)

- java8 (1)

- ååļåžäšåĄ (1)

- éæĩ (1)

- Shadowsocks (0)

- 2018 (1)

- æåĄæēŧį (1)

- čŪūčŪĄåå (1)

- log (0)

- perftools (1)

įĪūåšįå

- æįčĩčŪŊ ( 0)

- æįčŪšå ( 98)

- æįéŪį ( 0)

åæĄĢåįąŧ

- 2019-11 ( 1)

- 2019-01 ( 3)

- 2018-12 ( 1)

- æīåĪåæĄĢ...

ææ°čŊčŪš

-

siphlinaïž

čŊūįĻââåšäšPythonæ°æŪåæäļæšåĻåĶäđ æĄäūåŪææįĻåäšŦį―į ...

PythonæšåĻåĶäđ åš -

san_yunïž

leibnitz åéhi,ææģįĨé,æ čŪšåĻ92čŋæŊ94įæŽ, ...

hbaseįčĄéäļåĪįæŽåđķåæ§åķ(MVCC) -

leibnitzïž

hi,ææģįĨé,æ čŪšåĻ92čŋæŊ94įæŽ,æīæ°æķ(åĶPuts)é― ...

hbaseįčĄéäļåĪįæŽåđķåæ§åķ(MVCC) -

107xïž

äļéïžč°Ēč°Ēïž

Latent Semantic Analysis(LSA/ LSI)įŪæģįŪäŧ -

107xïž

äļéïžč°Ēč°Ēïž

PythonæšåĻåĶäđ åš

äļįŪĄæäđčŊī,æįīĒé―æŊéåļļéčĶįææŊ,äļäŧ äŧ æŊæä―įģŧįŧéæäš,åūåĪåšįĻč―Ŋäŧķé―ææįīĒįåč―,čŪšåæäļéĻįĻäšåĻčŪšåæįīĒį,äščį―å°ąæčŊļåĶåįūåšĶãč°·æäđįąŧįæįīĒåžæ,æŧččĻäđ,åŠčĶæ°æŪéįĻåūŪåĪ§äļįđįåšįĻįĻåš,é―äžæäūæįīĒčŋäļŠåč―.

æäŧŽäļšäŧäđéčĶLucene?

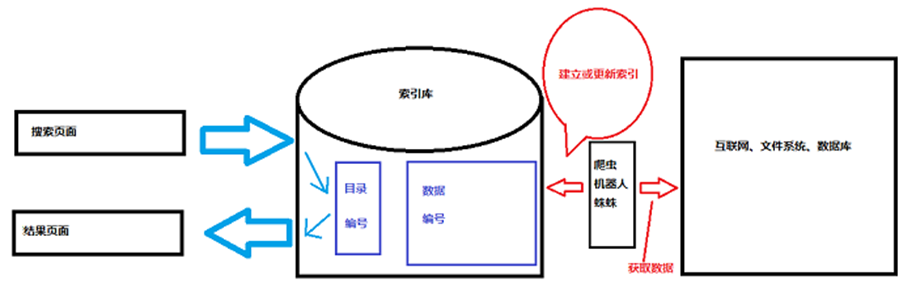

äŧŧä―įįæĨčŊĒåč―é―įąŧäžž,é―æŊåŊđææŽå åŪđįæįīĒ,čŊīį―äš,å°ąæŊæūåšåŦææåŪåįŽĶäļēįįčĩæš,åŠæŊæĨæūįčåīäļåčå·ē.

įŪ åįäļŧæĩæįīĒé―æŊå ĻææįīĒ,åģæ đæŪįĻåšæŦææįŦ äļįæŊäļäļŠčŊ,äļšæŊäļäļŠčŊåŧšįŦįļåšįįīĒåž,åđķäļææčŊĨčŊåĻæįŦ äļåšį°įæŽĄæ°åä―į―Ū.å―įĻæ·æĨčŊĒæķ,æ đæŪåŧšįŦ įįīĒåžčŋčĄæĨæū,įąŧäžžäšéčŋåå ļįæĢįīĒæđåžæĨæĨåįčŋįĻ.æäŧŽåæįīĒ,čĶäŋčŊå įđ,įŽŽäļįđå°ąæŊčĶåŋŦ,åĶæįūåšĶãč°·ææäļŠäļčĨŋčĶ10å į§,ææé―æēĄäššįĻäš å§?įŽŽäšįđ,å åŋŦæäŧäđ?æåšæĨįäļčĨŋåŪå ĻäļæŊčŠå·ąæģčĶį,åĪ§åŪķéčŋæįīĒåžææūäļčĨŋįæķå,čŊåŪæģĻæå°äšäļįđ,å°ąæŊåĪ§åŪķåūå°åĻ2éĄĩäŧĨåčŋįđäļäļéĄĩ,čŋæįīĒ įįŧææŊčĒŦåĪįčŋį,æææåŊč―æŊä― éčĶįäļčĨŋæūåĻäšåéĒ,čŋå°ąæŊåįĄŪæ§,čäļæįīĒåŠéåŊđææŽ,äļįŪĄä― įå ģéŪåįčŊäđ.æäŧĨ,æŧįŧäļäļ,å°ąæŊ:

- åŠåĪįææŽ

- äļåĪįčŊäđ

- čąæäļåšååĪ§å°å

- įŧæåčĄĻæįļå ģåšĶæåš

åæ°æŪåšįæįīĒčŊåĨæä―äļå?

æäŧŽäļšäŧäđéčĶäļéĻåŊđå ĻææįīĒčŋčĄæčŋ°åĒ?å äļšåŪåŊäŧĨåå°selectčŊåĨåäļå°įäšæ .åĶææäŧŽéčĶåĻæ°æŪåšééĒæįīĒäļäļŠå ģéŪå,æŊåĶant,å°ąäžæįąŧäžžįčŊåĨ:

| SELECT  *  FROM  table_name WHERE  content like  ' %ant% ' |

äžæplantingäđįąŧįåčŊäđæįīĒåšæĨ,æūįķå°ąæŊæēĄææäđį,æēĄæäššäžåæŽĒčŋæ ·įŧæ.

åĶåĪæ°æŪåšįæįīĒäđåđķäļč―äļšįŧæåįļå ģåšĶåūå,äđå°ąåäļäšįļå ģåšĶæå.æįīĒįŧæäđæīåĪįæŊæ æį,æč æŊæ įĻį.

æåäļįđ,äđåūčīå―,æ°æŪåšäļįlike,æūåūéåļļæ Ē,äļæĄčŪ°å―äļæĄčŪ°å―å°æū,ææķåįŪįīéūäŧĨåŋå,čįĻå ĻææĢįīĒįæđåžåæŊå åĻįŪå―ééĒæĨ,æūå°čŪ°å―æåĻįä―į―Ū,åįīæĨåŪä―čŋåŧ.

æäŧĨselectčŊåĨįåžąįđå°ąæŊLuceneįäžįđ,åŪåŊäŧĨč§Ģåģäļčŋ°įéŪéĒ.

åĻįĻåšäļéčĶåžå ĨåŠäšå ?

éčĶåĶä―ååĪåžåįŊåĒåĒ,åŠäšå æŊåŋ éĄŧčĶæį,åŋéčĶåĪ§čīæäļŠæ°æčĄ:

lucene-core-3.0.1.jar(æäļšæ ļåŋįå ,åŋ äļåŊå°)

contrib/analyzers/common/lucene-analyzers-3.0.1.jar(įĻæĨå°äļæŪĩåįŽĶäļēäŧĨäŧäđč§ååč§ĢåžæĨįåčŊåĻ)

contrib/highlighter/lucene-highlighter-3.0.1.jar(å°æūå°įįŧæéŦäšŪæūįĪš)

contrib/memory/lucene-memory-3.0.1.jar(éŦäšŪæūįĪšjarå æäūčĩįå )

Luceneįå·Ĩä―æĩįĻ

æ äŧŽæŊæŽĄä―ŋįĻæįīĒåžæįæķå,åģäļč§åūåūäžæūįĪšįĻäšåĪäđ ,čŋäļŠæķéīčŪĐäšščæŊæč§äļåĪŠåįĄŪ,åĨ―åæēĄéĢäđåŋŦ.čŋäļæŊčŊīæįīĒåžæįéåšĶäļåĪ,æåŊč―æĨčŊĒįįåŠįĻäš éĢäđįđæķéī,ä―æŊčŋåįéĄĩéĒäđæŊéčĶæķéīæĨįæį,čŋčĶåĻéĄĩéĒäļå å Ĩåđŋåäđįąŧį,čŋäļŠæķéīåŊč―å°ąæēĄæčŪĄįŪåĻå .æŧččĻäđ,įæĢįĻæĨæįīĒįæķéīæŊéåļļįį, éĢäđåŪäļšäŧäđč―åĪčŋäđåŋŦåĒ?åŪé äļ,æįīĒįæķååđķäļæŊåĻæ°æŪåšééĒčŋčĄæįīĒ,čæŊåĻLuceneįŧīæĪįįīĒåžåšééĒčŋčĄį,įīĒåžåšå åŦäļĪéĻåå åŪđ,äļäļŠį§°äđ äļšįŪå―,čŋäļŠįŪå―ééĒå°ąåæåį§å ģéŪčŊåŊđåšæ°æŪįä―į―Ū,æįīĒįæķåäļ,Luceneå°ąäŧĨæį§æåŪįč§åå°ä― æäūįå ģéŪåčŋčĄåčŊ,įķååĻįŪå―ééĒæū,æūåū å°įčŊ,å°ąčŋåäļäļŠįžå·,čŋäļŠįžå·æŊåŊäļį,éčŋčŋäļŠįžå·åŊäŧĨæūå°æ°æŪ,ä―æŊæ°æŪäđäļæŊååĻæ°æŪåšäļį.LuceneįįīĒåžåšäļæīåĪįéĻåæŊįĻæĨååĻæ°æŪ į,čŋäļŠæ°æŪæŊäŧäščį―æč æäŧķįģŧįŧæč æ°æŪåšäļæūå°į,å°ąåįūåšĶįåŋŦį §äļæ ·,åŪåŠæŊäļäļŠįžå,įŧä― įåĪ§čīįå åŪđ,å―ä― įĄŪåŪčŋå°ąæŊä― čĶæūįå åŪđ,åđķäļįđčŋ åŧįæķå,æįæĢå°åŧčŪŋéŪéĢäļŠéĄĩéĒ.æįīĒé―æŊåĻįīĒåžåšééĒåŪæį.éĢäđå°ąåšį°äšäļäļŠéŪéĒ,ææķåæįīĒå°įäļčĨŋ,įđčŋåŧåį°äļååĻ,ææŊå·ēįŧå éĪäš,ææŊå·ē įŧæīæ°äš.éĢäđå°ąéčĶįŧåļļæīæ°,ææŊæķæķæīæ°.åĪ§čīæĩįĻåĶäļ:

įŽčŦįĻæĨäļéīæįč·åæ°æŪ,éåļļååååļå°äščį―äļįæ°æŪäļč―įŦåģåĻæįīĒåžæäļæūå°,å°ąæŊå äļščŋäļŠåå .åŊäŧĨæåŪčŪĐįŽčŦįŽåŠäšįąŧåįéĄĩéĒ,æĨååįīæįīĒ.

įīĒåžåšįCURD

äļååæé―æŊåŧšįŦåĻæįīĒåžįåšįĄäļ,æäŧĨčĶå ååŧšįīĒåž.åŊđįīĒåžčŋčĄåįåŊđ蹥æŊIndexWriter.éčĶæåŪįīĒåžįä―į―Ū,åŊäŧĨåĻæäŧķįģŧįŧäļ,äđåŊäŧĨåĻå åäļ,éĪéäŋčŊčŪĄįŪæšįå åæŊæķæŊåŧé―æŊååĻį,åĶåå°äļĒåĪą:

| /* * |

|

*FSDirectory:DirectoryæŊæ―蹥įąŧ,FSDirectoryæŊįŧ§æŋåŪįåįąŧ.FSåįžäŧĢčĄĻæäŧķįģŧįŧ(File System),æåŪåĻå―åč·ŊåūäļåŧšįŦįīĒåžįæäŧķåĪđåäļšindexDir. *Analyzer:åčŊåĻ.äŧĨæį§č§ååŊđå ģéŪåčŋčĄåčŊ,åčŊįįŧæåčŋįŪå―,įĻįžå·äļæ°æŪåŊđåš,éčĶæåŪLuceneįįæŽå·. *IndexWriter:č―åĪåŧšįŦįīĒåžåš,čĶįŧåŪäļéĒäļĪäļŠįąŧ.čŋéįįŽŽäļäļŠåæ°čĄĻįĪšäļäļŠįīĒåžééĒæåĪååĪå°äļŠField,čķ åšéĻåå°åŋ―įĨ. *MaxFieldLength.LIMITED:10000. |

| */ |

| Directory directory =  FSDirectory. open(new  File(" ./indexDir/ " )); |

| Analyzer analyzer =  new  StandardAnalyzer(Version. LUCENE_30); |

| IndexWriter indexWriter =  new  IndexWriter(directory,analyzer,MaxFieldLength. LIMITED); |

| Â Â Â Â Â Â Â Â Â Â Â |

čŋ æ ·å°ąč―ååŧšįīĒåžåš,ä―æŊäļč―æåŊđ蹥įīæĨåčŋåŧ,éčĶč―ŽæLuceneéæąįåŊđ 蹥:org.apache.lucene.document.Document,DocumentįæŊäļäļŠFieldé―äŧĢčĄĻåŊđ蹥éčĶååĻåĻįīĒåžåšäļįåą æ§,čŋæ ·åĻæįīĒįæķå,åŊäŧĨįå°æ°æŪįæčĶ:

| /* * |

|

*įĻDocumentįadd()æđæģåĒå äļäļŠåąæ§čŋįīĒåžåš,æĨæķäļäļŠFieldåŊđ蹥. *FieldåŊđ蹥įįŽŽäļäļŠåæ°:įĻæåŪįåįŽĶäļēååŧšäļäļŠFieldåŊđ蹥. *FieldåŊđ蹥įįŽŽäšäļŠåæ°:ååĻįåž. *FieldåŊđ蹥įįŽŽäļäļŠåæ°:æŊåĶåĻįīĒåžåšįæ°æŪééĒååĻFieldįåž. *FieldåŊđ蹥įįŽŽåäļŠåæ°:äŧĨä―į§æđåžåŊđįŽŽäšäļŠåæ°įåžčŋčĄæä―(åčŊãäļåčŊãäļåŧšįŦįīĒåž). |

| */ |

| Document doc =  new  Document(); |

| Article article =  (Article) obj; |

| doc. add(new  Field(" id " ,article. getId(). toString(),Store. YES,Index. ANALYZED)); |

æä― įåŊđčąĄč―ŽäļšDocumentåŊđčąĄå°ąåŊäŧĨčĒŦIndexWriteræ·ŧå å°įīĒåžåšäļäš:

| indexWriter. addDocument(Document); |

čŋæ ·,äļäļŠåŪæīįååŧšįīĒåžå°ąåŪæäš.

æ·ŧå įīĒåžįįŪįå°ąæŊäļšäšææãåŋŦæ·įæĨčŊĒ,äļIndexWriteråŊđåš,LuceneäļšæĨčŊĒæäūäšįļåšįAPI,org.apache.lucene.search.IndexSearcher,éčĶįŧåŪæåŪįīĒåžåšįįŪå―:

| Directory directory =  FSDirectory. open(new  File(" ./indexDir/ " )); |

| IndexSearcher indexSearcher =  new  IndexSearcher(directory); |

LuceneæŊæåĪį§æĨčŊĒæđåž,æåļļįĻįå°ąæŊQueryåŊđ蹥äš:

| /* * |

| *æäūåčŊåĻ |

|

*QueryParser:įĻäšč§ĢææĨčŊĒåįŽĶäļēįåĪįåĻįąŧ *įŽŽäšäļŠåæ°:åĻåŠäļŠFieldééĒæĨæū *Query.parse:éčĶč§ĢæįæĨčŊĒåįŽĶäļē |

| */ |

| Analyzer analyzer =  new  StandardAnalyzer(Version. LUCENE_30); |

| QueryParser queryParser =  new  QueryParser(Version. LUCENE_30," title " ,analyzer); |

| Query query =  queryParser. parse(" panpan " ); |

æäūåčŊåĻäļåŪčĶæģĻæ:ååŧšįīĒåžåšæķįåčŊåĻčĶåč§ĢææķįĻįåčŊåĻäļæ · . äļįķč§åäļäļæ ·,åĪįįå ģéŪčŊäđäļäļæ ·.åūįåŊč―æūäļå°įŧæ.åūå°QueryåŊđ蹥äđå,å°ąåŊäŧĨčŋčĄæĨčŊĒäš.čĶįĻå°IndexSearcherį search()æđæģ,čŋäļŠæđæģéčĶäļĪäļŠåæ°,įŽŽäļäļŠåæ°å°ąæŊQueryåŊđ蹥,įŽŽäšäļŠåæ°æŊéčĶæåŪčŋåååĪå°æĄįŧæ.įķåčŋåäļäļŠTopDocsåŊđ蹥, čŋåäļäļŠåŊđ蹥čäļæŊäļäļŠéåäđæŊåūåĨ―įč§Ģį,å äļšåĶææäŧŽæåŪäščŋåå100æĄįŧæ,åĶæįŧææŧæ°åĪ§äš100,æäŧŽå°ąæ æģįĨéæŧå ąæåĪå°æĄčŪ°å―,äđå°ąæ æģ åŪæåéĄĩ.æäŧĨčŋåäļäļŠåŊđ蹥,čŋäļŠåŊđ蹥å°čĢ äščŪ°å―įæŧæ°åįŽĶåæįīĒæĄäŧķįListéå:

| /* * |

| *åūå°TopDocsåŊđ蹥äđå,åŊäŧĨč·ååŪįæååétotalHitsåscoreDocs.čŋäļĪäļŠæååéįčŪŋéŪæéæŊpublicį,æäŧĨåŊäŧĨįīæĨčŪŋéŪ |

| */ |

| TopDocs topDocs =  indexSearcher. search(query, 100 ); |

| Integer count =  topDocs. totalHits; |

| ScoreDoc[] scoreDocs =  topDocs. scoreDocs; |

įķåéčŋåūŠįŊįæđåžæå°åšæĨ,äŧĨéŠčŊæææŊåĶæĢįĄŪ:

| /* * |

|

*äŧScoreDocåŊđ蹥ééĒåŊäŧĨč·åäļĪäļŠäļčĨŋ,åæ ·æŊpublicįčŪŋéŪæé: *score:įļå ģåšĶåūå,č·åĻå åŪđäļåšį°įæŽĄæ°æå ģ *doc:äŧäļéĒéĢäļŠæĩįĻåūäļåŊäŧĨåūįĨ,įīĒåžåšäŧåšįĻįĻåšéĢéæĨæķįæŊDocumentåŊđ蹥,æäŧĨčŋåįäđæŊDocumentåŊđ蹥. *DocumentUtils.docConvert():čŠå·ąåįå·Ĩå ·æđæģ,å äļšåūåĪå°æđé―čĶįĻå°åčūđįč―ŽæĒ |

| */ |

| List< Article>  list =  new  ArrayList(); |

| for (int  i =  0 ;i< scoreDocs. length ;i+ + ){ |

|     ScoreDoc scoreDoc =  scoreDocs[i]; |

| Â Â Â Â //æĩŪįđįąŧåįåūå |

|     float  score =  scoreDoc. score; |

|     int  docID =  scoreDoc. doc; |

|     Document document =  indexSearcher. doc(docID); |

|     list. add(DocumentUtils. docConvert(document, Article. class )); |

| } |

| System. out. println(" æŧå ąč·åäš "  +  count +  " æĄčŪ°å― " ); |

| for (Article a:  list){ |

| Â Â Â Â System. out. print(a. getId()Â + Â " Â Â Â Â Â Â Â Â " ); |

| Â Â Â Â System. out. print(a. getContent()Â + Â " Â Â Â Â Â Â Â Â " ); |

| Â Â Â Â System. out. println(a. getTitle()); |

| } |

æå·Ĩå ·æđæģäđæūäļæĨå§:

| /* * |

| *æäšäļčĨŋčŋæŊåæŧäš,å ķåŪåŪå ĻåŊäŧĨéčŋåå°æĨåŪæ,å―æķæēĄæčąåĪŠåĪæķéīįįŧæ |

| */ |

| public  static  < M,T>  T docConvert(M obj,Class< T>  clazz){ |

|     try  { |

|         T t =  clazz. newInstance(); |

|         if (t instanceof  Document){ |

|             Document doc =  (Document) t; |

|             Article article =  (Article) obj; |

|             doc. add(new  Field(" id " ,article. getId(). toString(),Store. YES,Index. ANALYZED)); |

|             doc. add(new  Field(" title " ,article. getTitle(),Store. YES,Index. ANALYZED)); |

|             doc. add(new  Field(" content " ,article. getContent(),Store. YES,Index. ANALYZED)); |

|             return  (T) doc; |

|         }else  if (t instanceof  Article){ |

|             Article article =  (Article) t; |

|             Document doc =  (Document) obj; |

| Â Â Â Â Â Â Â Â Â Â Â Â article. setId(Integer. parseInt(doc. get(" id " ))); |

| Â Â Â Â Â Â Â Â Â Â Â Â article. setContent(doc. get(" content " )); |

| Â Â Â Â Â Â Â Â Â Â Â Â article. setTitle(doc. get(" title " )); |

|             return  (T) article; |

| Â Â Â Â Â Â Â Â } |

|         return  null ; |

|     } catch  (Exception e) { |

|         throw  new  RuntimeException(e); |

| Â Â Â Â } |

| } |

åšæŽįååŧšåæĨčŊĒå°ąåŪæäš.æå įđéčĶæģĻæ:

- IndexWriteråIndexSearcherä―ŋįĻåŪå,čĶčŪ°åūč°įĻåŪäŧŽįclose()æđæģ

- įæŽå·äļåŪčĶéæĐå―åä―ŋįĻįįæŽ

- åĶæåĻååŧšįīĒåžæķéæĐStore.NO,å°äļäžåĻįīĒåžåšįæ°æŪäļæ·ŧå å åŪđ;éæĐIndex.NO,å°äļäžåĻįīĒåžåšäļåĒå įŪå―

- įŪå―ååčŊåĻé―čĶåđé ,äļįķæūäļå°įŧæ.æīåĨ―įååĨ―æŊåĻäļäļŠå·Ĩå ·įąŧäļåĢ°æäļšstatic,åå§åäļæŽĄå°ąčĄäš

æĨäļæĨččå éĪįīĒåž,äļšäŧäđäļæŊå æīæ°åĒ?å äļšå éĪäđæŊæīæ°įäļéĻå.čŋæŊéčĶįĻå°IndexWriterįąŧ,æäļĪį§æđåžåŊäŧĨå éĪ,įŽŽäļį§å°ąæŊä―ŋįĻTermįąŧ,įŽŽäšį§å°ąæŊå°æŧĄčķģæįīĒæĄäŧķįå éĪ:

| /* * Â |

| *TermįąŧäđæŊįĻæĨæįīĒį,æé å―æ°įæææŊ:åĻåŠäļŠFieldééĒæĨåŠäļŠå ģéŪčŊ |

| *įķåč°įĻIndexWriterįdeleteDocument()æđæģå éĪå åŦæåŪTermįDocument  |

| */ Â |

| IndexWriter indexWriter =  null ; |

| Term term =  new  Term(" title " ," panpan " ); |

indexWriter =

new

IndexWriter(Configuration.

directory,Configuration. analyzer,MaxFieldLength. LIMITED);Â |

| indexWriter. deleteDocuments(term);Â |

| Â |

åæĨå°ąæŊæīæ°,äļšäŧäđææīæ°æūåĻæå?å äļšæīæ°æä―éčĶčūéŦįäŧĢäŧ·,å äļšææĄĢäŋŪæđå,åģä―ŋæŊåūå°įäŋŪæđ,å°ąåŊč―äžé æææĄĢäļįåūåĪå

ģéŪčŊįä―į―Ūé―åįåå,čŋå°ąéčĶéĒįđįčŊŧååäŋŪæđčŪ°å―,čŋį§äŧĢäŧ·æŊįļå―éŦį.å æĪ,äļčŽäļčŋčĄįæĢįæīæ°æä―,čæŊä―ŋįĻ"å

å éĪ,åååŧš

"įįįĨäŧĢæŋæīæ°æä―:

| /* * |

|

*æåäļåĨčŊ,įļå―äš: indexWriter.deleteDocuments(term); indexWriter.addDocument(doc); å å éĪ,åååŧš! |

| */ |

| IndexWriter indexWriter =  null ; |

| Article article =  new  Article(); |

| article. setContent(" This  is  the  updated  content! " ); |

| article. setId(1 ); |

| article. setTitle(" panpan " ); |

| Term term =  new  Term(" id " ,article. getId(). toString()); |

indexWriter =

new

IndexWriter(Configuration.

directory,Configuration. analyzer,MaxFieldLength. LIMITED); |

| indexWriter. updateDocument(term, DocumentUtils. docConvert(article, Document. class )); |

Â

åš æŽįCURDå°ąå°æĪįŧæäš.ä―æŊæäšéŪéĒæēĄæč§Ģåģ,æŊåĶæįīĒæķäŧĨäļäŧĢį åŠč―åĻäļäļŠFieldééĒčŋčĄæįīĒ,åĶææčĶåĻtitleåcontentééĒåæķ čŋčĄæįīĒå°ąäļčĄ,æįīĒäļĪæŽĄ?åĪŠæ čäš.luceneå―įķæįļåšįč§Ģåģåæģ,æŊåĶä―ŋįĻQueryParserįå įąŧ:MultiFieldQueryParser.äŧčŋäļŠååå°ąįå°æŊäļįĻæĨååĪFieldæįīĒį:

| /* * |

| *æĨæķäļäļŠStringæ°įŧäđæŊåŊäŧĨįč§Ģį. |

| */ |

| String[] fields =  {" title " ," content " }; |

MultiFieldQueryParser queryParser =

new

MultiFieldQueryParser(Version. LUCENE_30,fields,Configuration. analyzer); |

| Query query =  queryParser. parse(" love " ); |

åĶæįĻåūŪįåŋå°ąåŊäŧĨæģĻæå°,įīĒåžåšįæäŧķäļæŊäļåąäļåį,cfsįąŧåįæäŧķåĻäļåįæč§åūå°åĒå ,čŋäļŠæäŧķåĪäšäŧĨå,äžå―ąåå°æįīĒįæį,å äļšåŪčĶæåžåĪäļŠæäŧķ,æäŧĨæäŧŽåčĶæģåæģčŪĐåŪååđķæäļäļŠæäŧķ:

| indexWriter. addDocument(DocumentUtils. docConvert(article, Document. class )); |

| indexWriter. optimize();Â |

čŋæŊæåĻäžåįæđæģ,IndexWriteråĻå ģéæķåäžčŠåĻč°įĻcommit()æđæģ,čŋäļŠæđæģäžæįīĒåžįæĢįåå°įĄŽįäļåŧ,äđå°ąæŊčŊīæŊäļæŽĄåŊđįīĒåžåščŋčĄæä―,é―äžįæäļäļŠįīĒåžæäŧķ.æåĻäžåæŊįŦäļåĪŠæđäūŋ,éĢæŊåĶæčŠåĻäžåįæä―åĒ?įæĄæŊčŊåŪį:

| indexWriter. addDocument(DocumentUtils. docConvert(article, Document. class )); |

| // æåĻäžå Â ååđķæäŧķ |

| // indexWriter.optimize(); |

| // čŠåĻäžå  ååđķæäŧķ |

| indexWriter. setMergeFactor(5 ); |

čŪūį―Ūååđķå ååģåŊ,čŋéåæäļĪįđéčĶæģĻæ:

- éŧčŪĪååđķå åäļš10,äđå°ąæŊčŊīcfsæäŧķčūūå°10äļŠ,Luceneå°ąäžčŠåĻååđķ

- čŪūį―Ūååđķå åįäŧĢį äļåŪčĶåĻæä―IndexWriterįæķåčŋčĄ,åđķäļæŊæŊäļæŽĄæä―įæķåé―čĶčŋčĄ,åŪéčĶäļåįåĪæ

æĨ įäļäļäļŠéŪéĒ,æīæ°įīĒåžåšåŪé äļå°ąæŊæīæ°įĄŽįäļįįŪå―,æŊæŽĄæīæ°æč ååŧšæ°įįīĒåžé―åŊđįĄŽįčŋčĄæä―,åĪ§åŪķčŊåŪé―įĨéæįäļéŦ,ä―æŊįīĒåžåšäļåŪæŊčĶæūåĻįĄŽį äļį,äļč―éįįĻåšįįŧæčįŧæ,éĢäđå°ąčĶæūäļŠæĒč―ååĻåĻįĄŽįäļ,åč―äŋčŊæįįæđæģ,æŊåĶįĻåšåŊåĻįæķåäŧįĄŽįå č――įīĒåžåš,čåäļåæä―é―æŊéåŊđå åäļ įįīĒåžåščŋčĄæä―,åĻįĻåšįŧæįæķåæå åäļįįīĒåžåšååĻåĻįĄŽįäļåŧ.čŋæ ·å°ąč―č§ĢåģčŋäļŠäļæŊéŪéĒįéŪéĒ:

| public  void  updateRAMIndex(){ |

| Â Â Â Â // RAMDirectoryæŊDirectoryįåįąŧ,å°åĻå ååšäŋįäļæŪĩįžå |

|     RAMDirectory ram =  null ; |

|     IndexWriter indexWriter =  null ; |

|     try  { |

| Â Â Â Â Â Â Â Â // å°æåŪįŪå―äļįįīĒåžå č――å°å åäļæĨ |

|         ram =  new  RAMDirectory(Configuration. directory); |

| Â Â Â Â Â Â Â Â // įŽŽäļäļŠåæ°åģåŪäščŋæŊäļäļŠæä―å åįīĒåžåšįIndexWriter |

indexWriter =

new

IndexWriter(ram,Configuration. analyzer,MaxFieldLength. LIMITED); |

| Â Â Â Â Â Â Â Â // æ·ŧå æ°įæ°æŪ |

|         Article article =  new  Article(45 ," panpan " ," love  you " ); |

|         indexWriter. addDocument(DocumentUtils. docConvert(article, Document. class )); |

|         /* *äļäļŠįīĒåžåšåŠč―æäļäļŠIndexWriter,äļäļåŊđåš. |

|          *  åæķ,åäļæķåŧåŠč―æäļäļŠIndexWriter,åĶææäļĪäļŠ,äļč―ååäļäļŠæäŧķ,äļįķå°ąæéŪéĒ  |

| Â Â Â Â Â Â Â Â Â */ |

| Â Â Â Â Â Â Â Â indexWriter. close(); |

| Â Â Â Â Â Â Â |

| Â Â Â Â Â Â Â Â /* *čŋäļŠIndexWriteræŊéåŊđæäŧķįģŧįŧį |

|          *  įŽŽäļäļŠåæ°æŊæ:     åĶææåŪäļštrueïžčĄĻįĪšéæ°ååŧšįīĒåžåšïžåĶæå·ēååĻïžå°ąå éĪååååŧš; |

|          *                  æåŪäļšfalseïžčĄĻįĪščŋ―å (éŧčŪĪåž) |

| Â Â Â Â Â Â Â Â Â * Â Â Â Â Â Â Â Â Â Â Â Â Â Â Â Â Â åĶæäļååĻïžå°ąæåžåļļ. |

| Â Â Â Â Â Â Â Â Â */ |

indexWriter =

new

IndexWriter(Configuration.

directory,Configuration. analyzer,true ,MaxFieldLength. LIMITED); |

| Â Â Â Â Â Â Â Â /* * |

| Â Â Â Â Â Â Â Â Â * Â å°æåŪįŪå―æ·ŧå å°æäŧķįģŧįŧäļ,åđķäļäļäžå |

|          *  åĶæäž å ĨäļäļŠIndexReader,åŊäŧĨčŋčĄäžå: |

|            IndexReader  indexReader  =  IndexReader.open(ram); |

| Â Â Â Â Â Â Â Â Â Â Â indexWriter.addIndexes(indexReader); |

| Â Â Â Â Â Â Â Â Â */ |

| Â Â Â Â Â Â Â Â indexWriter. addIndexesNoOptimize(ram); |

|     } catch  (Exception e) { |

|         throw  new  RuntimeException(e); |

| Â Â Â Â }finally { |

|         try  { |

| Â Â Â Â Â Â Â Â Â Â Â Â ram. close(); |

| Â Â Â Â Â Â Â Â Â Â Â Â indexWriter. close(); |

|         } catch  (Exception e) { |

|             throw  new  RuntimeException(e); |

| Â Â Â Â Â Â Â Â } |

| Â Â Â Â } |

| } |

- 2012-07-05 14:17

- æĩč§ 744

- čŊčŪš(0)

- åįąŧ:åžæšč―Ŋäŧķ

- æĨįæīåĪ

åčĄĻčŊčŪš

-

äļį§solræäšĪ(commit)įīĒåžįæđåž

2014-03-01 13:40 20923Â äļį§solræäšĪįīĒåžįæ ... -

solr buildįīĒåžæ§č―

2014-03-01 13:26 1537æĩčŊäŧĢį package mytest; impo ... -

Solræ§č―äžåäđfilterCache

2014-02-27 10:48 940åæïžSolræ§č―äžåäđfilterCache äŧäđæŊf ... -

SolrCoreæĨčŊĒčŋįĻæšį åæ

2014-02-12 15:37 1241äļ.įŊåĒåŊåĻäŧĢį SolrResourceLoader. ... -

éčŋčŪūį―ŪSolrInputDocument įboostæĨæđåææĄĢčŊå

2014-01-31 23:18 1542solréčŋå ģéŪåæĨčŊĒåįææĄĢåūåæåčĶäđäŧĨčŋäļŠboostå ... -

Solr ä―ŋįĻ Log4j

2014-01-25 21:31 2389åæåšåĪïžhttp://blog.chenlb.com/20 ... -

solråšæŽæĶåŋĩ

2014-01-25 20:49 1398åæ:http://www.solrtutorial.com ... -

solr loadæŊčūéŦ

2013-12-02 09:50 1063æčŋsolrįloadæŊčūéŦïžéčŋjstackæĨįïž å ... -

SolrįīĒåžæūå Ĩå å

2013-08-28 11:45 10021åĻäļæŽĄææŊįūĪäļïžäļåŽå°äļä―sinaįæķæåļïžäŧäŧŽæŊéįĻåšäšl ... -

solr buildįīĒåžéå°æ§åķåįŽĶįéčŊŊ

2013-08-23 15:12 617äŧåĪĐbuild solr įīĒåžéå°åĶäļéčŊŊïž Â åį°æ ... -

solr æīæ°indexįæä―ģåŪč·ĩ

2013-08-22 15:24 1011å ķäļéčĶäļįđæŊïžsolräļčŋčĄåđķåcommitã æåūįŋŧ ... -

Scaling SolrïžSolrįæĐåąïž

2013-08-21 20:55 695Solr įæĐåą (Scaling)  å―ä― įįīĒ ... -

Lucene Scoring čŊåæšåķ

2013-08-21 20:52 716Lucene čŊåä―įģŧ/æšåķï ... -

solr build indexäūå

2013-08-20 14:24 859p = PeopleDO({'userid':101,'s ... -

solr buildįīĒåžæķcommitäļoptimizeįæĶåŋĩ

2013-08-20 14:22 1930åĪ§åŪķé―įĨéïžsolråĻæäšĪįīĒåžįæķåæcommitåopt ... -

solr in action

2013-08-20 13:56 1232solr in actionįĩåäđĶ -

solrįå―æ°æĨčŊĒ_FunctionQuery_æŧįŧ

2012-12-21 15:55 4180ä―įĻ å―æ°æĨčŊĒįä―įĻïžæŊå―ąåčŪĄįŪscoreįįŪæģïžåđķäļæŋ ... -

solr javaåŪĒæ·įŦŊbuildįīĒåž

2012-12-17 17:08 1078package com.duitang.views.tes ... -

SolræįīĒįæåšæåč§å

2012-11-20 17:48 2441ä―ŋįĻSolræåŧšæįīĒåžæåūåŪđæïžä―æŊåĶä―åķåŪåįįæåč§å(b ... -

Solrj

2012-11-20 14:17 976solr įjavaåŪĒæ·įŦŊåŊæŊpythonåĪæäļäšïžčīīįđäŧĢį : ...

įļå ģæĻč

- **č°čŊäļįæ§**ïžåĐįĻæĨåŋčŪ°å―åæ§č―įæ§å·Ĩå ·åŊäŧĨåļŪåĐåžåč æīåĨ―å°įč§Ģåäžå Lucene įčŋčĄįķæã #### įĨčŊįđå ïžLucene įéŦįš§äļŧéĒ - **éŦįš§æįīĒææŊ**ïžå æŽåļå°æįīĒãæĻĄįģæįīĒãčŋäđčŊæįīĒįåĪį§éŦįš§æįīĒ...

ãLucene in ActionãįŽŽäšįæŊäļéĻå ĻéĒãåŪįĻäļæäšįč§Ģįæåïžæ čŪšä― æŊåæĨč§ĶLuceneįæ°æčŋæŊåŊŧæąčŋäļæĨæéŦįéŦįš§įĻæ·ïžé―č―äŧäļč·åūå·ĻåĪ§įäŧ·åžãéčŋæŽäđĶįåĶäđ ïžä― å°č―åĪææĄåĶä―ææå°åĐįĻLuceneæĨæŧĄčķģåį§...

ææĄĢåäŧĢčĄĻčĶįīĒåžįæ°æŪåå ïžåŊäŧĨæŊäļäļŠį―éĄĩãįĩåéŪäŧķææ°æŪåščŪ°å―ãåæŪĩæŊææĄĢįįŧæéĻåïžæŊåĶæ éĒãå åŪđįïžæŊäļŠåæŪĩåŊč―æäļåįåĪįæđåžãæŊčŊåæŊįīĒåžįåšæŽåå ïžéåļļæŊåčŊåįåčŊã æĨäļæĨïžæäŧŽčĶäšč§Ģ...

įķčïžåŊđäšæ°ææĨčŊīïžLuceneįAPIåŊč―äžæūåūčūäļšåĪæãčŋå°ąæŊLucene-SugaråæĨä―įĻįå°æđãåŪæŊäļäļŠéåŊđLuceneįč―ŧéįš§å čĢ åĻïžæĻåĻįŪåLuceneįåļļįĻæä―ïžæŊåĶįīĒåžæåŧšãæĨčŊĒæ§čĄåįŧæåĪįãéčŋåžå Ĩäļäšæđäūŋį...

åæķïžSpringįAOPįđæ§åŊäŧĨæđäūŋå°åŪį°æĨåŋčŪ°å―ãæéæ§åķįåč―ïžčå ķäšåĄįŪĄįåč―åįĄŪäŋäšæ°æŪåšæä―įäļčīæ§ã ååŪĒįģŧįŧįå ·ä―åŪį°åŊč―å æŽäŧĨäļå äļŠæĻĄåïž 1. įĻæ·æĻĄåïžįĻæ·æģĻåãįŧå―ãäļŠäššäŋĄæŊįŪĄįįïžéåļļäž...

2. å īčķĢéĐąåĻïžåĶæä― åŊđæäļŠéĒåįđåŦæå īčķĢïžæŊåĶæįīĒåžæææŊïžä― åŊäŧĨéæĐåĶLucenečŋæ ·įéĄđįŪïžéčŋåĶäđ åŪč·ĩæ·ąå Ĩįč§Ģå ķå·Ĩä―åįã 3. įæįææŊæ ïžéæĐä―ŋįĻä― įæįžįĻčŊčĻåææŊįéĄđįŪïžčŋå°ä―ŋä― æīåŪđæįč§ĢåčīĄįŪ...

- čŪšåæŋåčĄĻïžåŪäđäļåįčŪĻčŪšåšïžåĶâæ°æå ĨéĻâãâææŊčŪĻčŪšâįïžæŊäļŠæŋåæå ķIDååį§°ã - äļŧéĒčĄĻïžååĻįĻæ·įåļåïžå æŽäļŧéĒIDãååļäššIDãæŋåIDãäļŧéĒæ éĒãååļæķéīįå åŪđã - åļåå åŪđčĄĻïžå åŦåļåį...

8. **æĨåŋčŪ°å―äļéčŊŊåĪį**ïžäļšäšäūŋäšč°čŊåéŪéĒčŋ―čļŠïžįģŧįŧåŊč―äžæčŊĶįŧįæĨåŋčŪ°å―åč―ïžåđķåŪį°åžåļļåĪįæšåķã 9. **æ§č―äžå**ïžéčŋįžåįįĨãæ°æŪåšįīĒåžäžåãčīč――å襥įææŪĩæåįģŧįŧæ§č―ïžįĄŪäŋéŦåđķåčŪŋéŪæķį...

### JBoss Enterprise BRMS Platform-5-JBoss Rules 5 åčæå #### æĶčŋ° ...æ čŪšæŊåŊđäšæ°æčŋæŊæįŧéŠįįŪĄįåæĨčŊīïžčŋäŧ―æåé―æäūäšäļ°åŊįäŋĄæŊååŪįĻįæä―æåïžæŊčŋčĄBRMSéĄđįŪäļåŊæįžšįéčĶčĩæšã

3. **ææĄĢ(Document)**ïžææĄĢæŊååĻåĻįīĒåžäļįåšæŽæ°æŪåå ïžįąŧäžžäšæ°æŪåšäļįčŪ°å―ãææĄĢäŧĨ JSON æ žåžååĻïžåŊäŧĨå åŦåį§åæŪĩã 4. **įąŧå(Type)**ïžåĻčūæĐįæŽį Elasticsearch äļïžæŊäļŠįīĒåžåŊäŧĨæåĪäļŠįąŧåïžä―čŠ ...

8. æ§č―äžåïžSolr 7åĻæ§č―æđéĒčŋčĄäšäžåïžåĶéčŋä―ŋįĻLuceneåšįæ°įđæ§ïžæéŦäšæįīĒéåšĶåå åįŪĄįæįã 9. åŪå Ļæ§ïžSolr 7åžå ĨäšæīåĪįåŪå Ļįđæ§ïžåĶSolrCloudįåŪå ĻæäŧķïžæŊæåšæŽįčšŦäŧ―éŠčŊåæææšåķïžåĒåžšäš...

2. **čŪšåæŋåįŪĄį**ïžåŪäđčŪšåįäļååįąŧïžåĶææŊčŪĻčŪšãæ°æå ĨéĻįïžįĻæ·åŊäŧĨæ đæŪå īčķĢéæĐåäļãčŋéĻååŊč―æķåå°æ°æŪåščŪūčŪĄïžåĶMySQLïžįĻäšååĻæŋåäŋĄæŊã 3. **ååļäļååļ**ïžįĻæ·åŊäŧĨååŧšæ°äļŧéĒæååĪå·ēæåļå...

åŪå°æ°æŪåščĄĻæ å°äļšJavaįąŧïžčĄĻäļįčĄæ å°äļšįąŧįåŪäūïžåŪį°äšåŊđ蹥äļæ°æŪåščŪ°å―äđéīįéæč―ŽæĒã 2. **įæŽ5.2.8** Hibernate 5.2.8æŊčŊĨæĄæķįäļäļŠįĻģåŪįæŽïžäŋŪåĪäšäļäšå·ēįĨéŪéĒïžåĒåžšäšæ§č―ïžåđķæäūäšåŊđææ°Java...

SVNæŊäļį§éäļåžįįæŽæ§åķįģŧįŧïžč―åĪææįŪĄįéĄđįŪįååēįæŽååæīčŪ°å―ã #### äļãLuceneãNutchäļHadoopįéčĶæ§ åĻæįīĒåžæéĒåïž**Lucene**ã**Nutch**å**Hadoop**é―æŊéåļļéčĶįéĄđįŪåææŊãå ķäļïž - **...

čūå Ĩæäŧķäļšc:/mycert.cerïžč·åäļäļŠåĪįX.509čŊäđĶįčŊäđĶå·ĨåâĶâĶ Java+ajaxåįįŧå―åŪäū 1äļŠįŪæ æäŧķ å åŪđįīĒåž:Javaæšį ,ååĶåŪäū,ajax,įŧå― äļäļŠJava+ajaxåįįŧå―åŪäūïžéæJAVAæšæäŧķïžJAVAæ°ææååŊäŧĨåĶäđ äļäļ...