-

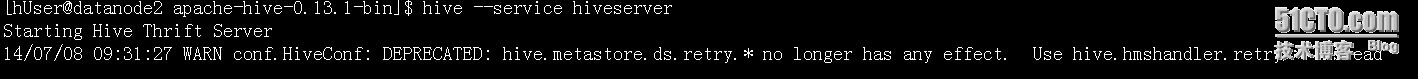

在hive上启动service

hive --service hiveserver

-

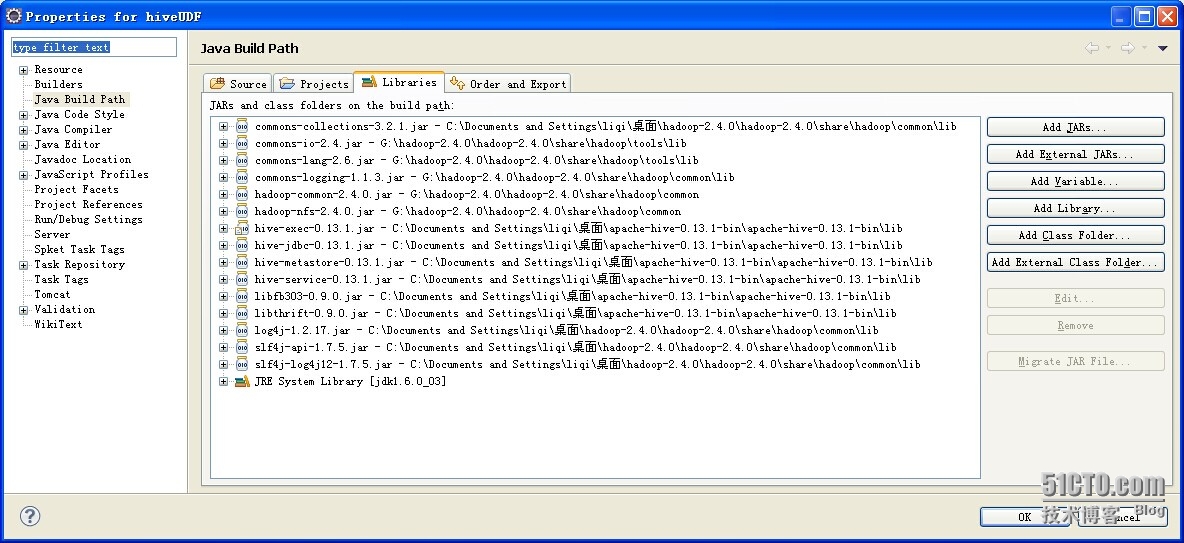

在eclipse中进行开发

导入需要的jar包(我这个导入的是udf和jdbc连接hive需要的jar包,基本是最简的了)

|

1

2

3

|

Connection con = new HiveJDBC().getConnection(

"jdbc:hive://192.168.192.138:10000/default", "", ""

);

|

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

|

package com.hive.jdbc;

import java.sql.Connection;

import java.sql.DriverManager;

import java.sql.ResultSet;

import java.sql.SQLException;

import java.sql.Statement;

/** * 连接hive

* @author liqi

*

*/

public class HiveJDBC {

public static final String driverName = "org.apache.hadoop.hive.jdbc.HiveDriver";

/**

* 获取连接

*/

public Connection getConnection(String url,String userName,String password){

try {

Class.forName(driverName);

Connection conn = DriverManager.getConnection(url, userName, password);

return conn;

} catch (ClassNotFoundException e) {

e.printStackTrace();

}catch (SQLException e) {

e.printStackTrace();

}

return null;

}

public static void main(String args[]){

Connection con = new HiveJDBC().getConnection(

"jdbc:hive://192.168.192.138:10000/default", "", ""

);

try {

Statement stmt = con.createStatement();

String sql = "show tables";

ResultSet res = stmt.executeQuery(sql);

while(res.next()) {

sql = "select * from " + res.getString(1);

System.out.println("tables:" + res.getString(1));

ResultSet resTable = stmt.executeQuery(sql);

while(resTable.next()){

System.out.println(resTable.getString(2));

}

}

} catch (SQLException e) {

e.printStackTrace();

}

}

} |

相关推荐

标题中的"jdbc连接hive数据库的驱动jar包"指的是Hive JDBC驱动的Java类库文件,通常是一个.jar文件,包含了所有必要的类和方法,使得Java应用程序能够建立到Hive服务器的连接,执行查询并获取结果。这个“jar包”...

在进行JDBC连接Hive时,理解Hadoop和Hive的体系结构、熟悉Java编程以及JDBC的工作原理至关重要。同时,根据具体的应用场景,合理配置和优化连接参数,可以极大地提高数据处理的效率和稳定性。在开发过程中,不断地...

下面将详细介绍如何使用JDBC连接Hive和Impala。 1. **JDBC连接Hive** Hive提供了一个名为Hive JDBC的驱动,它允许外部应用程序通过JDBC协议与Hive服务通信。要建立JDBC连接到Hive,你需要以下步骤: - **获取...

标题 "jdbc连接hive的jar包" 涉及的关键知识点主要集中在Hive的JDBC连接以及相关依赖的Java库上。Hive是一个基于Hadoop的数据仓库工具,它允许通过SQL查询语言(HQL)访问存储在Hadoop分布式文件系统(HDFS)中的...

标题中的“JDBC连接hive的jar”指的是Java应用程序通过Java Database Connectivity (JDBC) API来与Hadoop生态中的Hive数据仓库进行交互时所需的特定jar文件。Hive提供了一个基于SQL的接口,允许开发者以结构化的方式...

在Java中使用JDBC连接Hive,我们需要特定的驱动jar包来建立这种连接。 本压缩包文件"jdbc_hive_jar"包含了实现Java程序通过JDBC连接到Hive所需的所有jar包。这些jar包通常包含Hive JDBC驱动,它实现了与Hive服务器...

【jdbc连接Hive】 在大数据处理领域,Hive作为一个基于Hadoop的数据仓库工具,被广泛用于数据查询和分析。CDH(Cloudera Distribution Including Apache Hadoop)是Cloudera公司提供的一个完整的开源大数据平台,...

以上就是使用Java JDBC连接Hive数据库并执行基本操作的完整过程。通过这种方式,你可以构建更复杂的数据处理应用程序,如数据导入、ETL流程或数据分析任务。在实际项目中,为了提高性能和可维护性,可以考虑使用...

下面将详细介绍使用JDBC连接Hive所需的步骤和相关知识点。 1. **Hive JDBC驱动**: Hive JDBC驱动是连接Hive的桥梁,它实现了Java的JDBC接口,使得Java应用程序能够通过标准的JDBC API与Hive通信。在标题和描述中...

压缩包中包含Java通过JDBC连接Hive所需的jar包。包含有,antlr-runtime-3.0.1.jar;commons-logging-1.0.4.jar;hadoop-core-1.2.1.jar;hive-exec-0.10.0.jar;hive-jdbc-0.13.1.jar;hive-metastore-0.9.0.jar;hive-...

使用jdbc连接hive 里面提供了很多封装方法 .....................................................................

Hive JDBC连接是Java应用程序与Hive数据仓库进行交互的一种方式。它允许程序通过标准的JDBC接口查询和操作Hive中的数据。在使用Hive JDBC进行连接时,需要依赖一系列的jar包来确保所有必要的功能得以实现。下面将...

apache seatunnel支持hive jdbc

当我们在DataGrip中连接Hive时,需要确保正确配置了依赖的JAR包,以便驱动程序能够识别并连接到Hive服务器。下面我们将详细介绍这个过程。 1. **Hive驱动介绍** Hive提供了JDBC驱动,使得我们可以通过Java应用程序...

本篇将详细介绍如何在DBeaver和Java应用中使用JDBC连接Hive,以及涉及到的相关Jar包。 DBeaver是一款跨平台的数据库管理工具,支持多种数据库类型,包括Hive。要连接到Hive,我们需要在DBeaver中配置合适的JDBC驱动...

在描述中提到的"Hive1.2.1使用jdbc连接hive server2的所有jar包",意味着这个压缩包包含了所有必要的库文件,以确保在Hive 1.2.1版本下,能够成功建立并执行JDBC连接到HiveServer2。 要使用这些jar包,首先需要确保...

Hive JDBC是Apache Hive项目的一部分,它为Hive数据仓库提供了与Java数据库连接(JDBC)接口的兼容性。这使得开发人员能够使用标准的JDBC驱动程序来连接到Hive服务器,从而在各种应用程序中方便地进行大数据查询和...

使用JDBC连接Hive的基本步骤包括:加载驱动,创建连接,执行SQL,处理结果,最后关闭连接。以下是一个简单的示例代码: ```java Class.forName("org.apache.hive.jdbc.HiveDriver"); Connection conn = ...

本教程将深入讲解如何使用Hive JDBC在Java项目中建立与Hive的连接,并通过Maven来管理依赖。 首先,让我们了解Hive JDBC的基本概念。JDBC是Java中用于数据库访问的标准API,它定义了一组接口和类,使得开发者可以...

本篇文章将详细讲解如何通过Impala JDBC连接到Hive库,并介绍相关的POM配置。 首先,让我们理解JDBC。JDBC是Java中用于与各种数据库交互的一套标准API,它允许Java开发者使用SQL语句来操作数据库。对于Hive和Impala...