本文内容

- Web 负载均衡

- HTTP 重定向

- 反向代理

- IP 负载均衡

- DNS 负载均衡

- Web 系统缓存机制的建立和优化

- MySQL 数据库内部缓存

- 搭建多台 MySQL 数据库

- MySQL 数据库机器之间的数据同步

- 在 Web 服务器和数据库之间建立缓存

- 异地部署(地理分布式)

- 核心集中与节点分散

- 节点容灾和过载保护

当一个 Web 系统从日访问量10万逐步增长到1000万,甚至超过1亿的过程中,整个 Web 系统(无论是后端还是数据库端)承受的压力会越来越大,为了解决这些不同的性能压力问题,我们需要在 Web 系统的架构层面想办法。

Web负载均衡

Web 负载均衡(Load Balancing),简单地说就是采用适当的方式给服务器集群分配“工作”。

负载均衡的策略有很多。

1,HTTP 重定向

当用户发来请求的时候,Web 服务器通过修改 HTTP 响应头中的Location标记返回一个新的 URL,然后浏览器再继续请求这个新的 URL,这就是页面重定向。通过重定向达到“负载均衡”的目标。

例如,我们在下载 PHP 源码包的时候,点击下载链接时,为了解决不同国家和地域下载速度的问题,它会返回一个离我们近的下载地址。重定向的HTTP返回码是302,如下图:

如果使用 PHP 来实现这个功能,代码如下所示:

重定向很容易实现,而且可以自定义各种策略。但在大规模访问下,性能不佳,用户体验也不好,重定向会增加网络延时。

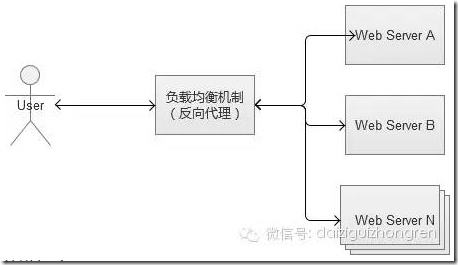

2,反向代理

反向代理的主要工作是转发 HTTP 请求,扮演了浏览器和后台 Web 服务器中转的角色。因为它工作在 HTTP 层(应用层),也就是网络七层结构中的第七层,因此也被称为“七层负载均衡”。可以做反向代理的软件很多,如 Nginx。

Nginx是一种非常灵活的反向代理服务,可以自由定制化转发策略,分配服务器流量的权重等。

反向代理中常见的一个问题,就是 Web 服务器存储的 session 数据,因为一般负载均衡的策略都是随机分配请求。同一个登录用户的请求,无法保证一定分配到相同的 Web 机器上,会导致无法找到session的问题。解决方案主要有两种:

-

配置反向代理的转发规则,让同一个用户的请求一定落到同一台机器上(通过分析 cookie),复杂的转发规则将会消耗更多的CPU,也增加了代理服务器的负担。

-

将 Session 这类的信息,专门用某个独立服务来存储,例如,redis、memchache,这个方案是比较推荐的。

反向代理服务,也是可以开启缓存,如果开启了,会增加反向代理的负担,需要谨慎使用。这种负载均衡策略实现和部署非常简单,而且性能表现也比较好。但它有“单点故障”的问题,而且,若后期继续增加 Web 服务器,它本身可能成为系统的瓶颈。

3,IP 负载均衡

IP 负载均衡是工作在网络层(修改IP)和传输层(修改端口,第四层),比起工作在应用层(第七层)性能要高出很多。其原理是,修改 IP 层数据包的 IP 地址和端口信息,达到负载均衡的目的。这种方式,也被称为“四层负载均衡”。常见的负载均衡方式,是 LVS(Linux Virtual Server,Linux 虚拟服务),通过 IPVS(IP Virtual Server,IP 虚拟服务)。

在负载均衡服务器收到客户端的IP包的时候,会修改IP包的目标IP地址或端口,然后原封不动地投递到内部网络中,数据包会流入到实际 Web 服务器。实际服务器处理完成后,又会将数据包投递回给负载均衡服务器,它再修改目标IP地址为用户IP地址,最终回到客户端。

上述的方式叫 LVS-NAT,除此之外,还有 LVS-RD(直接路由),LVS-TUN(IP 隧道),三者之间都属于 LVS 方式,但是有一定的区别,篇幅有限,不再敖述。

IP 负载均衡的性能要高出像 Nginx 这样反向代理服务很多,它只处理到传输层为止的数据包,并不做进一步的组包,然后直接转发给实际服务器。不过,它的配置和搭建比较复杂。

4,DNS 负载均衡

DNS(Domain Name System)负责域名解析的服务,域名 URL 实际上是服务器的别名,实际映射是一个 IP 地址,解析过程,就是 DNS 完成域名到IP的映射。而一个域名是可以配置成对应多个IP的。因此,DNS 也就可以作为负载均衡服务。

这种负载均衡策略,配置简单,性能极佳。但是,不能自由定义规则,而且,变更被映射的IP或者机器故障时很麻烦,还存在 DNS 生效延迟的问题。

5,DNS/GSLB 负载均衡

我们常用的CDN(Content Delivery Network,内容分发网络)实现方式,其实就是在同一个域名映射为多 IP 的基础上更进一步,通过 GSLB(Global Server Load Balance,全局负载均衡)按照指定规则映射域名的 IP。一般情况下都是按照地理位置,将离用户近的 IP 返回给用户,减少网络传输中的路由节点之间的跳跃消耗。

上图的“向上寻找”,实际过程是 LDNS(Local DNS)先向根域名服务(Root Name Server)获取到顶级根的 Name Server(例如.com的),然后得到指定域名的授权DNS,然后再获得实际服务器IP。

CDN 在 Web 系统中,一般情况下是用来解决较大静态资源(html/Js/Css/图片等)的加载问题,让这些资源尽可能离用户更近,提升用户体验。

例如,我访问了一张 imgcache.gtimg.cn 上的图片(腾讯的自建 CDN,不使用 qq.com 域名的原因是防止 HTTP 请求的时候,带上了多余的 cookie 信息),我获得的IP是183.60.217.90。

这种方式,和前面的DNS负载均衡一样,不仅性能极佳,而且支持配置多种策略。但搭建和维护成本非常高。一线互联网公司,会自建 CDN 服务,中小型公司一般使用第三方提供的 CDN。

Web 系统缓存机制的建立和优化

上面是如何优化 Web 系统的网络环境,接下来,我们开始关注 Web 系统自身的性能问题。随着 Web 站点访问量的上升,会遇到很多的挑战,解决这些问题不仅仅是扩容机器这么简单,建立和使用合适的缓存机制才是根本。

最开始,我们的 Web 系统架构可能是这样的,每个环节,只有一台机器。

1,MySQL 数据库内部缓存

MySQL 缓存机制,就先从 MySQL 内部开始,下面内容以 InnoDB 存储引擎为例。

1)建立恰当的索引

最简单的当然是建立索引,虽然成本还是有的。

- 首先,索引会占用一定的磁盘空间,其中组合索引产生的索引可能比实际数据还大;

- 其次,DML 操作(insert/update/delete)更新索引时比较耗时,好在我们以 select 操作居多。但索引对系统性能的作用还是相当大的(姑且不算大数据啊,如果数据相当庞大,那再高效的索引也白搭啊)。

2)数据库连接线程池缓存

如果每一个数据库请求都要创建和销毁连接的话,对数据库来说,无疑也是一种巨大的开销。为了减少开销,可以在 MySQL 中配置 thread_cache_size 表示保留多少线程用于复用。线程不够的时候,再创建,空闲过多的时候,则销毁。

还有更激进一点的做法,使用 pconnect(数据库长连接),线程一旦创建在很长时间内都保持着。但是,在访问量比较大,机器比较多的情况下,这种用法很可能会导致“数据库连接数耗尽”,因为建立连接并不回收,最终达到数据库的 max_connections(最大连接数)。因此,长连接的用法通常需要在 CGI 和 MySQL 之间实现一个“连接池”服务,控制 CGI 机器“盲目”创建连接数。

建立数据库连接池服务,有很多实现的方式,PHP 的话,推荐使用 swoole(PHP 一个网络通讯拓展)来实现。

3)Innodb 缓存设置(innodb_buffer_pool_size)

innodb_buffer_pool_size 用来保存索引和数据的内存缓存区,如果服务器是 MySQL 独占的,一般推荐为物理内存的 80%。在取表数据的场景中,它可以减少磁盘 IO。一般来说,这个值设置越大,cache 命中率会越高。

4)分库/分表/分区

MySQL 数据库表一般承受数据量在百万级别,再往上增长,各项性能将会出现大幅度下降,因此,当我们预见数据量会超过这个量级的时候,建议进行分库/分表/分区。

最好的做法,是服务在搭建之初就设计为分库分表的存储模式,从根本上杜绝中后期的风险。不过,会牺牲一些便利性,同时,也增加了维护的复杂度。不过,到了数据量千万级别或者以上的时候,这样做是值得的。

2,搭建多台 MySQL 数据库

一台 MySQL 机器,实际上是高风险的单点,因为如果它挂了,我们 Web 服务就不可用了。而且,随着 Web 系统访问量持续增加,总有一天,我们发现一台 MySQL 服务器无法支撑下去,我们开始需要使用更多的MySQL机器。当引入多台MySQL机器的时候,很多新的问题又将产生。

1)建立 MySQL 主从,从库作为备份

这种做法纯粹为了解决“单点故障”的问题,在主库出故障的时候,切换到从库。不过,这种做法有点浪费资源,因为从库实际上闲置的。

2)MySQL读写分离,主库写,从库读。

两台数据库,读写分离,主库负责写,从库负责读。如果主库发生故障,不影响读,也可以将全部读写都切换到从库(需要注意流量,可能会因为流量过大,把从库也拖垮)。

3)主主互备。

两台 MySQL 之间互为主从。这种方案,既做到了访问量的压力分流,同时也解决了“单点故障”问题。任何一台故障,都还有另外一套可供使用的服务。

不过,这种方案,只能用在两台机器的场景。如果业务拓展还是很快的话,可以选择将业务分离,建立多个主主互备。

3,MySQL 数据库机器之间的数据同步

每当我们解决一个问题,新的问题必然诞生。当我们有多台 MySQL,在业务高峰期,很可能出现两个库之间的数据有延迟的场景。而且网络和负载等也会影响数据同步的延迟。我们曾经遇到过,在日访问量接近1亿的场景下,出现,从库数据需要很多天才能同步追上主库的数据。这种场景下,从库基本失去效用了。因此,解决同步问题,是我们下一步关注点。

1)MySQL 自带多线程同步

MySQL 5.6 开始支持主库和从库数据同步,走多线程。但限制比较明显,只能以库为单位。MySQL 数据同步是通过 binlog 日志(5.0 前支持文本格式和二进制格式,5.0 后只支持二进制格式,因为二进制日志在性能、信息处理方面更有优势),主库写入到 binlog 日志的操作,是有顺序的,尤其当SQL操作中含有对于表结构的修改等操作,对于后续的SQL语句操作是有影响的。因此,从库同步数据,必须走单进程。

2)自己实现解析 binlog,多线程写入

以数据库的表为单位,解析 binlog 多张表同时做数据同步。这样做的话,的确能够加快数据同步的效率,但如果表和表之间存在结构关系或者数据依赖的话,则同样存在写入顺序的问题。这种方式,可用于一些比较稳定并且相对独立的数据表。国内一线互联网公司,大部分都是通过这种方式,来加快数据同步效率。

还有更为激进的做法,是直接解析 binlog,忽略以表为单位,直接写入。但是这种做法,实现复杂,使用范围就更受到限制,只能用于一些特殊场景(没有表结构变更,表和表之间没有数据依赖等特殊表)。

4,在 Web 服务器和数据库之间建立缓存

大访问量不能仅仅着眼于数据库层面,根据“二八定律”,80% 的请求只关注在 20% 的热点数据上。因此,我们应该在 Web 服务器和数据库之间建立的缓存机制。缓存可以用磁盘,也可以用内存。通过它们,将大部分的热点数据查询,阻挡在数据库之前。

1)页面静态化

用户访问网站的某个页面,页面上的大部分内容在很长一段时间内,可能都是没有变化的。例如新闻,一旦发布内容几乎不会被修改。这样,通过 CGI 生成的静态 html 页面缓存到 Web 服务器的本地磁盘(注意是本地磁盘,也就是缓存在 Web 服务器上)。除第一次,是通过动态 CGI 查询数据库获取之外,之后都直接将本地磁盘文件返回给用户。

在 Web 系统规模比较小的时候,这种做法还挺完美。可一旦 Web 系统规模变大,是个 Web 集群,例如,当有 100 台的 Web 服务器时,因为是缓存在本地磁盘,所以磁盘上将会有 100 份,浪费资源,维护性差。那用一台单独的服务器保存静态页面,不就得了,事实也的确如此,下面介绍。

缓存既可以用内存,也可以是磁盘,但内存的访问速度当然比磁盘快很多。

2)单台内存缓存

页面静态化,静态页面缓存在 Web 服务器本地磁盘或内存(实际上,通过PHP的apc拓展,可通过Key/value操作Web服务器的本机内存),不好维护,会带来更多问题。因此,利用一台单独的机器来搭建内存缓存服务。

内存缓存的选择,主要有 redis/memcache。性能上两者差别不大,但功能丰富程度上,Redis 更胜一筹。

3)内存缓存集群

单台内存缓存会面临单点故障的问题。简单的做法,是建立集群,增加一个 slave 作为备份机器。但是,如果请求量真的很多,cache 的命中率未必会高,因为,salve 不会接受请求,它只是一个备份而已,此时,不是增加给机器增加更多内存,而是需要建立一个集群。例如,redis cluster。

Redis cluster 集群内的 Redis 互为多组主从,同时每个节点都可以接受请求,在拓展集群的时候比较方便。客户端可以向任意一个节点发送请求,如果是它的“负责”的内容,则直接返回内容。否则,查找实际负责Redis节点,然后将地址告知客户端,客户端重新请求。

对于使用缓存服务的客户端来说,这一切是透明的。

内存缓存服务在切换的时候,是有一定风险的。从A集群切换到B集群的过程中,必须保证B集群提前做好“预热”(B集群的内存中的热点数据,应该尽量与A集群相同,否则,切换的一瞬间大量请求内容,在B集群的内存缓存中查找不到,流量直接冲击后端的数据库服务,很可能导致数据库宕机)。

4)减少数据库“写”

上面的机制,都试图减少数据库的“读”,但写操作也是一个大的压力。写操作,虽然无法减少,但可以通过合并请求来减轻压力。这个时候,我们就需要在内存缓存集群和数据库集群之间,建立一个修改同步机制。

先将修改请求生效在cache中,让外界查询显示正常,然后将这些 sql 修改放入到一个队列中存储起来,队列满或者每隔一段时间,合并为一个请求到数据库中更新数据库。

除了上述通过改变系统架构的方式提升写的性能外,MySQL 本身也可以通过配置参数 innodb_flush_log_at_trx_commit 来调整写入磁盘的策略。如果机器成本允许,从硬件层面解决问题,可以选择老一点的RAID(Redundant Arrays of independent Disks,磁盘列阵)或者比较新的SSD(Solid State Drives,固态硬盘)。

5)NoSQL存储

不管数据库的读还是写,当流量再进一步上涨,终会达到“人力有穷时”的场景。继续加机器的成本比较高,并且不一定可以真正解决问题。此时,部分核心数据,就可以考虑使用NoSQL的数据库。NoSQL 存储,大部分都是采用 key-value 方式。推荐使用 Redis,Redis 本身是一个内存 cache,同时也可以当做一个存储来使用,让它直接将数据落地到磁盘。

这样的话,我们就将数据库中某些被频繁读写的数据,分离出来,放在我们新搭建的Redis存储集群中,又进一步减轻原来MySQL数据库的压力,同时因为Redis本身是个内存级别的Cache,读写的性能都会大幅度提升。

国内一线互联网公司,架构上采用的解决方案很多是类似于上述方案,不过,使用的cache服务却不一定是Redis,他们会有更丰富的其他选择,甚至根据自身业务特点开发出自己的NoSQL服务。

6)空节点查询问题

当我们搭建完前面所说的全部服务,认为Web系统已经很强的时候。我们还是那句话,新的问题还是会来的。空节点查询,是指那些数据库中根本不存在的数据请求。例如,我请求查询一个不存在人员信息,系统会从各级缓存逐级查找,最后查到到数据库本身,然后才得出查找不到的结论,返回给前端。因为各级cache对它无效,这个请求是非常消耗系统资源的,而如果大量的空节点查询,是可以冲击到系统服务的。

在我曾经的工作经历中,曾深受其害。因此,为了维护 Web 系统的稳定性,设计适当的空节点过滤机制,非常有必要。

我们当时采用的方式,就是设计一张简单的记录映射表。将存在的记录存储起来,放入到一台内存 cache 中,这样,如果还有空节点查询,则在缓存这一层就被阻挡了。

异地部署(地理分布式)

完成了上述架构建设之后,我们的系统是否就已经足够强大了呢?答案当然是否定,优化是无极限的。Web 系统虽然表面上看,似乎比较强大了,但是给予用户的体验却不一定是最好的。因为东北的同学,访问深圳的一个网站服务,他还是会感到一些网络距离上的慢。这个时候,我们就需要做异地部署,让Web系统离用户更近。

1,核心集中与节点分散

有玩过大型网游的同学都会知道,网游是有很多个区的,一般都是按照地域来分,例如广东专区,北京专区。如果一个在广东的玩家,去北京专区玩,那么他会感觉明显比在广东专区卡。实际上,这些大区的名称就已经说明了,它的服务器所在地,所以,广东的玩家去连接地处北京的服务器,网络当然会比较慢。

当一个系统和服务足够大的时候,就必须开始考虑异地部署的问题了。让你的服务,尽可能离用户更近。我们前面已经提到了Web的静态资源,可以存放在CDN上,然后通过DNS/GSLB的方式,让静态资源的分散“全国各地”。但是,CDN只解决的静态资源的问题,没有解决后端庞大的系统服务还只集中在某个固定城市的问题。

这个时候,异地部署就开始了。异地部署一般遵循:核心集中,节点分散。

-

核心集中:实际部署过程中,总有一部分的数据和服务存在不可部署多套,或者部署多套成本巨大。而对于这些服务和数据,就仍然维持一套,而部署地点选择一个地域比较中心的地方,通过网络内部专线来和各个节点通讯。

-

节点分散:将一些服务部署为多套,分布在各个城市节点,让用户请求尽可能选择近的节点访问服务。

例如,我们选择在上海部署为核心节点,北京,深圳,武汉,上海为分散节点(上海自己本身也是一个分散节点)。我们的服务架构如图:

需要补充一下的是,上图中上海节点和核心节点是同处于一个机房的,其他分散节点各自独立机房。

国内有很多大型网游,都是大致遵循上述架构。它们会把数据量不大的用户核心账号等放在核心节点,而大部分的网游数据,例如装备、任务等数据和服务放在地区节点里。当然,核心节点和地域节点之间,也有缓存机制。

2,节点容灾和过载保护

节点容灾是指,某个节点如果发生故障时,我们需要建立一个机制去保证服务仍然可用。毫无疑问,这里比较常见的容灾方式,是切换到附近城市节点。假如系统的天津节点发生故障,那么我们就将网络流量切换到附近的北京节点上。考虑到负载均衡,可能需要同时将流量切换到附近的几个地域节点。另一方面,核心节点自身也是需要自己做好容灾和备份的,核心节点一旦故障,就会影响全国服务。

过载保护,指的是一个节点已经达到最大容量,无法继续接接受更多请求了,系统必须有一个保护的机制。一个服务已经满负载,还继续接受新的请求,结果很可能就是宕机,影响整个节点的服务,为了至少保障大部分用户的正常使用,过载保护是必要的。

解决过载保护,一般2个方向:

-

拒绝服务,检测到满负载之后,就不再接受新的连接请求。例如网游登入中的排队。

-

分流到其他节点。这种的话,系统实现更为复杂,又涉及到负载均衡的问题。

小结

Web系统会随着访问规模的增长,渐渐地从1台服务器可以满足需求,一直成长为“庞然大物”的大集群。而这个Web系统变大的过程,实际上就是我们解决问题的过程。在不同的阶段,解决不同的问题,而新的问题又诞生在旧的解决方案之上。

系统的优化是没有极限的,软件和系统架构也一直在快速发展,新的方案解决了老的问题,同时也带来新的挑战。

相关推荐

### 亿级Web系统搭建——单机到分布式集群 随着互联网技术的发展以及用户数量的急剧增加,Web系统面临着巨大的挑战。特别是当一个Web系统从日访问量10万逐步增长到1000万,甚至超过1亿的过程中,其面临的性能压力会...

自本期《问底》,徐汉彬将带大家开启异地跨集群分布式系统打造,本次关注的重点则是架构从单机到分布式集群的转变。徐汉彬曾在阿里巴巴和腾讯从事4年多的技术研发工作,负责过日请求量过亿的Web系统升级与重构,目前...

当一个Web系统从日访问量10万逐步增长到1000万,甚至超过1亿的过程中,Web系统承受的压力会越来越大,在这个过程中,我们会遇到很多的问题。为了解决这些性能压力带来问题,我们需要在Web系统架构层面搭建多个层次的...

刚刚我们讲完了Web系统的外部网络环境,现在我们开始关注我们Web系统自身的性能问题。我们的Web站点随着访问量的上升,会遇到很多的挑战,解决这些问题不仅仅是扩容机器这么简单,建立和使用合适的缓存机制才是根本...

本篇将详细介绍如何在本地计算机上搭建Hadoop的伪分布式集群环境,这非常适合初学者进行学习和测试。 首先,我们需要了解Hadoop的组成部分。Hadoop主要由两个核心组件构成:HDFS(Hadoop Distributed File System)...

4. **Hadoop完全分布式集群安装**:在多台机器上搭建真正的分布式集群,适用于大规模数据处理。 5. **Hadoop初始化**:格式化NameNode,为Hadoop集群做好准备。 6. **SSH免密登录配置**:通过SSH密钥对,实现集群内...

在当今的电商行业中,随着用户量和交易量的激增,传统的单机架构已经无法满足高并发和大数据量的处理需求,因此分布式集群架构成为了解决上述问题的关键技术之一。 SSM框架是JavaEE开发中非常流行的一种轻量级框架...

2. `.bash_profile`配置:通过编辑此文件设置系统级环境变量。 3. Spark环境变量:如SPARK_HOME、SPARK_MASTER_HOST、SPARK_MASTER_PORT等,它们定义了Spark的运行环境和配置。 4. Spark配置文件:如`spark-env.sh`...

总结来说,伪分布式Hadoop搭建是一个涉及环境配置、文件修改和服务启动的过程,它为开发者提供了一个在单机上模拟分布式计算的平台,便于学习和测试Hadoop的相关功能。通过这个过程,我们可以深入了解Hadoop的工作...

FastDFS是一种轻量级的开源分布式文件系统,主要用于解决大容量存储和负载均衡的问题。它在互联网行业中广泛应用于图片、视频等大文件的存储,因其高效、稳定、易用而备受青睐。本教程将详细讲解如何搭建FastDFS...

Zookeeper的主要作用是提供一种高效、可靠、可扩展的分布式系统协调机制,用于解决分布式系统中的许多挑战,如数据发布/订阅、负载均衡、命名服务、分布式协调/通知、集群管理、Master选举、分布式锁、分布式队列等...

RocketMQ是一款开源的消息中间件,由阿里巴巴开发并贡献给Apache基金会,它被广泛应用于分布式系统中的消息传递,提供高可用、高可靠的消息传输服务。在本压缩包中,你将找到搭建RocketMQ集群所需的全部资源,包括...

标题“Ubuntu 14.04.1 + Hadoop 2.4 完全分布式搭建要点”涉及到的是在Ubuntu 14.04.1操作系统上安装和配置Hadoop 2.4版本的过程,这是一个大数据处理框架,常用于分布式存储和计算任务。Hadoop的核心组件包括HDFS...

本文将详细介绍如何在单机环境下模拟搭建和管理WAS6.1ND集群。 首先,我们需要准备合适的环境。在这个场景中,我们有两台虚拟机,一台运行Windows Server 2003 SP2,另一台运行CentOS 5.2,它们都在主机Windows XP ...