分布式存储中的应用

在分布式存储系统中,将数据分布至多个节点的方式之一是使用哈希算法。假设初始节点数为 N,则传统的对 N 取模的映射方式存在一个问题在于:当节点增删,即 N 值变化时,整个哈希表(Hash Table)需要重新映射,这便意味着大部分数据需要在节点之间移动。

因此现在普遍使用的是被称为一致性哈希(Consistent Hashing)的一类算法。“一致性” 这个定语的意义在于:当增删节点时,只影响到与变动节点相邻的一个或两个节点,散列表的其他部分与原来保持一致。某种程度上可以将其理解为:一致性哈希算法的哈希函数与节点数 N 无关。

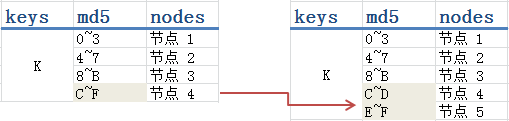

其他地方对一致性哈希配图的时候,都会选择一个圆环来解释,但我个人感觉哈希表更加直观:

上图左右分别表示增加一个 “节点 5” 前后的哈希表,哈希函数使用的是 md5 。md5 会根据 key 的值摘要出一个 128 bit 的哈希值(校验和),一般表示为一个 32 位的 16 进制数。这里我们取哈希值第一位的范围来将 key 映射到不同的节点,可以看到在拆分了 “节点 4” 的 md5 首位范围后,只需要将 “节点 4” 原本数据的约一半移动到 “节点 5” 上去就可以了,其他三个节点并未受到影响。

负载均衡改进

但这里其实仍有改进的空间。

问题在于,上面需要将 “节点 4” 的一半数据搬运到 “节点 5” 上,这个压力会比较大。以一个节点存有 3TB 的数据、节点间网络为千兆网(但只允许搬运进程使用 25% 负载)来算,搬运完 1.5TB 的数据最少需要 (1.5TB * 1024GB/TB * 1024MB/GB) / (125MB/s * 0.25) ≈ 14h;另一方面,“节点 5” 直接分担走了 “节点 4” 数据的一半,如果原来 4 个节点的负载是均衡的(md5 本身是一个很均匀的哈希函数),那么现在就变得不均衡了。

这两个问题有一个公共的解决方法:新增的 “节点 5” 不只从 “节点 4” 搬运数据,而从所有其他节点(或子集)处搬运数据,同时还要继续保持哈希一致性。

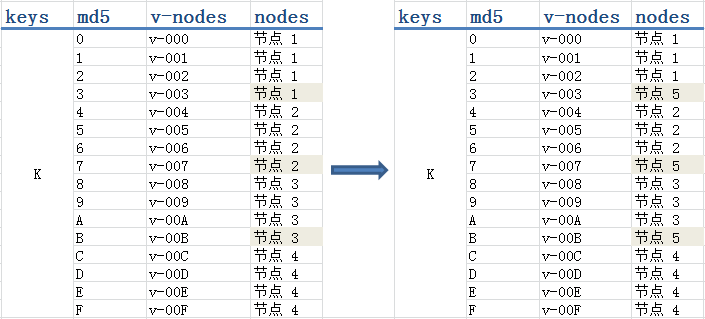

这种想法的一个实现方式就是,使用虚拟节点(virtual nodes)。上面 md5 哈希表实际可以分为两段:

- 通过 md5 将 key 哈希出一个 32 位的 16 进制哈希值

- 将这个哈希值映射到某个物理节点

当使用虚拟节点时,我们保持第一段不变,但会在第二段将哈希值映射到物理节点的过程中再插入一个虚拟节点中间件,从而将过程变为:

- 通过 md5 将 key 哈希出一个 32 位的 16 进制哈希值

- 将这个哈希值映射到一个虚拟节点

- 将这个虚拟节点映射到一个物理节点

新哈希表的关键之处在于虚拟节点的数量比物理节点数多得多,甚至很多时候会将虚拟节点的数量设置为 “尽可能多”。这样新哈希表的前两段就固定不变了,当增删物理节点时,只是对虚拟节点进行必要的重新分配的过程。

上图中我们依 md5 值的首位划分了 16 个虚拟节点,然后将它们映射到 4 个物理节点。(实际应用中,即使你当下只有 10 个物理节点,也大可以按 md5 的前三位划分出 4096 个虚拟节点)当我们增加物理 “节点 5” 的时候,就从节点 1、2、3 处各拿一个虚拟节点放到 “节点 5” 中。这个过程,“节点 5” 既可以使用 100% 的网络带宽来接收数据;新的哈希表也实现了负载均衡。当然一致性也得到了保证。

这种使用虚拟节点的一致性哈希算法我看到国内有人管它叫分布式一致性哈希(Distributed Consistent Hashing),但这个 “分布式” 叫法显得有些不合适,因为这种改进只涉及到算法的实现而与哈希过程发生的位置无关,并且 google 上也找不到这种叫法。所以一般就称改进的一致性哈希(Improved Consistent Hashing)好了。或者,使用虚拟节点的一致性哈希。

http://my.oschina.net/lionets/blog/288066

相关推荐

一致性哈希算法的工作流程如下: 1. 所有节点(包括服务器和数据)被哈希成一个唯一的值,并映射到一个闭合的哈希环上。 2. 当查找一个数据的存储位置时,同样对数据的键进行哈希,然后在哈希环上找到该键对应的点。...

一致性哈希算法通过将哈希值空间组织成一个虚拟的环状结构,使得每个存储节点仅负责环上的一段区域,从而有效减少了节点变化时的数据迁移量。然而,一致性哈希算法也存在一些问题,比如在节点数量较少时,节点间的...

在传统的哈希算法中,如果增加或减少服务器节点,会导致大量数据重新分配,而一致性哈希算法通过特殊的设计,使得节点的增减对整个系统的影响降到最低。在C#环境下实现一致性哈希,可以应用于如分布式缓存、负载均衡...

一致性哈希算法是一种在分布式系统中解决数据分片和负载均衡问题的算法,它主要解决了在动态添加或移除节点时,尽可能少地改变已经存在的数据分布。在云计算和大数据处理领域,一致性哈希被广泛应用,例如在分布式...

一致性哈希算法最初由麻省理工学院的K等人提出,并被广泛应用于分布式系统中,以解决节点动态变化时数据一致性问题。其核心思想是通过引入哈希环,将数据对象均匀分布在哈希环上的不同节点中,以此降低节点变更对...

总的来说,Ketama一致性哈希算法是分布式系统中解决数据分布问题的重要工具,通过巧妙的设计实现了在节点变化时尽可能少的数据迁移,提高了系统的稳定性和扩展性。通过深入理解并运用这种算法,我们可以构建更加健壮...

在一致性哈希算法中,首先将整个哈希空间组织成一个虚拟的圆环,通常使用模运算将所有可能的哈希值映射到这个圆环上。然后,每个服务器节点被分配到圆环上的一个或多个位置,这些位置由服务器的哈希值决定。同样,每...

为了进一步提高数据分布的均匀性和系统的灵活性,一致性哈希算法引入了虚拟节点的概念。虚拟节点本质上是物理节点的副本,但拥有唯一的标识符,这些标识符通过哈希函数映射到哈希环上。每个物理节点可以拥有一个或多...

在分布式缓存系统如Memcached或Redis中,一致性哈希算法被广泛使用。当用户请求数据时,根据数据的键进行哈希运算,然后在哈希环上找到最近的服务器节点来存储或检索数据。这种方式确保了数据与服务器之间的绑定关系...

本文针对这一问题,深入研究了一致性哈希算法在分布式数据库扩展中的应用,并提出了一种创新的扩展方法,旨在提高扩展效率,降低扩展成本,为大数据环境下的数据库管理带来新的优化方案。 一致性哈希算法最初由...

一致性哈希算法(Consistent Hashing)是一种在分布式系统中实现负载均衡的算法,尤其在分布式缓存如Memcached和Redis等场景下广泛使用。它解决了传统哈希算法在节点增减时导致的大量数据迁移问题,提高了系统的可用...

为了进一步提高负载均衡性和系统的容错能力,一致性哈希算法引入了虚拟节点的概念。每个物理节点可以在环上占据多个位置,即多个虚拟节点,这样即使部分物理节点失效,其他节点仍然可以承担更多的数据存储任务,提高...

分布式存储系统是一类将数据分布存储于多个物理节点上的系统,其设计目的是为了实现数据的可靠存储、高效访问和动态扩展...尽管存在一些需要改进的地方,但一致性哈希算法已经成为分布式系统领域研究和实践的重要基础。

一致性哈希算法(Consistent Hashing)是一种常用于分布式系统中的数据分片策略,它有效地解决了数据在多台服务器间均匀分布的问题,同时减少了因节点加入或离开时的数据迁移成本。 首先,一致性哈希的基本原理是将...

Mycat在处理大规模数据时,通过一致性哈希算法将数据均匀地分布到各个节点上,确保每个节点负责一部分数据,形成数据分片。当增加或减少节点时,一致性哈希可以保持数据分布的稳定性,降低对系统的影响。 三、Mycat...

总之,一致性哈希算法通过在环形空间中分配节点和对象,确保了动态变化时对系统影响最小,实现了高效的数据分布和负载均衡,是分布式缓存系统的重要组成部分。在面试中,理解并能详细解释一致性哈希的工作原理,对于...

一致性哈希分片算法是Mycat中的一种常用分片算法,它通过对数据的哈希值进行映射,来确定数据应该存储在哪个数据库节点中。这种算法具有良好的可扩展性和负载均衡性,能够满足大规模数据存储和高并发访问的需求。 ...

2. **一致性哈希算法**: - 一致性哈希解决了普通哈希扩容时大量元素移动的问题,特别适用于分布式系统中节点的动态增减。 - 哈希空间被组织成一个固定大小的环,每个节点分配到环上的一个或多个位置,负责其...

总的来说,Ketama一致性哈希算法通过引入虚拟节点的概念,有效解决了传统一致性哈希中的热点问题,使得在动态调整服务器数量时,数据分布的变动更加平滑,提高了分布式系统的稳定性和效率。在Java环境中,可以通过...