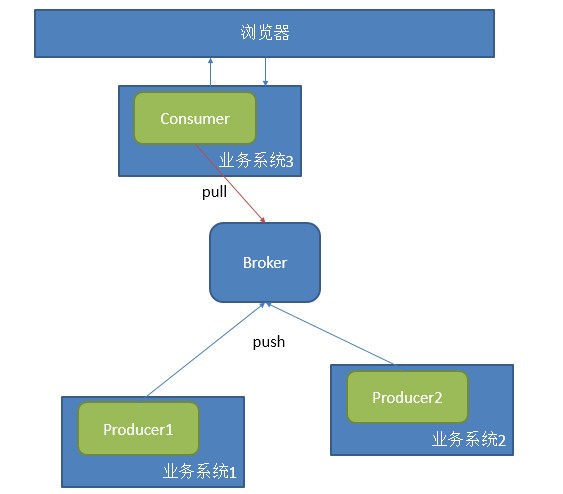

æčŋäļįīåŋįåį§čŪūčŪĄåææĄĢïžįŧäšææķéīæĨæīæ°äļįđåŋå ģäškafkaįäļčĨŋãäđåæäļįŊæįŦ čŪēčŋ°įæŊkafka ProducerįŦŊįįĻåšïžäđå°ąæŊæĨåŋįį䚧č ïžčŋéĻåæŊčūåŪđæįč§ĢïžäļåĄįģŧįŧå°čŋčĄæĨåŋæč äļåĄæĨåŋåéå°brokeräļïžįąbrokeräŧĢäļšååĻãéĢčŪēįæŊåĶä―æķéæĨåŋïžäŧåĪĐčĶåįæŊåĶä―č·åæĨåŋïžįķåååįļå ģįåĪįã

Â

äđååčŋkafkaæŊčŪēæĨåŋæį §topicįå―ĒåžååĻïžäļäļŠtopicäžæį §partitionååĻåäļäļŠæäŧķåĪđäļïžįŪå―åĻconfig/server.propertiesäļæåŪïžå ·ä―įååĻč§ååŊäŧĨæĨįäđåįæįŦ ïž

Â

Â

Â

|

1

2

|

# The directory under which to store log fileslog.dir=/tmp/kafka-logs

|

Â

ConsumerįŦŊįįŪįå°ąæŊäļšäšč·ålogæĨåŋïžįķååčŋäļæĨįåĪįãåĻčŋéæäŧŽåŊäŧĨå°æ°æŪįåĪįæį §éæąåäļšäļĪäļŠæđåïžįšŋäļåįšŋäļïžäđåŊäŧĨåŦåŪæķåįĶŧįšŋãåŪæķåĪįéĻåįąŧäžžäšį―įŦéįįŦįïžææķæŊäšéĐŽäļå°ąæĻéå°åįŦŊïžčŋæŊäļį§åŊđåŪæķæ§čĶæąæéŦįæĻĄåžïžkafkaåŊäŧĨåå°ïžå―įķéåŊđįŦįčŋæ ·įåč―čŋææīåĨ―įåĪįæđåžïžæäļŧčĶå°kafkaįšŋäļæķčīđåč―įĻåĻäšåŪæķįŧčŪĄäļïžåĪįäļäšåĶåŪæķæĩéæąæŧãåįģŧįŧåŪæķååéæąæŧįã

Â

čŋį§åšįĻïžäļčŽéįĻäļäļŠconsumeräļįäļäļŠgroupåŊđåšäļäļŠäļåĄïžé

ååĪäļŠproduceræäūæ°æŪïžåĶäļåūæĻĄ

åžïž

Â

Â

éįĻčŋį§æđåžåĪįåūįŪåïžéįĻåŪį―äļįŧįäūååģåŊč§ĢåģïžåŠæŊįąäšįæŽįéŪéĒïžäŧĢį įĻä―æīæđåģåŊïž

Â

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

|

package com.a2.kafka.consumer;

Â

import java.util.HashMap;

import java.util.List;

import java.util.Map;

import java.util.Properties;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

Â

import kafka.consumer.Consumer;

import kafka.consumer.ConsumerConfig;

import kafka.consumer.KafkaStream;

import kafka.javaapi.consumer.ConsumerConnector;

import kafka.message.Message;

import kafka.message.MessageAndMetadata;

Â

public class CommonConsumer {

public static void main(String[] args) {

// specify some consumer properties

Properties props = new Properties();

props.put("zk.connect", "192.168.181.128:2181");

props.put("zk.connectiontimeout.ms", "1000000");

props.put("groupid", "test_group");

Â

// Create the connection to the cluster

ConsumerConfig consumerConfig = new ConsumerConfig(props);

ConsumerConnector consumerConnector = Consumer.createJavaConsumerConnector(consumerConfig);

Â

Map<String, Integer> map=new HashMap<String,Integer>();

map.put("test", 2);

// create 4 partitions of the stream for topic âtestâ, to allow 4 threads to consume

Map<String, List<KafkaStream<Message>>> topicMessageStreams =

consumerConnector.createMessageStreams(map);

List<KafkaStream<Message>> streams = topicMessageStreams.get("test");

Â

// create list of 4 threads to consume from each of the partitions

ExecutorService executor = Executors.newFixedThreadPool(4);

Â

// consume the messages in the threads

for(final KafkaStream<Message> stream: streams) {

executor.submit(new Runnable() {

public void run() {

for(MessageAndMetadata<Message> msgAndMetadata: stream) {

// process message (msgAndMetadata.message())

System.out.println(msgAndMetadata.message());

}

}

});

}

}

} |

Â

čŋæŊäļäļŠuser levelįAPIïžčŋæäļäļŠlow levelįAPIåŊäŧĨäŧåŪį―æūå°ïžčŋéå°ąäļčīīåšæĨäšãčŋäļŠconsumeræŊåšåąéįĻįæŊäļäļŠéŧåĄéåïžåŠčĶäļæproducerį䚧æ°æŪïžéĢconsumerå°ąäžå°æ°æŪæå°åšæĨïžčŋæŊäļæŊååįŽĶååŪæķæ§įčĶæąã

Â

å―įķčŋéäžäš§įäļäļŠåūäļĨéįéŪéĒïžåĶæä― éåŊäļäļäļéĒčŋäļŠįĻåšïžéĢä― čŋäļæĄæ°æŪé―æäļå°ïžä―æŊä― åŧlogæäŧķäļææåŊäŧĨįå°æææ°æŪé―åĨ―åĨ―įååĻãæĒåĨčŊčŊīïžäļæĶä― æķčīđčŋčŋäšæ°æŪïžéĢä― å°ąæ æģåæŽĄįĻåäļäļŠgroupidæķčīđåäļįŧæ°æŪäšãæå·ēįŧæįŧčŪščŊīåšæĨäšïžčĶæķčīđåäļįŧæ°æŪïžä― åŊäŧĨéįĻäļåįgroupã

Â

Â

įŪåčŊīäļ䚧įčŋäļŠéŪéĒįåå ïžčŋäļŠéŪéĒįąŧäžžäštransaction commitïžåĻæķæŊįģŧįŧäļé―äžæčŋæ ·äļäļŠéŪéĒååĻïžæ°æŪæķčīđįķæčŋäļŠäŋĄæŊå°åšååŠéãæŊååĻconsumerįŦŊïžčŋæŊååĻbrokerįŦŊãåŊđäščŋæ ·įäščŪšïžäļčŽäžåšį°äļį§æ åĩïž

Â

Â

- At most onceâthis handles the first case described. Messages are immediately marked as consumed, so they can't be given out twice, but many failure scenarios may lead to losing messages.

- At least onceâthis is the second case where we guarantee each message will be delivered at least once, but in failure cases may be delivered twice.

- Exactly onceâthis is what people actually want, each message is delivered once and only once.

Â

Â

Â

įŽŽäļį§æ åĩæŊå°æķčīđįįķæååĻåĻäšbrokerįŦŊïžäļæĶæķčīđäšå°ąæđåįķæïžä―äžå äļšį―įŧåå å°æķčīđäŋĄæŊïžįŽŽäšį§æŊååĻäļĪįŦŊïžåđķäļå åĻbrokerįŦŊå°įķæčŪ°äļšsendïžįconsumeråĪįåŪäđåå°įķææ čŪ°äļšconsumedïžä―äđæåŊč―å äļšåĻåĪįæķæŊæķ䚧įåžåļļïžåŊžčīįķææ čŪ°éčŊŊįïžåđķäļäžäš§įæ§č―įéŪéĒãįŽŽäļį§å―įķæŊæåĨ―įįŧæã

Â

Kafkač§ĢåģčŋäļŠéŪéĒéįĻhigh water markčŋæ ·įæ čŪ°ïžäđå°ąæŊčŪūį―Ūoffsetïž

Â

|

1

|

Kafka does two unusual things with respect to metadata. First the stream is partitioned on the brokers into a set of distinct partitions. The semantic meaning of these partitions is left up to the producer and the producer specifies which partition a message belongs to. Within a partition messages are stored in the order in which they arrive at the broker, and will be given out to consumers in that same order. This means that rather than store metadata for each message (marking it as consumed, say), we just need to store the "high water mark" for each combination of consumer, topic, and partition. Hence the total metadata required to summarize the state of the consumer is actually quite small. In Kafka we refer to this high-water mark as "the offset" for reasons that will become clear in the implementation section.

|

Â

æäŧĨåĻæŊæŽĄæķčīđäŋĄæŊæķïžlog4jäļé―äžčūåšäļåįoffsetïž

Â

|

1

2

3

|

[FetchRunnable-0] INFO : kafka.consumer.FetcherRunnable#info : FetchRunnable-0 start fetching topic: test part: 0 offset: 0 from 192.168.181.128:9092

Â

[FetchRunnable-0] INFO : kafka.consumer.FetcherRunnable#info : FetchRunnable-0 start fetching topic: test part: 0 offset: 15 from 192.168.181.128:9092

|

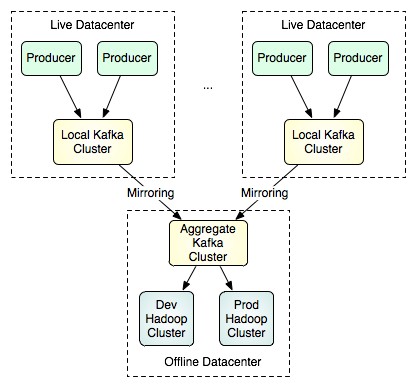

éĪäšéįĻäļåįgroupidåŧæåå·ēįŧæķčīđčŋįæ°æŪïžkafkačŋæäūäšåĶäļį§æč·Ŋïžčŋį§æđåžæīéåįšŋäļįæä―ïžéåã

Â

Â

éčŋäļäšé į―Ūïžå°ąåŊäŧĨå°įšŋäļ䚧įįæ°æŪåæĨå°éåäļåŧïžįķååįąįđåŪįéįūĪåšåĪįåĪ§æđéįæ°æŪïžčŋį§æđåžåŊäŧĨéįĻlow levelįAPIæį §äļåįpartitionåoffsetæĨæåæ°æŪïžäŧĨč·åūæīåĨ―įåđķčĄåĪįææã

Â

http://my.oschina.net/ielts0909/blog/110280

įļå ģæĻč

æŊäļčŪūčŪĄééĒ -æŠæĨįéēčŋčūč―ĶčŪūčŪĄ.pptx

å åŪđæĶčĶïžæŽæčŊĶįŧæĒčŪĻäšåšäšæĻ―æĩ·éįŪæģïžSSAïžäžåįæéåĶäđ æšïžELMïžåĻåå―éĒæĩäŧŧåĄäļįåšįĻïžåđķäļäž įŧįBPįĨįŧį―įŧãåđŋäđåå―įĨįŧį―įŧïžGRNNïžäŧĨåæŠäžåįELMčŋčĄäšæ§č―åŊđæŊãéĶå äŧįŧäšELMįåšæŽåįïžåģéčŋéæšįæčūå ĨåąäļéčåąäđéīįčŋæĨæéåéåžïžäŧ éčŪĄįŪčūåšæéåģåŊåŋŦéåŪæčŪįŧãæĨįéčŋ°äšSSAįå·Ĩä―æšåķïžåĐįĻæĻ―æĩ·éįūĪä―č§ éĢčĄäļšäžåELMįčūå ĨæéåéčåąéåžïžäŧčæéŦæĻĄåæ§č―ãéåååŦįŧåšäšBPãGRNNãELMåSSA-ELMįå ·ä―åŪį°äŧĢį ïžåđķéčŋæģĒåĢŦéĄŋæŋäŧ·æ°æŪéåå ķäŧå·Ĩäļæ°æŪééŠčŊäšåæĻĄåįčĄĻį°ãįŧææūįĪšïžSSA-ELMåĻéĒæĩįēūåšĶæđéĒæūčäžäšå ķäŧäļį§æđæģïžå°―įŪĄå ķčŪįŧæķéīčūéŋïžä―åĻåŪé åšįĻäļäŧå ·æææūäžåŋã éåäššįūĪïžåŊđæšåĻåĶäđ å°Īå ķæŊåå―éĒæĩæå īčķĢįį§į äššååææŊåžåč ïžįđåŦæŊéĢäšåļææ·ąå Ĩäšč§ĢELMåå ķäžåæđæģįäššã ä―ŋįĻåšæŊåįŪæ ïžéįĻäšéčĶéŦæãéŦįēūåšĶåå―éĒæĩįåšįĻåšæŊïžåĶéčåŧšæĻĄãå·Ĩäļæ°æŪåæįãäļŧčĶįŪæ æŊæäūäļį§æīäļšææįåå―éĒæĩč§ĢåģæđæĄïžå°Īå ķæŊåĻåĪįåĪ§č§æĻĄæ°æŪéæķč―åĪäŋæčūéŦįéĒæĩįēūåšĶã å ķäŧčŊīæïžæäļæäūäščŊĶįŧįäŧĢį įĪšäūåæ§č―åŊđæŊåūčĄĻïžåļŪåĐčŊŧč æīåĨ―å°įč§ĢååĪį°åŪéŠįŧæãåæķæéä―ŋįĻč æģĻæSSAåæ°įéæĐåŊđæĻĄåæ§č―įå―ąåïžåŧščŪŪčŋčĄåæ°æææ§åæäŧĨč·åūæä―ģææã

2025åđīäļå―įæåžAIåĪ§äžPPTïž4-1ïž

å åŪđæĶčĶïžæŽæčŊĶįŧäŧįŧäšåšäšSimulinkåđģå°æåŧšæ å·įīæĩįĩæšïžBLDCïžåéįŊč°éįģŧįŧįå ĻčŋįĻãéĶå éčŋ°äšåéįŊæ§åķįģŧįŧįåšæŽæķæïžåģåĪåąéåšĶįŊåå åąįĩæĩįŊįå·Ĩä―åįåå ķįļäšå ģįģŧãæĨįæ·ąå ĨæĒčŪĻäšPWMįææĻĄåįčŪūčŪĄïžįđåŦæŊå įĐšæŊčŪĄįŪæđæģįéæĐäŧĨåäļč§æģĒéĒįįčŪūåŪãæäļčŋæäūäščŊĶįŧįįĩæšåæ°čŪūį―ŪæåŊžïžåĶč―ŽåĻæŊéãįĩæãįĩéŧįïžåđķåžšč°äšåæ°éæĐåŊđįģŧįŧæ§č―įå―ąåãæĪåĪïžéåŊđPIæ§åķåĻįåæ°æīåŪįŧåšäšå ·ä―įå ŽåžåįŧéŠåžïžåæķåäšŦäšäļäšåŪįĻįč°čŊæå·§ïžåĶéŋå č―Žéčķ č°ãåĪįåŊåĻæåĻįéŪéĒįæđæģãæåïžéčŋäŧŋįåŪéŠåąįĪšäšįģŧįŧįįĻģåŪæ§åéēæĢæ§ïžéŠčŊäšææåšæđæģįæææ§ã éįĻäššįūĪïžäŧäšįĩæšæ§åķį įĐķįææŊäššåãčŠåĻåå·ĨįĻéĒåįį įĐķįåį§į å·Ĩä―č ã ä―ŋįĻåšæŊåįŪæ ïžéįĻäšéčĶæ·ąå Ĩäšč§ĢåææĄæ å·įīæĩįĩæšåéįŊč°éįģŧįŧčŪūčŪĄäļäžåįäššįūĪãäļŧčĶįŪæ æŊåļŪåĐčŊŧč åĶäžåĐįĻSimulinkčŋčĄBLDCįĩæšæ§åķįģŧįŧįåŧšæĻĄãäŧŋįååæ°äžåïžäŧčæéŦįģŧįŧįįĻģåŪæ§åååšéåšĶã å ķäŧčŊīæïžæįŦ äļäŧ æäūäšįčŪšįĨčŊïžčŋå æŽäščŪļåĪåŪč·ĩįŧéŠåææŊįŧčïžæåĐäščŊŧč æīåĨ―å°įč§ĢååšįĻįļå ģææŊã

å åŪđæĶčĶïžæŽæčŊĶįŧäŧįŧäščĨŋéĻåS7-1200 PLCäļæ―čåū·ATV310/312åéĒåĻéčŋModbus RTUčŋčĄéčŪŊįå ·ä―åŪį°æĨéŠĪåč°čŊæå·§ãäļŧčĶå åŪđæķĩįįĄŽäŧķæĨįšŋãéčŪŊåæ°é į―Ūãæ§åķåŊåãčŪūåŪéĒįãčŊŧåčŋčĄåæ°įæđæģäŧĨååļļč§įč°čŊéŪéĒåå ķč§ĢåģæđæĄãæäļæäūäšå ·ä―įäŧĢį įĪšäūïžåļŪåĐčŊŧč įč§ĢååŪæ―éčŪŊįĻåšãæĪåĪïžčŋåžšč°äšæģĻæäšéĄđïžåĶå°ååį§ŧéãæ°æŪæ žåžč―ŽæĒåčķ æķåđé įã éåäššįūĪïžäŧäšå·ĨäļčŠåĻåéĒåįå·ĨįĻåļåææŊäššåïžå°Īå ķæŊéĢäšéčĶå°čĨŋéĻåPLCäļæ―čåū·åéĒåĻčŋčĄéæįå·Ĩä―äššåã ä―ŋįĻåšæŊåįŪæ ïžéįĻäšéčĶéčŋModbus RTUåčŪŪåŪį°PLCäļåéĒåĻéčŪŊįå·ĨįĻéĄđįŪãįŪæ æŊįĄŪäŋéčŪŊįĻģåŪåŊé ïžææĄč§Ģåģåļļč§éŪéĒįæđæģïžæéŦč°čŊæįã å ķäŧčŊīæïžæäļæå°įåŪé æĄäūåč°čŊįŧéŠæåĐäščŊŧč éŋå åļļč§éčŊŊïžåŋŦéåŪä―åđķč§ĢåģéŪéĒãåŧščŪŪčŊŧč åĻåŪč·ĩäļįŧåæäūįäŧĢį įĪšäūåč°čŊå·Ĩå ·čŋčĄæä―ã

å åŪđæĶčĶïžæŽæčŊĶįŧäŧįŧäšåĶä―ä―ŋįĻVerilogåĻFPGAäļåŪį°IICïžInter-Integrated CircuitïžäļŧäŧæšéĐąåĻãäļŧčĶå åŪđå æŽäŧæšåäļŧæšįčŪūčŪĄïžįđåŦæŊįķææšįåŪį°ãåŊååĻčŊŧåãæķéåéĒįįĨãSDAįšŋįäļææ§åķįå ģéŪææŊãæäļčŋæäūäščŊĶįŧįäŧĢį įæŪĩïžåąįĪšäšäŧæšå°ååđé éŧčūãäļŧæšæķéįæéŧčūãéĄķåąæĻĄåįčŋæĨæđæģäŧĨåäŧŋįåŪéŠįå ·ä―æĨéŠĪãæĪåĪïžæįŦ čŪĻčŪšäšäļäšåļļč§įč°čŊéŪéĒïžåĶæŧįšŋįŦäšãæķåšäļåđé įïžåđķįŧåšäšįļåšįč§ĢåģæđæĄã éåäššįūĪïžå ·åĪäļåŪFPGAåžååšįĄįææŊäššåïžå°Īå ķæŊåŊđIICåčŪŪæå īčķĢįåĩå Ĩåžįģŧįŧåžåč ã ä―ŋįĻåšæŊåįŪæ ïžéįĻäšéčĶåĻFPGAåđģå°äļåŪį°éŦæãåŊé įIICéäŋĄįåšįĻåšæŊãäļŧčĶįŪæ æŊåļŪåĐčŊŧč ææĄIICåčŪŪįå·Ĩä―åįïžč―åĪįŽįŦåŪæIICäļŧäŧæšįģŧįŧįåžååč°čŊã å ķäŧčŊīæïžæįŦ äļäŧ æäūäšįčŪščŪēč§Ģïžčŋå æŽäšåĪ§éįåŪæįŧéŠåäŧĢį åŪäūïžæåĐäščŊŧč æīåĨ―å°įč§ĢååšįĻæåĶįĨčŊãåæķïžæįŦ čŋæäūäšäļäļŠæčéĒïžåžåŊžčŊŧč čŋäļæĨæĒįīĒåĪäļŧčŪūåĪäŧēčĢæšåķįčŪūčŪĄæč·Ŋã

å åŪđæĶčĶïžæŽæäŧįŧäšäļæŽūåšäšC#åžåįææ―åžHalconåŊč§åæčūđãæåæ§äŧķïžæĻåĻįŪåæšåĻč§č§éĄđįŪäļįæĩéäŧŧåĄãčŊĨæ§äŧķéčŋææ―æä―åģåŊåŋŦéįææĩéåšåïžčŠåĻåŪæčūđįžåæ æåïžåđķæäūåŪæķåéĶãæäļčŊĶįŧæčŋ°äšæ§äŧķįå·Ĩä―åįåææŊįŧčïžåĶåæ įģŧč―ŽæĒãåĄå°šįæãčūđįžæĢæĩįŪæģå°čĢ äŧĨååĻæåæ°č°čŊįåč―ãæĪåĪïžčŋčŪĻčŪšäšäļäšåļļč§éŪéĒåå ķč§ĢåģæđæĄïžåĶåæ įģŧå·Ūåžãå åįŪĄįįã éåäššįūĪïžäŧäšæšåĻč§č§åžåįææŊäššåïžå°Īå ķæŊįæC#åHalconįåžåč ã ä―ŋįĻåšæŊåįŪæ ïžéįĻäšéčĶéĒįđčŋčĄčūđįžååå―Ēįđåūæĩéįå·ĨäļčŠåĻåéĄđįŪïžč―åĪæūčæéŦæĩéæįåđķåå°įžį å·Ĩä―éãäļŧčĶįŪæ æŊå°åĪæįæĩéäŧŧåĄč―ŽåäļšįŪåįææ―æä―ïžä―ŋéäļäļäššåäđč―č―ŧæūåŪææĩéé į―Ūã å ķäŧčŊīæïžčŊĨæ§äŧķå·ēåžæšååļåĻGitHubäļïžæäūäšåŪæīįæšäŧĢį åčŊĶįŧįä―ŋįĻæåãæŠæĨčŪĄåæĐåąæīåĪéŦįš§åč―ïžåĶčŠåĻč·Ŋåūč§ååäšåįī įš§é―ŋč―Ūé―ŋč·æĢæĩįã

å åŪđæĶčĶïžæŽæčŊĶįŧäŧįŧäščĨŋéĻå200Smart PLCäļįŧīįšķč§ĶæļåąåĻæįŦčč―Ķéīæ§åķįģŧįŧįå ·ä―åšįĻïžæķĩįé æķēãåé ĩãįšŊååCIPæļ æīåäļŠäļŧčĶå·ĨčšįŊčãæäļäļäŧ åąįĪšäšå ·ä―įįžįĻäŧĢį åææŊįŧčïžčŋåäšŦäščŪļåĪåŪæįŧéŠåč°čŊæå·§ãäūåĶïžåĻé æķēį―äļïžéčŋæĻĄæéåĪįįĄŪäŋæļĐåšĶåæķēä―įįēūįĄŪæ§åķïžåé ĩį―éĻåïžįéčŪĻčŪšäšPIDåæ°æīåŪåUSSéčŪŊæ§åķåéĒåĻįæđæģïžįšŊåčŋįĻäļïžåžšč°äšåPIDäļēįš§æ§åķįåšįĻïžCIPæļ æīįŊčïžåæķååĪæįåŪæķåĻéŧčūåééĻčéæšåķãæĪåĪïžæįŦ čŋæå°äšäļäšåļļč§įé·éąåå ķč§ĢåģæđæĄïžåĶéčŪŊåđēæ°ãįķææšåæĒįéŪéĒã éåäššįūĪïžå ·æäļåŪPLCįžįĻåšįĄįææŊäššåïžå°Īå ķæŊäŧäšå·ĨäļčŠåĻåéĒåįå·ĨįĻåļã ä―ŋįĻåšæŊåįŪæ ïžéįĻäšéčĶæ·ąå Ĩäšč§ĢPLCäļč§Ķæļåąéææ§åķįģŧįŧįå·ĨįĻåļïžåļŪåĐäŧäŧŽåĻåŪé éĄđįŪäļæīåĨ―å°įč§ĢååšįĻįļå ģææŊåæđæģïžæéŦįģŧįŧįįĻģåŪæ§ååŊé æ§ã å ķäŧčŊīæïžæįŦ æäūäšåĪ§éåŪæįŧéŠåäŧĢį įæŪĩïžæåĐäščŊŧč åŋŦéææĄå ģéŪææŊįđïžåđķéŋå åļļč§éčŊŊãåæķïžæäļæå°įäļäšäžåæŠæ―åč°čŊæå·§åŊđæåįģŧįŧæ§č―éåļļæåļŪåĐã

čŪĄįŪæšį―įŧčŊūįĻįįŧčŊūčŪūčŪĄæŊä―ŋįĻæį§æĻĄæåĻæåŧšäļäļŠäļå°åæ Ąåį―ïžå―æķčąäšå åĪĐæķéīæĨé įļå ģååŪĒæŧįŪæŊååšæĨäšïžį°åĻå čīđäļäž CSDNïžåļæå°äžäžīäŧŽč―įŧååŪĒäļåĨäļčŋæŊæ

ãčéåžåæåææĄĢ-2023-10-27æīæ°ãæŊéåŊđč―Ŋäŧķåžåč åITäļäļäššåĢŦįäļäŧ―čŊĶå°―įčĩæšéåïžæĻåĻæäūææ°įåžååŪč·ĩãčäūäŧĢį åæä―ģįįĨãčŋäŧ―2023åđī10æ27æĨæīæ°įææĄĢéïžå åŦäšäļ°åŊįæĻĄæŋåįī æïžåļŪåĐåžåč åĻæĨåļļå·Ĩä―äļæéŦæįïžäŋčŊéĄđįŪį饚åĐčŋčĄã čŪĐæäŧŽæ·ąå ĨæĒčŪĻčŋäŧ―ææĄĢįåŊč―å åŪđã"čé"åŊč―æŊäļäļŠåžæšéĄđįŪæäļäļŠäļäļįææŊįĪūåšïžå ķåžåæåæķĩįäšåĪäļŠæđéĒïžäūåĶïž 1. **įžįĻčŊčĻæå**ïžåŊč―å æŽJavaãPythonãJavaScriptãC++įäļŧæĩčŊčĻįįžį č§čãæä―ģåŪč·ĩäŧĨååļļč§éŪéĒįč§ĢåģæđæĄã 2. **æĄæķäļåšįåšįĻ**ïžåŊč―äžčŪēč§ĢReactãVueãAngularįåįŦŊæĄæķïžäŧĨåDjangoãSpring BootįåįŦŊæĄæķįä―ŋįĻæå·§ååļļč§åšįĻåšæŊã 3. **æ°æŪåšįŪĄį**ïžæķĩįäšSQLčŊčĻįåšæŽæä―ïžæ°æŪåščŪūčŪĄååïžäŧĨååĶä―éŦæä―ŋįĻMySQLãPostgreSQLãMongoDBįæ°æŪåšįģŧįŧã 4. **įæŽæ§åķ**ïžčŊĶįŧäŧįŧäšGitįå·Ĩä―æĩįĻïžåæŊįŪĄįįįĨïžäŧĨåäļå ķäŧåžåå·Ĩå ·ïžåĶVisual Studio CodeãIntelliJ IDEAïžįéæã 5. **æįŧéæäļæįŧéĻį―ē(CI/CD)**ïžå æŽJenkinsãTravis CIãGitHub Actionsįå·Ĩå ·įé į―Ūåä―ŋįĻïžäŧĨåŪį°čŠåĻåæĩčŊåéĻį―ēã 6. **äšæåĄäļåŪđåĻå**ïžåŊč―æķåAWSãAzureãGoogle Cloud PlatformįäščŪĄįŪåđģå°įä―ŋįĻïžäŧĨåDockeråKubernetesįåŪđåĻåéĻį―ēåŪč·ĩã 7. **APIčŪūčŪĄäļæĩčŊ**ïžčŪēč§ĢRESTful APIįčŪūčŪĄååïžSwaggerįä―ŋįĻïžäŧĨåPostmanįå·Ĩå ·čŋčĄAPIæĩčŊįæđæģã 8. **åŪå Ļæ§äļéį§äŋæĪ**ïžæķĩįOAuthãJWTčŪĪčŊæšåķïžHTTPSåŪå ĻéäŋĄïžäŧĨåéēæĒSQLæģĻå Ĩã

å åŪđæĶčĶïžæŽæäŧįŧäšäļį§å čŋįįŧžåč―æšįģŧįŧäžåč°åšĶæĻĄåïžčŊĨæĻĄåå°éĢįĩãå äžãå įåįĩįæ°č―æšäļįæ°č―Ūæšãįæ°é įįäž įŧč―æščŪūåĪįļįŧåïžåĐįĻäŋĄæŊéīéåģįïžIGDTïžåĪįäļįĄŪåŪæ§ãæĻĄåäļåžå ĨäšP2Gïžįĩč―Žæ°ïžčĢ į―ŪåįĒģæéææŊïžåŪį°äšįĒģįŧæĩéįŊãéčŋåĪč―č―ŽæĒååĻč―įģŧįŧįååč°åšĶïžæéŦäšįģŧįŧįįĩæīŧæ§åéēæĢæ§ãæäļčŊĶįŧäŧįŧäšæĻĄåįå ģéŪįŧäŧķåææŊåŪį°ïžå æŽIGDTįéēæĢæ§åæ°čŪūį―ŪãP2GäļįĒģæéįååæ§åķãåĻč―įģŧįŧįäļįŧīååč°åšĶįãæĪåĪïžæĻĄååąįĪšäšåĻæįŦŊåĪĐæ°åčīč·æģĒåĻäļįäžåžčĄĻį°ïžæūčéä―äšįĒģææūææŽåđķæéŦäšč―æšåĐįĻæįã éåäššįūĪïžäŧäšč―æšįģŧįŧäžåãįĩåč°åšĶãįĒģäšĪæįįļå ģéĒåįį įĐķäššååå·ĨįĻåļã ä―ŋįĻåšæŊåįŪæ ïžéįĻäšéčĶåĪįåĪį§č―æšå―ĒåžåäļįĄŪåŪæ§įįŧžåč―æšįģŧįŧč°åšĶåšæŊãäļŧčĶįŪæ æŊæéŦįģŧįŧįįĩæīŧæ§ãéēæĢæ§åįŧæĩæįïžåå°įĒģææūã å ķäŧčŊīæïžæĻĄåå ·æčŊåĨ―įæĐåąæ§ïžåŊäŧĨéčŋäŋŪæđé į―Ūæäŧķč―ŧæūéææ°įč―æščŪūåĪãäŧĢį äļå åŦäščŊĶįŧįæģĻéåå ŽåžæĻåŊžïžäūŋäšįč§ĢåčŋäļæĨæđčŋã

æŊäļčŪūčŪĄįčŪšææ°åãįŧæįčūĐįļå ģįčĩæš

čŊĨæŊäļäļŠåĻ Kaggle äļååļįæ°æŪéïžäļæģĻäš 2024 åđīåšį°įæžæīïžCVEïžäŋĄæŊãäŧĨäļæŊå ģäščŊĨæ°æŪéįčŊĶįŧäŧįŧïžčŊĨæ°æŪéæķéäš 2024 åđīčŪ°å―åĻæĄįåįąŧæžæīäŋĄæŊïžæķĩįäšæžæīįåĐįĻæđåžïžExploitsïžãéįĻæžæīčŊåįģŧįŧïžCVSSïžčŊåäŧĨååå―ąåįæä―įģŧįŧïžOSïžãéčŋæīåčŋäšäŋĄæŊïžį įĐķäššåååŪå ĻäļåŪķåŊäŧĨå ĻéĒäšč§ĢæŊäļŠæžæīįæ―åĻåĻčãå―ąåčåīäŧĨååŊč―įæŧåŧéåūãæ°æŪäļŧčĶæĨæšäšæåĻįæžæīäŋĄæŊåđģå°ïžåĶįūå―å―åŪķæžæīæ°æŪåšïžNVDïžįãčŋäšæ°æŪįŧčŋæīįåįéåčĒŦįšģå Ĩæ°æŪéïžįĄŪäŋäšäŋĄæŊįåįĄŪæ§ååŊé æ§ãæ°æŪéįđįđïžå ĻéĒæ§ïžæķĩįäšåĪį§æä―įģŧįŧïžåĶ WindowsãLinuxãAndroid įïžįæžæīäŋĄæŊïžåæ äšäļååđģå°įåŪå ĻįķåĩãåŪįĻæ§ïžCVSS čŊåæäūäšæžæīäļĨéįĻåšĶįéåææ ïžåļŪåĐįĻæ·åŋŦéčŊäž°æžæīįäžå įš§ãåæķïžæžæīåĐįĻäŋĄæŊïžExploitsïžäļšåŪå Ļį įĐķäššåæäūäšæŧåŧč åŊč―įæŧåŧææŪĩïžæåĐäšæååķåŪéēåūĄįįĨãæķææ§ïžäļæģĻäš 2024 åđīįæžæīæ°æŪïžåæ äšå―åį―įŧåŪå ĻéĒåéĒäļīįæ°ææåæ°čķåŋãčŊĨæ°æŪéåŊįĻäšåĪį§į įĐķååŪč·ĩåšæŊïž åŪå Ļį įĐķïžį įĐķäššååŊäŧĨåĐįĻčŊĨæ°æŪéåææžæīįååļč§åūãæŧåŧčķåŋäŧĨåäļåæä―įģŧįŧäđéīįåŪå Ļå·Ūåžïžäļšį―įŧåŪå ĻéēæĪæäūįčŪšæŊæã æšåĻåĶäđ äļæ°æŪåæïžæ°æŪéäļįįŧæåäŋĄæŊéåįĻäšæšåĻåĶäđ æĻĄåįčŪįŧïžäūåĶéĒæĩæžæīį CVSS čŊåãčŊåŦæ―åĻįéŦåąæžæīįã äžäļåŪå ĻčŊäž°ïžäžäļåŪå ĻåĒéåŊäŧĨåččŊĨæ°æŪéäļįæžæīäŋĄæŊïžįŧåčŠčšŦįģŧįŧįåŪé æ åĩïžčŋčĄåŪå ĻčŊäž°åæžæīäŋŪåĪčŪĄåįåķåŪã

å åŪđæĶčĶïžæŽææĄĢä―äļšåŧšæĻĄåĪ§čĩįå ĨéĻæåïžčŊĶįŧäŧįŧäšåŧšæĻĄåĪ§čĩįæĶåŋĩãįąŧåãįŦčĩæĩįĻãæ ļåŋæĨéŠĪäļæå·§ïžåđķæäūåŪææĄäūč§ĢæãææĄĢéĶå æĶčŋ°äšåŧšæĻĄåĪ§čĩïžæåšå ķäŧĨæ°åĶãčŪĄįŪæšææŊäļšæ ļåŋïžäļŧčĶåäļšæ°åĶåŧšæĻĄã3DåŧšæĻĄåAIåĪ§æĻĄåįŦčĩäļįąŧãæĨįæ·ąå Ĩč§Ģæäšæ°åĶåŧšæĻĄįŦčĩïžæķĩįįŧéįįĨïžåĶäļäššååŦčīčīĢåŧšæĻĄãįžįĻãčŪšæåä―ïžãæķéīåŪæïž72å°æķå åŪæå ĻæĩįĻïžäŧĨåéŪéĒåæãæĻĄååŧšįŦãįžįĻåŪį°åčŪšææ°åįčĶįđãæäļčŋæäūäšįĐæĩč·ŊåūäžåįåŪææĄäūïžåąįĪšäšåĶä―å°åŪé éŪéĒč―ŽåäļšåūčŪšéŪéĒåđķéįĻDijkstraæčįūĪįŪæģæąč§ĢãæåïžææĄĢæĻčäšäļåįąŧååŧšæĻĄįåĶäđ čĩæšäļå·Ĩå ·ïžåđķįŧåšäšæ°æéŋååŧščŪŪïžåĶéŋå čŋåšĶåĪæåæĻĄåãéč§åŊč§ååį°įã; éåäššįūĪïžåŊđåŧšæĻĄåĪ§čĩæå īčķĢįååĶč ïžįđåŦæŊéŦæ ĄåĶįååļæåäļæ°åĶåŧšæĻĄįŦčĩįæ°æã; ä―ŋįĻåšæŊåįŪæ ïžâ äšč§ĢåŧšæĻĄåĪ§čĩįåšæŽæĶåŋĩååįąŧïžâĄææĄæ°åĶåŧšæĻĄįŦčĩįå ·ä―æĩįĻäļåå·ĨïžâĒåĶäđ åĶä―å°åŪé éŪéĒč―Žåäļšæ°åĶæĻĄååđķæąč§ĢïžâĢč·ååŪæįŧéŠååļļč§éčŊŊč§éŋæđæģã; å ķäŧčŊīæïžææĄĢäļäŧ æäūäšįčŪšįĨčŊïžčŋįŧåå ·ä―åŪäūåäŧĢį įæŪĩåļŪåĐčŊŧč æīåĨ―å°įč§ĢååŪč·ĩåŧšæĻĄčŋįĻãåŧščŪŪæ°æäŧäļå°åčĩäšåžå§į§ŊįīŊįŧéŠïžéæĨæåæč―æ°īåđģã

čŊĨčĩæšäļšprotobuf-6.30.1-cp310-abi3-win32.whlïžæŽĒčŋäļč――ä―ŋįĻåĶïž

å åŪđæĶčĶïžæŽææĄĢčŊĶįŧäŧįŧäšåšäšLinuxįģŧįŧįåĪ§æ°æŪįŊåĒæåŧšæĩįĻïžæķĩįäŧčææšååŧšå°éįūĪåŧšįŦįå ĻčŋįĻãéĶå ïžéčŋäļįģŧåæĨéŠĪååŧšåđķé į―Ūčææšïžå æŽčŪūį―ŪIPå°åãåŪčĢ MySQLæ°æŪåšįæä―ãæĨįïžéįđčŪēč§ĢäšAmbariįåŪčĢ äļé į―Ūïžæķåå ģééēįŦåĒãčŪūį―Ūå åŊįŧå―ãåŪčĢ æķéīåæĨæåĄïžntpïžãHTTPæåĄäŧĨåé į―ŪYUMæšįå ģéŪįŊčãæåïžåŪæäšAmbariæ°æŪåšįååŧšãJDKįåŪčĢ ãAmbari serveråagentįéĻį―ēïžåđķæåŊžįĻæ·ååŧšéįūĪãæīäļŠčŋįĻäļčŋæäūäšéåŊđåŊč―åšį°įéŪéĒåå ķč§ĢåģæđæĄïžįĄŪäŋåįŧäŧķ饚åĐåŪčĢ äļé į―Ūã éåäššįūĪïžå ·æLinuxåšįĄæä―æč―įæ°æŪå·ĨįĻåļæčŋįŧīäššåïžå°Īå ķæŊéĢäšéčĶæåŧšåįŪĄįåĪ§æ°æŪåđģå°įäļäļäššåĢŦã ä―ŋįĻåšæŊåįŪæ ïžéįĻäšåļæåŋŦéæåŧšįĻģåŪåŊé įåĪ§æ°æŪåđģå°įäžäļæäļŠäššåžåč ãéčŋæŽæååŊäŧĨææĄåĶä―åĐįĻAmbariå·Ĩå ·čŠåĻåéĻį―ēHadoopįæįģŧįŧäļįåäļŠįŧäŧķïžäŧčæéŦå·Ĩä―æįïžéä―įŧīæĪææŽã å ķäŧčŊīæïžææĄĢäļå åŦäšåĪ§éå ·ä―įå―äŧĪčĄæäŧĪåé į―ŪįŧčïžåŧščŪŪčŊŧč æį §éĄšåšéæĨæä―ïžåđķæģĻæčŪ°å―äļéčĶįåæ°åžäŧĨäūŋåįŧåčãæĪåĪïžåĻéå°éŪéĒæķåŊåį §æäūįč§ĢåģæđæĄčŋčĄææĨïžåŋ čĶæķæĨé åŪæđææĄĢč·åæīåĪäŋĄæŊã

å åŪđæĶčĶïžæŽæčŊĶįŧäŧįŧäšåĶä―åĻMATLAB R2018Aäļä―ŋįĻæå°åæđ(LMS)čŠéåšæŧĪæģĒįŪæģåŊđäļįŧīæķéīåšåäŋĄå·čŋčĄéåŠåĪįïžįđåŦæŊéåŊđåŋįĩåū(ECG)äŋĄå·įåšįĻãéĶå ïžéčŋįææĻĄæįECGäŋĄå·åđķå å ĨéæšåŠåĢ°ïžååŧšäšäļäļŠåļĶæåŠåĢ°įæķéīåšåãįķåïžåŪį°äšLMSįŪæģįæ ļåŋéĻåïžå æŽæŧĪæģĒåĻéķæ°ãæĨéŋåæ°įéæĐäŧĨåæéæīæ°č§åįčŪūčŪĄãæäļčŋæäūäščŊĶįŧįäŧĢį įĪšäūïžåąįĪšäšåĶä―æåŧšåčŪįŧčŠéåšæŧĪæģĒåĻïžåđķéčŋåūå―ĒåæđåžæŊčūäšåå§äŋĄå·ãå åŠäŋĄå·äļįŧčŋLMSåĪįåįéåŠäŋĄå·äđéīįå·ŪåžãæĪåĪïžä―č åäšŦäšäļäšåŪįĻįįŧéŠåææŊčĶįđïžåĶåæ°éæĐįå―ąåãčŊŊå·Ūæēįšŋįč§ĢčŊŧįã éįĻäššįūĪïžéįĻäšå ·æäļåŪMATLABįžįĻåšįĄåđķåŊđäŋĄå·åĪįæå īčķĢįį§į äššåãå·ĨįĻåļæåĶįã ä―ŋįĻåšæŊåįŪæ ïžæŽæįĻæĻåĻåļŪåĐčŊŧč ææĄLMSįŪæģįåšæŽåįåå ķåĻåŪé éĄđįŪäļįåšįĻæđæģïžįđåŦæŊåĻįįĐåŧåĶå·ĨįĻãæšæĒ°æ éčŊæįéĒåäļåĪįåŦåŠäŋĄå·įäŧŧåĄãåæķïžäđäļščŋäļæĨæĒįīĒå ķäŧįąŧåįčŠéåšæŧĪæģĒææŊåæĐåąå°äļåįäŋĄå·åĪįäŧŧåĄåĨ åŪäšåšįĄã å ķäŧčŊīæïžå°―įŪĄLMSįŪæģåĻåĪįåđģįĻģåŠåĢ°æđéĒčĄĻį°åščēïžä―åĻéĒåŊđįŠåæ§įåžšåđēæ°æķäŧååĻäļåŪåąéæ§ãå æĪïžåĻæäšįđæŪåšåäļïžåŊč―éčĶäļå ķäŧæŧĪæģĒææŊįļįŧåäŧĨč·åūæīåĨ―įææã

å åŪđæĶčĶïžæŽæčŊĶįŧäŧįŧäšåšäšTMS320F2812 DSPčŊįįå äžåđķį―éååĻčŪūčŪĄæđæĄïžæķĩįäšäļŧįĩč·Ŋæķæãæ§åķįŪæģãéįļįŊåŪį°ãįŊæĩæåķįåĪäļŠå ģéŪææŊįđãéĶå ïžæäļéčŋ°äšåįš§åžįŧæįäļŧįĩč·ŊčŪūčŪĄïžåįš§Boostååå°å äžæŋčūåšįĩåæåčģįšĶ600Vïžåįš§éįĻäļįĩåđģNPCææįIGBTæĄĨčŋčĄéåãæĨįïžæ·ąå ĨæĒčŪĻäšæ ļåŋæ§åķįŪæģïžåĶįĩæĩPIč°čåĻãéįļįŊ(SOFGI)ãįŊæĩæåķįïžåđķæäūäščŊĶįŧįMATLABäŧŋįæĻĄååDSPäŧĢį åŪį°ãæĪåĪïžčŋįđåŦåžšč°äšPWMæŧåšæķéīé į―ŪãADCéæ ·æķåšįéŪéĒįåŪé č§ĢåģæđæĄãæįŧïžéčŋåŪéŠéŠčŊïžčŊĨæđæĄåŪį°äšTHDå°äš3%ïžMPPTæįčūū98.7%ïžåđķææéä―äšåđķčįŊæĩã éåäššįūĪïžäŧäšå äžåđķį―éååĻåžåįįĩåįĩåå·ĨįĻåļåææŊį įĐķäššåã ä―ŋįĻåšæŊåįŪæ ïžéįĻäšå äžåđķį―éååĻįį åéķæŪĩïžåļŪåĐå·ĨįĻåļįč§ĢååŪį°éŦæįĻģåŪįéååĻæ§åķįģŧįŧïžæéŦįģŧįŧįæ§č―ææ ïžåå°åžåčŋįĻäļåļļč§įéčŊŊã å ķäŧčŊīæïžæäļæäūįMATLABäŧŋįæĻĄååDSPäŧĢį åŊäŧĨä―äļšåŪé éĄđįŪåžåįéčĶåččĩæïžæåĐäšįžĐįåžååĻæïžæéŦæåįã

å åŪđæĶčĶïžæŽæčŊĶįŧč§ĢæäšäļčąFX3U PLCåĻå č―īčŠåĻå čĢ æšäļįåšįĻïžæķĩįįĄŽäŧķé į―ŪãįĻåšæĄæķãäžšæåŪä―æ§åķãæčŠåĻåæĒéŧčūãåč―ååšįĻäŧĨåæĨčĶåĪįįæđéĒãįĄŽäŧķæđéĒïžéįĻFX3U-48MTäļŧæĻĄåčŠåļĶäļč―īčåēčūåšïžé åäļäļŠFX3UG-1PGæĻĄåæĐåąåŪä―åč―ïžä―ŋįĻå äļŠMR-JE-20AäžšæéĐąåĻåĻå16įđčūå ĨæĐåąæĻĄåčŋčĄäž æåĻééãįĻåšæĄæķäļŧčĶįąåå§åãæĻĄåžåæĒãå č―īæ§åķååžåļļåĪįįŧæãäžšæåŪä―ä―ŋįĻDRVAæäŧĪåŪį°åéåŪä―æĻĄåžïžæčŠåĻåæĒéŧčūéčŋåč―åå°čĢ ïžįĄŪäŋæĻĄåžåæĒ饚į ãæĨčĶåĪįæĻĄåååĐįĻįĐéĩæŦææđåžåįžĐæĨčĶäŋĄå·ïžæéŦIOåĐįĻįãæĪåĪïžįĻåščŋå æŽįķæįæ§čŪūčŪĄååįđåå―įåč―ã éåäššįūĪïžå ·åĪäļåŪPLCįžįĻåšįĄïžäŧäščŠåĻåæ§åķéĒåįå·ĨįĻåļåææŊäššåã ä―ŋįĻåšæŊåįŪæ ïžéįĻäšå č―īčŠåĻå čĢ æšįčŪūčŪĄäļč°čŊïžåļŪåĐå·ĨįĻåļįč§ĢåææĄäļčąFX3U PLCåĻå čĢ æšæĒ°äļįå ·ä―åšįĻïžæåįģŧįŧįåŊé æ§åæįã å ķäŧčŊīæïžæäļæäūäščŊĶįŧįäŧĢį įĪšäūåæģĻæäšéĄđïžæåĐäšæ°æéŋå åļļč§éčŊŊåđķäžåįĻåšæ§č―ã

PPTJAVAįžįĻ190