对于索引可能最关系的就是分词了 一般对于es 来说默认的smartcn 但效果不是很好

一个是ik的,一个是mmseg的,下面分别介绍下两者的用法,其实都差不多的,先安装插件,命令行:

安装ik插件

plugin -install medcl/elasticsearch-analysis-ik/1.1.0

下载ik相关配置词典文件到config目录

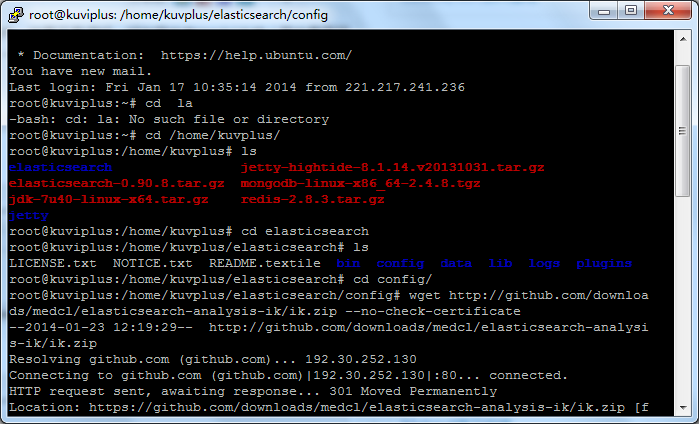

cd config

wget http://github.com/downloads/medcl/elasticsearch-analysis-ik/ik.zip --no-check-certificate

unzip ik.zip

rm ik.zip

分词配置

ik分词配置,在elasticsearch.yml文件中加上

|

1

2

3

4

5

6

|

index: analysis:

analyzer:

ik:

alias: [ik_analyzer]

type: org.elasticsearch.index.analysis.IkAnalyzerProvider

|

或

|

1

|

index.analysis.analyzer.ik.type : “ik” |

安装mmseg插件:

bin/plugin -install medcl/elasticsearch-analysis-mmseg/1.1.0

下载相关配置词典文件到config目录

cd config

wget http://github.com/downloads/medcl/elasticsearch-analysis-mmseg/mmseg.zip --no-check-certificate

unzip mmseg.zip

rm mmseg.zip

mmseg分词配置,也是在在elasticsearch.yml文件中

|

1

2

3

4

5

6

|

index: analysis:

analyzer:

mmseg:

alias: [news_analyzer, mmseg_analyzer]

type: org.elasticsearch.index.analysis.MMsegAnalyzerProvider

|

或

|

1

|

index.analysis.analyzer.default.type : "mmseg" |

mmseg分词还有些更加个性化的参数设置如下

|

1

2

3

4

5

6

7

8

9

10

11

12

|

index: analysis:

tokenizer:

mmseg_maxword:

type: mmseg

seg_type: "max_word"

mmseg_complex:

type: mmseg

seg_type: "complex"

mmseg_simple:

type: mmseg

seg_type: "simple"

|

这样配置完后插件安装完成,启动es就会加载插件。

定义mapping

在添加索引的mapping时就可以这样定义分词器

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

{ "page":{

"properties":{

"title":{

"type":"string",

"indexAnalyzer":"ik",

"searchAnalyzer":"ik"

},

"content":{

"type":"string",

"indexAnalyzer":"ik",

"searchAnalyzer":"ik"

}

}

}

} |

indexAnalyzer为索引时使用的分词器,searchAnalyzer为搜索时使用的分词器。

java mapping代码如下:

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

|

XContentBuilder content = XContentFactory.jsonBuilder().startObject() .startObject("page")

.startObject("properties")

.startObject("title")

.field("type", "string")

.field("indexAnalyzer", "ik")

.field("searchAnalyzer", "ik")

.endObject()

.startObject("code")

.field("type", "string")

.field("indexAnalyzer", "ik")

.field("searchAnalyzer", "ik")

.endObject()

.endObject()

.endObject()

.endObject()

|

测试分词可用调用下面api,注意indexname为索引名,随便指定一个索引就行了

http://localhost:9200/indexname/_analyze?analyzer=ik&text=测试elasticsearch分词器

附:

ik分词插件项目地址:https://github.com/medcl/elasticsearch-analysis-ik

mmseg分词插件项目地址:https://github.com/medcl/elasticsearch-analysis-mmseg

配置好的es版本,地址如下:https://github.com/medcl/elasticsearch-rtf

http://my.oschina.net/sunzy/blog/195341

相关推荐

Elasticsearch-analysis-ik 7.10.0 分词器是 Elasticsearch 在中文环境下的得力助手,它结合了 IK 分词器的强大功能和 Elasticsearch 的灵活性,为企业级搜索提供了坚实的基石。通过合理的配置和使用,可以显著提高...

Elasticsearch 7.6.2 已集成ik分词器 解压后运行bin目录下,elasticsearch.bat文件

在Elasticsearch中集成IK分词插件,可以显著提升对中文文本的索引和搜索性能。具体而言,IK分词插件包含两个主要模式:`smart`模式和`analyzed`模式。`smart`模式下,插件会尽可能地切分出标准词汇;`analyzed`模式...

总的来说,"elasticsearch-analysis-ik-7.10.0"分词插件是Elasticsearch处理中文文本的关键组件,通过与Elasticsearch的集成,可以实现高效、精准的中文全文检索,提升用户体验。同时,了解和掌握相关依赖库的作用也...

Elasticsearch 内置了多种分词器,如标准分词器(Standard Analyzer)、关键词分词器(Keyword Analyzer)和中文分词器(Smart Chinese Analyzer)等。这些分词器可以根据不同的语言和应用场景进行定制,以确保搜索...

总的来说,这个"elasticsearch7.17.9版本分词器插件安装包"是针对中文环境的Elasticsearch实例增强搜索功能的重要工具,通过IK分词器提供高效的文本分析能力,适用于日志收集、分析等场景。正确安装和配置此插件,...

lasticsearch整合分词、创建索引、搜索例子,elasticsearch版本为1.0,索引数据从数据表中动态读取生成,有关键字高亮效果,查询分页 1 在dababase目录中导致相关的数据库文件,修改DBCOperation java文件数据库连接...

Spring Boot结合Jest实现对ElasticSearch的全文检索,分词检索,分页,搜索结果高亮关键词,多字段检索 PageController中的搜索方法里面是全套的,分词,分页,高亮等都包含,数据格式个es-head中创建索引的索引在...

总结来说,通过改造IK分词器源码并集成MySQL数据库,我们可以实现动态更新热词库,从而提高Elasticsearch的分词效果,满足实时性需求。这种方式不仅解决了内置词库和静态词库的不足,还提供了更大的灵活性,能够适应...

IK分词器是针对Elasticsearch(ES)的一款热门中文分词插件,其全称为“Intelligent Chinese Analyzer for Elasticsearch”。它由Java编写,旨在为中文文档提供高效、准确的分词处理。版本7.10.2是IK分词器的一个...

基于Elasticsearch的中文分词插件 内容概要 本项目是一个基于Elasticsearch的中文分词插件,名为IK Analysis for Elasticsearch。该插件将Lucene IK分词器集成到Elasticsearch中,支持自定义词典和多种分词模式。...

Ik 分词器是为 Elasticsearch 设计的一款高效、灵活的中文分词工具,它可以将中文文本拆分成可索引的关键词,这对于提高中文搜索的准确性和效率至关重要。Ik 分词器支持多种分词模式,包括精确模式、全模式、最短...

`elasticsearch-analysis-ik`是一个专为Elasticsearch设计的插件,它集成了Apache Lucene的IK分词器,以实现更智能、更灵活的中文分词功能。 **一、IK分词器概述** IK全称为“Intelligent Chinese Analyzer”,它...

这个插件旨在提供更强大的中文分词能力,以提高Elasticsearch在处理中文数据时的搜索准确性和效率。 Elasticsearch是一款开源的全文搜索引擎,广泛应用于数据分析和日志监控等领域。其核心功能包括索引、搜索、分析...

Ik分词器的集成使得ES在中文环境下的搜索性能得到显著提升,能够处理复杂的中文语境,提供更精准的搜索结果。 **文件"elasticsearch-analysis-ik-master"** 这个文件名表明它是Ik分词器的一个版本仓库,可能是从...

总的来说,"elasticsearch-analysis-pinyin-7.5.1"插件是Elasticsearch处理中文内容的有力工具,它的拼音分词功能极大地拓展了Elasticsearch在中文环境下的应用范围,提升了用户体验和数据挖掘的价值。在理解和掌握...

集成IK分词器能够使Elasticsearch更好地支持中文处理,实现精准的中文分词,从而提高搜索质量和效率。IK分词器是针对Elasticsearch的中文分词插件,由Medcl开发并维护,其全称为`elasticsearch-analysis-ik`。 **一...

IK中文分词器是一个集成到Elasticsearch中的中文分词插件,支持自定义词典和多种分词模式。该插件基于Lucene IK分词器,提供了细粒度和智能分词两种模式,适用于中文文本的搜索和分析。 项目的主要特性和功能 1. ...

Elasticsearch + IK中文分词的组合广泛应用于各种需要全文检索的场景,如网站搜索、日志分析、电商商品搜索等。通过高效的分词和索引,能够快速响应用户的搜索请求,提供精确的搜索结果。 总的来说,Elasticsearch ...