目录[-]

- 1.start-all.sh开启线程

- 2. -ls/-lsr 查看目录下的文件信息

- 3. –touchz 创建文件

- 4. –mkdir 创建文件夹

- 5. -text/-cat查看文件内容

- 6. -mv 移动/重命名

- 7. -cp 复制

- 8. -rm/-rmr 删除文件

- 9. -put 上传文件

- 10.-copyFromLocal 从本地复制

- 11 -moveFromLocal从本地移动

- 12. -getmerge 合并下载到本地

- 13. -setrep/-setrep -R/-setrep -R -w 设置副本数量

- 14. -du统计目录下个文件大小

- 15.-count统计文件(夹)数量

- 16. –chmod/-chmod -R 修改文件权限

- 17. hadoop jar 导jar在命令行运行

- 18、报告HDFS的基本统计信息

- 19、安全模式

- 20、将HDFS中的文件复制到本地系统中

1.start-all.sh开启线程

hadoop fs -ls hdfs://cloud4:9000/user (cloud4表示主机名 9000代表端口号 /就代表根目录 /user就是user文件夹)

hadoop fs -ls /user(hdfs://cloud4:9000可省略)

2. -ls/-lsr 查看目录下的文件信息

hadoop fs -ls / 查看根目录下文件与文件夹

hadoop fs -lsr / 递归查看根目录下所有文件与文件夹

hadoop fs -ls 默认查看hdfs下的/user/<当前用户> 例如:/user/root (很方便的)

3. –touchz 创建文件

可以创建一个文件

hadoop fs -touchz /hello (创建一个hello文件)

4. –mkdir 创建文件夹

(linux中创建多级目录 mkdir –p p表示parents)

可以创建一个或者多个文件夹(hadoop则不需要-p)

hadoop fs -mkdir /user (创建一个user文件夹 )

5. -text/-cat查看文件内容

hadoop fs -text /hello

hadoop fs -cat /hello

6. -mv 移动/重命名

该命令选项表示移动 hdfs 的文件到指定的 hdfs 目录中。后面跟两个路径,第一个表示源文件,第二个表示目的目录

hadoop fs -mv /hello /user(文件到文件夹:是移动)

hadoop fs -mv /hello /user/hello(文件到文件:是重命名)

7. -cp 复制

该命令选项表示复制 hdfs 指定的文件到指定的 hdfs 目录中。后面跟两个路径,第

一个是被复制的文件,第二个是目的地

hadoop fs -cp /user/hello /user/root

8. -rm/-rmr 删除文件

-rm:删除文件/空白文件夹

该命令选项表示删除指定的文件或者空目录

hadoop fs -rm /user/hello

-rmr:递归删除

该命令选项表示递归删除指定目录下的所有子目录和文件

hadoop fs -rm /user

9. -put 上传文件

该命令选项表示把 linux 上的文件复制到 hdfs 中

hadoop fs -put hadoop-env.sh /user

将当前linux目录下的hadoop-env.sh文件,上传到/user(hdfs服务器上的user目录下)

hadoop fs -put hadoop-env.sh /你叫起的名字(hello—文件名)

例如:hadoop fs -put hadoop-env.sh /hello

10.-copyFromLocal 从本地复制

用法与-put一样

hadoop fs -copyFromLocal hadoop-env.sh /user

11 -moveFromLocal从本地移动

该命令表示把文件从 linux 上移动到 hdfs 中

hadoop fs -moveFromLocal /home/repine/hehe.txt /user

12. -getmerge 合并下载到本地

该命令选项的含义是把 hdfs 指定目录下的所有文件内容合并到本地 linux 的文件中

hadoop fs -getmerge /user /home/repine/abc.txt 表示把user目录下所有文件内容复制到linux下 /home/repine/abc.txt中

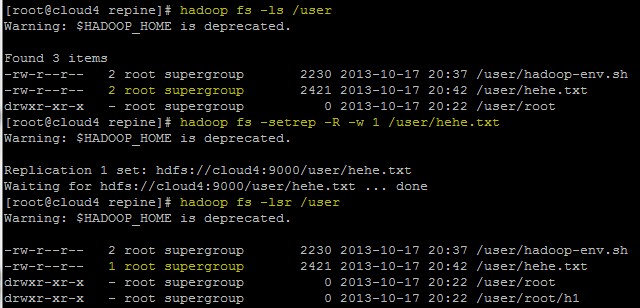

13. -setrep/-setrep -R/-setrep -R -w 设置副本数量

该命令选项是修改已保存文件的副本数量,后面跟副本数量,再跟文件路径

hadoop fs -setrep 2 /user/hehe.txt 设置/user/hehe.txt副本数量为2

如果最后的路径表示文件夹,那么需要跟选项-R,表示对文件夹中的所有文件都修改副本

hadoop fs -setrep -R 2 /user 设置/user下所有文件(不是文件夹)的副本数量为2

还有一个选项是-w,表示等待副本操作结束才退出命令

hadoop fs -setrep -R -w 1 /user/hehe.txt

14. -du统计目录下个文件大小

hadoop fs -du / 查看根目录下的各个文件的大小

hadoop fs -dus / 汇总统计目录下所有文件的总大小(也就是当前文件夹的大小)

15.-count统计文件(夹)数量

hadoop fs -count /usr 递归统计当前文件下的所有信息:数字代表(文件夹总数量、文件总数量、文件总大小信息)

hadoop fs -lsr /usr 验证信息

16. –chmod/-chmod -R 修改文件权限

该命令选项的使用类似于 linux 的 shell 中的 chmod 用法,作用是修改文件的权限

hadoop fs - chmod 777 /user/hehe.txt 修改该文件的权限

如果加上选项-R,可以对文件夹中的所有文件修改权限

hadoop fs – chmod -R 777 /user 修改该文件夹下所有文件的权限

17. hadoop jar 导jar在命令行运行

//打包运行程序必备宝典

job.setJarByClass(WordCountApp.class);

在linux下 :

hadoop jar /linux下路径/XXX.jar /hadoop执行jar的文件或者文件夹 /hadoop下存放目录

18、报告HDFS的基本统计信息

bin/hadoop dfsadmin -report

19、安全模式

bin/hadoop dfsadmin -safemode leave/enter/get/wait

20、将HDFS中的文件复制到本地系统中

bin/hadoop dfs -get in getin

将HDFS中的in文件复制到本地系统并命名为getin

转自:http://my.oschina.net/repine/blog/268278#OSC_h2_2

相关推荐

### Hadoop常用命令详解 Hadoop是一款开源软件框架,主要用于分布式存储与处理大规模数据集。在实际使用过程中,掌握一些常用的Hadoop命令对于管理和维护Hadoop集群至关重要。下面将详细介绍这些命令及其用法。 ##...

这篇文档将详细介绍Hadoop的常用命令,以及如何在Windows环境下进行Hadoop的开发和操作。 首先,我们来了解一下Hadoop的基本命令。`hadoop fs`是Hadoop文件系统(HDFS)的交互接口,用于执行文件系统操作,如`ls`...

下面将详细介绍一些常用命令的使用方法和示例: 1. cat命令:用于查看HDFS文件内容,命令格式为hadoop fs -cat URI [URI …]。例如,查看文件的内容,可以使用命令: ``` hadoop fs -cat hdfs://host1:port1/file...

hadoop 环境搭建、机器部署以及 Linux 常用命令操作指南 本指南将指导用户从头开始搭建 Hadoop 环境,包括虚拟机环境的准备、Linux 基础知识、shell 增强大数据集群环境准备、ZooKeeper 介绍及集群操作网络编程等...

### Linux常用的操作命令+hadoop安装指导 #### Linux用户与权限管理相关知识点 ##### 了解Linux用户与权限管理的重要性 在Linux系统中,用户管理和权限控制是确保系统安全性和稳定性的重要手段之一。通过合理地...

以上知识点详细地阐述了在CentOS系统上配置Hadoop伪分布式环境的全过程,包括了环境准备、JDK安装、环境变量配置、Hadoop配置文件修改、SSH无密码登录配置、集群的启动和使用,以及常用命令的介绍。对于初学者来说,...

以下是一些常用HDFS FS Shell命令的详细说明和使用方法: 1. `hadoop fs -cat URI[URI…]`:此命令用于将路径指定文件的内容输出到标准输出(stdout)。例如,`hadoop fs -cat hdfs://host1:port1/file1 hdfs://...

### Hadoop命令指南详解 #### 一、概述 在深入探讨Hadoop命令的具体用法之前,我们先来了解一下Hadoop的基本概念以及如何调用这些命令。 **1.1 泛用选项** Hadoop提供了一套泛用选项,这些选项被多个命令支持。...

常用的大数据技术如Hadoop、Spark、Kafka、HBase、Hive、Pig等,其核心思路为分而治之和移动计算而非移动数据。 Hadoop简介: Hadoop是大数据领域的核心技术之一,其核心组件包括HDFS、YARN和MapReduce。HDFS是...

Linux是Hadoop最常用的运行平台,因为它提供了稳定、高性能的服务器环境。你需要了解基本的Linux命令行操作,如文件和目录管理(ls、cd、mkdir、rm等)、文本编辑器(如vim或nano)的使用,以及网络配置和权限管理。...

在Hadoop环境中,掌握相关命令是至关重要的,本文将详细介绍Hadoop的常用命令,帮助用户更好地管理和操作Hadoop集群。 1. **通用选项**: - `--config confdir`:设置配置文件目录,默认为`${HADOOP_HOME}/conf`。...

- `hadoop fs`: 常用命令包括创建目录、上传文件、列出文件列表、删除文件等。 - **HDFS特点**: - 分块存储: 数据被分成多个块,每个块默认大小为128MB,分布在不同的节点上。 - 数据冗余: 每个数据块都有多个...

接下来是《Hadoop常用命令.docx》,这是一份实用的工具文档,列举了Hadoop生态系统中常用的命令行工具,如hdfs dfs、hadoop fs、hadoop jar等,这些命令对于日常操作Hadoop集群至关重要。通过学习这些命令,用户可以...

#### 其他常用命令 ##### get **使用方法**: `hadoop fs -get URI <localdst>` 该命令用于从 HDFS 下载文件到本地文件系统。 ##### getmerge **使用方法**: `hadoop fs -getmerge <src> <dst>` 合并多个文件为一个...

#### 知识点四:Hadoop常用命令 - `hadoop fs -put`:将本地文件上传到HDFS。 - `hadoop fs -get`:将HDFS上的文件下载到本地。 - `hadoop fs -ls`:查看HDFS上的文件目录。 - `hadoop fs -rm`:删除HDFS上的文件或...

- **HDFS命令操作**:提供常用HDFS命令的操作示例,如上传文件、查看目录结构、读取文件等。 #### 五、MapReduce编程模型 - **工作流程**:详细解释MapReduce的执行过程,包括Mapper、Shuffle、Reducer三个主要...

### 二、Linux常用命令及操作 #### 常用命令介绍 - **打开终端**:使用快捷键`Ctrl+Alt+T`快速打开终端。 - **创建用户**:使用`sudouseradd-mhadoop-s/bin/bash`命令创建名为`hadoop`的新用户,并指定默认shell。...

3. "hadoop运维命令总结.txt":这可能是对Hadoop操作和维护常用命令的汇总,包括启动、停止Hadoop服务,监控HDFS状态,以及执行MapReduce作业等操作。 从这些文件我们可以学习到的知识点有: 1. **Hadoop的安装与...

根据提供的文档内容,本文将详细解析Hadoop-2.8.1与Zookeeper-3.4.6在高可用环境下的部署步骤与注意事项,重点包括版本兼容性、主机规划、目录规划以及常用的脚本与命令。 ### 版本兼容性 在搭建Hadoop集群时,...

大数据常用软件安装指南 一、Hadoop 分布式文件存储系统:HDFS 分布式计算框架:MapReduce 集群资源管理器:YARN 单机伪集群环境搭建 集群环境搭建 常用 Shell 命令 Java API 的使用 基于 Zookeeper 搭建 Hadoop 高...