- 浏览: 430358 次

- 性别:

- 来自: 深圳

-

文章分类

最新评论

-

xinzhengjie:

服务器用什么实现

pjsip -

yxhloen01:

只放debug.keystore但是没给密码啊。。。。。。 ...

静默安装实现方法 -

tabolt:

android 应用强制停止 -

li1046964106:

[color=green][size=x-small][ali ...

安卓图表引擎AChartEngine(二) - 示例源码概述和分析 -

smallk2013:

用你这个方法为什么我只想模拟点击 无法实现啊

Android下执行Runtime.getRuntime().exec后返回状态

最近在做一个蓝光播放器的项目,负责JNI层,需要写java和C++,因为C++不熟练所以在开发中遇到很多小白的问题,╮(╯▽╰)╭惭愧啊~~

既然是做播放器肯定离不开ffmpeg啦,不知道ffmpeg的自己去面壁吧....╮(╯▽╰)╭我之前也不知道~~

这里有ffmpeg的文档ffmpeg文档,跟看源代码差不多,大家都是这么看过来的。。。。╮(╯▽╰)╭

进入正题,通过编译ffmpeg拿到libffmpeg.a或者libmpeg.so,本例将编译一个简单的调用ffmpeg中函数的.so库,也就是将编译好的ffmpeg.so集成到另一个.so库中,供应用层调用,这个例子可以发现存放在本地SD卡中的音视频文件,并通过FFmpeg提供的函数接口解析文件获取信息。

操作系统:Linux (window我还没试过哦)

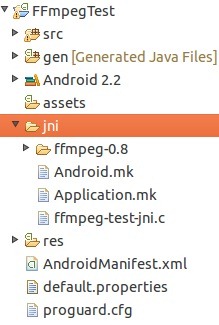

1.创建一个新的Android Project 命名为FFmpegTest

目标平台最好选择与编译好的libffmpeg.so相同的平台,在FFmpegTest目录下创建一个jni目录。

2.下载ffmpeg源代码并放到jni目录下

下载地址:http://ffmpeg.org/download.html 这是0.8 “Love”版本的ffmpeg,如果你想获取最新版本的ffmpeg源代码可以通过Git或者SVN获取(具体问google)。

下载完后放到jni目录下的ffmpeg目录。

3.编译ffmpeg

3.1复制粘贴以下脚本代码,保存命名为 build_android.sh ,并放到ffmpeg目录下。

注意:这几行代码是需要修改的

如果你不熟悉java的JNI开发, 你可能需要先阅读JNI规范后才能看懂以上的代码。

5.2编译本地代码,将ffmpeg.so集成到自己的.so库

在jni目录下创建一个 Android.mk 文件,此文件是用于告诉NDK如何去编译这个项目的jni层代码

LOCAL_PATH := $(call my-dir)

#declare the prebuilt library

include $(CLEAR_VARS)

LOCAL_MODULE := ffmpeg-prebuilt

LOCAL_SRC_FILES := ffmpeg/android/armv7-a/libffmpeg.so

LOCAL_EXPORT_C_INCLUDES := ffmpeg/android/armv7-a/include

LOCAL_EXPORT_LDLIBS := ffmpeg/android/armv7-a/libffmpeg.so

LOCAL_PRELINK_MODULE := true

include $(PREBUILT_SHARED_LIBRARY)

#the ffmpeg-test-jni library

include $(CLEAR_VARS)

LOCAL_ALLOW_UNDEFINED_SYMBOLS=false

LOCAL_MODULE := ffmpeg-test-jni

LOCAL_SRC_FILES := ffmpeg-test-jni.c

LOCAL_C_INCLUDES := $(LOCAL_PATH)/ffmpeg-0.8/android/armv7-a/include

LOCAL_SHARED_LIBRARY := ffmpeg-prebuilt

LOCAL_LDLIBS := -llog -ljnigraphics -lz -lm $(LOCAL_PATH)/ffmpeg/android/armv7-a/libffmpeg.so

include $(BUILD_SHARED_LIBRARY)

再在jni目录新建另一个新的文件命名为 Application.mk,代码如下:

# The ARMv7 is significanly faster due to the use of the hardware FPU

APP_ABI := armeabi-v7a

APP_PLATFORM := android-8

关于Android.mk 与 Application.mk的更多信息请参考android NDK的官方文档 .

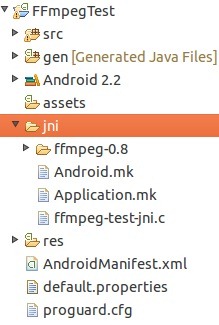

现在你的工程目录结构应该是酱紫的....

5.3 编写java native 方法调用 本地代码(Native Code)

要调用本地方法也就是.so库中的方法,需要先把.so加载到虚拟机中,以下是代码片段,后面会提供项目的下载链接

/*this part communicates with native code through jni (java native interface)*/

//load the native library

static {

System.loadLibrary("ffmpeg");

System.loadLibrary("ffmpeg-test-jni");

}

//declare the jni functions

private static native void naInit(String _videoFileName);

private static native int[] naGetVideoResolution();

private static native String naGetVideoCodecName();

private static native String naGetVideoFormatName();

private static native void naClose();

private void showVideoInfo(final File _file) {

String videoFilename = _file.getAbsolutePath();

naInit(videoFilename);

int[] prVideoRes = naGetVideoResolution();

String prVideoCodecName = naGetVideoCodecName();

String prVideoFormatName = naGetVideoFormatName();

naClose();

String displayText = "Video: " + videoFilename + "\n";

displayText += "Video Resolution: " + prVideoRes[0] + "x" + prVideoRes[1] + "\n";

displayText += "Video Codec: " + prVideoCodecName + "\n";

displayText += "Video Format: " + prVideoFormatName + "\n";

text_titlebar_text.setText(displayText);

}

这几个java 的native方法与上面实现的c 代码中的几个方法是一 一对应的,或者你可以先在命令行中cd 到工程的classes目录下使用javah工具生成这些java native方法对应的.h头文件,再新建一个.c文件将.h文件include进来再一 一去实现其中的函数。.h头文件并不是必须的...但生成.h文件比较规范.

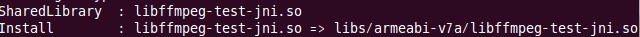

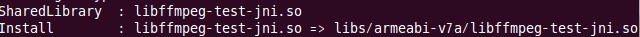

5.4 编译集成ffmpeg 这一步在5.3之前做也可以...

Android.mk 、Application.mk、ffmpeg-test-jni.c、ffmpeg/android中的库文件都准备齐全后,

使用终端cd 到工程目录(FFmpegTest) 执行命令:

ndk-build

出现以上提示则表示编译通过了 ╮(╯▽╰)╭ 终于搞定了

刷新工程目录后会生成一个libs文件夹,里面就包含了我们编译好的.so库

6.最后安装应用开始测试吧~

项目工程下载: http://download.csdn.net/detail/teisun/4276777

我的开发环境是ubuntu 10.04 和ndk-r5、ndk-r6、 ndk-r7都测试通过,window平台不敢保证可以 顺利编译哦。

既然是做播放器肯定离不开ffmpeg啦,不知道ffmpeg的自己去面壁吧....╮(╯▽╰)╭我之前也不知道~~

这里有ffmpeg的文档ffmpeg文档,跟看源代码差不多,大家都是这么看过来的。。。。╮(╯▽╰)╭

进入正题,通过编译ffmpeg拿到libffmpeg.a或者libmpeg.so,本例将编译一个简单的调用ffmpeg中函数的.so库,也就是将编译好的ffmpeg.so集成到另一个.so库中,供应用层调用,这个例子可以发现存放在本地SD卡中的音视频文件,并通过FFmpeg提供的函数接口解析文件获取信息。

操作系统:Linux (window我还没试过哦)

1.创建一个新的Android Project 命名为FFmpegTest

目标平台最好选择与编译好的libffmpeg.so相同的平台,在FFmpegTest目录下创建一个jni目录。

2.下载ffmpeg源代码并放到jni目录下

下载地址:http://ffmpeg.org/download.html 这是0.8 “Love”版本的ffmpeg,如果你想获取最新版本的ffmpeg源代码可以通过Git或者SVN获取(具体问google)。

下载完后放到jni目录下的ffmpeg目录。

3.编译ffmpeg

3.1复制粘贴以下脚本代码,保存命名为 build_android.sh ,并放到ffmpeg目录下。

注意:这几行代码是需要修改的

NDK=~/Desktop/android/android-ndk-r5b PLATFORM=$NDK/platforms/android-8/arch-arm/ PREBUILT=$NDK/toolchains/arm-linux-androideabi-4.4.3/prebuilt/linux-x86 根据你自己的情况指定NDK的各个目录,你也可以根据你项目的目标平台调整 PLATFORM 变量的值, SDK 2.2 对应的是android-8.#!/bin/bash ###################################################### # Usage: # put this script in top of FFmpeg source tree # ./build_android # It generates binary for following architectures: # ARMv6 # ARMv6+VFP # ARMv7+VFPv3-d16 (Tegra2) # ARMv7+Neon (Cortex-A8) # Customizing: # 1. Feel free to change ./configure parameters for more features # 2. To adapt other ARM variants # set $CPU and $OPTIMIZE_CFLAGS # call build_one ###################################################### NDK=~/Desktop/android/android-ndk-r5b PLATFORM=$NDK/platforms/android-8/arch-arm/ PREBUILT=$NDK/toolchains/arm-linux-androideabi-4.4.3/prebuilt/linux-x86 function build_one { ./configure --target-os=linux \ --prefix=$PREFIX \ --enable-cross-compile \ --extra-libs="-lgcc" \ --arch=arm \ --cc=$PREBUILT/bin/arm-linux-androideabi-gcc \ --cross-prefix=$PREBUILT/bin/arm-linux-androideabi- \ --nm=$PREBUILT/bin/arm-linux-androideabi-nm \ --sysroot=$PLATFORM \ --extra-cflags=" -O3 -fpic -DANDROID -DHAVE_SYS_UIO_H=1 -Dipv6mr_interface=ipv6mr_ifindex -fasm -Wno-psabi -fno-short-enums -fno-strict-aliasing -finline-limit=300 $OPTIMIZE_CFLAGS " \ --disable-shared \ --enable-static \ --extra-ldflags="-Wl,-rpath-link=$PLATFORM/usr/lib -L$PLATFORM/usr/lib -nostdlib -lc -lm -ldl -llog" \ --disable-everything \ --enable-demuxer=mov \ --enable-demuxer=h264 \ --disable-ffplay \ --enable-protocol=file \ --enable-avformat \ --enable-avcodec \ --enable-decoder=rawvideo \ --enable-decoder=mjpeg \ --enable-decoder=h263 \ --enable-decoder=mpeg4 \ --enable-decoder=h264 \ --enable-parser=h264 \ --disable-network \ --enable-zlib \ --disable-avfilter \ --disable-avdevice \ $ADDITIONAL_CONFIGURE_FLAG make clean make -j4 install $PREBUILT/bin/arm-linux-androideabi-ar d libavcodec/libavcodec.a inverse.o $PREBUILT/bin/arm-linux-androideabi-ld -rpath-link=$PLATFORM/usr/lib -L$PLATFORM/usr/lib -soname libffmpeg.so -shared -nostdlib -z,noexecstack -Bsymbolic --whole-archive --no-undefined -o $PREFIX/libffmpeg.so libavcodec/libavcodec.a libavformat/libavformat.a libavutil/libavutil.a libswscale/libswscale.a -lc -lm -lz -ldl -llog --warn-once --dynamic-linker=/system/bin/linker $PREBUILT/lib/gcc/arm-linux-androideabi/4.4.3/libgcc.a } #arm v6 #CPU=armv6 #OPTIMIZE_CFLAGS="-marm -march=$CPU" #PREFIX=./android/$CPU #ADDITIONAL_CONFIGURE_FLAG= #build_one #arm v7vfpv3 CPU=armv7-a OPTIMIZE_CFLAGS="-mfloat-abi=softfp -mfpu=vfpv3-d16 -marm -march=$CPU " PREFIX=./android/$CPU ADDITIONAL_CONFIGURE_FLAG= build_one #arm v7vfp #CPU=armv7-a #OPTIMIZE_CFLAGS="-mfloat-abi=softfp -mfpu=vfp -marm -march=$CPU " #PREFIX=./android/$CPU-vfp #ADDITIONAL_CONFIGURE_FLAG= #build_one #arm v7n #CPU=armv7-a #OPTIMIZE_CFLAGS="-mfloat-abi=softfp -mfpu=neon -marm -march=$CPU -mtune=cortex-a8" #PREFIX=./android/$CPU #ADDITIONAL_CONFIGURE_FLAG=--enable-neon #build_one #arm v6+vfp #CPU=armv6 #OPTIMIZE_CFLAGS="-DCMP_HAVE_VFP -mfloat-abi=softfp -mfpu=vfp -marm -march=$CPU" #PREFIX=./android/${CPU}_vfp #ADDITIONAL_CONFIGURE_FLAG= #build_one

为了提高编译速度此脚本放弃了ffmpeg的很多东西,你可以根据自己的需求改变脚本文件的配置,此外,你还可以编译多硬件平台的库文件,本例只编译 arm v7vfpv3,因为编译arm的库速度比较快~~╮(╯▽╰)╭ 请原谅 汤姆猫的懒惰。

3.2 确保 bash 脚本文件是可执行的. Linux系统使用终端进入项目jin目录下的ffmpeg目录,输入以下命令:

sudo chmod 755 build_android.sh ,这样就能确保脚本文件时可执行的啦~

3.3 使用终端执行脚本文件.

进入到 bash 脚本文件所在目录也就是jni/ffmpeg下,输入以下命令

./build_android.sh

执行脚本文件(应该是几分钟就编译完成了)。

注意:NDK-r6或者以上的版本如果无法编译通过,可以试试下面这个脚本文件<span style="color: rgb(51, 51, 51);">#!/bin/bash ###################################################### # Usage: # put this script in top of FFmpeg source tree # ./build_android # # It generates binary for following architectures: # ARMv6 # ARMv6+VFP # ARMv7+VFPv3-d16 (Tegra2) # ARMv7+Neon (Cortex-A8) # # Customizing: # 1. Feel free to change ./configure parameters for more features # 2. To adapt other ARM variants # set $CPU and $OPTIMIZE_CFLAGS # call build_one ###################################################### #change these three lines if you want to build using different vesion of Android ndk #build_one is for ndk 5, and build_one_r6 is for ndk 6 NDK=~/ffmpeg/android-ndk-r6 PLATFORM=$NDK/platforms/android-8/arch-arm/ PREBUILT=$NDK/toolchains/arm-linux-androideabi-4.4.3/prebuilt/linux-x86 function build_one_r6 { ./configure \ --disable-shared \ --enable-static \ --enable-gpl \ --enable-version3 \ --enable-nonfree \ --disable-doc \ --disable-ffmpeg \ --disable-ffplay \ --disable-ffprobe \ --disable-ffserver \ --disable-avdevice \ --disable-avfilter \ --disable-postproc \ --enable-small \ --cross-prefix=$PREBUILT/bin/arm-linux-androideabi- \ --enable-cross-compile \ --target-os=linux \ --extra-cflags="-I$PLATFORM/usr/include" \ --extra-ldflags="-L$PLATFORM/usr/lib -nostdlib" \ --arch=arm \ --disable-symver \ --disable-debug \ --disable-stripping \ $ADDITIONAL_CONFIGURE_FLAG sed -i 's/HAVE_LRINT 0/HAVE_LRINT 1/g' config.h sed -i 's/HAVE_LRINTF 0/HAVE_LRINTF 1/g' config.h sed -i 's/HAVE_ROUND 0/HAVE_ROUND 1/g' config.h sed -i 's/HAVE_ROUNDF 0/HAVE_ROUNDF 1/g' config.h sed -i 's/HAVE_TRUNC 0/HAVE_TRUNC 1/g' config.h sed -i 's/HAVE_TRUNCF 0/HAVE_TRUNCF 1/g' config.h make clean make -j4 install $PREBUILT/bin/arm-linux-androideabi-ar d libavcodec/libavcodec.a inverse.o $PREBUILT/bin/arm-linux-androideabi-ld -rpath-link=$PLATFORM/usr/lib -L$PLATFORM/usr/lib -soname libffmpeg.so -shared -nostdlib -z,noexecstack -Bsymbolic --whole-archive --no-undefined -o $PREFIX/libffmpeg.so libavcodec/libavcodec.a libavformat/libavformat.a libavutil/libavutil.a libswscale/libswscale.a -lc -lm -lz -ldl -llog --warn-once --dynamic-linker=/system/bin/linker $PREBUILT/lib/gcc/arm-linux-androideabi/4.4.3/libgcc.a } function build_one_r6_2 { $PREBUILT/bin/arm-linux-androideabi-ar d libavcodec/libavcodec.a inverse.o $PREBUILT/bin/arm-linux-androideabi-ld -rpath-link=$PLATFORM/usr/lib -L$PLATFORM/usr/lib -soname libffmpeg.so -shared -nostdlib -z,noexecstack -Bsymbolic --whole-archive --no-undefined -o $PREFIX/libffmpeg.so libavcodec/libavcodec.a libavformat/libavformat.a libavutil/libavutil.a libswscale/libswscale.a -lc -lm -lz -ldl -llog --warn-once --dynamic-linker=/system/bin/linker $PREBUILT/lib/gcc/arm-linux-androideabi/4.4.3/libgcc.a } #arm v6 #CPU=armv6 #OPTIMIZE_CFLAGS="-marm -march=$CPU" #PREFIX=./android/$CPU #ADDITIONAL_CONFIGURE_FLAG= #build_one #arm v7vfpv3 CPU=armv7-a OPTIMIZE_CFLAGS="-mfloat-abi=softfp -mfpu=vfpv3-d16 -marm -march=$CPU " PREFIX=./android/$CPU ADDITIONAL_CONFIGURE_FLAG= #build_one build_one_r6 #arm v7vfp #CPU=armv7-a #OPTIMIZE_CFLAGS="-mfloat-abi=softfp -mfpu=vfp -marm -march=$CPU " #PREFIX=./android/$CPU-vfp #ADDITIONAL_CONFIGURE_FLAG= #build_one #arm v7n #CPU=armv7-a #OPTIMIZE_CFLAGS="-mfloat-abi=softfp -mfpu=neon -marm -march=$CPU -mtune=cortex-a8" #PREFIX=./android/$CPU #ADDITIONAL_CONFIGURE_FLAG=--enable-neon #build_one #arm v6+vfp #CPU=armv6 #OPTIMIZE_CFLAGS="-DCMP_HAVE_VFP -mfloat-abi=softfp -mfpu=vfp -marm -march=$CPU" #PREFIX=./android/${CPU}_vfp #ADDITIONAL_CONFIGURE_FLAG= #build_one</span>

网上说可能还需要在ffmpeg目录下创建 ./android/armv7-a/的目录结构.

4.完成编译

当脚本文件执行完毕,会在ffmpeg目录下生成一个android的文件夹,里面就包含了所有的编译成果。

5.将编译完成的.so或.a库,使用JNI规范集成到android应用中供java代码调用。

5.1下面的代码是调用ffmpeg库的jni层代码,可以在jni目录下创建一个ffmpeg-test-jni.c文件,将代码粘贴过去,这部分代码是不完整的,文章末尾会提供 本例完整的工程项目的 下载链接。。

/*for android logs*/

#define LOG_TAG "FFmpegTest"

#define LOG_LEVEL 10

#define LOGI(level, ...) if (level <= LOG_LEVEL) {__android_log_print(ANDROID_LOG_INFO, LOG_TAG, __VA_ARGS__);}

#define LOGE(level, ...) if (level <= LOG_LEVEL) {__android_log_print(ANDROID_LOG_ERROR, LOG_TAG, __VA_ARGS__);}

char *gFileName; //the file name of the video

AVFormatContext *gFormatCtx;

int gVideoStreamIndex; //video stream index

AVCodecContext *gVideoCodecCtx;

static void get_video_info(char *prFilename);

static void get_video_info(char *prFilename) {

AVCodec *lVideoCodec;

int lError;

/*register the codec*/

extern AVCodec ff_h264_decoder;

avcodec_register(&ff_h264_decoder);

/*register demux*/

extern AVInputFormat ff_mov_demuxer;

av_register_input_format(&ff_mov_demuxer);

/*register the protocol*/

extern URLProtocol ff_file_protocol;

av_register_protocol2(&ff_file_protocol, sizeof(ff_file_protocol));

/*open the video file*/

if ((lError = av_open_input_file(&gFormatCtx, gFileName, NULL, 0, NULL)) !=0 ) {

LOGE(1, "Error open video file: %d", lError);

return; //open file failed

}

/*retrieve stream information*/

if ((lError = av_find_stream_info(gFormatCtx)) < 0) {

LOGE(1, "Error find stream information: %d", lError);

return;

}

/*find the video stream and its decoder*/

gVideoStreamIndex = av_find_best_stream(gFormatCtx, AVMEDIA_TYPE_VIDEO, -1, -1, &lVideoCodec, 0);

if (gVideoStreamIndex == AVERROR_STREAM_NOT_FOUND) {

LOGE(1, "Error: cannot find a video stream");

return;

} else {

LOGI(10, "video codec: %s", lVideoCodec->name);

}

if (gVideoStreamIndex == AVERROR_DECODER_NOT_FOUND) {

LOGE(1, "Error: video stream found, but no decoder is found!");

return;

}

/*open the codec*/

gVideoCodecCtx = gFormatCtx->streams[gVideoStreamIndex]->codec;

LOGI(10, "open codec: (%d, %d)", gVideoCodecCtx->height, gVideoCodecCtx->width);

if (avcodec_open(gVideoCodecCtx, lVideoCodec) < 0) {

LOGE(1, "Error: cannot open the video codec!");

return;

}

}

JNIEXPORT void JNICALL Java_roman10_ffmpegTest_VideoBrowser_naInit(JNIEnv *pEnv, jobject pObj, jstring pFileName) {

int l_mbH, l_mbW;

/*get the video file name*/

gFileName = (char *)(*pEnv)->GetStringUTFChars(pEnv, pFileName, NULL);

if (gFileName == NULL) {

LOGE(1, "Error: cannot get the video file name!");

return;

}

LOGI(10, "video file name is %s", gFileName);

get_video_info(gFileName);

}

JNIEXPORT jstring JNICALL Java_roman10_ffmpegTest_VideoBrowser_naGetVideoCodecName(JNIEnv *pEnv, jobject pObj) {

char* lCodecName = gVideoCodecCtx->codec->name;

return (*pEnv)->NewStringUTF(pEnv, lCodecName);

}

如果你不熟悉java的JNI开发, 你可能需要先阅读JNI规范后才能看懂以上的代码。

5.2编译本地代码,将ffmpeg.so集成到自己的.so库

在jni目录下创建一个 Android.mk 文件,此文件是用于告诉NDK如何去编译这个项目的jni层代码

LOCAL_PATH := $(call my-dir)

#declare the prebuilt library

include $(CLEAR_VARS)

LOCAL_MODULE := ffmpeg-prebuilt

LOCAL_SRC_FILES := ffmpeg/android/armv7-a/libffmpeg.so

LOCAL_EXPORT_C_INCLUDES := ffmpeg/android/armv7-a/include

LOCAL_EXPORT_LDLIBS := ffmpeg/android/armv7-a/libffmpeg.so

LOCAL_PRELINK_MODULE := true

include $(PREBUILT_SHARED_LIBRARY)

#the ffmpeg-test-jni library

include $(CLEAR_VARS)

LOCAL_ALLOW_UNDEFINED_SYMBOLS=false

LOCAL_MODULE := ffmpeg-test-jni

LOCAL_SRC_FILES := ffmpeg-test-jni.c

LOCAL_C_INCLUDES := $(LOCAL_PATH)/ffmpeg-0.8/android/armv7-a/include

LOCAL_SHARED_LIBRARY := ffmpeg-prebuilt

LOCAL_LDLIBS := -llog -ljnigraphics -lz -lm $(LOCAL_PATH)/ffmpeg/android/armv7-a/libffmpeg.so

include $(BUILD_SHARED_LIBRARY)

再在jni目录新建另一个新的文件命名为 Application.mk,代码如下:

# The ARMv7 is significanly faster due to the use of the hardware FPU

APP_ABI := armeabi-v7a

APP_PLATFORM := android-8

关于Android.mk 与 Application.mk的更多信息请参考android NDK的官方文档 .

现在你的工程目录结构应该是酱紫的....

5.3 编写java native 方法调用 本地代码(Native Code)

要调用本地方法也就是.so库中的方法,需要先把.so加载到虚拟机中,以下是代码片段,后面会提供项目的下载链接

/*this part communicates with native code through jni (java native interface)*/

//load the native library

static {

System.loadLibrary("ffmpeg");

System.loadLibrary("ffmpeg-test-jni");

}

//declare the jni functions

private static native void naInit(String _videoFileName);

private static native int[] naGetVideoResolution();

private static native String naGetVideoCodecName();

private static native String naGetVideoFormatName();

private static native void naClose();

private void showVideoInfo(final File _file) {

String videoFilename = _file.getAbsolutePath();

naInit(videoFilename);

int[] prVideoRes = naGetVideoResolution();

String prVideoCodecName = naGetVideoCodecName();

String prVideoFormatName = naGetVideoFormatName();

naClose();

String displayText = "Video: " + videoFilename + "\n";

displayText += "Video Resolution: " + prVideoRes[0] + "x" + prVideoRes[1] + "\n";

displayText += "Video Codec: " + prVideoCodecName + "\n";

displayText += "Video Format: " + prVideoFormatName + "\n";

text_titlebar_text.setText(displayText);

}

这几个java 的native方法与上面实现的c 代码中的几个方法是一 一对应的,或者你可以先在命令行中cd 到工程的classes目录下使用javah工具生成这些java native方法对应的.h头文件,再新建一个.c文件将.h文件include进来再一 一去实现其中的函数。.h头文件并不是必须的...但生成.h文件比较规范.

5.4 编译集成ffmpeg 这一步在5.3之前做也可以...

Android.mk 、Application.mk、ffmpeg-test-jni.c、ffmpeg/android中的库文件都准备齐全后,

使用终端cd 到工程目录(FFmpegTest) 执行命令:

ndk-build

出现以上提示则表示编译通过了 ╮(╯▽╰)╭ 终于搞定了

刷新工程目录后会生成一个libs文件夹,里面就包含了我们编译好的.so库

6.最后安装应用开始测试吧~

项目工程下载: http://download.csdn.net/detail/teisun/4276777

我的开发环境是ubuntu 10.04 和ndk-r5、ndk-r6、 ndk-r7都测试通过,window平台不敢保证可以 顺利编译哦。

相关推荐

本文将详细讲解如何在Android平台上编译FFmpeg 6.0,并生成适用于不同架构的动态链接库.so文件,包括armeabi-v7a和arm64-v8a。 1. **FFmpeg 框架介绍** FFmpeg 包含了多种音视频编解码器、过滤器和协议,使得...

本项目“Android编译ffmpeg+测试工程”旨在帮助开发者在Android环境中集成并运行FFmpeg,以便进行多媒体处理任务。通过这个项目,我们可以学习到以下关键知识点: 1. **FFmpeg简介**:FFmpeg是一个开源的跨平台...

这两个文件是Android NDK的构建脚本,用于指示如何编译FFmpeg库。`Android.mk`文件中,你需要指定FFmpeg的源目录、目标平台、编译选项等。`Application.mk`则用来设置APP_ABI(支持的架构)、APP_PLATFORM(最低...

在这个过程中,一个重要的步骤就是编译FFmpeg。本项目基于`android-ndk-r10b`(Android Native Development Kit的早期版本)成功编译了FFmpeg 3.1版本,并集成了x264编码库,x264是H.264/AVC编解码器的一个高效实现...

在编译FFmpeg的过程中,开发者需要考虑以下几个关键步骤: 1. **配置FFmpeg**: 首先,需要下载FFmpeg的源代码并根据Android平台的特定需求进行配置。这可能涉及到选择要编译的组件,如解码器、编码器、过滤器等,...

编译完成后,生成的库文件可以被Android应用通过JNI(Java Native Interface)调用,实现对音频和视频的解码、编码、转码、流媒体处理等功能。例如,开发者可以使用这些库来实现自定义的播放器、视频编辑工具或者...

8. **打包与发布**:最后,将编译好的库文件打包到Android应用的`jniLibs`目录下,然后按照常规方式发布应用。 在压缩包文件的文件名称列表中,我们看到"androids",这可能是编译过程中产生的Android相关的文件,...

使用`make`编译FFmpeg,完成后使用`make install`将编译出的静态库文件(libavcodec, libavformat, libavutil, libswscale)及其头文件安装到指定目录。 3. **FFmpeg在Android中的使用**: 要在Android应用中使用...

6. **集成到Android项目**:在Android Studio中,将打包好的库文件放入项目的`jniLibs`目录,然后通过JNI(Java Native Interface)接口调用FFmpeg的函数。 7. **编写JNI代码**:在C/C++层编写JNI代码,实现Java与...

6. **链接库文件**:将编译好的动态库(.so文件)复制到Android项目的jniLibs目录下,以便在应用运行时加载。 7. **测试与调试**:在Android设备或模拟器上运行应用程序,验证FFmpeg功能是否正常。 编译FFmpeg时...

只针对arm64-v8a架构编译FFmpeg库是一个涉及源码理解、交叉编译环境配置、编译优化和测试验证等多个步骤的复杂过程。开发者需要细心地处理每一个环节,以确保最终能够获得一个高效且稳定的FFmpeg库,从而增强Android...

- 动态库加载:Android项目中,通常会将编译好的FFmpeg库打包到APK中,使用System.loadLibrary()方法加载动态库。 - JNI接口:为了在Java代码中调用FFmpeg函数,需要编写JNI层的C/C++代码,定义对外接口,并在Java...

总结,Android测试FFmpeg库例子主要是通过NDK集成FFmpeg库,利用JNI调用FFmpeg的C/C++函数,获取FFmpeg的版本信息。这个过程涉及到了Android应用的原生开发,包括NDK的使用、JNI接口的定义与实现、库文件的编译与...

6. **集成到 Android 项目**:将编译好的 SO 文件添加到 Android 工程的 `jniLibs` 目录,然后在 Java 或 Kotlin 代码中通过 System.loadLibrary("ffmpeg") 加载库。记得在 AndroidManifest.xml 中添加相应的权限,...

3. 测试编译后的库在不同Android设备上的兼容性和性能。 4. 针对不同Android API级别可能需要编译不同版本的FFmpeg库,以确保兼容性。 综上所述,FFmpeg的编译是一个涉及多步骤的过程,需要熟悉Linux环境和Android...

编译FFmpeg库的过程涉及到多个步骤,主要包括以下内容: 1. **配置**: 首先,你需要下载FFmpeg源代码并进行配置。配置过程中,需要指定目标平台(Android)和架构(armv8-a),并选择需要的组件,如解码器、编码器...

总的来说,成功编译FFmpeg 0.6 for Android需要对Android NDK、交叉编译、JNI以及FFmpeg自身有深入理解。通过以上步骤,我们可以将FFmpeg集成到Android应用中,实现音视频的处理和播放功能。文件名`JNI_FFmpeg`可能...

在提供的压缩包文件"ffmpeg-gltransition-libs"中,可能包含了已经编译好的FFmpeg和gltransition库文件,可以直接用于Android项目。但是,为了确保最佳的兼容性和性能,建议根据自己的需求和环境进行交叉编译。

总之,"ffmpeg-android src and built result for arm-v7a" 提供了在Android设备上实现音视频处理的基础,开发者可以通过源码进行二次开发,或者直接使用编译好的库文件,结合Android SDK和NDK实现各种多媒体功能。...

总结起来,编译FFmpeg for Android涉及到多个环节,包括获取源代码、配置编译环境、执行编译、整合到Android项目以及编写JNI接口。这个过程需要对Android原生开发有一定的了解,同时也需要耐心和细致的工作态度。...