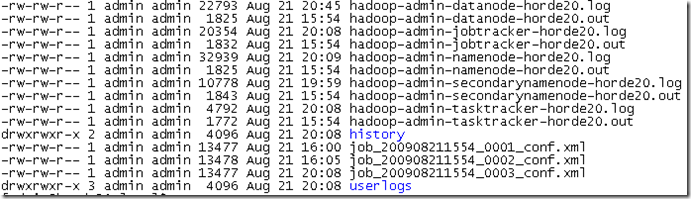

*.log日志文件和*.out日志文件

进入Hadoop_LOG目录,可以看到如下文件:

在启动Hadoop集群时,由hadoop-daemon.sh脚本指定一些列环境变量,然后log4j.properties文件读取相应的环境变量产生对应的*.log日志文件。这个日志文件输出类型为org.apache.log4j.DailyRollingFileAppender,它会自动按天更新。

*.out文件则是启动某个程序的标准输出重定向。

如:

hadoop-admin-datanode-horde20.log是在horde20这台机器上启动datanode进程的日志输出,由log4j实现。

hadoop-admin-datanode-horde20.out则是在horde20这台机器上启动datanode时的标准输出。

这些日志仅仅包含在horde20这台机器上启动datanode进程的日志,没有其他的信息。

userlogs目录下的日志文件

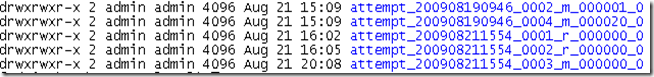

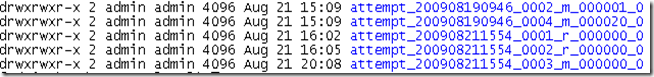

进入userlogs目录,可以看到:

这里的每一个目录代表每一个task的输出日志。

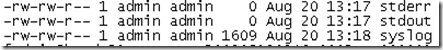

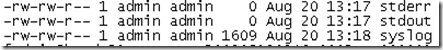

进入其中一个目录可以看到:

这里的stderr和stdout记录了我们的task(map or reduce)的在这台机器上运行的过程中所产生的标准错误输出和标准输出。这些信息集群中的每一个机器上都会出现,如果数据量足够多的话:)

syslog则记录了在我们的task中,通过log4j接口记录的日志信息。

每一个task都会通过TaskRunner.run()来启动,它会为每一个子java程序指定标准错误输出和标准输出到前面提到的文件中,同时设置相应的参数,其中包括”-Dhadoop.root.logger=INFO,TLA”,这个TLA的定义可以在log4j.properties文件中找到,具体实现是org.apache.hadoop.mapred.TaskLogAppender。这个参数指定了在我们的task中,通过log4j接口记录的日志信息都记录到syslog中。

history目录下的日志文件

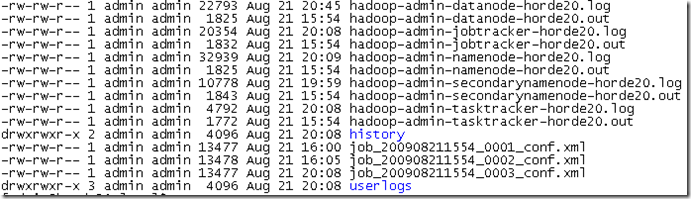

进入jobtracker机器的history目录,我们可以看到:

horde20_1250841267760_job_200908211554_0001_conf.xml记录了我们运行这个job时候的配置文件信息。

horde20_1250841267760_job_200908211554_0001_admin_wordcount记录了我们运行这个job的情况。

他们是由JobHistory产生的,并且只在jobtracker机器上产生。

EventCounter

在Hadoop的默认配置log4j.properties中,所有通过log4j接口记录的日志信息还会记录到一个叫EventCounter的Appender中,它的实现是org.apache.hadoop.metrics.jvm.EventCounter,具体的作用是统计Hadoop中使用log4j记录INFO,WARN,ERROR,FATAL信息的次数。

如果希望完全了解Hadoop的运行状况信息,还需要参考counter和metric。

参考:

逖靖寒的世界 http://gpcuster.cnblogs.com

分享到:

相关推荐

利用hadoop集群处理分析日志文件

3. `mapreduce.application.log-file`: 指定应用程序的日志文件名。 4. `mapreduce.jobhistory.done-dir` 和 `mapreduce.jobhistory.intermediate-done-dir`: 分别设置完成作业的历史日志目录和中间状态日志目录。 ...

【Hadoop应用程序】是关于使用Hadoop框架开发的软件应用,通常涉及大数据处理和分析。在Hadoop生态系统中,应用程序可以利用Hadoop的核心组件(如HDFS和MapReduce)进行分布式计算。这里的描述提到,这是一个便于...

在Windows 7操作系统中,使用Eclipse开发Hadoop应用程序的过程涉及多个步骤,涵盖了从环境配置到实际编程的各个层面。以下是对这个主题的详细讲解: 首先,我们需要了解Hadoop和Eclipse的基础。Hadoop是一个开源的...

1. **日志生成**:当系统或应用程序中发生特定事件时,会产生相应的日志消息。 2. **日志传输**:这些日志消息会被发送到syslog服务器。传输过程中通常使用UDP协议,但在安全性要求较高的场景下也会使用TCP协议。 3....

基于Hadoop的网站日志分析程序+源代码+文档说明 -------- 不懂运行,下载完可以私聊问,可远程教学 该资源内项目源码是个人的毕设,代码都测试ok,都是运行成功后才上传资源,答辩评审平均分达到96分,放心下载使用...

8. **案例分析**:通过实际案例展示Hadoop在日志分析、推荐系统、机器学习等领域的应用,加深对Hadoop的理解和应用能力。 9. **最佳实践**:如何设计高效的数据模型,如何优化MapReduce作业,如何选择合适的Hadoop...

标题中的“基于Hadoop的网站日志分析程序”是指利用Hadoop框架来处理和分析网站产生的海量日志数据。在大数据处理领域,Hadoop是一个开源的分布式计算框架,它允许在大规模集群上处理和存储大量数据。对于网站日志...

#### 一、Hadoop及其在日志分析中的应用背景 随着互联网技术的飞速发展,各类Web2.0网站、电子商务平台以及大型网络游戏产生了空前的数据量。这些系统在运行过程中会记录下大量的日志数据,从中提取有价值的信息...

- 运行MapReduce任务:使用hadoop-streaming工具,结合mapper和reducer程序,执行MapReduce作业,处理HDFS上的日志文件。 4. Hive和MySQL的使用: - Hive提供了一个基于Hadoop的数据仓库工具,可以将结构化的数据...

Hadoop框架在诸如日志分析、网络爬虫和科学计算等领域中得到了广泛的应用。 Hadoop的主要优点包括可扩展性、低成本、高效和可靠性。它使用Java语言开发,因此可以在多种软硬件平台上运行。这一点对于资源有限的组织...

在开发Hadoop应用程序时,Eclipse作为Java IDE是开发者常用的选择。为了在Eclipse中运行Hadoop 2.7.3程序,你需要确保正确配置了项目依赖并包含了所有必需的JAR包。以下是你需要知道的关键知识点: 1. **Hadoop环境...

Hadoop是由Apache基金会开发的分布式计算框架,它允许在廉价硬件上运行应用程序,处理和存储海量数据。Hadoop的核心组件包括HDFS(Hadoop Distributed File System)和MapReduce。HDFS提供了高容错性的分布式文件...

在大数据处理领域,Hive 和 Hadoop 是两个关键组件,它们常常被用来处理海量日志数据。本案例中,我们探讨的是如何通过 Hive 分析 Hadoop 集群的日志,并解决在 Eclipse 中运行时遇到的权限问题。该问题表现为:...

随着互联网技术的迅猛发展,各类应用程序和服务所产生的日志数据量日益增长。这些数据包含了丰富的信息,对于理解用户行为、优化系统性能以及提升服务质量具有重要意义。然而,传统的方法在处理这种大规模数据时显得...

这个示例程序“Hadoop示例程序合并文件”旨在演示如何在Hadoop环境下整合多个文件,这对于理解Hadoop分布式文件系统(HDFS)的工作原理至关重要。下面将详细阐述Hadoop的核心组件、HDFS的特性以及如何在Hadoop环境中...

- 在15台小型集群上进行测试,使用WordCount程序处理1.2GB的日志文件,总耗时2分16秒,展示了Hadoop处理大数据的高效性。 5. **Hadoop环境搭建步骤** - **装机阶段** - 安装Ubuntu 10.10,避免在安装过程中更新...

本篇将详细介绍如何配置基于Eclipse的Hadoop应用开发环境。 首先,我们需要了解Hadoop的基本构成。Hadoop主要由两个核心部分组成:HDFS(Hadoop Distributed File System)和MapReduce。HDFS是分布式文件系统,用于...

在大数据处理领域,Hadoop是一个不可或缺的开源框架,它主要用于分布式存储和计算大规模数据集。"hadoop流量统计程序"是基于...通过阅读和分析这些文件,我们可以更好地掌握如何在实际环境中应用Hadoop进行流量统计。

在日志分析系统中,HDFS可以存储来自各种服务器、应用程序的日志文件,MapReduce则负责解析和分析这些日志,提取关键信息。 设计一个基于Hadoop的日志分析系统,首先需要考虑以下几个关键点: 1. 数据采集:通过...