转载自:http://my.oschina.net/ielts0909/blog?catalog=263107&p=2

最近一直忙着各种设计和文档,终于有时间来更新一点儿关于kafka的东西。之前有一篇文章讲述的是kafka Producer端的程序,也就是日志的生产者,这部分比较容易理解,业务系统将运行日志或者业务日志发送到broker中,由broker代为存储。那讲的是如何收集日志,今天要写的是如何获取日志,然后再做相关的处理。

之前写过kafka是讲日志按照topic的形式存储,一个topic会按照partition存在同一个文件夹下,目录在config/server.properties中指定,具体的存储规则可以查看之前的文章:

2 |

log.dir=/tmp/kafka-logs

|

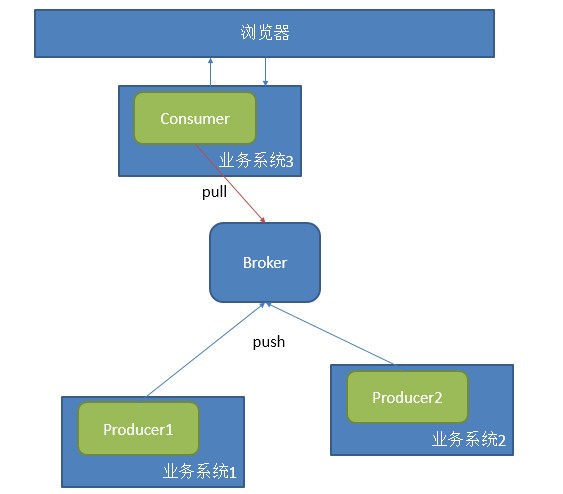

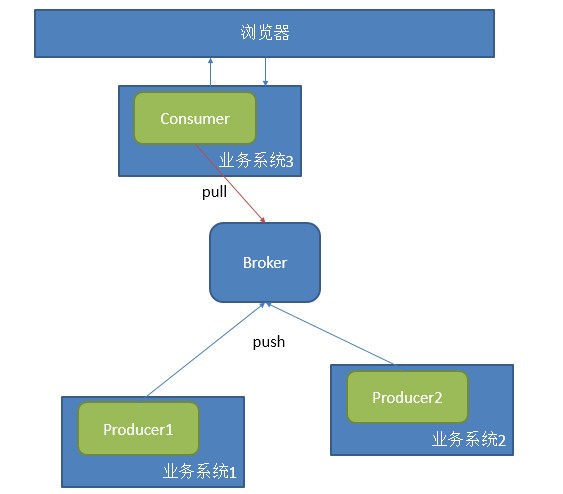

Consumer端的目的就是为了获取log日志,然后做进一步的处理。在这里我们可以将数据的处理按照需求分为两个方向,线上和线下,也可以叫实时和离线。实时处理部分类似于网站里的站短,有消息了马上就推送到前端,这是一种对实时性要求极高的模式,kafka可以做到,当然针对站短这样的功能还有更好的处理方式,我主要将kafka线上消费功能用在了实时统计上,处理一些如实时流量汇总、各系统实时吞吐量汇总等。

这种应用,一般采用一个consumer中的一个group对应一个业务,配合多个producer提供数据,如下图模

式:

采用这种方式处理很简单,采用官网上给的例子即可解决,只是由于版本的问题,代码稍作更改即可:

01 |

package com.a2.kafka.consumer;

|

03 |

import java.util.HashMap;

|

04 |

import java.util.List;

|

06 |

import java.util.Properties;

|

07 |

import java.util.concurrent.ExecutorService;

|

08 |

import java.util.concurrent.Executors;

|

10 |

import kafka.consumer.Consumer;

|

11 |

import kafka.consumer.ConsumerConfig;

|

12 |

import kafka.consumer.KafkaStream;

|

13 |

import kafka.javaapi.consumer.ConsumerConnector;

|

14 |

import kafka.message.Message;

|

15 |

import kafka.message.MessageAndMetadata;

|

17 |

public classCommonConsumer {

|

18 |

publicstatic

void main(String[] args) {

|

20 |

Properties props =new

Properties();

|

21 |

props.put("zk.connect","192.168.181.128:2181");

|

22 |

props.put("zk.connectiontimeout.ms","1000000");

|

23 |

props.put("groupid","test_group");

|

26 |

ConsumerConfig consumerConfig =new

ConsumerConfig(props);

|

27 |

ConsumerConnector consumerConnector = Consumer.createJavaConsumerConnector(consumerConfig);

|

29 |

Map<String, Integer> map=newHashMap<String,Integer>();

|

32 |

Map<String, List<KafkaStream<Message>>> topicMessageStreams =

|

33 |

consumerConnector.createMessageStreams(map);

|

34 |

List<KafkaStream<Message>> streams = topicMessageStreams.get("test");

|

37 |

ExecutorService executor = Executors.newFixedThreadPool(4);

|

40 |

for(finalKafkaStream<Message> stream: streams) {

|

41 |

executor.submit(newRunnable() {

|

43 |

for(MessageAndMetadata<Message> msgAndMetadata: stream) {

|

45 |

System.out.println(msgAndMetadata.message());

|

这是一个user level的API,还有一个low level的API可以从官网找到,这里就不贴出来了。这个consumer是底层采用的是一个阻塞队列,只要一有producer生产数据,那consumer就会将数据打印出来,这是不是十分符合实时性的要求。

当然这里会产生一个很严重的问题,如果你重启一下上面这个程序,那你连一条数据都抓不到,但是你去log文件中明明可以看到所有数据都好好的存在。换句话说,一旦你消费过这些数据,那你就无法再次用同一个groupid消费同一组数据了。我已经把结论说出来了,要消费同一组数据,你可以采用不同的group。

简单说下产生这个问题的原因,这个问题类似于transaction commit,在消息系统中都会有这样一个问题存在,数据消费状态这个信息到底存哪里。是存在consumer端,还是存在broker端。对于这样的争论,一般会出现三种情况:

-

At most once—this handles the first case described. Messages are immediately marked as consumed, so they can't be given out twice, but many failure scenarios may lead to losing messages.

-

At least once—this is the second case where we guarantee each message will be delivered at least once, but in failure cases may be delivered twice.

-

Exactly once—this is what people actually want, each message is delivered once and only once.

第一种情况是将消费的状态存储在了broker端,一旦消费了就改变状态,但会因为网络原因少消费信息,第二种是存在两端,并且先在broker端将状态记为send,等consumer处理完之后将状态标记为consumed,但也有可能因为在处理消息时产生异常,导致状态标记错误等,并且会产生性能的问题。第三种当然是最好的结果。

Kafka解决这个问题采用high water mark这样的标记,也就是设置offset:

1 |

Kafka does two unusual things with respect to metadata. First the stream is partitioned on the brokers into aset

of distinct partitions. The semantic meaning of these partitions is left up to the producer and the producer specifieswhich

partition a message belongs to. Within a partition messages are storedin

the order inwhich

they arrive at the broker, and will be given out to consumersin

that same order. This means that rather than store metadatafor

each message (marking it as consumed, say), we just need to store the"high water mark"

foreach combination of consumer, topic, and partition. Hence the total metadata required to summarize the state of the consumer is actually quite small. In Kafka we refer to this high-water mark as"the

offset" for reasons that will become

clear in

the implementation section.

|

所以在每次消费信息时,log4j中都会输出不同的offset:

1 |

[FetchRunnable-0] INFO : kafka.consumer.FetcherRunnable#info : FetchRunnable-0start fetching topic: test part:

0offset: 0

from 192.168.181.128:9092

|

3 |

[FetchRunnable-0] INFO : kafka.consumer.FetcherRunnable#info : FetchRunnable-0start fetching topic: test part:

0offset: 15

from 192.168.181.128:9092

|

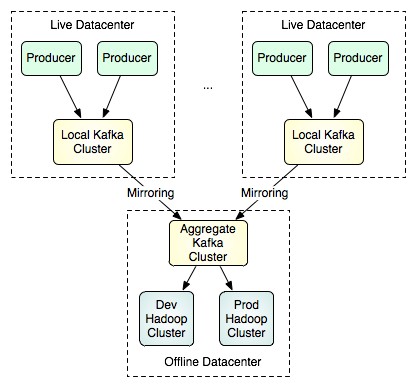

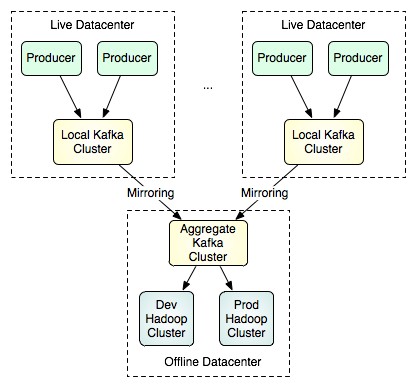

除了采用不同的groupid去抓取已经消费过的数据,kafka还提供了另一种思路,这种方式更适合线下的操作,镜像。

通过一些配置,就可以将线上产生的数据同步到镜像中去,然后再由特定的集群区处理大批量的数据,这种方式可以采用low level的API按照不同的partition和offset来抓取数据,以获得更好的并行处理效果。

分享到:

相关推荐

1. **创建Consumer实例**:首先,我们需要配置一个`Properties`对象,设置必要的参数如bootstrap servers、group id等,然后使用`KafkaConsumer`类的构造函数创建消费者实例。 2. **订阅主题**:消费者通过调用`...

在本文中,我们将深入探讨如何使用C++库RdKafka中的`KafkaConsumer`类来消费Apache Kafka消息。RdKafka是一个高效的C/C++ Kafka客户端,它提供了生产者和消费者API,使得与Kafka集群进行交互变得更加简单。在这个...

《Go-consumergroup:构建基于Golang的Kafka消费者库》 在现代软件开发中,消息队列系统如Apache Kafka扮演着至关重要的角色,它提供了高效、可靠的异步通信能力。而Go语言以其简洁的语法和高性能特性,成为了编写...

KafkaConsumerDemo.java

KafkaConsumer, String> consumer = new KafkaConsumer(props); consumer.subscribe(Arrays.asList("my-topic")); while (true) { ConsumerRecords, String> records = consumer.poll(Duration.ofMillis(100)); ...

在标题"pentaho-kafka-consumer.zip"中,我们看到的是一个专门为Pentaho Kettle定制的Kafka消费者插件的压缩包。 这个压缩包的描述提到了如何在Pentaho环境中安装和使用这个插件。首先,你需要在你的Pentaho Kettle...

【标题】"kafka_hdfs_consumer"涉及到的关键技术是将数据从Kafka消费并存储到HDFS(Hadoop Distributed File System)中。这个过程通常在大数据处理和流处理场景下非常常见,它允许实时或近实时的数据从消息队列流向...

kettle7.1版本整合kafka,kafka插件包含生产者、消费者。直接在kettle安装目录plugins下创建steps目录,并解压下载文件到kettle/plugins/steps目录。具体可查看...

【标题】"phpkafkaconsumer"是一个专门为PHP设计的Kafka消费者库,它不仅提供了基本的Kafka消息消费功能,还特别支持了消费者组(Consumer Group)和再平衡(Rebalance)机制。Kafka是一种分布式流处理平台,常用于...

import org.apache.kafka.clients.consumer.{ConsumerConfig, ConsumerRecord, KafkaConsumer} import java.util.Properties val props = new Properties() props.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, ...

**Kafka插件详解** Kafka插件是Apache Kafka与各种工具集成的重要组成部分,它使得开发者和运维人员能够更方便地在不同的系统中利用Kafka的功能。Kafka是一款分布式流处理平台,常用于构建实时数据管道和流应用,...

Kafka是一个发布/订阅模型的消息队列,它包含生产者(Producer)、消费者(Consumer)和主题(Topic)。生产者负责发布消息到主题,而消费者则订阅这些主题并消费消息。消费者通过消费者组(Consumer Group)进行...

5. **运行与测试**:启动Spring Boot应用,当`kafka.consumer.enabled`设置为`true`时,消费者将开始监听指定的Kafka主题。你可以通过发送消息到该主题来测试消费者的运行情况。 以上就是基于Spring Boot和Spring ...

本文是系列文章的第4篇,第一篇"第二篇第三篇第四篇本文主要介绍了KafkaHighLevelConsumer...同时也希望提供一些语义,例如同一条消息只被某一个Consumer消费(单播)或被所有Consumer消费(广播)。因此,KafkaHightL

KafkaConsumer, String> consumer = new KafkaConsumer(props); consumer.subscribe(Collections.singletonList("myTopic")); // 订阅主题 while (true) { ConsumerRecords, String> records = consumer.poll...

kafka-consumer kafka-consumer是基于Kafka-0.8.20封装的consumer。kafka-consumer的目的在于让业务开发人员不必了解kafka就能开发。并且提供消息过滤功能。 Example 关于kafka-consumer的使用,可以参考如下代码。 ...

2. **消费者(Consumer)**:从Kafka获取消息,可以使用`KafkaConsumer`类来实现。消费者可以订阅一个或多个主题,并且可以采用分组消费,确保每个消息仅被组内的一个消费者处理。 3. **主题(Topic)**:Kafka中的...

- KafkaConsumer:是创建消费者实例的静态接口。 - Consumer:是消费者结构,处理消费相关的逻辑。 - KafkaConsumerImpl:是消费者实现的具体封装。 librdkafka还提供了消费者回调机制,如ConsumeCb和EventCb,它们...

Kafka 的核心概念包括发布者(Producer)、消费者(Consumer)和主题(Topic)。发布者负责生成消息并发送到特定的主题,而消费者则从这些主题中订阅和消费消息。主题被划分为多个分区(Partition),每个分区都是一...