çåïŒè¿æ¯æ¯çïŒââåå§é·ç¹

å¯åïŒè¿æ¯äžå¯åïŒââæ¯æåéæº

ä¹åäžçŽåšè®šè®ºç线æ§åç±»åš,åšåŠå ¶åïŒæ±ïŒè¿æ¯ä»ä¹è¯Žæ³åïŒïŒåªèœå¯¹çº¿æ§å¯åçæ ·æ¬åå€çãåŠææäŸçæ ·æ¬çº¿æ§äžå¯åïŒç»æåŸç®åïŒçº¿æ§åç±»åšçæ±è§£çšåºäŒæ é埪ç¯ïŒæ°žè¿ä¹è§£äžåºæ¥ãè¿å¿ ç¶äœ¿åŸå®çéçšèåŽå€§å€§çŒ©å°ïŒèå®çåŸå€äŒç¹æ们å®åšäžåææŸåŒïŒæä¹åå¢ïŒæ¯åŠææç§æ¹æ³ïŒè®©çº¿æ§äžå¯åçæ°æ®ååŸçº¿æ§å¯åå¢ïŒ

æïŒå ¶ææ³è¯Žæ¥ä¹ç®åïŒæ¥çšäžäžªäºç»Žå¹³é¢äžçåç±»é®é¢äœäŸåïŒäœ äžçå°±äŒæçœãäºå 声æïŒäžé¢è¿äžªäŸåæ¯çœç»æ©å°±æçïŒæäžæ¶æŸäžå°åäœè çæ£ç¡®ä¿¡æ¯ïŒåšæ€åçšïŒå¹¶å è¿äºæèªå·±ç解诎èå·²ã

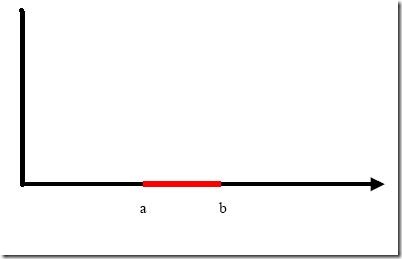

äŸåæ¯äžé¢è¿åŒ åŸïŒ

æ们æ暪蜎äžç«¯ç¹aåbä¹éŽçº¢è²éšåéçææç¹å®äžºæ£ç±»ïŒäž€èŸ¹çé»è²éšåéçç¹å®äžºèŽç±»ãè¯é®èœæŸå°äžäžªçº¿æ§åœæ°æ䞀类æ£ç¡®ååŒä¹ïŒäžèœïŒå 䞺äºç»Žç©ºéŽéç线æ§åœæ°å°±æ¯æçŽçº¿ïŒæŸç¶æŸäžå°ç¬Šåæ¡ä»¶ççŽçº¿ã

äœæ们å¯ä»¥æŸå°äžæ¡æ²çº¿ïŒäŸåŠäžé¢è¿äžæ¡ïŒ

æŸç¶éè¿ç¹åšè¿æ¡æ²çº¿çäžæ¹è¿æ¯äžæ¹å°±å¯ä»¥å€æç¹æå±çç±»å«ïŒäœ åšæšªèœŽäžé䟿æŸäžç¹ïŒç®ç®è¿äžç¹çåœæ°åŒïŒäŒåç°èŽç±»çç¹åœæ°åŒäžå®æ¯0倧ïŒèæ£ç±»çäžå®æ¯0å°ïŒãè¿æ¡æ²çº¿å°±æ¯æ们çç¥çäºæ¬¡æ²çº¿ïŒå®çåœæ°è¡šèŸŸåŒå¯ä»¥å䞺ïŒ

é®é¢åªæ¯å®äžæ¯äžäžªçº¿æ§åœæ°ïŒäœæ¯ïŒäžé¢èŠæ³šæçäºïŒæ°å»ºäžäžªåéyåaïŒ

è¿æ ·g(x)å°±å¯ä»¥èœ¬å䞺f(y)=<a,y>ïŒäœ å¯ä»¥æyåaåå«å垊äžäžïŒçççäžçäºåæ¥çg(x)ãçšå 积ç圢åŒåäœ å¯èœçäžå€ªæž æ¥ïŒå®é äžf(y)ç圢åŒå°±æ¯ïŒ

g(x)=f(y)=ay

åšä»»æ绎床ç空éŽäžïŒè¿ç§åœ¢åŒçåœæ°éœæ¯äžäžªçº¿æ§åœæ°ïŒåªäžè¿å ¶äžçaåyéœæ¯å€ç»Žåé眢äºïŒïŒå 䞺èªåéyç次æ°äžå€§äº1ã

çåºåŠåšåªäºä¹ïŒåæ¥åšäºç»Žç©ºéŽäžäžäžªçº¿æ§äžå¯åçé®é¢ïŒæ å°å°å绎空éŽåïŒåæäºçº¿æ§å¯åçïŒå æ€è¿ä¹åœ¢æäºæ们æåæ³è§£å³çº¿æ§äžå¯åé®é¢çåºæ¬æè·¯ââåé«ç»Žç©ºéŽèœ¬åïŒäœ¿å ¶ååŸçº¿æ§å¯åã

è蜬åæå ³é®çéšåå°±åšäºæŸå°xå°yçæ å°æ¹æ³ãéæŸçæ¯ïŒåŠäœæŸå°è¿äžªæ å°ïŒæ²¡æç³»ç»æ§çæ¹æ³ïŒä¹å°±æ¯è¯ŽïŒçº¯é çååïŒãå ·äœå°æ们çææ¬åç±»é®é¢ïŒææ¬è¢«è¡šç€ºäžºäžå绎çåéïŒå³äœ¿ç»Žæ°å·²ç»åŠæ€ä¹é«ïŒä¹åžžåžžæ¯çº¿æ§äžå¯åçïŒè¿èŠåæŽé«ç空éŽèœ¬åãå ¶äžçéŸåºŠå¯æ³èç¥ã

<!--<br /> <br /> Code highlighting produced by Actipro CodeHighlighter (freeware)<br /> http://www.CodeHighlighter.com/<br /> <br /> -->å°Tips:䞺ä»ä¹è¯Žf(y)=ayæ¯å绎空éŽéçåœæ°?

倧家å¯èœäžæ¶æ²¡çæçœãåæ³äžäžæ们äºç»Žç©ºéŽéçåœæ°å®ä¹

g(x)=ax+b

åéxæ¯äžç»ŽçïŒäžºä»ä¹è¯Žå®æ¯äºç»Žç©ºéŽéçåœæ°å¢ïŒå 䞺è¿æäžäžªåéæ们没ååºæ¥ïŒå®çå®æŽåœ¢åŒå ¶å®æ¯

y=g(x)=ax+b

å³

y=ax+b

ççïŒæå 䞪åéïŒäž€äžªãé£æ¯å 绎空éŽçåœæ°ïŒïŒäœè äºå²çåŒåŒçïŒäºç»Žçãäœè ïŒâŠâŠïŒ

åçç

f(y)=ay

éé¢çyæ¯äžç»ŽçåéïŒé£f(y)æ¯å 绎空éŽéçåœæ°ïŒïŒäœè äºå²çåŒåŒçïŒè¿æ¯äºç»Žçãäœè ïŒâŠâŠïŒ

Â

çšäžäžªå ·äœææ¬åç±»çäŸåæ¥ççè¿ç§åé«ç»Žç©ºéŽæ å°ä»èåç±»çæ¹æ³åŠäœè¿äœïŒæ³è±¡äžäžïŒæ们ææ¬åç±»é®é¢çåå§ç©ºéŽæ¯1000绎çïŒå³æ¯äžªèŠè¢«åç±»çæ档被衚瀺䞺äžäžª1000绎çåéïŒïŒåšè¿äžªç»ŽåºŠäžé®é¢æ¯çº¿æ§äžå¯åçãç°åšæ们æäžäžª2000绎空éŽéç线æ§åœæ°

f(xâ)=<wâ,xâ>+b

泚æåéçå³äžè§æ䞪 âåŠãå®èœå€å°åé®é¢ååŸå¯åãåŒäžç wâåxâéœæ¯2000绎çåéïŒåªäžè¿wâæ¯å®åŒïŒèxâæ¯åéïŒå¥œå§,äž¥æ Œè¯Žæ¥è¿äžªåœæ°æ¯2001绎ç,ååïŒïŒç°åšæ们çèŸå ¥å¢ïŒæ¯äžäžª1000绎çåéxïŒåç±»çè¿çšæ¯å æxåæ¢äžº2000绎çåéxâïŒç¶åæ±è¿äžªåæ¢åçåéxâäžåéwâçå 积ïŒåæè¿äžªå 积çåŒåbçžå ïŒå°±åŸå°äºç»æïŒçç»æ倧äºéåŒè¿æ¯å°äºéåŒå°±åŸå°äºåç±»ç»æã

äœ åç°äºä»ä¹ïŒæä»¬å ¶å®åªå ³å¿é£äžªé«ç»Žç©ºéŽéå 积çåŒïŒé£äžªåŒç®åºæ¥äºïŒåç±»ç»æå°±ç®åºæ¥äºãèä»ç论äžè¯ŽïŒ xâæ¯ç»ç±xåæ¢æ¥çïŒå æ€å¹¿ä¹äžå¯ä»¥æå®å«åxçåœæ°ïŒæäžäžªxïŒå°±ç¡®å®äºäžäžªxâïŒå¯¹å§ïŒç¡®å®äžåºç¬¬äºäžªïŒïŒèwâæ¯åžžéïŒå®æ¯äžäžªäœç»Žç©ºéŽéçåžžéwç»è¿åæ¢åŸå°çïŒæ以ç»äºäžäžªw åxçåŒïŒå°±æäžäžªç¡®å®çf(xâ)åŒäžå ¶å¯¹åºãè¿è®©æ们幻æ³ïŒæ¯åŠèœæè¿æ ·äžç§åœæ°K(w,x),ä»æ¥åäœç»Žç©ºéŽçèŸå ¥åŒïŒåŽèœç®åºé«ç»Žç©ºéŽçå 积åŒ<wâ,xâ>ïŒ

åŠææè¿æ ·çåœæ°ïŒé£ä¹åœç»äºäžäžªäœç»Žç©ºéŽçèŸå ¥x以åïŒ

g(x)=K(w,x)+b

f(xâ)=<wâ,xâ>+b

è¿äž€äžªåœæ°ç计ç®ç»æå°±å®å šäžæ ·ïŒæ们ä¹å°±çšäžç莹åæŸé£äžªæ å°å ³ç³»ïŒçŽæ¥æ¿äœç»ŽçèŸå ¥åŸg(x)éé¢ä»£å°±å¯ä»¥äºïŒå次æéïŒè¿åçg(x)å°±äžæ¯çº¿æ§åœæ°åŠïŒå äžºäœ äžèœä¿è¯K(w,x)è¿äžªè¡šèŸŸåŒéçx次æ°äžé«äº1åŠïŒã

äžå¹žçæ¯ïŒè¿æ ·çK(w,x)ç¡®å®ååšïŒåç°å¡æ¯æ们人类èœè§£å³çé®é¢ïŒå€§éœæ¯å·§åŸäžèœåå·§ïŒç¹æ®åŸäžèœåç¹æ®çé®é¢ïŒæ»æ¯æ°å¥œæäºèœææºåå·§çå°æ¹æèœè§£å³ïŒç±æ€æå°äººç±»ç枺å°ïŒïŒå®è¢«ç§°äœæ žåœæ°ïŒæ žïŒkernelïŒïŒèäžè¿äžæ¢äžäžªïŒäºå®äžïŒåªèŠæ¯æ»¡è¶³äºMerceræ¡ä»¶çåœæ°ïŒéœå¯ä»¥äœäžºæ žåœæ°ãæ žåœæ°çåºæ¬äœçšå°±æ¯æ¥å䞀䞪äœç»Žç©ºéŽéçåéïŒèœå€è®¡ç®åºç»è¿æ䞪åæ¢ååšé«ç»Žç©ºéŽéçåéå 积åŒãå 䞪æ¯èŸåžžçšçæ žåœæ°ïŒä¿ïŒæ诟乊ééœåè¿ïŒæå°±äžæ²äºïŒæïŒïŒã

åæ³æ们äžè诎çæ±äžäžªçº¿æ§åç±»åšïŒå®ç圢åŒåºè¯¥æ¯ïŒ

ç°åšè¿äžªå°±æ¯é«ç»Žç©ºéŽéç线æ§åœæ°ïŒäžºäºåºå«äœç»Žåé«ç»Žç©ºéŽéçåœæ°ååéïŒææ¹äºåœæ°çååïŒå¹¶äžç»wåxéœå äžäº âïŒïŒæ们就å¯ä»¥çšäžäžªäœç»Žç©ºéŽéçåœæ°ïŒåäžæ¬¡çïŒè¿äžªäœç»Žç©ºéŽéçåœæ°å°±äžåæ¯çº¿æ§çåŠïŒæ¥ä»£æ¿ïŒ

ååç°ä»ä¹äºïŒf(xâ) åg(x)éçαïŒyïŒbå šéœæ¯äžæ ·äžæ ·çïŒè¿å°±æ¯è¯ŽïŒå°œç®¡ç»çé®é¢æ¯çº¿æ§äžå¯åçïŒäœæ¯æ们就硬åœå®æ¯çº¿æ§é®é¢æ¥æ±è§£ïŒåªäžè¿æ±è§£è¿çšäžïŒå¡æ¯èŠæ±å 积çæ¶åå°±çšäœ éå®çæ žåœæ°æ¥ç®ãè¿æ ·æ±åºæ¥çαååäœ éå®çæ žåœæ°äžç»åïŒå°±åŸå°åç±»åšåŠïŒ

æçœäºä»¥äžè¿äºïŒäŒèªç¶çé®æ¥äžæ¥äž€äžªé®é¢ïŒ

1ïŒ æ¢ç¶æåŸå€çæ žåœæ°ïŒéå¯¹å ·äœé®é¢è¯¥æä¹éæ©ïŒ

2ïŒ åŠæ䜿çšæ žåœæ°åé«ç»Žç©ºéŽæ å°åïŒé®é¢ä»ç¶æ¯çº¿æ§äžå¯åçïŒé£æä¹åïŒ

第äžäžªé®é¢ç°åšå°±å¯ä»¥åçäœ ïŒå¯¹æ žåœæ°çéæ©ïŒç°åšè¿çŒºä¹æ富ååïŒåç§å®éªçè§å¯ç»æïŒäžå æ¯ææ¬åç±»ïŒç确衚æïŒæäºé®é¢çšæäºæ žåœæ°ææåŸå¥œïŒçšåŠäžäºå°±åŸå·®ïŒäœæ¯äžè¬æ¥è®²ïŒåŸååºæ žåœæ°æ¯äžäŒåºå€ªå€§åå·®çäžç§ïŒéŠéãïŒæåææ¬å类系ç»çæ¶åïŒäœ¿çšåŸååºæ žåœæ°ïŒæ²¡æåæ°è°äŒçæ åµäžïŒç»å€§éšåç±»å«çåç¡®åå¬åéœåš85%以äžïŒå¯è§ãèœç¶libSVMçäœè ææºä»è®€äžºææ¬åç±»çšçº¿æ§æ žåœæ°æææŽäœ³ïŒåŸ èè¯ïŒ

对第äºäžªé®é¢ç解å³ååŒåºäºæ们äžäžèçäž»é¢ïŒæŸåŒåéã

![clip_image002[7] clip_image002[7]](http://www.blogjava.net/images/blogjava_net/zhenandaci/WindowsLiveWriter/SVM_10595/clip_image002%5B7%5D_thumb.gif)

![clip_image002[9] clip_image002[9]](http://www.blogjava.net/images/blogjava_net/zhenandaci/WindowsLiveWriter/SVM_10595/clip_image002%5B9%5D_thumb.gif)

![clip_image002[11] clip_image002[11]](http://www.blogjava.net/images/blogjava_net/zhenandaci/WindowsLiveWriter/SVM_10595/clip_image002%5B11%5D_thumb.gif)

çžå ³æšè

### SVMå ¥éšïŒSVMçå «è¡ç®ä» #### 1.1 SVMçåºæ¬æŠå¿µ æ¯æåéæºïŒSupport Vector MachineïŒç®ç§°SVMïŒæ¯äžç§çç£åŠä¹ æš¡åïŒäž»èŠçšäºåç±»åååœåæãSVMææ©æ¯ç±CortesåVapnikåš1995幎æåºçãå ¶æ žå¿ææ³æ¯åšç¹åŸ...

SVMçç¬ç¹ä¹å€åšäºïŒå®å¹¶äžåæ ·æ¬ç»ŽåºŠç圱åïŒå³äœ¿é¢å¯¹é«ç»Žæ°æ®ä¹èœææå°å·¥äœïŒè¿æ¯ç±äºSVMçæ žå¿ææ³ââæ žåœæ°çåŒå ¥ïŒäœ¿åŸåæ¬é线æ§å¯åçé®é¢éè¿æ å°å°é«ç»Žç©ºéŽååŸçº¿æ§å¯åã æºåšåŠä¹ çæ¬èŽšæ¯æŸå°äžäžªæš¡å...

SVMçäžäžªå ³é®äŒç¹åšäºå®äžåæ ·æ¬ç»ŽåºŠç圱åïŒå³äœ¿åšé«ç»Žç©ºéŽäžïŒSVMä¹èœææå·¥äœïŒè¿åŸçäºå ¶åŒå ¥çæ žåœæ°ææ¯ïŒå®èœå€å°äœç»ŽèŸå ¥æ°æ®æ å°å°é«ç»Žç©ºéŽïŒä»èå®ç°é线æ§åç±»ã ç»æé£é©æå°åæ¯SVMäŒåç®æ çæ žå¿ã...

æ žåœæ°åšSVMäžæ®æŒçæå ¶å ³é®çè§è²ãå®å 讞æ们å°æ°æ®ä»åå§ç©ºéŽæ å°å°äžäžªæŽé«ç»Žç空éŽäžïŒèäžå¿ æŸåŒå°è®¡ç®è¿äžªæ å°ãè¿äžªè¿çšè¢«ç§°äžºæ žæå·§ãéè¿æ žæå·§ïŒåæ¬åšåå§ç©ºéŽäžçº¿æ§äžå¯åçæ°æ®ïŒåšé«ç»Žç©ºéŽäžå¯èœäŒ...

å ¶æ žå¿æŠå¿µå æ¬è¶ å¹³é¢ãéŽéãæ¯æåéåæ žåœæ°ïŒéè¿è¿äºå·¥å ·ïŒSVMèœå€åšé«ç»Žç©ºéŽäžæŸå°æ䜳çå³ç蟹çãåšå®é åºçšäžïŒSVMå¯ä»¥åºçšäºåç§é¢åïŒåŠææ¬åç±»ãåŸåè¯å«ãçç©ä¿¡æ¯åŠçãéè¿æ·±å ¥ç解SVMçå·¥äœåçå...

é线æ§èœååéè¿æ žåœæ°å®ç°ïŒåŠåŸååºåœæ°ïŒRBFïŒãå€é¡¹åŒæ žæsigmoidæ žïŒå®ä»¬å°åæ¬çº¿æ§äžå¯åçæ°æ®èœ¬æ¢äžºçº¿æ§å¯åïŒäœ¿åŸSVMåšå€çé线æ§é®é¢æ¶äŸç¶ææã æ€å€ïŒSVMè¿æå ¶ä»äžäºç¹æ§ïŒåŠäœ¿çšæ¯æåéïŒSupport ...

- é线æ§å¯åæ¶ïŒSVMåŒå ¥æ žåœæ°ïŒå°åå§ç¹åŸç©ºéŽæ å°å°é«ç»Žç©ºéŽïŒäœ¿åŸåšé«ç»Žç©ºéŽäžå¯ä»¥æŸå°äžäžªçº¿æ§è¶ å¹³é¢è¿è¡åç±»ã 3. **æ倧éŽé**ïŒ SVMçç®æ æ¯æŸå°å ·ææ倧éŽéçè¶ å¹³é¢ïŒéŽéïŒmarginïŒå®ä¹äžºåç±»è¶ å¹³é¢äž...

åžžçšçæ žåœæ°å æ¬å€é¡¹åŒæ žãåŸååºåœæ°æ žïŒRBFïŒçã #### SVMçåºçšåºæ¯ - **ææ¬åç±»**ïŒSVMå¯ä»¥çšäºè¯å«ææ¬äžçæ æåŸåãäž»é¢åç±»çã - **åŸåè¯å«**ïŒåšè®¡ç®æºè§è§é¢åïŒSVM被广æ³åºçšäºå¯¹è±¡è¯å«åå类任å¡...

- åæ°éæ©ïŒéæ©åéçæ žåœæ°ååæ° \(C\) éèŠç»éªïŒå¯¹ç»ææèŸå€§åœ±åã - 解éæ§èŸå·®ïŒæ žåœæ°å¯ŒèŽå³ç蟹çååŸå€æïŒéŸä»¥çŽè§è§£éã ### 7. SVMçåºçš SVM已被广æ³åºçšåšåç§é¢åïŒåŠææ¬åç±»ãåŸåè¯å«ãçç©...

SVMçäžäžªå ³é®äŒç¹æ¯å®å ³æ³šçæ¯VC绎ïŒè¿æå³çå³äœ¿åšé«ç»Žç©ºéŽäžïŒSVMä¹èœææå°å€çé®é¢ïŒè¿æ¯å 䞺å®åŒå ¥äºæ žåœæ°ïŒäœ¿åŸé«ç»Žæ°æ®èœåšäœç»Žç©ºéŽå è¿è¡æææäœïŒç¹å«éåææ¬åç±»çåºçšã ç»æé£é©æå°åæ¯SVMç®æ³ç...

æ žåœæ°çäžäžªéèŠç¹æ§æ¯å®èœå€å°æ°æ®ä¹éŽçå€æå ³ç³»èœ¬å䞺ç®åçå 积è¿ç®ïŒè¿äœ¿åŸSVMåšå€çé线æ§é®é¢æ¶ååŸæŽå é«æã ## SVMåšå®é äžçåºçš SVMç区项åšäºå®èœå€åŸå¥œå°è§£å³å°æ ·æ¬ãé线æ§åé«ç»Žæ°æ®çåç±»é®é¢ã...

### SVMå ¥éšç¥è¯è¯Šè§£ #### äžãSVMæŠè¿°äžèµ·æº æ¯æåéæºïŒSupport Vector MachineïŒç®ç§°SVMïŒæ¯äžç§æçç£çåŠä¹ æš¡åïŒäž»èŠçšäºåç±»åååœåæãå®æ¯ç±CortesåVapnikåš1995幎éŠæ¬¡æåºçãèªé£æ¶èµ·ïŒSVMå å ¶åš...

### SVMå ¥éšç¥è¯ç¹è¯Šè§£ #### äžãSVMç®ä»äžèæ¯ **æ¯æåéæº**(Support Vector Machine, SVM)æ¯ç±CortesåVapnikåš1995幎éŠæ¬¡æåºçäžç§æºåšåŠä¹ æš¡åãäœäžºäžç§çç£åŠä¹ æ¹æ³ïŒSVMåšå€çå°æ ·æ¬ãé线æ§åé«ç»Žæ°æ®...

SVMå ¥éšæçšïŒæ¯æåéæºïŒ SVMïŒSupport Vector MachineïŒïŒä¹ç§°äžºæ¯æåéæºïŒæ¯äžç§çç£åŠä¹ ç®æ³ïŒç±CortesåVapnikäº1995幎éŠå æåºãå®åšè§£å³å°æ ·æ¬ãé线æ§åé«ç»Žæš¡åŒè¯å«äžè¡šç°åºè®žå€ç¹æçäŒå¿ïŒå¹¶èœå€æšå¹¿...

è¿äžç¹åšå€çåŠææ¬åç±»çé«ç»Žæ°æ®æ¶æŸåŸå°€äžºéèŠïŒå 䞺SVMéè¿åŒå ¥æ žåœæ°ïŒå¯ä»¥å°åå§ç¹åŸç©ºéŽæ å°å°äžäžªæŽé«ç»Žç空éŽïŒåšé£éåæ¬çº¿æ§äžå¯åçæ°æ®å¯èœååŸå¯åã ç»æé£é©æå°åæ¯SVMäŒåç®æ çæ žå¿ãå®äžä» èè...

### SVMå ¥éšïŒäžïŒäžºäœéèŠæ žåœæ° #### æ žå¿ç¥è¯ç¹æŠè¿° æ¯æåéæºïŒSupport Vector MachineïŒç®ç§°SVMïŒæ¯äžç§å¹¿æ³åºçšäºæºåšåŠä¹ é¢åçåç±»äžååœåæç®æ³ãæ¬ææ¡£æšåšè§£é䞺ä»ä¹SVMäžéèŠåŒå ¥æ žåœæ°ïŒKernel ...

åšå€çé线æ§å¯åé®é¢æ¶ïŒSVMéè¿äœ¿çšæ žåœæ°å°äœç»Žç©ºéŽäžçé线æ§é®é¢èœ¬æ¢äžºé«ç»Žç©ºéŽäžç线æ§é®é¢ãåžžè§çæ žåœæ°å æ¬å€é¡¹åŒæ žãåŸååºæ žïŒRadial Basis Function, RBFïŒçãéè¿éæ©åéçæ žåœæ°ïŒSVMèœå€ææå°å€ç...

- **äœçš**: éè¿æ žåœæ°å¯ä»¥å°äœç»Žç©ºéŽäžçé线æ§é®é¢èœ¬æ¢äžºé«ç»Žç©ºéŽäžç线æ§é®é¢ïŒä»è解å³äºé线æ§åç±»çé®é¢ã - **åžžè§æ žåœæ°**: - **线æ§æ ž**: \(K(u, v) = u \cdot v\) - **å€é¡¹åŒæ ž**: \(K(u, v) = (u \...

### SVMå ¥éšïŒæ¯æåéæºè¯Šè§£ #### äžãSVMç®ä» æ¯æåéæºïŒSupport Vector MachineïŒç®ç§°SVMïŒæ¯ç±CortesåVapnikäº1995幎éŠæ¬¡æåºçæºåšåŠä¹ ç®æ³ãå®æ¯äžç§çç£åŠä¹ æ¹æ³ïŒåšè§£å³å°æ ·æ¬ãé线æ§åé«ç»Žæš¡åŒè¯å«ç...

æ»çæ¥è¯ŽïŒSVMæ¯äžç§åºäºç»è®¡åŠä¹ ç论çé«ææºåšåŠä¹ æš¡åïŒå®éè¿æå°åç»æé£é©åå©çšæ žåœæ°å®ç°é线æ§åç±»ïŒå°€å ¶éçšäºå°æ ·æ¬åé«ç»Žæ°æ®åºæ¯ãSVMçè¿äºç¹æ§äœ¿å ¶åšæš¡åŒè¯å«ãææ¬åç±»ã计ç®æºè§è§çé¢åæç广æ³ç...