魏仁言 2010.6.8

Hadoop 是一个开源的可运行于大规模集群上的分布式并行编程框架,由于分布式存储对于分布式编程来说是必不可少的,这个框架中还包含了一个分布式文件系统 HDFS( Hadoop Distributed File System ) 。也许到目前为止,Hadoop 还不是那么广为人知,其最新的版本号也仅仅是 0.20 ,距离 1.0 似乎都还有很长的一段距离,但提及 Hadoop 一脉相承的另外两个开源项目 Nutch 和 Lucene ( 三者的创始人都是 Doug Cutting ), 那绝对是大名鼎鼎。Lucene 是一个用 Java 开发的开源高性能全文检索工具包,它不是一个完整的应用程序,而是一套简单易用的 API 。在全世界范围内,已有无数的软件系统,Web 网站基于 Lucene 实现了全文检索功能,后来 Doug Cutting 又开创了第一个开源的 Web 搜索引擎它在 Lucene 的基础上增加了网络爬虫和一些和 Web 相关的功能,一些解析各类文档格式的插件等,此外,Nutch 中还包含了一个分布式文件系统用于存储数据。从 Nutch 0.8.0 版本之后,Doug Cutting 把 Nutch 中的分布式文件系统以及实现 MapReduce 算法的代码独立出来形成了一个新的开源项 Hadoop 。Nutch 也演化为基于 Lucene 全文检索以及 Hadoop 分布式计算平台的一个开源搜索引擎。

基于 Hadoop, 你可以轻松地编写可处理海量数据的分布式并行程序,并将其运行于由成百上千个结点组成的大规模计算机集群上。从目前的情况来看,Hadoop 注定会有一个辉煌的未来:" 云计算" 是目前灸手可热的技术名词,全球各大 IT 公司都在投资和推广这种新一代的计算模式,而 Hadoop 又被其中几家主要的公司用作其" 云计算" 环境中的重要基础软件,如: 雅虎正在借助 Hadoop 开源平台的力量对抗 Google, 除了资助 Hadoop 开发团队外,还在开发基于 Hadoop 的开源项目 Pig, 这是一个专注于海量数据集分析的分布式计算程序。Amazon 公司基于 Hadoop 推出了 Amazon S3 ( Amazon Simple Storage Service ) ,提供可靠,快速,可扩展的网络存储服务,以及一个商用的云计算平台 Amazon EC2 ( Amazon Elastic Compute Cloud ) 。在 IBM 公司的云计算项目--" 蓝云计划" 中,Hadoop 也是其中重要的基础软件。Google 正在跟IBM 合作,共同推广基于 Hadoop 的云计算。

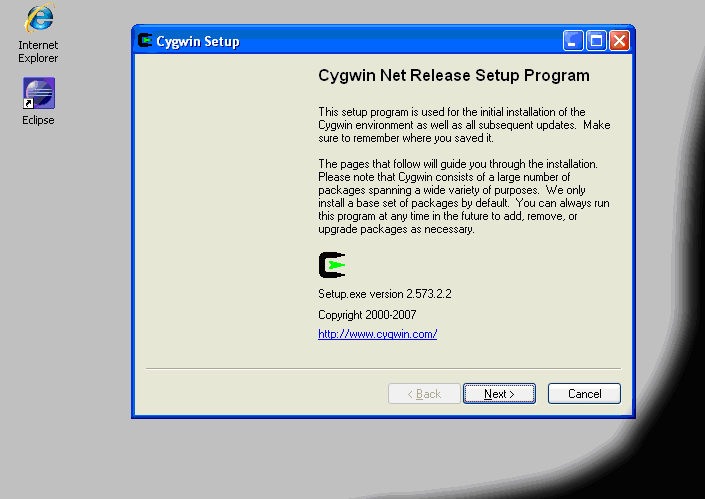

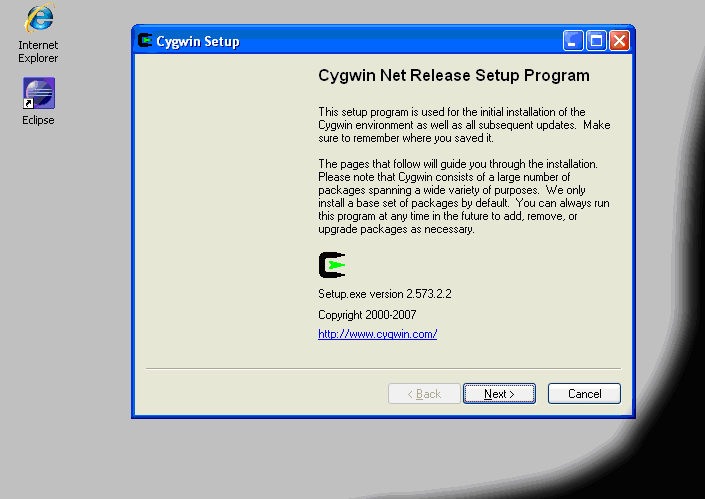

主要是在 Linux 平台下运行的,如果想在 Windows 平台下运行,你需要安装 Cygwin 才能运行, Hadoop 脚本。

下载 Cygwin 安装包

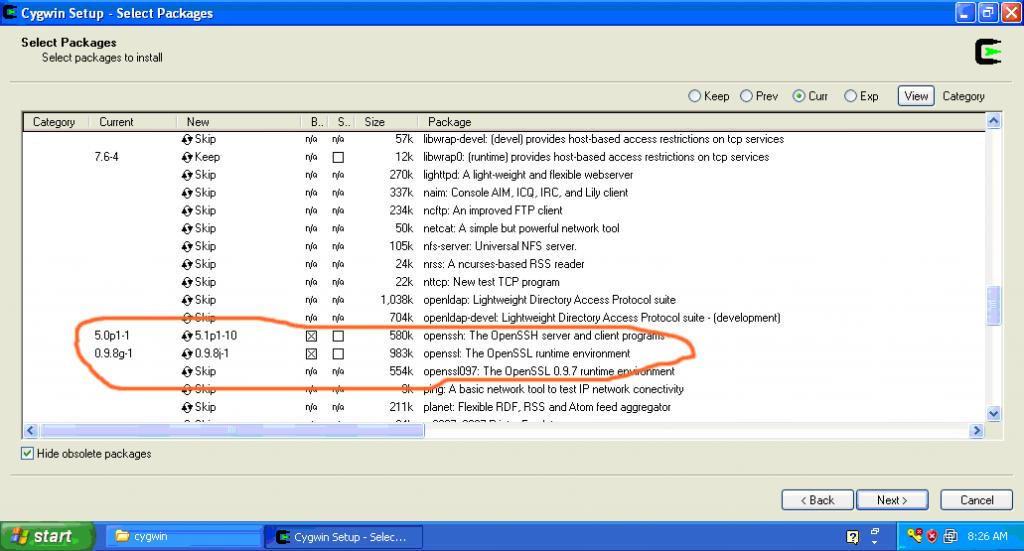

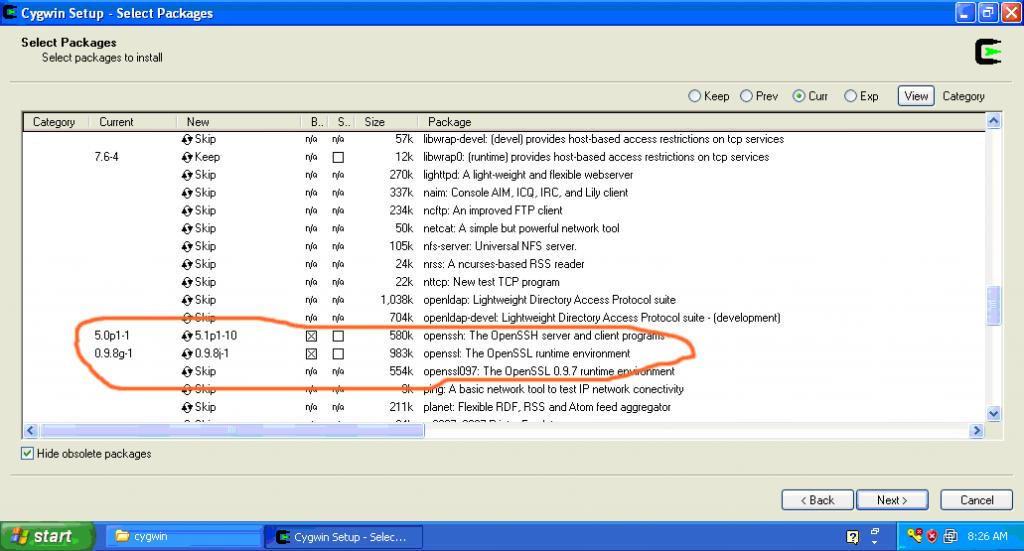

安装时一定要确认选择“ openssh ”安装包。如下图:

Hadoop 分布式运行需要 SSH 。所以这一部分介绍在 Cygwin 下配置 SSH 守护进程。

打开 Cygwin 命令环境

· When asked if privilege separation should be used, answer .

记着一定要答no, 否则用Hadoop-Ecliple Plugin 插件进行开发时,会提示你没有权限操作文件,不能写等错误。(我因为这个问题头痛了好长时间,最后才找到是这里出现问题的。)

· When asked if sshd should be installed as a service, answer

· When asked about the value of CYGWIN environment variable enter.

配置完后,启动 SSHD 守护进程

运行: n et start sshd 或者通过 Windows 服务,启动 CYGWINSSHD 服务 .

想要停止服务运行: n et stop sshd 就可以了

$ ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

$ cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

测试

最后运行以下命令测试

ssh localhost

如果没有问题会提示以下内容: The authenticity of host 'localhost (127.0.0.1)' can't be established. RSA key fingerprint is 08:03:20:43:48:39:29:66:6e:c5:61:ba:77:b2:2f:55. Are you sure you want to continue connecting (yes/no)? Warning: Permanently added 'localhost' (RSA) to the list of known hosts. rywei@localhost's password:

会提示输入你机子的登录密码,输入无误后,会出现文本图形,类似于欢迎的提示:

The Hippo says: Welcome to

如果你不想每次都要输入密码,可以执行以下命令即可

$ ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

$ cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

a. 从Hadoop 网站下载最新的安装包( 当前版本

解压hadoop-0.20.2 安装包到你的主目录(/home/username/)

修改conf/hadoop-env.sh 文件,将export JAVA_HOME 的值修改为你机上的jdk 安装目录,比如/cygdrive/d/tools/jdk1.6.0_03 ,/cygdrive 是Cygwin 安装成功后系统的根目录 如果你的JDK 安装在“C:\Program Files\Java\jdk1.6.0_20

如:export JAVA_HOME='C:\Program Files\Java\jdk1.6.0_20'

c. 在Hadoop 主目录内创建logs 目录,用以存放Hadoop 日志信息

Hadoop 可以用以下三种支持的模式中的一种启动 Hadoop 集群:

默认情况下, Hadoop 被配置成以非分布式模式运行的一个独立 Java 进程。这对调试非常有帮助。

下面的实例将已解压的 conf 目录拷贝作为输入,查找并显示匹配给定正则表达式的条目。输出写入到指定的 output 目录。

$ mkdir input

$ cp conf/*.xml input

$ bin/hadoop jar hadoop-*-examples.jar grep input output 'dfs[a-z.]+'

$ cat output/*

Hadoop 可以在单节点上以所谓的伪分布式模式运行,此时每一个 Hadoop 守护进程都作为一个独立的 Java 进程运行。

使用如下配置 :

conf/core-site.xml :

<name>fs.default.name</name>

<value>hdfs://localhost:9000</value>

<name>dfs.replication</name>

<value>1</value>

<name>mapred.job.tracker</name>

<value>localhost:9001</value>

在 Cygwin 下 必须设置中间的暂存目录,否则会出错的

<name>mapred.child.tmp</name>

<value>/home/hadoop-0.20.1/temp</value>

注:我就是忘记设置这个参数,代码总是不能成功运行, 产生如下错误:

10/05/04 09:15:50 WARN mapred.JobClient: Use GenericOptionsParser for parsing the arguments. Applications should implement Tool for the same.

10/05/04 09:15:50 INFO mapred.FileInputFormat: Total input paths to process : 4

10/05/04 09:15:51 INFO mapred.JobClient: Running job: job_201005040912_0002

10/05/04 09:15:52 INFO mapred.JobClient: map 0% reduce 0%

10/05/04 09:15:58 INFO mapred.JobClient: Task Id : attempt_201005040912_0002_m_000006_0, Status : FAILED

java.io.FileNotFoundException: File C:/tmp/hadoop-SYSTEM/mapred/local/taskTracker/jobcache/job_201005040912_0002/attempt_201005040912_0002_m_000006_0/work/tmp does not exist.

at org.apache.hadoop.fs.RawLocalFileSystem.getFileStatus(RawLocalFileSystem.java:420)

at org.apache.hadoop.fs.FilterFileSystem.getFileStatus(FilterFileSystem.java:244)

at org.apache.hadoop.mapred.TaskRunner.setupWorkDir(TaskRunner.java:520)

at org.apache.hadoop.mapred.Child.main(Child.java:143)

10/05/04 09:16:03 INFO mapred.JobClient: Task Id : attempt_201005040912_0002_m_000006_1, Status : FAILED

java.io.FileNotFoundException: File C:/tmp/hadoop-SYSTEM/mapred/local/taskTracker/jobcache/job_201005040912_0002/attempt_201005040912_0002_m_000006_1/work/tmp does not exist.

at org.apache.hadoop.fs.RawLocalFileSystem.getFileStatus(RawLocalFileSystem.java:420)

at org.apache.hadoop.fs.FilterFileSystem.getFileStatus(FilterFileSystem.java:244)

at org.apache.hadoop.mapred.TaskRunner.setupWorkDir(TaskRunner.java:520)

at org.apache.hadoop.mapred.Child.main(Child.java:143)

格式化一个新的分布式文件系统:

$ bin/hadoop namenode -format

启动 Hadoop 守护进程:

$ bin/start-all.sh

Hadoop 守护进程的日志写入到 ${HADOOP_LOG_DIR} 目录 ( 默认是 ${HADOOP_HOME}/logs ).

浏览 NameNode 和 JobTracker 的网络接口,它们的地址默认为:

将输入文件拷贝到分布式文件系统:

$ bin/hadoop fs -put conf input

运行发行版提供的示例程序:

$ bin/hadoop jar hadoop-*-examples.jar grep input output 'dfs[a-z.]+'

将输出文件从分布式文件系统拷贝到本地文件系统查看:

$ bin/hadoop fs -get output output

$ cat output/*

在分布式文件系统上查看输出文件:

$ bin/hadoop fs -cat output/*

完成全部操作后,停止守护进程:

$ bin/stop-all.sh

在Hadoop 根目录里,contrib\eclipse-plugin 文件夹下有,Hadoop 在Eclipse 的插件hadoop-0.20.2-eclipse-plugin.jar 。将其拷贝到Eclipse 的plugins 目录下。

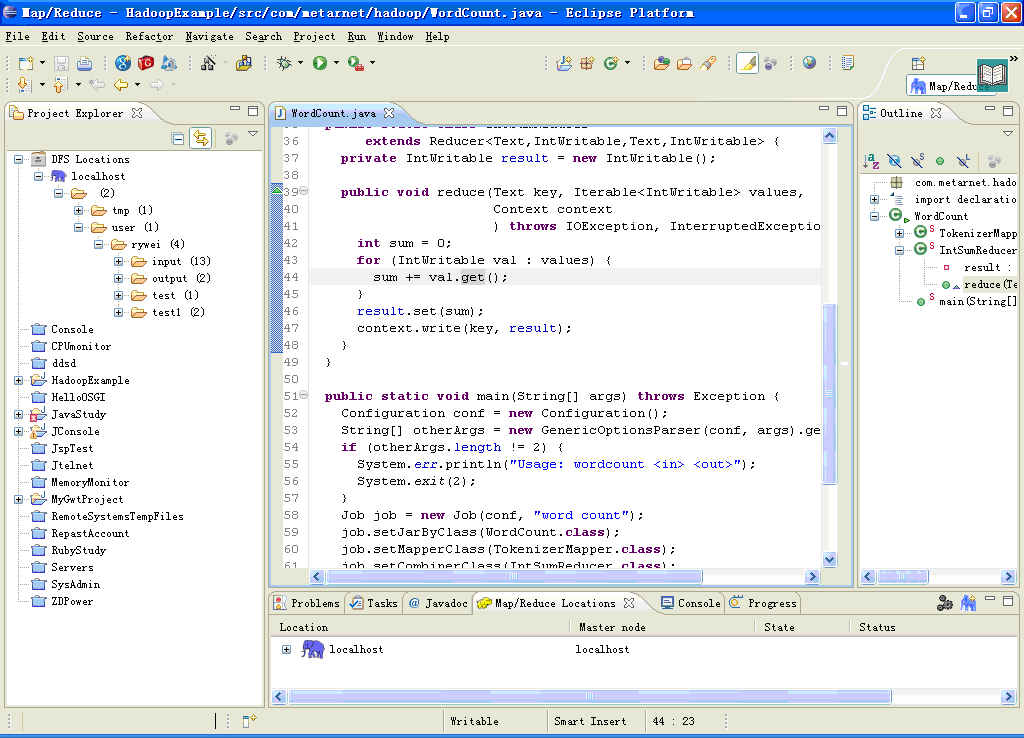

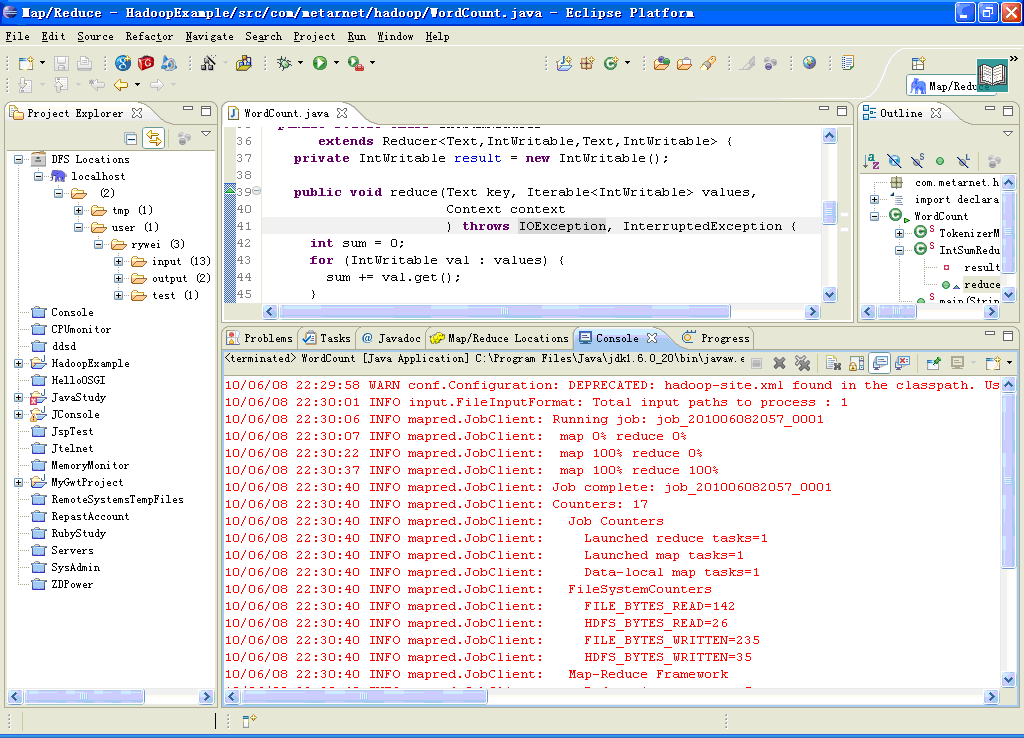

启动Eclipse 后,你将看到如下界面:

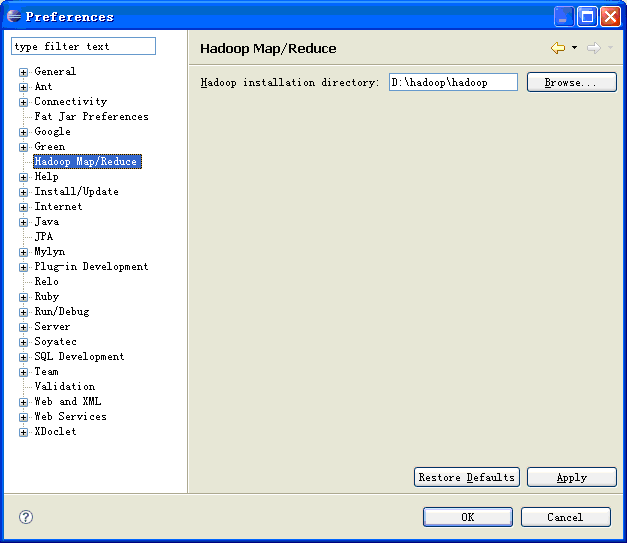

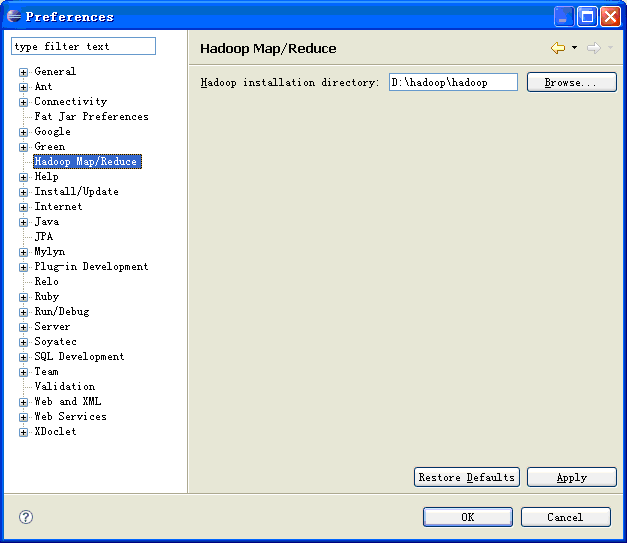

点击 Eclipse 主菜单上 Windows->Preferences, 然后在左侧选择 Hadoop Home Directory, 设定你的 Hadoop 主目录, 如图一所示:

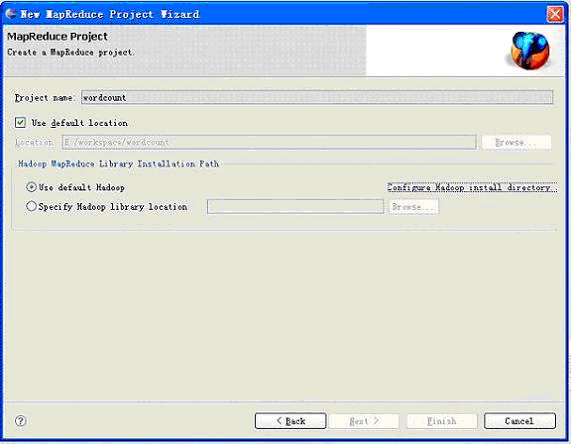

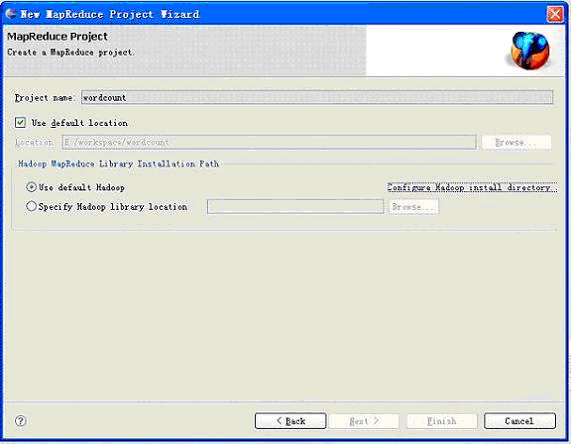

点击 Eclipse 主菜单上 File->New->Project, 在弹出的对话框中选择 MapReduce Project, 输入 project name 如 wordcount, 然后点击 Finish 即可。, 如图所示:

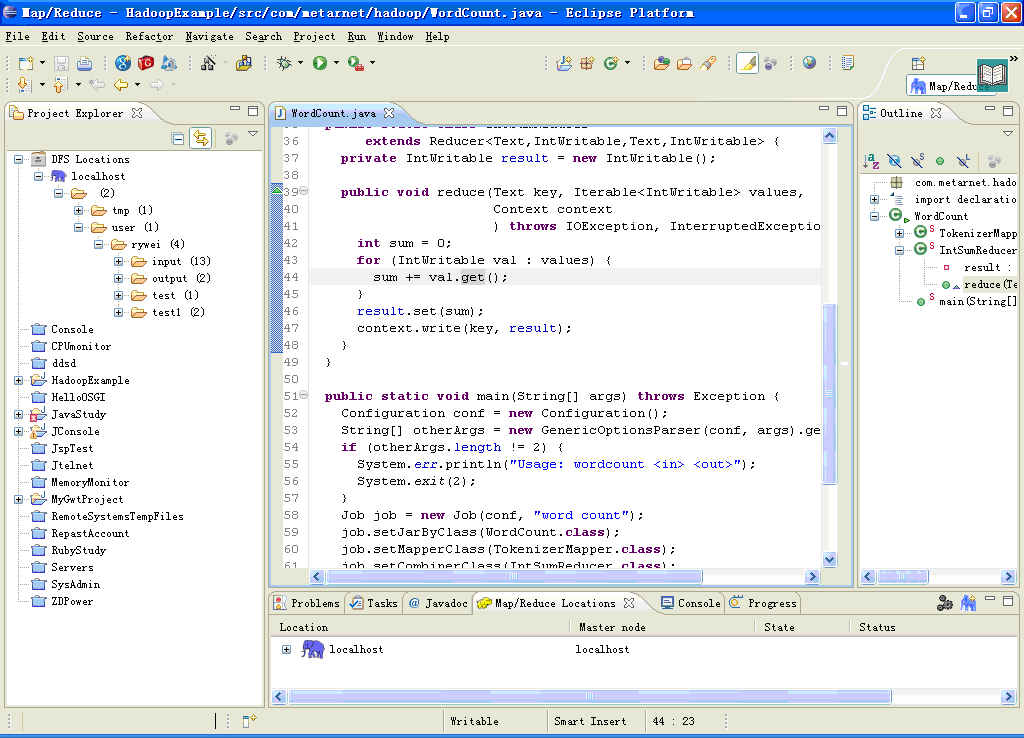

此后,你就可以象一个普通的 Eclipse Java project 那样,添加入 Java 类,比如你可以定义一个 WordCount 类。最简单的方法,就是将在Hadoop 主目录的src\example\ 下的WordCount 拷贝过来。

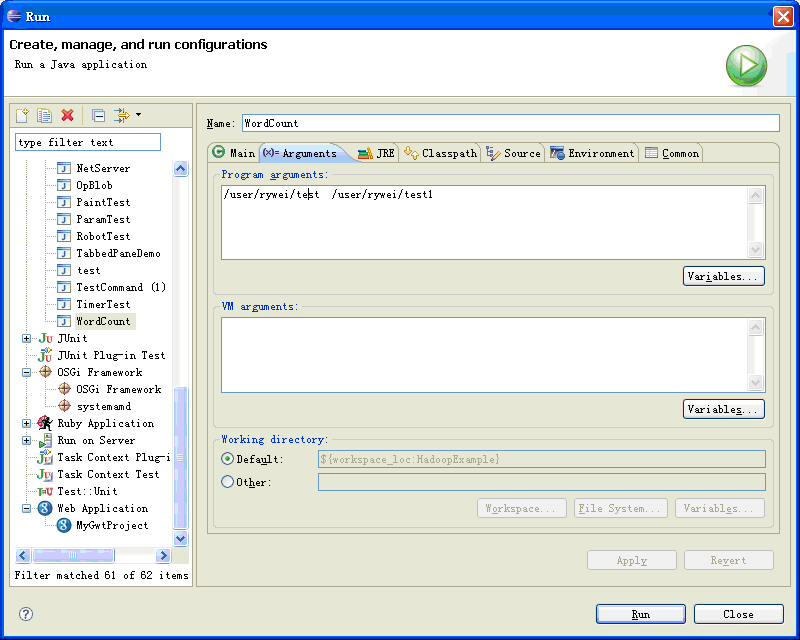

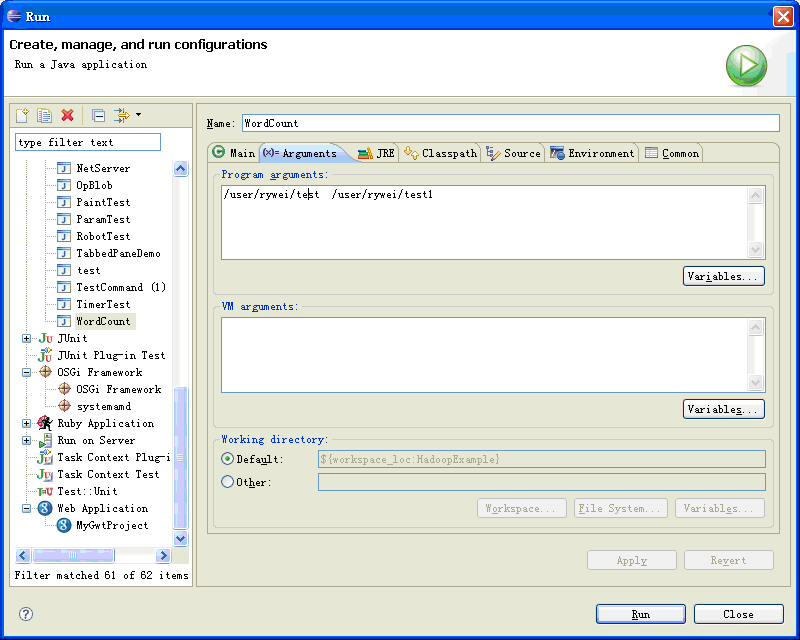

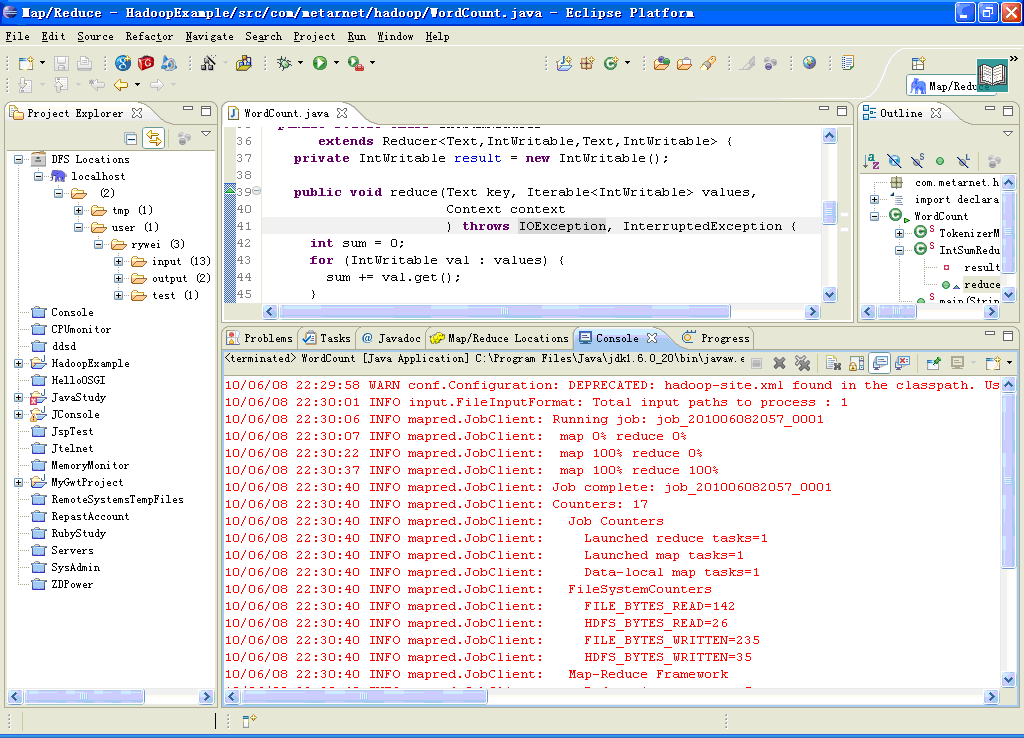

如图三所示,设定程序的运行参数: 输入目录和输出目录之后,你就可以在 Eclipse 中运行 wordcount 程序了,当然,你也可以设定断点,调试程序。

注:/user/rywei/test 和/user/rywei/test1 为HDFS 文件系统的路径。/user/rywei/tes 为输入目录, /user/rywei/test1 为执行输出目录。

打开 Map/Reduce perspective, 在菜单内选中 选择 "Other" 菜单, , 从 perspectives 列表选中 " Map/Reduce " .

DFS Locations 内可以查看 HDFS 文件系统内的文件,可以进行新增,删除等操作。

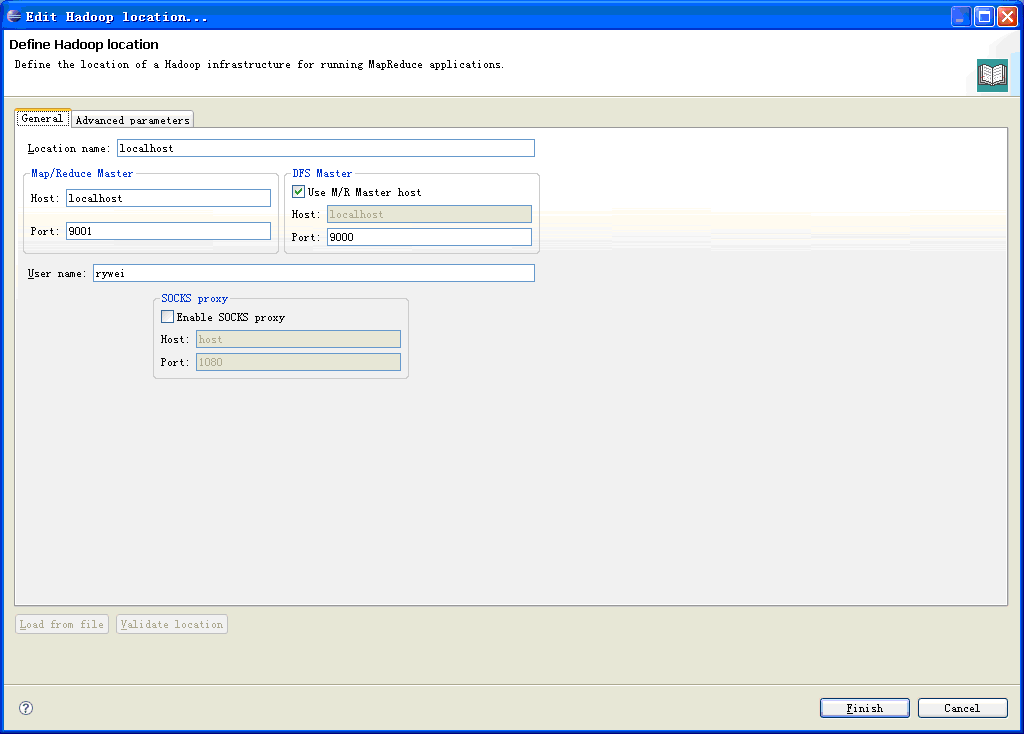

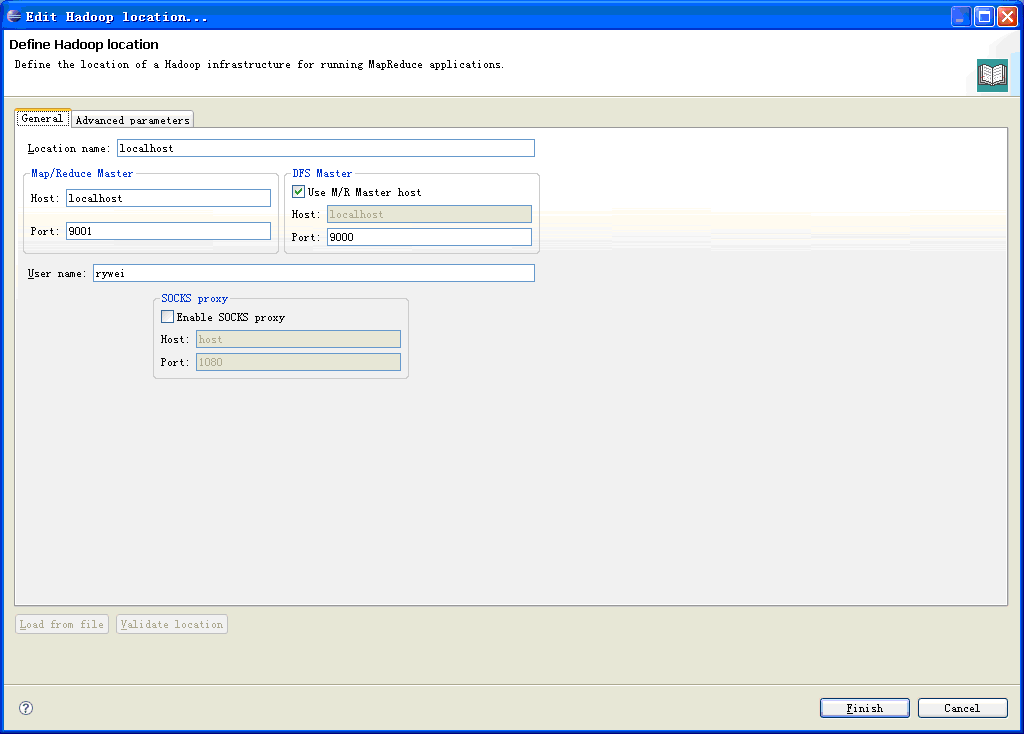

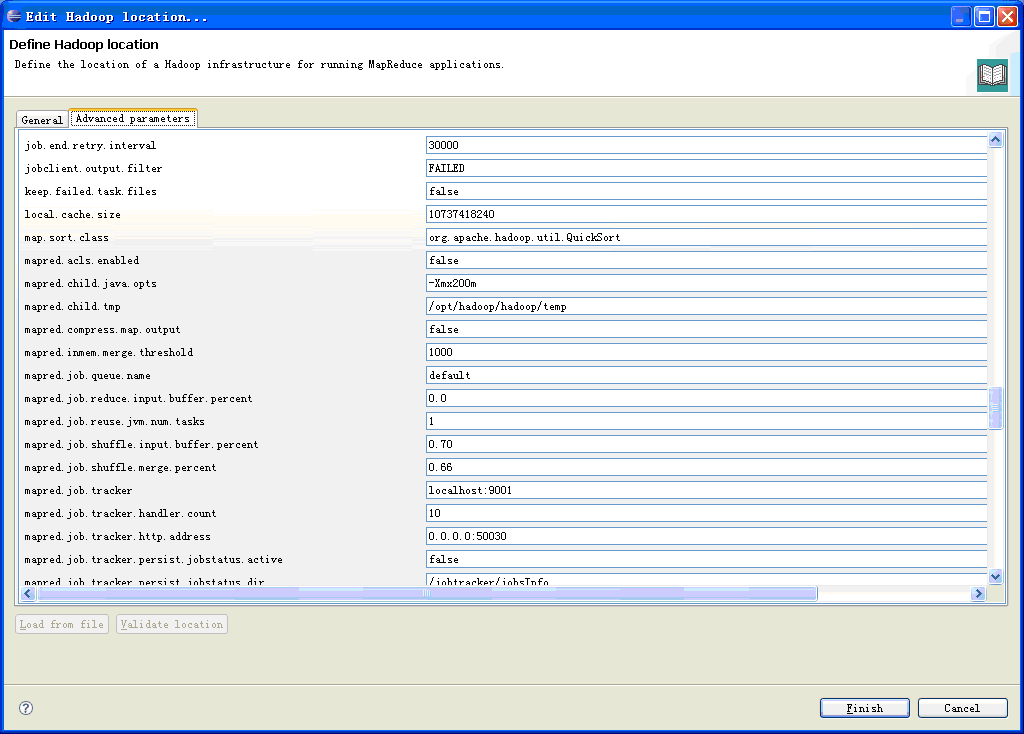

Location Name -- localhost Map/Reduce Master Host -- localhost DFS Master

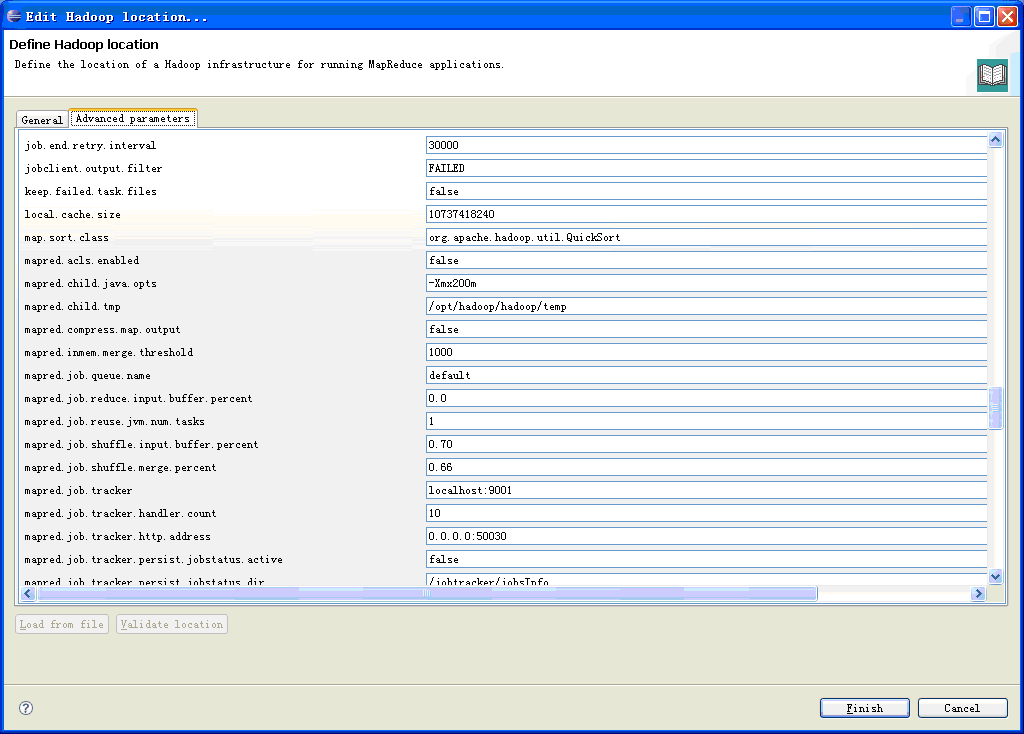

注意:一定要设置Mapred.Child.Tmp 目录。例如:

Mapred.Child.Tmp=${HADOOPHOME}/temp

一切都设置完了,可以点击运行. 运行结果如下:

引文来源 在 Windows 平台下部署 Hadoop 开发环境 - savechina的专栏 - CSDN博客

相关推荐

在Windows环境下搭建Hadoop开发环境是一项复杂但必要的任务,尤其对于初学者和开发者来说,能够直接在本地系统上运行和调试Hadoop程序是极其有用的。本文将详细介绍如何在Windows上配置Hadoop,以便使用Eclipse进行...

在Windows环境下搭建Hadoop2.6开发环境是一个相对复杂的过程,但通过详细的步骤和注意事项,可以有效地完成。这里我们将深入探讨这个过程,并介绍如何解决可能出现的问题。 首先,我们需要下载Hadoop2.6.0的安装包...

### Windows 下搭建 Hadoop 开发环境 (Eclipse) 在 Windows 操作系统上搭建 Hadoop 开发环境是一项技术挑战,但通过正确的步骤可以实现这一目标。本文档将详细解释如何在 Windows 7 上安装必要的组件,并配置一个可...

Hadoop伪分布式环境搭建是指在单个节点上模拟分布式环境,以便于开发、测试和学习Hadoop相关技术。本文将介绍如何在Windows和Linux平台上搭建Hadoop伪分布式环境,包括下载安装Hadoop、配置Eclipse、搭建Map/Reduce...

在本教程中,我们将详细介绍如何在Windows系统下搭建Hadoop环境,内容涉及虚拟机的安装、基础环境配置以及Hadoop集群的具体搭建步骤。适合初学者跟随本教程一步步进行操作。 首先,搭建Hadoop环境需要一台高性能...

在“压缩包子文件的文件名称列表”中提到的“hadoop开发环境”可能包含了一系列用于搭建Hadoop开发环境的文件和文档,如Hadoop的安装包、配置文件模板、示例代码等。这些资源可以帮助初学者快速理解和配置Hadoop环境...

在Windows环境下搭建Hadoop2开发环境是一个常见的任务,尤其对于初学者和开发者来说,了解这一过程至关重要。Hadoop是一个开源的分布式计算框架,它允许在大规模集群上处理和存储大量数据。在这个小案例中,我们将...

在Windows环境下搭建Hadoop 3.1.0的分布式文件系统需要解决一个重要依赖——WinUtils。这个组件是Hadoop在Windows上运行所必需的,因为Hadoop原本是为Linux环境设计的,它的一些核心功能,如文件操作和本地进程管理...

目的很简单,为进行研究与学习,部署一个hadoop运行环境,并搭建一个hadoop开发与测试环境。 具体目标是: 1.在ubuntu系统上部署hadoop 2.在windows 上能够使用eclipse连接ubuntu系统上部署的hadoop进行开发与测试 3...

为此,社区和博客作者们分享了相关资源,如winutils.exe和hadoop.dll,以帮助其他开发者在Windows上顺利搭建开发环境。 最后,对于没有积分下载资源的开发者,博客作者提供了私信方式,以便获取所需的winutils.exe...

Hadoop搭建与Eclipse开发环境设置 TITLE:Hadoop搭建与Eclipse开发环境设置 DESCRIPTION:本文将指导读者如何在Ubuntu系统上搭建Hadoop环境,并在Windows上使用Eclipse连接Ubuntu系统上的Hadoop环境进行开发和...

- **所需软件**:Java开发环境(JDK)、Hadoop二进制包、SSH客户端(如Putty)等。 - **安装软件**:确保安装好JDK,并设置好环境变量,下载对应版本的Hadoop,并解压到指定目录。 - **测试**:在安装完成后,...

搭建Hadoop开发环境,无论是单机模式还是伪分布式模式,都需要准备一些基础软件和环境。单机模式仅用于开发和测试,它在本地运行所有Hadoop守护进程;伪分布式模式将守护进程部署在单个机器上,但是每个守护进程都...

本文将详细介绍如何在Windows环境下搭建Hadoop2.6.0版本。首先,我们需要从指定的下载地址获取CDH(Cloudera Distribution Including Apache Hadoop)提供的Hadoop2.6.0-cdh5.13.0的压缩包,地址为:...

内容概要:本文详细介绍了如何在 Linux 系统上搭建 Hadoop 开发环境,从环境准备到配置完成,包括 Java 安装、Hadoop 下载与安装、配置文件修改、SSH 无密码登录设置、Namenode 格式化、服务启动与验证等步骤。...

2. **配置HDFS**:编辑`hdfs-site.xml`,设置`dfs.replication`为1,因为在本地开发环境中通常只有一个节点。 3. **格式化NameNode**:使用`hdfs namenode -format`命令对NameNode进行格式化,这是初次启动HDFS集群...

在Windows环境下安装和使用Hadoop可能对于一些初学者来说,是件挑战性较大的任务。不过,随着技术社区的不断发展,越来越多的教程和文章出现,为人们提供了宝贵的指导和帮助。本篇文档将详细介绍如何在Windows操作...

在Windows环境下搭建Hadoop集群是一...遵循正确的步骤,耐心调试,你就能在Windows上构建起一个本地Hadoop开发或测试环境。如果你遇到困难,可以参考相关的博客或教程,它们通常会提供详细的步骤和解决常见问题的技巧。

Hadoop搭建与Eclipse开发环境设置 本文旨在指导读者如何搭建Hadoop运行环境,并使用Eclipse在Windows上连接Ubuntu系统上的Hadoop进行开发与测试。整个过程分为三部分:Ubuntu安装、Hadoop安装和Eclipse配置。 部分...