一、 Hadoop环境搭建

首先在Apache官网下载hadoop的包hadoop-0.20.2.tar.gz。

解压hadoop-0.20.2.tar.gz包,具体命令如下:

tar zxvf hadoop-0.20.2.tar.gz

其中要注意的是,tar 包用xvf ,gz包用zxvf。

在安装中,如果遇到识别问题,或者无法解压,很有可能是权限问题,解决方案是修改此文件的使用权限,命令如下:

chmod 777 hadoop-0.20.2.tar.gz

其中,777为所有权限。

如果依然报错,如:Archive contains obsolescent base-64 headers;Error exit delayed from previous errors。

这种情况,一般是压缩包损坏的问题。因为大多数人会将包下载到windows环境,再通过ftp等方法上传到Linux环境。容易产生包损坏。建议大家直接下载到Linux即可。具体命令如下:

wget http://labs.renren.com/apache-mirror/hadoop/core/hadoop-0.20.2/hadoop-0.20.2.tar.gz

直接下载到当前目录。

当文件准备好之后,我们要修改配置,将Hadoop 简单run起来。

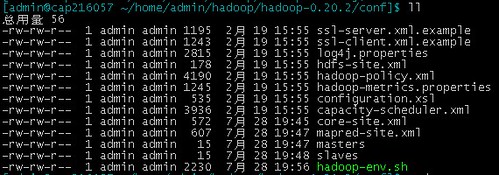

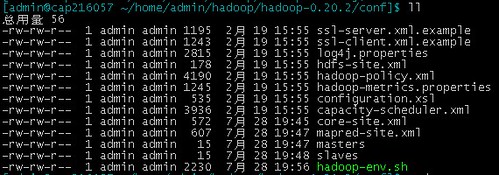

首先,我们进入hadoop-0.20.2/conf目录当中,其中会存在如下配置文件:

首先修改masters和slaves,这个是指定我们的m和s的ip地址,这里我们就以单台机器为例子,在文件中直接输入当前机器的IP。

之后我们修改mapred-site.xml文件,具体配置如下

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!-- Put site-specific property overrides in this file. -->

<configuration>

<property>

<name>mapred.job.tracker</name>

<value>hdfs://192.168.216.57:8012</value>

<description>The host and port that the MapReduce job tracker runs

at. If "local", then jobs are run in-process as a single map

and reduce task.

Pass in the jobtracker hostname via the

-Dhadoop.jobtracker=JOBTRACKER_HOST java option.

</description>

</property>

</configuration>

job.tracker是关键,mapReduce会将一个job,通过map(),打散为n个task。

之后是对文件core-site.xml的配置,详细配置如下:

<?xml version="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<!-- Put site-specific property overrides in this file. -->

<configuration>

<property>

<name>fs.default.name</name>

<value>hdfs://localhost:9100</value>

</property>

<property>

<name>mapred.job.tracker</name>

<value>localhost:9101</value>

</property>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/home/admin/tmp/</value>

<description>A base for other temporary directories. Set to a

directory off of the user's home directory for the simple test.

</description>

</property>

</configuration>

这个主要是配置我们的文件系统。其中,fs.default.name的value,不可以写IP地址,要写域名。域名的查询,具体命令如下:

cd ~

cd etc

vi hosts

在hosts文件中,找到自己IP对应的域名。

到此,Hadoop本身的配置就算完成了。但hadoop会在master/slaves之间进行文件的操作,在机器之间操作时候,就必须做到免登陆。对此,我们就得设置相应的公钥私钥。

具体命令如下:

ssh-keygen -t rsa -P ''

-P表示密码,-P '' 就表示空密码,也可以不用-P参数,这样就要三车回车,用-P就一次回车。它在/~ 下生成.ssh目录,.ssh下有id_rsa和id_rsa.pub。

如果是多台机器,则需要将公钥id-rsa.pub通过scp到其他机器的相同目录。

之后,追加公钥到相应文件,具体如下:

cat id_rsa.pub >> .ssh/authorized_keys

chmod 600 .ssh/authorized_keys

其中,authorized_keys要的权限是600

第一次登录是时要你输入yes,之后就不用了。

OK,所有均搞定了,进入hadoop-0.20.2/bin路径,直接执行start-all.sh脚本,即可启动Hadoop的服务了。

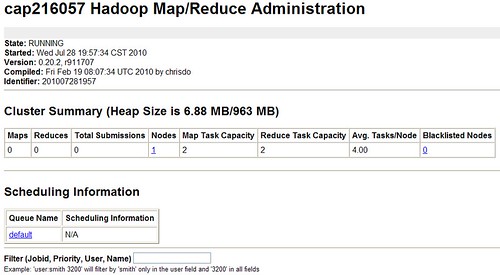

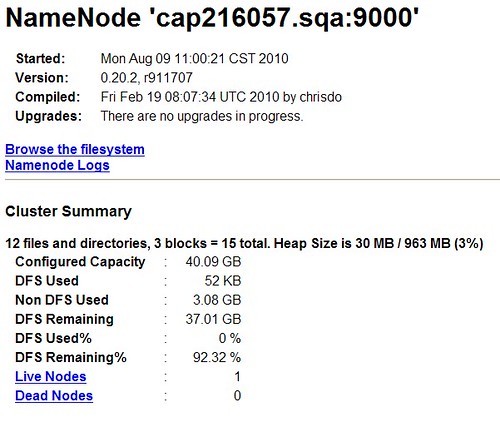

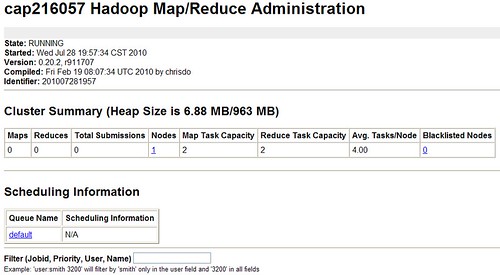

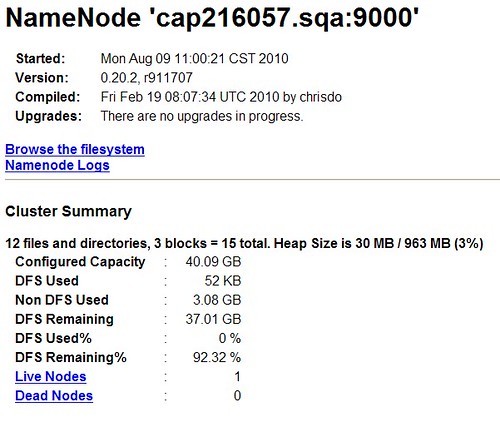

我们可以通过web的方式,对Hadoop的运转进行监控,具体url如下:

控制台:http://cap216057.sqa:50030/jobtracker.jsp

数据节点:http://cap216057.sqa:50070/dfshealth.jsp

cap216057.sqa可以再hosts里配置,或者直接访问IP地址。

二、 Hive搭建

Hive搭建在Hadoop的基础之上,相对就会简单很多。只需要设置Hadoop的HADOOP_HOME和HIVE_HOME即可了。

首先下载、解压,此操作与商品Hadoop的操作一样。值得注意的是,Apache的官网上会提供bin和dev两种版本的压缩包。建议使用bin版本。

Wget http://labs.renren.com/apache-mirror/hadoop/hive/hive-0.5.0/hive-0.5.0-bin.tar.gz

完成之后,如下操作:

export HADOOP_HOME=/home/admin/hadoop-0.20.0/

export HIVE_HOME=/home/admin/hive-0.5.0-bin

完成命令,直接在hive/bin目录下启动hive,启动端口任意写一个未被占用的即可。

./hive --service hiveserver 10000 &

三、 测试

在hive/bin目录下,输入./hive,进入hive命令的控制台。执行hql,就是hive的sql

具体如下:

create tables user(id,int);

show tables;

值得注意的是,语句结尾的分号,万万不可遗漏。

看看结果吧,哈哈,大功告成咯!

分享到:

相关推荐

### Mac环境下Hadoop与Hive搭建详解 #### 标题:Mac 搭建 Hadoop和hive环境 #### 描述:手把手教你进行mac搭建hadoop和hive环境 #### 标签:hadoop, hive, mac, mysql #### 详细知识点解析: ##### 一、前言 ...

### Hadoop Hive 安装与配置详解 #### 一、Hadoop Hive 概述 Hadoop Hive 是一种基于 Hadoop 的数据仓库工具,可以将结构化的数据文件映射为...通过上述步骤,可以顺利地在自己的系统上搭建起一个完整的 Hive 环境。

### Hadoop环境搭建之Hive 2.1.1配置详解 #### 一、概述 在构建大数据处理环境时,Apache Hive 是一个重要的组件,它提供了SQL查询功能,使用户能够方便地对存储在Hadoop文件系统(HDFS)中的大规模数据集进行数据...

单机伪集群环境搭建 集群环境搭建 常用 Shell 命令 Java API 的使用 基于 Zookeeper 搭建 Hadoop 高可用集群 二、Hive 简介及核心概念 Linux 环境下 Hive 的安装部署 CLI 和 Beeline 命令行的基本使用 常用 DDL 操作...

### Hadoop、Hive、HBase 的安装配置详解 #### 一、Hadoop 安装配置 ##### 1. 创建用户与安装 JDK 在安装 Hadoop 前,首先需要创建一个专用的用户账户用于运行 Hadoop 相关服务,并确保 Java 环境已经正确安装。 ...

Hadoop集群搭建详解 Hadoop是一个大数据处理框架,由Apache基金会开发和维护。它提供了一个分布式计算环境,能够处理大量数据。Hadoop生态系统包括了多个组件,如HDFS、MapReduce、YARN、HBase、Hive等。 Hadoop...

【标题】:基于CentOS的大数据Hadoop集群搭建详解 【描述】:本教程专为初学者设计,详细阐述了如何手动搭建Hadoop集群,步骤详尽,易于理解。 【标签】:Hadoop集群搭建 【正文】: Hadoop是一个开源的分布式...

### Centos+Hadoop+Hive+HBase 环境搭建详解 #### 一、Centos基础环境搭建 ##### 1.1 软件准备 为了搭建一个基于Centos的操作系统,需要准备以下软件: - **VMware-workstation-full-8.0.4-744019.exe**:这是...

本篇教程将深入浅出地讲解如何在单机环境下搭建Hadoop环境,帮助初学者快速入门。 Hadoop是Apache基金会开发的一个开源分布式计算框架,它设计用于高效地处理和存储海量数据。核心组件包括Hadoop Distributed File ...

书中可能详细介绍了Hadoop的安装与配置过程,包括集群搭建、硬件需求、网络配置等,这对于理解和部署Hadoop环境至关重要。此外,还会涉及YARN(Yet Another Resource Negotiator),它是Hadoop的资源管理系统,负责...

本篇文章将基于"深入云计算:Hadoop应用开发实战详解 源代码"这一主题,深入探讨Hadoop在云计算环境中的应用与开发实践。 Hadoop是Apache基金会开发的一个分布式计算系统,主要由Hadoop Distributed File System ...

8. **Hadoop安装与配置**:学习如何在本地或集群环境中搭建Hadoop环境,包括单机模式、伪分布式模式和完全分布式模式。 9. **实战项目**:通过书中源代码,可以实践数据导入导出、数据清洗、数据分析等实际任务,...

以上步骤详细介绍了如何在Linux环境下搭建基于Hadoop的Hive数据仓库,包括Hive的安装、MySQL作为Hive元数据存储的配置以及Hive的初始化等关键步骤。通过这些配置,你可以利用Hive对Hadoop中的大规模数据进行高效的...

Hadoop 单机伪集群环境搭建 Hadoop 集群环境搭建 HDFS 常用 Shell 命令 HDFS Java API 的使用 基于 Zookeeper 搭建 Hadoop 高可用集群 Hive Hive 简介及核心概念 Linux 环境下 Hive 的安装部署 Hive CLI 和 Beeline...

内容概要:本文详细介绍了如何在一个 CentOS7.0 系统环境中,从头搭建 Hadoop 2.x 版本的全分布式模式集群。它覆盖了基础环境预备、网络设置、Linux命令的初步运用,SSH免密码登录配置、JDK安装,直至最终部署和测试...

【Ubuntu完全分布式及Hive远程安装详解】 在大数据处理领域,Apache Hive是一个广泛使用的数据仓库工具,它允许用户使用SQL(HQL)查询Hadoop集群中的数据。本篇将详细介绍如何在Ubuntu操作系统上进行Hive的完全...

Hadoop 单机伪集群环境搭建 Hadoop 集群环境搭建 HDFS 常用 Shell 命令 HDFS Java API 的使用 基于 Zookeeper 搭建 Hadoop 高可用集群 二、Hive Hive 简介及核心概念 Linux 环境下 Hive 的安装部署 Hive CLI 和 ...

本教程旨在指导读者快速搭建一个基于Hadoop的大数据处理环境。适用于新手快速入门,节省时间和精力。在开始之前,请确保具备以下条件: - 已安装VMware Workstation或类似虚拟机软件 - 已安装CentOS 6.7 x64位操作...

### Hive的三种安装与搭建方式详解 #### 一、引言 Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供完整的SQL查询功能,可以将SQL语句转换为MapReduce任务进行运行。其优点...

#### 二、Hadoop架构详解 **2.1 Hadoop体系介绍** Hadoop不仅限于HDFS和MapReduce,还包括一系列相关的子项目和服务,它们共同构成了一个强大的分布式计算生态系统: - **Core**:包含了一系列分布式文件系统和...