转载 http://blog.csdn.net/jiedushi/article/details/7325292

Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供完整的sql查询功能,可以将sql语句转换为MapReduce任务进行运行。 其优点是学习成本低,可以通过类SQL语句快速实现简单的MapReduce统计,不必开发专门的MapReduce应用,十分适合数据仓库的统计分析。

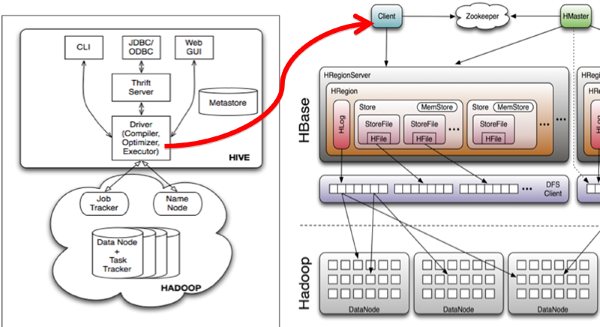

Hive与HBase的整合功能的实现是利用两者本身对外的API接口互相进行通信,相互通信主要是依靠hive_hbase-handler.jar工具类, 大致意思如图所示:

Mapr框架安装完后,安装与配置hbase、hive。

其中mapr框架的安装路径为/opt/mapr

Hbase的安装路径为/opt/mapr/hbase/hbase-0.90.4

Hive的安装路径为/opt/mapr/hive/hive-0.7.1

整合hive与hbase的过程如下:

1. 将文件 /opt/mapr/hbase/hbase-0.90.4/hbase-0.90.4.jar 与/opt/mapr/hbase/hbase-0.90.4/lib/zookeeper-3.3.2.jar拷贝到/opt/mapr/hive/hive-0.7.1/lib文件夹下面

注意:如果hive/lib下已经存在这两个文件的其他版本(例如zookeeper-3.3.1.jar),建议删除后使用hbase下的相关版本

2 修改hive/conf下hive-site.xml文件,在底部添加如下内容:

<property>

<name>hive.querylog.location</name>

<value>/opt/mapr/hive/hive-0.7.1/logs</value>

</property>

<property>

<name>hive.aux.jars.path</name> <value>file:///opt/mapr/hive/hive-0.7.1/lib/hive-hbase-handler-0.7.1.jar,file:///opt/mapr/hive/hive-0.7.1/lib/hbase-0.90.4.jar,file:///opt/mapr/hive/hive-0.7.1/lib/zookeeper-3.3.2.jar</value>

</property>

注意:如果hive-site.xml不存在则自行创建,或者把hive-default.xml.template文件改名后使用。

3. 拷贝hbase-0.90.4.jar到所有hadoop节点(包括master)的hadoop/lib下。

4. 拷贝hbase/conf下的hbase-site.xml文件到所有hadoop节点(包括master)的hadoop/conf下。

注意,如果3,4两步跳过的话,运行hive时很可能出现如下错误:

org.apache.hadoop.hbase.ZooKeeperConnectionException: HBase is able to connect to ZooKeeper but the connection closes immediately.

This could be a sign that the server has too many connections (30 is the default). Consider inspecting your ZK server logs for that error and

then make sure you are reusing HBaseConfiguration as often as you can. See HTable's javadoc for more information. at org.apache.hadoop.

hbase.zookeeper.ZooKeeperWatcher.

5 启动hive

单节点启动

bin/hive -hiveconf hbase.master=master:60000

集群启动

bin/hive -hiveconf hbase.zookeeper.quorum=node1,node2,node3 (所有的zookeeper节点)

如果hive-site.xml文件中没有配置hive.aux.jars.path,则可以按照如下方式启动。

hive --auxpath /opt/mapr/hive/hive-0.7.1/lib/hive-hbase-handler-0.7.1.jar,/opt/mapr/hive/hive-0.7.1/lib/hbase-0.90.4.jar,/opt/mapr/hive/hive-0.7.1/lib/zookeeper-3.3.2.jar -hiveconf hbase.master=localhost:60000

经测试修改hive的配置文件hive-site.xml

<property>

<name>hive.zookeeper.quorum</name>

<value>node1,node2,node3</value>

<description>The list of zookeeper servers to talk to. This is only needed for read/write locks.</description>

</property>

不用增加参数启动hive就可以联合hbase

6 启动后进行测试

(1) 创建hbase识别的表

CREATE TABLE hbase_table_1(key int, value string) STORED BY 'org.apache.hadoop.hive.hbase.HBaseStorageHandler' WITH SERDEPROPERTIES ("hbase.columns.mapping" = ":key,cf1:val") TBLPROPERTIES ("hbase.table.name" = "xyz");

hbase.table.name 定义在hbase的table名称,多列时,data:1,data:2;多列族时,data1:1,data2:1;

hbase.columns.mapping 定义在hbase的列族,里面的:key 是固定值而且要保证在表pokes中的foo字段是唯一值

创建有分区的表

CREATE TABLE hbase_table_1(key int, value string) partitioned by (day string) STORED BY 'org.apache.hadoop.hive.hbase.HBaseStorageHandler' WITH SERDEPROPERTIES ("hbase.columns.mapping" = ":key,cf1:val") TBLPROPERTIES ("hbase.table.name" = "xyz");

不支持表的修改

会提示不能修改非本地表。

hive> ALTER TABLE hbase_table_1 ADD PARTITION (day = '2012-09-22');

FAILED: Error in metadata: Cannot use ALTER TABLE on a non-native table FAILED: Execution Error, return code 1 from org.apache.hadoop.hive.ql.exec.DDLTask

(2) 使用sql导入数据

新建hive的数据表

create table pokes(foo int,bar string)row format delimited fields terminated by ',';

批量导入数据

load data local inpath '/home/1.txt' overwrite into table pokes;

1.txt文件的内容为

1,hello

2,pear

3,world

使用sql导入hbase_table_1

SET hive.hbase.bulk=true;

insert overwrite table hbase_table_1 select * from pokes;

导入有分区的表

insert overwrite table hbase_table_1 partition (day='2012-01-01') select * from pokes;

(3) 查看数据

hive> select * from hbase_table_1;

OK

1 hello

2 pear

3 world

(注:与hbase整合的有分区的表存在个问题 select * from table查询不到数据,select key,value from table可以查到数据)

(4)登录Hbase去查看数据

hbase shell

hbase(main):002:0> describe 'xyz'

DESCRIPTION ENABLED {NAME => 'xyz', FAMILIES => [{NAME => 'cf1', BLOOMFILTER => 'NONE', REPLICATION_S true

COPE => '0', COMPRESSION => 'NONE', VERSIONS => '3', TTL => '2147483647', BLOCKSI

ZE => '65536', IN_MEMORY => 'false', BLOCKCACHE => 'true'}]}

1 row(s) in 0.0830 seconds

hbase(main):003:0> scan 'xyz'

ROW COLUMN+CELL

1 column=cf1:val, timestamp=1331002501432, value=hello

2 column=cf1:val, timestamp=1331002501432, value=pear

3 column=cf1:val, timestamp=1331002501432, value=world

这时在Hbase中可以看到刚才在hive中插入的数据了。

7 对于在hbase已经存在的表,在hive中使用CREATE EXTERNAL TABLE来建立

例如hbase中的表名称为test1,字段为 a: , b: ,c: 在hive中建表语句为

create external table hive_test (key int,gid map<string,string>,sid map<string,string>,uid map<string,string>) STORED BY 'org.apache.hadoop.hive.hbase.HBaseStorageHandler' WITH SERDEPROPERTIES ("hbase.columns.mapping" ="a:,b:,c:") TBLPROPERTIES ("hbase.table.name" = "test1");

在hive中建立好表后,查询hbase中test1表内容

Select * from hive_test;

OK

1 {"":"qqq"} {"":"aaa"} {"":"bbb"}

2 {"":"qqq"} {} {"":"bbb"}

查询gid字段中value值的方法为

select gid[''] from hbase2;

得到查询结果

Total MapReduce jobs = 1

Launching Job 1 out of 1

Number of reduce tasks is set to 0 since there's no reduce operator

Starting Job = job_201203052222_0017, Tracking URL = http://localhost:50030/jobdetails.jsp?jobid=job_201203052222_0017

Kill Command = /opt/mapr/hadoop/hadoop-0.20.2/bin/../bin/hadoop job -Dmapred.job.tracker=maprfs:/// -kill job_201203052222_0017

2012-03-06 14:38:29,141 Stage-1 map = 0%, reduce = 0%

2012-03-06 14:38:33,171 Stage-1 map = 100%, reduce = 100%

Ended Job = job_201203052222_0017

OK

qqq

qqq

如果hbase表test1中的字段为user:gid,user:sid,info:uid,info:level,在hive中建表语句为

create external table hive_test(key int,user map<string,string>,info map<string,string>) STORED BY 'org.apache.hadoop.hive.hbase.HBaseStorageHandler' WITH SERDEPROPERTIES ("hbase.columns.mapping" ="user:,info:") TBLPROPERTIES ("hbase.table.name" = "test1");

查询hbase表的方法为

select user['gid'] from hbase2;

注:hive连接hbase优化,将HADOOP_HOME/conf中的hbase-site.xml文件中增加配置

<property>

<name>hbase.client.scanner.caching</name>

<value>10000</value>

</property>

或者在执行hive语句之前执行hive>set hbase.client.scanner.caching=10000;

相关推荐

2. **获取Hive数据**:使用Hive的Java API(如Hive Metastore Thrift Client)连接到Hive服务,查询并获取所需的数据。这通常涉及到解析HQL(Hive SQL)查询,获取查询结果集。 3. **预处理数据**:根据HBase的存储...

Scala、Hive与HBase是大数据处理领域中的关键组件,它们在Java开发环境中扮演着重要角色。本压缩包"scala-hive-HBASE-Api.7z"包含了2019年8月至10月间用于工作的相关jar包,主要用于支持Scala、Hive和HBase的集成...

Hive和Hbase的差异主要体现在延迟、数据模型和使用场景上。Hive是高延迟的,适合分析大量静态数据;而Hbase则提供了低延迟的查询,适用于需要快速响应的在线服务。 2. Hive与数据库的比较: - 查询语言:Hive采用...

"HIVE和HBASE区别" HIVE和HBASE是两种基于Hadoop的不同...就像用Google来搜索,用Facebook进行社交一样,HIVE可以用来进行统计查询,HBASE可以用来进行实时查询,数据也可以从HIVE写到HBASE,设置再从HBASE写回HIVE。

- **性能问题**:由于 Hive 默认的数据读取方式是全表扫描,因此查询速度相对较慢,尤其是对于非常大的数据集。 - **MapReduce 转换**:Hive 需要将 HQL 查询转换成 MapReduce 任务来执行,这可能会引入额外的时间...

这样,Hive查询可以通过HBase的表获取数据,反之亦然。映射的关键在于定义正确的SerDe(序列化/反序列化)类和配置参数,以确保Hive能理解HBase的行键和列族结构。 接下来,Spark作为一个分布式计算框架,提供了一...

- 编写代码,使用Table和Put对象将数据从本地文件读取并写入到HBase表中。 - 编译并运行Java程序,完成数据导入。 在整个过程中,确保所有组件的版本兼容,例如HBase与Hadoop、Sqoop与Hadoop之间的版本匹配。同时...

3. 从HBase中读取数据,转换成Spark DataFrame,方便进一步的数据处理和分析。 4. 利用Spark的MLlib库进行机器学习模型训练,预测和分类等任务。 在实际项目中,这些组件的集成可以帮助企业构建大规模数据处理平台...

文中介绍了通过 Sqoop 在 MySQL 和 HDFS 之间、MySQL 和 Hive 之间以及 MySQL 和 HBase 之间的数据互导过程,包括如何处理常见的错误。同时,也详细记录了 MySQL 用户创建、授权、数据插入和 Sqoop 配置的相关细节。...

这种模式提供了一种方法,用于获取已存储在Hive中的数据,将其导出为HFile,并从这些HFile批量加载HBase表。概述HFile生成功能已添加到。 它添加了以下属性,然后Hive HBaseStorageHandler可以利用这些属性。 hive....

### Centos+Hadoop+Hive+HBase 环境搭建详解 #### 一、Centos基础环境搭建 ##### 1.1 软件准备 为了搭建一个基于Centos的操作系统,需要准备以下软件: - **VMware-workstation-full-8.0.4-744019.exe**:这是...

- 两者可以通过Hive-on-HBase的方式结合使用,即利用Hive的SQL接口来查询HBase中的数据,增强了HBase的查询灵活性。 #### 2. HBase数据结构 **知识点解析:** HBase的数据模型主要由行键(Row Key)、列族(Column...

Hive通过HBaseStorageHandler获取HBase表的相关信息,如表名、列簇和列,以及InputFormat和OutputFormat类,从而在MapReduce作业中读写HBase表。具体来说,Hive的查询会被转化为MapReduce任务,其中...

在大数据处理领域,Hadoop、HBase和Hive是三个重要的组件,它们分别扮演着不同的角色,共同构建了一个高效、可扩展的数据处理生态系统。本文将详细介绍这三个组件的整合工程和相关文档,帮助读者理解如何在实际项目...

Hive是一个基于Hadoop的数据仓库工具,它允许用户使用SQL-like语法(HQL,Hive Query Language)对大规模数据集进行分析。而HBase是Google Bigtable的一个开源实现,是一个NoSQL数据库,适用于海量结构化数据的存储...

在大数据领域中,Hadoop、HBase和Hive是重要的组件,它们通常需要协同工作以实现数据存储、管理和分析。随着各个软件的版本不断更新,确保不同组件之间的兼容性成为了一个挑战。本文将介绍Hadoop、HBase、Hive以及...

### HBase 常用命令总结 ...以上总结了HBase和Hive中常用的命令,这些命令可以帮助用户更高效地管理、查询和分析大规模数据集。在实际应用中,根据具体需求灵活运用这些命令能够大大提高数据分析和处理效率。

Hive提供了丰富的接口供外部应用访问,包括Hive JDBC和Hive SerDe(Serializer/Deserializer),Java程序可以利用这些接口读取Hive表中的数据。 2. **Spark计算框架**: Spark是大数据处理的开源框架,以其高效、...

2. HBase到Hive:通过MapReduce任务,将HBase中的数据导入到Hive,创建Hive表并加载数据。也可以使用HBaseSerDe来解析HBase数据。 三、HBase和HDFS互导 1. HBase到HDFS:可以通过HBase的Export工具,将HBase表的...