- жµПиІИ: 119167 жђ°

- жАІеИЂ:

- жЭ•иЗ™: еМЧдЇђ

-

з§ЊеМЇзЙИеЭЧ

- жИСзЪДиµДиЃѓ ( 0)

- жИСзЪДиЃЇеЭЫ ( 0)

- жИСзЪДйЧЃз≠Ф ( 0)

е≠Шж°£еИЖз±ї

- 2020-02 ( 1)

- 2020-01 ( 45)

- 2019-12 ( 61)

- жЫіе§Ъе≠Шж°£...

жЬАжЦ∞иѓДиЃЇ

йШњйЗМеЈіеЈі Service Mesh иРљеЬ∞зЪДжЮґжЮДдЄОжМСжИШ

йГ®зљ≤жЮґжЮД

====

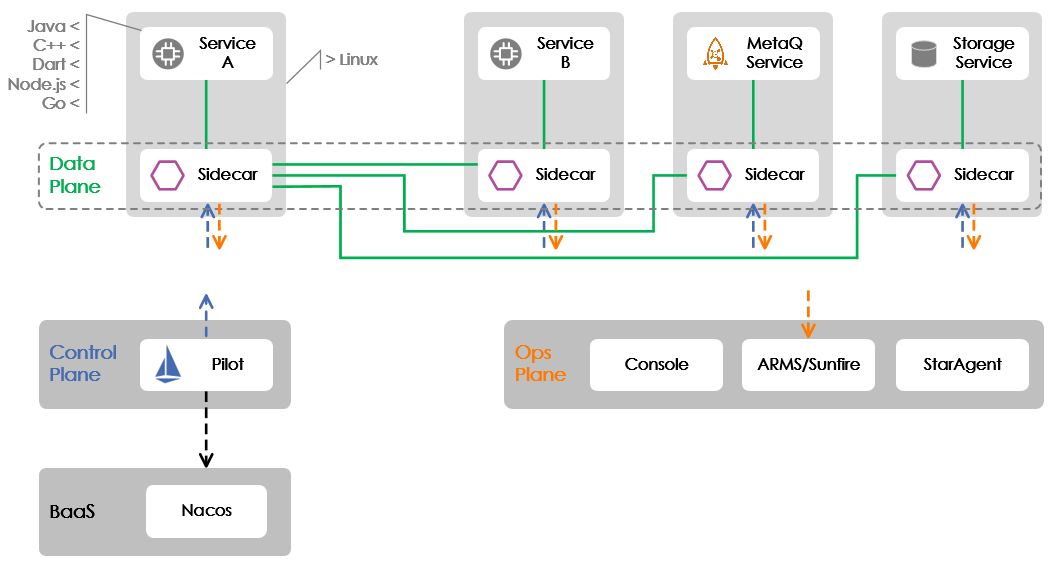

еИЗеЕ•дЄїйҐШеЙНпЉМйЬАи¶БдЇ§дї£дЄАдЄЛеЬ® еПМ11 ж†ЄењГеЇФзФ®дЄКиРљеЬ∞зЪДйГ®зљ≤жЮґжЮДпЉМе¶ВдЄЛеЫЊжЙАз§ЇгАВеЬ®ињЩзѓЗжЦЗзЂ†дЄ≠пЉМжИСдїђдЄїи¶БиБЪзД¶дЇО Service A еТМ Service B дєЛйЧі RPC еНПиЃЃзЪД Mesh еМЦгАВ

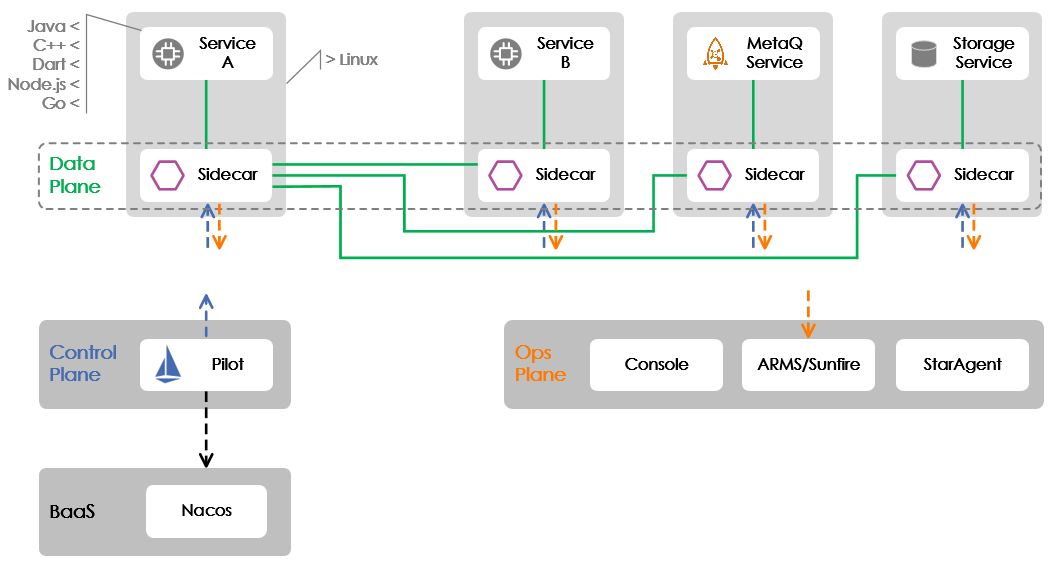

еЫЊдЄ≠з§ЇдЊЛиѓіжШОдЇЖ Service Mesh жЙАеМЕеРЂзЪДдЄЙе§Іеє≥йЭҐпЉЪеН≥жХ∞жНЃеє≥йЭҐпЉИData PlaneпЉЙгАБжОІеИґеє≥йЭҐпЉИControl PlaneпЉЙеТМињРзїіеє≥йЭҐпЉИOperation PlaneпЉЙгАВжХ∞жНЃеє≥йЭҐжИСдїђйЗЗзФ®зЪДжШѓеЉАжЇРзЪД EnvoyпЉИдЄКеЫЊдЄ≠зЪД SidecarпЉМиѓЈиѓїиАЕж≥®жДПињЩдЄ§дЄ™иѓНеЬ®жЬђжЦЗдЄ≠еПѓдї•дЇТжНҐдљњзФ®пЉЙпЉМжОІеИґеє≥йЭҐйЗЗзФ®зЪДжШѓеЉАжЇРзЪД IstioпЉИзЫЃеЙНеП™дљњзФ®дЇЖеЕґдЄ≠зЪД Pilot зїДдїґпЉЙпЉМињРзїіеє≥йЭҐеИЩеЃМеЕ®иЗ™з†ФгАВ

дЄОеНКеєіеЙНиРљеЬ∞жЧґдЄНеРМпЉМињЩжђ° еПМ11 ж†ЄењГеЇФзФ®дЄКиРљеЬ∞жИСдїђйЗЗзФ®дЇЖ Pilot йЫЖзЊ§еМЦйГ®зљ≤зЪДж®°еЉПпЉМеН≥ Pilot дЄНеЖНдЄО Envoy дЄАиµЈйГ®зљ≤еИ∞дЄЪеК°еЃєеЩ®дЄ≠пЉМиАМжШѓжР≠еїЇдЇЖдЄАдЄ™зЛђзЂЛзЪДйЫЖзЊ§гАВињЩдЄАеПШеМЦдљњеЊЧжОІеИґеє≥йЭҐзЪДйГ®зљ≤жЦєеЉПжЉФињЫеИ∞дЇЖ Service Mesh еЇФжЬЙзЪДзїИжАБгАВ

жМСжИШ

==

иРљеЬ∞жЙАйАЙжЛ©зЪД еПМ11 ж†ЄењГеЇФзФ®йГљжШѓйЗЗзФ® Java зЉЦз®Лиѓ≠и®АеЃЮзО∞зЪДпЉМеЬ®иРљеЬ∞зЪДињЗз®ЛдЄ≠жИСдїђйЭҐдЄідЇЖдї•дЄЛжМСжИШгАВ

1\. еЬ® SDK жЧ†ж≥ХеНЗзЇІзЪДжГЕ嚥дЄЛе¶ВдљХеЃЮзО∞еЇФзФ®зЪД Mesh еМЦ

--------------------------------

еЬ®еЖ≥еЃЪи¶БеЬ® еПМ11 зЪДж†ЄењГеЇФзФ®дЄКиРљеЬ∞ Mesh жЧґпЉМJava еЇФзФ®дЊЭиµЦзЪД RPC SDK зЙИжЬђеЈ≤зїПеЃЪз®њпЉМдЄЇдЇЖ Mesh еМЦеЃМеЕ®ж≤°жЬЙжЧґйЧіеОїеЉАеПСдЄАдЄ™йАВзФ®дЇО Mesh зЪД RPC SDK еєґеБЪеНЗзЇІгАВйВ£жЧґпЉМжСЖеЬ®еЫҐйШЯйЭҐеЙНзЪДжКАжЬѓйЧЃйҐШжШѓпЉЪе¶ВдљХеЬ®дЄНеНЗзЇІ SDK зЪДжГЕ嚥дЄЛпЉМеЃЮзО∞ RPC еНПиЃЃзЪД Mesh еМЦпЉЯ

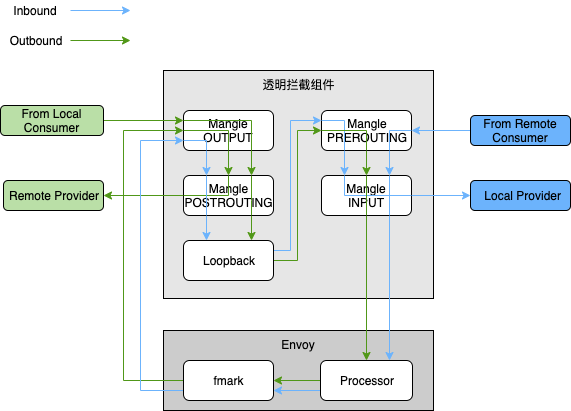

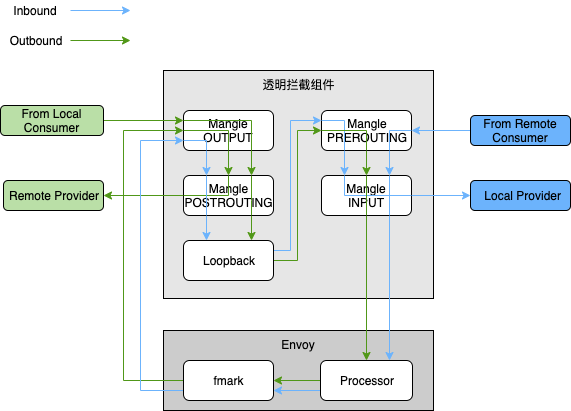

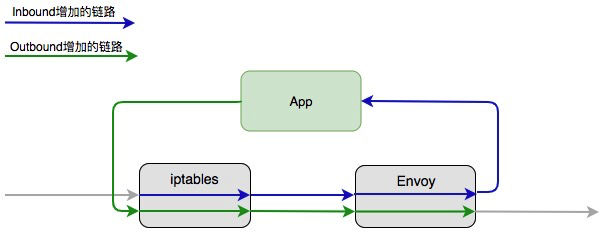

зЖЯжВЙ Istio зЪДиѓїиАЕжГ≥ењЕжЄЕж•ЪпЉМIstio жШѓйАЪињЗ iptables зЪД NAT и°®еОїеБЪжµБйЗПйАПжШОжЛ¶жИ™зЪДпЉМйАЪињЗжµБйЗПйАПжШОжЛ¶жИ™еПѓеЬ®еЇФзФ®жЧ†жДЯзЪДжГЕ嚥дЄЛе∞ЖжµБйЗПеКЂжМБеИ∞ Envoy дЄ≠дїОиАМеЃЮзО∞ Mesh еМЦгАВдљЖеЊИдЄНеєЄпЉМNAT и°®жЙАдљњзФ®еИ∞зЪД nf\_contrack еЖЕж†Єж®°еЭЧеЫ†дЄЇжХИзОЗеЊИдљОпЉМеЬ®йШњйЗМеЈіеЈізЪДзЇњдЄКзФЯдЇІжЬЇеЩ®дЄ≠襀еОїйЩ§дЇЖпЉМеЫ†ж≠§жЧ†ж≥ХзЫіжО•дљњзФ®з§ЊеМЇзЪДжЦєж°ИгАВе•љеЬ®еєіеИЭеЉАеІЛдЄНдєЕжИСдїђдЄОйШњйЗМеЈіеЈі¬†OS еЫҐйШЯиЊЊжИРдЇЖеРИдљЬеЕ±еїЇпЉМзФ±дїЦдїђиіЯиі£жЙњжЛЕ Service Mesh жЙАйЬАзЪДжµБйЗПйАПжШОжЛ¶жИ™еТМзљСзїЬеК†йАЯињЩдЄ§еЭЧеЯЇз°АиГљеКЫзЪДеїЇиЃЊгАВзїПињЗдЄ§дЄ™еЫҐйШЯзЪДзіІеѓЖеРИдљЬпЉМOS еЫҐйШЯжΥ糥дЇЖйАЪињЗеЯЇдЇО userid еТМ mark ж†ЗиѓЖжµБйЗПзЪДйАПжШОжЛ¶жИ™жЦєж°ИпЉМеЯЇдЇО iptables зЪД mangle и°®еЃЮзО∞дЇЖдЄАдЄ™еЕ®жЦ∞зЪДйАПжШОжЛ¶жИ™зїДдїґгАВ

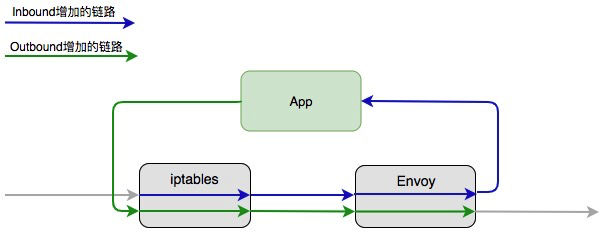

дЄЛеЫЊз§ЇдЊЛиѓіжШОдЇЖе≠ШеЬ®йАПжШОжЛ¶жИ™зїДдїґзЪДжГЕ嚥дЄЛпЉМRPC жЬНеК°и∞ГзФ®зЪДжµБйЗПиµ∞еРСгАВеЕґдЄ≠пЉМInbound жµБйЗПжШѓжМЗи∞ГињЫжЭ•зЪДжµБйЗПпЉИжµБйЗПзЪДжО•еПЧиАЕжШѓ Provider иІТиЙ≤пЉЙпЉМиАМ Outbound жШѓжМЗи∞ГеЗЇеОїзЪДжµБйЗПпЉИжµБйЗПзЪДеПСеЗЇиАЕжШѓ Consumer иІТиЙ≤пЉЙгАВйАЪеЄЄдЄАдЄ™еЇФзФ®дЉЪеРМжЧґжЙњжЛЕдЄ§дЄ™иІТиЙ≤пЉМжЙАдї•жЬЙ Inbound еТМ Outbound дЄ§иВ°жµБйЗПеєґе≠ШгАВ

жЬЙдЇЖйАПжШОжЛ¶жИ™зїДдїґдєЛеРОпЉМеЇФзФ®зЪД Mesh еМЦеЃМеЕ®иГљеБЪеИ∞жЧ†жДЯпЉМињЩе∞ЖжЮБе§ІеЬ∞жФєеЦД Mesh иРљеЬ∞зЪДдЊњеИ©жАІгАВељУзДґпЉМзФ±дЇО RPC зЪД SDK дїНе≠ШеЬ®дї•еЙНзЪДжЬНеК°еПСзО∞еТМиЈѓзФ±йАїиЊСпЉМиАМиѓ•жµБйЗП襀еКЂжМБеИ∞ Envoy дєЛеРОеПИдЉЪеЖНеБЪдЄАжђ°пЉМињЩе∞ЖеѓЉиЗі Outbound зЪДжµБйЗПдЉЪеЫ†дЄЇе≠ШеЬ®дЄ§жђ°жЬНеК°еПСзО∞еТМиЈѓзФ±иАМеҐЮеК† RTпЉМињЩеЬ®еРОйЭҐзЪДжХ∞жНЃйГ®еИЖдєЯе∞ЖжЬЙжЙАдљУзО∞гАВжШЊзДґпЉМдї•зїИжАБиРљеЬ∞ Service Mesh жЧґпЉМйЬАи¶БеОїйЩ§ RPC SDK дЄ≠зЪДжЬНеК°еПСзО∞дЄОиЈѓзФ±йАїиЊСпЉМе∞ЖзЫЄеЇФзЪД CPU еТМеЖЕе≠ШеЉАйФАзїЩиКВзЇ¶дЄЛжЭ•гАВ

2.зЯ≠жЧґйЧіеЖЕжФѓжМБзФµеХЖдЄЪеК°е§НжЭВзЪДжЬНеК°ж≤їзРЖеКЯиГљ

---------------------

### иЈѓзФ±

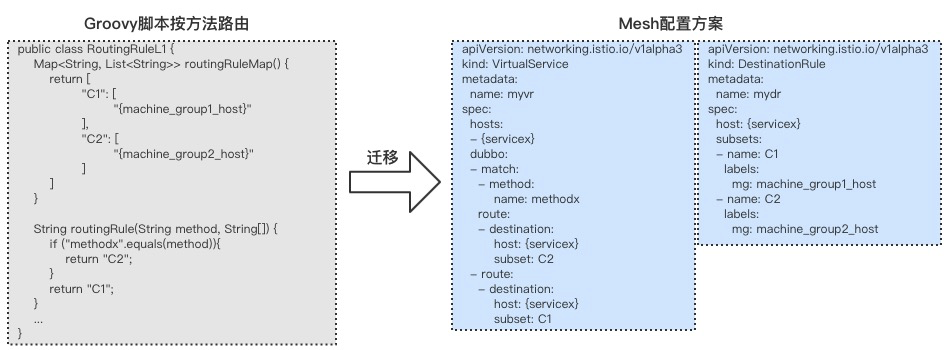

еЬ®йШњйЗМеЈіеЈізФµеХЖдЄЪеК°еЬЇжЩѓдЄЛзЪДиЈѓзФ±зЙєжАІдЄ∞еѓМе§Ъж†ЈпЉМйЩ§дЇЖи¶БжФѓжМБеНХеЕГеМЦгАБзОѓеҐГйЪФз¶їз≠ЙиЈѓзФ±з≠ЦзХ•пЉМињШеЊЧж†єжНЃ RPC иѓЈж±ВзЪДжЦєж≥ХеРНгАБи∞ГзФ®еПВжХ∞гАБеЇФзФ®еРНз≠ЙеЃМжИРжЬНеК°иЈѓзФ±гАВйШњйЗМеЈіеЈіеЖЕйГ®зЪД Java¬†RPC ж°ЖжЮґжШѓйАЪињЗеµМеЕ• Groovy иДЪжЬђжЭ•жФѓжМБињЩдЇЫиЈѓзФ±з≠ЦзХ•зЪДпЉМдЄЪеК°жЦєеЬ®ињРзїіжОІеИґеП∞дЄКйЕНзљЃ Groovy иЈѓзФ±ж®°жЭњпЉМSDK еПСиµЈи∞ГзФ®жЧґдЉЪжЙІи°Миѓ•иДЪжЬђеЃМжИРиЈѓзФ±з≠ЦзХ•зЪДињРзФ®гАВ

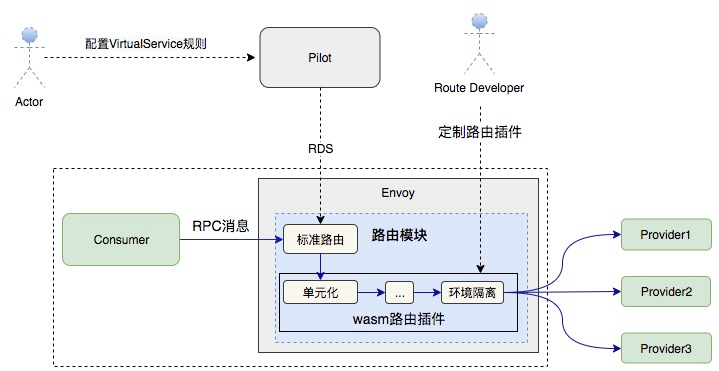

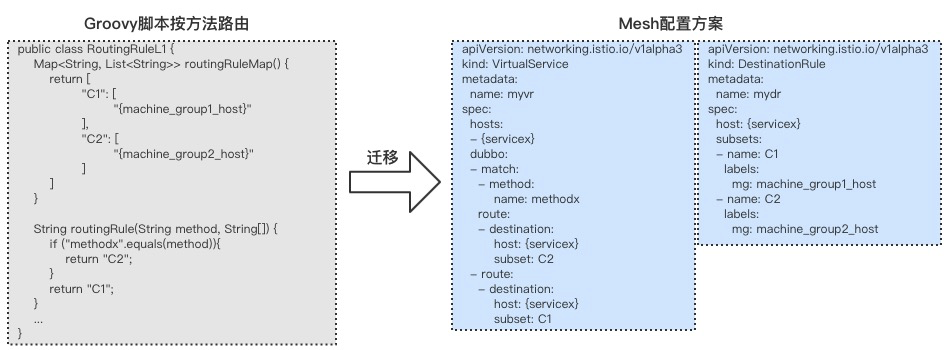

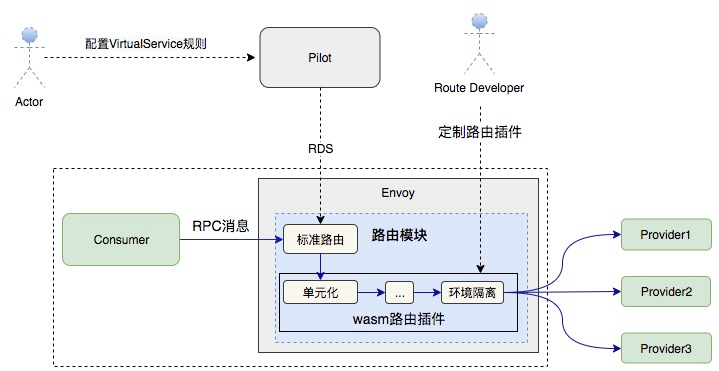

жЬ™жЭ•зЪД Service Mesh еєґдЄНжЙУзЃЧжПРдЊЫ Groovy иДЪжЬђйВ£дєИзБµжіїзЪДиЈѓзФ±з≠ЦзХ•еЃЪеИґжЦєж°ИпЉМйБњеЕНеЫ†дЄЇињЗдЇОзБµжіїиАМзїЩ Service Mesh иЗ™иЇЂзЪДжЉФињЫеЄ¶еОїжО£иВШгАВеЫ†ж≠§пЉМжИСдїђеЖ≥еЃЪеАЯ Mesh еМЦзЪДжЬЇдЉЪеОїйЩ§¬†Groovy иДЪжЬђгАВйАЪињЗиРљеЬ∞еЇФзФ®жЙАдљњзФ® Groovy иДЪжЬђзЪДеЬЇжЩѓеИЖжЮРпЉМжИСдїђжКљи±°еЗЇдЇЖдЄАе•Чзђ¶еРИдЇСеОЯзФЯзЪДиІ£еЖ≥жЦєж°ИпЉЪжЙ©е±Х Istio еОЯзФЯзЪД CRD дЄ≠зЪД VirtualService еТМ DestinationRuleпЉМеҐЮеК† RPC еНПиЃЃжЙАйЬАзЪДиЈѓзФ±йЕНзљЃжЃµеОїи°®иЊЊиЈѓзФ±з≠ЦзХ•гАВ

зЫЃеЙНйШњйЗМеЈіеЈізОѓеҐГдЄЛзЪДеНХеЕГеМЦгАБзОѓеҐГйЪФз¶їз≠Йз≠ЦзХ•йГљжШѓеЬ® Istio/Envoy зЪДж†ЗеЗЖиЈѓзФ±ж®°еЭЧеЖЕеБЪдЇЖеЃЪеИґеЉАеПСпЉМдЄНеПѓйБњеЕНеЬ∞е≠ШеЬ®дЄАдЇЫ hack йАїиЊСгАВжЬ™жЭ•иЃ°еИТеЬ® Istio/Envoy зЪДж†ЗеЗЖиЈѓзФ±з≠ЦзХ•дєЛе§ЦпЉМиЃЊиЃ°дЄАе•ЧеЯЇдЇО Wasm зЪДиЈѓзФ±жПТдїґжЦєж°ИпЉМиЃ©йВ£дЇЫзЃАеНХзЪДиЈѓзФ±з≠ЦзХ•дї•жПТдїґзЪД嚥еЉПе≠ШеЬ®гАВе¶Вж≠§дЄАжЭ•пЉМжЧҐеЗПе∞СдЇЖеѓєж†ЗеЗЖиЈѓзФ±ж®°еЭЧзЪДдЊµеЕ•пЉМдєЯеЬ®дЄАеЃЪз®ЛеЇ¶дЄКжї°иґ≥дЇЖдЄЪеК°жЦєеѓєжЬНеК°иЈѓзФ±еЃЪеИґзЪДйЬАи¶БгАВиЃЊжГ≥зЪДжЮґжЮДе¶ВдЄЛеЫЊжЙАз§ЇпЉЪ

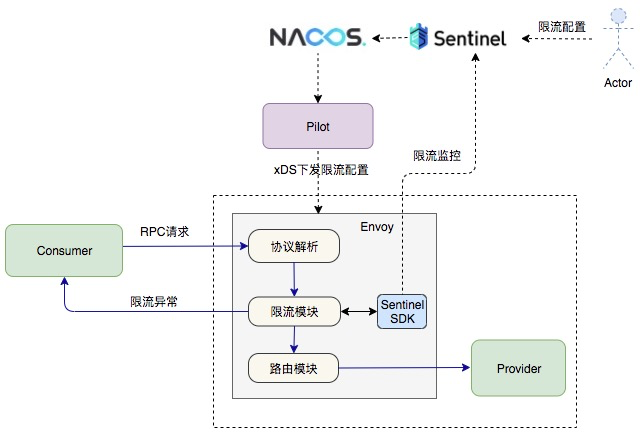

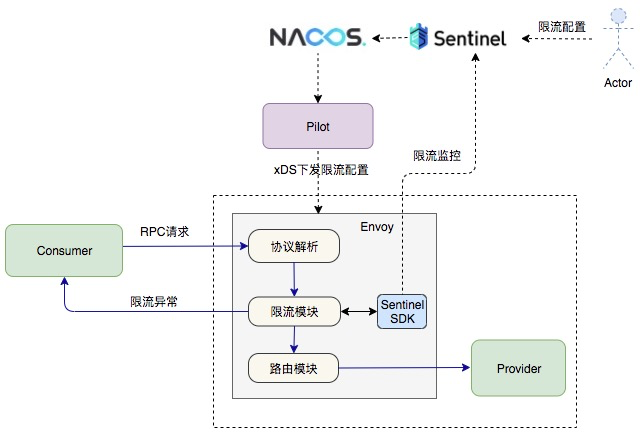

### йЩРжµБ

еЗЇдЇОжАІиГљиАГиЩСпЉМйШњйЗМеЈіеЈіеЖЕйГ®иРљеЬ∞зЪД Service Mesh жЦєж°Иеєґж≤°жЬЙйЗЗзФ® Istio дЄ≠зЪД Mixer зїДдїґпЉМйЩРжµБињЩеЭЧеКЯиГљеАЯеК©йШњйЗМеЈіеЈіеЖЕйГ®еєњж≥ЫдљњзФ®зЪД¬†[Sentinel зїДдїґ](https://yq.aliyun.com/go/articleRenderRedirect?url=https%3A%2F%2Fgithub.com%2Falibaba%2FSentinel)жЭ•еЃЮзО∞пЉМдЄНдїЕеПѓдї•дЄОеЈ≤зїПеЉАжЇРзЪД Sentinel 嚥жИРеРИеКЫпЉМињШеПѓдї•еЗПе∞СйШњйЗМеЈіеЈіеЖЕйГ®зФ®жИЈзЪДињБзІїжИРжЬђпЉИзЫіжО•еЕЉеЃєдЄЪеК°зЪДзО∞жЬЙйЕНзљЃжЭ•йЩРжµБпЉЙгАВдЄЇдЇЖжЦєдЊњ Mesh йЫЖжИРпЉМеЖЕйГ®е§ЪдЄ™еЫҐйШЯеРИдљЬеЉАеПСдЇЖ Sentinel зЪД¬†[C++зЙИжЬђ](https://yq.aliyun.com/go/articleRenderRedirect?url=https%3A%2F%2Fgithub.com%2Falibaba%2Fsentinel-cpp)пЉМжХідЄ™йЩРжµБзЪДеКЯиГљжШѓйАЪињЗ Envoy зЪД Filter жЬЇеИґжЭ•еЃЮзО∞зЪДпЉМжИСдїђеЬ® Dubbo еНПиЃЃдєЛдЄКжЮДеїЇдЇЖзЫЄеЇФзЪД FilterпЉИEnvoy дЄ≠зЪДжЬѓиѓ≠пЉМдї£и°®е§ДзРЖиѓЈж±ВзЪДдЄАдЄ™зЛђзЂЛеКЯиГљж®°еЭЧпЉЙпЉМжѓПдЄ™иѓЈж±ВйГљдЉЪзїПињЗ Sentinel Filter еБЪе§ДзРЖгАВйЩРжµБжЙАйЬАзЪДйЕНзљЃдњ°жБѓеИЩжШѓйАЪињЗ Pilot дїО Nacos дЄ≠иОЈеПЦпЉМеєґйАЪињЗ xDS еНПиЃЃдЄЛеПСеИ∞ Envoy дЄ≠гАВ

3\. Envoy зЪДиµДжЇРеЉАйФАињЗе§І

-----------------

Envoy иѓЮзФЯдєЛеИЭи¶БиІ£еЖ≥зЪДдЄАдЄ™ж†ЄењГйЧЃйҐШе∞±жШѓжЬНеК°зЪДеПѓиІВжµЛжАІпЉМеЫ†ж≠§ Envoy дЄАеЉАеІЛе∞±еЖЕзљЃдЇЖе§ІйЗПзЪД statsпЉИеН≥зїЯиЃ°дњ°жБѓпЉЙпЉМдї•дЊњжЫіе•љеЬ∞еѓєжЬНеК°ињЫи°МиІВжµЛгАВ

Envoy зЪД stats з≤ТеЇ¶еЊИзїЖпЉМзФЪиЗ≥зїЖеИ∞жХідЄ™йЫЖзЊ§зЪД IP зЇІеИЂпЉМеЬ®йШњйЗМеЈіеЈізОѓеҐГдЄЛпЉМжЯРдЇЫзФµеХЖеЇФзФ®зЪД Consumer еТМ Provider жЬНеК°еК†иµЈжЭ•иЊЊеИ∞дЇЖеЗ†еНБдЄЗдєЛе§ЪзЪД IPпЉИжѓПдЄ™ IP еЬ®дЄНеРМзЪДжЬНеК°дЄЛжРЇеЄ¶зЪДеЕГдњ°жБѓдЄНеРМпЉМжЙАдї•дЄНеРМзЪДжЬНеК°дЄЛзЪДзЫЄеРМ IP жШѓеРДиЗ™зЛђзЂЛзЪДпЉЙгАВе¶Вж≠§дЄАжЭ•пЉМEnvoy еЬ®ињЩеЭЧзЪДеЖЕе≠ШеЉАйФАзФЪжШѓеЈ®е§ІгАВдЄЇж≠§пЉМжИСдїђзїЩ Envoy еҐЮеК†дЇЖ stats еЉАеЕ≥пЉМзФ®дЇОеЕ≥йЧ≠жИЦжЙУеЉА IP зЇІеИЂзЪД statsпЉМеЕ≥йЧ≠ IP зЇІеИЂзЪД stats зЫіжО•еЄ¶жЭ•дЇЖеЖЕе≠ШиКВзЇ¶ 30% жИРжЮЬгАВдЄЛдЄАж≠•жИСдїђе∞ЖиЈЯињЫз§ЊеМЇзЪД stats symbol table зЪДжЦєж°ИжЭ•иІ£еЖ≥ stats жМЗж†Зе≠Чзђ¶дЄ≤йЗНе§НзЪДйЧЃйҐШпЉМйВ£жЧґзЪДеЖЕе≠ШеЉАйФАе∞ЖињЫдЄАж≠•еЗПе∞СгАВ

4\. иІ£иА¶дЄЪеК°дЄОеЯЇз°АиЃЊжЦљпЉМеЃЮзО∞еЯЇз°АиЃЊжЦљеНЗзЇІеѓєдЄЪеК°жЧ†жДЯ

---------------------------

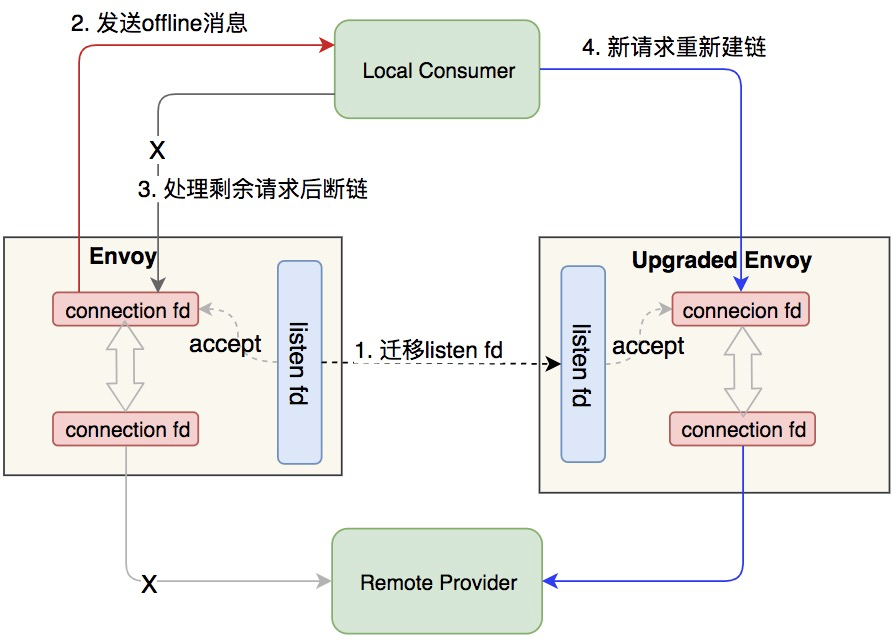

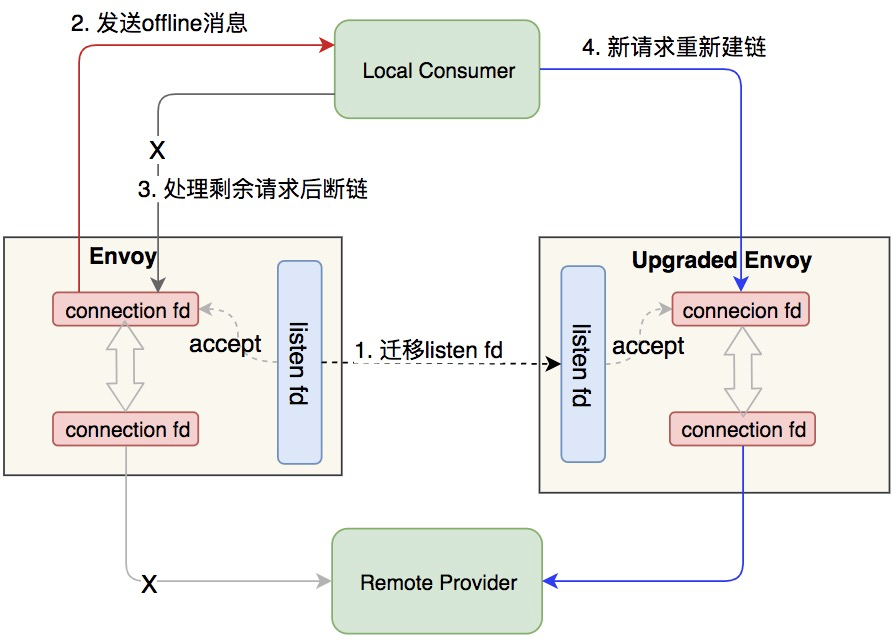

Service Mesh иРљеЬ∞зЪДдЄАй°єж†ЄењГдїЈеАЉе∞±жШѓиЃ©еЯЇз°АиЃЊжЦљдЄОдЄЪеК°йАїиЊСеЃМеЕ®иІ£иА¶пЉМдЄ§иАЕеПѓдї•зЛђзЂЛжЉФињЫгАВдЄЇдЇЖеЃЮзО∞ињЩдЄ™ж†ЄењГдїЈеАЉпЉМSidecar йЬАи¶БеЕЈе§ЗзГ≠еНЗзЇІиГљеКЫпЉМдї•дЊњеНЗзЇІжЧґдЄНдЉЪйА†жИРдЄЪеК°жµБйЗПдЄ≠жЦ≠пЉМињЩеѓєжЦєж°ИиЃЊиЃ°еТМжКАжЬѓеЃЮзО∞зЪДжМСжИШињШжШѓиЫЃе§ІзЪДгАВ

жИСдїђзЪДзГ≠еНЗзЇІйЗЗзФ®еПМињЫз®ЛжЦєж°ИпЉМеЕИжЛЙиµЈжЦ∞зЪД Sidecar еЃєеЩ®пЉМзФ±еЃГдЄОжЧІзЪД Sidecar ињЫи°МињРи°МжЧґжХ∞жНЃдЇ§жО•пЉМеЬ®жЦ∞зЪД Sidecar еЗЖе§ЗеПСжО•зЃ°жµБйЗПеРОпЉМиЃ©жЧІзЪД Sidecar з≠ЙеЊЕдЄАеЃЪжЧґйЧіеРОйААеЗЇпЉМжЬАзїИеЃЮзО∞дЄЪеК°жµБйЗПжЧ†жНЯгАВж†ЄењГжКАжЬѓдЄїи¶БжШѓињРзФ®дЇЖ¬†[Unix Domain¬†Socket](https://yq.aliyun.com/go/articleRenderRedirect?url=https%3A%2F%2Fen.wikipedia.org%2Fwiki%2FUnix_domain_socket)¬†еТМ RPC зЪДиКВзВєдЉШйЫЕдЄЛзЇњеКЯиГљгАВдЄЛеЫЊе§ІиЗіз§ЇдЊЛдЇЖеЕ≥йФЃињЗз®ЛгАВ

жХ∞жНЃи°®зО∞

====

еЕђеЄГжАІиГљжХ∞жНЃдЄАдЄНе∞ПењГе∞±дЉЪеЉХеПСдЇЙиЃЃеТМиѓѓиІ£пЉМеЫ†дЄЇжАІиГљжХ∞жНЃзЪДеЬЇжЩѓе≠ШеЬ®еЊИе§ЪеПШйЗПгАВжѓФе¶ВпЉМеєґеПСеЇ¶гАБQPSгАБpayload е§Іе∞Пз≠ЙеѓєжЬАзїИзЪДжХ∞жНЃи°®зО∞е∞ЖдЇІзФЯеЕ≥йФЃељ±еУНгАВдєЯж≠£еЫ†е¶Вж≠§пЉМEnvoy еЃШжЦєдїОжЭ•ж≤°жЬЙжПРдЊЫињЗжЬђжЦЗжЙАеИЧеЗЇзЪДињЩдЇЫжХ∞жНЃпЉМиГМеРОзЪДеОЯеЫ†ж≠£жШѓеЕґдљЬиАЕ Matt Klein жЛЕењГеЉХеПСиѓѓиІ£гАВеАЉеЊЧеЉЇи∞ГзЪДжШѓпЉМеЬ®жЧґйЧійЭЮеЄЄзіІињЂзЪДжГЕ嚥дЄЛпЉМжИСдїђжЙАиРљеЬ∞зЪД Service Mesh еєґйЭЮе§ДдЇОжЬАдЉШзКґжАБпЉМзФЪиЗ≥дЄНжШѓжЬАзїИжЦєж°ИпЉИжѓФе¶В Consumer дЊІе≠ШеЬ®дЄ§жђ°иЈѓзФ±зЪДйЧЃйҐШпЉЙгАВжИСдїђдєЛжЙАдї•йАЙжЛ©еИЖдЇЂеЗЇжЭ•пЉМжШѓеЄМжЬЫиЃ©жЫіе§ЪзЪДеРМи°МдЇЖиІ£жИСдїђзЪДињЫе±ХеТМзКґжАБгАВ

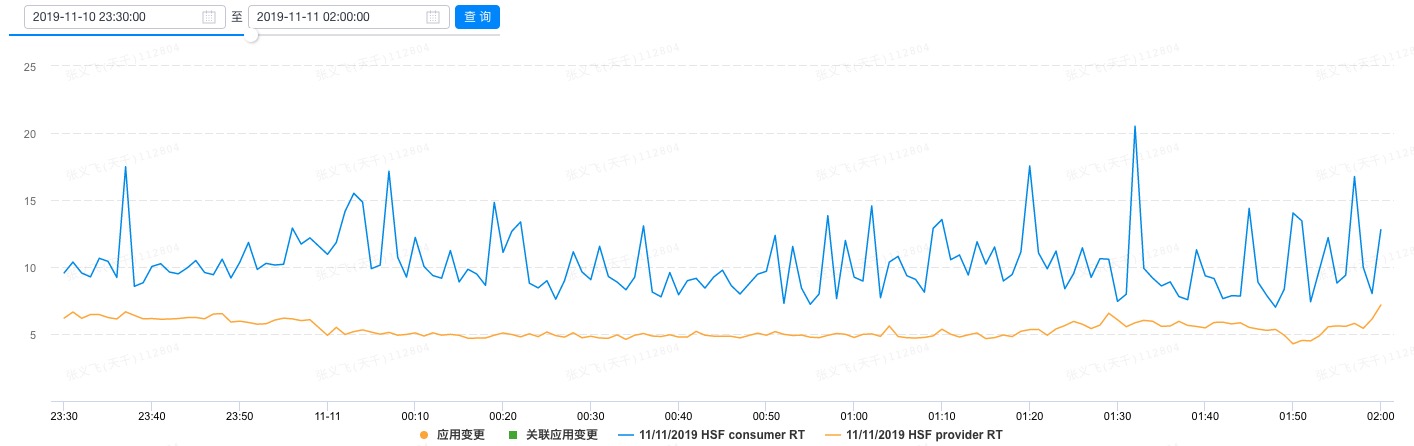

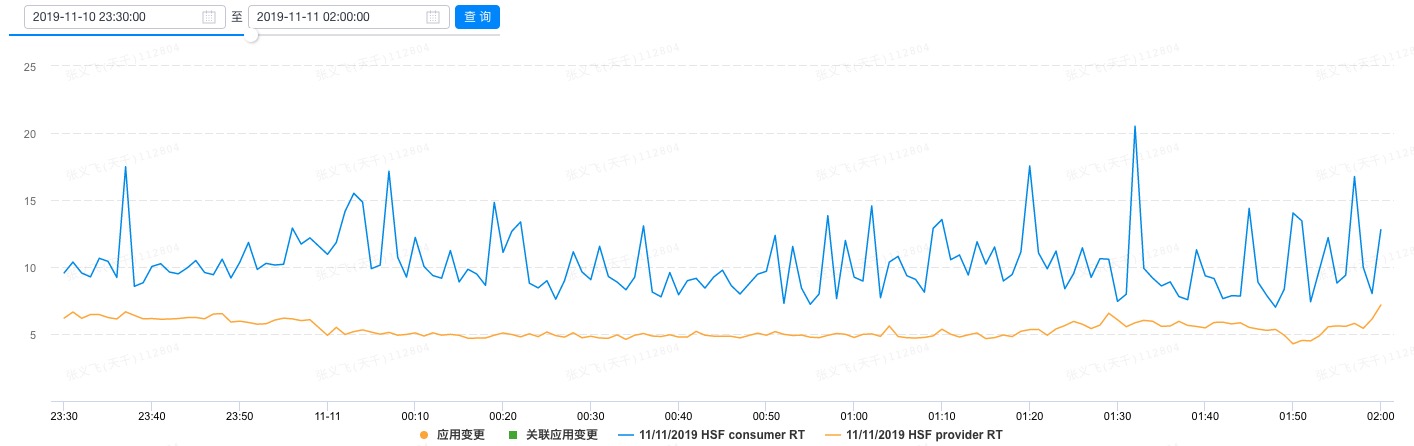

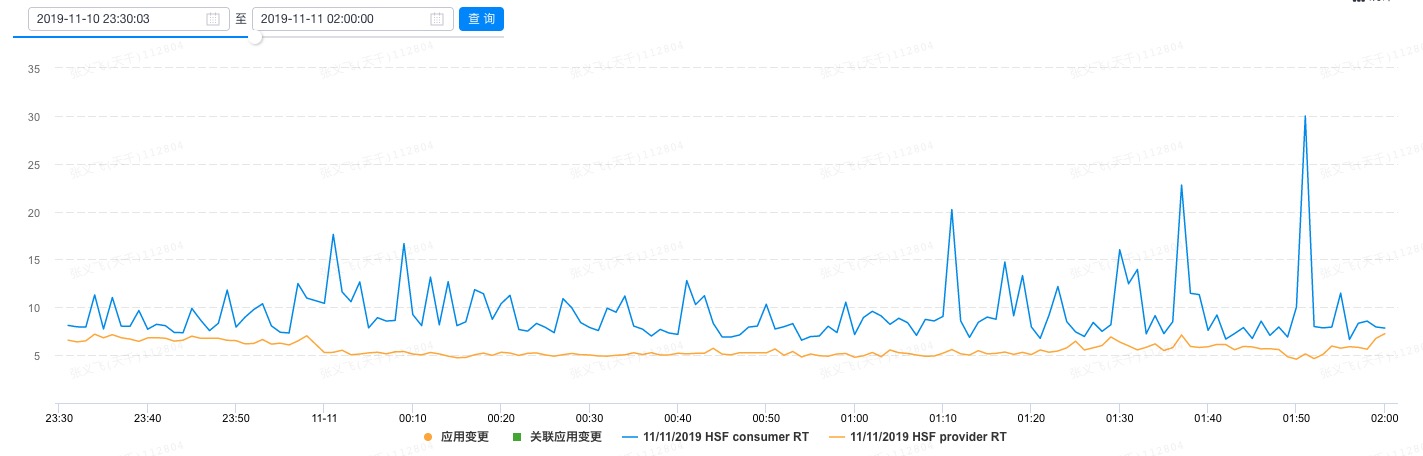

жЬђжЦЗеП™еИЧеЗЇдЇЖ еПМ11 жЙАдЄКзЇњж†ЄењГеЇФзФ®дЄ≠жЯРдЄАдЄ™зЪДжХ∞жНЃгАВдїОеНХжЬЇ RT жКљж†ЈзЪДиІТеЇ¶пЉМйГ®зљ≤дЇЖ Service Mesh зЪДжЯРеП∞жЬЇеЩ®пЉМеЕґ Provider дЊІзЪД RT еЭЗеАЉжШѓ 5.6msпЉМConsumer дЊІзЪДжШѓ 10.36msгАВиѓ•жЬЇеЩ®еЬ® еПМ11 йЫґзВєйЩДињСзЪД RT и°®зО∞е¶ВдЄЛеЫЊжЙАз§ЇпЉЪ

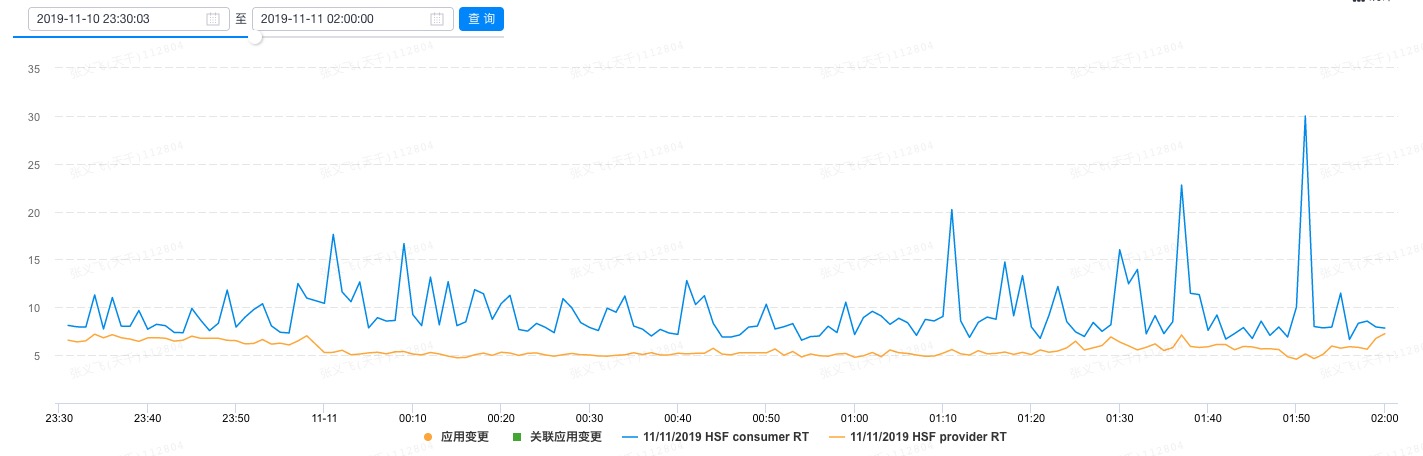

ж≤°жЬЙйГ®зљ≤ Service Mesh зЪДжЯРеП∞жЬЇеЩ®пЉМProvider дЊІзЪДеЭЗеАЉдЄЇ 5.34msпЉМConsumer дЊІзЪДеИЩжШѓ 9.31msгАВдЄЛеЫЊз§ЇдЊЛдЇЖиѓ•жЬЇеЩ®еЬ® еПМ11 йЫґзВєйЩДдїґзЪД RT и°®зО∞гАВ

зЫЄжѓФдєЛдЄЛпЉМProvider дЊІзЪД RT еЬ® Mesh еМЦеЙНеРОеҐЮеК†дЇЖ 0.26msпЉМConsumer дЊІеИЩеҐЮеК†дЇЖ 1.05msгАВж≥®жДПпЉМињЩдЄ™ RT еЈЃжШѓеМЕеРЂдЇЖдЄЪеК°еЇФзФ®еИ∞ SidecarпЉМдї•еПК Sidecar е§ДзРЖзЪДжЙАжЬЙжЧґйЧіеЬ®еЖЕзЪДпЉМдЄЛеЫЊз§ЇдЊЛиѓіжШОдЇЖеЄ¶жЭ•жЧґеїґеҐЮеК†зЪДйУЊиЈѓгАВ

жХідљУдЄКпЉМиѓ•ж†ЄењГеЇФзФ®жЙАжЬЙдЄКзЇњдЇЖ Service Mesh зЪДжЬЇеЩ®еТМж≤°жЬЙдЄКзЇњ Service Mesh зЪДжЬЇеЩ®еЬ®жЯРдЄ™жЧґйЧіжЃµзЪДжХідљУеЭЗеАЉжХ∞жНЃеБЪдЇЖеѓєжѓФгАВProvider дЊІ Mesh еМЦеРОзЪД RT еҐЮеК†дЇЖ 0.52msпЉМиАМ Consumer дЊІеҐЮеК†дЇЖ 1.63msгАВ

еЬ® CPU еТМеЖЕе≠ШеЉАйФАжЦєйЭҐпЉМMesh еМЦдєЛеРОпЉМEnvoy жЙАжґИиАЧзЪД CPU еЬ®жЙАжЬЙж†ЄењГеЇФзФ®дЄКйГљзїіжМБеЬ® 0.1 ж†ЄеЈ¶еП≥пЉМдЉЪйЪПзЭА Pilot жО®йАБжХ∞жНЃиАМдЇІзФЯжѓЫеИЇгАВжЬ™жЭ•йЬАи¶БеАЯеК© Pilot еТМ Envoy дєЛйЧізЪДеҐЮйЗПжО®йАБеОїеѓєжѓЫеИЇеБЪдЉШеМЦгАВеЖЕе≠ШзЪДеЉАйФАйЪПзЭАеЇФзФ®зЪДжЬНеК°еТМйЫЖзЊ§иІДж®°дЄНеРМиАМе≠ШеЬ®еЈ®е§ІеЈЃеЉВпЉМзЫЃеЙНзЬЛжЭ• Envoy еЬ®еЖЕе≠ШзЪДдљњзФ®дЄКдїНе≠ШеЬ®еЊИе§ІзЪДдЉШеМЦз©ЇйЧігАВ

дїОжЙАжЬЙеПМ11 дЄКзЇњзЪДж†ЄењГеЇФзФ®зЪДжХ∞жНЃи°®зО∞жЭ•зЬЛпЉМService Mesh зЪДеЉХеЕ•еѓєдЇО RT зЪДељ±еУНеТМеЄ¶жЭ•зЪД CPU еЉАйФАжШѓеЯЇжЬђдЄАж†ЈзЪДпЉМиАМеЖЕе≠ШеЉАйФАеИЩеЫ†дЄЇдЊЭиµЦжЬНеК°еТМйЫЖзЊ§иІДж®°зЪДдЄНеРМиАМжЬЙзЫЄељУе§ІзЪДеЈЃеЉВгАВ

е±ХжЬЫ

==

еЬ®дЇСеОЯзФЯзЪДжµ™жљЃдЄЛпЉМйШњйЗМеЈіеЈіеАЯињЩж≥ҐжКАжЬѓжµ™жљЃиЗіеКЫдЇОжЙУйА†йЭҐеРСжЬ™жЭ•зЪДжКАжЬѓеЯЇз°АиЃЊжЦљгАВеЬ®еПСе±ХзЪДйБУиЈѓдЄКе∞ЖиіѓељївАЬеАЯеКЫеЉАжЇРпЉМеПНеУЇеЉАжЇРвАЭзЪДеПСе±ХжАЭиЈѓпЉМйАЪињЗеЉАжЇРеЃЮзО∞жКАжЬѓжЩЃжГ†пЉМдЄЇжЬ™жЭ•зЪДдЇСеОЯзФЯжКАжЬѓеЬ®жЫіе§ІиМГеЫізЪДжЩЃеПКеБЪеЗЇиЗ™еЈ±зЪДиі°зМЃгАВ

жО•дЄЛжЭ•пЉМжИСдїђзЪДжХідљУжКАжЬѓзЭАеКЫзВєеЬ®дЇОпЉЪ

* дЄО Istio еЉАжЇРз§ЊеМЇеЕ±еРМеҐЮеЉЇ Pilot зЪДжХ∞жНЃжО®йАБиГљеКЫгАВеЬ®йШњйЗМеЈіеЈіеЕЈе§З еПМ11 ињЩзІНиґЕе§ІиІДж®°зЪДеЇФзФ®еЬЇжЩѓдЄЛпЉМжИСдїђеѓєдЇОPilot зЪДжХ∞жНЃжО®йАБиГљеКЫжЬЙзЭАжЮБиЗізЪДи¶Бж±ВпЉМзЫЄдњ°еЬ®ињљж±ВжЮБиЗізЪДињЗз®ЛдЄ≠пЉМиГљдЄОеЉАжЇРз§ЊеМЇдЄАйБУеК†йАЯеЕ®зРГдЇЛеЃЮж†ЗеЗЖзЪДеЕ±еїЇгАВдїОйШњйЗМеЈіеЈіеЖЕйГ®жЭ•зЬЛпЉМжИСдїђзЫЃеЙНжЛЙйАЪдЇЖдЄО Nacos еЫҐйШЯзЪДеЕ±еїЇпЉМе∞ЖйАЪињЗз§ЊеМЇзЪД MCP еНПиЃЃдЄО Nacos еѓєжО•пЉМиЃ©йШњйЗМеЈіеЈіжЙАеЉАжЇРзЪДеРДзІНжКАжЬѓзїДдїґиГљдљУз≥їеМЦеЬ∞еНПеРМеЈ•дљЬпЉЫ

* дї• Istio еТМ Envoy дЄЇдЄАдљУпЉМињЫдЄАж≠•дЉШеМЦдЄ§иАЕзЪДеНПиЃЃдї•еПКеРДиЗ™зЪДзЃ°зРЖжХ∞жНЃзїУжЮДпЉМйАЪињЗжЫіеК†з≤ЊзВЉгАБжЫіеК†еРИзРЖзЪДжХ∞жНЃзїУжЮДеОїеЗПе∞СеРДиЗ™зЪДеЖЕе≠ШеЉАйФАпЉЫ

* зЭАеКЫиІ£еЖ≥е§ІиІДж®° Sidecar зЪДињРзїіиГљеКЫеїЇиЃЊгАВиЃ© Sidecar зЪДеНЗзЇІеБЪеИ∞еПѓзБ∞еЇ¶гАБеПѓзЫСжОІеТМеПѓеЫЮжїЪпЉЫ

* еЕСзО∞ Service Mesh зЪДдїЈеАЉпЉМиЃ©дЄЪеК°дЄОжКАжЬѓиЃЊжЦљиГљдї•жЫійЂШзЪДжХИзОЗељЉж≠§зЛђзЂЛжЉФињЫгАВ

[еОЯжЦЗйУЊжО•](https://link.zhihu.com/?target=https%3A//yq.aliyun.com/articles/730349%3Futm_content%3Dg_1000090543)

жЬђжЦЗдЄЇйШњйЗМдЇСеЖЕеЃєпЉМжЬ™зїПеЕБиЃЄдЄНеЊЧиљђиљљгАВ

====

еИЗеЕ•дЄїйҐШеЙНпЉМйЬАи¶БдЇ§дї£дЄАдЄЛеЬ® еПМ11 ж†ЄењГеЇФзФ®дЄКиРљеЬ∞зЪДйГ®зљ≤жЮґжЮДпЉМе¶ВдЄЛеЫЊжЙАз§ЇгАВеЬ®ињЩзѓЗжЦЗзЂ†дЄ≠пЉМжИСдїђдЄїи¶БиБЪзД¶дЇО Service A еТМ Service B дєЛйЧі RPC еНПиЃЃзЪД Mesh еМЦгАВ

еЫЊдЄ≠з§ЇдЊЛиѓіжШОдЇЖ Service Mesh жЙАеМЕеРЂзЪДдЄЙе§Іеє≥йЭҐпЉЪеН≥жХ∞жНЃеє≥йЭҐпЉИData PlaneпЉЙгАБжОІеИґеє≥йЭҐпЉИControl PlaneпЉЙеТМињРзїіеє≥йЭҐпЉИOperation PlaneпЉЙгАВжХ∞жНЃеє≥йЭҐжИСдїђйЗЗзФ®зЪДжШѓеЉАжЇРзЪД EnvoyпЉИдЄКеЫЊдЄ≠зЪД SidecarпЉМиѓЈиѓїиАЕж≥®жДПињЩдЄ§дЄ™иѓНеЬ®жЬђжЦЗдЄ≠еПѓдї•дЇТжНҐдљњзФ®пЉЙпЉМжОІеИґеє≥йЭҐйЗЗзФ®зЪДжШѓеЉАжЇРзЪД IstioпЉИзЫЃеЙНеП™дљњзФ®дЇЖеЕґдЄ≠зЪД Pilot зїДдїґпЉЙпЉМињРзїіеє≥йЭҐеИЩеЃМеЕ®иЗ™з†ФгАВ

дЄОеНКеєіеЙНиРљеЬ∞жЧґдЄНеРМпЉМињЩжђ° еПМ11 ж†ЄењГеЇФзФ®дЄКиРљеЬ∞жИСдїђйЗЗзФ®дЇЖ Pilot йЫЖзЊ§еМЦйГ®зљ≤зЪДж®°еЉПпЉМеН≥ Pilot дЄНеЖНдЄО Envoy дЄАиµЈйГ®зљ≤еИ∞дЄЪеК°еЃєеЩ®дЄ≠пЉМиАМжШѓжР≠еїЇдЇЖдЄАдЄ™зЛђзЂЛзЪДйЫЖзЊ§гАВињЩдЄАеПШеМЦдљњеЊЧжОІеИґеє≥йЭҐзЪДйГ®зљ≤жЦєеЉПжЉФињЫеИ∞дЇЖ Service Mesh еЇФжЬЙзЪДзїИжАБгАВ

жМСжИШ

==

иРљеЬ∞жЙАйАЙжЛ©зЪД еПМ11 ж†ЄењГеЇФзФ®йГљжШѓйЗЗзФ® Java зЉЦз®Лиѓ≠и®АеЃЮзО∞зЪДпЉМеЬ®иРљеЬ∞зЪДињЗз®ЛдЄ≠жИСдїђйЭҐдЄідЇЖдї•дЄЛжМСжИШгАВ

1\. еЬ® SDK жЧ†ж≥ХеНЗзЇІзЪДжГЕ嚥дЄЛе¶ВдљХеЃЮзО∞еЇФзФ®зЪД Mesh еМЦ

--------------------------------

еЬ®еЖ≥еЃЪи¶БеЬ® еПМ11 зЪДж†ЄењГеЇФзФ®дЄКиРљеЬ∞ Mesh жЧґпЉМJava еЇФзФ®дЊЭиµЦзЪД RPC SDK зЙИжЬђеЈ≤зїПеЃЪз®њпЉМдЄЇдЇЖ Mesh еМЦеЃМеЕ®ж≤°жЬЙжЧґйЧіеОїеЉАеПСдЄАдЄ™йАВзФ®дЇО Mesh зЪД RPC SDK еєґеБЪеНЗзЇІгАВйВ£жЧґпЉМжСЖеЬ®еЫҐйШЯйЭҐеЙНзЪДжКАжЬѓйЧЃйҐШжШѓпЉЪе¶ВдљХеЬ®дЄНеНЗзЇІ SDK зЪДжГЕ嚥дЄЛпЉМеЃЮзО∞ RPC еНПиЃЃзЪД Mesh еМЦпЉЯ

зЖЯжВЙ Istio зЪДиѓїиАЕжГ≥ењЕжЄЕж•ЪпЉМIstio жШѓйАЪињЗ iptables зЪД NAT и°®еОїеБЪжµБйЗПйАПжШОжЛ¶жИ™зЪДпЉМйАЪињЗжµБйЗПйАПжШОжЛ¶жИ™еПѓеЬ®еЇФзФ®жЧ†жДЯзЪДжГЕ嚥дЄЛе∞ЖжµБйЗПеКЂжМБеИ∞ Envoy дЄ≠дїОиАМеЃЮзО∞ Mesh еМЦгАВдљЖеЊИдЄНеєЄпЉМNAT и°®жЙАдљњзФ®еИ∞зЪД nf\_contrack еЖЕж†Єж®°еЭЧеЫ†дЄЇжХИзОЗеЊИдљОпЉМеЬ®йШњйЗМеЈіеЈізЪДзЇњдЄКзФЯдЇІжЬЇеЩ®дЄ≠襀еОїйЩ§дЇЖпЉМеЫ†ж≠§жЧ†ж≥ХзЫіжО•дљњзФ®з§ЊеМЇзЪДжЦєж°ИгАВе•љеЬ®еєіеИЭеЉАеІЛдЄНдєЕжИСдїђдЄОйШњйЗМеЈіеЈі¬†OS еЫҐйШЯиЊЊжИРдЇЖеРИдљЬеЕ±еїЇпЉМзФ±дїЦдїђиіЯиі£жЙњжЛЕ Service Mesh жЙАйЬАзЪДжµБйЗПйАПжШОжЛ¶жИ™еТМзљСзїЬеК†йАЯињЩдЄ§еЭЧеЯЇз°АиГљеКЫзЪДеїЇиЃЊгАВзїПињЗдЄ§дЄ™еЫҐйШЯзЪДзіІеѓЖеРИдљЬпЉМOS еЫҐйШЯжΥ糥дЇЖйАЪињЗеЯЇдЇО userid еТМ mark ж†ЗиѓЖжµБйЗПзЪДйАПжШОжЛ¶жИ™жЦєж°ИпЉМеЯЇдЇО iptables зЪД mangle и°®еЃЮзО∞дЇЖдЄАдЄ™еЕ®жЦ∞зЪДйАПжШОжЛ¶жИ™зїДдїґгАВ

дЄЛеЫЊз§ЇдЊЛиѓіжШОдЇЖе≠ШеЬ®йАПжШОжЛ¶жИ™зїДдїґзЪДжГЕ嚥дЄЛпЉМRPC жЬНеК°и∞ГзФ®зЪДжµБйЗПиµ∞еРСгАВеЕґдЄ≠пЉМInbound жµБйЗПжШѓжМЗи∞ГињЫжЭ•зЪДжµБйЗПпЉИжµБйЗПзЪДжО•еПЧиАЕжШѓ Provider иІТиЙ≤пЉЙпЉМиАМ Outbound жШѓжМЗи∞ГеЗЇеОїзЪДжµБйЗПпЉИжµБйЗПзЪДеПСеЗЇиАЕжШѓ Consumer иІТиЙ≤пЉЙгАВйАЪеЄЄдЄАдЄ™еЇФзФ®дЉЪеРМжЧґжЙњжЛЕдЄ§дЄ™иІТиЙ≤пЉМжЙАдї•жЬЙ Inbound еТМ Outbound дЄ§иВ°жµБйЗПеєґе≠ШгАВ

жЬЙдЇЖйАПжШОжЛ¶жИ™зїДдїґдєЛеРОпЉМеЇФзФ®зЪД Mesh еМЦеЃМеЕ®иГљеБЪеИ∞жЧ†жДЯпЉМињЩе∞ЖжЮБе§ІеЬ∞жФєеЦД Mesh иРљеЬ∞зЪДдЊњеИ©жАІгАВељУзДґпЉМзФ±дЇО RPC зЪД SDK дїНе≠ШеЬ®дї•еЙНзЪДжЬНеК°еПСзО∞еТМиЈѓзФ±йАїиЊСпЉМиАМиѓ•жµБйЗП襀еКЂжМБеИ∞ Envoy дєЛеРОеПИдЉЪеЖНеБЪдЄАжђ°пЉМињЩе∞ЖеѓЉиЗі Outbound зЪДжµБйЗПдЉЪеЫ†дЄЇе≠ШеЬ®дЄ§жђ°жЬНеК°еПСзО∞еТМиЈѓзФ±иАМеҐЮеК† RTпЉМињЩеЬ®еРОйЭҐзЪДжХ∞жНЃйГ®еИЖдєЯе∞ЖжЬЙжЙАдљУзО∞гАВжШЊзДґпЉМдї•зїИжАБиРљеЬ∞ Service Mesh жЧґпЉМйЬАи¶БеОїйЩ§ RPC SDK дЄ≠зЪДжЬНеК°еПСзО∞дЄОиЈѓзФ±йАїиЊСпЉМе∞ЖзЫЄеЇФзЪД CPU еТМеЖЕе≠ШеЉАйФАзїЩиКВзЇ¶дЄЛжЭ•гАВ

2.зЯ≠жЧґйЧіеЖЕжФѓжМБзФµеХЖдЄЪеК°е§НжЭВзЪДжЬНеК°ж≤їзРЖеКЯиГљ

---------------------

### иЈѓзФ±

еЬ®йШњйЗМеЈіеЈізФµеХЖдЄЪеК°еЬЇжЩѓдЄЛзЪДиЈѓзФ±зЙєжАІдЄ∞еѓМе§Ъж†ЈпЉМйЩ§дЇЖи¶БжФѓжМБеНХеЕГеМЦгАБзОѓеҐГйЪФз¶їз≠ЙиЈѓзФ±з≠ЦзХ•пЉМињШеЊЧж†єжНЃ RPC иѓЈж±ВзЪДжЦєж≥ХеРНгАБи∞ГзФ®еПВжХ∞гАБеЇФзФ®еРНз≠ЙеЃМжИРжЬНеК°иЈѓзФ±гАВйШњйЗМеЈіеЈіеЖЕйГ®зЪД Java¬†RPC ж°ЖжЮґжШѓйАЪињЗеµМеЕ• Groovy иДЪжЬђжЭ•жФѓжМБињЩдЇЫиЈѓзФ±з≠ЦзХ•зЪДпЉМдЄЪеК°жЦєеЬ®ињРзїіжОІеИґеП∞дЄКйЕНзљЃ Groovy иЈѓзФ±ж®°жЭњпЉМSDK еПСиµЈи∞ГзФ®жЧґдЉЪжЙІи°Миѓ•иДЪжЬђеЃМжИРиЈѓзФ±з≠ЦзХ•зЪДињРзФ®гАВ

жЬ™жЭ•зЪД Service Mesh еєґдЄНжЙУзЃЧжПРдЊЫ Groovy иДЪжЬђйВ£дєИзБµжіїзЪДиЈѓзФ±з≠ЦзХ•еЃЪеИґжЦєж°ИпЉМйБњеЕНеЫ†дЄЇињЗдЇОзБµжіїиАМзїЩ Service Mesh иЗ™иЇЂзЪДжЉФињЫеЄ¶еОїжО£иВШгАВеЫ†ж≠§пЉМжИСдїђеЖ≥еЃЪеАЯ Mesh еМЦзЪДжЬЇдЉЪеОїйЩ§¬†Groovy иДЪжЬђгАВйАЪињЗиРљеЬ∞еЇФзФ®жЙАдљњзФ® Groovy иДЪжЬђзЪДеЬЇжЩѓеИЖжЮРпЉМжИСдїђжКљи±°еЗЇдЇЖдЄАе•Чзђ¶еРИдЇСеОЯзФЯзЪДиІ£еЖ≥жЦєж°ИпЉЪжЙ©е±Х Istio еОЯзФЯзЪД CRD дЄ≠зЪД VirtualService еТМ DestinationRuleпЉМеҐЮеК† RPC еНПиЃЃжЙАйЬАзЪДиЈѓзФ±йЕНзљЃжЃµеОїи°®иЊЊиЈѓзФ±з≠ЦзХ•гАВ

зЫЃеЙНйШњйЗМеЈіеЈізОѓеҐГдЄЛзЪДеНХеЕГеМЦгАБзОѓеҐГйЪФз¶їз≠Йз≠ЦзХ•йГљжШѓеЬ® Istio/Envoy зЪДж†ЗеЗЖиЈѓзФ±ж®°еЭЧеЖЕеБЪдЇЖеЃЪеИґеЉАеПСпЉМдЄНеПѓйБњеЕНеЬ∞е≠ШеЬ®дЄАдЇЫ hack йАїиЊСгАВжЬ™жЭ•иЃ°еИТеЬ® Istio/Envoy зЪДж†ЗеЗЖиЈѓзФ±з≠ЦзХ•дєЛе§ЦпЉМиЃЊиЃ°дЄАе•ЧеЯЇдЇО Wasm зЪДиЈѓзФ±жПТдїґжЦєж°ИпЉМиЃ©йВ£дЇЫзЃАеНХзЪДиЈѓзФ±з≠ЦзХ•дї•жПТдїґзЪД嚥еЉПе≠ШеЬ®гАВе¶Вж≠§дЄАжЭ•пЉМжЧҐеЗПе∞СдЇЖеѓєж†ЗеЗЖиЈѓзФ±ж®°еЭЧзЪДдЊµеЕ•пЉМдєЯеЬ®дЄАеЃЪз®ЛеЇ¶дЄКжї°иґ≥дЇЖдЄЪеК°жЦєеѓєжЬНеК°иЈѓзФ±еЃЪеИґзЪДйЬАи¶БгАВиЃЊжГ≥зЪДжЮґжЮДе¶ВдЄЛеЫЊжЙАз§ЇпЉЪ

### йЩРжµБ

еЗЇдЇОжАІиГљиАГиЩСпЉМйШњйЗМеЈіеЈіеЖЕйГ®иРљеЬ∞зЪД Service Mesh жЦєж°Иеєґж≤°жЬЙйЗЗзФ® Istio дЄ≠зЪД Mixer зїДдїґпЉМйЩРжµБињЩеЭЧеКЯиГљеАЯеК©йШњйЗМеЈіеЈіеЖЕйГ®еєњж≥ЫдљњзФ®зЪД¬†[Sentinel зїДдїґ](https://yq.aliyun.com/go/articleRenderRedirect?url=https%3A%2F%2Fgithub.com%2Falibaba%2FSentinel)жЭ•еЃЮзО∞пЉМдЄНдїЕеПѓдї•дЄОеЈ≤зїПеЉАжЇРзЪД Sentinel 嚥жИРеРИеКЫпЉМињШеПѓдї•еЗПе∞СйШњйЗМеЈіеЈіеЖЕйГ®зФ®жИЈзЪДињБзІїжИРжЬђпЉИзЫіжО•еЕЉеЃєдЄЪеК°зЪДзО∞жЬЙйЕНзљЃжЭ•йЩРжµБпЉЙгАВдЄЇдЇЖжЦєдЊњ Mesh йЫЖжИРпЉМеЖЕйГ®е§ЪдЄ™еЫҐйШЯеРИдљЬеЉАеПСдЇЖ Sentinel зЪД¬†[C++зЙИжЬђ](https://yq.aliyun.com/go/articleRenderRedirect?url=https%3A%2F%2Fgithub.com%2Falibaba%2Fsentinel-cpp)пЉМжХідЄ™йЩРжµБзЪДеКЯиГљжШѓйАЪињЗ Envoy зЪД Filter жЬЇеИґжЭ•еЃЮзО∞зЪДпЉМжИСдїђеЬ® Dubbo еНПиЃЃдєЛдЄКжЮДеїЇдЇЖзЫЄеЇФзЪД FilterпЉИEnvoy дЄ≠зЪДжЬѓиѓ≠пЉМдї£и°®е§ДзРЖиѓЈж±ВзЪДдЄАдЄ™зЛђзЂЛеКЯиГљж®°еЭЧпЉЙпЉМжѓПдЄ™иѓЈж±ВйГљдЉЪзїПињЗ Sentinel Filter еБЪе§ДзРЖгАВйЩРжµБжЙАйЬАзЪДйЕНзљЃдњ°жБѓеИЩжШѓйАЪињЗ Pilot дїО Nacos дЄ≠иОЈеПЦпЉМеєґйАЪињЗ xDS еНПиЃЃдЄЛеПСеИ∞ Envoy дЄ≠гАВ

3\. Envoy зЪДиµДжЇРеЉАйФАињЗе§І

-----------------

Envoy иѓЮзФЯдєЛеИЭи¶БиІ£еЖ≥зЪДдЄАдЄ™ж†ЄењГйЧЃйҐШе∞±жШѓжЬНеК°зЪДеПѓиІВжµЛжАІпЉМеЫ†ж≠§ Envoy дЄАеЉАеІЛе∞±еЖЕзљЃдЇЖе§ІйЗПзЪД statsпЉИеН≥зїЯиЃ°дњ°жБѓпЉЙпЉМдї•дЊњжЫіе•љеЬ∞еѓєжЬНеК°ињЫи°МиІВжµЛгАВ

Envoy зЪД stats з≤ТеЇ¶еЊИзїЖпЉМзФЪиЗ≥зїЖеИ∞жХідЄ™йЫЖзЊ§зЪД IP зЇІеИЂпЉМеЬ®йШњйЗМеЈіеЈізОѓеҐГдЄЛпЉМжЯРдЇЫзФµеХЖеЇФзФ®зЪД Consumer еТМ Provider жЬНеК°еК†иµЈжЭ•иЊЊеИ∞дЇЖеЗ†еНБдЄЗдєЛе§ЪзЪД IPпЉИжѓПдЄ™ IP еЬ®дЄНеРМзЪДжЬНеК°дЄЛжРЇеЄ¶зЪДеЕГдњ°жБѓдЄНеРМпЉМжЙАдї•дЄНеРМзЪДжЬНеК°дЄЛзЪДзЫЄеРМ IP жШѓеРДиЗ™зЛђзЂЛзЪДпЉЙгАВе¶Вж≠§дЄАжЭ•пЉМEnvoy еЬ®ињЩеЭЧзЪДеЖЕе≠ШеЉАйФАзФЪжШѓеЈ®е§ІгАВдЄЇж≠§пЉМжИСдїђзїЩ Envoy еҐЮеК†дЇЖ stats еЉАеЕ≥пЉМзФ®дЇОеЕ≥йЧ≠жИЦжЙУеЉА IP зЇІеИЂзЪД statsпЉМеЕ≥йЧ≠ IP зЇІеИЂзЪД stats зЫіжО•еЄ¶жЭ•дЇЖеЖЕе≠ШиКВзЇ¶ 30% жИРжЮЬгАВдЄЛдЄАж≠•жИСдїђе∞ЖиЈЯињЫз§ЊеМЇзЪД stats symbol table зЪДжЦєж°ИжЭ•иІ£еЖ≥ stats жМЗж†Зе≠Чзђ¶дЄ≤йЗНе§НзЪДйЧЃйҐШпЉМйВ£жЧґзЪДеЖЕе≠ШеЉАйФАе∞ЖињЫдЄАж≠•еЗПе∞СгАВ

4\. иІ£иА¶дЄЪеК°дЄОеЯЇз°АиЃЊжЦљпЉМеЃЮзО∞еЯЇз°АиЃЊжЦљеНЗзЇІеѓєдЄЪеК°жЧ†жДЯ

---------------------------

Service Mesh иРљеЬ∞зЪДдЄАй°єж†ЄењГдїЈеАЉе∞±жШѓиЃ©еЯЇз°АиЃЊжЦљдЄОдЄЪеК°йАїиЊСеЃМеЕ®иІ£иА¶пЉМдЄ§иАЕеПѓдї•зЛђзЂЛжЉФињЫгАВдЄЇдЇЖеЃЮзО∞ињЩдЄ™ж†ЄењГдїЈеАЉпЉМSidecar йЬАи¶БеЕЈе§ЗзГ≠еНЗзЇІиГљеКЫпЉМдї•дЊњеНЗзЇІжЧґдЄНдЉЪйА†жИРдЄЪеК°жµБйЗПдЄ≠жЦ≠пЉМињЩеѓєжЦєж°ИиЃЊиЃ°еТМжКАжЬѓеЃЮзО∞зЪДжМСжИШињШжШѓиЫЃе§ІзЪДгАВ

жИСдїђзЪДзГ≠еНЗзЇІйЗЗзФ®еПМињЫз®ЛжЦєж°ИпЉМеЕИжЛЙиµЈжЦ∞зЪД Sidecar еЃєеЩ®пЉМзФ±еЃГдЄОжЧІзЪД Sidecar ињЫи°МињРи°МжЧґжХ∞жНЃдЇ§жО•пЉМеЬ®жЦ∞зЪД Sidecar еЗЖе§ЗеПСжО•зЃ°жµБйЗПеРОпЉМиЃ©жЧІзЪД Sidecar з≠ЙеЊЕдЄАеЃЪжЧґйЧіеРОйААеЗЇпЉМжЬАзїИеЃЮзО∞дЄЪеК°жµБйЗПжЧ†жНЯгАВж†ЄењГжКАжЬѓдЄїи¶БжШѓињРзФ®дЇЖ¬†[Unix Domain¬†Socket](https://yq.aliyun.com/go/articleRenderRedirect?url=https%3A%2F%2Fen.wikipedia.org%2Fwiki%2FUnix_domain_socket)¬†еТМ RPC зЪДиКВзВєдЉШйЫЕдЄЛзЇњеКЯиГљгАВдЄЛеЫЊе§ІиЗіз§ЇдЊЛдЇЖеЕ≥йФЃињЗз®ЛгАВ

жХ∞жНЃи°®зО∞

====

еЕђеЄГжАІиГљжХ∞жНЃдЄАдЄНе∞ПењГе∞±дЉЪеЉХеПСдЇЙиЃЃеТМиѓѓиІ£пЉМеЫ†дЄЇжАІиГљжХ∞жНЃзЪДеЬЇжЩѓе≠ШеЬ®еЊИе§ЪеПШйЗПгАВжѓФе¶ВпЉМеєґеПСеЇ¶гАБQPSгАБpayload е§Іе∞Пз≠ЙеѓєжЬАзїИзЪДжХ∞жНЃи°®зО∞е∞ЖдЇІзФЯеЕ≥йФЃељ±еУНгАВдєЯж≠£еЫ†е¶Вж≠§пЉМEnvoy еЃШжЦєдїОжЭ•ж≤°жЬЙжПРдЊЫињЗжЬђжЦЗжЙАеИЧеЗЇзЪДињЩдЇЫжХ∞жНЃпЉМиГМеРОзЪДеОЯеЫ†ж≠£жШѓеЕґдљЬиАЕ Matt Klein жЛЕењГеЉХеПСиѓѓиІ£гАВеАЉеЊЧеЉЇи∞ГзЪДжШѓпЉМеЬ®жЧґйЧійЭЮеЄЄзіІињЂзЪДжГЕ嚥дЄЛпЉМжИСдїђжЙАиРљеЬ∞зЪД Service Mesh еєґйЭЮе§ДдЇОжЬАдЉШзКґжАБпЉМзФЪиЗ≥дЄНжШѓжЬАзїИжЦєж°ИпЉИжѓФе¶В Consumer дЊІе≠ШеЬ®дЄ§жђ°иЈѓзФ±зЪДйЧЃйҐШпЉЙгАВжИСдїђдєЛжЙАдї•йАЙжЛ©еИЖдЇЂеЗЇжЭ•пЉМжШѓеЄМжЬЫиЃ©жЫіе§ЪзЪДеРМи°МдЇЖиІ£жИСдїђзЪДињЫе±ХеТМзКґжАБгАВ

жЬђжЦЗеП™еИЧеЗЇдЇЖ еПМ11 жЙАдЄКзЇњж†ЄењГеЇФзФ®дЄ≠жЯРдЄАдЄ™зЪДжХ∞жНЃгАВдїОеНХжЬЇ RT жКљж†ЈзЪДиІТеЇ¶пЉМйГ®зљ≤дЇЖ Service Mesh зЪДжЯРеП∞жЬЇеЩ®пЉМеЕґ Provider дЊІзЪД RT еЭЗеАЉжШѓ 5.6msпЉМConsumer дЊІзЪДжШѓ 10.36msгАВиѓ•жЬЇеЩ®еЬ® еПМ11 йЫґзВєйЩДињСзЪД RT и°®зО∞е¶ВдЄЛеЫЊжЙАз§ЇпЉЪ

ж≤°жЬЙйГ®зљ≤ Service Mesh зЪДжЯРеП∞жЬЇеЩ®пЉМProvider дЊІзЪДеЭЗеАЉдЄЇ 5.34msпЉМConsumer дЊІзЪДеИЩжШѓ 9.31msгАВдЄЛеЫЊз§ЇдЊЛдЇЖиѓ•жЬЇеЩ®еЬ® еПМ11 йЫґзВєйЩДдїґзЪД RT и°®зО∞гАВ

зЫЄжѓФдєЛдЄЛпЉМProvider дЊІзЪД RT еЬ® Mesh еМЦеЙНеРОеҐЮеК†дЇЖ 0.26msпЉМConsumer дЊІеИЩеҐЮеК†дЇЖ 1.05msгАВж≥®жДПпЉМињЩдЄ™ RT еЈЃжШѓеМЕеРЂдЇЖдЄЪеК°еЇФзФ®еИ∞ SidecarпЉМдї•еПК Sidecar е§ДзРЖзЪДжЙАжЬЙжЧґйЧіеЬ®еЖЕзЪДпЉМдЄЛеЫЊз§ЇдЊЛиѓіжШОдЇЖеЄ¶жЭ•жЧґеїґеҐЮеК†зЪДйУЊиЈѓгАВ

жХідљУдЄКпЉМиѓ•ж†ЄењГеЇФзФ®жЙАжЬЙдЄКзЇњдЇЖ Service Mesh зЪДжЬЇеЩ®еТМж≤°жЬЙдЄКзЇњ Service Mesh зЪДжЬЇеЩ®еЬ®жЯРдЄ™жЧґйЧіжЃµзЪДжХідљУеЭЗеАЉжХ∞жНЃеБЪдЇЖеѓєжѓФгАВProvider дЊІ Mesh еМЦеРОзЪД RT еҐЮеК†дЇЖ 0.52msпЉМиАМ Consumer дЊІеҐЮеК†дЇЖ 1.63msгАВ

еЬ® CPU еТМеЖЕе≠ШеЉАйФАжЦєйЭҐпЉМMesh еМЦдєЛеРОпЉМEnvoy жЙАжґИиАЧзЪД CPU еЬ®жЙАжЬЙж†ЄењГеЇФзФ®дЄКйГљзїіжМБеЬ® 0.1 ж†ЄеЈ¶еП≥пЉМдЉЪйЪПзЭА Pilot жО®йАБжХ∞жНЃиАМдЇІзФЯжѓЫеИЇгАВжЬ™жЭ•йЬАи¶БеАЯеК© Pilot еТМ Envoy дєЛйЧізЪДеҐЮйЗПжО®йАБеОїеѓєжѓЫеИЇеБЪдЉШеМЦгАВеЖЕе≠ШзЪДеЉАйФАйЪПзЭАеЇФзФ®зЪДжЬНеК°еТМйЫЖзЊ§иІДж®°дЄНеРМиАМе≠ШеЬ®еЈ®е§ІеЈЃеЉВпЉМзЫЃеЙНзЬЛжЭ• Envoy еЬ®еЖЕе≠ШзЪДдљњзФ®дЄКдїНе≠ШеЬ®еЊИе§ІзЪДдЉШеМЦз©ЇйЧігАВ

дїОжЙАжЬЙеПМ11 дЄКзЇњзЪДж†ЄењГеЇФзФ®зЪДжХ∞жНЃи°®зО∞жЭ•зЬЛпЉМService Mesh зЪДеЉХеЕ•еѓєдЇО RT зЪДељ±еУНеТМеЄ¶жЭ•зЪД CPU еЉАйФАжШѓеЯЇжЬђдЄАж†ЈзЪДпЉМиАМеЖЕе≠ШеЉАйФАеИЩеЫ†дЄЇдЊЭиµЦжЬНеК°еТМйЫЖзЊ§иІДж®°зЪДдЄНеРМиАМжЬЙзЫЄељУе§ІзЪДеЈЃеЉВгАВ

е±ХжЬЫ

==

еЬ®дЇСеОЯзФЯзЪДжµ™жљЃдЄЛпЉМйШњйЗМеЈіеЈіеАЯињЩж≥ҐжКАжЬѓжµ™жљЃиЗіеКЫдЇОжЙУйА†йЭҐеРСжЬ™жЭ•зЪДжКАжЬѓеЯЇз°АиЃЊжЦљгАВеЬ®еПСе±ХзЪДйБУиЈѓдЄКе∞ЖиіѓељївАЬеАЯеКЫеЉАжЇРпЉМеПНеУЇеЉАжЇРвАЭзЪДеПСе±ХжАЭиЈѓпЉМйАЪињЗеЉАжЇРеЃЮзО∞жКАжЬѓжЩЃжГ†пЉМдЄЇжЬ™жЭ•зЪДдЇСеОЯзФЯжКАжЬѓеЬ®жЫіе§ІиМГеЫізЪДжЩЃеПКеБЪеЗЇиЗ™еЈ±зЪДиі°зМЃгАВ

жО•дЄЛжЭ•пЉМжИСдїђзЪДжХідљУжКАжЬѓзЭАеКЫзВєеЬ®дЇОпЉЪ

* дЄО Istio еЉАжЇРз§ЊеМЇеЕ±еРМеҐЮеЉЇ Pilot зЪДжХ∞жНЃжО®йАБиГљеКЫгАВеЬ®йШњйЗМеЈіеЈіеЕЈе§З еПМ11 ињЩзІНиґЕе§ІиІДж®°зЪДеЇФзФ®еЬЇжЩѓдЄЛпЉМжИСдїђеѓєдЇОPilot зЪДжХ∞жНЃжО®йАБиГљеКЫжЬЙзЭАжЮБиЗізЪДи¶Бж±ВпЉМзЫЄдњ°еЬ®ињљж±ВжЮБиЗізЪДињЗз®ЛдЄ≠пЉМиГљдЄОеЉАжЇРз§ЊеМЇдЄАйБУеК†йАЯеЕ®зРГдЇЛеЃЮж†ЗеЗЖзЪДеЕ±еїЇгАВдїОйШњйЗМеЈіеЈіеЖЕйГ®жЭ•зЬЛпЉМжИСдїђзЫЃеЙНжЛЙйАЪдЇЖдЄО Nacos еЫҐйШЯзЪДеЕ±еїЇпЉМе∞ЖйАЪињЗз§ЊеМЇзЪД MCP еНПиЃЃдЄО Nacos еѓєжО•пЉМиЃ©йШњйЗМеЈіеЈіжЙАеЉАжЇРзЪДеРДзІНжКАжЬѓзїДдїґиГљдљУз≥їеМЦеЬ∞еНПеРМеЈ•дљЬпЉЫ

* дї• Istio еТМ Envoy дЄЇдЄАдљУпЉМињЫдЄАж≠•дЉШеМЦдЄ§иАЕзЪДеНПиЃЃдї•еПКеРДиЗ™зЪДзЃ°зРЖжХ∞жНЃзїУжЮДпЉМйАЪињЗжЫіеК†з≤ЊзВЉгАБжЫіеК†еРИзРЖзЪДжХ∞жНЃзїУжЮДеОїеЗПе∞СеРДиЗ™зЪДеЖЕе≠ШеЉАйФАпЉЫ

* зЭАеКЫиІ£еЖ≥е§ІиІДж®° Sidecar зЪДињРзїіиГљеКЫеїЇиЃЊгАВиЃ© Sidecar зЪДеНЗзЇІеБЪеИ∞еПѓзБ∞еЇ¶гАБеПѓзЫСжОІеТМеПѓеЫЮжїЪпЉЫ

* еЕСзО∞ Service Mesh зЪДдїЈеАЉпЉМиЃ©дЄЪеК°дЄОжКАжЬѓиЃЊжЦљиГљдї•жЫійЂШзЪДжХИзОЗељЉж≠§зЛђзЂЛжЉФињЫгАВ

[еОЯжЦЗйУЊжО•](https://link.zhihu.com/?target=https%3A//yq.aliyun.com/articles/730349%3Futm_content%3Dg_1000090543)

жЬђжЦЗдЄЇйШњйЗМдЇСеЖЕеЃєпЉМжЬ™зїПеЕБиЃЄдЄНеЊЧиљђиљљгАВ

- 2019-12-17 15:50

- жµПиІИ 583

- иѓДиЃЇ(0)

- еИЖз±ї:и°МдЄЪеЇФзФ®

- жЯ•зЬЛжЫіе§Ъ

зЫЄеЕ≥жО®иНР

йШњйЗМеЈіеЈіеЬ®иРљеЬ∞Service MeshзЪДињЗз®ЛдЄ≠йБЗеИ∞дЇЖеЕЈдљУжМСжИШгАВй¶ЦеЕИжШѓSDKеНЗзЇІзЪДйЧЃйҐШпЉМзФ±дЇОжЯРдЇЫеЇФзФ®жЧ†ж≥ХжИЦдЄНжДњеНЗзЇІRPC-SDKпЉМйШњйЗМеЈіеЈідЄНеЊЧдЄНеѓїж±ВжЫњдї£жЦєж°ИпЉМе¶ВдЄОAliOSеЫҐйШЯеРИдљЬпЉМеИ©зФ®iptablesзЪДmangleи°®еЃЮзО∞йАПжШОжЛ¶жИ™гАВеЕґжђ°пЉМ...

дЄЙгАБйШњйЗМеЈіеЈізЪДеЃЮиЈµдЄОжМСжИШ 1. SDKеНЗзЇІйЪЊйҐШпЉЪеЬ®жЯРдЇЫжГЕеЖµдЄЛпЉМзФ±дЇОжЧ†ж≥ХеНЗзЇІRPC-SDKпЉМеЇФзФ®зЪДmeshеМЦеПШеЊЧеЫ∞йЪЊгАВйШњйЗМеЈіеЈійАЪињЗдЄОAliOSеЫҐйШЯеРИдљЬпЉМеИ©зФ®iptablesзЪДmangleи°®еЉАеПСеЗЇйАПжШОжЛ¶жИ™зїДдїґпЉМиІ£еЖ≥дЇЖињЩдЄАйЧЃйҐШгАВ 2. е§НжЭВжЬНеК°...

### зЯ•иѓЖзВєдЇМпЉЪйШњйЗМеЈіеЈіиРљеЬ∞ Service Mesh зЪДжМСжИШдЄОеѓєз≠Ц #### йШњйЗМеЈіеЈійЭҐдЄізЪДжМСжИШ 1. **SDK жЧ†ж≥ХеНЗзЇІзЪДжГЕеЖµдЄЛеЃЮзО∞еЇФзФ® Mesh еМЦ** - **иІ£еЖ≥жЦєж°И**пЉЪдЄО AliOS еЫҐйШЯеРИдљЬпЉМжΥ糥еЗЇдЄАзІНеЯЇдЇО userid еТМ mark ж†ЗиѓЖжµБйЗПзЪД...

Service MeshиРљеЬ∞жЧґйЭҐдЄізЪДжМСжИШеМЕжЛђжЦ∞жКАжЬѓзЪДеє≥жїСжЉФињЫгАБжКАжЬѓдЄОдЄЪеК°еПСе±ХзЪДеНПи∞ГгАБе§ДзРЖеОЖеП≤еМЕ襱пЉМдї•еПКеЕЛжЬНе§ІиІДж®°зОѓеҐГдЄЛзЪДйЧЃйҐШгАВеЕґдЄ≠пЉМжХ∞жНЃеє≥йЭҐеТМжОІеИґеє≥йЭҐзЪДеєґйЗНеПСе±ХжШѓеЕ≥йФЃпЉМзїПеОЖдЇЖдїОеЯЇз°А嚥жАБеИ∞дЄЙдљНдЄАдљУзЪДжЉФињЫињЗз®ЛгАВеЬ®дЄЪеК°...

йШњйЗМеЈіеЈідљЬдЄЇжЛ•жЬЙеЇЮе§ІеЊЃжЬНеК°жЮґжЮДзЪДдЉБдЄЪпЉМйЭҐдЄідЉЧе§ЪжМСжИШпЉМе¶ВдЄЪеК°е§НжЭВеЇ¶йЂШгАБжЬНеК°еПѓиІБжАІзЉЇдєПйЪФз¶їгАБжКАжЬѓж†ИдЄНеЭЗи°°дї•еПКеОЖеП≤еМЕ襱з≠ЙйЧЃйҐШгАВеЬ®ињЩж†ЈзЪДиГМжЩѓдЄЛпЉМService MeshдљЬдЄЇдЄАзІНжЦ∞еЕізЪДжКАжЬѓиІ£еЖ≥жЦєж°ИпЉМ襀зФ®жЭ•иІ£еЖ≥ињЩдЇЫйЧЃйҐШгАВ ...

Service Mesh еЬ®иґЕе§ІиІДж®°еЬЇжЩѓдЄЛзЪДиРљеЬ∞жМСжИШ Spring Cloud Alibaba еЬ® Kubernetes дЄЛзЪДеЊЃжЬНеК°ж≤їзРЖжЬАдљ≥еЃЮиЈµ дЇМгАБK8s жКАжЬѓдЄОеЃЮиЈµиЃЇеЭЫ дЄАзІНеЯЇдЇОз°ђе§ЪзІЯзЪДе§ІжХ∞жНЃ serverless иІ£еЖ≥жЦєж°И Alluxio еК©еКЫ KubernetesпЉМеК†йАЯдЇСзЂѓ...

йШњйЗМеЈіеЈіж†ЄењГеЇФзФ®иРљеЬ∞ Service Mesh зЪДжМСжИШдЄОжЬЇйБЗ йШњйЗМеЈіеЈідЇСеОЯзФЯеЉАжЇРжΥ糥дЄОеЃЮиЈµеПЄеЊТжФЊпЉИеІђй£ОпЉЙ йШњйЗМдЇСжЦЗдїґе≠ШеВ®пЉЪK8s дЇСеОЯзФЯеЬЇжЩѓдЄЛзЪДеЕ±дЇЂйЂШжАІиГље≠ШеВ® еЃЙеЕ®еЃєеЩ®зЪДеПСе±ХдЄОжАЭиАГ жЛРзВєеЈ≤иЗ≥пЉМ дЇСеОЯзФЯеЉХйҐЖжХ∞е≠ЧеМЦиљђеЮЛеНЗзЇІ жЛРзВє...

4. ServiceMeshзЪДиРљеЬ∞дЄОжМСжИШпЉЪжЬНеК°зљСж†ЉжШѓеЊЃжЬНеК°жЮґжЮДдЄ≠зЪДеЕ≥йФЃзїДжИРйГ®еИЖгАВжЦЗж°£дїЛзїНдЇЖServiceMeshеЬ®еПМ11жЬЯйЧізЪДиРљеЬ∞еЃЮиЈµдї•еПКжЙАеЕЛжЬНзЪДжМСжИШпЉМеєґеИЖдЇЂдЇЖжЬНеК°зљСж†ЉдЇІеУБеЬ®еЃЮиЈµдЄ≠зЪДжАЭиАГдЄОеЇФзФ®гАВ 5. ServerlessиЃ°зЃЧеє≥еП∞пЉЪ...

жК•еСКдЄ≠жПРеИ∞йШњйЗМйЫЖеЫҐеТМиЪВиЪБйЗСжЬНеЬ®Service MeshзЪДиРљеЬ∞еЃЮиЈµдЄ≠еЕЛжЬНдЇЖжМСжИШпЉМеЃЮзО∞дЇЖе§ІиІДж®°жЬНеК°йЧізЪДжЩЇиГљиЈѓзФ±еТМзЃ°зРЖгАВService MeshзЪДеПСе±ХжП≠з§ЇдЇЖеЕґеЬ®еЊЃжЬНеК°жЮґжЮДдЄ≠зЪДеЈ®е§ІжљЬеКЫеТМеПШйЭ©еКЫйЗПгАВ гАРServerlessиЃ°зЃЧгАС ServerlessиЃ°зЃЧ...

жЬђжК•еСКдЄ≠жПРеИ∞ServiceMeshеЬ®йШњйЗМеЈіеЈіж†ЄењГеЇФзФ®дЄ≠зЪДиРљеЬ∞еПКиЪВиЪБйЗСжЬНеПМ11жЬЯйЧізЪДиґЕе§ІиІДж®°иРљеЬ∞пЉМжШЊз§ЇдЇЖServiceMeshеЬ®жПРеНЗеЊЃжЬНеК°ж≤їзРЖиГљеКЫжЦєйЭҐзЪДйЗНи¶БжАІгАВ дЇФгАБServerless ServerlessиЃ°зЃЧжШѓдЇСиЃ°зЃЧзЪДдЄАзІН嚥еЉПпЉМеЃГеЕБиЃЄеЉАеПСиАЕ...

еПМзЃ°йљРдЄЛпЉЪ ServicemeshеТМDaprзЪДеЃЮиЈµдЄОе±ХжЬЫ дЇСеОЯзФЯжХ∞жНЃеЇУпЉЪдЄАзЂЩеЉПжХ∞жНЃжЬНеК°пЉЪ дЇСеОЯзФЯеИЖеЄГеЉПжХ∞жНЃеЇУ PolarDBжКАжЬѓжЈ±еЇ¶иІ£еѓЖ йШњйЗМеЈіеЈійЫЖеЫҐжХ∞жНЃеЇУжЬАдљ≥еЃЮиЈµ жХ∞жНЃеЇУе§ІжХ∞жНЃдЄАдљУеМЦпЉЪ еК†йАЯжХ∞жЩЇеМЦеИЫжЦ∞ жЦ∞зІСжКАиЊЊжС©йЩҐGanosжЧґз©Ї...

еЬ®иЪВиЪБйЗСжЬНеПМ11е§ІдњГдЄ≠пЉМService Mesh襀姲иІДж®°иРљеЬ∞пЉМиѓБжШОдЇЖеЕґеЬ®йЂШеєґеПСеЬЇжЩѓдЄЛзЪДз®≥еЃЪжАІеТМжХИзОЗгАВ гАРServerlessгАС ServerlessжШѓдЄАзІНиЃ°зЃЧжЙІи°Мж®°еЮЛпЉМзФ®жИЈжЧ†йЬАеЕ≥ењГеЇХе±ВжЬНеК°еЩ®иµДжЇРпЉМеП™йЬАеЕ≥ж≥®дЄЪеК°йАїиЊСгАВйШњйЗМдЇСзЪДServerless...

Service MeshдљЬдЄЇеП¶дЄАдЄ™еЕ≥йФЃиѓЭйҐШпЉМжК•еСКжМЗеЗЇеЃГе∞ЖеЄ¶жЭ•еПШйЭ©еТМжЬЇйБЗпЉМзЙєеИЂжШѓеЬ®йШњйЗМеЈіеЈійЫЖеЫҐеТМиЪВиЪБйЗСжЬНзЪДж†ЄењГеЇФзФ®дЄ≠пЉМService MeshзЪДиРљеЬ∞е±Хз§ЇдЇЖеЕґеЬ®иґЕе§ІиІДж®°зОѓеҐГдЄЛзЪДжљЬеКЫгАВеРМжЧґпЉМжК•еСКжОҐиЃ®дЇЖжЬНеК°зљСж†ЉеЬ®еЃЮйЩЕеЇФзФ®дЄ≠зЪДжМСжИШеТМ...

жЬђдє¶зЪДдљЬиАЕеЫҐйШЯжШѓйШњйЗМеЈіеЈідЄ≠йЧідїґеЫҐйШЯзЪДж†ЄењГжИРеСШпЉМдїЦдїђеЬ®еЊЃжЬНеК°йҐЖеЯЯжЛ•жЬЙдЄ∞еѓМзЪДзїПй™МеТМжЈ±еОЪзЪДзІѓзіѓпЉМдїЦдїђиі°зМЃзЪДеЉАжЇРй°єзЫЃе¶ВApache DubboгАБRocketMQгАБNacosгАБSpringCloud AlibabaеТМSeataз≠ЙпЉМжЮБе§ІеЬ∞жО®еК®дЇЖдЉБдЄЪеЊЃжЬНеК°еМЦжЮґжЮД...

ж≠§е§ЦпЉМйШњйЗМеЈіеЈізЪДDubboдєЯжШѓдЄАдЄ™еЉЇе§ІдЄФжИРзЖЯзЪДжЬНеК°ж≤їзРЖж°ЖжЮґпЉМйАВеРИJavaзОѓеҐГпЉМдљЖиЈ®иѓ≠и®АжФѓжМБзЫЄеѓєиЊГеЉ±гАВ 2. жЬНеК°ж≥®еЖМдЄОеПСзО∞пЉЪзФ®дЇОжЬНеК°йЧізЪДиЗ™еК®ж≥®еЖМеТМеПСзО∞пЉМдЊЛе¶ВEurekaпЉИNetflixпЉЙеТМConsulгАВ 3. иіЯиљљеЭЗи°°дЄОиЈѓзФ±пЉЪе¶ВRibbon...

KubernetesзЪДService MeshжЮґжЮДдєЯеЉАеІЛеРСеНХдљУжЮґжЮДеЫЮељТпЉМдЊЛе¶ВIstioжОІеИґйЭҐзЪДеНХдљУеМЦпЉМињЩдљњеЊЧжЬНеК°зљСж†ЉзЃ°зРЖеПШеЊЧжЫіеК†зЃАжіБйЂШжХИгАВ иЊєзЉШиЃ°зЃЧдљЬдЄЇдЇСиЃ°зЃЧзЪДдЄАзІНи°•еЕЕпЉМдєЯеЬ®жЦЗж°£дЄ≠襀жПРеПКгАВеЃГе∞ЖиЃ°зЃЧдїїеК°дїОдЄ≠ењГдЇСеїґдЉЄеИ∞зљСзїЬиЊєзЉШпЉМиЃ©...

иАМDubboдљЬдЄЇйШњйЗМеЈіеЈізЪДеЉАжЇРжИРжЮЬпЉМжПРдЊЫеЉЇе§ІзЪДжЬНеК°ж≤їзРЖеКЯиГљпЉМе∞§еЕґйАВеРИJavaеЉАеПСиАЕгАВеЃГжШѓдЄАзІНRPCж°ЖжЮґпЉМдЄОSpring Boot/CloudзЫЄжѓФпЉМDubboзЪДжЬНеК°и∞ГзФ®жЫійЂШжХИпЉМдљЖиЈ®иѓ≠и®АжФѓжМБдЄНе¶ВRESTfulжЦєж°ИгАВ еЬ®йАЙжЛ©жЬНеК°ж°ЖжЮґжЧґпЉМйЩ§дЇЖиАГиЩС...