作者 | 元毅 阿里云智能事业群高级开发工程师

> **导读:**当前在 Knative 中已经提供了对 Kafka 事件源的支持,那么如何基于 Kafka 实现消息推送呢?本文作者将以阿里云 Kafka 产品为例,给大家解锁这一新的姿势。

背景

--

消息队列 for Apache Kafka 是阿里云提供的分布式、高吞吐、可扩展的消息队列服务。消息队列 for Apache Kafka 广泛用于日志收集、监控数据聚合、流式数据处理、在线和离线分析等大数据领域,已成为大数据生态中不可或缺的部分。

结合 Knative 中提供了 KafkaSource 事件源的支持, 可以方便的对接 Kafka 消息服务。

另外也可以安装社区 Kafka 2.0.0 及以上版本使用。

在阿里云上创建 Kafka 实例

----------------

### 创建 Kafka 实例

登录[消息队列 Kafka 控制台](https://kafka.console.aliyun.com/), 选择【购买实例】。由于当前 Knative 中 Kafka 事件源支持 2.0.0 及以上版本,在阿里云上创建 Kafka 实例需要选择包年包月、专业版本进行购买,购买之后升级到 2.0.0 即可。

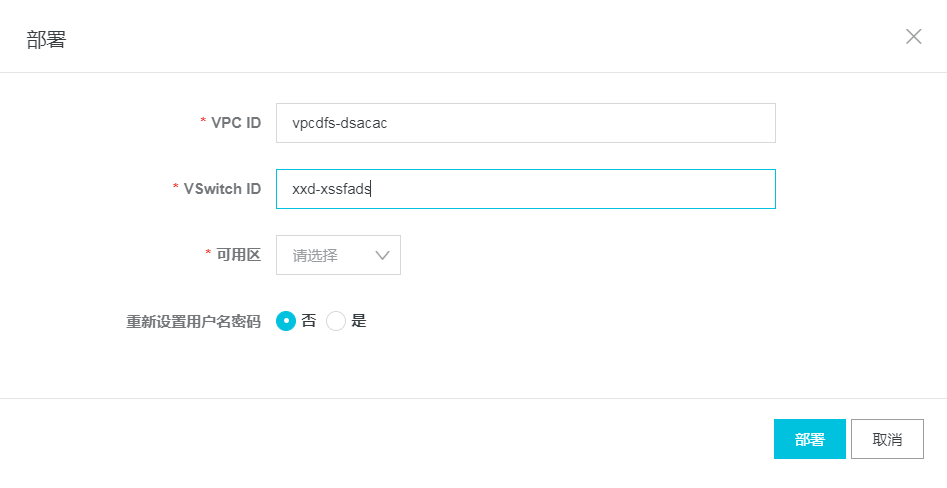

### 部署实例并绑定 VPC

购买完成之后,进行部署,部署时设置 Knative 集群所在的 VPC 即可:

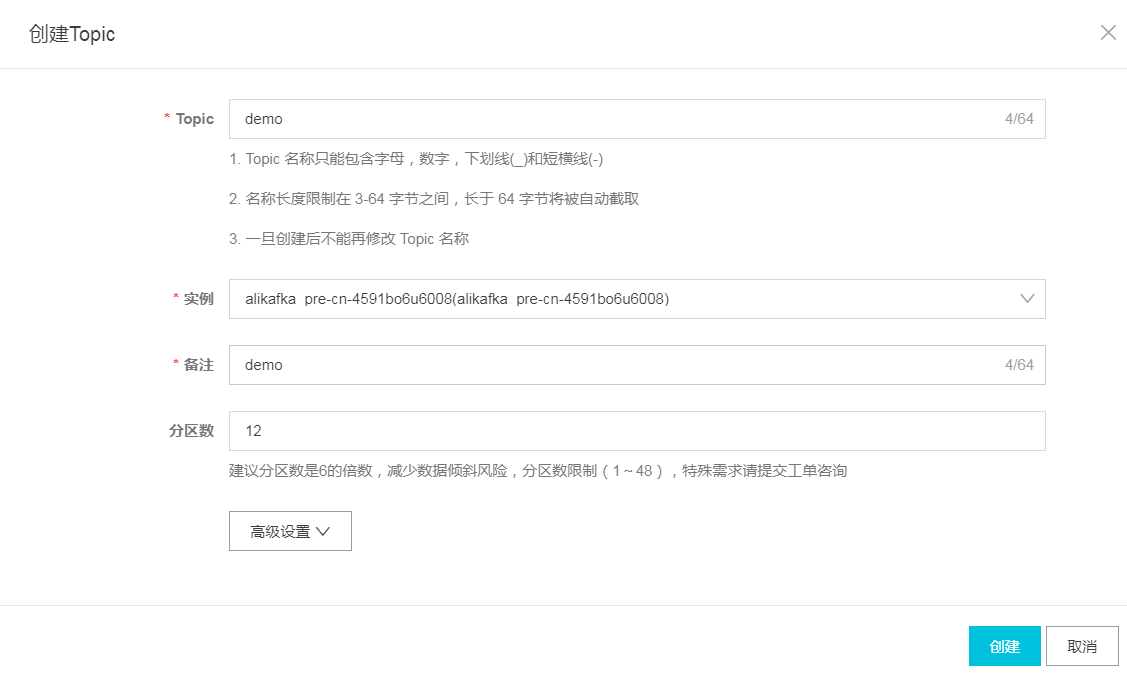

### 创建 Topic 和 Consumer Group

接下来我们创建 Topic 和消费组。

进入【Topic 管理】,点击 `创建 Topic`, 这里我们创建名称为 demo 的 topic:

进入【Consumer Group 管理】,点击 `创建 Consumer Group`, 这里我们创建名称为 demo-consumer 的消费组:

部署 Kafka 数据源

------------

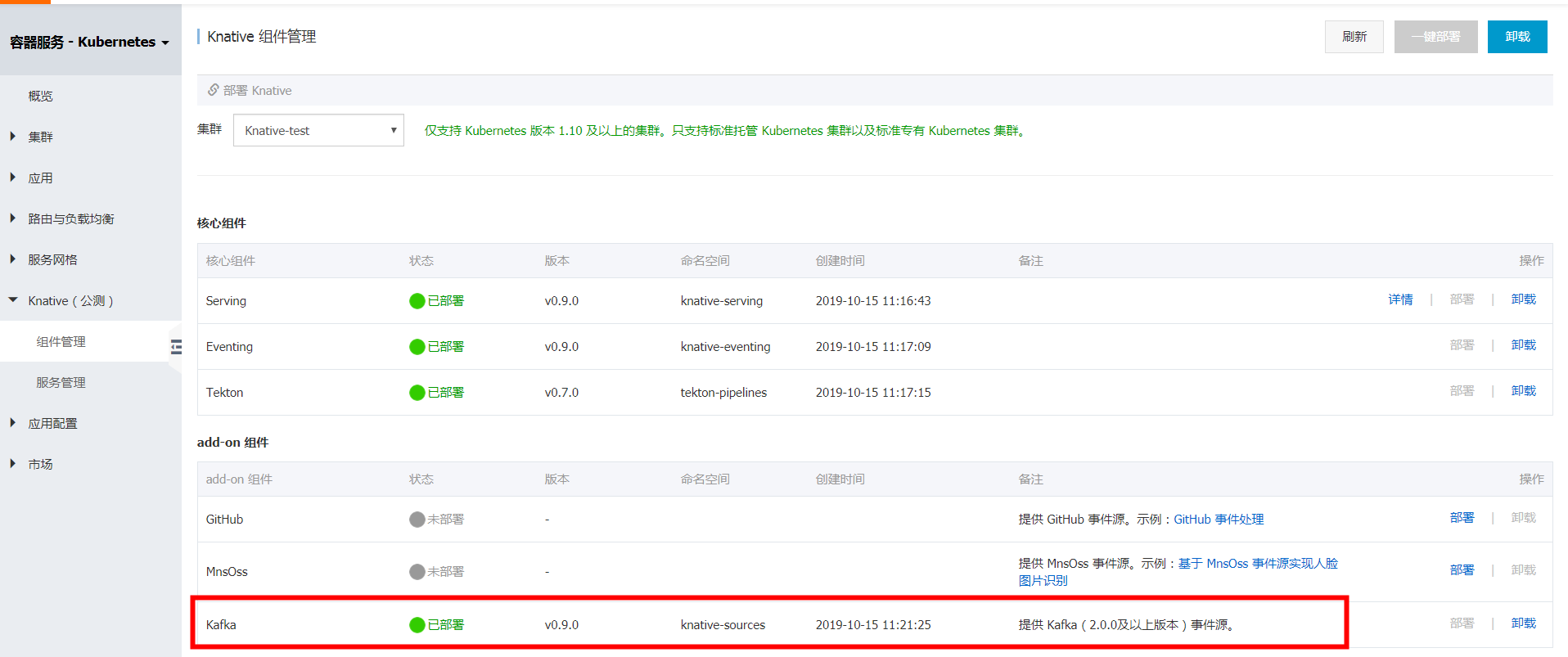

### 部署 Kafka addon 组件

登录容器服务控制台,进入【Knative 组件管理】,部署 Kafka addon 组件。

### 创建 KafkaSource 实例

首先创建用于接收事件的服务 event-display:

```

apiVersion: serving.knative.dev/v1

kind: Service

metadata:

name: event-display

spec:

template:

spec:

containers:

- image: registry.cn-hangzhou.aliyuncs.com/knative-sample/eventing-sources-cmd-event_display:bf45b3eb1e7fc4cb63d6a5a6416cf696295484a7662e0cf9ccdf5c080542c21d

```

接下来创建 KafkaSource:

```

apiVersion: sources.eventing.knative.dev/v1alpha1

kind: KafkaSource

metadata:

name: alikafka-source

spec:

consumerGroup: demo-consumer

# Broker URL. Replace this with the URLs for your kafka cluster,

# which is in the format of my-cluster-kafka-bootstrap.my-kafka-namespace:9092.

bootstrapServers: 192.168.0.6x:9092,192.168.0.7x:9092,192.168.0.8x:9092

topics: demo

sink:

apiVersion: serving.knative.dev/v1alpha1

kind: Service

name: event-display

```

说明:

* bootstrapServers: Kafka VPC 访问地址

* consumerGroup: 设置消费组

* topics:设置 Topic

创建完成之后,我们可以查看对应的实例已经运行:

```

[root@iZ2zeae8wzyq0ypgjowzq2Z ~]# kubectl get pods

NAME READY STATUS RESTARTS AGE

alikafka-source-k22vz-db44cc7f8-879pj 1/1 Running 0 8h

```

验证

--

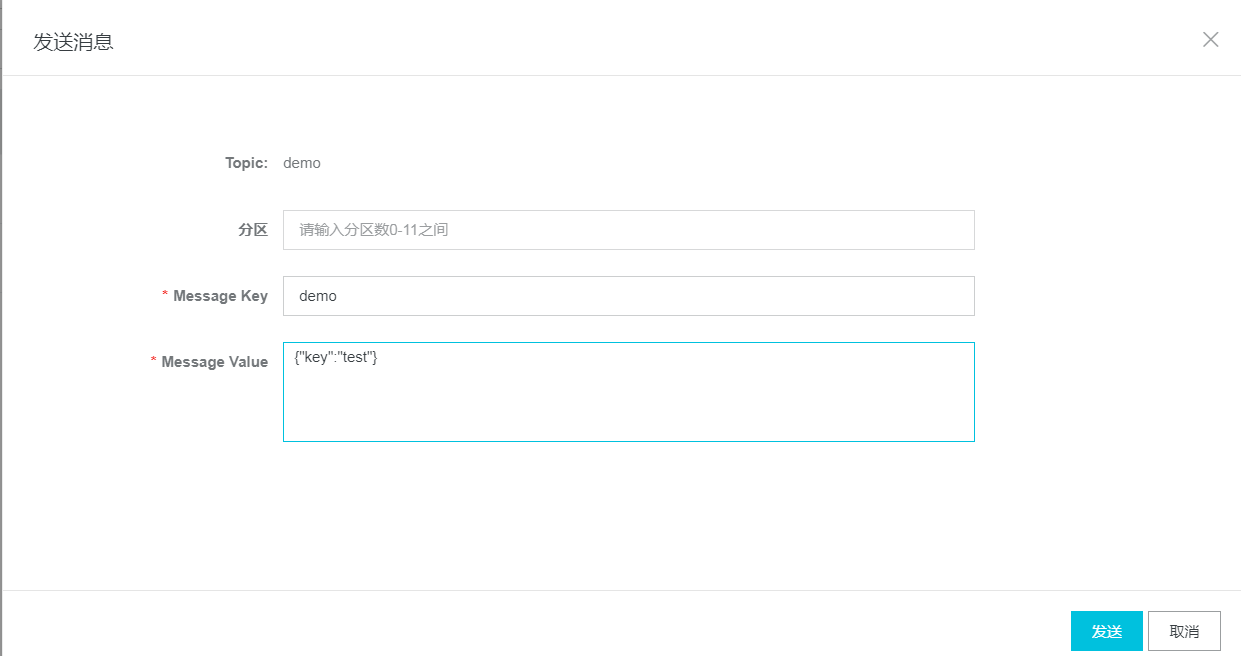

在 Kafka 控制台,选择 topic 发送消息,注意这里的消息格式必须是 json 格式:

我们可以看到已经接收到了发送过来的 Kafka 消息:

```

[root@iZ2zeae8wzyq0ypgjowzq2Z ~]# kubectl logs event-display-zl6m5-deployment-6bf9596b4f-8psx4 user-container

️ CloudEvent: valid

Context Attributes,

SpecVersion: 0.2

Type: dev.knative.kafka.event

Source: /apis/v1/namespaces/default/kafkasources/alikafka-source#demo

ID: partition:7/offset:1

Time: 2019-10-18T08:50:32.492Z

ContentType: application/json

Extensions:

key: demo

Transport Context,

URI: /

Host: event-display.default.svc.cluster.local

Method: POST

Data,

{

"key": "test"

}

```

小结

--

结合阿里云 Kafka 产品,通过事件驱动触发服务(函数)执行,是不是简单又高效。这样我们利用 Knative 得以把云原生的能力充分释放出来,带给我们更多的想象空间。欢迎对 Knative 感兴趣的一起交流。

iPhone 11 Pro、卫衣、T恤等你来抽,马上来试试手气 [https://www.aliyun.com/1111/2019/m-lottery?utm\_content=g\_1000083877](https://link.zhihu.com/?target=https%3A//www.aliyun.com/1111/2019/m-lottery%3Futm_content%3Dg_1000083877)

[原文链接](https://yq.aliyun.com/articles/722572?utm_content=g_1000084429)

本文为云栖社区原创内容,未经允许不得转载。

分享到:

相关推荐

在本文中,我们将深入探讨如何将SpringBoot与Apache Kafka集成,以便实现消息推送功能。首先,让我们了解一下这两个关键组件。 SpringBoot是Spring框架的一个模块,它简化了创建独立的、生产级别的基于Spring的应用...

在本文中,我们将深入探讨如何使用C++库RdKafka中的`KafkaConsumer`类来消费Apache Kafka消息。RdKafka是一个高效的C/C++ Kafka客户端,它提供了生产者和消费者API,使得与Kafka集群进行交互变得更加简单。在这个...

基于Kafka的消息发布订阅服务的设计与实现_卢帅.caj

.NET CORE 代码使用 Kafka 推送数据涉及到一系列关键知识点,主要涵盖 .NET Core 开发环境、Kafka 概念、Confluent.Kafka .NET 客户端库以及消息生产和消费的实现。以下是对这些主题的详细解释: 1. **.NET Core**...

《Kafka技术内幕:图文详解Kafka源码设计与实现》是一本深入解析Apache Kafka的专著,旨在帮助读者理解Kafka的核心设计理念、内部机制以及源码实现。这本书结合图文并茂的方式,使得复杂的概念变得更为易懂。同时,...

**KAFKA分布式消息系统在Windows环境下的搭建与应用** KAFKA是一个高吞吐量的分布式消息系统,由LinkedIn开发并开源,现在是Apache软件基金会的顶级项目。它主要设计用于处理实时流数据,允许应用程序发布和订阅...

本资料通过实际案例介绍了实时事件系统,主要围绕Kafka和Kinesis展开。全书分为三个部分,从不同角度深入探讨了事件流和统一日志的相关知识。第一部分介绍了事件流和统一日志的基本概念,通过虚构的在线零售商Nile和...

《Apache Kafka实战》这本书是关于分布式流处理平台Kafka的深度实践指南,旨在帮助读者深入理解和熟练运用Kafka。Kafka是由LinkedIn开发并开源的一种高吞吐量、分布式的发布订阅消息系统,现在已经成为大数据领域不...

kafka 实现的消息推送服务”涉及到三个核心的技术栈:Spring Boot、Netty和Kafka。这些技术在IT行业中都是至关重要的组件,尤其是在构建分布式系统和实时数据处理场景下。 1. **Spring Boot**: Spring Boot是由...

Trigger事件模型、事件注册机制、Sequeue解析)、云原生开发实战(日志监控告警、调用链管理、基于kafka实现消息推送、基于MNS与OSS实现人脸图片识别、基于APIGateway打造生产级别的Knative服务)

### 图解Kafka之实战指南知识点详述 #### 一、Kafka简介 **Kafka** 起初由LinkedIn采用Scala语言开发,后捐赠给Apache基金会,现已成为一款广泛应用于分布式流处理平台的成熟软件。它凭借高吞吐量、可持久化存储、...

Kafka支持多消费者组,同一组内的消费者会通过负载均衡的方式分摊消息消费,实现水平扩展。 5. **Kafka集群**:Kafka集群由多个服务器(节点)组成,每个节点都可以作为broker。数据在节点间复制,提供容错性。副本...

综上所述,通过Kafka处理实时GPS数据并利用WebSocket技术实现实时数据推送,可以有效地实现地图上的实时车辆展示。此方案不仅充分利用了Kafka的高性能消息处理能力,还借助WebSocket实现了低延迟的数据传输,满足了...

华为大数据认证,消息队列Kafka

总结,Kafka的基础代码实现涵盖了生产者和消费者的创建、消息发送与接收,以及服务端的配置。通过理解这些基本概念和操作,开发者能够构建出高效的数据流处理系统。在实际应用中,还需要考虑更多因素,如性能优化、...

golang 推送系统 单机 客户端通过websocket连接到服务端 ...服务端从rabbitmq接收消息,根据消息所属通过websocket推送到具体用户 服务端从http api接收消息,根据消息所属通过websocket推送到具体用户

标题中的“flink-kafka-hbase”项目是一个集成解决方案,旨在实现实时数据流处理,将Kafka消息高效地存储到HBase数据库中。这个解决方案利用了Apache Flink的流处理能力,结合Kafka作为数据源和HBase作为数据存储,...

《Kafka源码解析及实战》是一本专为深度学习Apache Kafka的读者设计的教材,旨在帮助读者深入了解Kafka的工作原理及其内部机制。通过源码级别的解析,读者可以更好地掌握Kafka在分布式消息系统中的核心功能和设计...

Kafka技术内幕:图文详解Kafka源码设计与实现 PDF 下载 Kafka技术内幕:图文详解Kafka源码设计与实现 PDF 下载

标题"perl-Net-Kafka:Net :: Kafka-Apache Kafka的高性能Perl客户端"指出了我们讨论的主题是Perl语言的一个库——Net::Kafka,它是一个专门为Apache Kafka设计的高性能客户端。Apache Kafka是一种分布式流处理平台...