дЄАгАБkettleиµДжЇРеЇУ

иµДжЇРеЇУжШѓзФ®жЭ•дњЭе≠ШиљђжНҐдїїеК°зЪДпЉМзФ®жИЈйАЪињЗеی嚥зХМйЭҐеИЫеїЇзЪДзЪДиљђжНҐдїїеК°еПѓдї•дњЭе≠ШеЬ®иµДжЇРеЇУдЄ≠гАВ

¬† ¬† ¬† ¬† иµДжЇРеЇУеПѓдї•дљње§ЪзФ®жИЈеЕ±дЇЂиљђжНҐдїїеК°пЉМиљђжНҐдїїеК°еЬ®иµДжЇРеЇУдЄ≠жШѓдї•жЦЗ俴姺嚥еЉПеИЖзїДзЃ°зРЖзЪДпЉМзФ®жИЈеПѓдї•иЗ™еЃЪдєЙжЦЗдїґе§єеРНзІ∞гАВ

гААгАА1.ketleиµДжЇРеЇУеЕГжХ∞жНЃ

гААгААвАҐ¬†иµДжЇРеЇУ

гААгААгААгААиµДжЇРеЇУеМЕжЛђжЦЗдїґиµДжЇРеЇУгАБжХ∞жНЃеЇУиµДжЇРеЇУ

гААгААгААгААKettle 4.0 дї•еРОиµДжЇРеЇУз±їеЮЛеПѓдї•жПТдїґжЙ©е±Х

гААгААвАҐ¬†XML жЦЗдїґ

гААгААгААгАА.ktr иљђжНҐжЦЗдїґзЪДXMLзЪДж†єиКВзВєењЕй°їжШѓ <transformation>

.гААгААгААгААkjb дљЬдЄЪXMLзЪДж†єиКВзВєжШѓ<job>

гААгАА2.kettleиµДжЇРеЇУз±їеЮЛ

гААгААжХ∞жНЃеЇУиµДжЇРеЇУпЉЪ

гААгААгААгААвАҐ жКК Kettle зЪДеЕГжХ∞жНЃдЄ≤и°МеМЦеИ∞жХ∞жНЃеЇУдЄ≠пЉМе¶В R_TRANSFORMATION и°®дњЭ

гААгАА¬† е≠ШдЇЖKettle иљђжНҐзЪДеРНзІ∞гАБжППињ∞з≠Йе±ЮжАІгАВ

гААгААгААгААвАҐ еЬ®Spoon йЗМеИЫеїЇеТМеНЗзЇІжХ∞жНЃеЇУиµДжЇРеЇУ

гААгААжЦЗдїґиµДжЇРеЇУпЉЪ

гААгААгААгААеЬ®жЦЗдїґзЪДеЯЇз°АдЄКзЪДе∞Би£ЕпЉМеЃЮзО∞дЇЖ org.pentaho.di.repository.Repository жО•еП£гАВ

гААгААгААгААжШѓKettle 4.0 дї•еРОзЙИжЬђйЗМеҐЮеК†зЪДиµДжЇРеЇУз±їеЮЛ

гААгААдЄНдљњзФ®иµДжЇРеЇУпЉЪ

гААгААгААгААзЫіжО•дњЭе≠ШдЄЇktr жИЦ kjb жЦЗдїґгАВ

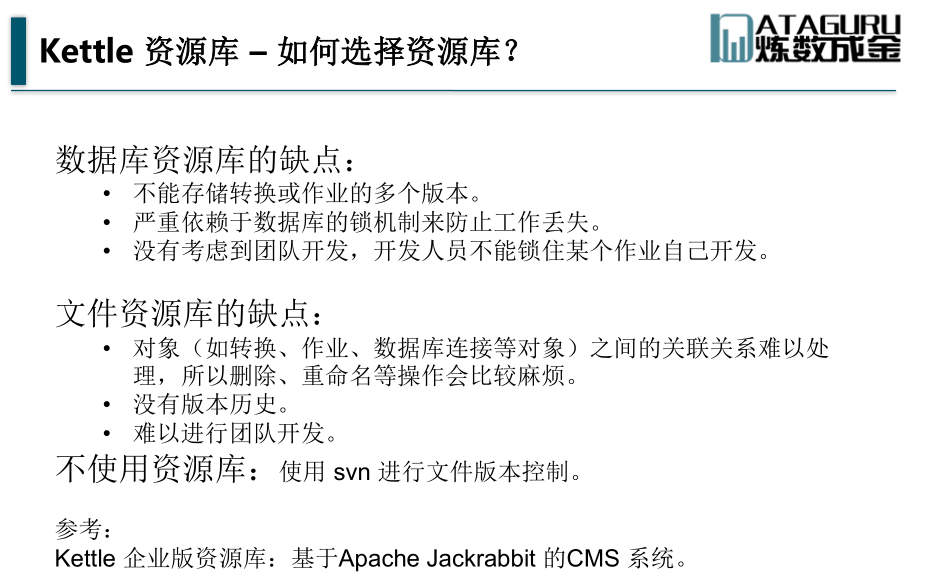

гААгАА3.иµДжЇРеЇУжУНдљЬ

гААгААгААгААжЦ∞еїЇиµДжЇРеЇУпЉЪ

гААгААгААгААkettle7.0еРОжЦ∞еїЇжЦєеЉПзХ•жЬЙдЄНеРМпЉМжЦ∞еїЇиµДжЇРеЇУеЬ®еП≥дЄКиІТ->connectпЉМ

гААгААгААгААиѓ¶зїЖжЦ∞еїЇеЫЊжЦЗж≠•й™§пЉМеПВиАГпЉЪhttps://blog.csdn.net/m0_37979608/article/details/77096201

гААгААгААгААдљњзФ®йїШиЃ§зЪДadmin/adminеН≥еПѓзЩїйЩЖеИ∞иµДжЇРеЇУпЉБ

гААгААгААгААе¶ВжЮЬдљњзФ®дЄ≠жЦЗињЫи°МдЇЖиµДжЇРеЇУеСљеРНпЉМе∞ЖдЉЪеЗЇзО∞иµДжЇРеЇУжЧ†ж≥ХжЦ∞еїЇзЪДйЧЃйҐШгАВиІ£еЖ≥жЦєж°ИпЉМеПВиАГпЉЪhttps://blog.csdn.net/liuwenbiao1203/article/details/77579436

гААгААгААгААеѓЉеЕ•/еѓЉеЗЇиµДжЇРеЇУпЉЪ

гААгААгААгААеѓЉиИ™ж†П->еЈ•еЕЈ->еѓЉеЕ•/еѓЉеЗЇиµДжЇРеЇУпЉМжИЦиАЕжΥ糥иµДжЇРеЇУињЫи°МжМЗеЃЪзЫЃељХзЪДеѓЉеЗЇпЉМеѓЉеЗЇдЄЇ.xmlжЦЗдїґеН≥еПѓпЉБ

гААгААгААгААиµДжЇРеЇУзЃ°зРЖпЉЪ

гААгААгААгААkettleжЦ∞зЙИзЃ°зРЖдєЯеЬ®еП≥дЄКиІТпЉЪ

гААгААгААгАА

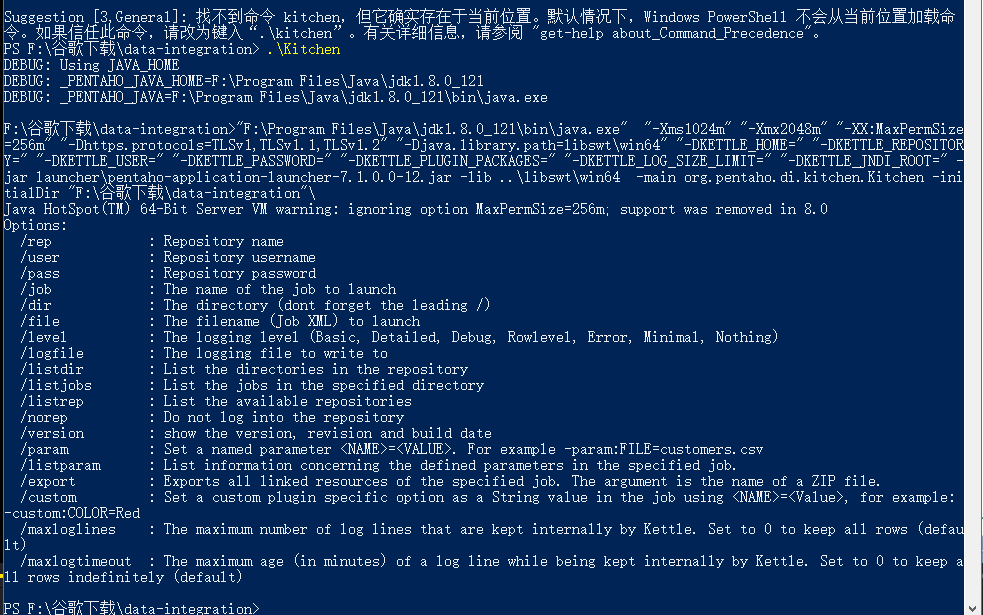

дЇМпЉМkettleињРи°МжЦєеЉП

еПВжХ∞еРНеИЧи°®пЉЪ /rep : иµДжЇРеЇУеРНзІ∞ /user : иµДжЇРеЇУзФ®жИЈеРН /pass : иµДжЇРеЇУеѓЖз†Б /trans : и¶БеРѓеК®зЪДиљђжНҐеРНзІ∞ /dir : зЫЃељХ(дЄНи¶БењШдЇЖеЙНзЉА /) /file : и¶БеРѓеК®зЪДжЦЗдїґеРН(иљђжНҐжЦЗдїґ) /level : жЧ•ењЧзЇІеИЂ (Error, Nothing, Minimal, Basic , Detailed, Debug, Rowlevel) /logfile : и¶БеЖЩеЕ•зЪДжЧ•ењЧжЦЗдїґ /listdir : еИЧеЗЇиµДжЇРеЇУйЗМзЪДзЫЃељХ /listtrans : еИЧеЗЇжМЗеЃЪзЫЃељХдЄЛзЪДиљђжНҐ /listrep : еИЧеЗЇеПѓзФ®иµДжЇРеЇУ /exprep : е∞ЖиµДжЇРеЇУйЗМзЪДжЙАжЬЙеѓєи±°еѓЉеЗЇеИ∞ XML жЦЗдїґдЄ≠ /norep : дЄНи¶Бе∞ЖжЧ•ењЧеЖЩеИ∞иµДжЇРеЇУдЄ≠ /safemode : еЃЙеЕ®ж®°еЉПдЄЛињРи°М: жЬЙйҐЭе§ЦзЪДж£АжЯ• /version : жШЊз§ЇиљђжНҐзЪДзЙИжЬђ,ж†°иЃҐеТМеИЫеїЇжЧ•жЬЯ /param : иЃЊзљЃеПВжХ∞пЉМеПВжХ∞ж†ЉеЉП<NAME>=<VALUE>пЉМдЊЛе¶В-param:FOO=bar /listparam: еИЧеЗЇиљђжНҐйЗМеЈ≤зїПиЃЊзљЃе•љзЪДеПВжХ∞гАВ /maxloglinesпЉЪеЖЕе≠ШдЄ≠дњЭе≠ШжЧ•ењЧзЪДжЬАе§ІжЧ•ењЧи°МжХ∞ /maxlogtimeoutпЉЪеЖЕе≠ШдЄ≠дњЭе≠ШжЧ•ењЧзЪДжЬАйХњжЧґйЧі Pan.sh ињРи°Мж®°еЉП

/rep : иµДжЇРеЇУеРНзІ∞ /user : иµДжЇРеЇУзФ®жИЈеРН /pass : иµДжЇРеЇУеѓЖз†Б /job : и¶БеРѓеК®зЪДдљЬдЄЪеРНзІ∞ /dir : зЫЃељХ(дЄНи¶БењШдЇЖеЙНзЉА /) /file : и¶БеРѓеК®зЪДжЦЗдїґеРН(иљђжНҐжЦЗдїґ) /level : жЧ•ењЧзЇІеИЂ (Error, Nothing, Minimal, Basic , Detailed, Debug, Rowlevel) /logfile : и¶БеЖЩеЕ•зЪДжЧ•ењЧжЦЗдїґ /listdir : еИЧеЗЇиµДжЇРеЇУйЗМзЪДзЫЃељХ /listjobs : еИЧеЗЇжМЗеЃЪзЫЃељХдЄЛзЪДдљЬдЄЪ /listrep : еИЧеЗЇеПѓзФ®иµДжЇРеЇУ /exprep : е∞ЖиµДжЇРеЇУйЗМзЪДжЙАжЬЙеѓєи±°еѓЉеЗЇеИ∞ XML жЦЗдїґдЄ≠ /norep : дЄНи¶Бе∞ЖжЧ•ењЧеЖЩеИ∞иµДжЇРеЇУдЄ≠ /safemode : еЃЙеЕ®ж®°еЉПдЄЛињРи°М: жЬЙйҐЭе§ЦзЪДж£АжЯ• /version : жШЊз§ЇиљђжНҐзЪДзЙИжЬђ,ж†°иЃҐеТМеИЫеїЇжЧ•жЬЯ /param : иЃЊзљЃеПВжХ∞пЉМеПВжХ∞ж†ЉеЉП<NAME>=<VALUE>пЉМдЊЛе¶В-param:FOO=bar /listparam: еИЧеЗЇиљђжНҐйЗМеЈ≤зїПиЃЊзљЃе•љзЪДеПВжХ∞ /exportпЉЪ жККдљЬдЄЪдЊЭиµЦзЪДжЙАжЬЙиµДжЇРеѓЉеЗЇеИ∞дЄАдЄ™zip жЦЗдїґйЗМ /maxloglinesпЉЪеЖЕе≠ШдЄ≠дњЭе≠ШжЧ•ењЧзЪДжЬАе§ІжЧ•ењЧи°МжХ∞ /maxlogtimeoutпЉЪеЖЕе≠ШдЄ≠дњЭе≠ШжЧ•ењЧзЪДжЬАйХњжЧґйЧі Kitchen.sh ињРи°Мж®°еЉП

Error: еП™иЃ∞ељХйФЩиѓѓдњ°жБѓ Nothing: дЄНиЃ∞ељХдїїдљХдњ°жБѓ,жЙІи°МжХИзОЗжЬАйЂШ Minimal: иЃ∞ељХжЬАе∞СзЪДдњ°жБѓ Basic: иЃ∞ељХеЯЇжЬђдњ°жБѓ Detailed: иЃ∞ељХиѓ¶зїЖдњ°жБѓ Debug: иЃ∞ељХи∞ГиѓХдњ°жБѓ Rowlevel: иљђжНҐињЗз®ЛдЄ≠зЪДжѓПдЄАи°МйГљиЃ∞ељХдЄЛжЭ•,жЧ•ењЧжЬАиѓ¶ зїЖ,жЙІи°МжХИзОЗжЬАдљО жЧ•ењЧзЇІеИЂ

гААгААгААеСљдї§ж†ЉеЉПпЉЪ

/еПВжХ∞еРН:еАЉ

жИЦ

-еПВжХ∞еРН=еАЉ

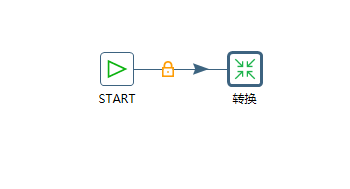

гААгААжЦ∞еїЇдЄАдЄ™жµЛиѓХдљЬдЄЪпЉЪ

гААгАА

гААгААжЙІи°МдљЬдЄЪз§ЇдЊЛпЉЪ

./kitchen /rep:r1 /user:admin /pass:admin /job:j1 /dir:/ /logfile:F:/log3.txt

¬†гААгАА// жЫіе§Ъз§ЇдЊЛпЉМеЊЕи°•еЕЕ

дЄЙгАБжЧ•ењЧ

гААгАА1.жЦЗдїґжЧ•ењЧдљНзљЃ

гААгААгААгААйАЪињЗ/logfileеЬ®еСљдї§и°МдЄ≠ињРи°МJobжЧґиЃЊзљЃ

гААгААгААгААlinuxдЄ≠йАЪињЗзЃ°йБУзђ¶ињЫи°МиЊУеЗЇйЗНеЃЪеРС

гААгААгААгААйїШиЃ§зЪДжЧ•ењЧжЦЗдїґдњЭе≠ШеЬ® java.io.tmpdir зЫЃељХдЄЛпЉМжЦЗдїґеРНз±їдЉЉspoon_xxx.log

гААгААгААгААеی嚥еМЦзХМйЭҐдєЯжЬЙжЧ•ењЧиЊУеЗЇз™ЧеП£

гААгАА2.жЧ•ењЧеПВжХ∞иЃЊзљЃ

гААгААгААгААSpoonдЄ≠йАЪињЗеЈ•еЕЈ->йАЙй°єињЫи°МйГ®еИЖжЧ•ењЧиЊУеЗЇз™ЧеП£иЃЊзљЃ

гААгААгАА kettle.propertiesдЄ≠зЫЄеЕ≥еПВжХ∞иЃЊзљЃпЉЪ

KETTLE_MAX_LOG_SIZE_IN_LINE еПШйЗП

KETTLE_MAX_LOG_TIMEOUT_IN_MINUTESеПШйЗП

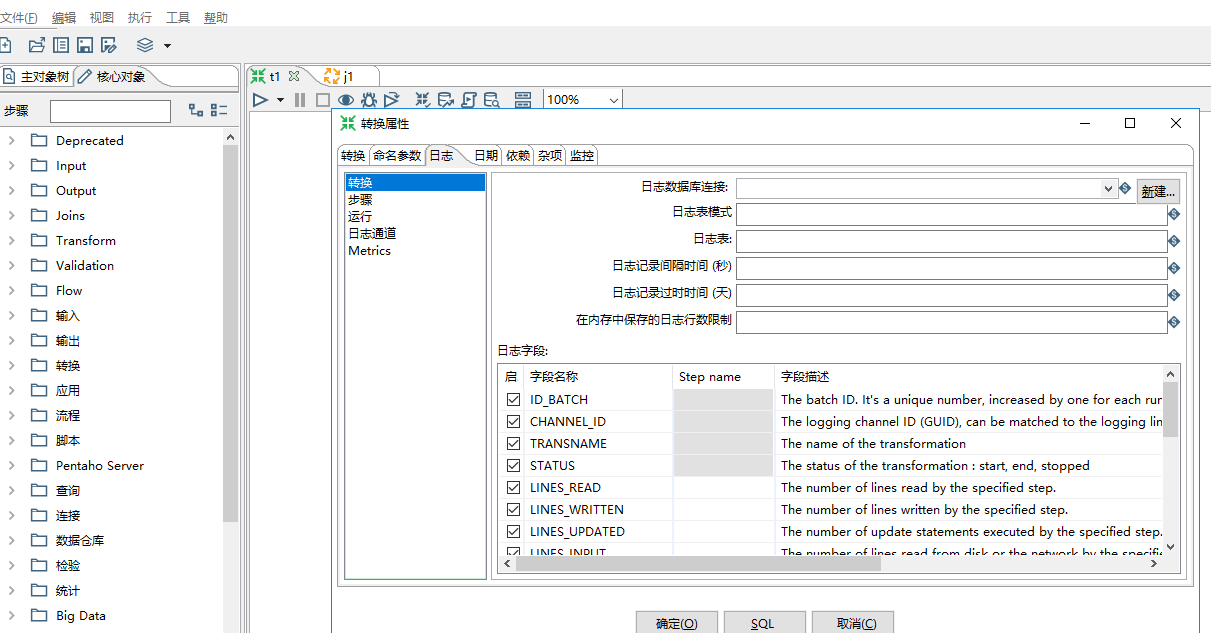

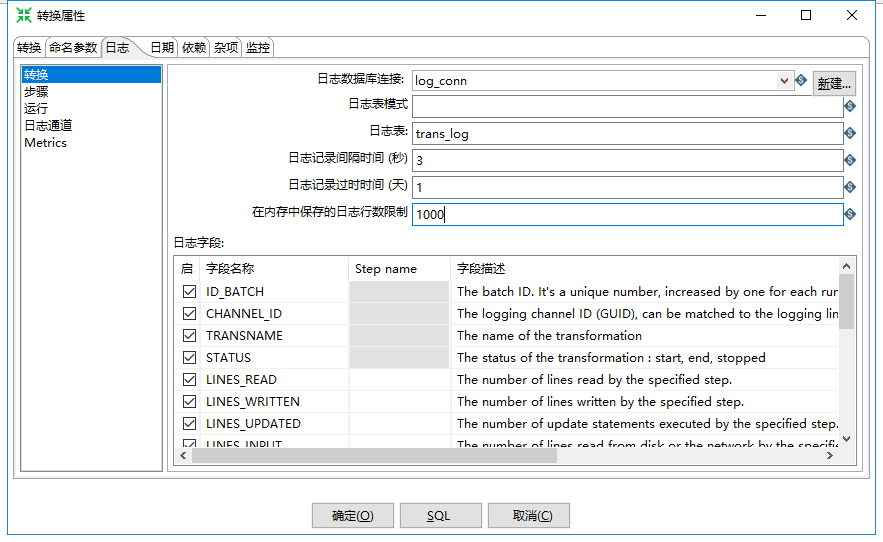

гААгААгАА3.жХ∞жНЃеЇУжЧ•ењЧ

гААгААгААгААгААиљђжНҐжЬЙ4дЄ™жЧ•ењЧи°®пЉЪ

вАҐ иљђжНҐжЧ•ењЧи°®

вАҐ ж≠•й™§жЧ•ењЧи°®

вАҐ жАІиГљжЧ•ењЧи°®

вАҐ жЧ•ењЧйАЪйБУжЧ•ењЧи°®

гААгААгААгААдљЬдЄЪжЧ•ењЧи°®пЉЪ

вАҐ дљЬдЄЪжЧ•ењЧи°®

вАҐ дљЬдЄЪй°єжЧ•ењЧи°®

вАҐ жЧ•ењЧйАЪйБУжЧ•ењЧи°®

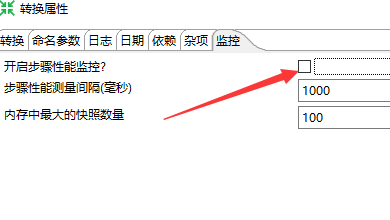

гААгААгААгААиљђжНҐзЪДжЧ•ењЧиЃЊзљЃеЬ®пЉЪзЉЦиЊС->иЃЊзљЃпЉЫйАЙжЛ©жЧ•ењЧпЉИдљЬдЄЪеРМзРЖпЉЙ

гААгААйАЙжЛ©жХ∞жНЃеЇУињЮжО•->е¶ВжЮЬжХ∞жНЃеЇУдЄ≠ж≤°жЬЙињЩдЄ™и°®пЉМеИЩеПѓдї•зВєеЗїдЄЛйЭҐзЪДSQLпЉМеЖНйАЪињЗжЙІи°МињЫи°МжЦ∞еїЇ

гААгААиљђжНҐи°®йЕНзљЃе¶ВдЄЛпЉЪ

гААгАА

гААгААеЕґдїЦжЧ•ењЧи°®з±їдЉЉ

гААгААзЫСжОІи°®йЬАи¶БеЉАеРѓзЫСжОІпЉЪ

гААгАА

жЬђжЦЗеПВиАГйУЊжО•пЉЪhttps://www.cnblogs.com/jiangbei/p/8987403.html

зЫЄеЕ≥жО®иНР

иІ£еЖ≥жЦєж°ИзЪДжАЭиЈѓжШѓпЉЪй¶ЦеЕИпЉМжЙУеЉА Kettle иљѓдїґпЉМињЮжО•еИ∞ Oracle жХ∞жНЃеЇУпЉМеИЫеїЇдЄАдЄ™жЦ∞зЪДиµДжЇРеЇУпЉМзДґеРОиЃЊзљЃиљђжНҐзЪДе±ЮжАІпЉМеМЕжЛђжЧ•ењЧгАБж≠•й™§жЧ•ењЧгАБињРи°МжЧ•ењЧгАБжЧ•ењЧйАЪйБУз≠ЙгАВжО•зЭАпЉМиЃЊзљЃдљЬдЄЪзЪДе±ЮжАІпЉМеМЕжЛђдљЬдЄЪжЧ•ењЧгАБдљЬдЄЪй°єжЧ•ењЧгАБдљЬдЄЪ...

### KETTLEиµДжЇРеЇУйЕНзљЃжЦєж≥Хиѓ¶иІ£ #### дЄАгАБKETTLEиµДжЇРеЇУж¶Вињ∞ KETTLEжШѓдЄАжђЊеЉАжЇРзЪДжХ∞жНЃйЫЖжИРеЈ•еЕЈпЉМеЃГдЄїи¶БзФ®дЇОжХ∞жНЃжЄЕжіЧгАБиљђжНҐеПКеК†иљљз≠ЙжУНдљЬгАВKETTLEйАЪињЗеی嚥еМЦзХМйЭҐжПРдЊЫдЇЖдЄ∞еѓМзЪДеКЯиГљпЉМдљњеЊЧжХ∞жНЃе§ДзРЖеПШеЊЧжЫіеК†зЃАеНХйЂШжХИгАВеЬ®...

39. **R_REPOSITORY_LOG**пЉЪиµДжЇРеЇУжУНдљЬжЧ•ењЧдњ°жБѓгАВ - **ID_REPOSITORY_LOG**пЉЪжЧ•ењЧIDгАВ - **OPERATION**пЉЪжУНдљЬз±їеЮЛгАВ - **DETAILS**пЉЪжУНдљЬиѓ¶жГЕгАВ 40. **R_PERMISSION**пЉЪжЭГйЩРи°®пЉМеЃЪдєЙзФ®жИЈжИЦиІТиЙ≤зЪДжЭГйЩРгАВ - **ID_...

еРМжЧґпЉМKettle дєЯеПѓдї•дЄОиµДжЇРеЇУйЫЖжИРпЉМдЊЛе¶ВеПѓдї•жККеИґдљЬзЪДжЦЗдїґдњЭе≠ШеИ∞иµДжЇРеЇУдЄ≠пЉМжЬЙдї•дЄЛдЄ§дЄ™е•ље§ДпЉЪ1. еЬ®еРМдЄАдЄ™иµДжЇРеЇУдЄЛпЉМеїЇзЂЛзЪДжХ∞жНЃеЇУињЮжО•жИЦ hadoop йЕНзљЃеПѓдї•еЕ±зФ®гАВ2. ињЮжО• hadoop зЪДиљђжНҐжИЦдљЬдЄЪеП™жЬЙеЬ®еЬ®иµДжЇРеЇУдЄЛпЉМйАЪињЗз™ЧеП£...

- **жАІиГљдЉШеМЦ**пЉЪи∞ГжХіKettleзЪДињРи°МеПВжХ∞пЉМе¶ВеєґеПСеЇ¶еТМзЉУеЖ≤еМЇе§Іе∞ПпЉМдї•жПРеНЗињБзІїйАЯеЇ¶гАВ - **йФЩиѓѓе§ДзРЖ**пЉЪиЃЊзљЃйАВељУзЪДйФЩиѓѓе§ДзРЖз≠ЦзХ•пЉМдЊЛе¶ВиЈ≥ињЗйФЩиѓѓи°МжИЦиЃ∞ељХйФЩиѓѓжЧ•ењЧгАВ жАїзїУпЉМKettle 7.0жПРдЊЫдЇЖеЉЇе§ІдЄФзБµжіїзЪДжХ∞жНЃеЇУињБзІїеЈ•еЕЈ...

9. **R_LOGLEVEL/R_LOG**пЉЪжЧ•ењЧзЇІеИЂдЄОжЧ•ењЧзЃ°зРЖпЉМжОІеИґзЭАз≥їзїЯињРи°МжЧґзЪДиЃ∞ељХз≠ЙзЇІеТМе≠ШеВ®жЦєеЉПгАВ 10. **R_NOTE/R_JOB_NOTE**пЉЪж≥®йЗКи°®пЉМеЕ≥иБФдЇОжХ∞жНЃиљђжНҐжИЦдљЬдЄЪпЉМжПРдЊЫйҐЭе§ЦзЪДдњ°жБѓеТМиѓіжШОгАВ 11. **R_JOB_HOP**пЉЪз±їдЉЉR_TRANS_HOP...

KettleпЉМеЕ®зІ∞дЄЇPentaho Data IntegrationпЉИPDIпЉЙпЉМжШѓдЄАжђЊеЉЇе§ІзЪДеЉАжЇРжХ∞жНЃйЫЖжИРеЈ•еЕЈпЉМзФ±з§ЊеМЇй©±еК®пЉМдЄїи¶Б...дљњзФ®KettleиµДжЇРеМЕпЉМзФ®жИЈеПѓдї•ењЂйАЯжЮДеїЇеТМйГ®зљ≤иЗ™еЈ±зЪДжХ∞жНЃе§ДзРЖй°єзЫЃпЉМжПРйЂШеЈ•дљЬжХИзОЗпЉМжО®еК®дЉБдЄЪзЪДжХ∞жНЃеИЖжЮРеТМеЖ≥з≠ЦжФѓжМБгАВ

Javaи∞ГзФ®KettleдЄ≠зЪДJobдЄОиљђжНҐжШѓжХ∞жНЃйЫЖжИРињЗз®ЛдЄ≠зЪДеЄЄиІБйЬАж±ВпЉМKettleпЉИPentaho Data IntegrationпЉМзЃАзІ∞PDIпЉЙжШѓдЄАзІНеЉЇе§ІзЪДETLеЈ•еЕЈпЉМиАМJavaеИЩдљЬдЄЇйАЪзФ®зЉЦз®Лиѓ≠и®АпЉМиГље§ЯзБµжіїеЬ∞дЄОеРДзІНз≥їзїЯињЫи°МдЇ§дЇТгАВеЬ®JavaдЄ≠и∞ГзФ®KettleзЪДJobеТМ...

KettleжФѓжМБеی嚥еМЦзХМйЭҐжУНдљЬеТМеСљдї§и°МжУНдљЬдЄ§зІНжЦєеЉПпЉМеЕґдЄ≠еСљдї§и°МжУНдљЬеЬ®зФЯдЇІзОѓеҐГдЄ≠е∞§дЄЇеЄЄиІБпЉМеЫ†дЄЇеЃГдЊњдЇОиЗ™еК®еМЦеТМжЙєе§ДзРЖдїїеК°зЪДеЃЮзО∞гАВ #### дЇМгАБKettleеСљдї§и°МеЯЇз°АзЯ•иѓЖ еЬ®KettleдЄ≠пЉМдЄїи¶БйАЪињЗдЄ§дЄ™жЙєе§ДзРЖжЦЗдїґжЭ•ињЫи°МеСљдї§и°М...

дЄАгАБkettleиµДжЇРеЇУзЪДйЕНзљЃ kettleдЄ≠зЪДRepositoryжШѓе≠ШеВ®еЕГжХ∞жНЃзЪДе§ЪеЉ†жХ∞жНЃи°®пЉМеЬ®иµДжЇРеЇУж®°еЉПдЄЛиЃЊиЃ°зЪДtransformationеТМjobйГљдЉЪ襀е≠ШеВ®еЬ®ињЩдЇЫжХ∞жНЃи°®дЄ≠гАВдЄЇйЕНзљЃRepositoryпЉМйЬАи¶БеЕИйЕНзљЃDatabase ConnectionпЉИжХ∞жНЃеЇУињЮжО•пЉЙпЉМ...

иµДжЇРеЇУжШѓKettleзФ®жЭ•е≠ШеВ®иљђжНҐеТМдїїеК°зЪДеЬ∞жЦєпЉМеПѓдї•зРЖиІ£дЄЇKettleзЪДжХ∞жНЃдЄ≠ењГгАВеЬ®SpoonдЄ≠еПѓдї•йАЪињЗвАЬиµДжЇРеЇУвАЭиПЬеНХжЭ•зЃ°зРЖиµДжЇРеЇУпЉМеМЕжЛђеИЫеїЇгАБињЮжО•иµДжЇРеЇУз≠ЙжУНдљЬгАВ ##### 1.5 иµДжЇРеЇУиЗ™еК®зЩїељХ дЄЇдЇЖжЦєдЊњзФ®жИЈдљњзФ®пЉМKettleжПРдЊЫдЇЖ...

1. **LinuxжЬНеК°еЩ®зОѓеҐГ**пЉЪз°ЃдњЭLinuxжЬНеК°еЩ®еЈ≤зїПеЃЙи£ЕеєґйЕНзљЃе•љдЇЖJava Development Kit (JDK)пЉМињЩжШѓињРи°МKettleзЪДеЯЇз°АгАВеРМжЧґпЉМж£АжЯ•зОѓеҐГеПШйЗПжШѓеР¶ж≠£з°ЃиЃЊзљЃпЉМдї•дЊњKettleеПѓдї•иѓЖеИЂJavaиЈѓеЊДгАВ 2. **KettleжЦЗдїґеЗЖе§З**пЉЪеЬ®...

kettleеЬ®linuxзКґжАБдЄЛи∞ГзФ®зЪДиДЪжЬђжЦЗдїґпЉМиЗ™еК®еМЦпЉМдЄАйФЃињРи°МпЉМдЊњдЇОеЃЮжЦљгАВ

4. **еЉЇе§ІзЪДи∞ГеЇ¶еТМзЫСжОІ**пЉЪKettleзЪДдљЬдЄЪпЉИJobпЉЙеКЯиГљеПѓдї•еЃЙжОТеТМжОІеИґиљђжНҐзЪДжЙІи°МпЉМеРМжЧґжПРдЊЫиѓ¶е∞љзЪДињРи°МжЧ•ењЧеТМзЫСжОІеКЯиГљгАВ 5. **еИЖеЄГеЉПе§ДзРЖиГљеКЫ**пЉЪKettleжФѓжМБеЬ®е§ЪжЬНеК°еЩ®зОѓеҐГдЄ≠еєґи°МжЙІи°МпЉМеИ©зФ®Pentaho Data Integration ...

7. **еЉВеЄЄе§ДзРЖеТМжЧ•ењЧиЃ∞ељХ**пЉЪз°ЃдњЭKettleзЪДйФЩиѓѓеТМжЧ•ењЧдњ°жБѓиГље§Яж≠£з°ЃеЬ∞襀Spring BootзЪДжЧ•ењЧз≥їзїЯжНХиОЈеТМиЃ∞ељХпЉМдї•дЊњдЇОйЧЃйҐШжОТжЯ•гАВ йАЪињЗдї•дЄКж≠•й™§пЉМжИСдїђеПѓдї•е∞ЖKettleзЪДеЉЇе§ІжХ∞жНЃе§ДзРЖиГљеКЫжЧ†зЉЭиЮНеЕ•еИ∞Spring BootеЇФзФ®дЄ≠пЉМеЃЮзО∞...

жЬђз≥їзїЯжШѓеЯЇдЇОжХ∞жНЃеЇУиµДжЇРеЇУиЃЊиЃ°зЪДпЉМжЪВжЧґдЄНиАГиЩСжФѓжМБжЦЗдїґиµДжЇРеЇУгАВжЬђз≥їзїЯињШйЩДеЄ¶дЇЖдЄАдЄ™kettleжПТдїґпЉМз±їдЉЉkettleеЈ≤жЬЙзЪДиЗ™еЃЪдєЙз±їжОІдїґпЉИеПѓдї•еЬ®иљђжНҐдЄ≠еЖЩjavaдї£з†БпЉЙгАВиѓ•жОІдїґзЪДиЃЊиЃ°жЧґдЄЇдЇЖйБњеЕНжѓПдЄАдЄ™йЬАж±ВйГљеОїеЉАеПСдЄАдЄ™kettleжОІдїґпЉМ...

- KettleжФѓжМБињЮжО•еИ∞иµДжЇРеЇУпЉМзФ®дЇОзЃ°зРЖеТМеЕ±дЇЂиљђжНҐеТМJobжЦЗдїґгАВ - йАЪињЗиЃЊзљЃиµДжЇРеЇУињЮжО•дњ°жБѓеЃЮзО∞ж≠§еКЯиГљгАВ 6. **дїОиµДжЇРеЇУиѓїеПЦTrans** - дїОиµДжЇРеЇУдЄ≠еК†иљљиљђжНҐжЦЗдїґгАВ - еК†иљљеРОеПѓзЫіжО•жЙІи°МжИЦдњЃжФєеРОеЖНжЙІи°МгАВ 7. **дїОиµДжЇРеЇУ...

4. **жЧ•ењЧеТМзЫСжОІ**пЉЪKettleжПРдЊЫиѓ¶е∞љзЪДжЧ•ењЧиЃ∞ељХеТМжАІиГљзЫСжОІпЉМдЊњдЇОи∞ГиѓХеТМдЉШеМЦгАВ 5. **жХ∞жНЃйҐДиІИеТМжµЛиѓХ**пЉЪеЬ®иЃЊиЃ°ињЗз®ЛдЄ≠пЉМеПѓдї•еЃЮжЧґйҐДиІИжХ∞жНЃпЉМж£АжЯ•иљђжНҐжХИжЮЬгАВ **дЇФгАБе≠¶дє†иµДжЇР** "Kettle8.2еЕ•йЧ®PPT"жШѓеИЭе≠¶иАЕдЇЖиІ£еТМе≠¶дє†...

5. зЫСжОІдЄОжЧ•ењЧпЉЪKettleжПРдЊЫиѓ¶зїЖзЪДжЧ•ењЧиЃ∞ељХеТМзЫСжОІеЈ•еЕЈпЉМйАЪињЗжЧ•ењЧжЯ•зЬЛеЩ®еПѓдї•ињљиЄ™иљђжНҐеТМдљЬдЄЪзЪДжЙІи°МзКґжАБпЉМеЄЃеК©еЃЪдљНеТМиІ£еЖ≥йЧЃйҐШгАВ дЄЙгАБKettleеЃЮиЈµж°ИдЊЛ - жХ∞жНЃињБзІїпЉЪдїОе§ЪдЄ™жЇРз≥їзїЯжКљеПЦжХ∞жНЃпЉМзїПињЗжЄЕжіЧеТМиљђжНҐпЉМеК†иљљеИ∞жЦ∞зЪД...

еЬ®еЕЈдљУеЃЮжЦљињЗз®ЛдЄ≠пЉМйЩ§дЇЖиАГиЩСз®≥еЃЪжАІдЄОжАІиГљжМЗж†Зе§ЦпЉМињШеЇФиѓДдЉ∞иµДжЇРеН†зФ®гАБи∞ГеЇ¶еКЯиГљгАБеєґи°МиГљеКЫгАБжЙ©е±ХжАІгАБзЫСжОІиГљеКЫдї•еПКжЧ•ењЧеКЯиГљз≠ЙеЕ≥йФЃеЫ†зі†гАВйАЪињЗињЩдЇЫзїЉеРИиѓДдЉ∞пЉМдЉБдЄЪеПѓдї•жЫіеЗЖз°ЃеЬ∞йАЙжЛ©йАВеРИиЗ™еЈ±зЪДKettleеЃЪжЧґи∞ГеЇ¶зЫСжОІжЦєж°ИпЉМз°ЃдњЭ...