如果您是一个大数据开发工程师并且使用过hadoop的hive框架,那么恭喜您,阿里云的大数据计算服务-Maxcompute,您已经会了90%。这篇文章就来简单对比下Maxcompute和hive的异同,来方便刚开始使用Maxcompute的用户,从hive秒速迁移到Maxcompute的使用上。

首先,回顾下hive的概念。

1、hive是基于hadoop的,以表的形式来存储数据,实际上数据是存储在hdfs上,数据库和表其实是hdfs上的两层目录,数据是放在表名称目录下的,计算还是转换成mapreduce计算。

2、hive可以通过客户端命令行和java api操作数据

3、hive是hql语言操作表,跟通用sql语言的语法大致相同,可能会多一些符合本身计算的函数等。hql会解析成mapreduce进行相关逻辑计算

4、hive有分区分桶的概念

5、hive可以通过命令从本地服务器来上传下载表数据

hive可以通过外部表功能映射hbase和es等框架的数据

6、hive任务可以通过hadoop提供的webUI来查看任务进度,日志等

7、hive支持自定义函数udf,udaf,udtf

8、hive可以通过hue界面化操作

9、hive可以通过sqoop等工具和其他数据源交互

10、资源调度依赖于hadoop-yarn平台

那么如果你对这些hive的功能稍微熟悉的话,现在我告诉你,Maxcompute的功能以及用法和上述hive功能基本一致。

先看下Maxcompute的组件:

MaxCompute 主要服务于批量结构化数据的存储和计算,可以提供海量数据仓库的解决方案以及针对大数据的分析建模服务,支持sql查询计算,自定义函数udf实现复杂逻辑,mapreduce程序实现更具体的业务计算,支持Graph面向迭代的图计算处理框架,提供java api来连接操作sqltask。

是不是初步看起来MaxCompute也是和hive一样,可以用sql,udf,mr

①文件系统对比

对比差异之前,容许我先简单介绍下阿里云的基石-飞天系统,详细的可以网上搜下。飞天系统是分布式的文件存储和计算系统,听起来是不是好熟悉,是不是和hadoop的味道一样。这里对于Maxcompute可以暂时把它当作是hadoop类似的框架,那Maxcompute就是基于飞天系统的,类似于hive基于hadoop。hive的数据实际上是在hdfs上,元数据一般放在mysql,以表的形式展现。你可以直接到hdfs上查到具体文件。Maxcompute的数据是在飞天文件系统,对外不暴露文件系统,底层优化会自动做好。

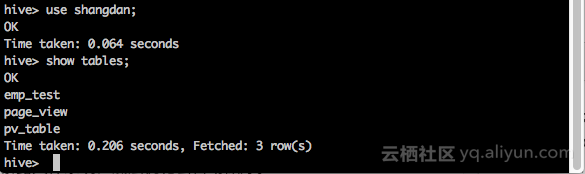

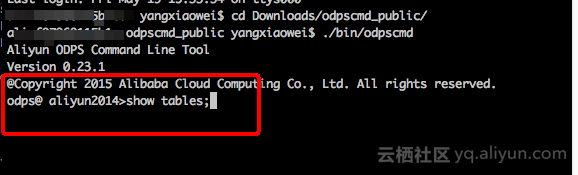

②hive和Maxcompute客户端

直接上图来对比

hive的客户端:

Maxcompute(原odps)的客户端:

是不是看起来一致。

实际上

项目空间(Project)是 MaxCompute 的基本组织单元,它类似于传统数据库的Database 或 Schema 的概念,是进行多用户隔离和访问控制的主要边界 。一个用户可以同时拥有多个项目空间的权限

配置文件如图

在客户端中可以执行sql和其他命令。

那么MaxCompute除了命令行客户端也提供了python和java的sdk来访问。不说了直接上代码

import java.util.List;

import com.aliyun.odps.Instance;

import com.aliyun.odps.Odps;

import com.aliyun.odps.OdpsException;

import com.aliyun.odps.account.Account;

import com.aliyun.odps.account.AliyunAccount;

import com.aliyun.odps.data.Record;

import com.aliyun.odps.task.SQLTask;

public class testSql {

//这里accessId和accessKey是阿里云为安全设置的账户访问验证,类似于密码,不止是在Maxcompute中使用

private static final String accessId = "";

private static final String accessKey = “”;

//这里是的服务地址

private static final String endPoint = "http://service.odps.aliyun.com/api";

//Maxcompute的项目名称,类似于hive的database

private static final String project = "";

private static final String sql = "select category from iris;";

public static void

main(String[] args) {

Account account = new AliyunAccount(accessId, accessKey);

Odps odps = new Odps(account);

odps.setEndpoint(endPoint);

odps.setDefaultProject(project);

Instance i;

try {

i = SQLTask.run(odps, sql);

i.waitForSuccess();

List<Record> records = SQLTask.getResult(i);

for(Record r:records){

System.out.println(r.get(0).toString());

}

} catch (OdpsException e) {

e.printStackTrace();

}

}

}是不是觉得很亲切,跟大多数数据库的访问方式一样。

③odpscmd和hivesql

首先来看建表语句

hive标准建表语句:

hive> create table page_view

> (

> page_id bigint comment '页面ID',

> page_name string comment '页面名称',

> page_url string comment '页面URL'

> )

> comment '页面视图'

> partitioned by (ds string comment '当前时间,用于分区字段')

> row format delimited

> stored as rcfile

> location '/user/hive/test'; maxcompute建表语句:

create table page_view

(

page_id bigint comment '页面ID',

page_name string comment '页面名称',

page_url string comment '页面URL'

) partitioned by (ds string comment '当前时间,用于分区字段')从建表语句上明显的可以感觉出来,maxcompute没有指定分隔符,没有指定文件存储路径,没有指定文件的存储格式。难道是默认的吗?不。

因为maxcompute是基于阿里云飞天文件系统,用户无需关心文件存储格式,压缩格式,存储路径等,

这些操作由阿里云来完成,用户也不用来疲于文件存储成本,压缩性价比,读写速度等优化,可以将精力集中在业务的开发上。

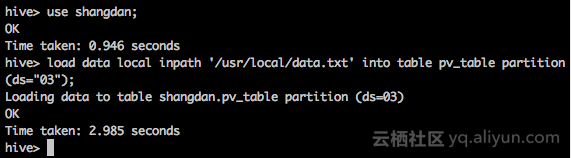

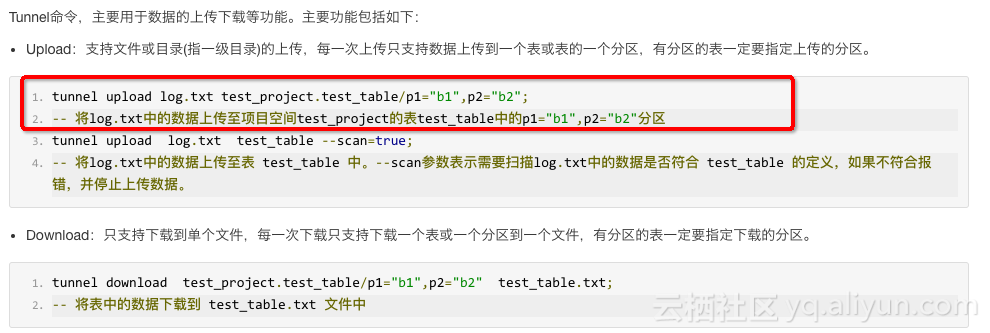

另外二者的数据的上传下载;

hive可以通过命令,比如上传

maxcompute是通过命令工具 tunnel上传下载,同时支持在上传过程校验文件格式脏数据等

④分区和分桶

分区的概念相信使用hive的同学很熟悉,其实就是在表目录上再套一层目录,将数据区分,目的就是提高查询效率。那么从上面建表语句中可以看出maxcomoute和hive都是支持分区的,概念用法一致。

关于分桶,上面建表语句中hive中有分桶语句,maxcompute没有分桶的操作,实际上分桶是把一个大文件根据某个字段hash成多个小文件,适当的分桶会提高查询效率,在maxcompute中这些优化底层已经做了。

⑤外部表功能

hive可以通过外部表的功能来操作例如hbase和es的数据。外部表功能maxcompute(2.0版本支持)中也是同样适用,maxcompute通过外部表来映射阿里云的OTS和OSS两个数据存储产品来处理非结构化的数据,例如音频视频等。看下建表语句:

CREATE EXTERNAL TABLE IF NOT EXISTS ambulance_data_csv_external

(

vehicleId int,

recordId int,

patie

ntId int,

calls int,

locationLatitute double,

locationLongtitue double,

recordTime string,

direction string

)

STORED BY 'com.aliyun.odps.CsvStorageHandler' -- (2)

LOCATION 'oss://oss-cn-hangzhou-zmf.aliyuncs.com/oss-odps-test/Demo/SampleData/CSV/AmbulanceData/';

再看hive映射到hbase建表语句

CREATE EXTERNAL TABLE cofeed_info

(

rowkey string,

id string,

source string,

insert_time timestamp,

dt string

) STORED BY ‘org.apache.Hadoop.hive.hbase.HBaseStorageHandler’ WITH

SERDEPROPERTIES (“hbase.columns.mapping”=

“:key,

cf:id,

cf:source,

cf:insert_time,

cf:dt”) TBLPROPERTIES (“hbase.table.name” = “cofeed_info”);语法基本一致,maxcompute可以自定义extractor来处理非结构化数据,可以参考https://yq.aliyun.com/articles/61567来学习

⑥webui

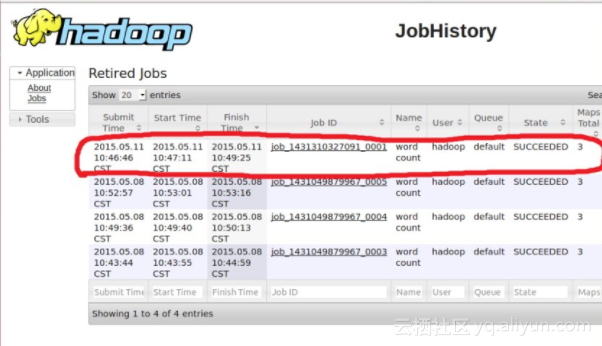

hive任务依赖于hadoop的hdfs和yarn提供的webui访问。看下对比

hadoopwebui

在这里可以通过历史任务来查看hive任务的执行情况。个人觉得页面不是很友好。

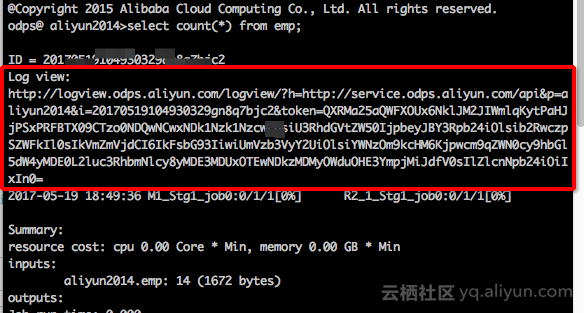

那么在Maxcompute中当然也是可以通过ui来查看任务执行状态,进度,参数,以及任务日志等

首先在任务执行的时候,在客户端会打印出来一串http地址我们叫做logview,复制下来在浏览器中打开即可。

如图

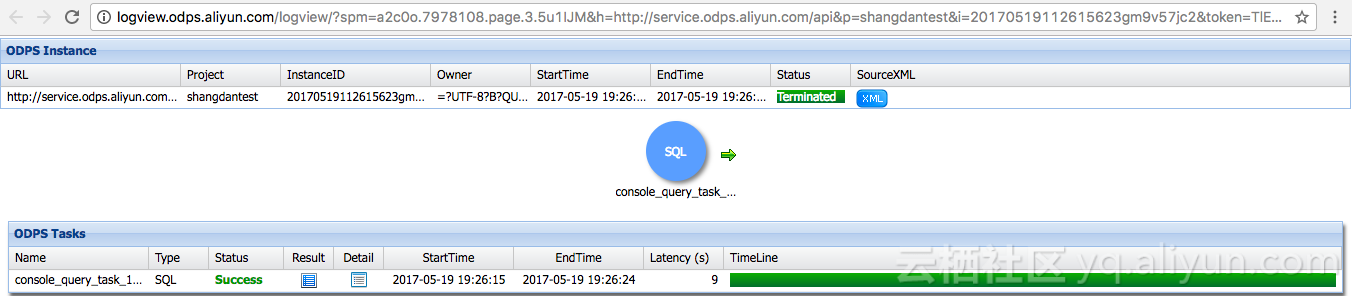

在浏览器中打开

总体上一看,非常清晰明了。任务开始时间结束时间,任务状态,绿色进度条。很方便的获取任务的总体情况

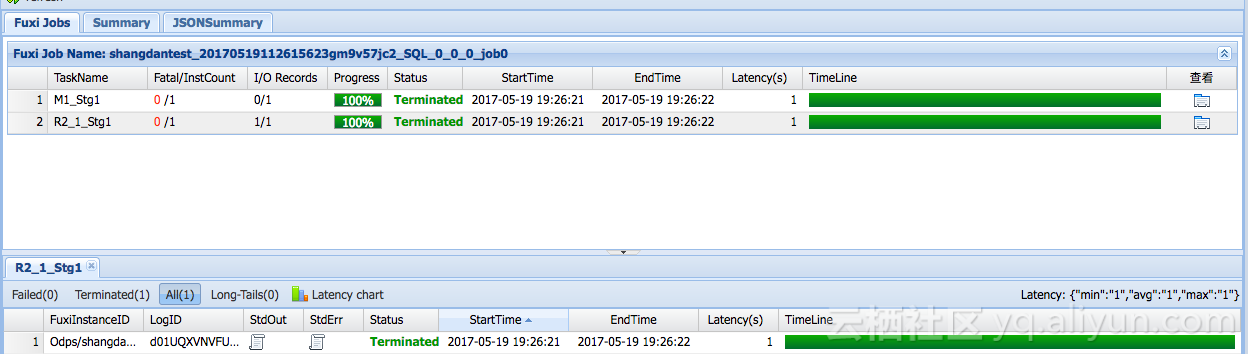

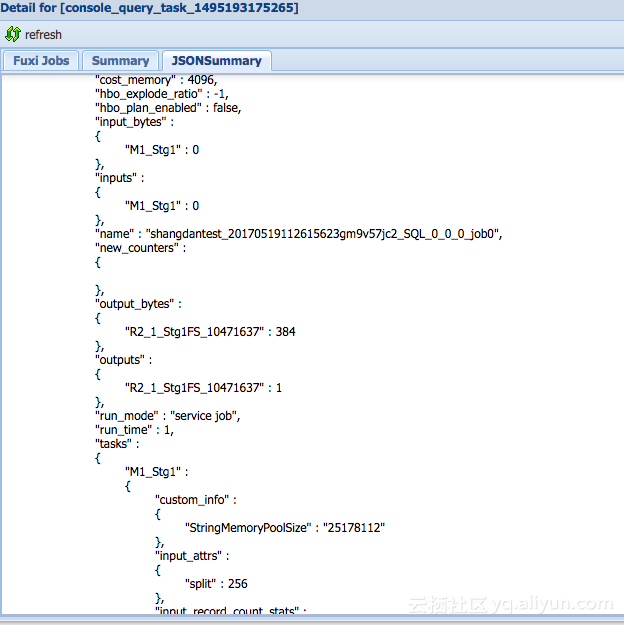

点击Detail按钮可以看更具体的调度,日志等

点击jsonsumary可以看到非常详细的执行过程

那么可以看到Maxcompute的webui还是比较友好的,方便用户很快定位问题。调度方面这里也说一下是由阿里云统一调度,用户无需关心优化。

⑦自定义函数的支持

hive和Maxcompute都支持自定函数。同样是三种,udf,udtf,udaf。

代码写法一致。最大的区别在于数据类型的支持上。

目前Maxcompute支持的数据类型是

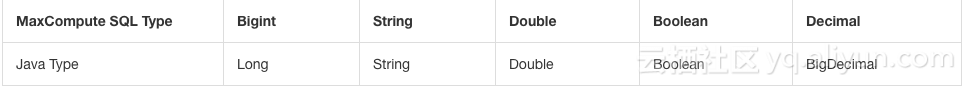

UDF 支持 MaxCompute SQL 的数据类型有:Bigint, String, Double, Boolean 类型 。MaxCompute 数据类型与 Java 类型的对应关系如下:

注意:

java 中对应的数据类型以及返回值数据类型是对象,首字母请务必大写;

目前暂不支持 datetime 数据类型,建议可以转换成 String 类型传入处理 。

SQL 中的 NULL 值通过 Java 中的 NULL 引用表示,因此 Java primitive type 是不允许使用的,因为无法表示 SQL 中的 NULL 值 。

所以不同于hive中支持各种类型。

看maxcompute代码示例

import com.aliyun.odps.udf.UDF;

public final class Lower extends UDF {

public String evaluate(String s) {

if (s == null) { return null; }

return s.toLowerCase();

}

}用法一致,所以使用hive的用户基本可以直接迁移。

在此强调一下,在MaxCompute中处于安全层面的考虑对udf和mr是有java沙箱限制的,比如在udf代码中不能启用其他线程等等,具体可以参考

https://help.aliyun.com/document_detail/27967.html

那么可以看到Maxcompute的webui还是比较友好的,方便用户很快定位问题。调度方面这里也说一下是由阿里云统一调度,用户无需关心优化。

⑧界面化操作。

谈到界面化的操作,阿里云的产品基本上都是界面化操作,可拖拽等等,开发门槛非常低,所以也是非常适合初学大数据或者公司没有相关开发人力的公司。

hive可以借助hue工具来操作查询数据,但是实际上交互性不是很强。

那么这里就将Maxcompute的界面化操作以及数据同步,权限控制,数据管理,和其他数据源交互,定时调度等简单介绍下,就是阿里云的产品-大数据开发套件,目前是免费使用的。需要开通Maxcompute项目进入操作。等不及了直接上图

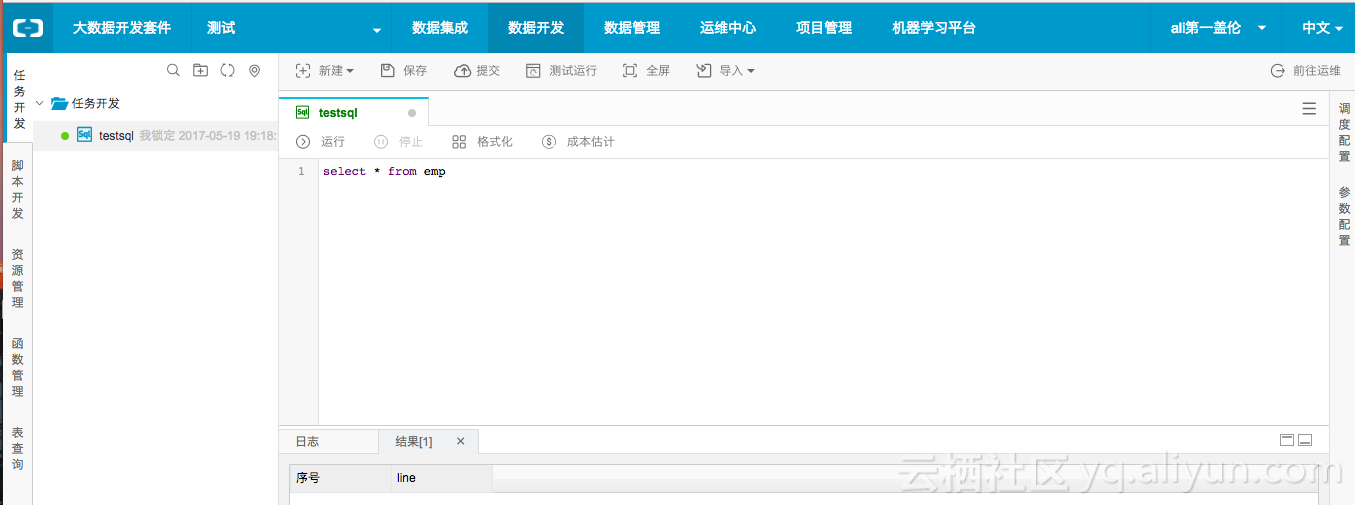

1,Maxcompute sql 查询界面化

maxcompute mapreduce界面化配置

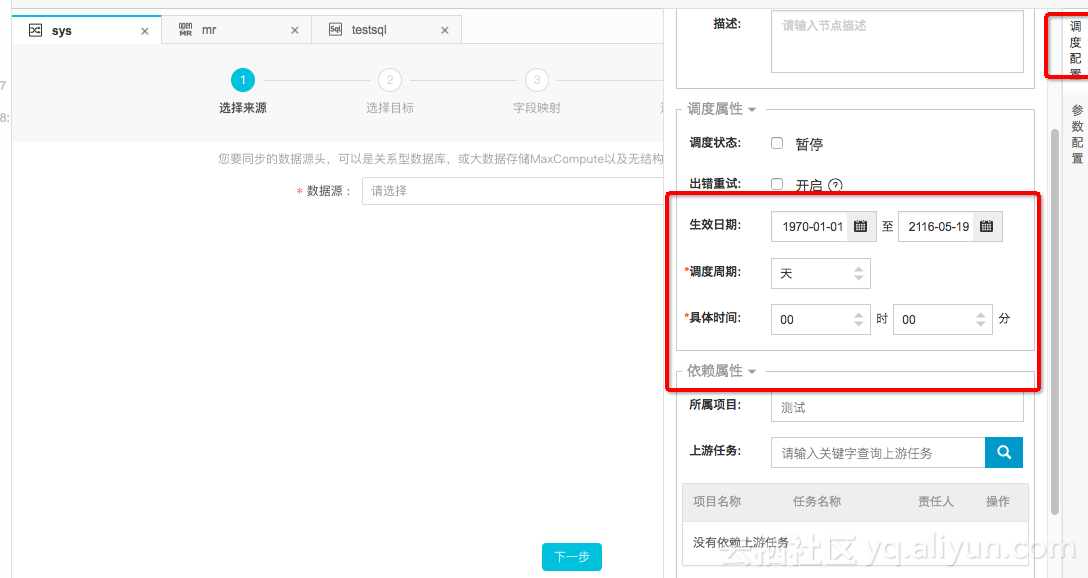

Maxcompute数据同步界面化

hive可以通过sqoop工具和多种数据源进行数据同步。Maxcompute在大数据开发套件中也是非常方便的和其他数据源进行同步

并且可以配置流程控制,调度

是不是很神奇,惊不惊喜,意不意外。具体的使用还是大家亲自体验,这里就不一一介绍了。

那最后来看下hadoop-mapreduce和Maxcompute-mapreduce的使用对比。还是用大家最喜欢的wordcount来做示例。

介绍之前还是要强调一下,1,Maxcompute-mapreduce输入输出都是表(或者分区)的形式,如果需要引用其他文件,需要先上传2,Maxcompute-mapreduce也是有沙箱限制,不允许在代码中启用别的框架线程等。

hadoop-mr代码就不贴了,直接上Maxcompute-mapreduce代码

@Override

public void setup(TaskContext context) throws IOException {

word = context.createMapOutputKeyRecord();

one = context.createMapOutputValueRecord();

one.set(new Object[] { 1L });

System.out.println("TaskID:" + context.getTaskID().toString());

}

@Override

public void map(long recordNum, Record record, TaskContext context)

throws IOException {

//maxcompute中是以表中一行记录来处理,Record

for (int i = 0; i < record.getColumnCount(); i++) {

word.set(new Object[] { record.get(i).toString() });

context.write(word, one);

}

}

}再看job主函数配置,代码逻辑是通用的

public static void main(String[] args) throws Exception {

if (args.length != 2) {

System.err.println("Usage: WordCount <in_table> <out_table>");

System.exit(2);

}

JobConf job = new JobConf();

job.setMapperClass(TokenizerMapper.class);

job.setCombinerClass(SumCombiner.class);

job.setReducerClass(SumReducer.class);

//这里可以直接指定map端输出的字段

job.setMapOutputKeySchema(SchemaUtils.fromString("word:string"));

job.setMapOutputValueSchema(SchemaUtils.fromString("count:bigint"));

//这里输入出需要是表活着分区

InputUtils.addTable(TableInfo.builder().tableName(args[0]).build(), job);

OutputUtils.addTable(TableInfo.builder().tableName(args[1]).build(), job);

JobClient.runJob(job);

}那么基本上主要的功能对比差不多了,大家可以发现,如果您是一位使用过hive的开发人员可以秒迁移到maxcompute上,更加方便简洁的来做开发,将开发人员从苦逼的加班中解放出来,实际上公司节省了大量的运维成本,开发人力成本等等,将主要精力放在业务开发。如果非要问我hive和maxcompute的性能对比,那我只能告诉它是经历双十一考验过的。

总结:如果说工业革命是将人们从体力劳动解放出来,那么如今的互联网革命,尤其是云计算大数据的飞速发展是将人们从脑力中解放出来。

相关推荐

本课程旨在指导学习者如何基于阿里云服务,搭建一个高效且可靠的数据仓库系统。学习者将从基础概念出发,逐步深入到实际的项目需求和架构设计中,最终理解并掌握数据在整个数仓架构中的采集、存储、计算、输出和展示...

DataSphereStudio(DSS)是阿里云推出的一款强大而全面的大数据开发平台,旨在为用户提供从数据接入、处理、分析到展示的一站式解决方案。其核心功能涵盖了数据交换、数据清洗、数据分析、数据质量检测、数据可视化...

内容概要:本文详细介绍了利用COMSOL软件模拟碳酸钙(CaCO3)在岩石中与盐酸(HCl)反应过程中产生的随机孔隙酸化路径及其形成的布林克曼流动。首先,通过蒙特卡洛方法生成随机孔隙分布,模拟真实岩石内部复杂的孔隙结构。接着,采用布林克曼方程处理多孔介质中的粘性力和渗透流动,并引入化学反应模块,模拟CaCO3与HCl之间的化学反应。随着模拟的进行,酸液流动路径逐渐形成类似雪花状的分形结构,展示了流动与溶解之间的动态博弈。最后,通过自适应网格技术和粒子追踪功能,精确捕捉并可视化这些精美的分形图案。 适合人群:从事地质工程、材料科学、化学工程等领域研究的专业人士,以及对多孔介质传输现象感兴趣的科研工作者。 使用场景及目标:适用于研究多孔介质内的化学反应和流体流动特性,特别是对于优化石油开采中的酸化压裂工艺具有重要指导意义。 其他说明:文中提供了详细的MATLAB和COMSOL代码片段,帮助读者理解和重现模拟过程。此外,强调了随机性和确定性在微观尺度上的相互作用,揭示了自然界深层次的规律。

内容概要:本文详细介绍了将滑模控制(SMC)应用于永磁同步电机(PMSM)直接转矩控制(DTC)的技术细节。首先解释了转矩和磁链误差计算方法,接着探讨了滑模面的设计及其对系统抖振的影响。文中还提供了扇区矢量选择的具体实现方式,并深入讨论了磁链观测器的改进措施。此外,文章分析了滑模控制器的设计要点以及仿真过程中需要注意的关键参数配置。通过对比传统PI控制,验证了滑模控制在提高系统鲁棒性和快速响应方面的优势。 适合人群:从事电机控制系统研究的专业人士,尤其是对永磁同步电机直接转矩控制感兴趣的科研工作者和技术人员。 使用场景及目标:适用于希望深入了解并掌握滑模控制理论及其在PMSM-DTC应用中的具体实现方法的研究人员。目标是在实际项目中能够运用滑模控制提升系统的稳定性和性能。 其他说明:文中提供的MATLAB/Simulink代码片段有助于读者更好地理解和复现实验结果。同时提醒读者关注一些常见的陷阱,如参数选择不当可能导致的问题。

内容概要:本文详细介绍了北京大学针对网络安全工作人员的管理规定,旨在加强网络安全管理和明确不同角色的责任。全文分为九章,涵盖了网络安全工作人员及其职责、聘用管理、转岗和离岗管理、教育培训、第三方人员管理及奖惩措施等方面的内容。重点在于明确各级单位和人员的具体职责,确保网络安全制度的有效执行,并强调了对第三方人员的严格管控和保密要求。 适合人群:适用于高校网络安全管理人员及相关技术人员,尤其是北京大学及其下属单位的网络安全工作者。 使用场景及目标:①帮助高校建立健全网络安全管理体系;②指导网络安全工作人员明确自身职责,提高工作效率;③规范第三方人员的访问和操作,降低安全风险。 其他说明:本文还提供了多个附件,如网络安全承诺书、访问申请表和保密协议模板,便于实际操作和管理。

内容概要:本文深入探讨了中国网络设备市场的现状及其未来发展潜力。首先介绍了网络设备的基本概念及其作为现代通信网络基础设施的重要地位,随后分析了当前市场面临的挑战和技术进步带来的机遇。文中特别强调了5G、物联网、云计算等新兴技术对网络设备性能和安全性的更高要求,以及由此催生的高带宽、低延迟产品的市场需求。此外,还讨论了软件定义网络(SDN)、网络功能虚拟化(NFV)、边缘计算等新技术的应用前景,指出未来网络设备将更加智能化、自动化,并能更好地支持AI和ML技术。最后,通过对多家领先企业的案例研究,展示了行业内竞争态势及各公司在技术创新方面的努力。 适用人群:从事网络设备相关领域的研究人员、工程师、管理人员,以及关注该领域发展的投资者。 使用场景及目标:帮助读者了解网络设备行业的最新动态和技术趋势,为制定战略决策提供依据;同时为企业和个人投资者提供市场洞察,辅助其做出合理的投资选择。 其他说明:报告基于详实的数据分析和专家意见撰写而成,旨在为专业人士提供有价值的参考资料。

内容概要:本文详细介绍了基于西门子1200 PLC的码垛系统的设计与实现,涵盖了多个关键技术点。首先,文章讲解了Modbus TCP通讯的实现方法,展示了如何通过TSEND_C和TRCV_C功能块进行工业相机和机器人之间的数据传输,并提供了具体的报文处理代码。接着,文章深入探讨了SCL编程的优势及其在复杂逻辑处理中的应用,如托盘堆叠算法,该算法能够根据当前层数动态调整机械手的高度,确保堆叠的安全性和稳定性。此外,文章还介绍了机器人控制中的移位寄存器实现的动作队列管理和变频器的速度平滑处理,以及视觉系统的坐标解析和异常处理机制。最后,文章强调了良好的注释规范和异常处理链的重要性,确保程序的可维护性和可靠性。 适合人群:从事工业自动化领域的工程师和技术人员,尤其是熟悉西门子PLC编程和SCL语言的从业者。 使用场景及目标:适用于需要深入了解和掌握西门子1200 PLC在码垛系统中的具体应用的技术人员。目标是帮助读者理解并实现多设备联动的复杂控制系统,提高系统的稳定性和效率。 其他说明:文中提供的代码示例和详细的解释有助于读者更好地理解和应用相关技术,同时也为后续的维护和优化提供了宝贵的参考资料。

适合从入门到进阶的驱动程序爱好者

计算机二级上机题库答案.pdf

内容概要:本文介绍了深信服科技推出的下一代防火墙(NGAF)网络安全监测解决方案。随着网络安全成为国家战略的一部分,企业不仅需要遵守法律法规,还需增强自身的网络安全防护能力。传统的安全措施难以应对复杂的新型威胁,如APT攻击。深信服的NGAF通过多维度的安全监测,包括入侵风险、僵尸主机、实时漏洞、数据风险、黑链风险以及对外DoS攻击监测等功能,结合云端威胁情报共享,为企业提供了一套立体化的主动防御体系。该方案不仅可以旁路或串接部署,不影响现有业务系统,还能通过外置数据中心进行日志管理和综合分析,帮助用户快速定位和解决安全问题。 适合人群:IT管理人员、网络安全专家、企业信息安全负责人。 使用场景及目标:适用于各类企业的网络安全建设,特别是需要应对复杂网络攻击的企业。目标是构建一个多层次、全方位、智能化的网络安全监测和响应体系,提高企业的安全防护能力和应急响应速度。 其他说明:深信服NGAF不仅提升了网络安全监测的效果,还降低了运维成本,改变了传统的被动防护模式,使得安全运维更加高效和智能化。

内容概要:本文详细介绍了利用COMSOL软件进行超表面偏振转换的设计方法,主要聚焦于介质半波片和1/4波片的实现。文中首先解释了超表面的基本原理及其在光学调控中的重要作用,随后具体阐述了如何在COMSOL中设置材料属性、创建几何结构并施加适当的边界条件。针对半波片和1/4波片的不同需求,分别探讨了它们各自的设计要点、模拟步骤及优化策略。此外,还分享了一些实用的编码示例和技术诀窍,帮助研究人员更好地理解和掌握相关技能。 适合人群:从事光学工程、光电子学等领域研究的专业人士,尤其是那些希望深入了解超表面偏振转换机制并对COMSOL有一定使用经验的技术人员。 使用场景及目标:适用于需要设计高性能偏振转换器件的研究项目,旨在提高对超表面特性的认识水平,推动新型光学组件的研发进程。通过学习本文提供的理论知识和实践经验,读者可以在实际工作中运用COMSOL完成高质量的仿真实验。 其他说明:文中不仅涵盖了基本的概念介绍,还包括了许多具体的实施细节,如参数选择、模型构建、边界条件设定等,这些都是成功搭建有效仿真的关键因素。同时,作者也强调了实验过程中可能出现的问题及解决方案,为后续研究提供了宝贵的参考资料。

内容概要:本文详细介绍了将萤火虫算法应用于支持向量机(SVM)模型参数优化的方法和技术细节。首先解释了萤火虫算法的基本原理及其在参数空间中的应用方式,然后展示了具体的Python实现代码,包括萤火虫移动规则、适应度评价函数以及主循环逻辑。文中还讨论了参数范围设定、随机扰动的作用、目标函数设计等多个关键技术点,并提供了多个数据集上的实验结果对比,证明了该方法的有效性和优越性。 适合人群:对机器学习尤其是SVM模型有一定了解的研究人员和工程师,希望掌握先进的超参数优化技术。 使用场景及目标:适用于需要提高SVM模型性能的项目中,特别是在面对大规模数据集或复杂特征空间的情况下。通过使用萤火虫算法进行参数寻优,可以显著减少调参时间和成本,获得更好的分类效果。 其他说明:文章不仅提供了理论依据,还有详细的代码示例可供参考。此外,作者强调了一些实用技巧如参数范围的选择、随机扰动的应用等,有助于读者更好地理解和应用这一技术。

内容概要:本文详细介绍了软考高级信息系统项目管理师考试的内容,

内容概要:本文探讨了网络中间设备(middlebox)在现代网络架构中的地位和发展方向。首先介绍了网络中间设备的基本概念及其与传统转发设备的区别,强调了中间设备在网络安全、流量管理和优化方面的作用。接着讨论了软件定义网络(SDN)和网络功能虚拟化(NFV)背景下,中间设备面临的机遇和挑战,以及两者融合的趋势。最后展望了未来网流监控技术的发展前景,特别是在高效载荷过滤算法和敏捷策略管理机制方面的突破。 适合人群:从事网络工程、信息安全、云计算等领域工作的技术人员,以及对网络技术和架构感兴趣的科研人员。 使用场景及目标:帮助读者理解网络中间设备的关键作用和技术发展趋势,指导他们在实际工作中更好地规划和部署相关设备和服务。 其他说明:文中引用了SIGCOMM 2012和CoNEXT 2013的相关研究成果,提供了丰富的理论依据和技术背景支持。

计算机二级各章考点.pdf

Tomcat 部署配置指南安全配置性能调优

计算机辅助光学设计.pdf

计算机二级考试机试(南开100题全).pdf

计算机二级VFP历年真题及答案.pdf