жСШи¶БпЉЪ¬†2017йШњйЗМдЇСзљСзїЬжКАжЬѓйЂШе≥∞иЃЇеЭЫеЬ®зЇњжКАжЬѓе≥∞дЉЪпЉМйШњйЗМдЇСеНЂе≥•еЄ¶жЭ•йҐШдЄЇйЂШжАІиГљиіЯиљљеЭЗи°°иЃЊиЃ°дЄОеЃЮзО∞зЪДжЉФиЃ≤гАВжЬђжЦЗдЄїи¶БдїОжЧ©жЬЯзЪДиіЯиљљеЭЗи°°еЉАеІЛи∞ИиµЈпЉМињЫиАМиЃ≤иІ£дЇЖйЂШжАІиГљиіЯиљљеЭЗи°°пЉМзЭАйЗНеИЖжЮРдЇЖLVSеТМTengineпЉМдї•еПКе¶ВдљХеБЪеИ∞йЂШеПѓзФ®пЉМжЬАеРОдљЬдЇЖзЃАи¶БжАїзїУгАВ

дї•дЄЛжШѓз≤Њељ©еЖЕеЃєжХізРЖпЉЪ

иіЯиљљеЭЗи°°

иіЯиљљеЭЗи°°жШѓдЇСиЃ°зЃЧзЪДеЯЇз°АзїДдїґпЉМжШѓзљСзїЬжµБйЗПзЪДеЕ•еП£пЉМеЕґйЗНи¶БжАІдЄНи®АиАМеЦїгАВ

дїАдєИжШѓиіЯиљљеЭЗи°°еСҐпЉЯзФ®жИЈиЊУеЕ•зЪДжµБйЗПйАЪињЗиіЯиљљеЭЗи°°еЩ®жМЙзЕІжЯРзІНиіЯиљљеЭЗи°°зЃЧж≥ХжККжµБйЗПеЭЗеМАзЪДеИЖжХ£еИ∞еРОзЂѓзЪДе§ЪдЄ™жЬНеК°еЩ®дЄКпЉМжО•жФґеИ∞иѓЈж±ВзЪДжЬНеК°еЩ®еПѓдї•зЛђзЂЛзЪДеУНеЇФиѓЈж±ВпЉМиЊЊеИ∞иіЯиљљеИЖжЛЕзЪДзЫЃзЪДгАВдїОеЇФзФ®еЬЇжЩѓдЄКжЭ•иѓіпЉМеЄЄиІБзЪДиіЯиљљеЭЗи°°ж®°еЮЛжЬЙеЕ®е±АиіЯиљљеЭЗи°°еТМйЫЖзЊ§еЖЕиіЯиљљеЭЗи°°пЉМдїОдЇІеУБ嚥жАБиІТеЇ¶жЭ•иѓіпЉМеПИеПѓдї•еИЖдЄЇз°ђдїґиіЯиљљеЭЗи°°еТМиљѓдїґиіЯиљљеЭЗи°°гАВеЕ®е±АиіЯиљљеЭЗи°°дЄАиИђйАЪињЗDNSеЃЮзО∞пЉМйАЪињЗе∞ЖдЄАдЄ™еЯЯеРНиІ£жЮРеИ∞дЄНеРМVIPпЉМжЭ•еЃЮзО∞дЄНеРМзЪДregionи∞ГеЇ¶иГљеКЫпЉЫз°ђдїґиіЯиљљеЭЗи°°еЩ®еЄЄиІБзЪДжЬЙF5гАБA10гАБArrayпЉМеЃГдїђзЪДдЉШзЉЇзВєйГљжѓФиЊГжШОжШЊпЉМдЉШзВєжШѓеКЯиГљеЉЇе§ІпЉМжЬЙдЄУйЧ®зЪДеФЃеРОжЬНеК°еЫҐйШЯпЉМжАІиГљжѓФиЊГе•љпЉМзЉЇзВєжШѓзЉЇе∞СеЃЪеИґзЪДзБµжіїжАІпЉМзїіжК§жИРжЬђиЊГйЂШпЉЫзО∞еЬ®зЪДдЇТиБФзљСжЫіе§ЪзЪДжАЭиЈѓжШѓйАЪињЗиљѓдїґиіЯиљљеЭЗи°°жЭ•еЃЮзО∞пЉМињЩж†ЈеПѓдї•жї°иґ≥еРДзІНеЃЪеИґеМЦйЬАж±ВпЉМеЄЄиІБзЪДиљѓдїґиіЯиљљеЭЗи°°жЬЙLVSгАБNginxгАБHaproxyгАВ

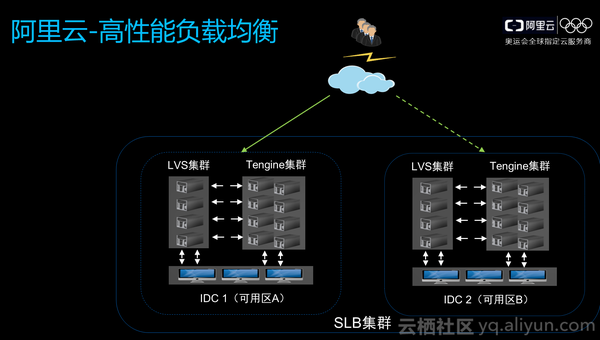

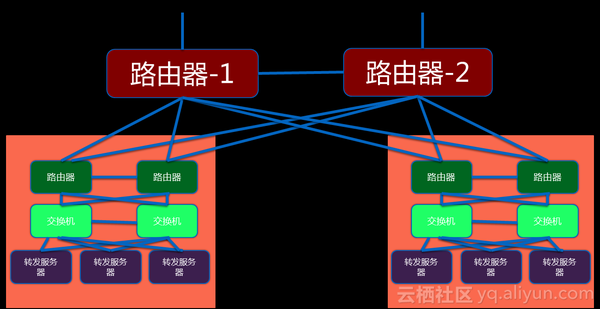

йШњйЗМдЇСйЂШжАІиГљиіЯиљљеЭЗи°°дљњзФ®LVSеТМTengineпЉМжИСдїђеЬ®дЄАдЄ™regionеМЇеИЖдЄНеРМзЪДжЬЇжИњ,жѓПдЄ™жЬЇжИњйГљжЬЙLVSйЫЖзЊ§еТМTengineйЫЖзЊ§пЉМеѓєдЇОзФ®жИЈйЕНзљЃзЪДеЫЫе±ВзЫСеРђпЉМLVSеРОйЭҐдЉЪзЫіжО•жМВиљљзФ®жИЈECSпЉМдЄГе±ВзФ®жИЈзЫСеРђECSеИЩжМВиљљеЬ®TengineдЄКпЉМеЫЫе±ВзЫСеРђзЪДжµБйЗПзЫіжО•зФ±LVSиљђеПСеИ∞ECSпЉМиАМ7е±ВзЫСеРђзЪДжµБйЗПдЉЪзїПињЗLVSеИ∞TenigineеЖНеИ∞зФ®жИЈECSгАВжѓПдЄАдЄ™regionйЗМйГљдЉЪжЬЙе§ЪдЄ™еПѓзФ®еМЇпЉМиЊЊеИ∞дЄїе§ЗеЃєзБЊзЫЃзЪДпЉМжѓПдЄАдЄ™йЫЖзЊ§йЗМйГљжЬЙе§ЪеП∞иЃЊе§ЗпЉМзђђдЄАжШѓдЄЇдЇЖжПРеНЗжАІиГљпЉМзђђдЇМдєЯжШѓеЯЇдЇОеЃєзБЊиАГиЩСгАВ

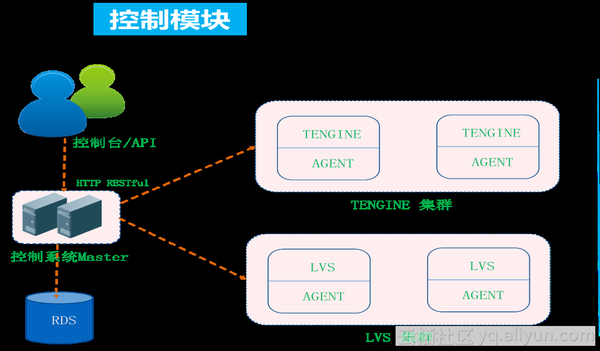

еЫЊдЄЇйЂШжАІиГљиіЯиљљеЭЗи°°жОІеИґзЃ°зРЖж¶Ви¶БеЫЊпЉМSLBдЇІеУБдєЯжЬЙSDNж¶ВењµпЉМиљђеПСеТМжОІеИґжШѓеИЖз¶їзЪДпЉМзФ®жИЈжЙАжЬЙйЕНзљЃйАЪињЗжОІеИґеП∞еЕИеИ∞жОІеИґеЩ®пЉМйАЪињЗйЫЖдЄ≠жОІеИґеЩ®иљђжНҐе∞ЖзФ®жИЈйЕНзљЃжО®йАБеИ∞дЄНеРМиЃЊе§ЗдЄКпЉМжѓПеП∞иЃЊе§ЗдЄКйГљжЬЙAgentжО•жФґжОІеИґеЩ®дЄЛеПСзЪДйЬАж±ВпЉМйАЪињЗжЬђеЬ∞иљђжНҐжИРLVSеТМTengineиГље§ЯиѓЖеИЂзЪДйЕНзљЃпЉМињЩдЄ™ињЗз®ЛжФѓжМБзГ≠йЕНзљЃпЉМдЄНељ±еУНзФ®жИЈиљђеПСпЉМдЄНйЬАи¶БreloadжЙНиГљдљњжЦ∞йЕНзљЃзФЯжХИгАВ

LVS

LVSжФѓжМБзЪДдЄЙзІНж®°еЉП

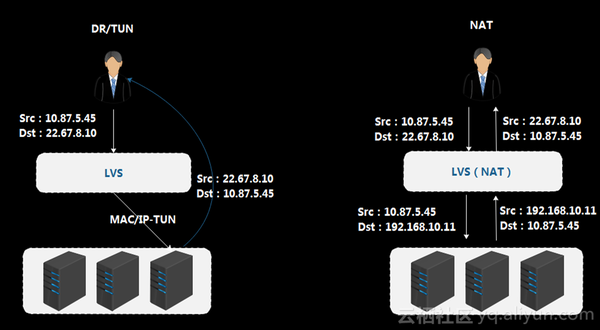

жЧ©жЬЯLVSжФѓжМБдЄЙзІНж®°еЉПпЉМDRж®°еЉПгАБTUNж®°еЉПеТМNATж®°еЉПгАВDRж®°еЉПзїПињЗLVSдєЛеРОпЉМLVSдЉЪе∞ЖMACеЬ∞еЭАжЫіжФєгАБе∞Би£ЕMACе§іпЉМеЖЕе±ВIPжК•жЦЗдЄНеК®пЉМжК•жЦЗзїПињЗLVSиіЯиљљеЭЗи°°жЯ•жЙЊеИ∞RSдєЛеРОпЉМе∞ЖжЇРMACе§іжФєжИРиЗ™еЈ±зЪДпЉМзЫЃзЪДMACжФєжИРRSеЬ∞еЭАпЉМMACеѓїеЭАжШѓеЬ®дЇМе±ВзљСзїЬйЗМпЉМеѓєзљСзїЬйГ®зљ≤жЬЙдЄАеЃЪзЪДйЩРеЃЪпЉМеЬ®е§ІиІДж®°еИЖеЄГеЉПйЫЖзЊ§йГ®зљ≤йЗМпЉМињЩзІНж®°еЉПзЪДзБµжіїжАІж≤°жЬЙеКЮж≥Хжї°иґ≥йЬАж±ВпЉЫTUNж®°еЉПиµ∞еЬ®LVSдєЛеРОпЉМLVSдЉЪеЬ®еОЯжЬЙжК•жЦЗеЯЇз°АдЄКе∞Би£ЕIPе§іпЉМеИ∞дЇЖеРОзЂѓRSдєЛеРОпЉМRSйЬАи¶БиІ£еЉАIPжК•жЦЗе∞Би£ЕпЉМжЙНиГљжЛњеИ∞еОЯеІЛжК•жЦЗпЉМдЄНзЃ°жШѓDRж®°еЉПињШжШѓTUNж®°еЉПпЉМеРОзЂѓRSйГљеПѓдї•зЬЛеИ∞зЬЯеЃЮеЃҐжИЈжЇРIPпЉМзЫЃзЪДIPжШѓиЗ™еЈ±зЪДVIPпЉМVIPеЬ®RSиЃЊе§ЗдЄКйЬАи¶БйЕНзљЃпЉМињЩж†ЈеПѓдї•зЫіжО•зїХињЗLVSињФеЫЮзїЩзФ®жИЈпЉМTUNж®°еЉПйЧЃйҐШеЬ®дЇОйЬАи¶БеЬ®еРОзЂѓECSдЄКйЕНзљЃиІ£е∞Би£Еж®°еЭЧпЉМеЬ®LinuxдЄКеЈ≤зїПжФѓжМБињЩзІНж®°еЭЧпЉМдљЖжШѓwindowsдЄКињШж≤°жЬЙжПРдЊЫжФѓжМБпЉМжЙАдї•дЉЪеѓєзФ®жИЈз≥їзїЯйХЬеГПйАЙжЛ©жЬЙйЩРеЃЪгАВNATж®°еЉПзФ®жИЈиЃњйЧЃзЪДжШѓVIPпЉМLVSжЯ•жЙЊеЃМеРОдЉЪе∞ЖзЫЃзЪДIPеБЪDNATиљђжНҐпЉМйАЙжЛ©еЗЇRSеЬ∞еЭАпЉМеЫ†дЄЇеЃҐжИЈзЂѓзЪДIPж≤°еПШпЉМеЬ®еЫЮеМЕзЪДжЧґеАЩзЫіжО•еРСеЕђзљСзЬЯеЃЮеЃҐжИЈзЂѓIPеОїиЈѓзФ±пЉМNATзЪДзЇ¶жЭЯжШѓеЫ†дЄЇLVSеБЪдЇЖDNATиљђжНҐпЉМжЙАдї•еЫЮеМЕйЬАи¶Биµ∞LVSпЉМжККжК•жЦЗе§іиљђжНҐеЫЮеОїпЉМзФ±дЇОECSзЬЛеИ∞зЪДжШѓеЃҐжИЈзЂѓзЬЯеЃЮзЪДжЇРеЬ∞еЭАпЉМжИСдїђйЬАи¶БеЬ®зФ®жИЈECSдЄКйЕНзљЃиЈѓзФ±пЉМе∞ЖеИ∞ECSзЪДйїШиЃ§иЈѓзФ±жМЗеРСLVSдЄКпЉМињЩеѓєзФ®жИЈеЬЇжЩѓдєЯеБЪдЇЖйЩРеИґгАВ

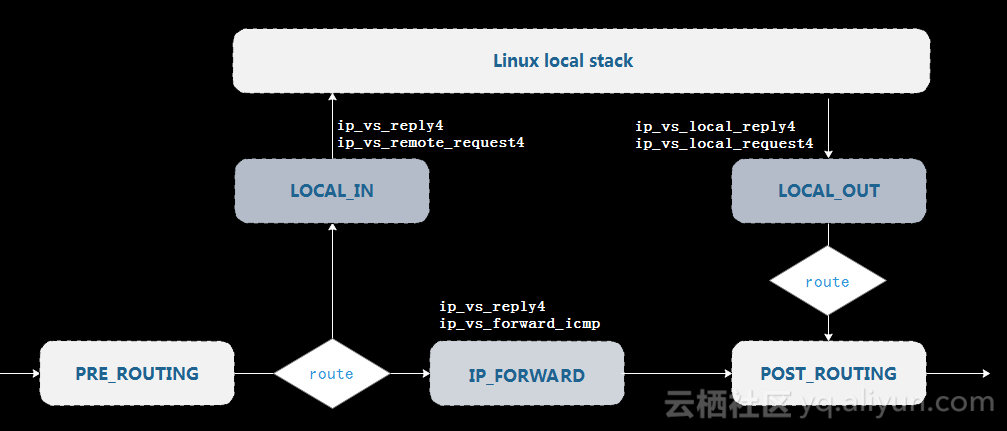

LVSеЯЇдЇОNetfilterж°ЖжЮґеЃЮзО∞

NetfilterжШѓLinuxжПРдЊЫзЪДзљСзїЬеЉАжФЊеє≥еП∞пЉМеЯЇдЇОеє≥еП∞еПѓдї•еЉАеПСиЗ™еЈ±зЪДдЄЪеК°еКЯиГљж®°еЭЧпЉМжЧ©жЬЯе•ље§ЪеЃЙеЕ®еОВеХЖйГљжШѓеЯЇдЇОNetfilterеБЪдЄАдЇЫдЄЪеК°ж®°еЮЛеЃЮзО∞пЉМињЩзІНж®°еЮЛжѓФиЊГзБµжіїпЉМдљЖйАЪзФ®ж®°еЮЛйЗМжЫіе§ЪзЪДжШѓеЕЉеЃєжАІиАГиЩСпЉМиЈѓеЊДдЉЪйЭЮеЄЄйХњпЉЫиАМдЄФйАЪзФ®ж®°еЮЛдЄ≠ж≤°еКЮж≥ХеПСжМ•е§Ъж†ЄзЙєжАІпЉМзЫЃеЙНCPUзЪДеПСе±ХжЫіе§ЪжШѓеРСж®™еРСжЙ©е±ХпЉМжИСдїђзїПеЄЄиІБеИ∞е§ЪиЈѓжЬНеК°еЩ®пЉМжѓПиЈѓдЄКжЬЙе§Ъе∞Сж†ЄпЉМжЧ©жЬЯйАЪзФ®ж®°еЮЛеѓєе§Ъж†ЄжФѓжМБеєґдЄНжШѓзЙєеИЂеПЛеЦДпЉМеЬ®е§Ъж†ЄиЃЊиЃ°дЄКжЬЙдЇЫжђ†зЉЇпЉМеѓЉиЗіжИСдїђеЬ®йАЪзФ®ж®°еЮЛдЄКеБЪдЄАдЇЫеЇФзФ®еЉАеПСжЧґзЪДжЙ©е±ХжАІжШѓжЬЙйЩРзЪДпЉМйЪПзЭАж†ЄзЪДжХ∞йЗПиґКжЭ•иґКе§ЪпЉМжАІиГљдЄНеҐЮеПНйЩНгАВ

LVSзЪДжФєињЫ

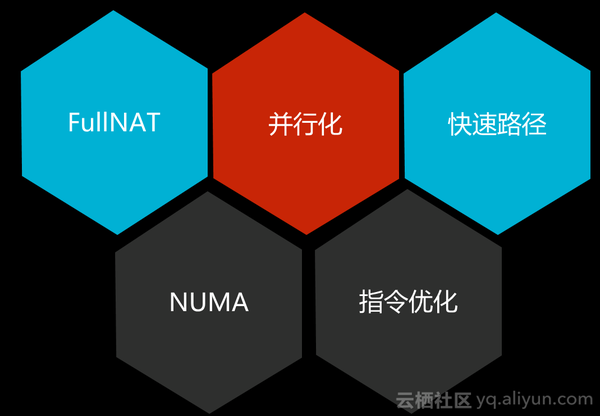

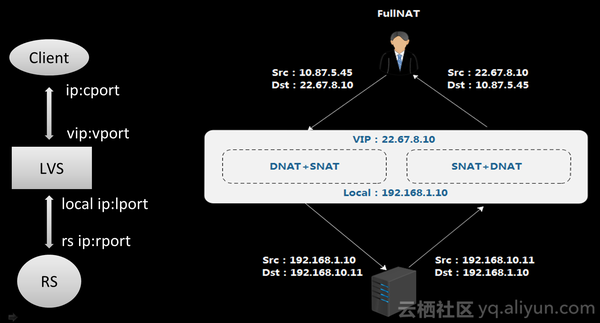

жЧ©жЬЯж®°еЉПзЪДеРДзІНйЩРеИґеИґзЇ¶дЇЖжИСдїђзЪДеПСе±ХпЉМжЙАдї•жИСдїђй¶ЦеЕИеБЪдЇЖFullNATпЉМзЫЄжѓФеОЯжЭ•зЪДNATжЦєеЉПпЉМFullNATе§ЪдЇЖSNATе±ЮжАІпЉМе∞ЖеЃҐжИЈзЂѓзЪДеОЯIPеЬ∞еЭАдљЬдЇЖиљђжНҐпЉЫеЕґжђ°пЉМжИСдїђеЬ®еєґи°МеМЦдЄКеБЪдЇЖе§ДзРЖпЉМеЕЕеИЖеИ©зФ®е§Ъж†ЄеЃЮзО∞жАІиГљзЇњжАІжПРеНЗпЉЫзДґеРОжШѓењЂйАЯиЈѓеЊДпЉМжИСдїђеЬ®еБЪзљСзїЬиљђеПСж®°еЮЛжЧґеЊИеЃєжШУжГ≥еИ∞иЃЊиЃ°ењЂйАЯиЈѓеЊДеТМжЕҐйАЯиЈѓеЊДпЉМжЕҐйАЯиЈѓеЊДжЫіе§ЪжШѓиІ£еЖ≥й¶ЦеМЕе¶ВдљХйАЪињЗиЃЊе§ЗйЧЃйҐШпЉМеПѓиГљйЬАи¶БжЯ•ACLжИЦиЈѓзФ±пЉМйЬАи¶БеИ§жЦ≠иЃЄе§ЪеТМз≠ЦзХ•зЫЄеЕ≥зЪДдЄЬи•њпЉМеРОйЭҐжЙАжЬЙжК•жЦЗйГљеПѓдї•йАЪињЗењЂйАЯиЈѓеЊДиљђеПСеЗЇеОїпЉЫињШжЬЙжМЗдї§зЫЄеЕ≥дЉШеМЦпЉМеИ©зФ®еЫ†зЙєе∞ФзЙєжЃКжМЗдї§жПРеНЗжАІиГљпЉЫеП¶е§ЦйТИеѓєе§Ъж†ЄжЮґжЮДпЉМNUMAе§ЪиКВзВєеЖЕе≠ШиЃњйЧЃпЉМйАЪињЗиЃњйЧЃLocalиКВзВєеЖЕе≠ШеПѓиГљиОЈеЊЧжЫіе•љзЪДеїґињЯи°®зО∞гАВ

еЃҐжИЈзЂѓињЫжЭ•IPй¶ЦеЕИиЃњйЧЃLVSзЪДVIPпЉМеОЯIPжШѓеЃҐжИЈзЂѓзЪДпЉМзЫЃзЪДIPжШѓLVSзЪДVIPпЉМзїПињЗFullNATиљђжНҐеРОпЉМеОЯIPеПШжИРLVSзЪДLocalеЬ∞еЭАпЉМзЫЃзЪДеЬ∞еЭАжШѓLVSйАЙжЛ©еЗЇжЭ•зЪДRSеЬ∞еЭАпЉМињЩж†ЈеЬ®RSеЫЮеМЕжЧґжѓФиЊГеЃєжШУпЉМеП™и¶БиЈѓзФ±еПѓиЊЊпЉМжК•жЦЗдЄАеЃЪдЉЪдЇ§еИ∞LVSдЄКпЉМдЄНйЬАи¶БеЬ®RSдЄКеБЪзЙєжЃКзЪДйЕНзљЃгАВеП≥йЭҐе∞±жШѓDNAT+SNATиљђжНҐпЉМжК•жЦЗе∞±еПѓдї•йАЪињЗLVSиљђеПСеЫЮеЃҐжИЈзЂѓпЉМињЩзІНжЦєеЉПдЄїи¶БеЄ¶жЭ•еЇФзФ®еЬЇжЩѓйГ®зљ≤зБµжіїжАІйАЙжЛ©гАВ

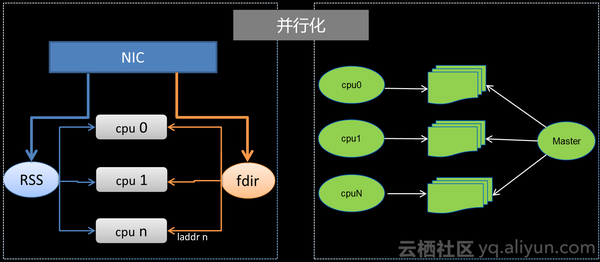

йАЪињЗеєґи°МеМЦеЃЮзО∞еѓєLVSжАІиГљзЪДжФєеЦДпЉМжАІиГљж≤°жЬЙеКЮж≥ХеЊЧеИ∞зЇњжАІжПРеНЗжЫіе§ЪзЪДжШѓеЫ†дЄЇжѓПжЭ°иЈѓеЊДйГљйЬАи¶БиЃњйЧЃеЕ®е±АиµДжЇРпЉМе∞±дЉЪдЄНеПѓйБњеЕНеЉХеЕ•йФБзЪДеЉАзЃ±пЉМеП¶е§ЦпЉМеРМдЄАжЭ°йУЊжО•дЄКзЪДжК•жЦЗеПѓиГљеИЖжХ£еЬ®дЄНеРМзЪДж†ЄдЄКпЉМе§ІеЃґеОїиЃњйЧЃеЕ®е±АиµДжЇРжЧґдєЯдЉЪеѓЉиЗіcacheзЪД䪥姱гАВжЙАдї•жИСдїђйАЪињЗRSSжКАжЬѓжККеРМдЄАдЄ™дЇФжЇРзїДжК•жЦЗжЙФеИ∞еРМдЄАдЄ™CPUдЄКе§ДзРЖпЉМдњЭиѓБеЕ•жЦєеРСзЪДжЙАжЬЙзЫЄеРМињЮжО•дЄКзЪДжК•жЦЗйГљиГљдЇ§зїЩзЫЄеРМCPUе§ДзРЖпЉМжѓПдЄ™ж†ЄеЬ®иљђеПСеЗЇеОїжЧґйГљзФ®ељУеЙНCPUдЄКзЪДLocalеЬ∞еЭАпЉМйАЪињЗиЃЊзљЃдЄАдЇЫfdirиІДеИЩпЉМжК•жЦЗеЫЮжЭ•жЧґеРОзЂѓRSиЃњйЧЃзЪДзЫЃзЪДеЬ∞еЭАе∞±жШѓеѓєеЇФCPUдЄКзЪДlocalеЬ∞еЭАпЉМеПѓдї•дЇ§еИ∞жМЗеЃЪзЪДCPUдЄКеОїе§ДзРЖпЉМињЩж†ЈдЄАжЭ°ињЮжО•дЄКеЈ¶еП≥жЦєеРСжК•жЦЗйГљеПѓдї•дЇ§зїЩеРМдЄАдЄ™CPUе§ДзРЖпЉМе∞ЖжµБеЬ®дЄНеРМзЪДCPUйЪФз¶їеЉАпЉЫеП¶е§ЦпЉМжИСдїђжККжЙАжЬЙйЕНзљЃиµДжЇРеМЕжЛђеК®жАБзЉУе≠ШиµДжЇРеЬ®жѓПдЄ™CPUдЄКдљЬдЇЖжЛЈиіЭпЉМ е∞ЖиµДжЇРе±АйГ®еМЦпЉМињЩдљњжХідЄ™жµБдїОињЫеЕ•LVSеИ∞иљђеПСеЗЇеОїиЃњйЧЃзЪДиµДжЇРйГљжШѓеЫЇеЃЪеЬ®дЄАдЄ™ж†ЄдЄКзЪДжЬђеЬ∞иµДжЇРпЉМдљњжАІиГљиЊЊеИ∞жЬАе§ІеМЦпЉМеЃЮзО∞зЇњжАІжПРеНЗгАВ

зїПињЗжИСдїђжФєињЫдєЛеРОпЉМLVSзЪДеЕЈдљУи°®зО∞е¶ВдЄЛпЉЪ

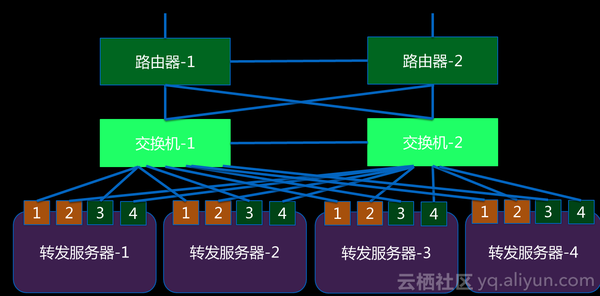

- еЗЇдЇОеѓєеЃєзБЊеТМжАІиГљжПРеНЗзЪДиАГиЩСпЉМжИСдїђеБЪдЇЖйЫЖзЊ§еМЦйГ®зљ≤пЉМжѓПдЄ™regionжЬЙдЄНеРМжЬЇжИњпЉМжѓПдЄ™жЬЇжИњжЬЙе§ЪдЄ™и∞ГеЇ¶еНХеЕГпЉМжѓПдЄ™еНХеЕГжЬЙе§ЪеП∞LVSиЃЊе§ЗпЉЫ

- жѓПеП∞LVSзїПињЗдЉШеМЦеРОпЉМйГљиГљиЊЊеИ∞жЫійЂШжАІиГљпЉМе§ІеЃєйЗПпЉМеНХеП∞LVSеПѓдї•иЊЊеИ∞4000W PPSпЉМ600W CPSгАБеНХдЄ™groupеПѓдї•еИ∞иЊЊ1дЇњеєґеПСпЉЫ

- жФѓжМБregionгАБIDCгАБйЫЖзЊ§еТМеЇФзФ®зЇІзЪДйЂШеПѓзФ®пЉЫ

- еЃЮзО∞дЇЖйШ≤жФїеЗїеКЯиГљпЉМеєґеЬ®еОЯзЙИLVSдЄКжПРдЊЫдЇЖжЫідЄ∞еѓМзЪДеКЯиГљпЉМеПѓдї•еЯЇдЇОеРДдЄ™зїіеЇ¶еБЪзЃ°зРЖжОІеИґпЉМз≤Њз°ЃзЪДзїЯиЃ°пЉМжµБйЗПзЪДеИЖжЮРз≠ЙгАВ

Tengine

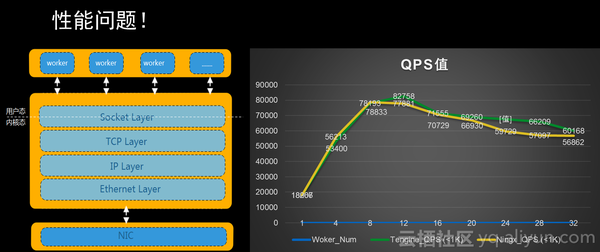

TengineеЬ®еЇФзФ®ињЗз®ЛдЄ≠дєЯйБЗеИ∞дЇЖеРДзІНйЧЃйҐШпЉМжЬАдЄ•йЗНзЪДе∞±жШѓжАІиГљйЧЃйҐШпЉМжИСдїђеПСзО∞йЪПзЭАCPUжХ∞йЗПиґКжЭ•иґКе§ЪпЉМQPSеАЉеєґж≤°жЬЙзЇњжАІжПРеНЗпЉЫNginxжЬђиЇЂжШѓе§Ъworkerж®°еЮЛпЉМжѓПдЄ™workerжШѓеНХињЫз®Лж®°еЉПпЉМе§ЪworkerжЮґжЮДеБЪCPUдЇ≤еТМпЉМеЖЕйГ®еЯЇдЇОдЇЛдїґй©±еК®зЪДж®°еЮЛпЉМеЕґжЬђиЇЂеЈ≤зїПжПРдЊЫдЇЖеЊИйЂШзЪДжАІиГљпЉМеНХж†ЄNginxеПѓдї•иЈСеИ∞1W5пљЮ2W QPSгАВNginxеЊАдЄЛзђђдЄАе±ВжШѓsocket APIпЉМsocket еЊАдЄЛжЬЙдЄАе±ВVFSпЉМеЖНеЊАдЄЛжШѓTCPгАБIPпЉМsocketе±ВжѓФиЊГиЦДпЉМзїПињЗйЗПеМЦзЪДеИЖжЮРеТМиѓДдЉ∞пЉМжАІиГљеЉАйФАжЬАе§ІзЪДжШѓTCPеНПиЃЃж†ИеТМVFSйГ®еИЖпЉМеЫ†дЄЇеРМж≠•еЉАйФАе§ІпЉМжИСдїђеПСзО∞ж®™еРСжЙ©е±ХдЄНи°МпЉМеѓєж≠§пЉМжИСдїђеБЪдЇЖдЄАдЇЫдЉШеМЦгАВ

дЄГе±ВеПНеРСдї£зРЖзЪДиЈѓеЊДжЫійХњпЉМе§ДзРЖжЫіе§НжЭВпЉМжЙАдї•еЃГзЪДжАІиГљжѓФLVSдљОеЊИе§ЪпЉМжИСдїђжѓФиЊГеЕ≥ж≥®еНХжЬЇеТМйЫЖзЊ§зЪДжАІиГљпЉМйЫЖзЊ§жАІиГљеПѓдї•йЭ†е†ЖиЃЊе§ЗеОїиІ£еЖ≥пЉМеНХжЬЇе¶ВжЮЬдЄНжПРеНЗпЉМжИРжЬђдЉЪдЄАзЫіеҐЮеК†пЉМдїОжАІиГљиІТеЇ¶жЭ•зЬЛпЉМжЬЙдї•дЄЛзЪДдЉШеМЦжАЭиЈѓеТМжЦєеРСпЉЪ

- еЯЇдЇОKernelеБЪеЉАеПСпЉМжѓФе¶ВдЉШеМЦеНПиЃЃж†ИпЉЫ

- еЯЇдЇОAliscoketзЪДдЉШеМЦпЉМAlisocketжШѓйШњйЗМз†ФеПСзЪДйЂШжАІиГљTCPеНПиЃЃж†Иеє≥еП∞пЉМеЇХе±ВжШѓDPDKпЉМеЃГе∞ЖиµДжЇРеБЪдЇЖе±АйГ®еМЦе§ДзРЖпЉМжК•жЦЗеИЖеПСдЄНеРМж†Єе§ДзРЖпЉМжАІиГљйЭЮеЄЄеЗЇиЙ≤пЉЫ

- HTTPSдЄЪеК°иґКжЭ•иґКе§ЪпЉМжµБйЗПйАРж≠•йАТеҐЮпЉМжИСдїђйЗЗзФ®з°ђдїґеК†йАЯеН°жЦєеЉПеБЪдЄАдЇЫеК†иІ£еѓЖзЪДжАІиГљжПРеНЗпЉМињШжЬЙHTTPSзЪДдЉЪиѓЭе§НзФ®пЉЫ

- еЯЇдЇОWebдЉ†иЊУе±ВзЪДжАІиГљдЉШеМЦгАВ

дїОеЉєжАІиІТеЇ¶зЬЛпЉМжѓФе¶ВдЄАдЇЫеЕђеПЄзЪДеЇФзФ®еТМзФ®жИЈзГ≠зВєжЬЙеЕ≥пЉМељУеПСзФЯдЄАдЄ™з§ЊдЉЪзљСзїЬзГ≠зВєеРОпЉМиЃњйЧЃйЗПдЉЪжА•еЙІеПШйЂШпЉМжИСдїђеЫЇжЬЙзЪДеЯЇдЇОзЙ©зРЖжЬЇеЩ®еЃЮзО∞зЪДиіЯиљљеЭЗи°°ж®°еЮЛеЬ®еЉєжАІжЙ©е±ХжЦєйЭҐжШѓжЬЙйЩРеИґзЪДпЉМеѓєж≠§пЉМжИСдїђеПѓдї•дљњзФ®VMеОїеБЪпЉМжККеПНеРСдї£зРЖеКЯиГљжФЊеЬ®VMеОїиЈСпЉМжИСдїђдЉЪзЫСжОІеЃЮдЊЛиіЯиљљжГЕеЖµпЉМж†єжНЃеЃЮжЧґйЬАж±ВеБЪеЉєжАІжЙ©еЃєзЉ©еЃєпЉЫйЩ§дЇЖVMпЉМињШжЬЙи∞ГеЇ¶еНХеЕГпЉМжИСдїђеПѓдї•еЬ®дЄНеРМи∞ГеЇ¶еНХеЕГеБЪеє≥жїСеИЗжНҐпЉМж†єжНЃдЄНеРМзЪДж∞ідљНжГЕеЖµпЉМйАЪињЗеИЗжНҐеПѓдї•жККиіЯиљљеЭЗи°°еЃЮдЊЛи∞ГеЇ¶еИ∞дЄНеРМзЪДеНХеЕГдЄ≠еОїпЉМжФєеЦДдљњеЃєйЗПдЄКзЃ°зРЖгАВTengineжЬђиЇЂдєЯеБЪдЇЖйЫЖзЊ§еМЦйГ®зљ≤пЉМжИСдїђеЬ®дЄАдЄ™regionйЗМжЬЙдЄНеРМзЪДжЬЇжИњпЉМдЄНеРМзЪДи∞ГеЇ¶еНХеЕГпЉМжѓПдЄ™и∞ГеЇ¶еНХеЕГжЬЙе§ЪзїДиЃЊе§ЗпЉЫLVSеИ∞TengineдєЯжЬЙеБ•еЇЈж£АжЯ•пЉМе¶ВжЮЬдЄАеП∞TengineжЬЙйЧЃйҐШпЉМеПѓдї•йАЪињЗеБ•еЇЈж£АжЯ•жЦєеЉПжСШйЩ§пЉМдЄНдЉЪељ±еУНзФ®жИЈиљђеПСиГљеКЫпЉЫTengineеЕЈе§ЗзБµжіїзЪДи∞ГеЇ¶иГљеКЫпЉМеПѓдї•еЄЃеК©жИСдїђеЇФеѓєжЫіе§ЪзЪДе§НжЭВжГЕеЖµпЉЫеП¶е§ЦпЉМTengineдєЯжЬЙеЊИе§ЪйЂШзЇІзЪДзЙєжАІпЉМжѓФе¶ВеЯЇдЇОcookieзЪДдЉЪиѓЭдњЭжМБгАБеЯЇдЇОеЯЯеРН/URLзЪДиљђеПСиІДеИЩгАБHTTP2гАБWebsocketз≠ЙеКЯиГљпЉЫзЫЃеЙНпЉМжИСдїђ7е±ВеНХVIPеПѓдї•жФѓжТС10WиІДж†ЉзЪДHTTPS QPSгАВ

йЂШеПѓзФ®

Group

йЂШеПѓзФ®жШѓжХідЄ™дЇІеУБеЊИйЗНи¶БзЪДдЄАйГ®еИЖпЉМеЫЊдЄЇйЫЖзЊ§еЖЕзЪДйЂШеПѓзФ®жЮґжЮДеЫЊпЉМеПѓдї•зЬЛеИ∞пЉМеЬ®зљСзїЬиЈѓеЊДдЄКжШѓеЕ®еЖЧдљЩжЧ†еНХзВєзЪДгАВеЕЈдљУжГЕеЖµе¶ВдЄЛпЉЪ

- еПМиЈѓжЬНеК°еЩ®пЉМжѓПиКВзВєеПМзљСеП£дЄКиБФдЄНеРМдЇ§жНҐжЬЇпЉМеҐЮеК†еЄ¶еЃљпЉМйБњеЕНиЈ®иКВзВєжФґеМЕ

- VIPиЈѓзФ±дЄ§иЊєеПСдЄНеРМзЪДдЉШеЕИзЇІпЉМдЄНеРМзЪДVIPпЉМйЂШдЉШеЕИзЇІиЈѓзФ±еЬ®дЄНеРМзЪДдЇ§жНҐжЬЇдЄК

- еНХжЬЇ160GиљђеПСиГљеКЫпЉМеНХVIP 80GеЄ¶еЃљпЉМеНХжµБ 40GеЄ¶еЃљ

- зљСеН°жХЕйЪЬдЄНељ±еУНиљђеПСпЉМдЄКдЄЛжЄЄиЈѓзФ±иЗ™еК®еИЗжНҐ

- ECMPпЉМVIPиЈѓзФ±еПСдЄ§иЊєпЉМйАЪињЗдЉШеЕИзЇІжОІеИґдїОеЕ•еП£

- йЫЖзЊ§640GиљђеПСиГљеКЫпЉМеНХvip 320GеЄ¶еЃљ

- дЉЪиѓЭеРМж≠•пЉМе§ЪжТ≠гАБеМЕиІ¶еПСеРМж≠•гАБеЃЪжЧґеРМж≠•

- еНХжЬЇжХЕйЪЬдЄНељ±еУНиљђеПС

- дЇ§жНҐжЬЇжХЕйЪЬдЄНељ±еУНиљђеПСпЉМиЈѓзФ±зІТзЇІеИЗжНҐ

- зФ®жИЈжЧ†жДЯзЯ•зЪДеНЗзЇІеПШжЫіпЉМйГ®еИЖжЬ™еПКжЧґеРМж≠•зЪДињЮжО•йЗНињЮеН≥еПѓ

AZ

жѓПдЄ™жЬЇжИњињЮжО•дЄ§дЄ™дЄНеРМиЈѓзФ±еЩ®пЉМељУдЄАдЄ™AZеЗЇзО∞жХЕйЪЬдєЛеРОпЉМжИСдїђеПѓдї•жЧ†зЉЭеИЗжНҐеИ∞еП¶е§ЦдЄАдЄ™жЬЇжИњпЉМеЕЈдљУжГЕеЖµе¶ВдЄЛпЉЪ

- VIPеЬ®дЄНеРМзЪДAZеПСдЄНеРМдЉШеЕИзЇІзЪДиЈѓзФ±пЉИзІТзЇІеИЗжНҐгАБиЗ™еК®еИЗжНҐпЉЙ

- VIPеМЇеИЖдЄїе§ЗAZпЉМдЄНеРМзЪДVIPдЄїе§ЗAZдЄНеРМ

- е§ЪдЄ™AZзЪДиіЯиљљйАЪињЗжОІеИґз≥їзїЯеИЖйЕН

- зЉЇзЬБжПРдЊЫVIPе§ЪAZзЪДеЃєзБЊиГљеКЫ

- дЄНжФѓжМБиЈ®AZзЪДsessionеРМж≠•пЉМиЈ®AZеИЗжНҐеРОпЉМжЙАжЬЙињЮжО•йГљйЬАи¶БйЗНињЮ

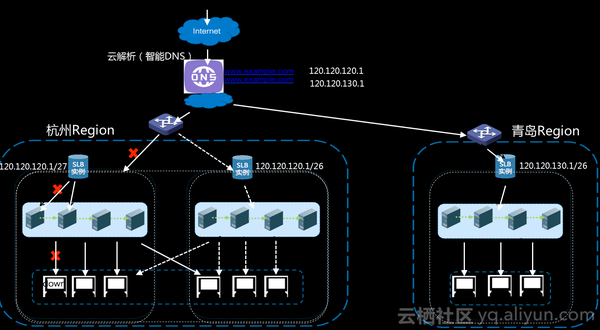

Region

ељУзФ®жИЈиЃњйЧЃеЯЯеРНжЧґпЉМйАЪињЗDNSиІ£жЮРпЉМеПѓдї•иЃЊеЃЪDNSиІ£жЮРеИ∞е§ЪдЄ™regionVIPеЬ∞еЭАпЉМдЄЛж≤ЙеИ∞жЯРдЄАдЄ™RegionжЭ•зЬЛпЉМе¶ВжЮЬдЄАдЄ™жЬЇжИњеЗЇзО∞жХЕйЪЬпЉМжµБйЗПеПѓдї•еИЗжНҐеИ∞еП¶дЄАдЄ™еПѓзФ®еМЇзїІзї≠иљђеПСпЉМе¶ВжЮЬжµБйЗПињЫеИ∞жЬЇжИњеПСзО∞дЄАеП∞LVSиљђеПСиЃЊе§ЗеЗЇзО∞жХЕйЪЬеРОпЉМжИСдїђеПѓдї•еИЗжНҐеИ∞еП¶е§ЦдЄАеП∞LVSдљЬе§ДзРЖпЉМе¶ВжЮЬLVSеРОйЭҐжМВиљљзЪДRSеЗЇзО∞йЧЃйҐШпЉМйАЪињЗеБ•еЇЈж£АжЯ•дєЯеПѓдї•ењЂйАЯжСШжОЙиЃЊе§ЗпЉМе∞ЖжµБйЗПиљђжНҐеИ∞еБ•еЇЈзЪДиЃЊе§ЗдЄКеОїгАВжИСдїђдїОе§ЪдЄ™зїіеЇ¶еЃЮзО∞йЂШеПѓзФ®пЉМжЬАе§ІйЩРеЇ¶зЪДжї°иґ≥зФ®жИЈзЪДйЬАж±ВгАВ

жАїзїУ

зЫЃеЙНпЉМйЂШжАІиГљиіЯиљљеЭЗи°°еЇФзФ®дЄїи¶БеЬ®еЗ†дЄ™жЦєйЭҐпЉЪ

- дљЬдЄЇеЕђжЬЙдЇСеЯЇз°АзїДдїґпЉМдЄЇеЕђжЬЙдЇСзљСзЂЩгАБжЄЄжИПеЃҐжИЈгАБAPPжПРдЊЫиіЯиљљеЭЗи°°еКЯиГљпЉМдєЯйТИеѓєжФњеЇЬгАБйЗСиЮНз≠ЙеЃЙеЕ®жАІйЂШзЪДеЃҐжИЈжПРдЊЫдЄУжЬЙдЇСжФѓжМБпЉЫ

- дЄЇйШњйЗМдЇСеЖЕйГ®дЇСдЇІеУБRDSгАБOSSгАБйЂШйШ≤з≠ЙжПРдЊЫдЇЖиіЯиљљеЭЗи°°зЪДеКЯиГљпЉЫ

- иіЯиљљеЭЗи°°дљЬдЄЇзФµеХЖеє≥еП∞еЕ•еП£пЉМеРСжЈШеЃЭгАБ姩зМЂгАБ1688жПРдЊЫVIPзїЯдЄАжО•еЕ•еКЯиГљпЉЫ

- дЇ§жШУеє≥еП∞зЪДжµБйЗПеЕ•еП£дєЯеЬ®иіЯиљљеЭЗи°°иЃЊе§ЗдЄКпЉМе¶ВжФѓдїШеЃЭгАБзљСдЄКйУґи°МгАВ

жЬ™жЭ•пЉМжИСдїђеЄМжЬЫжЬЙжЫіе•љзЪДеЉєжАІжЙ©е±ХиГљеКЫпЉМжЫійЂШзЪДеНХжЬЇе§ДзРЖиГљеКЫпЉМжИСдїђеЄМжЬЫVIPдЄїеК®жОҐжµЛзФ®жИЈпЉМдї•еПКзљСзїЬеЕ®йУЊиЈѓзЫСжОІгАВ

жЬђжЦЗдЄЇдЇСж†Цз§ЊеМЇеОЯеИЫеЖЕеЃєпЉМжЬ™зїПеЕБиЃЄдЄНеЊЧиљђиљљпЉМе¶ВйЬАиљђиљљиѓЈеПСйАБйВЃдїґиЗ≥yqeditor@list.alibaba-inc.com

зЫЄеЕ≥жО®иНР

еЬ®жЮДеїЇйЂШжАІиГљWebзЂЩзВєжЧґпЉМеЯЇдЇОLVSпЉИLinux Virtual ServerпЉЙзЪДиіЯиљљеЭЗи°°жКАжЬѓжШѓеЕ≥йФЃзЪДдЄАзОѓгАВLVSжШѓдЄАзІНеЉАжЇРзЪДиіЯиљљеЭЗи°°иІ£еЖ≥жЦєж°ИпЉМеЃГиГље§Яе∞ЖзљСзїЬжµБйЗПжЬЙжХИеЬ∞еИЖеПСеИ∞е§ЪдЄ™жЬНеК°еЩ®дЄКпЉМдї•жПРйЂШз≥їзїЯзЪДе§ДзРЖиГљеКЫеТМеПѓзФ®жАІгАВжЬђжЦЗе∞Жиѓ¶зїЖ...

зїЉдЄКпЉМйШњйЗМдЇСзЪДйЂШжАІиГљиіЯиљљеЭЗи°°жЦєж°ИйАЪињЗLVSеТМTengineзЪДзїДеРИпЉМеЃЮзО∞дЇЖйЂШеПѓзФ®гАБеПѓжЙ©е±ХзЪДжµБйЗПеИЖеПСпЉМжї°иґ≥дЇЖе§ІиІДж®°еИЖеЄГеЉПз≥їзїЯзЪДиіЯиљљеЭЗи°°йЬАж±ВпЉМеєґйАЪињЗжМБзї≠дЉШеМЦеЕЛжЬНдЇЖжЧ©жЬЯж®°еЉПзЪДе±АйЩРжАІпЉМжПРеНЗдЇЖжХідљУз≥їзїЯзЪДжАІиГљеТМеПѓйЭ†жАІгАВ

2. з°ђдїґиіЯиљљеЭЗи°°дЇ§жНҐжЬЇе¶ВF5 NetworksзЪДBIG-IPз≥їеИЧпЉМжАІиГљеЊИйЂШпЉМеПѓжФѓжМБйЂШиЊЊжХ∞зЩЊдЄЗжЭ°еєґеПСињЮжО•пЉМдљЖжИРжЬђдєЯзЫЄеѓєиЊГйЂШгАВ 3. иљѓдїґеЃЮзО∞иіЯиљљеЭЗи°°зЪДжЦєж≥ХжЬЙLVSпЉМеЃГжШѓдЄАзІНеЬ®LinuxеЖЕж†ЄдЄ≠ињЫи°МеЫЫе±ВдЇ§жНҐзЪДиљѓдїґпЉМиГље§ЯжФѓжМБйЂШеєґеПСињЮжО•пЉМдЄФ...

ж†ЗйҐШжЙАжґЙеПКзЪДзЯ•иѓЖзВєдЄЇвАЬMycatйЂШеПѓзФ®...еЬ®еЯЇдЇОDubboзЪДеИЖеЄГеЉПз≥їзїЯжЮґжЮДдЄ≠пЉМињЩзІНйЂШеПѓзФ®иіЯиљљеЭЗи°°йЫЖзЊ§зЪДеЃЮзО∞еПШеЊЧе∞§дЄЇеЕ≥йФЃпЉМеЫ†дЄЇеЃГиГље§Яз°ЃдњЭжЬНеК°зЪДйЂШеПѓзФ®еТМз≥їзїЯзЪДйЂШжАІиГљпЉМеѓєдЇОдЉБдЄЪзЇІеЇФзФ®иАМи®АпЉМињЩжШѓдЄАдЄ™йЭЮеЄЄйЗНи¶БзЪДжКАжЬѓжФѓжТСзВєгАВ

жЬђжЦЗдЄїи¶БдїЛзїНдЇЖиіЯиљљеЭЗи°°зЪДеЯЇжЬђж¶ВењµеТМеОЯзРЖпЉМеєґеЯЇдЇОLVSжКАжЬѓпЉМеЬ®Linuxеє≥еП∞иЃЊиЃ°еЃЮзО∞дЇЖдЄАдЄ™йЂШжАІиГљгАБйЂШеПѓдЉЄзЉ©жАІгАБйЂШеПѓзФ®жАІгАБйЂШжАІдїЈжѓФзЪДиіЯиљљеЭЗи°°з≥їзїЯгАВиѓ•з≥їзїЯеПѓдї•жЬЙжХИеЬ∞еҐЮеЉЇжЬНеК°зЪДжАІиГљеТМеПѓзФ®жАІпЉМеЕЈжЬЙеЊИйЂШзЪДдЉЄзЉ©жАІеТМжАІдїЈжѓФгАВ...

гАРиіЯиљљеЭЗи°°зЪДLVSжЬНеК°еЩ®иЃЊиЃ°дЄОеЃЮзО∞гАС LVSпЉИLinux Virtual ServerпЉЙжШѓеЯЇдЇОLinuxжУНдљЬз≥їзїЯзЪДдЄАзІНйЂШжАІиГљгАБйЂШеПѓзФ®зЪДиіЯиљљеЭЗи°°иІ£еЖ≥жЦєж°ИгАВеЃГеИ©зФ®йЫЖзЊ§жКАжЬѓпЉМйАЪињЗIPиіЯиљљеЭЗи°°жКАжЬѓпЉМеЃЮзО∞дЇЖиЩЪжЛЯжЬНеК°еЩ®зЪДеКЯиГљпЉМдїОиАМжПРдЊЫдЇЖйЂШеПѓдЉЄзЉ©...

еЬ®ељУдїКзЪДиЃ°зЃЧйҐЖеЯЯпЉМйЪПзЭАдЇТиБФзљСжКАжЬѓзЪДй£ЮйАЯеПСе±ХеТМе§ІжХ∞жНЃгАБдЇСиЃ°зЃЧз≠Йж¶Вењµ...зРЖиІ£дЄНеРМиіЯиљљеЭЗи°°жКАжЬѓзЪДзЙєзВєеТМйАВзФ®еЬЇжЩѓпЉМжЬЙеК©дЇОеЉАеПСиАЕеТМжЮґжЮДеЄИдЄЇдЄНеРМйЬАж±ВзЪДеИЖеЄГеЉПз≥їзїЯиЃЊиЃ°еЗЇжЬАдљ≥зЪДиіЯиљљеЭЗи°°жЦєж°ИпЉМдї•еЃЮзО∞йЂШжАІиГљгАБйЂШеПѓзФ®жАІзЪДзЫЃж†ЗгАВ

дЉ†зїЯзЪДиіЯиљљеЭЗи°°жЦєж°ИйАЪеЄЄдЊЭиµЦдЇОдЄ≠ењГиКВзВєпЉИе¶ВDNSжЬНеК°еЩ®пЉЙињЫи°МињЮжО•еИЖйЕНпЉМињЩзІНйЫЖдЄ≠еЉПзЪДжЦєж≥ХеЬ®йЂШиіЯиљљжГЕеЖµдЄЛеЃєжШУжИРдЄЇз≥їзїЯжАІиГљзЪДзУґйҐИгАВдЄЇдЇЖиІ£еЖ≥ињЩдЄАйЧЃйҐШпЉМеИЖеЄГеЉПиіЯиљљеЭЗи°°жКАжЬѓеЇФињРиАМзФЯгАВеЕґдЄ≠дЄАзІНжЦєж≥ХжШѓеИ©зФ®IPе∞Би£ЕжКАжЬѓйЗНжЮД...

ж†°еЫ≠зљСWebжЬНеК°еЩ®иіЯиљљеЭЗи°°иЃЊиЃ°еПКOPNETдїњзЬЯ жЬђжЦЗдЄїи¶БдїЛзїНдЇЖж†°еЫ≠зљСWebжЬНеК°еЩ®иіЯиљљеЭЗи°°иЃЊиЃ°еПКOPNETдїњзЬЯзЪДзЫЄеЕ≥зЯ•иѓЖзВєгАВйЪПзЭАж†°еЫ≠зљСзЪДжЩЃеПКпЉМWebжЬНеК°жИРдЄЇж†°еЫ≠зљСжЬАйЗНи¶БзЪДжЬНеК°дєЛдЄАгАВеЬ®йЂШиіЯиљљзЪДжГЕеЖµдЄЛпЉМWebжЬНеК°еЩ®зЪДжАІиГље∞ЖжИРдЄЇ...

HAProxyдљЬдЄЇдЄАдЄ™еєњж≥ЫдљњзФ®зЪДйЂШжАІиГљиіЯиљљеЭЗи°°иІ£еЖ≥жЦєж°ИпЉМиГље§ЯжЬЙжХИеЬ∞еИЖеПСзљСзїЬжИЦеЇФзФ®жµБйЗПеИ∞е§ЪдЄ™жЬНеК°еЩ®дЄКгАВеЯЇдЇОCиѓ≠и®АеЉАеПСзЪДHAProxyжЇРз†БиЃЊиЃ°пЉМдЄНдїЕжДПеС≥зЭАз≥їзїЯзЪДжЙІи°МжХИзОЗйЂШпЉМињШи°®жШОдЇЖеЕґеПѓзїіжК§жАІеТМеПѓжЙ©е±ХжАІгАВ HAProxyзЪДйЂШжАІиГљ...

### иіЯиљљеЭЗи°°еПКжЬНеК°еЩ®йЫЖзЊ§зЪДеЕ≥йФЃж¶ВењµдЄОеЃЮиЈµ #### дЄАгАБиіЯиљљеЭЗи°°дЄОжЬНеК°еЩ®йЫЖзЊ§зЪДйЗНи¶БжАІ иіЯиљљеЭЗи°°еТМжЬНеК°еЩ®йЫЖзЊ§жШѓзО∞дї£дЇТиБФзљСеЇФзФ®жЮґжЮДдЄ≠зЪДеЕ≥йФЃжКАжЬѓдєЛдЄАгАВйЪПзЭАдЇТиБФзљСдЄЪеК°зЪДењЂйАЯеПСе±ХпЉМеНХеП∞жЬНеК°еЩ®еЊАеЊАйЪЊдї•еЇФеѓєе§ІйЗПзЪДеєґеПС...

еЬ®зО∞дї£ITзОѓеҐГдЄ≠пЉМеЃєеЩ®жКАжЬѓеЈ≤зїПжИРдЄЇдЇЖеЇФзФ®йГ®зљ≤еТМзЃ°зРЖзЪДж†ЄењГжЙЛжЃµдєЛдЄА...йАЪињЗжЈ±еЕ•зРЖиІ£ињЩдЇЫзЯ•иѓЖзВєпЉМеЉАеПСиАЕеТМињРзїідЇЇеСШеПѓдї•жЫіе•љеЬ∞жЮДеїЇеТМзїіжК§дЄАдЄ™еЬ®еЃєеЩ®зФЯжАБдЄЛеЕЈжЬЙйЂШжАІиГљиіЯиљљеЭЗи°°иГљеКЫзЪДз≥їзїЯпЉМеЃЮзО∞йЂШжХИгАБз®≥еЃЪеТМеЉєжАІзЪДжЬНеК°дЇ§дїШгАВ

еЫ†ж≠§пЉМжЬђиЃЇжЦЗйТИеѓєNginxзЪДWLCзЃЧж≥ХињЫи°МдЇЖдЉШеМЦпЉМжПРеЗЇдЇЖдЄАдЄ™иЗ™йАВеЇФеК®жАБиіЯиљљеЭЗи°°зЪДиЃЊиЃ°дЄОеЃЮзО∞жЦєж°ИгАВ иѓ•жЦєж°ИзЪДж†ЄењГжШѓж†єжНЃеРОзЂѓжЬНеК°еЩ®зЪДеЃЮжЧґињРи°МзКґжАБеС®жЬЯжАІеЬ∞иѓїеПЦеРДй°єеПВжХ∞пЉМе¶ВCPUеИ©зФ®зОЗгАБеЖЕе≠ШеН†зФ®зОЗгАБеУНеЇФжЧґйЧіз≠ЙпЉМињЩдЇЫеПВжХ∞...

жЬђжЦЗе∞Жиѓ¶зїЖдїЛзїНеЯЇдЇОDPDKзЪДеКЯиГљиіЯиљљеЭЗи°°еЩ®зЪДеЃЮзО∞пЉМжОҐиЃ®еЕґиЃЊиЃ°зРЖењµгАБжЮґжЮДиЃЊиЃ°гАБеЃЮзО∞зїЖиКВеТМжАІиГљдЉШеМЦз≠ЦзХ•гАВ иЃЊиЃ°зРЖењµ иіЯиљљеЭЗи°°еЩ®жШѓжХ∞жНЃдЄ≠ењГеТМдЇСиЃ°зЃЧзОѓеҐГдЄ≠зЪДдЄАзІНеЕ≥йФЃзїДдїґпЉМиіЯиі£е∞ЖincomingжµБйЗПеИЖйЕНеИ∞е§ЪдЄ™жЬНеК°еЩ®пЉМдї•з°ЃдњЭ...

еЕґдЄ∞еѓМзЪДз≠ЦзХ•йАЙй°єеТМеБ•еЇЈж£АжЯ•жЬЇеИґз°ЃдњЭдЇЖжЬНеК°иі®йЗПпЉМиАМе§Ъе±ВиіЯиљљеЭЗи°°еТМйЂШеПѓзФ®жАІиЃЊиЃ°еИЩињЫдЄАж≠•еҐЮеЉЇдЇЖзљСзїЬжЮґжЮДзЪДеПѓйЭ†жАІгАВзРЖиІ£еєґж≠£з°ЃеЃЮжЦљињЩдЇЫеЈ•дљЬеОЯзРЖпЉМеѓєдЇОжЮДеїЇеТМзїіжК§йЂШжАІиГљгАБйЂШеПѓзФ®зЪДзљСзїЬзОѓеҐГиЗ≥еЕ≥йЗНи¶БгАВ

4. иіЯиљљеЭЗи°°зЪДйЕНзљЃдЄОзЫСжОІпЉЪи¶Бз°ЃдњЭиіЯиљљеЭЗи°°ж≠£еЄЄеЈ•дљЬпЉМйЬАи¶БеЃЪжЬЯеѓєйЕНзљЃињЫи°Мж£АжЯ•еТМжЫіжЦ∞пЉМеРМжЧґињЫи°МжАІиГљзЫСжОІеТМжµБйЗПеИЖжЮРпЉМеПКжЧґеПСзО∞еєґиІ£еЖ≥еПѓиГље≠ШеЬ®зЪДйЧЃйҐШгАВ 5. еЃЙеЕ®жАІпЉЪиіЯиљљеЭЗи°°еЩ®йЬАи¶БиЃЊзљЃйАВељУзЪДеЃЙеЕ®з≠ЦзХ•пЉМе¶ВDDoSжФїеЗїйШ≤жК§гАБ...