жСШи¶БпЉЪ¬†##зЃАдїЛ еЬ®ељУдїКдЇТиБФзљСеЇФзФ®дЄ≠пЉМзЉУе≠ШдљЬдЄЇдЄАжККе∞ЦеИАеИ©еЩ®еѓєеЇФзФ®зЪДжАІиГљиµЈзЭАдЄЊиґ≥иљїйЗНзЪДдљЬзФ®гАВзЉУе≠ШзЪДдљњзФ®еПѓдї•иѓіжЧ†е§ДдЄНеЬ®пЉМдїОеЇФзФ®иѓЈж±ВзЪДиЃњйЧЃиЈѓеЊДжЭ•зЬЛпЉМзФ®жИЈuser -> жµПиІИеЩ®зЉУе≠Ш -> еПНеРСдї£зРЖзЉУе≠Ш-> WEBжЬНеК°еЩ®зЉУе≠Ш -> еЇФзФ®з®ЛеЇПзЉУе≠Ш -> жХ∞жНЃеЇУзЉУе≠Шз≠ЙпЉМеЗ†дєОжѓПжЭ°йУЊиЈѓйГљеЕЕжЦ•зЭАзЉУе≠ШзЪДдљњзФ®пЉМељУзДґдЇ§жНҐжЬЇпЉМзљСзїЬйАВйЕНеЩ®пЉМз°ђзЫШдЄКдєЯжЬЙCache дљЖињЩдЄНжШѓжИСдїђи¶БиЃ®иЃЇзЪДиМГеЫігАВдїК姩жИСдїђиЃ®иЃЇзЪДвАЬзЉУе≠ШвАЭпЉМиЗ™зДґе∞±жШѓвАЬзФ®з©ЇйЧіжНҐжЧґйЧі

зЃАдїЛ

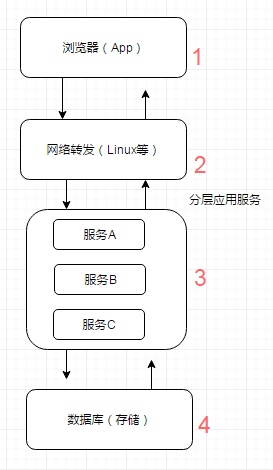

еЬ®ељУдїКдЇТиБФзљСеЇФзФ®дЄ≠пЉМзЉУе≠ШдљЬдЄЇдЄАжККе∞ЦеИАеИ©еЩ®еѓєеЇФзФ®зЪДжАІиГљиµЈзЭАдЄЊиґ≥иљїйЗНзЪДдљЬзФ®гАВзЉУе≠ШзЪДдљњзФ®еПѓдї•иѓіжЧ†е§ДдЄНеЬ®пЉМдїОеЇФзФ®иѓЈж±ВзЪДиЃњйЧЃиЈѓеЊДжЭ•зЬЛпЉМзФ®жИЈuser -> жµПиІИеЩ®зЉУе≠Ш -> еПНеРСдї£зРЖзЉУе≠Ш-> WEBжЬНеК°еЩ®зЉУе≠Ш -> еЇФзФ®з®ЛеЇПзЉУе≠Ш -> жХ∞жНЃеЇУзЉУе≠Шз≠ЙпЉМеЗ†дєОжѓПжЭ°йУЊиЈѓйГљеЕЕжЦ•зЭАзЉУе≠ШзЪДдљњзФ®пЉМељУзДґдЇ§жНҐжЬЇпЉМзљСзїЬйАВйЕНеЩ®пЉМз°ђзЫШдЄКдєЯжЬЙCache дљЖињЩдЄНжШѓжИСдїђи¶БиЃ®иЃЇзЪДиМГеЫігАВдїК姩жИСдїђиЃ®иЃЇзЪДвАЬзЉУе≠ШвАЭпЉМиЗ™зДґе∞±жШѓвАЬзФ®з©ЇйЧіжНҐжЧґйЧівАЭзЪДзЃЧж≥ХгАВзЉУе≠Ше∞±жШѓжККдЄАдЇЫжХ∞жНЃжЪВжЧґе≠ШжФЊдЇОжЯРдЇЫеЬ∞жЦєпЉМеПѓиГљжШѓеЖЕе≠ШпЉМдєЯжЬЙеПѓиГљз°ђзЫШгАВжАїдєЛпЉМзЫЃзЪДе∞±жШѓдЄЇдЇЖйБњеЕНжЯРдЇЫиАЧжЧґзЪДжУНдљЬгАВжИСдїђеЄЄиІБзЪДиАЧжЧґзЪДжУНдљЬпЉМжѓФе¶ВжХ∞жНЃеЇУзЪДжߕ胥гАБдЄАдЇЫжХ∞жНЃзЪДиЃ°зЃЧзїУжЮЬпЉМжИЦиАЕжШѓдЄЇдЇЖеЗПиљїжЬНеК°еЩ®зЪДеОЛеКЫгАВеЕґеЃЮеЗПиљїеОЛеКЫдєЯжШѓеЫ†жߕ胥жИЦиЃ°зЃЧпЉМиЩљзДґзЯ≠иАЧжЧґпЉМдљЖжУНдљЬеЊИйҐСзєБпЉМзіѓеК†иµЈжЭ•дєЯеЊИйХњпЉМйА†жИРдЄ•йЗНжОТйШЯз≠ЙжГЕеЖµпЉМжЬНеК°еЩ®жКЧдЄНдљПгАВ

зЉУе≠ШдїЛиі®

иЩљзДґдїОз°ђдїґдїЛиі®дЄКжЭ•зЬЛпЉМжЧ†йЭЮе∞±жШѓеЖЕе≠ШеТМз°ђзЫШдЄ§зІНпЉМдљЖдїОжКАжЬѓдЄКпЉМеПѓдї•еИЖжИРеЖЕе≠ШгАБз°ђзЫШжЦЗдїґгАБжХ∞жНЃеЇУгАВ

- еЖЕе≠Ш е∞ЖзЉУе≠Ше≠ШеВ®дЇОеЖЕе≠ШдЄ≠жШѓжЬАењЂзЪДйАЙжЛ©пЉМжЧ†йЬАйҐЭе§ЦзЪДI/OеЉАйФАпЉМдљЖжШѓеЖЕе≠ШзЪДзЉЇзВєжШѓж≤°жЬЙжМБдєЕеМЦиРљеЬ∞зЙ©зРЖз£БзЫШпЉМдЄАжЧ¶еЇФзФ®еЉВеЄЄbreak downиАМйЗНжЦ∞еРѓеК®пЉМжХ∞жНЃеЊИйЪЊжИЦиАЕжЧ†ж≥Хе§НеОЯгАВ

- з°ђзЫШ дЄАиИђжЭ•иѓіпЉМеЊИе§ЪзЉУе≠Шж°ЖжЮґдЉЪзїУеРИдљњзФ®еЖЕе≠ШеТМз°ђзЫШпЉМеЬ®еЖЕе≠ШеИЖйЕНз©ЇйЧіжї°дЇЖжИЦжШѓеЬ®еЉВеЄЄзЪДжГЕеЖµдЄЛпЉМеσ俕襀еК®жИЦдЄїеК®зЪДе∞ЖеЖЕе≠Шз©ЇйЧіжХ∞жНЃжМБдєЕеМЦеИ∞з°ђзЫШдЄ≠пЉМиЊЊеИ∞йЗКжФЊз©ЇйЧіжИЦе§ЗдїљжХ∞жНЃзЪДзЫЃзЪДгАВ

- жХ∞жНЃеЇУ еЙНйЭҐжЬЙжПРеИ∞пЉМеҐЮеК†зЉУе≠ШзЪДз≠ЦзХ•зЪДзЫЃзЪДдєЛдЄАе∞±жШѓдЄЇдЇЖеЗПе∞СжХ∞жНЃеЇУзЪДI/OеОЛеКЫгАВињЩйЗМжЙАжМЗзЪДжХ∞жНЃеЇУеП™жШѓзЃАеНХзЪДkey-valueе≠ШеВ®зїУжЮДзЪДзЙєжЃКNOSQLжХ∞жНЃеЇУпЉИе¶ВBerkeleyDBеТМRedisпЉЙпЉМеУНеЇФйАЯеЇ¶еТМеРЮеРРйЗПйГљињЬињЬйЂШдЇОжИСдїђеЄЄзФ®зЪДеЕ≥з≥їеЮЛжХ∞жНЃеЇУз≠ЙгАВ

зЉУе≠ШеСљдЄ≠зОЗ

зЉУе≠ШеСљдЄ≠зОЗйАЪеЄЄжМЗзЪДжШѓзЉУе≠Шжߕ胥еСљдЄ≠жАїжХ∞дЄОзЉУе≠Шжߕ胥жАїжХ∞зЪДжѓФзОЗпЉМеЇФзФ®зЉУе≠ШеСљдЄ≠зОЗиґКйЂШиґКе•љпЉМињЩжШѓи°°йЗПзЉУе≠ШдљњзФ®жШѓеР¶иЙѓе•љзЪДйЗНи¶БжМЗж†ЗгАВ

зЉУе≠ШеЫЮжФґз≠ЦзХ•

зЉУе≠ШзЪДеЫЮжФґз≠ЦзХ•еЬ®еИЖеЄГеЉПзЉУе≠ШдЄ≠з±їеЮЛдЄїи¶БжЬЙе¶ВдЄЛеЗ†зІН

1. еЯЇдЇОжЧґйЧі

TTL:е≠ШжіїжЬЯпЉМдЄАжЭ°зЉУе≠ШиЗ™еИЫеїЇжЧґйЧіиµЈе§ЪдєЕеРО姱жХИ

TTI:з©ЇйЧ≤жЬЯпЉМдЄАжЭ°зЉУе≠ШиЗ™жЬАеРОиѓїеПЦжИЦжЫіжЦ∞иµЈе§ЪдєЕеРО姱жХИ

2. еЯЇдЇОз©ЇйЧі

йАЪеЄЄжМЗзЪДжШѓиЃЊзљЃе≠ШеВ®з©ЇйЧіе§Іе∞ПпЉМжѓФе¶ВTAIRзФ≥иѓЈжЧґз©ЇйЧіе§Іе∞ПпЉМиґЕињЗињЩдЄ™йШИеАЉеРОпЉМдЉЪжМЙзЕІдЄАеЃЪзЪДз≠ЦзХ•зЃЧж≥ХзІїйЩ§жХ∞жНЃгАВ

3. еЯЇдЇОеЃєйЗП

йАЪеЄЄжМЗзЪДжШѓиЃЊзљЃзЉУе≠ШжЭ°зЫЃжХ∞йЗПе§Іе∞ПпЉМиґЕињЗињЩдЄ™йШИеАЉеРОпЉМдЉЪжМЙзЕІдЄАеЃЪзЪДз≠ЦзХ•зЃЧж≥ХзІїйЩ§жХ∞жНЃгАВ

зЉУе≠Шз≥їзїЯзЪДжХідљУеЫЮжФґй¶ЦеЕИж†єжНЃжЧґйЧіињЫи°МзІїйЩ§ињЗжЬЯжХ∞жНЃпЉМе¶ВжЮЬиґЕињЗз©ЇйЧіжИЦиАЕеЃєйЗПиЃЊзљЃзЪДйШИеАЉпЉМдЉЪж†єжНЃзЫЄеЇФзЪДзЃЧж≥ХзІїйЩ§жХ∞жНЃ,зІїйЩ§жХ∞жНЃзЪДзЃЧж≥ХдЄїи¶БжЬЙLRUгАБFIFOгАБLFUпЉМжЬАеЄЄзФ®зЪДзЃЧж≥ХжШѓLRUпЉМеИЖеЄГеЉПзЉУе≠ШmemcachedгАБredisдї•еПКtairйГљжФѓжМБиѓ•зЃЧж≥ХпЉМжЬђеЬ∞зЉУе≠Шguava cacheгАБehcacheдєЯеРМж†ЈжФѓжМБLRUзЃЧж≥ХгАВ

жХ∞жНЃжЈШж±∞зЃЧж≥ХзЃАи¶БдїЛзїНпЉЪ

-

FIFO(first in first out)

еЕИињЫеЕИеЗЇз≠ЦзХ•пЉМжЬАеЕИињЫеЕ•зЉУе≠ШзЪДжХ∞жНЃеЬ®зЉУе≠Шз©ЇйЧідЄНе§ЯзЪДжГЕеЖµдЄЛпЉИиґЕеЗЇжЬАе§ІеЕГзі†йЩРеИґпЉЙдЉЪ襀дЉШеЕИ襀жЄЕйЩ§жОЙпЉМдї•иЕЊеЗЇжЦ∞зЪДз©ЇйЧіжО•еПЧжЦ∞зЪДжХ∞жНЃгАВз≠ЦзХ•зЃЧж≥ХдЄїи¶БжѓФиЊГзЉУе≠ШеЕГзі†зЪДеИЫеїЇжЧґйЧігАВеЬ®жХ∞жНЃеЃЮжХИжАІи¶Бж±ВеЬЇжЩѓдЄЛеПѓйАЙжЛ©иѓ•з±їз≠ЦзХ•пЉМдЉШеЕИдњЭйЪЬжЬАжЦ∞жХ∞жНЃеПѓзФ®гАВ -

LFU(less frequently used)

жЬАе∞СдљњзФ®з≠ЦзХ•пЉМжЧ†иЃЇжШѓеР¶ињЗжЬЯпЉМж†єжНЃеЕГзі†зЪД襀䚜зФ®жђ°жХ∞еИ§жЦ≠пЉМжЄЕйЩ§дљњзФ®жђ°жХ∞иЊГе∞СзЪДеЕГзі†йЗКжФЊз©ЇйЧігАВз≠ЦзХ•зЃЧж≥ХдЄїи¶БжѓФиЊГеЕГзі†зЪДhitCountпЉИеСљдЄ≠жђ°жХ∞пЉЙгАВеЬ®дњЭиѓБйЂШйҐСжХ∞жНЃжЬЙжХИжАІеЬЇжЩѓдЄЛпЉМеПѓйАЙжЛ©ињЩз±їз≠ЦзХ•гАВ -

LRU(least recently used)

жЬАињСжЬАе∞СдљњзФ®з≠ЦзХ•пЉМжЧ†иЃЇжШѓеР¶ињЗжЬЯпЉМж†єжНЃеЕГзі†жЬАеРОдЄА搰襀䚜зФ®зЪДжЧґйЧіжИ≥пЉМжЄЕйЩ§жЬАињЬдљњзФ®жЧґйЧіжИ≥зЪДеЕГзі†йЗКжФЊз©ЇйЧігАВз≠ЦзХ•зЃЧж≥ХдЄїи¶БжѓФиЊГеЕГзі†жЬАињСдЄА搰襀getдљњзФ®жЧґйЧігАВеЬ®зГ≠зВєжХ∞жНЃеЬЇжЩѓдЄЛиЊГйАВзФ®пЉМдЉШеЕИдњЭиѓБзГ≠зВєжХ∞жНЃзЪДжЬЙжХИжАІгАВ

зЉУе≠ШдљњзФ®еЬЇжЩѓдЄОеИЖз±ї

дљњзФ®зЉУе≠ШзЪДзЫЃзЪДжПРйЂШз≥їзїЯзЪДжХідљУжАІиГљпЉМзЉУе≠ШзЪДеЈ•дљЬжЬЇеИґжШѓеЕИдїОзЉУе≠ШдЄ≠иѓїеПЦжХ∞жНЃпЉМе¶ВжЮЬж≤°жЬЙпЉМеИЩеЖНдїОжЕҐйАЯиЃЊе§ЗдЄКиѓїеПЦеЃЮйЩЕжХ∞жНЃеєґеРМж≠•еИ∞зЉУе≠ШгАВйВ£дЇЫзїПеЄЄжߕ胥зЪДжХ∞жНЃгАБйҐСзєБиЃњйЧЃзЪДжХ∞жНЃгАБзГ≠зВєжХ∞жНЃгАБIOзУґйҐИжХ∞жНЃгАБиЃ°зЃЧжШВиіµзЪДжХ∞жНЃгАБзђ¶еРИдЇФеИЖйТЯж≥ХеИЩеТМе±АйГ®жАІеОЯзРЖзЪДжХ∞жНЃйГљеПѓдї•ињЫи°МзЉУе≠ШгАВ

еЬ®дЇТиБФзљСеЇФзФ®дЄ≠еЄЄиІБзЪДзЉУе≠ШзЪДеЬЇжЩѓдЄїи¶БпЉЪ

- жХ∞жНЃеЇУзЉУе≠ШпЉЪ йЪПзЭАдЄЪеК°йЗПзЪДдЄКеНЗпЉМжХ∞жНЃеЇУе≠ШеВ®зЪДжХ∞жНЃйЗПиґКжЭ•иґКе§ІпЉМеєґеПСиѓЈж±ВйАРжЄРеҐЮе§ІпЉМйЪПдєЛиАМжЭ•зЪДйЧЃйҐШе∞±жШѓжХ∞жНЃеЇУз≥їзїЯзЪДиіЯиљљеНЗйЂШпЉМеУНеЇФеїґињЯдЄЛйЩНпЉМдЄ•йЗНзЪДжЧґеАЩпЉМзФЪиЗ≥жЬЙеПѓиГљеЫ†ж≠§иАМеѓЉиЗіжЬНеК°дЄ≠жЦ≠пЉМињЩжЧґеРѓзФ®зЉУе≠ШеИ©еЩ®еПѓдї•жПРйЂШз≥їзїЯжАІиГљгАВ

- дЄіжЧґжХ∞жНЃе≠ШеВ®пЉЪ еЇФзФ®з®ЛеЇПйЬАи¶БзїіжК§е§ІйЗПдЄіжЧґжХ∞жНЃпЉМдЊЛе¶ВиЃ°жХ∞еЩ®гАБеИЖеЄГеЉПйФБгАБзФ®жИЈsessionз≠ЙпЉМе∞ЖдЄіжЧґжХ∞жНЃе≠ШеВ®еЬ®еИЖеЄГеЉПзЉУе≠ШдЄ≠пЉМеПѓдї•йЩНдљОеЖЕе≠ШзЃ°зРЖзЪДеЉАйФАпЉМжФєињЫеЇФзФ®з®ЛеЇПеЈ•дљЬиіЯиљљгАВ

еЬ®дЇТиБФзљСеЇФзФ®дЄ≠пЉМдїОеЇФзФ®дЄОзЉУе≠ШиА¶еРИеЇ¶иІТеЇ¶зЉУе≠ШдЄїи¶БеИЖдЄЇжЬђеЬ∞зЉУе≠ШгАБеИЖеЄГеЉПзЉУе≠ШдЄ§е§Із±їгАВ

-

жЬђеЬ∞зЉУе≠ШпЉЪжМЗзЪДжШѓеЬ®еЇФзФ®дЄ≠зЪДзЉУе≠ШзїДдїґпЉМеЕґжЬАе§ІзЪДдЉШзВєжШѓеЇФзФ®еТМcacheжШѓеЬ®еРМдЄАдЄ™ињЫз®ЛеЖЕйГ®пЉМиѓЈж±ВзЉУе≠ШйЭЮеЄЄењЂйАЯпЉМж≤°жЬЙињЗе§ЪзЪДзљСзїЬеЉАйФАз≠ЙпЉМеЬ®еНХеЇФзФ®дЄНйЬАи¶БйЫЖзЊ§жФѓжМБжИЦиАЕйЫЖзЊ§жГЕеЖµдЄЛеРДиКВзВєжЧ†йЬАдЇТзЫЄйАЪзЯ•зЪДеЬЇжЩѓдЄЛдљњзФ®жЬђеЬ∞зЉУе≠ШиЊГеРИйАВпЉЫеРМжЧґпЉМеЃГзЪДзЉЇзВєдєЯжШѓеЇФдЄЇзЉУе≠ШиЈЯеЇФзФ®з®ЛеЇПиА¶еРИпЉМе§ЪдЄ™еЇФзФ®з®ЛеЇПжЧ†ж≥ХзЫіжО•зЪДеЕ±дЇЂзЉУе≠ШпЉМеРДеЇФзФ®жИЦйЫЖзЊ§зЪДеРДиКВзВєйГљйЬАи¶БзїіжК§иЗ™еЈ±зЪДеНХзЛђзЉУе≠ШпЉМеѓєеЖЕе≠ШжШѓдЄАзІНжµ™иієгАВ

Guava CacheгАБEhcacheгАБMapDBйГљеПѓдї•еЃЮзО∞JAVAе†ЖеЖЕе≠ШжЬђеЬ∞зЉУе≠ШпЉМи∞Ие†ЖеЖЕе≠ШеЕґеЃЮJAVAињШжФѓжМБе†Же§ЦеЖЕе≠ШпЉМEhcache 3.xгАБMapDB 3.xдєЯеРМж†ЈжФѓжМБе†Же§ЦеЖЕе≠ШпЉМе†Же§ЦеЖЕе≠ШжДПеС≥зЭАжККеЖЕе≠Шеѓєи±°еИЖйЕНеЬ®JavaиЩЪжЛЯжЬЇзЪДе†Ждї•е§ЦзЪДеЖЕе≠ШпЉМињЩдЇЫеЖЕе≠ШзЫіжО•еПЧжУНдљЬз≥їзїЯзЃ°зРЖпЉИиАМдЄНжШѓиЩЪжЛЯжЬЇпЉЙпЉМNettyе∞±жШѓдљњзФ®е†Же§ЦеЖЕе≠ШжЭ•зЃ°зРЖеЖЕе≠ШпЉМеїЇиЃЃжЕОзФ®е†Же§ЦеЖЕе≠ШпЉМдљњзФ®дЄНељУеЃєжШУеѓЉиЗіOOMпЉМеЕ≥дЇОе†Же§ЦеЖЕе≠ШдЄОе†ЖеЖЕе≠ШжО•дЄЛжЭ•дЄНеБЪйЗНзВєдїЛзїНгАВ -

еИЖеЄГеЉПзЉУе≠ШпЉЪжМЗзЪДжШѓдЄОеЇФзФ®еИЖз¶їзЪДзЉУе≠ШзїДдїґжИЦжЬНеК°пЉМеЕґжЬАе§ІзЪДдЉШзВєжШѓиЗ™иЇЂе∞±жШѓдЄАдЄ™зЛђзЂЛзЪДеЇФзФ®пЉМдЄОжЬђеЬ∞еЇФзФ®йЪФз¶їпЉМе§ЪдЄ™еЇФзФ®еПѓзЫіжО•зЪДеЕ±дЇЂзЉУе≠ШпЉМеГПmemcachedгАБredisгАБtairйГљжШѓеИЖеЄГеЉПзЉУе≠ШгАВ

зЉУе≠ШдљњзФ®еЃЮиЈµ

зЉУе≠ШзЪДдљњзФ®дєЯжШѓиЃ≤з©ґдЄАеЃЪжКАеЈІжАІпЉМе¶ВжЮЬдљњзФ®дЄНељУдЉЪеѓЉиЗіжХ∞жНЃдЄАиЗіжАІйЧЃйҐШгАБзЉУе≠Ш襀穜йАПеѓЉиЗіеЇФзФ®йЫ™еі©з≠ЙгАВ

дЄКйЭҐиЃ≤еИ∞е±АйГ®жАІеОЯзРЖпЉМзЃАеНХдїЛзїНдЄЛдЄОзЉУе≠ШзЫЄеЕ≥зЪДе±АйГ®жАІеОЯзРЖпЉЪ

- жЧґйЧіе±АйГ®жАІпЉИtemporal localityпЉЙпЉЪжХ∞жНЃе∞Ж襀е§Ъжђ°иЃњйЧЃ

- з©ЇйЧіе±АйГ®жАІпЉИspatial localityпЉЙпЉЪйВїињСжХ∞жНЃе∞Ж襀聜йЧЃ

еЯЇдЇОе±АйГ®жАІеОЯзРЖпЉМзЉУе≠ШеЬ®иЃЊиЃ°дЄКйЬАи¶БиАГиЩСиЃЄе§ЪзЪДеЫ†зі†пЉЪ

- зЉУе≠ШеЕ≥иБФжАІпЉИcache associativityпЉЙ

- еЖЩз≠ЦзХ•пЉИwriting policyпЉЙ

- жЫњжНҐз≠ЦзХ•пЉИcache replacementпЉЙ

- зЉУе≠ШдЄАиЗіжАІпЉИcache coherencyпЉЙ

- cache姱жХИеПѓиГљеЉХеПСзЪДdog-pilingжХИеЇФпЉИcache stampedeпЉЙ

- .....

жО•дЄЛжЭ•е∞ЖдЉЪж†єжНЃдї•дЄКеЗ†зВєдїЛзїНзЉУе≠ШдљњзФ®зЪДдЄАдЇЫеЃЮиЈµгАВ

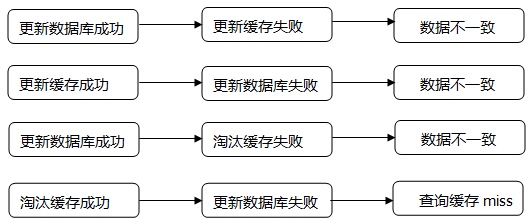

зЉУе≠ШдЄОDBжХ∞жНЃдЄАиЗіжАІ

жХ∞жНЃзЪДжЫіжЦ∞дЄОзЉУе≠ШеРМж≠•пЉМж≤°жЬЙйЂШзІСжКАеРЂйЗПпЉМдљЖи¶БеБЪе•љеєґдЄНеЃєжШУпЉМжЬЙдЇЫеЬЇжЩѓйЬАи¶БеБЪеИ∞еЃЮжЧґдЄАиЗіжАІпЉМжЬЙдЇЫеЬЇжЩѓйЬАи¶БеБЪеИ∞жЬАзїИдЄАиЗіжАІгАВ

е¶ВжЮЬи¶БеБЪеИ∞еЉЇдЄАиЗіжАІпЉМеПѓдї•йЗЗеПЦдї•дЄЛжЦєж°ИпЉЪ

-

жХ∞жНЃеЇУжЫіжЦ∞еРОпЉМеИ†йЩ§зЉУе≠ШгАВ

ињЩзІНжЦєеЉПзЪДдЉШзВєжШѓеЃЮзО∞зЃАеНХпЉМзЉЇзВєжШѓеИ†йЩ§зЉУе≠ШеРОпЉМе¶ВжЮЬжЬЙе§ЪдЄ™жߕ胥胣ж±ВеєґеПСињЗжЭ•пЉМйГљеПСзО∞зЉУе≠ШдЄ≠ж≤°жХ∞жНЃпЉМйГљдЉЪе∞ЖиѓЈж±ВиРљеИ∞жХ∞жНЃеЇУдЄКпЉМеѓЉиЗіжХ∞жНЃеЇУеОЛеКЫзЮђйЧіеҐЮеК†гАВ -

жХ∞жНЃеЇУжЫіжЦ∞еРОпЉМжЫіжЦ∞зЉУе≠ШгАВ

ињЩжШѓеѓєеИ†йЩ§жЦєеЉПзЪДжФєињЫпЉМдљЖдєЯжЬЙзЉЇзВєпЉМеЖЩеЕ•еЙНи¶Бе§ЪдЄАжђ°жߕ胥пЉМеЬ®йГ®еИЖеЬЇжЩѓдЄЛжШѓж≤°ж≥ХдљњзФ®зЪДпЉМжѓФе¶ВеИЖй°µжߕ胥еЬЇжЩѓпЉМеРДзІНиѓЈж±ВеПВжХ∞зїДеРИеЊИе§ЪпЉМеЇФзФ®жЧ†ж≥ХзЯ•йБУжЬЙе§Ъе∞СзІНkeyпЉМиЗ™зДґжЧ†ж≥ХдЄїеК®еЖЩеЕ•пЉМеП™иГљз≠ЙзЉУе≠Ш姱жХИгАВ

дї•дЄКдЄ§зІНеЃЮжЧґеРМж≠•зЉУе≠ШжЬЇеИґпЉМеЕИжУНдљЬжХ∞жНЃеЇУзДґеРОжУНдљЬзЉУе≠ШпЉМеЫ†еЉВжЮДжХ∞жНЃе≠ШеВ®жЧ†ж≥ХйАЪињЗдЇЛеК°дњЭиѓБдЄАиЗігАВељУзДґзЉУе≠ШжґЙеПКеИ∞зљСзїЬIOеЉАйФАпЉМе¶ВжЮЬињЮжО•еИЖеЄГеЉПзЉУе≠ШиґЕжЧґдєЯйЬАи¶БиАГиЩСпЉМеР¶еИЩдЉЪеЗЇзО∞дЇЛеК°иґЕжЧґпЉМеѓЉиЗіеЇФзФ®зЇњз®ЛжМВиµЈгАВ

е¶ВжЮЬи¶БеБЪеИ∞жЬАзїИдЄАиЗіжАІпЉМеПѓдї•йЗЗеПЦдї•дЄЛжЦєж°ИпЉЪ

- MQеЉВж≠•еИЈжЦ∞гАБеЃЪжЧґеИЈжЦ∞ йЗЗзФ®MQеЉВж≠•жґИжБѓжЬЇеИґеИЈжЦ∞пЉМе¶ВжЮЬжЫіжЦ∞姱賕и¶БжЬЙйАВељУзЪДи°•еБњжЬЇеИґгАВжЙАжЬЙйЬАи¶БжЫіжЦ∞зЪДеѓєи±°е≠ШеВ®еИ∞дЄАеЉ†еЃЪжЧґдїїеК°и°®пЉМеЃЪжЧґдїїеК°жЙЂжППдїїеК°и°®еЉВж≠•жЫіжЦ∞гАВињЩдЄ§зІНжЫіжЦ∞жЬЇеИґдЄНиГљдњЭиѓБжߕ胥зЉУе≠ШеРМDBзЪДдЄАиЗіжАІпЉМдљЖжШѓиГље§ЯдњЭиѓБжЬАзїИдЄАиЗіжАІгАВ

- иЗ™еʮ姱жХИ еРИзРЖиЃЊзљЃзЉУе≠Ш姱жХИжЧґйЧіпЉМйЬАж†єжНЃдЄЪеК°еЬЇжЩѓиЃЊзљЃжѓПдЄ™зЉУе≠ШзЪД姱жХИжЧґйЧіпЉМдЄАиЗіжАІи¶Бж±ВиґКйЂШпЉМиЗ™зĴ姱жХИжЧґйЧідєЯи¶БиґКзЯ≠гАВ

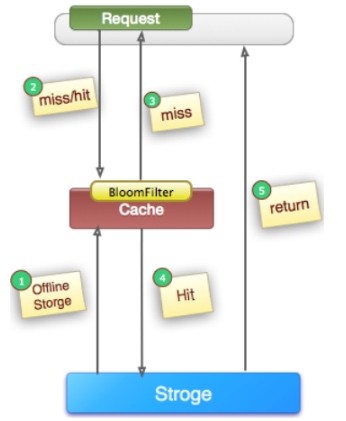

зЉУе≠ШеєґеПС

зЉУе≠ШињЗжЬЯеРОе∞Же∞ЭиѓХдїОеРОзЂѓжХ∞жНЃеЇУиОЈеПЦжХ∞жНЃпЉМињЩжШѓдЄАдЄ™зЬЛдЉЉеРИзРЖзЪДжµБз®ЛгАВдљЖжШѓпЉМеЬ®йЂШеєґеПСеЬЇжЩѓдЄЛпЉМжЬЙеПѓиГље§ЪдЄ™иѓЈж±ВеєґеПСзЪДеОїдїОжХ∞жНЃеЇУиОЈеПЦжХ∞жНЃпЉМеѓєеРОзЂѓжХ∞жНЃеЇУйА†жИРжЮБе§ІзЪДеЖ≤еЗїпЉМзФЪиЗ≥еѓЉиЗі вАЬйЫ™еі©вАЭзО∞и±°гАВж≠§е§ЦпЉМељУжЯРдЄ™зЉУе≠Шkeyеܮ襀жЫіжЦ∞жЧґпЉМеРМжЧґдєЯеПѓиÚ襀姲йЗПиѓЈж±ВеЬ®иОЈеПЦпЉМињЩдєЯдЉЪеѓЉиЗідЄАиЗіжАІзЪДйЧЃйҐШгАВйВ£е¶ВдљХйБњеЕНз±їдЉЉйЧЃйҐШеСҐпЉЯжИСдїђдЉЪжГ≥еИ∞з±їдЉЉ"йФБ"зЪДжЬЇеИґ(еПѓйЗНеЕ•йФБ)пЉМеЬ®зЉУе≠ШжЫіжЦ∞жИЦиАЕињЗжЬЯзЪДжГЕеЖµдЄЛпЉМеЕИе∞ЭиѓХиОЈеПЦеИ∞йФБпЉМељУжЫіжЦ∞жИЦиАЕдїОжХ∞жНЃеЇУиОЈеПЦеЃМжИРеРОеЖНйЗКжФЊйФБпЉМеЕґдїЦзЪДиѓЈж±ВеП™йЬАи¶БзЙЇзЙ≤дЄАеЃЪзЪДз≠ЙеЊЕжЧґйЧіпЉМеН≥еПѓзЫіжО•дїОзЉУе≠ШдЄ≠зїІзї≠иОЈеПЦжХ∞жНЃгАВ

зЉУе≠Ш襀穜йАП

еЬ®йЂШеєґеПСеЬЇжЩѓдЄЛпЉМе¶ВжЮЬжЯРдЄАдЄ™key襀йЂШеєґеПСиЃњйЧЃпЉМж≤°жЬЙ襀еСљдЄ≠пЉМеЗЇдЇОеѓєеЃєйФЩжАІиАГиЩСпЉМдЉЪе∞ЭиѓХеОїдїОеРОзЂѓжХ∞жНЃеЇУдЄ≠иОЈеПЦпЉМдїОиАМеѓЉиЗідЇЖе§ІйЗПиѓЈж±ВиЊЊеИ∞жХ∞жНЃеЇУпЉМиАМељУиѓ•keyеѓєеЇФзЪДжХ∞жНЃжЬђиЇЂе∞±жШѓз©ЇзЪДжГЕеЖµдЄЛпЉМињЩе∞±еѓЉиЗіжХ∞жНЃеЇУдЄ≠еєґеПСзЪДеОїжЙІи°МдЇЖеЊИе§ЪдЄНењЕи¶БзЪДжߕ胥жУНдљЬпЉМдїОиАМеѓЉиЗіеЈ®е§ІеЖ≤еЗїеТМеОЛеКЫгАВ

жИСдїђеЬ®еЇФзФ®дЄ≠дљњзФ®зЉУе≠ШзЪДжЧґеАЩпЉМеЊИеПѓиГље∞±жШѓдљњзФ®зЪДе¶ВдЄЛдї£з†БжЙАи°®з§ЇзЪДйАїиЊСзЪДжЦєеЉПгАВгААеЕИиОЈеПЦзЉУе≠ШдЄ≠зЪДжХ∞жНЃпЉМе¶ВжЮЬдЄЇз©ЇеИЩжߕ胥жХ∞жНЃеЇУжИЦиАЕеЕґдїЦжЦєеЉПиОЈеПЦжХ∞жНЃпЉМзДґеРОеЖНе≠ШеЕ•зЉУе≠ШпЉМињФеЫЮжХ∞жНЃпЉМе¶ВдЄЛдЉ™дї£з†БгАВ

data=cache.get(key);

if(data=null || !isValid(data)){

гААгААгААsql="SELECT ......";

data=db.query(sql);

гААгААгАА//dataеПѓиГљдЄЇnull

if(data пЉБ= null){

cache.set(key,data,expire);

}

}

return data;

зЫЄдњ°е§Іе§ЪжХ∞дЇЇдЉЪиЃ§дЄЇињЩжЃµдї£з†Бж≤°жЬЙйЧЃйҐШпЉМеЊИе§ЪдЇЇдєЯжШѓињЩдєИеОїеЖЩзЪДгАВ

йЧЃйҐШпЉЪ

ељУkeyзЪДеЖЕеЃєеЬ®жХ∞жНЃеЇУдєЯдЄНе≠ШеЬ®жЧґпЉМйВ£дєИдЄКйЭҐдї£з†БдЄ≠зЪДdataеІЛзїИдЄЇnullпЉМзЉУе≠ШдЄ≠дєЯеІЛзїИж≤°жЬЙжХ∞жНЃпЉМе¶ВжЮЬињЩдЄ™keyзЪДиѓЈж±Вз™БзДґеПШеЊЧеЊИе§ІпЉИеЊИе§ЪжГЕеЖµдЄЛйГљдЉЪеПСзФЯпЉМжѓФе¶Вжߕ胥胣ж±ВдЄНе≠ШеЬ®зЪДжХ∞жНЃпЉЙпЉМйВ£дєИе∞ЖдЉЪжЬЙе§ІйЗПзЪДиѓЈж±ВзїХињЗзЉУе≠ШпЉМзЫіжО•еИ∞дЇЖеРОзЂѓжХ∞жНЃеЇУпЉМеѓєжХ∞жНЃеЇУзЪДIOQPSйА†жИРињЗе§ІзЪДеЖ≤еЗїпЉМжЬАеРОеЊИеПѓиГљеѓЉиЗіз≥їзїЯеі©жЇГгАВ

иІ£еЖ≥жЦєж°ИпЉЪ

1. зЉУе≠Шз©Їеѓєи±°

иІ£еЖ≥ињЩдЄ™йЧЃйҐШзЪДеКЮж≥Хе∞±жШѓељУжХ∞жНЃеЇУжߕ胥еИ∞nullжЧґпЉМжИСдїђдєЯеЇФиѓ•жККnullињЫи°МзЫЄеЇФзЪДзЉУе≠ШгАВ

жѓФе¶ВжХ∞жНЃеЇУињФеЫЮзЪДжШѓдЄАдЄ™listпЉМйВ£дєИжИСдїђеПѓдї•е≠ШеЕ•дЄАдЄ™з©ЇзЪДlistжЭ•е§ДзРЖcache.set(key,new List(),expire)гАВ

еРМжЧґпЉМдєЯйЬАи¶БдњЭиѓБзЉУе≠ШжХ∞жНЃзЪДжЧґжХИжАІгАВињЩзІНжЦєеЉПеЃЮзО∞иµЈжЭ•жИРжЬђиЊГдљОпЉМжѓФиЊГйАВеРИеСљдЄ≠дЄНйЂШпЉМдљЖеПѓиÚ襀йҐСзєБжЫіжЦ∞зЪДжХ∞жНЃгАВ

2. еНХзЛђеБЪињЗжї§е§ДзРЖ

еѓєжЙАжЬЙеПѓиГљеѓєеЇФжХ∞жНЃдЄЇз©ЇзЪДkeyињЫи°МзїЯдЄАзЪДе≠ШжФЊпЉМеєґеЬ®иѓЈж±ВеЙНеБЪжЛ¶жИ™пЉМињЩж†ЈйБњеЕНиѓЈж±Вз©њйАПеИ∞еРОзЂѓжХ∞жНЃеЇУгАВињЩзІНжЦєеЉПеЃЮзО∞иµЈжЭ•зЫЄеѓєе§НжЭВпЉМжѓФиЊГйАВеРИеСљдЄ≠дЄНйЂШпЉМдљЖжШѓжЫіжЦ∞дЄНйҐСзєБзЪДжХ∞жНЃгАВ

жѓФиЊГеЄЄзФ®зЪДжЦєж°ИжШѓйАЪињЗBloom FilterжПРеЙНжЛ¶жИ™пЉМBloom FilterжШѓдЄАдЄ™з©ЇйЧіжХИзОЗеЊИйЂШзЪДйЪПжЬЇжХ∞жНЃзїУжЮДпЉМеЃГзФ±дЄАдЄ™дљНжХ∞зїДеТМдЄАзїДhashжШ†е∞ДеЗљжХ∞зїДжИРгАВBloom FilterеПѓдї•зФ®дЇОж£А糥дЄАдЄ™еЕГзі†жШѓеР¶еЬ®дЄАдЄ™йЫЖеРИдЄ≠пЉМеЃГзЪДдЉШзВєжШѓз©ЇйЧіжХИзОЗеТМжߕ胥жЧґйЧійГљињЬињЬиґЕињЗдЄАиИђзЪДзЃЧж≥ХпЉМзЉЇзВєжШѓжЬЙдЄАеЃЪзЪДиѓѓиѓЖеИЂзОЗгАВеЫ†ж≠§Bloom FilterдЄНйАВеРИйВ£дЇЫвАЬйЫґйФЩиѓѓвАЭзЪДеЇФзФ®еЬЇеРИгАВиАМеЬ®иГљеЃєењНдљОйФЩиѓѓзОЗзЪДеЇФзФ®еЬЇеРИдЄЛ,Bloom FilterйАЪињЗжЮБе∞СзЪДйФЩиѓѓжНҐеПЦдЇЖе≠ШеВ®з©ЇйЧізЪДжЮБе§ІиКВзЬБгАВ

еГПGuava CacheгАБGoogleзЪДbigtableйГљжЬЙз±їдЉЉbloomfilterеЃЮзО∞пЉМеЕ≥дЇОbloomfilterеЕЈдљУеПѓдї•еПВиАГпЉЪhttps://www.javacodegeeks.com/2012/11/bloom-filter-implementation-in-java-on-github.html

дї•дЄКдЄ§зІНжЦєж°ИеЭЗеПѓдї•дњЭйЪЬзЪДзЉУе≠Ш襀穜йАПйЧЃйҐШпЉМзђђдЄАзІНжЦєж°ИжЫізЃАеНХпЉМдљЖйЬАи¶БйҐЭе§ЦеН†дЄАдЇЫзЉУе≠Шз©ЇйЧігАВзђђдЇМзІНжЦєж°Ие§НжЭВдЄАдЇЫпЉМдљЖжШѓеН†зФ®зЉУе≠Шз©ЇйЧіе∞СгАВ

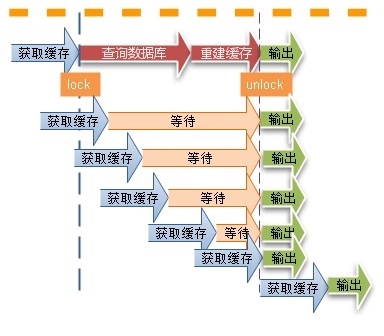

зГ≠зВєзЉУе≠Ш

жѓФе¶Вkey XXXеѓєеЇФзЪДжХ∞жНЃиЃњйЧЃйЗПзЙєеИЂе§ІпЉМдљЖжШѓXXXеЬ®зЉУе≠ШдЄ≠жШѓжЬЙ姱жХИжЧґйЧізЪДгАВдЄАжЧ¶зЉУе≠Ш姱жХИпЉМдЉЪжЬЙNе§ЪзЇњз®ЛеєґеПСзЪДеОїиѓЈж±ВжХ∞жНЃеЇУпЉМзДґеРОжЫіжЦ∞зЉУе≠ШпЉМињЩдЄ™жЧґеАЩдЉЪеѓЉиЗіз≥їзїЯеОЛеКЫињЗе§ІгАВйАЪеЄЄжЬЙињЩдєИеЗ†зІНиІ£еЖ≥жЦєж≥ХпЉЪ

1. еК†йФБпЉМеРМжЧґеП™еЕБиЃЄдЄАдЄ™зЇњз®ЛеОїжߕ胥жХ∞жНЃеЇУеєґжЫіжЦ∞зЉУе≠Ш

2. зЉУе≠ШдЄНеʆ姱жХИжЧґйЧіпЉМдљЖеРОеП∞жЬЙдЄ™еЉВж≠•зЇњз®ЛеЃЪжЬЯзЪДеОїжЫіжЦ∞еЃГ

3. еЉХеЕ•з±їдЉЉдЇОHystrixзЪДзЖФжЦ≠жЬЇеИґпЉМеП™еЕБиЃЄдЄАеЃЪйЗПзЪДиѓЈж±ВеОїиѓЈж±ВжХ∞жНЃеЇУеєґжЫіжЦ∞зЉУе≠Ш

жѓФе¶ВзЉУе≠ШдљњзФ®memcachedгАБredisпЉМеПѓдї•иАГиЩСе¶ВдЄКжЦєж°ИйТИеѓєзГ≠зВєжХ∞жНЃгАВе¶ВжЮЬдљњзФ®tairзЉУе≠ШзЪДиѓЭпЉМtairжПРдЊЫдЇЖhotkeyзЪДиІ£еЖ≥жЦєж°ИпЉМдЄїи¶БеОЯзРЖеЉАеРѓжЬђеЬ∞LocalCacheеКЯиГљпЉМжѓПжђ°еЖЩжУНдљЬдЉЪиЗ™еК®еЉЇеИґеИ†йЩ§ Localcache йЗМе≠ШеЬ®зЪД keyпЉМиѓїжУНдљЬеРОдЉЪиЗ™еК®дїО Localcache йЗМиѓїеПЦпЉМ Localcache дЄ≠дЄНе≠ШеЬ®еИЩдїОжЬНеК°зЂѓиОЈеПЦпЉМжИРеКЯеРОе≠ШеВ®еИ∞ Localcache йЗМгАВеЬ® Hotkey йШ≤еЊ°з≥їзїЯдЄ≠пЉМеЃҐжИЈзЂѓи¶БеЉАеРѓ hot-running ж®°еЉПпЉМиѓ•ж®°еЉПдЄЛеП™иГљзЉУе≠ШеЄ¶зГ≠зВєж†ЗиЃ∞зЪД keyпЉМLocalcache дЄ≠йЭЮзГ≠зВєзЪД key е∞ЖйАРж≠•иҐЂжЈШж±∞гАВеН≥дЄАжЧ¶еЉАеРѓеЃҐжИЈзЂѓзЪДиѓ•ж®°еЉПпЉМдЉЪеЉЇеИґжФєеПШ Localcache зЪДеЈ•дљЬж®°еЉПгАВ

жХ∞жНЃзЉУе≠Шж®°еЉПйАЪеЄЄжЬЙжЗТеК†иљљеТМйҐДеК†иљљдЄ§зІНж®°еЉПпЉМдљЖжШѓеѓєдЇОзГ≠зВєзЉУе≠ШжЬАе•љйЗЗеПЦйҐДеК†иљљж®°еЉПпЉМзђФиАЕжЫЊзїПйБЗеИ∞еЇФзФ®з≥їзїЯеИЪеПСеЄГеЃМе∞±зЫіжО•жМВжОЙзЪДж°ИдЊЛпЉМдЄАдЇЫзГ≠зВєжХ∞жНЃжߕ胥еЬ®йЂШеєґеПСеЬЇжЩѓдЄЛињШж≤°жЬЙеК†иљљињЫжЭ•пЉМиѓЈж±ВжµБйЗПе∞±жґМеЕ•ињЫжЭ•гАВ

зЉУе≠Ше§Іеѓєи±°

жЯРдЇЫеЬЇжЩѓдЄЛжИСдїђжГ≥и¶БжККдЄАдЇЫе§Іеѓєи±°зЉУе≠ШиµЈжЭ•пЉМеЫ†дЄЇдЇІзФЯдЄАжђ°е§Іеѓєи±°зЪДдї£дїЈеЊИе§ІпЉМжИСдїђйЬАи¶БдЇІзФЯдЄАжђ°пЉМе∞љеПѓиГљзЪДе§Ъжђ°дљњзФ®пЉМдїОиАМжПРеНЗQPSгАВ

йАЪеЄЄзЪДиІ£еЖ≥жЦєж°ИжШѓеѓєжХ∞жНЃињЫи°МеОЛзЉ©пЉМеОЛзЉ©еПѓдї•еЬ®еЃҐжИЈзЂѓињЫи°МеОЛзЉ©пЉМзЉУе≠ШжЬНеК°зЂѓдєЯеПѓдї•еОЛзЉ©пЉМеГПmemcachedзЪДиѓЭйЬАи¶БеЬ®еЃҐжИЈзЂѓињЫи°МеОЛзЉ©пЉМеПѓдї•йЗЗзФ®gzipеОЛзЉ©зЃЧж≥ХињЫи°МеОЛзЉ©пЉМеГПtairзЪДиѓЭе¶ВжЮЬvalueиґЕињЗдЄАеЃЪзЪДйШИеАЉжЬНеК°зЂѓдЉЪиЗ™еК®еѓєvalueињЫи°МеОЛзЉ©гАВ

зЫЄеЕ≥жО®иНР

дЇТиБФзљСзЉУе≠ШеЃЮиЈµжШѓдЇТиБФзљСжЬНеК°жПРдЊЫиАЕзФ®жЭ•жПРеНЗзФ®жИЈдљУй™МгАБйЩНдљОжЬНеК°еЩ®еОЛеКЫеТМеЗПе∞СзљСзїЬеЄ¶еЃљжґИиАЧзЪДйЗНи¶БжКАжЬѓгАВеЃГйАЪињЗеЬ®зФ®жИЈжЬђеЬ∞жИЦйЭ†ињСзФ®жИЈзЪДиЊєзЉШиКВзВєе≠ШеВ®еЄЄзФ®жХ∞жНЃпЉМдљњеЊЧжХ∞жНЃиЃњйЧЃйАЯеЇ¶е§Іе§ІжПРйЂШпЉМеїґињЯеЗПе∞СпЉМе∞§еЕґеѓєдЇОйЂШжµБйЗПзЪДзљСй°µ...

### жґИйЩ§зЯ•иѓЖзЫ≤еМЇпЉЪдЇТиБФзљСзЉУе≠ШжЮґжЮДдїОзРЖиЃЇеИ∞еЃЮиЈµ #### дЄАгАБеЉХи®А йЪПзЭАдЇТиБФзљСжКАжЬѓзЪДењЂйАЯеПСе±ХпЉМзФ®жИЈеѓєдЇОжХ∞жНЃиЃњйЧЃйАЯеЇ¶зЪДи¶Бж±ВиґКжЭ•иґКйЂШгАВдЄЇдЇЖжПРйЂШзљСзЂЩеУНеЇФйАЯеЇ¶еТМзФ®жИЈдљУй™МпЉМеЗПе∞СжХ∞жНЃеЇУеОЛеКЫпЉМзЉУе≠ШжКАжЬѓжИРдЄЇдЇЖдЄНеПѓжИЦзЉЇзЪДдЄАйГ®еИЖ...

еИЖеЄГеЉПе§ЪзЇІзЉУе≠ШеЃЮиЈµжШѓдЄАзІНдЉШеМЦйЂШеєґеПСзОѓеҐГдЄЛжХ∞жНЃиЃњйЧЃжАІиГљзЪДйЗНи¶БжКАжЬѓгАВеЬ®зО∞дї£дЇТиБФзљСеЇФзФ®дЄ≠пЉМйЪПзЭАзФ®жИЈжХ∞йЗПзЪДеҐЮйХњеТМжХ∞жНЃйЗПзЪДиЖ®иГАпЉМеНХзЇѓдЊЭиµЦжХ∞жНЃеЇУињЫи°МеЃЮжЧґиѓїеЖЩжУНдљЬеЊАеЊАдЉЪеѓЉиЗіжАІиГљзУґйҐИгАВдЄЇдЇЖиІ£еЖ≥ињЩдЄ™йЧЃйҐШпЉМеИЖеЄГеЉПе§ЪзЇІзЉУе≠Ш...

1. **дЇСиЃ°зЃЧеИЖеЄГеЉПзЉУе≠ШеПКеЇФзФ®еЃЮиЈµ**пЉЪжЬђжЦЗдїґжОҐиЃ®зЪДжШѓдЇСиЃ°зЃЧжКАжЬѓдЄ≠зЪДеИЖеЄГеЉПзЉУе≠ШжКАжЬѓеПКеЕґеЬ®еЃЮйЩЕеЇФзФ®дЄ≠зЪДж°ИдЊЛеТМеЃЮжЦљжЦєж≥ХгАВеИЖеЄГеЉПзЉУе≠ШдљЬдЄЇдЄАзІНе≠ШеВ®жКАжЬѓпЉМеЕБиЃЄжХ∞жНЃеЬ®е§ЪдЄ™иКВзВєйЧіеИЖеЄГе≠ШеВ®пЉМжПРйЂШдЇЖжХ∞жНЃе≠ШеПЦзЪДеєґеПСжАІиГљпЉМеєґиГљ...

еЬ®вАЬзљСзїЬеЇФзФ®з®ЛеЇПеЃЮиЈµвАЭињЩдЄАдЄїйҐШдЄ≠пЉМжИСдїђдЄїи¶БжОҐиЃ®зЪДжШѓе¶ВдљХиЃЊиЃ°гАБеЉАеПСдї•еПКдЉШеМЦзљСзїЬеЇФзФ®з®ЛеЇПпЉМдї•дЊњеЬ®дЇТиБФзљСдЄКйЂШжХИињРи°МгАВдЄЬеМЧе§Іе≠¶зЪДињЩдЄ™еЃЮиЈµиѓЊз®ЛжЧ®еЬ®еЄЃеК©е≠¶зФЯжОМжП°зљСзїЬзЉЦз®ЛзЪДеЯЇз°АзЯ•иѓЖпЉМзРЖиІ£зљСзїЬйАЪдњ°еНПиЃЃпЉМеєґиГљеЃЮйЩЕеК®жЙЛ...

жЬђиµДжЇР"AndroidдЇТиБФзљСеЇФзФ®еЉАеПСеЃЮиЈµ--дї£з†Б.zip"жШЊзДґжШѓдЄАдїљжХЩе≠¶иµДжЦЩпЉМжЧ®еЬ®еЄЃеК©еЉАеПСиАЕжОМжП°е¶ВдљХеЬ®AndroidзОѓеҐГдЄ≠жЮДеїЇдЄОдЇТиБФзљСдЇ§дЇТзЪДеЇФзФ®гАВдЄЛйЭҐе∞Жиѓ¶зїЖжОҐиЃ®зЫЄеЕ≥зЯ•иѓЖзВєгАВ 1. **AndroidзљСзїЬиѓЈж±В**пЉЪAndroidеЇФзФ®еПѓдї•йАЪињЗе§ЪзІН...

### дЇТиБФзљСеЇФзФ®жЮґжЮДж®°еЉП еЬ®ељУдїКзЪДдњ°жБѓжЧґдї£пЉМйЪПзЭАдЇТиБФзљСжКАжЬѓзЪДй£ЮйАЯеПСе±ХпЉМеРДзІНе§НжЭВзЪДдЇТиБФзљСеЇФзФ®дЄНжЦ≠жґМзО∞гАВињЩдЇЫеЇФзФ®дЄНдїЕйЬАи¶БйЂШжХИз®≥еЃЪеЬ∞ињРи°МпЉМињШи¶БеЕЈе§ЗиЙѓе•љзЪДжЙ©е±ХжАІеТМеПѓзїіжК§жАІгАВеЫ†ж≠§пЉМйАЙжЛ©еРИйАВзЪДжЮґжЮДж®°еЉПеѓєдЇОжЮДеїЇйЂШиі®йЗП...

"йУґи°МдЇТиБФзљСж†ЄењГдЇСеОЯзФЯжХ∞жНЃеЇУеЇФзФ®дЄОеЃЮиЈµ" жЬђжЦЗж°£дЄїи¶БдїЛзїНдЇЖйУґи°МдЇТиБФзљСж†ЄењГдЇСеОЯзФЯжХ∞жНЃеЇУзЪДеЇФзФ®еТМеЃЮиЈµпЉМжґµзЫЦдЇЖдЇСеОЯзФЯжХ∞жНЃеЇУзЪДеИЖз±їгАБзЙєзВєгАБеЇФзФ®еЬЇжЩѓгАБжКАжЬѓи¶Бж±ВгАБжЮґжЮДиІДеИТгАБеЇФзФ®еЉАеПСиІДиМГгАБеЃєзБЊдљУз≥їеїЇиЃЊз≠ЙжЦєйЭҐзЪДзЯ•иѓЖзВєгАВ...

**дЇТиБФзљСеЇФзФ®еЉАеПСзїЉеРИеЃЮиЈµжК•еСК** жЬђеЃЮиЈµжК•еСКиѓ¶зїЖиЃ∞ељХдЇЖйТИеѓєвАЬжЬЇжҐ∞еЈ•дЄЪеУБзФµе≠РеХЖеЯОвАЭзЪДеЉАеПСињЗз®ЛпЉМжґµзЫЦдЇЖй°єзЫЃдїОйЬАж±ВеИЖжЮРеИ∞з≥їзїЯиЃЊиЃ°зЪДеРДдЄ™зОѓиКВгАВдї•дЄЛжШѓеЕ≥йФЃзЯ•иѓЖзВєзЪДжЈ±еЕ•иІ£жЮРпЉЪ ### 1. й°єзЫЃзЃАдїЛ жЬЇжҐ∞еЈ•дЄЪеУБзФµе≠РеХЖеЯОжШѓ...

### зІїеК®дЇТиБФзљСеЇФзФ®еЉАеПСжХЩе≠¶е§ІзЇ≤зЯ•иѓЖзВєиІ£жЮР #### дЄАгАБиѓЊз®ЛеЯЇжЬђдњ°жБѓ - **иѓЊз®ЛеРНзІ∞**пЉЪзІїеК®дЇТиБФзљСеЇФзФ®еЉАеПС - **е≠¶еИЖеПКе≠¶жЧґ**пЉЪ2е≠¶еИЖпЉМ36е≠¶жЧґ - **йАВзФ®дЄУдЄЪ**пЉЪзЙ©иБФзљСеЈ•з®Л - **еЉАиѓЊе≠¶жЬЯ**пЉЪзђђеЕ≠е≠¶жЬЯ - **еЉАиѓЊйГ®йЧ®**пЉЪ...

еЬ®жЬђжђ°зЪД"дЇТиБФзљСеЇФзФ®жЮґжЮДеЃЮжИШе≥∞дЉЪ-01"дЄ≠пЉМжИСдїђжЬЙеєЄеРђеИ∞жЭ•иЗ™дЄЪзХМй°ґзЇІеЕђеПЄзЪДдЄУеЃґеИЖдЇЂдїЦдїђзЪДжКАжЬѓеЃЮиЈµеТМжЮґжЮДжЉФињЫзїПй™МгАВдї•дЄЛжШѓдїЦдїђжЉФиЃ≤зЪДдЄїи¶БеЖЕеЃєпЉЪ й¶ЦеЕИпЉМйШњйЗМеЈіеЈізЪДйЩИеЇЈиі§иѓ¶зїЖдїЛзїНдЇЖйШњйЗМзЫіжТ≠еє≥еП∞зЪДжЮґжЮДжЉФињЫињЗз®ЛгАВдїЦ...

FlexжШѓзФ±AdobeеЉАеПСзЪДдЄАзІНеЉАжЇРж°ЖжЮґпЉМзФ®дЇОжЮДеїЇеѓМдЇТиБФзљСеЇФзФ®з®ЛеЇПпЉИRIAпЉЙгАВеЃГдЄїи¶БеЯЇдЇОActionScriptзЉЦз®Лиѓ≠и®АеТМMXMLж†ЗиЃ∞иѓ≠и®АпЉМиГље§ЯзФЯжИРSWFжЦЗдїґпЉМињЩдЇЫжЦЗдїґеПѓдї•еЬ®Adobe Flash PlayerжИЦAdobe AIRдЄ≠ињРи°МгАВ еЬ®Flex3дЄ≠пЉМеЃҐжИЈзЂѓ...

жЬђжЦЗж°£вАЬTWEB-дЉБдЄЪзЇІй°єзЫЃеЯЇдЇОPWAзЉУе≠ШзЪДжЬАдљ≥еЃЮиЈµ.pdfвАЭйАЪињЗзОЛжґµеЖ∞зЪДдїЛзїНпЉМжЈ±еЕ•жОҐиЃ®дЇЖдЉБдЄЪзЇІй°єзЫЃдЄ≠еЇФзФ®PWAзЉУе≠ШжКАжЬѓзЪДжЬАдљ≥еЃЮиЈµгАВ й¶ЦеЕИпЉМжЦЗж°£дїЛзїНдЇЖдЄЪеК°зО∞зКґпЉМжПРеИ∞дЇЖељУеЙНй°єзЫЃдЄ≠е≠ШеЬ®зЪДжАІиГљзУґйҐИпЉМдЊЛе¶ВпЉМеЬ®дЄНеРМзЪДеЃҐжИЈзЂѓ...

еИЖеЄГеЉПзЉУе≠ШжШѓзО∞дї£дЇТиБФзљСеЇФзФ®з®ЛеЇПдЄ≠дЄНеПѓжИЦзЉЇзЪДжКАжЬѓпЉМеЃГиГљжШЊиСЧжПРйЂШжХ∞жНЃиѓїеПЦйАЯеЇ¶пЉМйЩНдљОжХ∞жНЃеЇУеОЛеКЫгАВжЬђжЦЗдЄїи¶БжОҐиЃ®дЇЖеИЖеЄГеЉПзЉУе≠ШзЪДжЬАдљ≥еЃЮиЈµпЉМжЧ®еЬ®йБњеЕНзФЯдЇІзОѓеҐГдЄ≠еПѓиГљйБЗеИ∞зЪДйЧЃйҐШпЉМз°ЃдњЭз≥їзїЯзЪДз®≥еЃЪжАІеТМйЂШеПѓзФ®жАІгАВ й¶ЦеЕИпЉМзЉУе≠Ш...

### дЇСиЃ°зЃЧеЇФзФ®еЉАеПСеЃЮиЈµзЯ•иѓЖзВєиѓ¶иІ£ #### 1.1 JavaеЃ†зЙ©еХЖеЇЧзЃАдїЛ ##### 1.1.1 зОѓеҐГеЗЖе§З еЬ®еЗЖе§ЗйГ®зљ≤JavaеЃ†зЙ©еХЖеЇЧеЇФзФ®дєЛеЙНпЉМйЬАи¶Бз°ЃдњЭдї•дЄЛзОѓеҐГеТМиµДжЇРеЈ≤зїПеИ∞дљНпЉЪ 1. **жУНдљЬз≥їзїЯ**: жФѓжМБJavaз®ЛеЇПзЪДжУНдљЬз≥їзїЯпЉМдЊЛе¶ВWindows...

Redisж†ЄењГеОЯзРЖдЄОеЇФзФ®еЃЮиЈµ Redis дљЬдЄЇдЇТиБФзљСжКАжЬѓжЮґжЮДдЄ≠жЬАдЄЇеєњж≥ЫдљњзФ®зЪДдЄ≠йЧідїґпЉМеЃГеЬ®е≠ШеВ®з≥їзїЯдЄ≠еПСжМ•зЭАиЗ≥еЕ≥йЗНи¶БзЪДдљЬзФ®гАВзЙєеИЂжШѓеЬ®е§ІеЮЛдЇТиБФзљСеЕђеПЄдЄ≠пЉМRedis жШѓйЭҐиѓХеЃШжЬАеЦЬ搥йЧЃзЪДеЈ•з®ЛжКАиГљдєЛдЄАпЉМињЩдєЯеПНжШ†дЇЖ Redis еЬ®и°МдЄЪдЄ≠зЪД...

жАїзїУжЭ•иѓіпЉМдЇТиБФзљСзЉУе≠ШеТМCDNзЪДжФїеЗїз†Фз©ґжП≠з§ЇдЇЖдЇТиБФзљСеЯЇз°АиЃЊжЦљдЄ≠е≠ШеЬ®зЪДеЃЙеЕ®жЉПжіЮпЉМдЄЇеРОзї≠зЪДеЃЙеЕ®з†Фз©ґеТМеЃЮиЈµжПРдЊЫдЇЖеЃЭиіµзЪДеПВиАГгАВйЪПзЭАдЇТиБФзљСжКАжЬѓзЪДдЄНжЦ≠ињЫж≠•пЉМзљСзїЬеЃЙеЕ®йЧЃйҐШе∞ЖдЉЪжЫіеК†е§НжЭВе§ЪеПШпЉМеЫ†ж≠§жМБзї≠еЕ≥ж≥®еТМз†Фз©ґињЩдЄАйҐЖеЯЯпЉМ...

еИЖеЄГеЉПзЉУе≠ШжШѓзО∞дї£е§ІеЮЛдЇТиБФзљСеЇФзФ®дЄ≠дЄНеПѓжИЦзЉЇзЪДдЄАйГ®еИЖпЉМеЃГеЬ®е§ДзРЖжµЈйЗПжХ∞жНЃгАБжПРйЂШз≥їзїЯжАІиГљеТМеУНеЇФйАЯеЇ¶жЦєйЭҐеПСжМ•зЭАеЕ≥йФЃдљЬзФ®гАВжЬђдє¶вАЬжЈ±еЕ•еИЖеЄГеЉПзЉУе≠ШпЉЪдїОеОЯзРЖеИ∞еЃЮиЈµвАЭжЧ®еЬ®еЕ®йЭҐиІ£жЮРеИЖеЄГеЉПзЉУе≠ШзЪДж†ЄењГж¶ВењµгАБеЈ•дљЬеОЯзРЖеПКеЕґеЬ®еЃЮйЩЕ...

### жЈ±дњ°жЬНеЇФзФ®дЇ§дїШзљСзїЬжКАжЬѓеЇФзФ®дЄОеЃЮиЈµ #### дЄАгАБеЇФзФ®дЇ§дїШзљСзїЬж¶Вињ∞ еЇФзФ®дЇ§дїШзљСзїЬпЉИApplication Delivery NetworkingпЉМзЃАзІ∞ADNпЉЙжШѓдЄАзІНеИ©зФ®зљСзїЬдЉШеМЦжКАжЬѓз°ЃдњЭдЄЪеК°еЇФзФ®иГље§Яз®≥еЃЪгАБењЂйАЯгАБеЃЙеЕ®еЬ∞дЉ†йАТзїЩжЬАзїИзФ®жИЈзЪДиІ£еЖ≥...

зїЉдЄКжЙАињ∞пЉМеЃЮзО∞гАРйЂШжАІиГљйЂШжµБйЗПе§ІжХ∞жНЃдЇТиБФзљСеЇФзФ®еЃЮжИШгАСйЬАи¶БеѓєеИЖеЄГеЉПз≥їзїЯгАБе§ІжХ∞жНЃе§ДзРЖж°ЖжЮґгАБиіЯиљљеЭЗи°°гАБзЉУе≠ШжКАжЬѓгАБеЃЮжЧґе§ДзРЖгАБжЇРз†БеИЖжЮРгАБеЈ•еЕЈйАЙжЛ©еТМCI/CDжµБз®ЛжЬЙжЈ±еЕ•зРЖиІ£еТМеЃЮиЈµзїПй™МгАВињЩдЇЫзЯ•иѓЖзВєжЮДжИРдЇЖжФѓжТСйЂШжАІиГљдЇТиБФзљС...