1. жҖ§иғҪдјҳеҢ–йқўеҜ№зҡ„жҢ‘жҲҳ

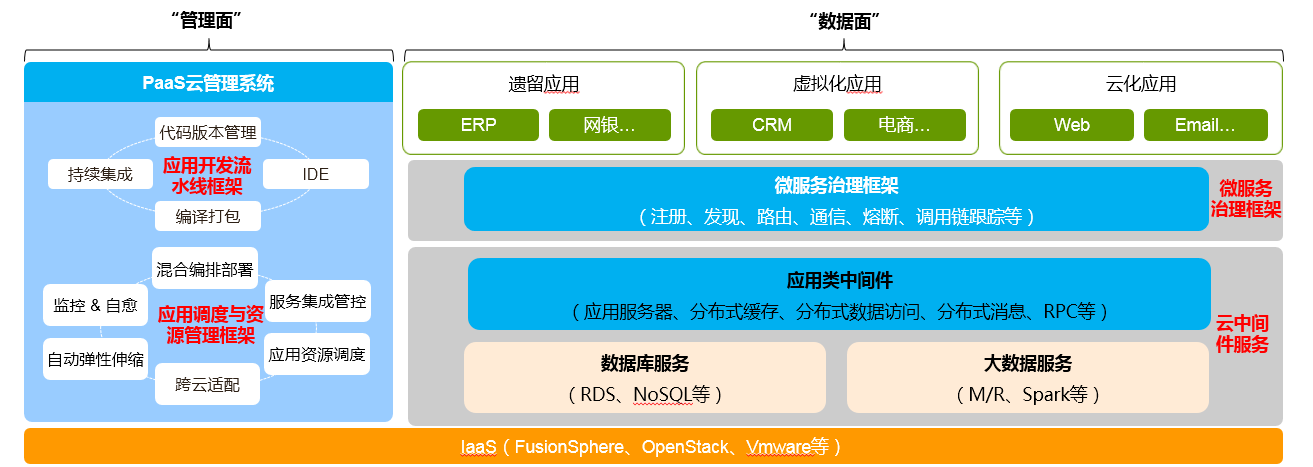

д»ҘдёӢжҳҜж•ҙдёӘPaaSе№іеҸ°зҡ„жһ¶жһ„

е…¶дёӯдё»иҰҒеҢ…жӢ¬иҝҷдәӣеӯҗзі»з»ҹпјҡ

- еҫ®жңҚеҠЎжІ»зҗҶжЎҶжһ¶пјҡдёәеә”з”ЁжҸҗдҫӣиҮӘеҠЁжіЁеҶҢгҖҒеҸ‘зҺ°гҖҒжІ»зҗҶгҖҒйҡ”зҰ»гҖҒи°ғз”ЁеҲҶжһҗзӯүдёҖзі»еҲ—еҲҶеёғејҸ/еҫ®жңҚеҠЎжІ»зҗҶиғҪеҠӣпјҢеұҸи”ҪеҲҶеёғејҸзі»з»ҹзҡ„еӨҚжқӮеәҰгҖӮ

- еә”з”Ёи°ғеәҰдёҺиө„жәҗз®ЎзҗҶжЎҶжһ¶пјҡжү“йҖҡд»Һеә”з”Ёе»әжЁЎгҖҒзј–жҺ’йғЁзҪІеҲ°иө„жәҗи°ғеәҰгҖҒеј№жҖ§дјёзј©гҖҒзӣ‘жҺ§иҮӘж„Ҳзҡ„з”ҹе‘Ҫе‘Ёжңҹз®ЎзҗҶиҮӘеҠЁеҢ–гҖӮ

- еә”з”ЁејҖеҸ‘жөҒж°ҙзәҝжЎҶжһ¶пјҡжү“йҖҡд»Һзј–еҶҷд»Јз ҒжҸҗдәӨеҲ°иҮӘеҠЁзј–иҜ‘жү“еҢ…гҖҒжҢҒз»ӯйӣҶжҲҗгҖҒиҮӘеҠЁйғЁзҪІдёҠзәҝзҡ„дёҖзі»еҲ—CI/CDе…ЁжөҒзЁӢиҮӘеҠЁеҢ–гҖӮ

- дә‘дёӯй—ҙ件жңҚеҠЎпјҡеә”з”Ёдә‘еҢ–жүҖйңҖзҡ„ж•°жҚ®еә“гҖҒеӨ§ж•°жҚ®гҖҒйҖҡдҝЎе’Ңеә”з”Ёдёӯй—ҙ件жңҚеҠЎпјӣйҖҡиҝҮжңҚеҠЎйӣҶжҲҗз®ЎжҺ§еҸҜйӣҶжҲҗдј з»ҹйқһдә‘еҢ–зҡ„дёӯй—ҙ件иғҪеҠӣгҖӮ

йқўеҜ№дёҖдёӘеҰӮжӯӨеӨҚжқӮзҡ„зі»з»ҹпјҢжҖ§иғҪдјҳеҢ–е·ҘдҪңжҳҜдёҖдёӘйқһеёёиү°е·Ёзҡ„жҢ‘жҲҳпјҢиҝҷйҮҢжңүиҝҷд№ҲдёҖдәӣз—ӣзӮ№пјҡ

- жәҗд»Јз ҒеҸҠејҖеҸ‘组件еӨҡпјҢ100+ git repoпјҢж•ҙдҪ“жһ„е»әи¶…иҝҮ1еӨ©

- иҝҗиЎҢжһ¶жһ„еӨҚжқӮпјҢе…ЁеҘ—е®үиЈ…е®ҢйңҖиҰҒ30+VMпјҢ200+иҝӣзЁӢ

- иҪҜ件ж Ҳж·ұпјҢзҪ‘з»ңе№ійқўеӨҚжқӮ

- йӣҶзҫӨ规模еӨ§пјҢ5k вҖ” 10kиҠӮзӮ№зҺҜеўғжҗӯе»әйқһеёёеӣ°йҡҫ

- зі»з»ҹж“ҚдҪңдјҡз»ҸиҝҮеҲҶеёғејҸзҡ„еӨҡдёӘ组件пјҢж— жі•йҖҡиҝҮеҚ•дёҖ组件иҜҠж–ӯеҸ‘зҺ°зі»з»ҹ瓶йўҲ

- ж— жі•иҝҪиёӘдёҠеҚғдёӘеӨ„дәҺдёҚеҗҢеұӮж¬Ўзҡ„APIзҡ„时延е’Ңеҗһеҗҗ

- еӨ§йғЁеҲҶејҖеҸ‘дәәе‘ҳдё“жіЁдәҺеҠҹиғҪејҖеҸ‘пјҢж— жі•ж„ҸиҜҶеҲ°иҮӘе·ұзҡ„д»Јз ҒеҸҜиғҪйҖ жҲҗжҖ§иғҪй—®йўҳ

2. дјҳеҢ–еҲҶжһҗ

йӮЈд№ҲпјҢеҜ№дәҺиҝҷд№ҲдёҖдёӘеӨ§зҡ„гҖҒеӨҚжқӮзҡ„зі»з»ҹпјҢд»Һж–№жі•и®әзҡ„и§’еәҰжқҘи®ІпјҢеә”иҜҘжҖҺд№ҲеҺ»дјҳеҢ–е‘ўпјҹеҹәжң¬жҖқи·Ҝе°ұжҳҜеҒҡжӢҶеҲҶпјҢжҠҠдёҖдёӘеӨ§зҡ„й—®йўҳеҲҶи§ЈдёәеӨҡдёӘдә’зӣёдёҚиҖҰеҗҲзҡ„з»ҙеәҰпјҢиҝӣиЎҢеҗ„дёӘеҮ»з ҙгҖӮд»ҺеӨ§зҡ„з»ҙеәҰжқҘи®ІпјҢдёҖдёӘPaaSе®№еҷЁйӣҶзҫӨпјҢеҸҜд»ҘеҲҶдёә3дёӘеӨ§зҡ„еӯҗзі»з»ҹгҖӮ

- жҺ§еҲ¶еӯҗзі»з»ҹпјҡжҺ§еҲ¶жҢҮд»Өзҡ„дёӢеҸ‘е’ҢиҝҗиЎҢ(k8s)пјҢдҫӢеҰӮеҲӣе»әpod

- дёҡеҠЎжөҒйҮҸеӯҗзі»з»ҹпјҡе®№еҷЁзҪ‘з»ң(flannel)гҖҒиҙҹиҪҪеқҮиЎЎ(ELB/kube-proxy)

- зӣ‘жҺ§еӯҗзі»з»ҹпјҡзӣ‘жҺ§е‘ҠиӯҰж•°жҚ®зҡ„йҮҮйӣҶ(kafka, Hadoop)

иҝҷдёӘзңӢиө·жқҘд»…д»…жҳҜдёҖдёӘжһ¶жһ„дёҠзҡ„еҲ’еҲҶпјҢйӮЈд№ҲеҰӮдҪ•е’Ңе…·дҪ“зҡ„дёҡеҠЎеңәжҷҜеҜ№еә”иө·жқҘе‘ўпјҹжҲ‘们еҸҜд»ҘиҖғиҷ‘еҰӮдёӢдёҖдёӘеңәжҷҜпјҢеңЁPaaSе№іеҸ°дёҠеӨ§жү№йҮҸзҡ„йғЁзҪІеә”з”ЁгҖӮзңӢзңӢеңЁйғЁзҪІеә”з”Ёзҡ„иҝҮзЁӢдёӯпјҢдјҡеҜ№еҗ„дёӘеӯҗзі»з»ҹдә§з”ҹд»Җд№ҲеҺӢеҠӣгҖӮ

- еә”з”ЁиҪҜ件еҢ…еӨ§е°Ҹпјҡ400M

- еә”з”ЁжЁЎжқҝеӨ§е°Ҹпјҡ10M

- 1000дёӘиҠӮзӮ№пјҢжҜҸдёӘиҠӮзӮ№дёҖдёӘPODпјҢдёҖдёӘе®һдҫӢ

- 10з§Қзұ»еһӢзҡ„иҪҜ件еҢ…пјҢдҫқиө–й•ҝеәҰдёә3пјҢ10GB зҪ‘з»ң

- и°ғеәҰеҸҠиө„жәҗз®ЎзҗҶ 3VM

иҝҷжҳҜдёҖдёӘе…ёеһӢзҡ„йғЁзҪІеә”з”Ёзҡ„дёҖдәӣи§„ж јпјҢйӮЈд№ҲеҜ№дәҺиҝҷж ·зҡ„дёҖдёӘиҫ“е…ҘпјҢжҲ‘们еҸҜд»ҘжҢүз…§жһ¶жһ„жҠҠеҺӢеҠӣеҲҶи§ЈеҲ°жҜҸдёӘеӯҗзі»з»ҹдёҠпјҢиҝҷж ·еҫ—еҮәзҡ„еӯҗзі»з»ҹйңҖиҰҒж”Ҝж’‘зҡ„жҢҮж ҮжҳҜпјҡ

- жҺ§еҲ¶еӯҗзі»з»ҹпјҡ kubernetesи°ғеәҰйҖҹеәҰ > 50 pods/sпјҢд»“еә“ж”ҜжҢҒ300并еҸ‘дёӢиҪҪпјҢ>40M/s

- ж•°жҚ®еӯҗзі»з»ҹпјҡoverlayе®№еҷЁзҪ‘з»ңTCP收еҸ‘жҖ§иғҪжҚҹиҖ— <5%

- зӣ‘жҺ§еӯҗзі»з»ҹпјҡеңЁдёҠйқўиҝҷдёӘеңәжҷҜдёӯдёҚж¶үеҸҠпјҢдҪҶеҸҜд»Ҙд»ҺеҲ«зҡ„еңәжҷҜеӨ§иҮҙе‘ҠиӯҰеӨ„зҗҶиғҪеҠӣ100жқЎ/з§’

иҝҷйҮҢзҡ„дёҡеҠЎеңәжҷҜпјҡжһ¶жһ„еҲҶжһҗпјҡеӯҗзі»з»ҹжҢҮж ҮпјҢиҝҷдёүиҖ…жҳҜm:1:nзҡ„пјҢд№ҹе°ұжҳҜиҜҙеңЁдёҚеҗҢеңәжҷҜдёӢеҜ№дёҚеҗҢзҡ„组件зҡ„жҖ§иғҪиҰҒжұӮдёҚеҗҢпјҢжңҖеҗҺжҜҸдёӘ组件йңҖиҰҒеҸ–иҮӘе·ұжҢҮж Үзҡ„жңҖеӨ§еҖјгҖӮ

жҢҮж ҮеҶіе®ҡдәҶеҗҺз»ӯжҖҺд№ҲиҝӣиЎҢе®һйӘҢжөӢиҜ•пјҢиҖҢжөӢиҜ•жҳҜиҰҒиҠұиҫғеӨ§ж—¶й—ҙжҲҗжң¬зҡ„пјҢжүҖд»ҘеңЁжҢҮж Үзҡ„йҖүеҸ–дёҠиҰҒжұӮе°‘жұӮзІҫпјҢе°ҪйҮҸеҠӣеӣҫз”Ё2-3дёӘжҢҮж ҮиЎЎйҮҸеӯҗзі»з»ҹгҖӮ

3. дјҳеҢ–жөӢиҜ• & е·Ҙе…·

дёҠйқўи®Ізҡ„иҝҳжҳҜеҒҸзәёдёҠзҡ„жҺЁжј”е’ҢеҲҶжһҗпјҢжҺҘдёӢжқҘиҝӣе…Ҙе®һжҲҳйҳ¶ж®ө

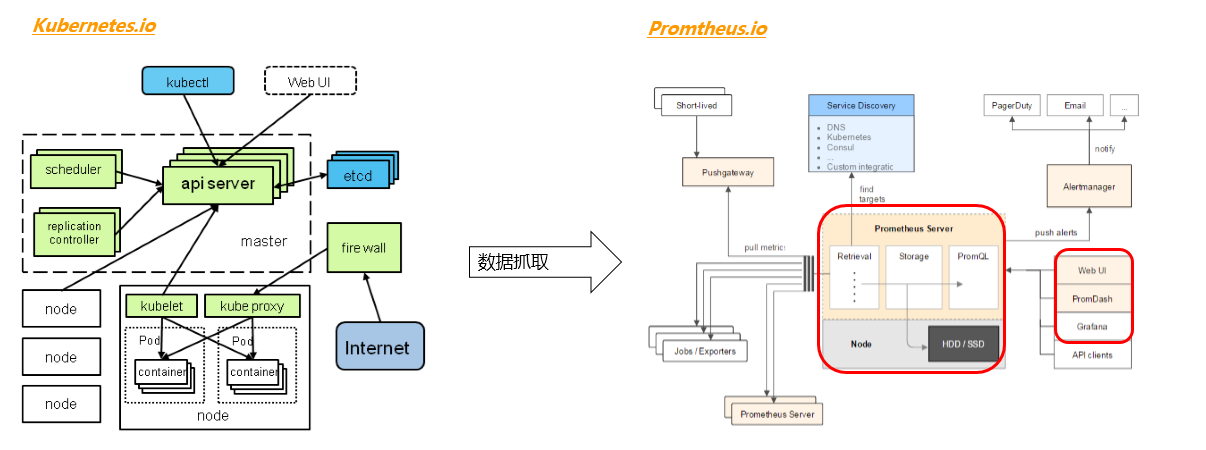

еҜ№дәҺжңҚеҠЎеҷЁеҗҺз«Ҝзҡ„зЁӢеәҸжқҘи®ІпјҢжҺЁиҚҗдҪҝз”ЁPromtheusиҝҷдёӘе·Ҙе…·жқҘеҒҡжҢҮж Үзҡ„е®ҡд№үе’ҢйҮҮйӣҶгҖӮPromtheusзҡ„еҹәжң¬е·ҘдҪңеҺҹзҗҶжҳҜпјҡеҗҺз«ҜзЁӢеәҸеј•е…ҘPromtheusзҡ„SDKпјҢиҮӘе®ҡд№үжүҖжңүйңҖиҰҒзҡ„жөӢйҮҸзҡ„жҢҮж ҮпјҢ然еҗҺејҖеҗҜдёҖдёӘhttpзҡ„йЎөйқўпјҢе®ҡжңҹеҲ·ж–°ж•°жҚ®гҖӮPromtheusжңҚеҠЎеҷЁдјҡе®ҡжңҹжҠ“еҸ–иҝҷдёӘйЎөйқўдёҠзҡ„ж•°жҚ®пјҢ并еӯҳеңЁеҶ…йғЁзҡ„ж—¶й—ҙеәҸеҲ—ж•°жҚ®еә“еҶ…гҖӮиҝҷз§ҚжҠ“иҖҢйқһжҺЁзҡ„ж–№ејҸеҮҸе°‘дәҶеҜ№иў«жөӢиҜ•зЁӢеәҸзҡ„еҺӢеҠӣпјҢйҒҝе…ҚдәҶиў«жөӢзЁӢеәҸиҰҒйў‘з№ҒеҫҖеӨ–еҸ‘йҖҒеӨ§йҮҸж•°жҚ®пјҢеҜјиҮҙиҮӘиә«жҖ§иғҪеҸҚиҖҢеҸҳе·®иҖҢеҜјиҮҙжөӢйҮҸдёҚеҮҶзЎ®гҖӮPromtheusж”ҜжҢҒиҝҷеҮ з§Қж•°жҚ®зұ»еһӢпјҡ

- и®Ўж•°(еҜ№еә”收йӣҶеҷЁеҲқе§ӢеҢ–ж–№жі•NewCounterгҖҒNewCounterFuncгҖҒNewCounterVecпјҢеҚ•дёҖж•°еҖјпјҢж•°еҖјдёҖзӣҙйҖ’еўһпјҢйҖӮеҗҲиҜ·жұӮж•°йҮҸз»ҹи®Ўзӯү)

- жөӢйҮҸ(еҜ№еә”收йӣҶеҷЁеҲқе§ӢеҢ–ж–№жі•NewGaugeгҖҒNewGaugeFuncгҖҒNewGaugeVecпјҢеҚ•дёҖж•°еҖјпјҢж•°еҖјеўһеҮҸеҸҳеҠЁпјҢйҖӮеҗҲCPUгҖҒMemзӯүзҡ„з»ҹи®Ў)

- зӣҙж–№еӣҫжөӢйҮҸ(еҜ№еә”收йӣҶеҷЁеҲқе§ӢеҢ–ж–№жі•NewHistogramгҖҒNewHistogramVecпјҢжҜ”иҫғйҖӮеҗҲж—¶й•ҝзӯүзҡ„з»ҹи®Ў)

- жҰӮиҰҒжөӢйҮҸ(еҜ№еә”收йӣҶеҷЁеҲқе§ӢеҢ–ж–№жі•NewSummaryгҖҒNewSummaryVecпјҢжҜ”иҫғйҖӮеҗҲиҜ·жұӮ时延зӯүзҡ„з»ҹи®Ў)

жҲ‘们еҸҜд»ҘзңӢзңӢеңЁkubernetesйЎ№зӣ®йҮҢйқўжҳҜжҖҺд№Ҳз”Ёзҡ„пјҡ

var (

// TODO(a-robinson): Add unit tests for the handling of these metrics once

// the upstream library supports it.

requestCounter = prometheus.NewCounterVec(

prometheus.CounterOpts{

Name: "apiserver_request_count",

Help: "Counter of apiserver requests broken out for each verb, API resource, client, and HTTP response contentType and code.",

},

[]string{"verb", "resource", "client", "contentType", "code"},

)

requestLatencies = prometheus.NewHistogramVec(

prometheus.HistogramOpts{

Name: "apiserver_request_latencies",

Help: "Response latency distribution in microseconds for each verb, resource and client.",

// Use buckets ranging from 125 ms to 8 seconds.

Buckets: prometheus.ExponentialBuckets(125000, 2.0, 7),

},

[]string{"verb", "resource"},

)

requestLatenciesSummary = prometheus.NewSummaryVec(

prometheus.SummaryOpts{

Name: "apiserver_request_latencies_summary",

Help: "Response latency summary in microseconds for each verb and resource.",

// Make the sliding window of 1h.

MaxAge: time.Hour,

},

[]string{"verb", "resource"},

)

)

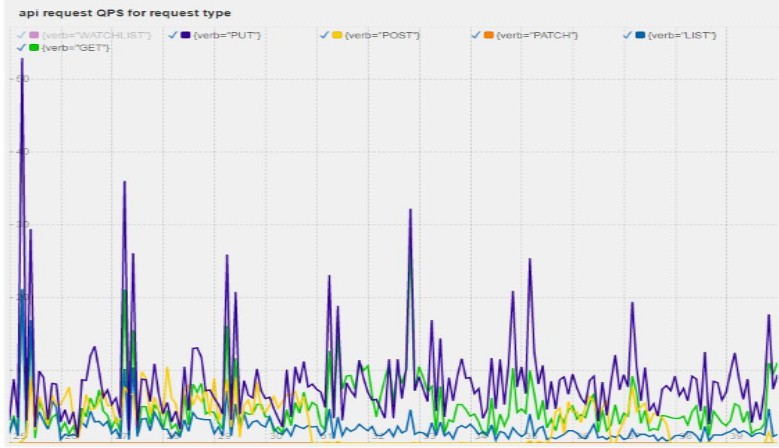

еңЁиҝҷйҮҢпјҢдёҖдёӘhttpиҜ·жұӮиў«еҲҶдёәverb, resource, client, contentType, codeиҝҷдә”дёӘз»ҙеәҰпјҢйӮЈд№ҲеҗҺйқўеңЁPromDashдёҠе°ұиғҪеӣҫеҪўеҢ–зҡ„з”»еҮәиҝҷдәӣиҜ·жұӮзҡ„ж•°йҮҸгҖӮ д»ҺиҖҢеҲҶжһҗе“Әз§Қзұ»еһӢзҡ„иҜ·жұӮжҳҜжңҖеӨҡпјҢеҜ№зі»з»ҹйҖ жҲҗжңҖеӨ§еҺӢеҠӣзҡ„пјҢеҰӮеӣҫ

йҷӨдәҶPromtheusпјҢиҝҳеҸҜд»Ҙеј•е…Ҙе…¶д»–зҡ„жөӢйҮҸжүӢж®өпјҢеҜ№зі»з»ҹиҝӣиЎҢеҲҶжһҗгҖӮ

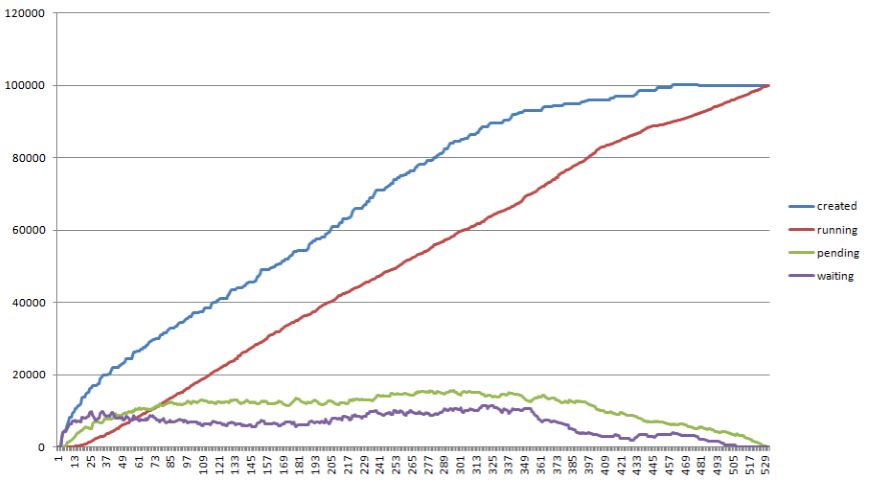

- еңЁkubernetesи°ғеәҰиҝҮзЁӢдёӯпјҢеҗ„дёӘзҠ¶жҖҒPodзҡ„ж•°йҮҸпјҢзңӢе“ӘдёҖжӯҘжҳҜжңҖеҚЎзҡ„

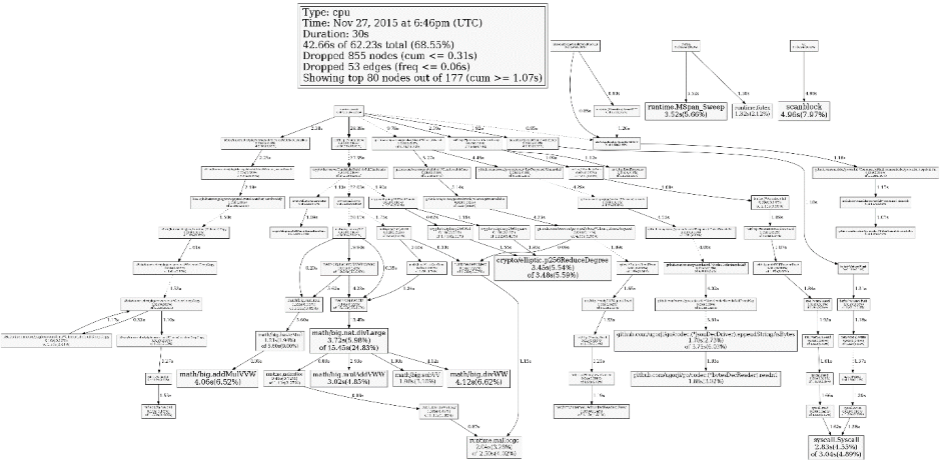

- go pprofеҲҶжһҗпјҢе“ӘдәӣеҮҪж•°жҳҜжңҖиҖ—CPUзҡ„

4. дјҳеҢ–ејҖеҸ‘

еҸ‘зҺ°дәҶ瓶йўҲд№ӢеҗҺпјҢдёӢдёҖжӯҘе°ұжҳҜи§ЈеҶіз“¶йўҲпјҢе’Ңе…·дҪ“дёҡеҠЎйҖ»иҫ‘жңүе…іпјҢжң¬ж–ҮеңЁиҝҷйҮҢе°ұдёҚеҒҡиҝҮеӨҡзҡ„йҳҗйҮҠгҖӮйңҖиҰҒеҜ№зӣёе…ід»Јз ҒйқһеёёзҶҹжӮүпјҢеңЁдёҚж”№еҸҳеҠҹиғҪзҡ„жғ…еҶөдёӢеўһејәжҖ§иғҪпјҢеҹәжң¬жҖқи·Ҝдёә并еҸ‘/зј“еӯҳ/еҺ»йҷӨж— з”ЁжӯҘйӘӨзӯүгҖӮ

5. дјҳеҢ–жҲҗжһң

иҝҷжҳҜжҲ‘们еңЁkubernetesйЎ№зӣ®дёҠжҺ§еҲ¶йқўдјҳеҢ–зҡ„жҲҗжһң

| MasterиҠӮзӮ№ж•°йҮҸ | 5 | ж— жҳҺзЎ®ж•°жҚ® |

| NodeиҠӮзӮ№(kubemarkжЁЎжӢҹ)ж•°йҮҸ | 10000иҠӮзӮ№ | 5000иҠӮзӮ№ |

| йғЁзҪІеҗһеҗҗзҺҮ | >100 pod/s | зәҰдёә50 pod/s |

| Podз«ҜеҲ°з«Ҝ延时 | <2s | <5s |

| API延时 | <79.321ms | <1s |

иҝҷйҮҢд»…д»…жҳҫзӨәдәҶжҺ§еҲ¶еӯҗзі»з»ҹзҡ„жҢҮж ҮпјҢе…¶д»–еӯҗзі»з»ҹиҝҳжІЎжңүж”ҜжҢҒйӮЈд№ҲеӨ§зҡ„йӣҶзҫӨпјҢе°Өе…¶еңЁзҪ‘з»ңж–№йқўпјҢдёҚеҗҢз”ЁжҲ·зҡ„зҪ‘з»ңжһ¶жһ„е·®еҲ«еҫҲеӨ§гҖӮжүҖд»Ҙж•°жҚ®д»…дҫӣеҸӮиҖғгҖӮ

6. дјҳеҢ–зҡ„дјҳеҢ–

еңЁдёҠйқўзҡ„дјҳеҢ–иҝҮзЁӢеҪ“дёӯпјҢеҹәжң¬дёҠе·ҘзЁӢеёҲиҰҒеҒҡеҮ зҷҫж¬ЎдјҳеҢ–зҡ„жөӢиҜ•е’ҢејҖеҸ‘гҖӮиҝҷйҮҢдјҡдә§з”ҹдёҖдёӘеҫӘзҺҜпјҡ

- жөӢиҜ•еҜ»жүҫ瓶йўҲзӮ№

- дҝ®ж”№д»Јз ҒзӘҒз ҙиҝҷдёӘ瓶йўҲзӮ№

- йҮҚж–°жөӢиҜ•йӘҢиҜҒиҝҷж®өд»Јз ҒжҳҜеҗҰжңүж•ҲпјҢжҳҜеҗҰйңҖиҰҒж”№дјҳеҢ–жҖқи·Ҝ

иҝҷе°ұжҳҜдёҖдёӘе®Ңж•ҙзҡ„дјҳеҢ–зҡ„иҝӯд»ЈиҝҮзЁӢпјҢеңЁиҝҷдёӘиҝҮзЁӢеҪ“дёӯпјҢеӨ§йғЁеҲҶж—¶й—ҙиў«жөӘиҙ№еңЁжһ„е»әд»Јз ҒгҖҒжҗӯе»әзҺҜеўғгҖҒиҫ“еҮәжҠҘе‘ҠдёҠгҖӮејҖеҸ‘дәәе‘ҳзңҹжӯЈжҖқиҖғе’ҢеҶҷд»Јз Ғзҡ„ж—¶й—ҙжҜ”иҫғзҹӯгҖӮдёәдәҶи§ЈеҶіиҝҷдёӘй—®йўҳпјҢе°ұйңҖиҰҒеҒҡеҫҲеӨҡиҮӘеҠЁеҢ–зҡ„е·ҘдҪңгҖӮеңЁkubernetesдјҳеҢ–зҡ„иҝҮзЁӢдёӯпјҢжңүиҝҷд№ҲеҮ йЎ№ж–№жі•еҸҜд»ҘиҠӮзңҒж—¶й—ҙпјҡ

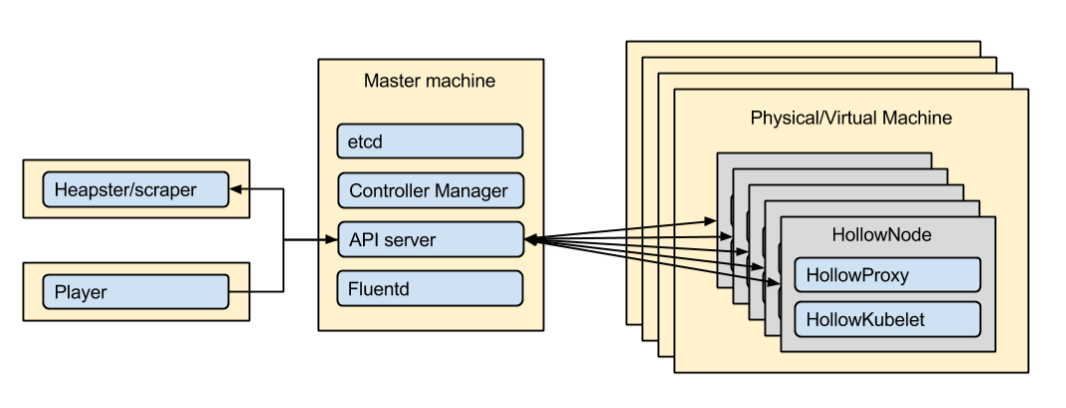

- kubemarkжЁЎжӢҹеҷЁВ пјҡзӨҫеҢәйЎ№зӣ®пјҢдҪҝз”Ёе®№еҷЁжЁЎжӢҹиҷҡжӢҹжңәпјҢеңЁжөӢиҜ•дёӯжЁЎжӢҹжҜ”иҫҫеҲ°1пјҡ20пјҢд№ҹе°ұжҳҜдёҖеҸ°иҷҡжӢҹжңәеҸҜд»ҘжЁЎжӢҹ20еҸ°иҷҡжӢҹжңәеҜ№apiserverдә§з”ҹзҡ„еҺӢеҠӣгҖӮеңЁжөӢиҜ•иҝҮзЁӢеҪ“дёӯпјҢжҲ‘们дҪҝз”ЁдәҶ500еҸ°иҷҡжӢҹжңәпјҢжЁЎжӢҹдәҶ10000иҠӮзӮ№зҡ„жҺ§еҲ¶йқўиЎҢдёәгҖӮ

- CIйӣҶжҲҗпјҡжҸҗдәӨPRеҗҺиҮӘеҠЁжӢүжҖ§иғҪдјҳеҢ–еҲҶж”Ҝ并ејҖе§Ӣеҝ«йҖҹжһ„е»ә

- CDйӣҶжҲҗпјҡдҪҝз”ЁIеұӮзҡ„еҝ«з…§жңәеҲ¶пјҢеҝ«йҖҹжҗӯе»әйӣҶзҫӨ并жү§иЎҢжөӢиҜ•жЎҲдҫӢиҫ“еҮәжөӢиҜ•жҠҘе‘Ҡ

д»ҘдёҠйғҪжҳҜеңЁе®һи·өиҝҮзЁӢдёӯжҖ»з»“зҡ„дёҖдәӣзӮ№пјҢеҜ№дәҺдёҚеҗҢзҡ„йЎ№зӣ®е·ҘзЁӢеә”иҜҘжңүеҫҲеӨҡзӮ№еҸҜд»ҘеҒҡиҝӣдёҖжӯҘзҡ„дјҳеҢ–пјҢжҸҗеҚҮиҝӯд»Јж•ҲзҺҮгҖӮ

еңЁжҗӯе»әе®ҢиҝҷеҘ—зі»з»ҹеҗҺпјҢжҲ‘们еҸ‘зҺ°иҝҷдёӘзі»з»ҹеҸҜд»Ҙд»ҺжәҗеӨҙдёҠйў„йҳІйҷҚдҪҺзі»з»ҹжҖ§иғҪзҡ„д»Јз ҒеҗҲе…Ҙдё»зәҝгҖӮеҰӮжһңдёҖйЎ№зү№жҖ§д»Јз ҒйҖ жҲҗдәҶжҖ§иғҪдёӢйҷҚпјҢеңЁCIзҡ„иҝҮзЁӢеҪ“дёӯпјҢеҠҹиғҪејҖеҸ‘иҖ…е°ұиғҪ收еҲ°жҖ§иғҪжҠҘе‘ҠпјҢиҝҷж ·ејҖеҸ‘иҖ…е°ұиғҪиҮӘеҠ©ејҸзҡ„еҺ»жҹҘжүҫиҮӘе·ұд»Јз Ғзҡ„жҖ§иғҪй—®йўҳжүҖеңЁпјҢеҮҸе°‘жҖ§иғҪе·ҘзЁӢеёҲзҡ„д»Ӣе…ҘгҖӮ

зӣёе…іжҺЁиҚҗ

гҖҗж ҮйўҳгҖ‘"Paasе®№еҷЁе®һжҲҳ"зҡ„жҸҸиҝ°жҢҮеҮәпјҢиҝҷжҳҜдёҖд»Ҫе…ідәҺPaaSпјҲPlatform as a Serviceпјүе®№еҷЁжҠҖжңҜзҡ„е®һжҲҳжҢҮеҚ—пјҢзү№еҲ«е…іжіЁKubernetesпјҲK8sпјүе’ҢSpring Security 3зҡ„дҪҝз”ЁгҖӮеңЁPaaSзҺҜеўғдёӯпјҢе®№еҷЁеҢ–жҠҖжңҜе·Із»ҸжҲҗдёәзҺ°д»Јеә”з”ЁзЁӢеәҸйғЁзҪІзҡ„...

гҖҠеҹәдәҺе®№еҷЁPaaSдә‘жҠҖжңҜе№іеҸ°ж–№жЎҲгҖӢжҺўи®ЁдәҶеҲ©з”Ёе®№еҷЁжҠҖжңҜжһ„е»әPaaSдә‘е№іеҸ°зҡ„ж–№жі•пјҢд»Ҙе®һзҺ°иө„жәҗзҡ„...йҖҡиҝҮеҫ®жңҚеҠЎеҢ–гҖҒе®№еҷЁеҢ–е’ҢйӣҶзҫӨз®ЎзҗҶпјҢиҜҘж–№жЎҲдёҚд»…дјҳеҢ–дәҶиө„жәҗеҲ©з”ЁзҺҮпјҢиҝҳжҸҗеҚҮдәҶзі»з»ҹзҡ„еј№жҖ§е’ҢзЁіе®ҡжҖ§пјҢйҖӮеә”дәҶдә’иҒ”зҪ‘ж—¶д»Јзҡ„дёҡеҠЎйңҖжұӮгҖӮ

### иҜҒеҲёиЎҢдёҡзҡ„е®№еҷЁе®һи·өд№Ӣи·ҜвҖ”вҖ”еҹәдәҺKubernetesзҡ„дә‘е№іеҸ°е»әи®ҫ #### дёҖгҖҒиғҢжҷҜдёҺжҰӮиҝ° йҡҸзқҖйҮ‘иһҚиЎҢдёҡзҡ„ж•°еӯ—еҢ–иҪ¬еһӢеҠ йҖҹпјҢдј з»ҹзҡ„ITжһ¶жһ„е·Ійҡҫд»Ҙж»Ўи¶іж—ҘзӣҠеўһй•ҝзҡ„дёҡеҠЎйңҖжұӮгҖӮеӣҪжі°еҗӣе®үиҜҒеҲёдҪңдёәдёӯеӣҪйўҶе…Ҳзҡ„иҜҒеҲёе…¬еҸёд№ӢдёҖпјҢйқўеҜ№дёҡеҠЎ...

- еҗҲзҗҶи°ғж•ҙеҚ•дёӘж“ҚдҪңзі»з»ҹд№ӢдёҠзҡ„е®№еҷЁеҜҶеәҰпјҢдјҳеҢ–иө„жәҗдҪҝз”ЁзҺҮпјҢеҮҸе°‘дәҶ硬件жҠ•е…ҘжҲҗжң¬гҖӮ 4. **иҪҜд»¶з ”еҸ‘жҠҖжңҜз»ҹдёҖдёҺиҙЁйҮҸжҠҠжҺ§**пјҡ - иҝҗиЎҢзҺҜеўғж ҮеҮҶеҢ–жңүеҠ©дәҺе®һзҺ°е…Ёе…¬еҸёзҡ„жҠҖжңҜз ”еҸ‘и·Ҝзәҝз»ҹдёҖпјҢдҝғиҝӣCI/CDпјҲжҢҒз»ӯйӣҶжҲҗ/жҢҒз»ӯйғЁзҪІпјүе®һи·ө...

ж•°жҚ®еә“е®№еҷЁеҢ–PaaSе№іеҸ°е»әи®ҫж–№жЎҲж—ЁеңЁйҖҡиҝҮжҠҖжңҜеҲӣж–°пјҢж”№еҸҳдј з»ҹж•°жҚ®еә“з®ЎзҗҶзҡ„зҺ°зҠ¶пјҢжҺЁеҠЁж•°жҚ®еә“жңҚеҠЎеҗ‘иҮӘеҠЁеҢ–гҖҒжҷәиғҪеҢ–ж–№еҗ‘еҸ‘еұ•гҖӮжӯӨж–№жЎҲзү№еҲ«е…іжіЁдәҶзү©зҗҶжңәдёҺиҷҡжӢҹжңәзҡ„иҮӘеҠЁеҢ–йғЁзҪІгҖҒе®№еҷЁеҢ–жҠҖжңҜзҡ„еә”з”Ёд»ҘеҸҠз§ҒжңүеҢ–е’Ңе…¬жңүдә‘зҺҜеўғдёӢзҡ„...

и®ҫи®Ўе®ҢжҲҗеҗҺпјҢе°ҶжҢүз…§ж•ҸжҚ·ејҖеҸ‘жЁЎејҸеҲҶйҳ¶ж®өе®һж–ҪпјҢеҢ…жӢ¬йңҖжұӮеҲҶжһҗгҖҒеҺҹеһӢи®ҫи®ЎгҖҒејҖеҸ‘гҖҒжөӢиҜ•гҖҒйғЁзҪІе’ҢжҢҒз»ӯдјҳеҢ–пјҢзЎ®дҝқPaaSе№іеҸ°зЁіе®ҡеҸҜйқ ең°жңҚеҠЎдәҺеҗ„зұ»з”ЁжҲ·гҖӮ жҖ»з»“пјҢдә‘и®Ўз®—PaaSе№іеҸ°жҖ»дҪ“и®ҫи®ЎиҜҙжҳҺд№Ұж—ЁеңЁжһ„е»әдёҖдёӘе…Ёйқўзҡ„ејҖеҸ‘е’ҢиҝҗиЎҢзҺҜеўғ...

иҝҷйҮҢпјҢKubernetesд»…жҳҜе®№еҷЁзј–жҺ’е·Ҙе…·пјҢе№іеҸ°и®ҫи®Ўеә”и¶…и¶Ҡе…¶еҠҹиғҪпјҢиҖғиҷ‘дёҺPaaSе№іеҸ°гҖҒдә‘з®Ўе№іеҸ°гҖҒDevOpsгҖҒжңҚеҠЎжІ»зҗҶзӯүзҡ„ж•ҙеҗҲпјҢеҪўжҲҗдёҖдҪ“еҢ–зҡ„иө„жәҗз®ЎзҗҶж–№жЎҲгҖӮ еҶҚиҖ…пјҢйңҖжұӮйў„жөӢе’Ңе®№йҮҸ规еҲ’жҳҜиө„жәҗз®ЎзҗҶзҡ„ж ёеҝғгҖӮз§ҹжҲ·йңҖжұӮйҖҡеёёеҹәдәҺеә”з”Ё...

еңЁе®№еҷЁзҪ‘з»ңж–№жЎҲзҡ„дјҳеҢ–дёҠпјҢж–ҮдёӯжҸҗеҲ°дәҶеӨҡйӣҶзҫӨз®ЎзҗҶе’ҢK8SйӣҶзҫӨзҡ„й«ҳеҸҜз”ЁжҖ§гҖӮеӨҡйӣҶзҫӨж–№жЎҲе…Ғи®ёдјҒдёҡеңЁдёҚеҗҢзҡ„ж•°жҚ®дёӯеҝғжҲ–ең°зҗҶдҪҚзҪ®еҲҶж•ЈйғЁзҪІпјҢд»ҘжҸҗй«ҳе®№зҒҫиғҪеҠӣе’Ңж•°жҚ®е®үе…ЁжҖ§гҖӮеҪ“йҒҮеҲ°й—®йўҳж—¶пјҢеҸҜд»ҘйҮҮз”ЁдёӨз§Қзӯ–з•ҘиҝӣиЎҢдё»еӨҮеҲҮжҚўпјҡдёҖз§ҚжҳҜ...

еңЁе®һйҷ…ж“ҚдҪңдёӯпјҢжҗӯе»әзҡ„PaaSдә‘е№іеҸ°еҲҶдёәз®ЎзҗҶйӣҶзҫӨгҖҒдёҡеҠЎйӣҶзҫӨе’Ңе№іеҸ°йӣҶзҫӨгҖӮз®ЎзҗҶйӣҶзҫӨеҢ…жӢ¬еӨҡдёӘmasterиҠӮзӮ№д»Ҙж»Ўи¶ій«ҳеҸҜз”ЁжҖ§иҰҒжұӮпјҢ并еңЁйӣҶзҫӨеҶ…йғЁзҪІдәҶglusterfsе’ҢetcdзӯүеҲҶеёғејҸеӯҳеӮЁе’Ңй…ҚзҪ®з®ЎзҗҶ组件гҖӮдёҡеҠЎйӣҶзҫӨеҲҷдҫқжүҳиҝҷдәӣ组件пјҢиҝҗиЎҢ...

иҝҷдёӘи®®йўҳдё»иҰҒжҺўи®ЁдәҶеҰӮдҪ•йҖҡиҝҮе®№еҷЁеҢ–жҠҖжңҜдјҳеҢ–Android Virtual Device (AVD) зҡ„з®ЎзҗҶе’ҢдҪҝз”ЁпјҢд»Ҙи§ЈеҶіеңЁеӨ§и§„жЁЎеә”з”ЁдёӯйҒҮеҲ°зҡ„й—®йўҳе’Ңз—ӣзӮ№гҖӮ йҰ–е…ҲпјҢAVDеңЁжҗәзЁӢйқўдёҙзҡ„дё»иҰҒй—®йўҳе’Ңз—ӣзӮ№еҢ…жӢ¬иө„жәҗеҲ©з”ЁзҺҮдҪҺгҖҒжү©еұ•жҖ§е·®гҖҒиҝҗз»ҙеӨҚжқӮд»ҘеҸҠ...

### дјҒдёҡPaaSйҖҡз”ЁиғҪеҠӣе№іеҸ°и§ЈеҶіж–№жЎҲ #### дёҖгҖҒеј•иЁҖ йҡҸзқҖдҝЎжҒҜжҠҖжңҜзҡ„еҝ«йҖҹеҸ‘еұ•пјҢдјҒдёҡеҜ№ITеҹәзЎҖи®ҫж–Ҫе’ҢжңҚеҠЎзҡ„йңҖжұӮд№ҹеңЁдёҚж–ӯеўһй•ҝгҖӮдёәдәҶж»Ўи¶іиҝҷдәӣйңҖжұӮпјҢдә‘и®Ўз®—жҠҖжңҜжҲҗдёәдәҶдёҖдёӘйҮҚиҰҒзҡ„йҖүжӢ©гҖӮе…¶дёӯпјҢPaaSпјҲе№іеҸ°еҚіжңҚеҠЎпјүдҪңдёәдёҖз§Қ...

иҝҷзҜҮеҲҶдә«ж–Үз« жҸҗдҫӣдәҶзҫҺеӣўзӮ№иҜ„дёҡеҠЎе®№еҷЁеҢ–зҡ„е®һи·өз»ҸйӘҢе’ҢжҠҖжңҜйҖүеһӢпјҢж¶өзӣ–дәҶе®№еҷЁеҢ–гҖҒPaaS е№іеҸ°гҖҒDevOpsгҖҒйҳҝйҮҢдә‘жңҚеҠЎгҖҒSRE е®һи·өгҖҒGit зүҲжң¬жҺ§еҲ¶гҖҒPuppet иҮӘеҠЁеҢ–е·Ҙе…·гҖҒVM е’Ң K8s йӣҶзҫӨз®ЎзҗҶгҖҒREST API и®ҫи®ЎзӯүеӨҡдёӘж–№йқўзҡ„зҹҘиҜҶзӮ№гҖӮ

- Dockerе®№еҷЁз®ЎзҗҶпјҡеҹәдәҺSwarm APIе’ҢDocker APIпјҢжҸҗдҫӣйӣҶзҫӨйғЁзҪІгҖҒе®№еҷЁз”ҹе‘Ҫе‘Ёжңҹз®ЎзҗҶгҖҒзЈҒзӣҳе’ҢзҪ‘з»ңз®ЎзҗҶзӯүеҠҹиғҪпјҢдё”иғҪеҜ№жҺҘIaaSеұӮпјҢзЎ®дҝқеә•еұӮиө„жәҗзҡ„и°ғеәҰе’ҢжңҚеҠЎзҡ„зЁіе®ҡжҖ§гҖӮ 3. **APIжқғйҷҗз®ЎзҗҶ**пјҡ - еҜ№APIи®ҝй—®иҝӣиЎҢжқғйҷҗжҺ§еҲ¶пјҢ...

гҖҠйҮ‘иһҚзә§дә‘еҺҹз”ҹPaaSжҺўзҙўдёҺе®һи·өгҖӢзҡ„и®Іи§Јж¶өзӣ–дәҶйҮ‘иһҚиЎҢдёҡеңЁдә‘еҺҹз”ҹе№іеҸ°еҚіжңҚеҠЎпјҲPaaSпјүйўҶеҹҹзҡ„ж·ұе…ҘжҺўи®ЁпјҢж—ЁеңЁдјҳеҢ–дёҡеҠЎиғҢжҷҜгҖҒе®һзҺ°еӨҡйӣҶзҫӨз®ЎжҺ§д»ҘеҸҠжү“йҖ й«ҳж•ҲеҸ‘еёғиҝҗз»ҙдҪ“зі»гҖӮ йҰ–е…ҲпјҢдёҡеҠЎиғҢжҷҜйғЁеҲҶйҳҗиҝ°дәҶйҮ‘иһҚдёҡеҠЎзҡ„жј”еҸҳиҝҮзЁӢгҖӮйҡҸзқҖ...

- **зЁіе®ҡжҖ§**пјҡзӣ‘жөӢе’ҢдјҳеҢ–е®№еҷЁйӣҶзҫӨжҖ§иғҪпјҢзЎ®дҝқжңҚеҠЎзҡ„й«ҳеҸҜз”ЁжҖ§пјҢе»әз«Ӣж•…йҡңжҒўеӨҚжңәеҲ¶гҖӮ - **еҗҲ规жҖ§**пјҡз¬ҰеҗҲзӣ‘з®ЎиҰҒжұӮпјҢзЎ®дҝқж•°жҚ®йҡҗз§Ғе’ҢеҗҲ规ж“ҚдҪңпјҢеҰӮж•°жҚ®еҠ еҜҶе’Ңе®Ўи®Ўж—Ҙеҝ—и®°еҪ•гҖӮ - **зүҲжң¬жҺ§еҲ¶**пјҡе®һиЎҢдёҘж јзҡ„д»Јз ҒзүҲжң¬жҺ§еҲ¶пјҢ...

Amazonзҡ„жЁЎејҸжӣҙеҖҫеҗ‘дәҺдј з»ҹзҡ„иҷҡжӢҹжңәпјҢиҖҢGoogleеҲҷеҖҫеҗ‘дәҺдҪҝз”Ёе®№еҷЁйӣҶзҫӨжҠҖжңҜпјҲеҰӮKubernetesпјүпјҢе°ҶеӨ§йҮҸе°ҸеһӢе®№еҷЁз»„еҗҲеңЁдёҖиө·пјҢеҪўжҲҗеӨ§еһӢзҡ„еә”з”ЁжңҚеҠЎйӣҶзҫӨгҖӮ жҖ»зҡ„жқҘиҜҙпјҢе®№еҷЁжҠҖжңҜжӯЈеңЁж·ұеҲ»ж”№еҸҳдә‘и®Ўз®—зҡ„йқўиІҢпјҢжҺЁеҠЁзқҖжӣҙеҠ зҒөжҙ»гҖҒй«ҳж•Ҳ...

з»јдёҠжүҖиҝ°пјҢж–ҮжЎЈдёӯжҸҗеҲ°зҡ„вҖңе®№еҷЁдә‘еңЁд»Ҡж—ҘеӨҙжқЎзҡ„иҗҪең°е’Ңе®һи·өвҖқж¶үеҸҠдәҶе®№еҷЁдә‘жҠҖжңҜеңЁе®һйҷ…дјҒдёҡзҺҜеўғдёӯзҡ„еӨҡз§Қеә”з”ЁпјҢеҢ…жӢ¬PaaSе’ҢIaaSзҡ„з»“еҗҲдҪҝз”ЁгҖҒжәҗд»Јз Ғз®ЎзҗҶгҖҒKubernetesйӣҶзҫӨз®ЎзҗҶгҖҒз»ҶзІ’еәҰиө„жәҗжҺ§еҲ¶е’ҢеӨ„зҗҶеҷЁиө„жәҗеҲҶй…ҚзӯүеӨҡдёӘж–№йқўгҖӮ...

жӯӨеӨ–пјҢе®№еҷЁжҠҖжңҜеҰӮLXCгҖҒWardenе’ҢDockerзҡ„еҸ‘еұ•пјҢдҪҝеҫ—еә”з”Ёд»Һзі»з»ҹеұӮйқўйҖҗжёҗжј”иҝӣдёәжңҚеҠЎеҢ–зҡ„еҪўжҖҒпјҢжӣҙдҫҝдәҺз®ЎзҗҶе’ҢйӣҶзҫӨеҢ–ж“ҚдҪңгҖӮ PaaSе№іеҸ°жҸҗдҫӣдәҶд»Ҙеә”з”Ёдёәдёӯеҝғзҡ„ејҖеҸ‘гҖҒжөӢиҜ•гҖҒйғЁзҪІе’Ңиҝҗз»ҙе…Ёз”ҹе‘Ҫе‘Ёжңҹз®ЎзҗҶгҖӮејҖеҸ‘зҺҜиҠӮпјҢе№іеҸ°ж”ҜжҢҒжҢҒз»ӯ...

### дјҒдёҡPaaSйҖҡз”ЁиғҪеҠӣе№іеҸ°и§ЈеҶіж–№жЎҲ #### дёҖгҖҒеј•иЁҖ йҡҸзқҖдҝЎжҒҜжҠҖжңҜзҡ„еҝ«йҖҹеҸ‘еұ•пјҢдјҒдёҡеҜ№дҝЎжҒҜеҢ–е»әи®ҫзҡ„йңҖжұӮж—ҘзӣҠеўһеҠ пјҢзү№еҲ«жҳҜеңЁдә‘и®Ўз®—йўҶеҹҹпјҢи¶ҠжқҘи¶ҠеӨҡзҡ„дјҒдёҡйҖүжӢ©йҮҮз”ЁPaaSпјҲе№іеҸ°еҚіжңҚеҠЎпјүжқҘжһ„е»әиҮӘе·ұзҡ„еә”з”Ёе’ҢжңҚеҠЎгҖӮжң¬и§ЈеҶіж–№жЎҲ...

ж–°жҷәи¶…и„‘PaaSдә‘е№іеҸ°жҳҜдёҖж¬ҫеҹәдәҺKubernetesжһ„е»әзҡ„дјҒдёҡзә§е®№еҷЁдә‘е№іеҸ°пјҢж—ЁеңЁдёәдјҒдёҡжҸҗдҫӣйӣҶдёӯзҡ„еә”з”Ёз®ЎзҗҶе’ҢдәӨд»ҳи§ЈеҶіж–№жЎҲгҖӮиҜҘе№іеҸ°е……еҲҶеҲ©з”ЁDockerзӯүе®№еҷЁжҠҖжңҜпјҢе®һзҺ°дәҶиҪ»йҮҸзә§иҷҡжӢҹеҢ–гҖҒеҫ®жңҚеҠЎжһ¶жһ„гҖҒDevOpsжөҒзЁӢд»ҘеҸҠжҢҒз»ӯдәӨд»ҳзӯүеҠҹиғҪпјҢ...