пјҲеӣҫзүҮжқҘжәҗпјҡhttps://github.com/Netflix/Hystrix/wikiпјү

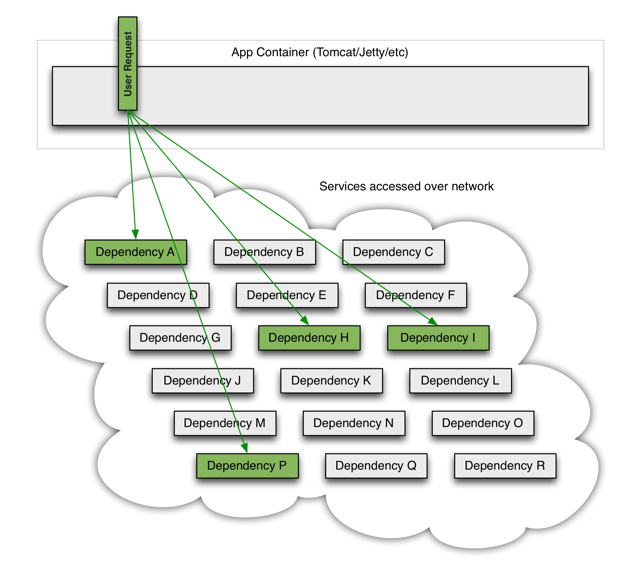

然иҖҢд»»дҪ•дёҖдёӘжңҚеҠЎзҡ„еҸҜз”ЁжҖ§йғҪдёҚжҳҜ 100% зҡ„пјҢзҪ‘з»ңдәҰжҳҜи„Ҷејұзҡ„гҖӮеҪ“жҲ‘дҫқиө–зҡ„жҹҗдёӘжңҚеҠЎдёҚеҸҜз”Ёзҡ„ж—¶еҖҷпјҢжҲ‘иҮӘиә«жҳҜеҗҰдјҡиў«жӢ–жӯ»пјҹеҪ“зҪ‘з»ңдёҚзЁіе®ҡзҡ„ж—¶еҖҷпјҢжҲ‘иҮӘиә«жҳҜеҗҰдјҡиў«жӢ–жӯ»пјҹиҝҷдәӣеңЁеҚ•жңәзҺҜеўғдёӢдёҚеӨӘйңҖиҰҒиҖғиҷ‘зҡ„й—® йўҳпјҢеңЁеҲҶеёғејҸзҺҜеўғдёӢе°ұдёҚеҫ—дёҚиҖғиҷ‘дәҶгҖӮеҒҮи®ҫжҲ‘жңү5дёӘдҫқиө–зҡ„жңҚеҠЎпјҢ他们зҡ„еҸҜз”ЁжҖ§йғҪжҳҜ99.95%пјҢеҚідёҖе№ҙдёҚеҸҜз”Ёж—¶й—ҙзәҰдёә4дёӘеӨҡе°Ҹж—¶пјҢйӮЈд№ҲжҳҜеҗҰж„Ҹе‘ізқҖжҲ‘зҡ„еҸҜз”ЁжҖ§ жңҖеӨҡе°ұжҳҜ 99.95% зҡ„5ж¬Ўж–№пјҢ99.75%пјҲиҝ‘д№ҺдёҖеӨ©пјүпјҢеҶҚеҠ дёҠзҪ‘з»ңдёҚзЁіе®ҡеӣ зҙ гҖҒдҫқиө–жңҚеҠЎеҸҜиғҪжӣҙеӨҡпјҢеҸҜз”ЁжҖ§дјҡжӣҙдҪҺгҖӮиҖғиҷ‘еҲ°жүҖдҫқиө–зҡ„жңҚеҠЎеҝ…е®ҡдјҡеңЁжҹҗдәӣж—¶й—ҙдёҚеҸҜз”ЁпјҢиҖғиҷ‘еҲ°зҪ‘з»ңеҝ… е®ҡдјҡдёҚзЁіе®ҡпјҢжҲ‘们еә”иҜҘжҖҺд№Ҳи®ҫи®ЎиҮӘиә«жңҚеҠЎпјҹеҚіпјҢжҖҺд№ҲдёәеҮәй”ҷи®ҫи®Ўпјҹ

Michael T. Nygard еңЁеңЁзІҫеҪ©зҡ„гҖҠRelease It!гҖӢдёҖд№ҰдёӯжҖ»з»“дәҶеҫҲеӨҡжҸҗй«ҳзі»з»ҹеҸҜз”ЁжҖ§зҡ„жЁЎејҸпјҢе…¶дёӯйқһеёёйҮҚиҰҒзҡ„дёӨжқЎжҳҜпјҡ

- дҪҝз”Ёи¶…ж—¶

- дҪҝз”Ёж–ӯи·ҜеҷЁ

第дёҖжқЎпјҢйҖҡиҝҮзҪ‘з»ңи°ғз”ЁеӨ–йғЁдҫқиө–жңҚеҠЎзҡ„ж—¶еҖҷпјҢйғҪеҝ…йЎ»еә”иҜҘи®ҫзҪ®и¶…ж—¶гҖӮеңЁеҒҘеә·зҡ„жғ…еҶөдёӢпјҢдёҖиҲ¬еұҖеҹҹеҫҖзҡ„дёҖж¬ЎиҝңзЁӢи°ғз”ЁеңЁеҮ еҚҒжҜ«з§’еҶ…е°ұиҝ”еӣһдәҶпјҢдҪҶжҳҜеҪ“зҪ‘з»ңжӢҘе өзҡ„ ж—¶еҖҷпјҢжҲ–иҖ…жүҖдҫқиө–жңҚеҠЎдёҚеҸҜз”Ёзҡ„ж—¶еҖҷпјҢиҝҷдёӘж—¶й—ҙеҸҜиғҪжҳҜеҘҪеӨҡз§’пјҢжҲ–иҖ…еҺӢж №е°ұеғөжӯ»дәҶгҖӮйҖҡеёёжғ…еҶөдёӢпјҢдёҖж¬ЎиҝңзЁӢи°ғз”ЁеҜ№еә”дәҶдёҖдёӘзәҝзЁӢжҲ–иҖ…иҝӣзЁӢпјҢеҰӮжһңе“Қеә”еӨӘж…ўпјҢжҲ–иҖ…еғөжӯ» дәҶпјҢйӮЈдёҖдёӘиҝӣзЁӢ/зәҝзЁӢпјҢе°ұиў«жӢ–жӯ»пјҢзҹӯж—¶й—ҙеҶ…еҫ—дёҚеҲ°йҮҠж”ҫпјҢиҖҢиҝӣзЁӢ/зәҝзЁӢйғҪеҜ№еә”дәҶзі»з»ҹиө„жәҗпјҢиҝҷе°ұзӯүдәҺиҜҙжҲ‘иҮӘиә«жңҚеҠЎиө„жәҗдјҡиў«иҖ—е°ҪпјҢеҜјиҮҙиҮӘиә«жңҚеҠЎдёҚеҸҜз”ЁгҖӮеҒҮи®ҫжҲ‘зҡ„ жңҚеҠЎдҫқиө–дәҺеҫҲеӨҡжңҚеҠЎпјҢе…¶дёӯдёҖдёӘйқһж ёеҝғзҡ„дҫқиө–еҰӮжһңдёҚеҸҜз”ЁпјҢиҖҢдё”жІЎжңүи¶…ж—¶жңәеҲ¶пјҢйӮЈд№ҲиҝҷдёӘйқһж ёеҝғдҫқиө–е°ұиғҪжӢ–жӯ»жҲ‘зҡ„жңҚеҠЎпјҢе°Ҫз®ЎзҗҶи®әдёҠеҚідҪҝжІЎжңүе®ғжҲ‘еңЁеӨ§йғЁеҲҶжғ…еҶөиҝҳиғҪ еҒҘеә·иҝҗиҪ¬зҡ„гҖӮ

ж–ӯи·ҜеҷЁе…¶е®һжҲ‘们еӨ§е®¶йғҪдёҚйҷҢз”ҹпјҲдҪ дјҡжҚўдҝқйҷ©дёқд№ҲпјҹпјүпјҢеҰӮжһңдҪ 家没жңүж–ӯи·ҜеҷЁпјҢеҪ“з”өжөҒиҝҮиҪҪпјҢжҲ–иҖ…зҹӯи·Ҝзҡ„ж—¶еҖҷпјҢз”өи·ҜдёҚж–ӯејҖпјҢз”өзәҝе°ұдјҡеҚҮжё©пјҢйҖ жҲҗзҒ«зҒҫпјҢзғ§жҺүжҲҝеӯҗгҖӮжңүдәҶж–ӯи·ҜеҷЁд№ӢеҗҺпјҢз”өжөҒиҝҮиҪҪзҡ„ж—¶еҖҷпјҢдҝқйҷ©дёқе°ұдјҡйҰ–е…Ҳзғ§жҺүпјҢж–ӯејҖз”өи·ҜпјҢдёҚиҮідәҺеј•иө·жӣҙеӨ§зҡ„зҒҫйҡҫпјҲеҸӘдёҚиҝҮиҝҷдёӘж—¶еҖҷдҪ еҫ—жҚўдҝқйҷ©дёқпјүгҖӮ

еҪ“жҲ‘们зҡ„жңҚеҠЎи®ҝй—®жҹҗйЎ№дҫқиө–жңүеӨ§йҮҸи¶…ж—¶зҡ„ж—¶еҖҷпјҢеҶҚи®©ж–°зҡ„иҜ·жұӮеҺ»и®ҝй—®е·Із»ҸжІЎжңүеӨӘеӨ§ж„Ҹд№үпјҢйӮЈеҸӘдјҡж— и°“зҡ„ж¶ҲиҖ—зҺ°жңүиө„жәҗгҖӮеҚідҪҝдҪ е·Із»Ҹи®ҫзҪ®и¶…ж—¶1з§’дәҶпјҢйӮЈжҳҺзҹҘдҫқ иө–дёҚеҸҜз”Ёзҡ„жғ…еҶөдёӢеҶҚи®©жӣҙеӨҡзҡ„иҜ·жұӮпјҢжҜ”еҰӮ100дёӘпјҢеҺ»и®ҝй—®иҝҷдёӘдҫқиө–пјҢд№ҹдјҡеҜјиҮҙ100дёӘзәҝзЁӢ1з§’зҡ„иө„жәҗжөӘиҙ№гҖӮиҝҷдёӘж—¶еҖҷпјҢж–ӯи·ҜеҷЁе°ұиғҪеё®еҠ©жҲ‘们йҒҝе…Қиҝҷз§Қиө„жәҗжөӘиҙ№пјҢ еңЁиҮӘиә«жңҚеҠЎе’Ңдҫқиө–д№Ӣй—ҙж”ҫдёҖдёӘж–ӯи·ҜеҷЁпјҢе®һж—¶з»ҹи®Ўи®ҝй—®зҡ„зҠ¶жҖҒпјҢеҪ“и®ҝй—®и¶…ж—¶жҲ–иҖ…еӨұиҙҘиҫҫеҲ°жҹҗдёӘйҳҲеҖјзҡ„ж—¶еҖҷпјҲеҰӮ50%иҜ·жұӮи¶…ж—¶пјҢжҲ–иҖ…иҝһз»ӯ20ж¬ЎиҜ·еӨұиҙҘпјүпјҢе°ұжү“ејҖж–ӯи·Ҝ еҷЁпјҢйӮЈд№ҲеҗҺз»ӯзҡ„иҜ·жұӮе°ұзӣҙжҺҘиҝ”еӣһеӨұиҙҘпјҢдёҚиҮідәҺжөӘиҙ№иө„жәҗгҖӮж–ӯи·ҜеҷЁеҶҚж №жҚ®дёҖдёӘж—¶й—ҙй—ҙйҡ”пјҲеҰӮ5еҲҶй’ҹпјүе°қиҜ•е…ій—ӯж–ӯи·ҜеҷЁпјҲжҲ–иҖ…жӣҙжҚўдҝқйҷ©дёқпјүпјҢзңӢдҫқиө–жҳҜеҗҰжҒўеӨҚжңҚеҠЎдәҶгҖӮ

и¶…ж—¶жңәеҲ¶е’Ңж–ӯи·ҜеҷЁиғҪеӨҹеҫҲеҘҪзҡ„дҝқжҠӨжҲ‘们зҡ„жңҚеҠЎпјҢдёҚеҸ—дҫқиө–жңҚеҠЎдёҚеҸҜз”Ёзҡ„еҪұе“ҚеӨӘеӨ§пјҢе…·дҪ“еҸҜд»ҘеҸӮзңӢж–Үз« гҖҠ дҪҝз”ЁзҶ”ж–ӯеҷЁи®ҫи®ЎжЁЎејҸдҝқжҠӨиҪҜ件гҖӢгҖӮ然иҖҢе…·дҪ“е®һзҺ°иҝҷдёӨдёӘжЁЎејҸиҝҳжҳҜжңүдёҖе®ҡзҡ„еӨҚжқӮеәҰзҡ„пјҢжүҖе№ё Netflix ејҖжәҗзҡ„В HystrixжЎҶжһ¶В её®жҲ‘们еӨ§еӨ§з®ҖеҢ–дәҶи¶…ж—¶жңәеҲ¶е’Ңж–ӯи·ҜеҷЁзҡ„е®һзҺ°пјҢHystrixпјҡдҫӣеҲҶеёғејҸзі»з»ҹдҪҝз”ЁпјҢжҸҗдҫӣ延иҝҹе’Ңе®№й”ҷеҠҹиғҪпјҢйҡ”зҰ»иҝңзЁӢзі»з»ҹгҖҒи®ҝй—®е’Ң第дёүж–№зЁӢеәҸеә“зҡ„и®ҝй—®зӮ№пјҢйҳІжӯўзә§иҒ”еӨұиҙҘпјҢдҝқиҜҒеӨҚжқӮзҡ„еҲҶеёғзі»з»ҹеңЁйқўдёҙдёҚеҸҜйҒҝе…Қзҡ„еӨұиҙҘж—¶пјҢд»ҚиғҪжңүе…¶еј№жҖ§гҖӮеңЁCodeplexдёҠжңүдёҖдёӘ.NETзҡ„移жӨҚзүҲжң¬https://hystrixnet.codeplex.com/ гҖӮ

дҪҝз”ЁHystrixпјҢйңҖиҰҒйҖҡиҝҮCommandе°ҒиЈ…еҜ№иҝңзЁӢдҫқиө–зҡ„и°ғз”Ёпјҡ

public class GetCurrentTimeCommand : HystrixCommand<long>

{

private static long currentTimeCache;

В

public GetCurrentTimeCommand()

: base(HystrixCommandSetter.WithGroupKey("TimeGroup")

.AndCommandKey("GetCurrentTime")

.AndCommandPropertiesDefaults(new HystrixCommandPropertiesSetter().WithExecutionIsolationThreadTimeout(TimeSpan.FromSeconds(1.0)).WithExecutionIsolationThreadInterruptOnTimeout(true)))

{

}

В

protected override long Run()

{

using (WebClient wc = new WebClient())

{

string content = wc.DownloadString("http://tycho.usno.navy.mil/cgi-bin/time.pl");

XDocument document = XDocument.Parse(content);

currentTimeCache = long.Parse(document.Element("usno").Element("t").Value);

return currentTimeCache;

}

}

В

protected override long GetFallback()

{

return currentTimeCache;

}

}

然еҗҺеңЁйңҖиҰҒзҡ„ж—¶еҖҷи°ғз”ЁиҝҷдёӘCommandпјҡ

GetCurrentTimeCommand command = new GetCurrentTimeCommand();

long currentTime = command.Execute();

дёҠиҝ°жҳҜеҗҢжӯҘи°ғз”ЁпјҢеҪ“然еҰӮжһңдёҡеҠЎйҖ»иҫ‘е…Ғи®ёдё”жӣҙиҝҪжұӮжҖ§иғҪпјҢжҲ–и®ёеҸҜд»ҘйҖүжӢ©ејӮжӯҘи°ғз”Ёпјҡ

иҜҘдҫӢдёӯпјҢдёҚи®ә WebClient. DownloadString () иҮӘиә«жңүжІЎжңүи¶…ж—¶жңәеҲ¶пјҲеҸҜиғҪдҪ дјҡеҸ‘зҺ°еҫҲеӨҡиҝңзЁӢи°ғз”ЁжҺҘеҸЈиҮӘиә«е№¶жІЎжңүз»ҷдҪ жҸҗдҫӣи¶…ж—¶жңәеҲ¶пјүпјҢз”Ё HystrixCommand е°ҒиЈ…иҝҮеҗҺпјҢи¶…ж—¶жҳҜејәеҲ¶зҡ„пјҢй»ҳи®Өи¶…ж—¶ж—¶й—ҙжҳҜ1з§’пјҢеҪ“然дҪ еҸҜд»Ҙж №жҚ®йңҖиҰҒиҮӘе·ұеңЁжһ„йҖ еҮҪж•°дёӯи°ғиҠӮ Command зҡ„и¶…ж—¶ж—¶й—ҙпјҢдҫӢеҰӮиҜҙ2з§’пјҡ

HystrixCommandSetter.WithGroupKey("TimeGroup")

.AndCommandKey("GetCurrentTime")

.AndCommandPropertiesDefaults(new HystrixCommandPropertiesSetter().WithExecutionIsolationThreadTimeout(TimeSpan.FromSeconds(2.0)).WithExecutionIsolationThreadInterruptOnTimeout(true))

еҪ“Hystrixжү§иЎҢе‘Ҫд»Өи¶…ж—¶еҗҺпјҢHystrix жү§иЎҢе‘Ҫд»Өи¶…ж—¶жҲ–иҖ…еӨұиҙҘд№ӢеҗҺпјҢжҳҜдјҡе°қиҜ•еҺ»и°ғз”ЁдёҖдёӘ fallback зҡ„пјҢиҝҷдёӘ fallback еҚідёҖдёӘеӨҮз”Ёж–№жЎҲпјҢиҰҒдёә HystrixCommand жҸҗдҫӣ fallbackпјҢеҸӘиҰҒйҮҚеҶҷ protected virtual R GetFallback()ж–№жі•еҚіеҸҜгҖӮ

дёҖиҲ¬жғ…еҶөдёӢпјҢHystrix дјҡдёә Command еҲҶй…Қдё“й—Ёзҡ„зәҝзЁӢжұ пјҢжұ дёӯзҡ„зәҝзЁӢж•°йҮҸжҳҜеӣәе®ҡзҡ„пјҢиҝҷд№ҹжҳҜдёҖдёӘдҝқжҠӨжңәеҲ¶пјҢеҒҮи®ҫдҪ дҫқиө–еҫҲеӨҡдёӘжңҚеҠЎпјҢдҪ дёҚеёҢжңӣеҜ№е…¶дёӯдёҖдёӘжңҚеҠЎзҡ„и°ғз”Ёж¶ҲиҖ—иҝҮеӨҡзҡ„зәҝзЁӢд»ҘиҮҙдәҺе…¶д»–жңҚеҠЎйғҪжІЎ зәҝзЁӢи°ғз”ЁдәҶгҖӮй»ҳи®ӨиҝҷдёӘзәҝзЁӢжұ зҡ„еӨ§е°ҸжҳҜ10пјҢеҚіе№¶еҸ‘жү§иЎҢзҡ„е‘Ҫд»ӨжңҖеӨҡеҸӘиғҪжңүжҳҜдёӘдәҶпјҢи¶…иҝҮиҝҷдёӘж•°йҮҸзҡ„и°ғз”Ёе°ұеҫ—жҺ’йҳҹпјҢеҰӮжһңйҳҹдјҚеӨӘй•ҝдәҶпјҲй»ҳи®Өи¶…иҝҮ 5пјүпјҢHystrixе°ұз«ӢеҲ»иө° fallback жҲ–иҖ…жҠӣејӮеёёгҖӮ

ж №жҚ®дҪ зҡ„е…·дҪ“йңҖиҰҒпјҢдҪ еҸҜиғҪдјҡжғіиҰҒи°ғж•ҙжҹҗдёӘCommandзҡ„зәҝзЁӢжұ еӨ§е°ҸпјҢдҫӢеҰӮдҪ еҜ№жҹҗдёӘдҫқиө–зҡ„и°ғз”Ёе№іеқҮе“Қеә”ж—¶й—ҙдёә200msпјҢиҖҢеі°еҖјзҡ„QPSжҳҜ200пјҢйӮЈд№ҲиҝҷдёӘ并еҸ‘иҮіе°‘е°ұжҳҜ 0.2 x 200 = 40 (Little's Law)пјҢиҖғиҷ‘еҲ°дёҖе®ҡзҡ„е®ҪжқҫеәҰпјҢиҝҷдёӘзәҝзЁӢжұ зҡ„еӨ§е°Ҹи®ҫзҪ®дёә60еҸҜиғҪжҜ”иҫғеҗҲйҖӮпјҡ

public GetCurrentTimeCommand()

: base(HystrixCommandSetter.WithGroupKey("TimeGroup")

.AndCommandKey("GetCurrentTime")

.AndCommandPropertiesDefaults(new HystrixCommandPropertiesSetter().WithExecutionIsolationThreadTimeout(TimeSpan.FromSeconds(1.0)).WithExecutionIsolationThreadInterruptOnTimeout(true))

.AndThreadPoolPropertiesDefaults(new HystrixThreadPoolPropertiesSetter().WithCoreSize(60) // size of thread pool

.WithKeepAliveTime(TimeSpan.FromMinutes(1.0)) // minutes to keep a thread alive (though in practice this doesn't get used as by default we set a fixed size)

.WithMaxQueueSize(100) // size of queue (but we never allow it to grow this big ... this can't be dynamically changed so we use 'queueSizeRejectionThreshold' to artificially limit and reject)

.WithQueueSizeRejectionThreshold(10) // number of items in queue at which point we reject (this can be dyamically changed)

.WithMetricsRollingStatisticalWindow(10000) // milliseconds for rolling number

.WithMetricsRollingStatisticalWindowBuckets(10)))

{

}

иҜҙдәҶиҝҷд№ҲеӨҡпјҢиҝҳжІЎжҸҗеҲ°Hystrixзҡ„ж–ӯи·ҜеҷЁпјҢе…¶е®һеҜ№дәҺдҪҝз”ЁиҖ…жқҘиҜҙпјҢж–ӯи·ҜеҷЁжңәеҲ¶й»ҳи®ӨжҳҜеҗҜз”Ёзҡ„пјҢдҪҶжҳҜзј–зЁӢжҺҘеҸЈй»ҳи®ӨеҮ д№ҺдёҚйңҖиҰҒе…іеҝғиҝҷдёӘпјҢжңәеҲ¶е’ҢеүҚйқўи®Ізҡ„ д№ҹе·®дёҚеӨҡпјҢHystrixдјҡз»ҹи®Ўе‘Ҫд»Өи°ғз”ЁпјҢзңӢе…¶дёӯеӨұиҙҘзҡ„жҜ”дҫӢпјҢй»ҳи®ӨеҪ“и¶…иҝҮ50%еӨұиҙҘеҗҺпјҢејҖеҗҜж–ӯи·ҜеҷЁпјҢйӮЈд№ӢеҗҺдёҖж®өж—¶й—ҙзҡ„е‘Ҫд»Өи°ғз”ЁзӣҙжҺҘиҝ”еӣһеӨұиҙҘпјҲжҲ–иҖ…иө° fallbackпјүпјҢ5з§’д№ӢеҗҺпјҢHystrixеҶҚе°қиҜ•е…ій—ӯж–ӯи·ҜеҷЁпјҢзңӢзңӢиҜ·жұӮжҳҜеҗҰиғҪжӯЈеёёе“Қеә”гҖӮдёӢйқўзҡ„еҮ иЎҢHystrixжәҗз Ғеұ•зӨәдәҶе®ғеҰӮдҪ•з»ҹи®ЎеӨұиҙҘзҺҮзҡ„пјҡ

public HealthCounts GetHealthCounts()

{

// we put an interval between snapshots so high-volume commands don't

// spend too much unnecessary time calculating metrics in very small time periods

long lastTime = this.lastHealthCountsSnapshot;

long currentTime = ActualTime.CurrentTimeInMillis;

if (currentTime - lastTime >= this.properties.MetricsHealthSnapshotInterval.Get().TotalMilliseconds || this.healthCountsSnapshot == null)

{

if (Interlocked.CompareExchange(ref this.lastHealthCountsSnapshot, currentTime, lastTime) == lastTime)

{

// our thread won setting the snapshot time so we will proceed with generating a new snapshot

// losing threads will continue using the old snapshot

long success = counter.GetRollingSum(HystrixRollingNumberEvent.Success);

long failure = counter.GetRollingSum(HystrixRollingNumberEvent.Failure); // fallbacks occur on this

long timeout = counter.GetRollingSum(HystrixRollingNumberEvent.Timeout); // fallbacks occur on this

long threadPoolRejected = counter.GetRollingSum(HystrixRollingNumberEvent.ThreadPoolRejected); // fallbacks occur on this

long semaphoreRejected = counter.GetRollingSum(HystrixRollingNumberEvent.SemaphoreRejected); // fallbacks occur on this

long shortCircuited = counter.GetRollingSum(HystrixRollingNumberEvent.ShortCircuited); // fallbacks occur on this

long totalCount = failure + success + timeout + threadPoolRejected + shortCircuited + semaphoreRejected;

long errorCount = failure + timeout + threadPoolRejected + shortCircuited + semaphoreRejected;

healthCountsSnapshot = new HealthCounts(totalCount, errorCount); }

}

return healthCountsSnapshot;

}

е…¶дёӯ failure иЎЁзӨәе‘Ҫд»Өжң¬иә«еҸ‘з”ҹй”ҷиҜҜгҖҒsuccess иҮӘ然дёҚеҝ…иҜҙпјҢtimeout жҳҜи¶…ж—¶гҖҒthreadPoolRejected иЎЁзӨәеҪ“зәҝзЁӢжұ ж»ЎеҗҺжӢ’з»қзҡ„е‘Ҫд»Өи°ғз”ЁгҖҒshortCircuited иЎЁзӨәж–ӯи·ҜеҷЁжү“ејҖеҗҺжӢ’з»қзҡ„е‘Ҫд»Өи°ғз”ЁпјҢsemaphoreRejected дҪҝз”ЁдҝЎеҸ·йҮҸжңәеҲ¶пјҲиҖҢдёҚжҳҜзәҝзЁӢжұ пјүжӢ’з»қзҡ„е‘Ҫд»Өи°ғз”ЁгҖӮ

В

В

http://www.cnblogs.com/shanyou/p/4752226.html

зӣёе…іжҺЁиҚҗ

з»јдёҠжүҖиҝ°пјҢHystrixйҖҡиҝҮдёҖзі»еҲ—зІҫеҝғи®ҫи®Ўзҡ„еҺҹеҲҷе’ҢжңәеҲ¶пјҢжңүж•Ҳең°и§ЈеҶідәҶеҲҶеёғејҸзі»з»ҹдёӯзҡ„еҸҜз”ЁжҖ§жҢ‘жҲҳпјҢжҸҗй«ҳдәҶзі»з»ҹзҡ„еҒҘеЈ®жҖ§е’ҢзЁіе®ҡжҖ§гҖӮеңЁе®һйҷ…йЎ№зӣ®дёӯпјҢдҪҝз”ЁHystrixеҸҜд»ҘжһҒеӨ§ең°з®ҖеҢ–жңҚеҠЎе®№й”ҷе’Ңй«ҳеҸҜз”ЁжҖ§зҡ„е®һзҺ°пјҢеҮҸе°‘еӣ дҫқиө–жңҚеҠЎж•…йҡң...

гҖҠHystrix Dashboard 1.5.12пјҡжһ„е»ә...еҜ№дәҺJavaејҖеҸ‘иҖ…иҖҢиЁҖпјҢжҺҢжҸЎHystrix Dashboard зҡ„дҪҝз”ЁпјҢиғҪеӨҹжҸҗеҚҮзі»з»ҹзҡ„зЁіе®ҡжҖ§пјҢзЎ®дҝқжңҚеҠЎзҡ„й«ҳеҸҜз”ЁжҖ§гҖӮеҗҢж—¶пјҢдәҶи§Је…¶иғҢеҗҺзҡ„е·ҘдҪңеҺҹзҗҶпјҢжңүеҠ©дәҺжҲ‘们еңЁйҒҮеҲ°еӨҚжқӮзі»з»ҹй—®йўҳж—¶пјҢиҝ…йҖҹе®ҡдҪҚ并解еҶігҖӮ

Hystrix жҳҜдёҖдёӘз”ұ Netflix ејҖеҸ‘并ејҖжәҗзҡ„е®№й”ҷеә“пјҢе®ғж—ЁеңЁйҖҡиҝҮж·»еҠ 延иҝҹе®№еҝҚе’Ңе®№й”ҷйҖ»иҫ‘жқҘйҡ”зҰ»жңҚеҠЎд№Ӣй—ҙзҡ„дәӨдә’пјҢд»ҺиҖҢжҸҗй«ҳзі»з»ҹзҡ„ж•ҙдҪ“еј№жҖ§е’ҢжҖ§иғҪгҖӮеңЁеҲҶеёғејҸзі»з»ҹдёӯпјҢжңҚеҠЎд№Ӣй—ҙйҖҡеёёдјҡйҖҡиҝҮзҪ‘з»ңиҝӣиЎҢйҖҡдҝЎгҖӮ然иҖҢпјҢзҪ‘з»ң延иҝҹгҖҒж•…йҡң...

### HystrixзҶ”ж–ӯеҷЁз®Җд»ӢеҸҠе…¶е·ҘдҪңеҺҹзҗҶ #### дёҖгҖҒHystrixжҰӮеҝөдёҺиғҢжҷҜ ...жҖ»д№ӢпјҢHystrix дҪңдёәдёҖз§ҚејәеӨ§зҡ„е·Ҙе…·пјҢдёҚд»…иғҪеӨҹжңүж•ҲйҳІжӯўжңҚеҠЎйӣӘеҙ©ж•Ҳеә”пјҢиҝҳиғҪжҸҗй«ҳзі»з»ҹзҡ„ж•ҙдҪ“еҒҘеЈ®жҖ§е’ҢеҸҜз”ЁжҖ§пјҢжҳҜжһ„е»әзЁіеҒҘеҲҶеёғејҸзі»з»ҹзҡ„еҝ…еӨҮ组件д№ӢдёҖгҖӮ

Spring Cloud жҸҗдҫӣдәҶж–ӯи·ҜеҷЁжЁЎејҸзҡ„е®һзҺ°пјҢеҗҚдёә HystrixпјҢз”ЁдәҺйҳІжӯўжңҚеҠЎй—ҙзҡ„зә§иҒ”ж•…йҡңпјҢжҸҗй«ҳзі»з»ҹзҡ„е®№й”ҷжҖ§гҖӮж–ӯи·ҜеҷЁжЁЎејҸзҡ„ж ёеҝғжҖқжғіжҳҜеңЁи°ғз”ЁиҝңзЁӢжңҚеҠЎж—¶пјҢйҖҡиҝҮдёҖдёӘдёӯй—ҙеұӮпјҲеҚіж–ӯи·ҜеҷЁпјүжқҘзӣ‘жҺ§и°ғз”Ёзҡ„еҒҘеә·зҠ¶еҶөгҖӮеҪ“жңҚеҠЎеҮәзҺ°ж•…йҡңж—¶...

иҜ·жұӮзј“еӯҳжңәеҲ¶е…Ғи®ёе°ҶжңҖиҝ‘иҜ·жұӮзҡ„з»“жһңеӯҳеӮЁиө·жқҘпјҢеҪ“жҺҘ收еҲ°зӣёеҗҢзҡ„иҜ·жұӮж—¶пјҢеҸҜд»ҘзӣҙжҺҘд»Һзј“еӯҳдёӯиҜ»еҸ–з»“жһңиҖҢдёҚжҳҜйҮҚж–°еҸ‘иө·зҪ‘з»ңи°ғз”ЁпјҢиҝҷжңүеҠ©дәҺеҮҸе°‘дёҚеҝ…иҰҒзҡ„зҪ‘з»ңдәӨдә’пјҢжҸҗй«ҳзі»з»ҹзҡ„е“Қеә”йҖҹеәҰгҖӮ ##### 2.4 иҜ·жұӮжү№еӨ„зҗҶ Hystrixиҝҳж”ҜжҢҒ...

жҖ»з»“пјҢHystrixйҖҡиҝҮHystrixCommandе®һзҺ°дәҶжңҚеҠЎи°ғз”Ёзҡ„е°ҒиЈ…пјҢй…ҚеҗҲдё°еҜҢзҡ„й…ҚзҪ®йҖүйЎ№пјҢиғҪеӨҹжңүж•Ҳең°йҳІжӯўжңҚеҠЎйӣӘеҙ©пјҢжҸҗй«ҳзі»з»ҹзҡ„еҒҘеЈ®жҖ§гҖӮеҗҢж—¶пјҢйҖҡиҝҮзҶ”ж–ӯе’ҢйҷҚзә§зӯ–з•ҘпјҢзЎ®дҝқдәҶеңЁжңҚеҠЎдёҚзЁіе®ҡж—¶пјҢзі»з»ҹд»ҚиғҪжҸҗдҫӣдёҖе®ҡзҡ„еҸҜз”ЁжҖ§гҖӮеңЁе®һйҷ…ејҖеҸ‘...

дёәдәҶжҸҗй«ҳзі»з»ҹзҡ„еҸҜз”ЁжҖ§е’ҢеҸҜйқ жҖ§пјҢйҖҡеёёдјҡе°ҶеҚ•дёҖзҡ„жңҚеҠЎиҝӣиЎҢйӣҶзҫӨйғЁзҪІгҖӮ然иҖҢпјҢеңЁе®һйҷ…иҝҗиЎҢиҝҮзЁӢдёӯпјҢз”ұдәҺзҪ‘з»ңж•…йҡңжҲ–жңҚеҠЎиҮӘиә«зҡ„дёҚзЁіе®ҡеӣ зҙ пјҢеҸҜиғҪдјҡеҜјиҮҙжңҚеҠЎж— жі•жӯЈеёёе“Қеә”иҜ·жұӮгҖӮиҝҷз§Қжғ…еҶөдёӢпјҢиӢҘеӨ§йҮҸиҜ·жұӮж¶Ңе…ҘпјҢе°Ҷдјҡеј•иө·жңҚеҠЎе“Қеә”...

еңЁзҺ°д»Јеҫ®жңҚеҠЎжһ¶жһ„дёӯпјҢзі»з»ҹе®№й”ҷиғҪеҠӣжҳҜиҮіе…ійҮҚиҰҒзҡ„пјҢHystrix жҳҜ Netflix ејҖжәҗзҡ„дёҖдёӘз”ЁдәҺеӨ„зҗҶеҲҶеёғејҸзі»з»ҹдёӯ延иҝҹе’Ңж•…йҡңзҡ„еә“пјҢе®ғйҖҡиҝҮйҡ”зҰ»иҜ·жұӮгҖҒйҷҚзә§зӯ–з•Ҙд»ҘеҸҠзҶ”ж–ӯжңәеҲ¶жқҘдҝқжҠӨжңҚеҠЎе…ҚеҸ—ејӮеёёзҡ„еҪұе“ҚпјҢжҸҗй«ҳзі»з»ҹзҡ„ж•ҙдҪ“еҸҜз”ЁжҖ§гҖӮ...

HystrixжҳҜNetflixејҖжәҗзҡ„дёҖдёӘз”ЁдәҺжһ„е»әеј№жҖ§еҫ®жңҚеҠЎжһ¶жһ„зҡ„еә“пјҢе®ғдё»иҰҒзӣ®ж ҮжҳҜжҸҗдҫӣе®№й”ҷжңәеҲ¶пјҢйҳІжӯўжңҚеҠЎйӣӘеҙ©пјҢзЎ®дҝқзі»з»ҹзҡ„зЁіе®ҡжҖ§е’Ңй«ҳеҸҜз”ЁжҖ§гҖӮеңЁжң¬зҜҮж–Үз« дёӯпјҢжҲ‘们е°Ҷж·ұе…Ҙеү–жһҗHystrixзҡ„е·ҘдҪңеҺҹзҗҶпјҢзҗҶи§Је…¶жү§иЎҢжөҒзЁӢпјҢ并жҺўи®Ёе…¶дёӯзҡ„...

еңЁе®һйҷ…йЎ№зӣ®дёӯпјҢеҗҲзҗҶең°й…ҚзҪ®е’ҢдҪҝз”ЁHystrixдёҚд»…иғҪжҸҗй«ҳзі»з»ҹзҡ„е®№й”ҷиғҪеҠӣпјҢиҝҳиғҪдјҳеҢ–ж•ҙдҪ“зҡ„е“Қеә”ж—¶й—ҙе’Ңиө„жәҗеҲ©з”ЁзҺҮгҖӮзҗҶ解并жҺҢжҸЎHystrixзҡ„иҝҷдәӣзү№жҖ§еҜ№дәҺејҖеҸ‘еҒҘеЈ®зҡ„еҫ®жңҚеҠЎжһ¶жһ„иҮіе…ійҮҚиҰҒгҖӮ еңЁеҺӢзј©еҢ…ж–Ү件еҲ—иЎЁдёӯзҡ„"springcloud"еҸҜиғҪ...

гҖҠзҶ”ж–ӯеҷЁHystrixпјҡеҫ®жңҚеҠЎ...жҖ»з»“жқҘиҜҙпјҢHystrixдҪңдёәеҫ®жңҚеҠЎжһ¶жһ„зҡ„йҮҚиҰҒ组件пјҢйҖҡиҝҮе…¶зӢ¬зү№зҡ„зҶ”ж–ӯгҖҒйҷҚзә§е’Ңйҡ”зҰ»жңәеҲ¶пјҢдёәжңҚеҠЎзҡ„зЁіе®ҡжҖ§е’Ңй«ҳеҸҜз”ЁжҖ§жҸҗдҫӣдәҶеқҡе®һдҝқйҡңгҖӮзҗҶ解并зҶҹз»ғиҝҗз”ЁHystrixпјҢеҜ№дәҺжһ„е»әеҒҘеЈ®зҡ„еҲҶеёғејҸзі»з»ҹиҮіе…ійҮҚиҰҒгҖӮ

е…¶жң¬иҙЁжҳҜзәҝзЁӢжІЎжңүеҸҠж—¶еӣһ收пјҢиҝҷеҸҜиғҪеҜјиҮҙзі»з»ҹиө„жәҗиҖ—е°ҪпјҢд»ҺиҖҢеҪұе“ҚжңҚеҠЎзҡ„зЁіе®ҡжҖ§е’ҢеҸҜз”ЁжҖ§гҖӮ дёәдәҶи§ЈеҶіжңҚеҠЎйӣӘеҙ©пјҢжңүеҮ з§Қеёёи§Ғзҡ„зӯ–з•ҘгҖӮйҰ–е…ҲпјҢеҸҜд»Ҙи°ғж•ҙжңҚеҠЎи°ғз”Ёзҡ„и¶…ж—¶ж—¶й•ҝпјҢдҪҶиҝҷ并дёҚжҖ»жҳҜжңҖдҪіж–№жЎҲпјҢеӣ дёәе®ғеҸҜиғҪиҝҮдәҺеғөеҢ–пјҢж— жі•...

гҖҠSpring Cloud ...жҖ»з»“пјҢSpring Cloud Netflix Hystrix жҳҜдёҖдёӘејәеӨ§зҡ„е·Ҙе…·пјҢйҖҡиҝҮзҶ”ж–ӯеҷЁжңәеҲ¶пјҢе®һзҺ°дәҶжңҚеҠЎй—ҙзҡ„е®№й”ҷе’Ңйҡ”зҰ»пјҢжҸҗй«ҳдәҶеҲҶеёғејҸзі»з»ҹзҡ„зЁіе®ҡжҖ§гҖӮзҗҶи§Је’ҢзҶҹз»ғиҝҗз”Ё HystrixпјҢеҜ№дәҺжһ„е»әеҒҘеЈ®зҡ„еҫ®жңҚеҠЎжһ¶жһ„иҮіе…ійҮҚиҰҒгҖӮ

еңЁ"Maven"зҡ„`pom.xml`ж–Ү件дёӯпјҢж·»еҠ `spring-cloud-starter-netflix-hystrix`е’Ң`spring-cloud-starter-netflix-eureka-client`дҫқиө–пјҢзЎ®дҝқHystrixе’ҢEurekaе®ўжҲ·з«Ҝзҡ„еҸҜз”ЁжҖ§гҖӮ жҺҘдёӢжқҘпјҢжҲ‘们йңҖиҰҒй…ҚзҪ®HystrixгҖӮеңЁ`...

10. **жңҖдҪіе®һи·ө**пјҡдҪҝз”ЁHystrix Dashboardж—¶пјҢеә”е®ҡжңҹжЈҖжҹҘе’ҢеҲҶжһҗзӣ‘жҺ§ж•°жҚ®пјҢиҜҶеҲ«жҪңеңЁзҡ„жҖ§иғҪ瓶йўҲе’Ңж•…йҡңзӮ№пјҢеҸҠж—¶и°ғж•ҙжңҚеҠЎжһ¶жһ„е’Ңй…ҚзҪ®пјҢжҸҗй«ҳж•ҙдёӘеҫ®жңҚеҠЎзі»з»ҹзҡ„еҒҘеЈ®жҖ§гҖӮ жҖ»д№ӢпјҢstandalone Hystrix Dashboard 1.5.6жҸҗдҫӣдәҶиҪ»...

Hystrixзҡ„дё»иҰҒзӣ®ж ҮжҳҜйҡ”зҰ»жңҚеҠЎд№Ӣй—ҙзҡ„и°ғз”ЁпјҢйҳІжӯўзә§иҒ”еӨұиҙҘпјҢ并жҸҗдҫӣеӣһйҖҖжңәеҲ¶пјҢзЎ®дҝқзі»з»ҹзҡ„зЁіе®ҡжҖ§е’Ңй«ҳеҸҜз”ЁжҖ§гҖӮйҖҡиҝҮеҲӣе»әдёҖдёӘе‘Ҫд»ӨеҜ№иұЎжқҘе°ҒиЈ…жңҚеҠЎи°ғз”ЁпјҢHystrixеҸҜд»ҘеңЁе‘Ҫд»Өжү§иЎҢеӨұиҙҘж—¶еҗҜз”ЁеӨҮз”ЁйҖ»иҫ‘пјҢиҝҷе°ұжҳҜж–ӯи·ҜеҷЁжЁЎејҸгҖӮ жҺҘдёӢжқҘ...

иҝҷз§Қжһ¶жһ„еҸҜд»ҘеҫҲеҘҪең°йҖӮеә”дә‘зҺҜеўғпјҢжҸҗй«ҳзі»з»ҹзҡ„еҸҜз”ЁжҖ§е’Ңе®№й”ҷжҖ§гҖӮ еңЁе®һйҷ…йЎ№зӣ®дёӯпјҢжҲ‘们иҝҳйңҖиҰҒиҖғиҷ‘е…¶д»–зҡ„з»ҶиҠӮпјҢдҫӢеҰӮж—Ҙеҝ—и®°еҪ•гҖҒзӣ‘жҺ§гҖҒй…ҚзҪ®з®ЎзҗҶзӯүгҖӮдҪҶжҖ»зҡ„жқҘиҜҙпјҢSpring BootдёҺConsulгҖҒFeignе’ҢHystrixCommandзҡ„ж•ҙеҗҲпјҢдёәеҫ®жңҚеҠЎ...

иҝҷдәӣд»Јз ҒйҖҡеёёдјҡеұ•зӨәеҰӮдҪ•й…ҚзҪ®еҗ„дёӘ组件пјҢеҰӮдҪ•зј–еҶҷжңҚеҠЎжҸҗдҫӣиҖ…е’ҢжңҚеҠЎж¶Ҳиҙ№иҖ…пјҢд»ҘеҸҠеҰӮдҪ•еңЁе®һйҷ…еңәжҷҜдёӯеҲ©з”Ёе®ғ们жқҘжҸҗй«ҳзі»з»ҹжҖ§иғҪе’ҢеҸҜйқ жҖ§гҖӮйҖҡиҝҮе®һи·өпјҢдҪ еҸҜд»Ҙж·ұе…ҘзҗҶи§Јиҝҷдәӣ组件зҡ„з”Ёжі•пјҢ并е°Ҷе…¶еә”з”ЁдәҺиҮӘе·ұзҡ„йЎ№зӣ®дёӯпјҢжҸҗеҚҮеҫ®жңҚеҠЎзі»з»ҹ...

Spring Cloud Hystrix жҳҜдёҖдёӘеҹәдәҺ Netflix Hystrix е®һзҺ°зҡ„жңҚеҠЎйҷҚзә§гҖҒж–ӯи·ҜеҷЁе’ҢзҶ”ж–ӯеҷЁжЎҶжһ¶пјҢе®ғиў«е№ҝжіӣеә”з”ЁдәҺеҲҶеёғејҸзі»з»ҹдёӯзҡ„е®№й”ҷз®ЎзҗҶпјҢд»ҘжҸҗй«ҳзі»з»ҹзҡ„зЁіе®ҡжҖ§е’ҢеҸҜз”ЁжҖ§гҖӮеңЁеҫ®жңҚеҠЎжһ¶жһ„дёӯпјҢжңҚеҠЎй—ҙйҖҡдҝЎжҳҜеёёи§Ғзҡ„ж“ҚдҪңпјҢиҖҢSpring ...