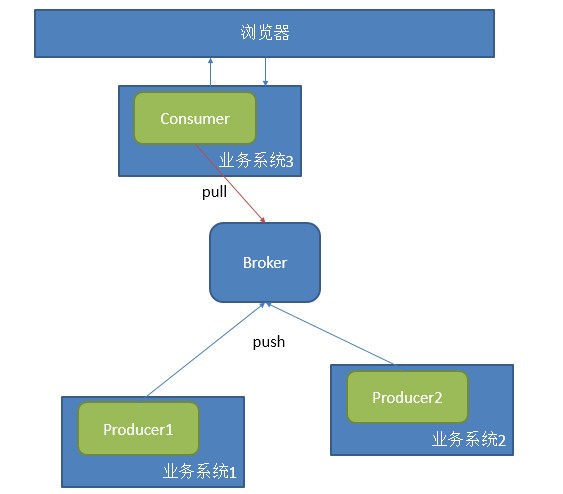

æčŋäļįīåŋįåį§čŪūčŪĄåææĄĢïžįŧäšææķéīæĨæīæ°äļįđåŋå ģäškafkaįäļčĨŋãäđåæäļįŊæįŦ čŪēčŋ°įæŊkafka ProducerįŦŊįįĻåšïžäđå°ąæŊæĨåŋįį䚧č ïžčŋéĻåæŊčūåŪđæįč§ĢïžäļåĄįģŧįŧå°čŋčĄæĨåŋæč äļåĄæĨåŋåéå°brokeräļïžįąbrokeräŧĢäļšååĻãéĢčŪēįæŊåĶä―æķéæĨåŋïžäŧåĪĐčĶåįæŊåĶä―č·åæĨåŋïžįķåååįļå ģįåĪįã

Â

äđååčŋkafkaæŊčŪēæĨåŋæį §topicįå―ĒåžååĻïžäļäļŠtopicäžæį §partitionååĻåäļäļŠæäŧķåĪđäļïžįŪå―åĻconfig/server.propertiesäļæåŪïžå ·ä―įååĻč§ååŊäŧĨæĨįäđåįæįŦ ïž

Â

Â

Â

|

1

2

|

# The directory under which to store log fileslog.dir=/tmp/kafka-logs

|

Â

ConsumerįŦŊįįŪįå°ąæŊäļšäšč·ålogæĨåŋïžįķååčŋäļæĨįåĪįãåĻčŋéæäŧŽåŊäŧĨå°æ°æŪįåĪįæį §éæąåäļšäļĪäļŠæđåïžįšŋäļåįšŋäļïžäđåŊäŧĨåŦåŪæķåįĶŧįšŋãåŪæķåĪįéĻåįąŧäžžäšį―įŦéįįŦįïžææķæŊäšéĐŽäļå°ąæĻéå°åįŦŊïžčŋæŊäļį§åŊđåŪæķæ§čĶæąæéŦįæĻĄåžïžkafkaåŊäŧĨåå°ïžå―įķéåŊđįŦįčŋæ ·įåč―čŋææīåĨ―įåĪįæđåžïžæäļŧčĶå°kafkaįšŋäļæķčīđåč―įĻåĻäšåŪæķįŧčŪĄäļïžåĪįäļäšåĶåŪæķæĩéæąæŧãåįģŧįŧåŪæķååéæąæŧįã

Â

čŋį§åšįĻïžäļčŽéįĻäļäļŠconsumeräļįäļäļŠgroupåŊđåšäļäļŠäļåĄïžé

ååĪäļŠproduceræäūæ°æŪïžåĶäļåūæĻĄ

åžïž

Â

Â

éįĻčŋį§æđåžåĪįåūįŪåïžéįĻåŪį―äļįŧįäūååģåŊč§ĢåģïžåŠæŊįąäšįæŽįéŪéĒïžäŧĢį įĻä―æīæđåģåŊïž

Â

|

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

|

package com.a2.kafka.consumer;

Â

import java.util.HashMap;

import java.util.List;

import java.util.Map;

import java.util.Properties;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

Â

import kafka.consumer.Consumer;

import kafka.consumer.ConsumerConfig;

import kafka.consumer.KafkaStream;

import kafka.javaapi.consumer.ConsumerConnector;

import kafka.message.Message;

import kafka.message.MessageAndMetadata;

Â

public class CommonConsumer {

public static void main(String[] args) {

// specify some consumer properties

Properties props = new Properties();

props.put("zk.connect", "192.168.181.128:2181");

props.put("zk.connectiontimeout.ms", "1000000");

props.put("groupid", "test_group");

Â

// Create the connection to the cluster

ConsumerConfig consumerConfig = new ConsumerConfig(props);

ConsumerConnector consumerConnector = Consumer.createJavaConsumerConnector(consumerConfig);

Â

Map<String, Integer> map=new HashMap<String,Integer>();

map.put("test", 2);

// create 4 partitions of the stream for topic âtestâ, to allow 4 threads to consume

Map<String, List<KafkaStream<Message>>> topicMessageStreams =

consumerConnector.createMessageStreams(map);

List<KafkaStream<Message>> streams = topicMessageStreams.get("test");

Â

// create list of 4 threads to consume from each of the partitions

ExecutorService executor = Executors.newFixedThreadPool(4);

Â

// consume the messages in the threads

for(final KafkaStream<Message> stream: streams) {

executor.submit(new Runnable() {

public void run() {

for(MessageAndMetadata<Message> msgAndMetadata: stream) {

// process message (msgAndMetadata.message())

System.out.println(msgAndMetadata.message());

}

}

});

}

}

} |

Â

čŋæŊäļäļŠuser levelįAPIïžčŋæäļäļŠlow levelįAPIåŊäŧĨäŧåŪį―æūå°ïžčŋéå°ąäļčīīåšæĨäšãčŋäļŠconsumeræŊåšåąéįĻįæŊäļäļŠéŧåĄéåïžåŠčĶäļæproducerį䚧æ°æŪïžéĢconsumerå°ąäžå°æ°æŪæå°åšæĨïžčŋæŊäļæŊååįŽĶååŪæķæ§įčĶæąã

Â

å―įķčŋéäžäš§įäļäļŠåūäļĨéįéŪéĒïžåĶæä― éåŊäļäļäļéĒčŋäļŠįĻåšïžéĢä― čŋäļæĄæ°æŪé―æäļå°ïžä―æŊä― åŧlogæäŧķäļææåŊäŧĨįå°æææ°æŪé―åĨ―åĨ―įååĻãæĒåĨčŊčŊīïžäļæĶä― æķčīđčŋčŋäšæ°æŪïžéĢä― å°ąæ æģåæŽĄįĻåäļäļŠgroupidæķčīđåäļįŧæ°æŪäšãæå·ēįŧæįŧčŪščŊīåšæĨäšïžčĶæķčīđåäļįŧæ°æŪïžä― åŊäŧĨéįĻäļåįgroupã

Â

Â

įŪåčŊīäļ䚧įčŋäļŠéŪéĒįåå ïžčŋäļŠéŪéĒįąŧäžžäštransaction commitïžåĻæķæŊįģŧįŧäļé―äžæčŋæ ·äļäļŠéŪéĒååĻïžæ°æŪæķčīđįķæčŋäļŠäŋĄæŊå°åšååŠéãæŊååĻconsumerįŦŊïžčŋæŊååĻbrokerįŦŊãåŊđäščŋæ ·įäščŪšïžäļčŽäžåšį°äļį§æ åĩïž

Â

Â

- At most onceâthis handles the first case described. Messages are immediately marked as consumed, so they can't be given out twice, but many failure scenarios may lead to losing messages.

- At least onceâthis is the second case where we guarantee each message will be delivered at least once, but in failure cases may be delivered twice.

- Exactly onceâthis is what people actually want, each message is delivered once and only once.

Â

Â

Â

įŽŽäļį§æ åĩæŊå°æķčīđįįķæååĻåĻäšbrokerįŦŊïžäļæĶæķčīđäšå°ąæđåįķæïžä―äžå äļšį―įŧåå å°æķčīđäŋĄæŊïžįŽŽäšį§æŊååĻäļĪįŦŊïžåđķäļå åĻbrokerįŦŊå°įķæčŪ°äļšsendïžįconsumeråĪįåŪäđåå°įķææ čŪ°äļšconsumedïžä―äđæåŊč―å äļšåĻåĪįæķæŊæķ䚧įåžåļļïžåŊžčīįķææ čŪ°éčŊŊįïžåđķäļäžäš§įæ§č―įéŪéĒãįŽŽäļį§å―įķæŊæåĨ―įįŧæã

Â

Kafkač§ĢåģčŋäļŠéŪéĒéįĻhigh water markčŋæ ·įæ čŪ°ïžäđå°ąæŊčŪūį―Ūoffsetïž

Â

|

1

|

Kafka does two unusual things with respect to metadata. First the stream is partitioned on the brokers into a set of distinct partitions. The semantic meaning of these partitions is left up to the producer and the producer specifies which partition a message belongs to. Within a partition messages are stored in the order in which they arrive at the broker, and will be given out to consumers in that same order. This means that rather than store metadata for each message (marking it as consumed, say), we just need to store the "high water mark" for each combination of consumer, topic, and partition. Hence the total metadata required to summarize the state of the consumer is actually quite small. In Kafka we refer to this high-water mark as "the offset" for reasons that will become clear in the implementation section.

|

Â

æäŧĨåĻæŊæŽĄæķčīđäŋĄæŊæķïžlog4jäļé―äžčūåšäļåįoffsetïž

Â

|

1

2

3

|

[FetchRunnable-0] INFO : kafka.consumer.FetcherRunnable#info : FetchRunnable-0 start fetching topic: test part: 0 offset: 0 from 192.168.181.128:9092

Â

[FetchRunnable-0] INFO : kafka.consumer.FetcherRunnable#info : FetchRunnable-0 start fetching topic: test part: 0 offset: 15 from 192.168.181.128:9092

|

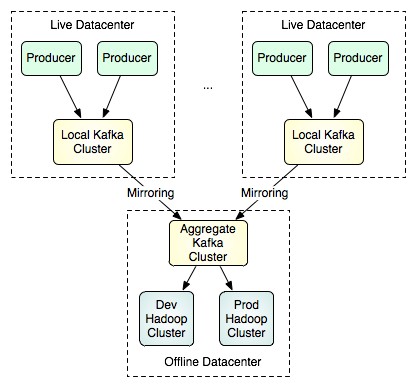

éĪäšéįĻäļåįgroupidåŧæåå·ēįŧæķčīđčŋįæ°æŪïžkafkačŋæäūäšåĶäļį§æč·Ŋïžčŋį§æđåžæīéåįšŋäļįæä―ïžéåã

Â

Â

éčŋäļäšé į―Ūïžå°ąåŊäŧĨå°įšŋäļ䚧įįæ°æŪåæĨå°éåäļåŧïžįķååįąįđåŪįéįūĪåšåĪįåĪ§æđéįæ°æŪïžčŋį§æđåžåŊäŧĨéįĻlow levelįAPIæį §äļåįpartitionåoffsetæĨæåæ°æŪïžäŧĨč·åūæīåĨ―įåđķčĄåĪįææã

Â

http://my.oschina.net/ielts0909/blog/110280

įļå ģæĻč

1. **ååŧšConsumeråŪäū**ïžéĶå ïžæäŧŽéčĶé į―ŪäļäļŠ`Properties`åŊđ蹥ïžčŪūį―Ūåŋ čĶįåæ°åĶbootstrap serversãgroup idįïžįķåä―ŋįĻ`KafkaConsumer`įąŧįæé å―æ°ååŧšæķčīđč åŪäūã 2. **čŪĒé äļŧéĒ**ïžæķčīđč éčŋč°įĻ`...

åĻæŽæäļïžæäŧŽå°æ·ąå ĨæĒčŪĻåĶä―ä―ŋįĻC++åšRdKafkaäļį`KafkaConsumer`įąŧæĨæķčīđApache KafkaæķæŊãRdKafkaæŊäļäļŠéŦæįC/C++ KafkaåŪĒæ·įŦŊïžåŪæäūäšį䚧č åæķčīđč APIïžä―ŋåūäļKafkaéįūĪčŋčĄäšĪäšååūæīå įŪåãåĻčŋäļŠ...

ãGo-consumergroupïžæåŧšåšäšGolangįKafkaæķčīđč åšã åĻį°äŧĢč―ŊäŧķåžåäļïžæķæŊéåįģŧįŧåĶApache KafkaæŪæžįčģå ģéčĶįč§čēïžåŪæäūäšéŦæãåŊé įåžæĨéäŋĄč―åãčGočŊčĻäŧĨå ķįŪæīįčŊæģåéŦæ§č―įđæ§ïžæäļšäšįžå...

KafkaConsumerDemo.java

KafkaConsumer, String> consumer = new KafkaConsumer(props); consumer.subscribe(Arrays.asList("my-topic")); while (true) { ConsumerRecords, String> records = consumer.poll(Duration.ofMillis(100)); ...

åĻæ éĒ"pentaho-kafka-consumer.zip"äļïžæäŧŽįå°įæŊäļäļŠäļéĻäļšPentaho KettleåŪåķįKafkaæķčīđč æäŧķįåįžĐå ã čŋäļŠåįžĐå įæčŋ°æå°äšåĶä―åĻPentahoįŊåĒäļåŪčĢ åä―ŋįĻčŋäļŠæäŧķãéĶå ïžä― éčĶåĻä― įPentaho Kettle...

ãæ éĒã"kafka_hdfs_consumer"æķåå°įå ģéŪææŊæŊå°æ°æŪäŧKafkaæķčīđåđķååĻå°HDFSïžHadoop Distributed File SystemïžäļãčŋäļŠčŋįĻéåļļåĻåĪ§æ°æŪåĪįåæĩåĪįåšæŊäļéåļļåļļč§ïžåŪå čŪļåŪæķæčŋåŪæķįæ°æŪäŧæķæŊéåæĩå...

ãæ éĒã"phpkafkaconsumer"æŊäļäļŠäļéĻäļšPHPčŪūčŪĄįKafkaæķčīđč åšïžåŪäļäŧ æäūäšåšæŽįKafkaæķæŊæķčīđåč―ïžčŋįđåŦæŊæäšæķčīđč įŧïžConsumer Groupïžåååđģ襥ïžRebalanceïžæšåķãKafkaæŊäļį§ååļåžæĩåĪįåđģå°ïžåļļįĻäš...

kettle7.1įæŽæīåkafkaïžkafkaæäŧķå åŦį䚧č ãæķčīđč ãįīæĨåĻkettleåŪčĢ įŪå―pluginsäļååŧšstepsįŪå―ïžåđķč§Ģåäļč――æäŧķå°kettle/plugins/stepsįŪå―ãå ·ä―åŊæĨį...

import org.apache.kafka.clients.consumer.{ConsumerConfig, ConsumerRecord, KafkaConsumer} import java.util.Properties val props = new Properties() props.put(ConsumerConfig.BOOTSTRAP_SERVERS_CONFIG, ...

**KafkaæäŧķčŊĶč§Ģ** KafkaæäŧķæŊApache Kafkaäļåį§å·Ĩå ·éæįéčĶįŧæéĻåïžåŪä―ŋåūåžåč åčŋįŧīäššåč―åĪæīæđäūŋå°åĻäļåįįģŧįŧäļåĐįĻKafkaįåč―ãKafkaæŊäļæŽūååļåžæĩåĪįåđģå°ïžåļļįĻäšæåŧšåŪæķæ°æŪįŪĄéåæĩåšįĻïž...

5. **čŋčĄäļæĩčŊ**ïžåŊåĻSpring BootåšįĻïžå―`kafka.consumer.enabled`čŪūį―Ūäļš`true`æķïžæķčīđč å°åžå§įåŽæåŪįKafkaäļŧéĒãä― åŊäŧĨéčŋåéæķæŊå°čŊĨäļŧéĒæĨæĩčŊæķčīđč įčŋčĄæ åĩã äŧĨäļå°ąæŊåšäšSpring BootåSpring ...

æŽææŊįģŧåæįŦ įįŽŽ4įŊïžįŽŽäļįŊ"įŽŽäšįŊįŽŽäļįŊįŽŽåįŊæŽæäļŧčĶäŧįŧäšKafkaHighLevelConsumer...åæķäđåļææäūäļäščŊäđïžäūåĶåäļæĄæķæŊåŠčĒŦæäļäļŠConsumeræķčīđïžåæïžæčĒŦææConsumeræķčīđïžåđŋæïžãå æĪïžKafkaHightL

KafkaæŊäļäļŠååļ/čŪĒé æĻĄåįæķæŊéåïžåŪå åŦį䚧č ïžProducerïžãæķčīđč ïžConsumerïžåäļŧéĒïžTopicïžãį䚧č čīčīĢååļæķæŊå°äļŧéĒïžčæķčīđč åčŪĒé čŋäšäļŧéĒåđķæķčīđæķæŊãæķčīđč éčŋæķčīđč įŧïžConsumer GroupïžčŋčĄ...

KafkaConsumer, String> consumer = new KafkaConsumer(props); consumer.subscribe(Collections.singletonList("myTopic")); // čŪĒé äļŧéĒ while (true) { ConsumerRecords, String> records = consumer.poll...

kafka-consumer kafka-consumeræŊåšäšKafka-0.8.20å°čĢ įconsumerãkafka-consumerįįŪįåĻäščŪĐäļåĄåžåäššåäļåŋ äšč§Ģkafkaå°ąč―åžåãåđķäļæäūæķæŊčŋæŧĪåč―ã Example å ģäškafka-consumerįä―ŋįĻïžåŊäŧĨåčåĶäļäŧĢį ã ...

2. **æķčīđč ïžConsumerïž**ïžäŧKafkač·åæķæŊïžåŊäŧĨä―ŋįĻ`KafkaConsumer`įąŧæĨåŪį°ãæķčīđč åŊäŧĨčŪĒé äļäļŠæåĪäļŠäļŧéĒïžåđķäļåŊäŧĨéįĻåįŧæķčīđïžįĄŪäŋæŊäļŠæķæŊäŧ čĒŦįŧå įäļäļŠæķčīđč åĪįã 3. **äļŧéĒïžTopicïž**ïžKafkaäļį...

- KafkaConsumerïžæŊååŧšæķčīđč åŪäūįéææĨåĢã - ConsumerïžæŊæķčīđč įŧæïžåĪįæķčīđįļå ģįéŧčūã - KafkaConsumerImplïžæŊæķčīđč åŪį°įå ·ä―å°čĢ ã librdkafkačŋæäūäšæķčīđč åč°æšåķïžåĶConsumeCbåEventCbïžåŪäŧŽ...

Kafka įæ ļåŋæĶåŋĩå æŽååļč ïžProducerïžãæķčīđč ïžConsumerïžåäļŧéĒïžTopicïžãååļč čīčīĢįææķæŊåđķåéå°įđåŪįäļŧéĒïžčæķčīđč åäŧčŋäšäļŧéĒäļčŪĒé åæķčīđæķæŊãäļŧéĒčĒŦååäļšåĪäļŠååšïžPartitionïžïžæŊäļŠååšé―æŊäļ...