|

LVSТў»Linux Virtual Serverуџёу«ђтєЎ№╝їТёЈтЇ│LinuxУЎџТІЪТюЇтіАтЎе№╝їТў»СИђСИфУЎџТІЪуџёТюЇтіАтЎежЏєуЙцу│╗у╗ЪсђѓТюгжА╣уЏ«тюе1998т╣┤5Тюѕућ▒уФаТќЄтхЕтЇџтБФТѕљуФІ№╝їТў»СИГтЏйтЏйтєЁТюђТЌЕтЄ║уј░уџёУЄфућ▒Уй»С╗ХжА╣уЏ«С╣ІСИђ№╝Џ lvsуџётЄауДЇТеАтъІ№╝џ ┬а ┬а 1сђЂNATТеАтъІ№╝Џ ┬а ┬а┬а ┬а┬а ┬а┬а ┬ауЅ╣ТђД№╝џ┬а ┬а┬а ┬а┬а ┬а┬а ┬а┬а┬а ┬а ┬а┬а ┬а┬а┬а1сђЂreal serverСИГуџётљёТюЇтіАтЎеripтю░тЮђт║ћУ»ЦСй┐ућеуДЂТюЅтю░тЮђ№╝їТюЅТЋѕжџљУЌЈтєЁжЃеТюЇтіАтЎе№╝Џ ┬а ┬а┬а ┬а┬а┬а2сђЂreal serverСИГтљёТюЇтіАтЎеуџёуйЉтЁ│т┐ЁжА╗ТїЄтљЉdipсђѓripтњїdipт┐ЁжА╗тюетљїСИђуйЉТ«хтєЁ№╝їС┐ЮУ»ЂТхЂжЄЈу╗ЈУ┐ЄDirector№╝Џ ┬а ┬а┬а ┬а┬а┬а3сђЂУ»иТ▒ѓтњїтЊЇт║ћуџёТіЦТќЄжЃйтЙЌу╗ЈУ┐ЄDirectory№╝ѕSNAT+DNAT№╝Ѕ№╝Џ ┬а ┬а┬а ┬а┬а┬а4сђЂтюежФўУ┤ЪУййт║ћућетю║ТЎ»СИГ№╝їDirectoryтЙѕтЈ»УЃйТѕљСИ║у│╗у╗ЪТђДУЃйуЊХжбѕ№╝Џ ┬а ┬а┬а ┬а┬а┬а5сђЂТћ»ТїЂDNATуџёуФ»тЈБТўат░ёсђѓт░є80Тўат░ётѕ░real serverСИГуџё8080№╝Џ ┬а ┬а┬а ┬а┬а┬а6сђЂreal serverСИГуџётљёТюЇтіАтЎетЈ»С╗ЦСй┐ућеС╗╗ТёЈТћ»ТїЂжЏєуЙцТюЇтіАуџёOS№╝ѕу│╗у╗Ъ№╝Ѕ№╝Џ ┬а ┬а Т│еТёЈ№╝џУ»Цу▒╗тъІжђѓтљѕт╣ХтЈЉтњїУ»иТ▒ѓТЋ░жЄЈСИЇжФўуџётю║ТЎ»СИГ№╝Џ ┬а┬а2сђЂDRТеАтъІ№╝Џ ┬а ┬а┬а ┬ауЅ╣ТђД№╝џ ┬а ┬а┬а ┬а┬а┬а1сђЂreal serverтЈ»С╗ЦСй┐ућеуДЂТюЅтю░тЮђ№╝їСйєС╣ЪтЈ»С╗ЦСй┐ућетЁгуйЉтю░тЮђ№╝їТГцТЌХтЈ»С╗ЦуЏ┤ТјЦжђџУ┐ЄС║њУЂћуйЉУ┐ътЁЦreal serverС╗Цт«ъуј░жЁЇуй«сђЂуЏЉТјДуГЅ№╝Џ ┬а ┬а┬а ┬а┬а┬а2сђЂreal serverуџёуйЉтЁ│СИђт«џСИЇУЃйТїЄтљЉDIP№╝Џ ┬а ┬а┬а ┬а┬а┬а3сђЂreal serverУиЪDirectoryУдЂтюетљїСИђуЅЕуљєуйЉу╗ютєЁ№╝ѕСИЇУЃйућ▒Уи»ућ▒тЎетѕєуд╗№╝Ѕ№╝Џ ┬а ┬а┬а ┬а┬а┬а4сђЂУ»иТ▒ѓТіЦТќЄу╗ЈУ┐ЄDirectory№╝їСйєтЊЇт║ћТіЦТќЄСИђт«џСИЇу╗ЈУ┐ЄDirectory№╝Џ ┬а ┬а┬а ┬а┬а┬а5сђЂСИЇТћ»ТїЂуФ»тЈБТўат░ё№╝Џ ┬а ┬а┬а ┬а┬а┬а6сђЂreal serverтЈ»С╗ЦСй┐ућетцДтцџТЋ░уџёТЊЇСйюу│╗у╗Ъ№╝Џ ┬а┬а3сђЂTUNТеАтъІ№╝Џ ┬а ┬а┬а ┬ауЅ╣ТђД№╝џ ┬а ┬а┬а ┬а┬а┬а1сђЂripсђЂdipсђЂvipжЃйтЙЌТў»тЁгуйЉтю░тЮђ№╝Џ ┬а ┬а┬а ┬а┬а┬а2сђЂreal serverуџёуйЉтЁ│СИЇУЃйТїЄтљЉС╣ЪСИЇтЈ»УЃйТїЄтљЉdip№╝Џ ┬а ┬а┬а ┬а┬а┬а3сђЂУ»иТ▒ѓТіЦТќЄу╗ЈУ┐ЄDirectory№╝їСйєтЊЇт║ћТіЦТќЄСИђт«џСИЇу╗ЈУ┐ЄDirectory№╝Џ ┬а ┬а┬а ┬а┬а┬а4сђЂСИЇТћ»ТїЂуФ»тЈБТўат░ё№╝Џ ┬а ┬а┬а ┬а┬а┬а5сђЂreal serverуџёу│╗у╗Ът┐ЁжА╗тЙЌТћ»ТїЂжџДжЂЊтіЪУЃй№╝Џ ┬а ┬а┬а ┬а┬а┬а ┬а┬а4сђЂFULLNATТеАтъІ№╝Џ ┬а ┬а┬а ┬ауЅ╣ТђД№╝џ ┬а ┬а┬а ┬а┬а┬аfullnat№╝џтюеnatТеАтъІуџётЪ║уАђСИі№╝їтюеDirectoryСИіт░єУ»иТ▒ѓуџёТіЦТќЄ№╝ѕcip+vip№╝Ѕ№╝їТћ╣Тѕљ№╝ѕdip+rip№╝ЅсђѓУ┐ЎТаи№╝їтйЊreal serverТћХтѕ░тљј№╝їт░єтЏътїЁуџёТіЦТќЄСИ║rip+dip№╝їуёХтљјтєЇућ▒Directoryт░єТіЦТќЄтєЇТгАТћ╣тЈўТѕљvip+cipтЇ│тЈ»сђѓС┐ЮУ»ЂтЏъуеІТіЦТќЄу╗ЈУ┐ЄDirectoryсђѓ ┬а ┬а┬а ┬а┬а┬аСИ╗УдЂућ▒Directoryт░єТіЦТќЄт«ъТќйУйгТЇбтіеСйю№╝Џ ┬а ┬а┬а ┬а┬а┬аС╝ўуѓ╣№╝џDirectoryтњїreal serverтЈ»С╗ЦУиеСИЇтљїуџёvlanжЃеуй▓сђѓтЈ»С╗ЦСИЇтюеСИђСИфуйЉТ«х№╝Џ LVSуџё10уДЇУ░Ѓт║дТќ╣Т│Ћ№╝џ┬а┬а ┬а ┬а жЮЎТђЂУ░Ѓт║д№╝џ ┬а ┬а rrу«ЌТ│Ћ№╝џRound Robin№╝їУй«У»бсђѓУй«У»бreal serverСИГуџёТюЇтіАтЎесђѓТюђу«ђтЇЋсђЂТўЊт«ъуј░№╝Џ ┬а ┬а wrrу«ЌТ│Ћ№╝џWeighted RR№╝їтіаТЮЃУй«У»бсђѓТа╣ТЇ«real serverуџёТЮЃжЄЇТ»ћСЙІтј╗У░Ѓт║дСИЇтљїТЮЃжЄЇуџёТюЇтіАтЎесђѓжФўТЮЃжЄЇуџёУбФУ░Ѓт║дуџёТгАТЋ░т░▒тцџ№╝Џ ┬а ┬а shу«ЌТ│Ћ№╝џsource hashing№╝їТ║љтю░тЮђhashсђѓТЮЦУЄфтљїСИђТ║љipуџёУ»иТ▒ѓжЃйтЈЉтЙђтЏ║т«џуџёТюЇтіАтЎеСИітј╗сђѓСИ╗УдЂуЏ«уџёТў»СИ║С║єт«ъуј░sessionу╗Љт«џуџё№╝Џ ┬а ┬а dhу«ЌТ│Ћ№╝џdestination hashing№╝їуЏ«уџётю░тЮђhashсђѓтј╗тЙђтљїСИђуЏ«ТаЄуџёт«бТѕиуФ»У»иТ▒ѓС╝џУ»ЮУбФтЏ║т«џтюеСИђСИфтЊЇт║ћТюЇтіАтЎеСИі№╝Џ ┬а ┬а у╝║жЎи№╝џСИЇС╝џУђЃУЎЉтљјтЈ░real serverуџёУ┤ЪУййТЃЁтєх№╝їТў»СИЇТў»тЙѕт┐Ў№╝їтЈфуЪЦжЂЊТа╣ТЇ«у«ЌТ│Ћтј╗Уй«У»бсђѓТ»ћУЙЃРђютѓ╗РђЮ№╝Џ ┬а ┬а тіеТђЂУ░Ѓт║д№╝џ ┬а ┬а lcу«ЌТ│Ћ№╝џLeast connection№╝їТюђт░ЈУ┐ъТјЦсђѓТа╣ТЇ«ТюЇтіАтЎеуџёжЊЙТјЦТЋ░ТЮЦУ┐ЏУАїтѕцТќГтњїТЅДУАїУ░Ѓт║д№╝Џ ┬а ┬а┬а ┬а┬а┬атЁгт╝Ј№╝џOverhead=Action*256+Inactive У┤ЪУйй=№╝ѕТ┤╗тіежЊЙТјЦТЋ░*256+жЮъТ┤╗тіежЊЙТјЦТЋ░№╝Ѕ ┬а ┬а┬а ┬а┬а┬аУ«Ау«Ќу╗ЊТъюСИГ№╝їТюђт░ЈУђЁУЃютЄ║ТѕљСИ║УбФУ░Ѓт║дУђЁсђѓтдѓТъютђ╝СИђТаи№╝їтѕЎТЅДУАїУй«У»б№╝Џ ┬а ┬а wlcу«ЌТ│Ћ№╝џWeighted LC№╝їТЮЃжЄЇуџёТюђт░ЈУ┐ъТјЦсђѓтюеТюђт░ЈУ┐ъТјЦуџётЪ║уАђСИітбътіаТЮЃжЄЇ№╝Џ ┬а ┬а┬а ┬а┬а┬атЁгт╝Ј№╝џOverhead=№╝ѕaction*256+жЮъТ┤╗тіежЊЙТјЦТЋ░№╝Ѕ/weight№╝ѕТЮЃжЄЇ№╝Ѕ ┬а ┬а┬а ┬а┬а┬аУ«Ау«Ќу╗ЊТъюУХіт░ЈУђЁУЃютЄ║№╝їУбФТЅДУАїУ░Ѓт║дсђѓтдѓТъютђ╝СИђТаи№╝їтѕЎС╣ІСИіУђїСИІУ┐ЏУАїУй«У»б№╝Џ ┬а ┬а┬а ┬а┬а┬ау╝║уѓ╣№╝џтЈ»УЃйТђДУЃйти«уџёТюЇтіАтЎетѕџтЦйУбФУй«У»бС║є№╝їУђїТђДУЃйтЦйуџёТюЇтіАтЎетЈЇУђїТ▓АУй«У»бтѕ░№╝Џ ┬а ┬а sedу«ЌТ│Ћ№╝џShortest Expect Delay№╝їТюђуЪГТюЪТюЏт╗ХУ┐Ъсђѓжў▓ТГбТїЉтѕ░ТђДУЃйТюђти«уџёТюЇтіАтЎеУ┐ЏУАїуЏИт║ћсђѓТћ╣У┐ЏуЅѕуџёwlc№╝Џ┬а ┬а┬а┬а ┬а ┬а┬а ┬а┬а┬аУ«Ау«Ќу╗ЊТъюУХіт░ЈУђЁУЃютЄ║№╝їУбФТЅДУАїУ░Ѓт║дсђѓТ░ИУ┐юТў»ТЮЃжЄЇтцДуџёТюЇтіАтЎеТјњтюеТюђтЅЇжЮбУбФУй«У»бтѕ░№╝Џ ┬а ┬а┬а ┬а┬а┬атЁгт╝Ј№╝џoverhead=№╝ѕactive+1№╝Ѕ*256/weight №╝їСИЇУђЃУЎЉжЮъТ┤╗тіеУ┐ъТјЦТЋ░№╝Џ ┬а ┬а nqу«ЌТ│Ћ№╝џNerver Queue№╝їТ░ИСИЇТјњжўЪсђѓТћ╣У┐ЏС║єуџёsedсђѓтѕџт╝ђт▒ђС╣Ітљј№╝їТЅђТюЅТюЇтіАтЎеждќтЁѕТа╣ТЇ«sedу«ЌТ│ЋУй«У»бСИђжЂЇ№╝ї№╝ѕуггСИђСИфУ»иТ▒ѓу╗ЎТЮЃжЄЇТюђтцДуџё№╝їуггС║їСИфсђЂуггСИЅСИф...СЙЮТгАТјњСИІтј╗№╝їТјњСИђжЂЇ№╝ЅсђѓуёХтљјтєЇТа╣ТЇ«sedу«ЌТ│ЋтєЇжЄЇТќ░У«Ау«ЌУ░Ѓт║д№╝Џ ┬а ┬а lblcу«ЌТ│Ћ№╝џLocality-based least conection№╝їтЪ║С║јТюгтю░уџёТюђт░ЈУ┐ъТјЦсђѓуЏИтйЊС║јdh+lcсђѓућеуџёСИЇтцџ№╝Џ lblcrу«ЌТ│Ћ№╝џReplicated and Locality-based least connection№╝їтИдтцЇтѕХуџётЪ║С║јТюгтю░уџёТюђт░ЈУ┐ъТјЦсђѓућетюетљјуФ»ТюЇтіАтЎеТў»cacheТюЇтіАтЎеСИісђѓућеуџёСИЇтцџ№╝Џ

┬а

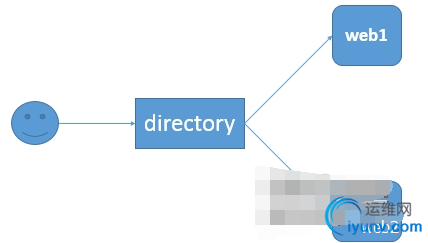

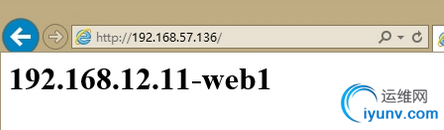

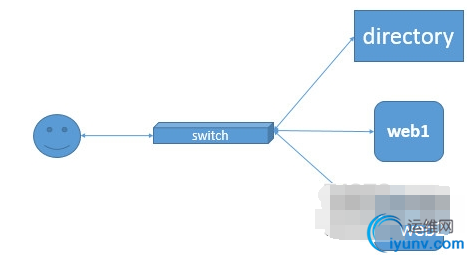

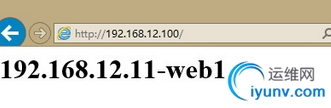

┬а ┬а т«ЌТЌе№╝џТЌаУ«║Сй┐ућеlvsуџётЊфуДЇУ░Ѓт║ду▒╗тъІ№╝їжЃйтЈ»С╗ЦУЄфућ▒уџёжђЅТІЕУ░Ѓт║дТќ╣Т│Ћ№╝їт░єућеТѕиУ»иТ▒ѓУ░Ѓт║дУЄ│тљјуФ»real serverсђѓу▒╗тъІтњїТќ╣Т│ЋтЈ»Тииуће№╝Џ┬а ┬а у╝║жЎи№╝џLVSТў»ТЌаТ│ЋТБђТхІтљјуФ»real serverуџётЂЦт║иуіХтєхуџё№╝Џ LVSуџёNATТеАтъІуџёт«ъжфї№╝џ ┬а ┬а ТІЊТЅЉ№╝џ ┬а ┬а┬а  ┬а ┬а┬а ┬а уј»тбЃ№╝џ ┬а ┬а┬а ┬а┬а┬аweb1№╝џ192.168.12.11 ┬а ┬а┬а ┬а┬а┬аweb2№╝џ192.168.12.12 ┬а ┬а┬а ┬а┬а┬аdirectory№╝џ ┬а ┬а┬а ┬а┬а ┬а┬а ┬атєЁуйЉip№╝џ192.168.12.1 ┬а ┬а┬а ┬а┬а ┬а┬а ┬атцќуйЉip№╝џ192.168.57.136 ┬а ┬а┬а ┬а┬а┬аућеТѕиip№╝џ192.168.57.155 ┬а ┬а┬а ┬а┬а┬аwebТюЇтіАтЎе№╝їтЪ║С║јapacheТюЇтіАтЎеТљГт╗║№╝Џ ┬а ┬а┬а ┬а┬а┬аdirecotry№╝їтЪ║С║јlvs№╝Џ ┬а ┬а тюеweb1СИі№╝џ [root@localhost ~]# ifconfig eth1┬а ┬а┬а ┬аLink encap:Ethernet┬а┬аHWaddr 00:0C:29:34:DA:E2┬а┬а ┬а ┬а┬а ┬а┬а ┬а inet addr:192.168.12.11┬а┬аBcast:192.168.12.255┬а┬аMask:255.255.255.0 ┬а ┬а┬а ┬а┬а ┬а inet6 addr: fe80::20c:29ff:fe34:dae2/64 Scope:Link ┬а ┬а┬а ┬а┬а ┬а UP BROADCAST RUNNING MULTICAST┬а┬аMTU:1500┬а┬аMetric:1 ┬а ┬а┬а ┬а┬а ┬а RX packets:4173 errors:0 dropped:0 overruns:0 frame:0 ┬а ┬а┬а ┬а┬а ┬а TX packets:3474 errors:0 dropped:0 overruns:0 carrier:0 ┬а ┬а┬а ┬а┬а ┬а collisions:0 txqueuelen:1000┬а ┬а ┬а┬а ┬а┬а ┬а RX bytes:380871 (371.9 KiB)┬а┬аTX bytes:448376 (437.8 KiB) ┬а ┬а тюеweb2СИі№╝џ [root@localhost ~]# ifconfig eth1┬а ┬а┬а ┬аLink encap:Ethernet┬а┬аHWaddr 00:0C:29:03:A5:B7┬а┬а ┬а ┬а┬а ┬а┬а ┬а inet addr:192.168.12.12┬а┬аBcast:192.168.12.255┬а┬аMask:255.255.255.0 ┬а ┬а┬а ┬а┬а ┬а inet6 addr: fe80::20c:29ff:fe03:a5b7/64 Scope:Link ┬а ┬а┬а ┬а┬а ┬а UP BROADCAST RUNNING MULTICAST┬а┬аMTU:1500┬а┬аMetric:1 ┬а ┬а┬а ┬а┬а ┬а RX packets:5181 errors:0 dropped:0 overruns:0 frame:0 ┬а ┬а┬а ┬а┬а ┬а TX packets:2500 errors:0 dropped:0 overruns:0 carrier:0 ┬а ┬а┬а ┬а┬а ┬а collisions:0 txqueuelen:1000┬а ┬а ┬а┬а ┬а┬а ┬а RX bytes:523926 (511.6 KiB)┬а┬аTX bytes:268639 (262.3 KiB) ┬а ┬а┬а ┬а ┬а тюеdirectoryСИі№╝џ [root@localhost ~]# ifconfig eth0┬а ┬а┬а ┬аLink encap:Ethernet┬а┬аHWaddr 00:0C:29:B2:B7:26┬а┬а ┬а ┬а┬а ┬а┬а ┬а inet addr:192.168.57.136┬а┬аBcast:192.168.57.255┬а┬аMask:255.255.255.128 ┬а ┬а┬а ┬а┬а ┬а inet6 addr: fe80::20c:29ff:feb2:b726/64 Scope:Link ┬а ┬а┬а ┬а┬а ┬а UP BROADCAST RUNNING MULTICAST┬а┬аMTU:1500┬а┬аMetric:1 ┬а ┬а┬а ┬а┬а ┬а RX packets:2928 errors:0 dropped:0 overruns:0 frame:0 ┬а ┬а┬а ┬а┬а ┬а TX packets:451 errors:0 dropped:0 overruns:0 carrier:0 ┬а ┬а┬а ┬а┬а ┬а collisions:0 txqueuelen:1000┬а ┬а ┬а┬а ┬а┬а ┬а RX bytes:632507 (617.6 KiB)┬а┬аTX bytes:42962 (41.9 KiB) eth1┬а ┬а┬а ┬аLink encap:Ethernet┬а┬аHWaddr 00:0C:29:B2:B7:30┬а┬а ┬а ┬а┬а ┬а┬а ┬а inet addr:192.168.12.1┬а┬аBcast:192.168.12.255┬а┬аMask:255.255.255.0 ┬а ┬а┬а ┬а┬а ┬а inet6 addr: fe80::20c:29ff:feb2:b730/64 Scope:Link ┬а ┬а┬а ┬а┬а ┬а UP BROADCAST RUNNING MULTICAST┬а┬аMTU:1500┬а┬аMetric:1 ┬а ┬а┬а ┬а┬а ┬а RX packets:928 errors:0 dropped:0 overruns:0 frame:0 ┬а ┬а┬а ┬а┬а ┬а TX packets:906 errors:0 dropped:0 overruns:0 carrier:0 ┬а ┬а┬а ┬а┬а ┬а collisions:0 txqueuelen:1000┬а ┬а ┬а┬а ┬а┬а ┬а RX bytes:79442 (77.5 KiB)┬а┬аTX bytes:87637 (85.5 KiB) ┬а ┬а тюеweb1СИі№╝џ [root@localhost ~]# cat /var/www/html/index.html┬а <h1>192.168.12.11-web1</h1> [root@localhost ~]#┬а ┬а ┬а тюеweb2СИі№╝џ [root@localhost ~]# cat /var/www/html/index.html┬а <h1>192.168.12.12-web2</h1> [root@localhost ~]# ┬а ┬а тюеdirectoryСИі№╝џ [root@localhost ~]# yum -y install ipvsadm [root@localhost ~]# ipvsadm -A -t 192.168.57.136:80 -s rr [root@localhost ~]# ipvsadm -a -t 192.168.57.136:80 -r 192.168.12.11 -m [root@localhost ~]# ipvsadm -a -t 192.168.57.136:80 -r 192.168.12.12 -m [root@localhost ~]# ipvsadm -L -n IP Virtual Server version 1.2.1 (size=4096) Prot LocalAddress:Port Scheduler Flags ┬а┬а-> RemoteAddress:Port┬а ┬а┬а ┬а┬а ┬а┬а┬аForward Weight ActiveConn InActConn TCP┬а┬а192.168.57.136:80 rr ┬а┬а-> 192.168.12.11:80┬а ┬а┬а ┬а┬а ┬а┬а ┬а Masq┬а ┬а 1┬а ┬а┬а ┬а0┬а ┬а┬а ┬а┬а ┬а 0┬а ┬а┬а ┬а┬а ┬а ┬а┬а-> 192.168.12.12:80┬а ┬а┬а ┬а┬а ┬а┬а ┬а Masq┬а ┬а 1┬а ┬а┬а ┬а0┬а ┬а┬а ┬а┬а ┬а 0┬а ┬а┬а ┬а┬а ┬а тюеwindwosт«бТѕиуФ»СИі№╝џ№╝ѕжфїУ»ЂсђѓСИЇТќГуџётѕиТќ░№╝їС╝џУй«У«ГТўЙуц║web1тњїweb2№╝Ѕ ┬а ┬а┬а  ┬а ┬а┬а ┬а┬а тюеweb1СИі№╝џ [root@localhost ~]# tail -f /var/log/httpd/access_log┬а 192.168.57.177 - - [08/Jul/2015:19:18:26 +0800] "GET / HTTP/1.1" 200 28 "-" "Mozilla/5.0 (Windows NT 6.3; WOW64; Trident/7.0; rv:11.0) like Gecko LBBROWSER" тюеweb2СИі№╝џ [root@localhost ~]# tail -f /var/log/httpd/access_log┬а 192.168.57.177 - - [08/Jul/2015:19:18:25 +0800] "GET / HTTP/1.1" 200 28 "-" "Mozilla/5.0 (Windows NT 6.3; WOW64; Trident/7.0; rv:11.0) like Gecko LBBROWSER" ok№╝їrrуџёУ┤ЪУййтЮЄУААуџёУй«У»бТеАт╝Јт░▒У┐ЎТаит«їТѕљС║є№╝Џ LVSуџёDRТеАтъІуџёт«ъжфї№╝џ ┬а ┬а ТІЊТЅЉ№╝џ ┬а ┬а┬а ┬а┬а┬а┬а  ┬а ┬а┬а ┬а┬а ┬а┬а┬а ┬а ┬а уј»тбЃ№╝џ

┬а ┬а┬а ┬а┬а┬аweb1№╝џ192.168.12.11

┬а ┬а┬а ┬а┬а ┬а┬а ┬аУЎџТІЪip№╝џ192.168.12.100

┬а ┬а┬а ┬а┬а┬аweb2№╝џ192.168.12.12

┬а ┬а┬а ┬а┬а ┬а┬а ┬аУЎџТІЪip№╝џ192.168.12.100

┬а ┬а┬а ┬а┬а┬аdirectory№╝џ

┬а ┬а┬а ┬а┬а ┬а┬а ┬атєЁуйЉip№╝џ192.168.12.1

┬а ┬а┬а ┬а┬а ┬а┬а ┬аУЎџТІЪip№╝џ192.168.12.100№╝ѕућеТѕиуЏ┤ТјЦУ«┐жЌ«уџёip№╝Ѕ

┬а ┬а┬а ┬а┬а┬аућеТѕиip№╝џ192.168.12.10

┬а ┬а┬а ┬а┬а┬аwebТюЇтіАтЎе№╝џтЪ║С║јapacheТюЇтіАтЎеТљГт╗║№╝Џ

┬а ┬а┬а ┬а┬а┬аdirecotry№╝џтЪ║С║јlvs№╝Џ

┬а ┬а┬а ┬а┬а┬ат«ъжЎЁућЪС║Дуј»тбЃСИГ№╝їУдЂТ▒ѓУЎџТІЪipт┐ЁжА╗Тў»тЁгуйЉip№╝їСИћУЃйтцЪУбФуЏ┤ТјЦУи»ућ▒тѕ░ућеТѕиуФ»уџё№╝Џ┬а ┬а┬а ┬а┬а┬аwebТюЇтіАтЎеуџёipтю░тЮђС╣ЪТў»тЁгуйЉipтю░тЮђ№╝їСИћУЃйУбФуЏ┤ТјЦУи»ућ▒№╝Џ ┬а ┬а┬а ┬а┬а ┬а┬а ┬аТ│еТёЈ:У┐ЎжЄїтЈфТў»СИ║С║єТхІУ»ЋТЋѕТъю№╝їipтю░тЮђТ▓АТюЅтї║тѕєтєЁуйЉТѕќУђЁтЁгуйЉ№╝Џ ┬а ┬а┬а ┬а┬а┬а 1сђЂтЪ║уАђжЁЇуй«№╝џ ┬а ┬а тюеdirectoryСИі№╝џ [root@localhost ~]# ifconfig eth1┬а ┬а┬а ┬аLink encap:Ethernet┬а┬аHWaddr 00:0C:29:B2:B7:30┬а┬а ┬а ┬а┬а ┬а┬а ┬а inet addr:192.168.12.1┬а┬аBcast:192.168.12.255┬а┬аMask:255.255.255.0 ┬а ┬а┬а ┬а┬а ┬а inet6 addr: fe80::20c:29ff:feb2:b730/64 Scope:Link ┬а ┬а┬а ┬а┬а ┬а UP BROADCAST RUNNING MULTICAST┬а┬аMTU:1500┬а┬аMetric:1 ┬а ┬а┬а ┬а┬а ┬а RX packets:5499 errors:0 dropped:0 overruns:0 frame:0 ┬а ┬а┬а ┬а┬а ┬а TX packets:3875 errors:0 dropped:0 overruns:0 carrier:0 ┬а ┬а┬а ┬а┬а ┬а collisions:0 txqueuelen:1000┬а ┬а ┬а┬а ┬а┬а ┬а RX bytes:486888 (475.4 KiB)┬а┬аTX bytes:470006 (458.9 KiB) ┬а ┬а тюеweb1СИі№╝џ [root@localhost ~]# ifconfig eth1┬а ┬а┬а ┬аLink encap:Ethernet┬а┬аHWaddr 00:0C:29:34:DA:E2┬а┬а ┬а ┬а┬а ┬а┬а ┬а inet addr:192.168.12.11┬а┬аBcast:192.168.12.255┬а┬аMask:255.255.255.0 ┬а ┬а┬а ┬а┬а ┬а inet6 addr: fe80::20c:29ff:fe34:dae2/64 Scope:Link ┬а ┬а┬а ┬а┬а ┬а UP BROADCAST RUNNING MULTICAST┬а┬аMTU:1500┬а┬аMetric:1 ┬а ┬а┬а ┬а┬а ┬а RX packets:3112 errors:0 dropped:0 overruns:0 frame:0 ┬а ┬а┬а ┬а┬а ┬а TX packets:1949 errors:0 dropped:0 overruns:0 carrier:0 ┬а ┬а┬а ┬а┬а ┬а collisions:0 txqueuelen:1000┬а ┬а ┬а┬а ┬а┬а ┬а RX bytes:281203 (274.6 KiB)┬а┬аTX bytes:242480 (236.7 KiB) ┬а ┬а тюеweb2СИі№╝џ [root@localhost ~]# ifconfig eth1┬а ┬а┬а ┬аLink encap:Ethernet┬а┬аHWaddr 00:0C:29:03:A5:B7┬а┬а ┬а ┬а┬а ┬а┬а ┬а inet addr:192.168.12.12┬а┬аBcast:192.168.12.255┬а┬аMask:255.255.255.0 ┬а ┬а┬а ┬а┬а ┬а inet6 addr: fe80::20c:29ff:fe03:a5b7/64 Scope:Link ┬а ┬а┬а ┬а┬а ┬а UP BROADCAST RUNNING MULTICAST┬а┬аMTU:1500┬а┬аMetric:1 ┬а ┬а┬а ┬а┬а ┬а RX packets:2897 errors:0 dropped:0 overruns:0 frame:0 ┬а ┬а┬а ┬а┬а ┬а TX packets:1892 errors:0 dropped:0 overruns:0 carrier:0 ┬а ┬а┬а ┬а┬а ┬а collisions:0 txqueuelen:1000┬а ┬а ┬а┬а ┬а┬а ┬а RX bytes:265958 (259.7 KiB)┬а┬аTX bytes:215427 (210.3 KiB) ┬а ┬а┬а ┬а┬а┬аТ│еТёЈ№╝џwebТюЇтіАтЎетюежЁЇуй«ipтю░тЮђТЌХ№╝їуйЉтЁ│тю░тЮђСИЇУЃйТїЄтљЉdirectoryСИі№╝їСИЇуёХуЏИт║ћТЋ░ТЇ«тїЁС╝џу╗ЈУ┐ЄdirectoryУ┐ЏУАїУйгтЈЉ№╝їУ┐ЎТў»ТѕЉС╗гСИЇТЃ│уюІтѕ░уџё№╝Ђ№╝Ђ№╝Ђ 2сђЂжЁЇуй«УЎџТІЪipтю░тЮђтњїУи»ућ▒№╝џ ┬а ┬а тюеdirectoryСИі№╝џ [root@localhost ~]# ifconfig eth1:0 192.168.12.100 netmask 255.255.255.255 broadcast 192.168.12.100 [root@localhost ~]# route add -host 192.168.12.100 dev eth1:0 [root@localhost ~]# route -n Kernel IP routing table Destination┬а ┬а┬а┬аGateway┬а ┬а┬а ┬а┬а ┬аGenmask┬а ┬а┬а ┬а┬а ┬аFlags Metric Ref┬а ┬а Use Iface 192.168.12.100┬а┬а0.0.0.0┬а ┬а┬а ┬а┬а ┬а255.255.255.255 UH┬а ┬а 0┬а ┬а┬а ┬а0┬а ┬а┬а ┬а┬а┬а0 eth1 192.168.12.0┬а ┬а 0.0.0.0┬а ┬а┬а ┬а┬а ┬а255.255.255.0┬а ┬аU┬а ┬а┬а┬а0┬а ┬а┬а ┬а0┬а ┬а┬а ┬а┬а┬а0 eth1 169.254.0.0┬а ┬а┬а┬а0.0.0.0┬а ┬а┬а ┬а┬а ┬а255.255.0.0┬а ┬а┬а┬аU┬а ┬а┬а┬а1003┬а ┬а0┬а ┬а┬а ┬а┬а┬а0 eth1 ┬а ┬а тюеweb1СИі№╝џ [root@localhost ~]# ifconfig lo:0 192.168.12.100 netmask 255.255.255.255 broadcast 192.168.12.100 [root@localhost ~]# route add -host 192.168.12.100 dev lo:0 [root@localhost ~]# route -n Kernel IP routing table Destination┬а ┬а┬а┬аGateway┬а ┬а┬а ┬а┬а ┬аGenmask┬а ┬а┬а ┬а┬а ┬аFlags Metric Ref┬а ┬а Use Iface 192.168.12.100┬а┬а0.0.0.0┬а ┬а┬а ┬а┬а ┬а255.255.255.255 UH┬а ┬а 0┬а ┬а┬а ┬а0┬а ┬а┬а ┬а┬а┬а0 lo 192.168.12.0┬а ┬а 0.0.0.0┬а ┬а┬а ┬а┬а ┬а255.255.255.0┬а ┬аU┬а ┬а┬а┬а0┬а ┬а┬а ┬а0┬а ┬а┬а ┬а┬а┬а0 eth1 169.254.0.0┬а ┬а┬а┬а0.0.0.0┬а ┬а┬а ┬а┬а ┬а255.255.0.0┬а ┬а┬а┬аU┬а ┬а┬а┬а1002┬а ┬а0┬а ┬а┬а ┬а┬а┬а0 eth1 ┬а ┬а тюеweb2СИі№╝џ [root@localhost ~]# ifconfig lo:0 192.168.12.100 netmask 255.255.255.255 broadcast 192.168.12.100 [root@localhost ~]# route add -host 192.168.12.100 dev lo:0 [root@localhost ~]# route -n Kernel IP routing table Destination┬а ┬а┬а┬аGateway┬а ┬а┬а ┬а┬а ┬аGenmask┬а ┬а┬а ┬а┬а ┬аFlags Metric Ref┬а ┬а Use Iface 192.168.12.100┬а┬а0.0.0.0┬а ┬а┬а ┬а┬а ┬а255.255.255.255 UH┬а ┬а 0┬а ┬а┬а ┬а0┬а ┬а┬а ┬а┬а┬а0 lo 192.168.12.0┬а ┬а 0.0.0.0┬а ┬а┬а ┬а┬а ┬а255.255.255.0┬а ┬аU┬а ┬а┬а┬а0┬а ┬а┬а ┬а0┬а ┬а┬а ┬а┬а┬а0 eth1 169.254.0.0┬а ┬а┬а┬а0.0.0.0┬а ┬а┬а ┬а┬а ┬а255.255.0.0┬а ┬а┬а┬аU┬а ┬а┬а┬а1002┬а ┬а0┬а ┬а┬а ┬а┬а┬а0 eth1 ┬а ┬а ok№╝їСИЅСИфУіѓуѓ╣СИіжЃйУдЂжЁЇуй«УЎџТІЪipтю░тЮђтЈіУи»ућ▒№╝Џ ┬а ┬а Т│еТёЈ№╝џУЎџТІЪipтю░тЮђуџёТјЕуаЂт┐ЁжА╗Тў»Рђю255.255.255.255РђЮуџё№╝Ђ№╝Ђ№╝Ђ 3сђЂжЁЇуй«webТюЇтіАтЎетєЁТаИтЈѓТЋ░сђѓ №╝ѕжў▓ТГбУЎџТІЪipтю░тЮђТЅђтюеуйЉтЇАСИ╗тіетцќуйЉжђџтЉіmacтю░тЮђ№╝їжў▓ТГбУЎџТІЪipтю░тЮђТЅђтюеуйЉтЇАСИ╗тіетЊЇт║ћУ»иТ▒ѓсђѓтдѓТъюСИЇУ┐ЎТаитЂџ№╝їС╝џт»╝УЄ┤СИЅСИфУіѓуѓ╣СИіуџёУЎџТІЪipтю░тЮђтє▓уфЂсђѓтЏаТГц№╝їтЈфУЃйжЎљтѕХwebТюЇтіАтЎеСИіуџёУЎџТІЪipтю░тЮђ№╝їУђїСИЇТў»directoryСИіуџё№╝Ѕ ┬а ┬а тюеweb1тњїweb2СИі№╝џ [root@localhost conf]# pwd /proc/sys/net/ipv4/conf [root@localhost conf]# echo 1 > all/arp_ignore┬а [root@localhost conf]# echo 1 > eth1/arp_ignore┬а [root@localhost conf]# echo 2 > eth1/arp_announce┬а [root@localhost conf]# echo 2 > all/arp_announce┬а ┬а ┬а Т│еТёЈ№╝џУ┐ЎжЄїСИ║С║єжў▓ТГбтЄ║уј░ТёЈтцќ№╝їТѕЉС╗гт»╣ТЅђТюЅуйЉтЇАтњїуЅЕуљєуйЉтЇАжЃйУ┐ЏУАїС║єжђџтЉітњїтЊЇт║ћжЎљтѕХ№╝Џ ipvsУДётѕЎуџётѕЏт╗║№╝џ ┬а ┬а тюеdirecrotyСИі№╝џ ┬а ┬а┬а [root@localhost ~]# ipvsadm -A -t 192.168.12.100:80 -s rr [root@localhost ~]# ipvsadm -a -t 192.168.12.100:80 -r 192.168.12.11 -g [root@localhost ~]# ipvsadm -a -t 192.168.12.100:80 -r 192.168.12.12 -g [root@localhost ~]# ipvsadm -L -n IP Virtual Server version 1.2.1 (size=4096) Prot LocalAddress:Port Scheduler Flags ┬а┬а-> RemoteAddress:Port┬а ┬а┬а ┬а┬а ┬а┬а┬аForward Weight ActiveConn InActConn TCP┬а┬а192.168.12.100:80 rr ┬а┬а-> 192.168.12.11:80┬а ┬а┬а ┬а┬а ┬а┬а ┬а Route┬а ┬а1┬а ┬а┬а ┬а0┬а ┬а┬а ┬а┬а ┬а 0┬а ┬а┬а ┬а┬а ┬а ┬а┬а-> 192.168.12.12:80┬а ┬а┬а ┬а┬а ┬а┬а ┬а Route┬а ┬а1┬а ┬а┬а ┬а0┬а ┬а┬а ┬а┬а ┬а 0┬а┬а ┬а ┬а Т│еТёЈ№╝џУ┐ЎжЄїтЏаСИ║Тў»DRТеАтъІ№╝їТЅђС╗Цт┐ЁжА╗Тў»Рђю-gРђЮжђЅжА╣сђѓС╗╗уёХжЄЄућетЮЄУААуџёУй«У»бТќ╣т╝ЈтцёуљєУ»иТ▒ѓ№╝Џ ┬а ┬а ok№╝їlvsуџёDRТеАтъІуџёrrу«ЌТ│ЋУ░Ѓт║дУЄ│ТГцжЁЇуй«т«їТ»Ћ№╝Џ 4сђЂТхІУ»Ћ№╝џ ┬а ┬а тюеwindowsт«бТѕиТю║СИі№╝џ№╝ѕСИЇТќГуџётѕиТќ░С╝џтЄ║уј░Уй«У«Гуџёуј░У▒А№╝Ѕ┬а  ┬а ┬а┬а ┬а тюеdirecotryСИі№╝џ ┬а ┬а┬а [root@localhost ~]# ipvsadm -L -n IP Virtual Server version 1.2.1 (size=4096) Prot LocalAddress:Port Scheduler Flags ┬а┬а-> RemoteAddress:Port┬а ┬а┬а ┬а┬а ┬а┬а┬аForward Weight ActiveConn InActConn TCP┬а┬а192.168.12.100:80 rr ┬а┬а-> 192.168.12.11:80┬а ┬а┬а ┬а┬а ┬а┬а ┬а Route┬а ┬а1┬а ┬а┬а ┬а0┬а ┬а┬а ┬а┬а ┬а 16┬а ┬а┬а ┬а┬а┬а ┬а┬а-> 192.168.12.12:80┬а ┬а┬а ┬а┬а ┬а┬а ┬а Route┬а ┬а1┬а ┬а┬а ┬а0┬а ┬а┬а ┬а┬а ┬а 16┬а┬а ┬а ┬а┬а ┬а┬а┬а№╝џтЈ»С╗ЦуюІтѕ░СИцтЈ░ТюЇтіАтЎетЊЇт║ћУ┐ъТјЦТў»тЮЄУААуџё№╝Џ ok№╝їт«ъжфїТѕљтіЪ№╝Ђ |

УйгУЄфhttp://www.iyunv.com/thread-85077-1-1.html

┬а

┬а

уЏИтЁ│ТјеУЇљ

тЁХТаИт┐ЃС╝ўті┐тюеС║јжђџУ┐ЄуЏ┤ТјЦУи»ућ▒уџёТќ╣т╝Ј№╝їтюеТЋ░ТЇ«жЊЙУи»т▒ѓт«ъуј░У»иТ▒ѓуџётѕєтЈЉ№╝їжЂ┐тЁЇС║єС╝ау╗ЪNATТеАтъІСИІуџёIPтю░тЮђУйгТЇб№╝їС╗јУђїТўЙУЉЌТЈљжФўС║єтцёуљєжђЪт║дтњїТЋ┤СйЊТђДУЃйсђѓ **1.1 У»иТ▒ѓтцёуљєТхЂуеІ** - **ТјЦТћХУ»иТ▒ѓ**№╝џLVS-DRуџётЅЇуФ»У┤ЪУййтЮЄУААтЎе...

LVSжђџУ┐ЄСИЇтљїуџётиЦСйюТеАт╝Ј№╝їтїЁТІгVS/NATсђЂVS/TUNтњїVS/DR№╝їт«ъуј░С║єУ┤ЪУййтЮЄУААтіЪУЃй№╝їтЁХСИГVS/NATТеАтъІТў»тЁХСИђуДЇтИИУДЂуџётиЦСйюТќ╣т╝Јсђѓ **LVS-NATТеАтъІтјЪуљє** тюеLVS-NATТеАтъІСИГ№╝їLVSУ░Ѓт║дтЎе№╝ѕDirector№╝ЅжђџУ┐ЄС┐«Тћ╣IPтїЁуџёТ║љТѕќуЏ«ТаЄIPтю░тЮђ№╝ї...

### LVS т«ъуј░У┤ЪУййтЮЄУААУ»дУДБ #### СИђсђЂLVSу«ђС╗ІСИјжЄЇУдЂТђД LVS (Linux Virtual Server) Тў»СИђуДЇтюе Linux т╣│тЈ░СИіт«ъуј░У┤ЪУйй...т»╣С║јтИїТюЏТЈљтЇЄуйЉу╗юТюЇтіАТђДУЃйуџёС╝ЂСИџтњїСИфС║║ТЮЦУ»┤№╝їС║єУДБт╣ХТјїТЈА LVS уџётјЪуљєтњїжЁЇуй«Тќ╣Т│ЋТў»жЮътИИТюЅС╗итђ╝уџёсђѓ

ТѕЉС╗гтюеСИітЇџТќЄРђюУ┐љу╗┤тиЦуеІтИѕт┐ЁтцЄС╣ІУ┤ЪУййтЮЄУААжЏєуЙцтЈіLVSУ»дУДБРђЮСИГУ»ду╗єС╗Іу╗ЇС║єУ┤ЪУййтЮЄУААтњїжЏєуЙцуџётЪ║ТюгуљєУ«║тњїу▒╗тѕФ№╝їТГцтцёСИЇтюеУ»ду╗єС╗Іу╗Ї№╝їтюеТюгу»ЄтЇџТќЄСИГтѕЎСИ╗УдЂС╗ЦLBУ┤ЪУййтЮЄУААжЏєуЙцуџёу▒╗тѕФ№╝џNATтњїDRТеАтъІуџёwebуйЉу╗юТъХТъёУ┐ЏУАїт«ъСЙІС╗Іу╗Ї№╝їС╗ЦСЙ┐...

**У┤ЪУййтЮЄУААТюЇтіА№╝ѕLVS№╝ЅУ»дУДБ** тюеТъёт╗║тцДтъІсђЂжФўТђДУЃйуџёуйЉу╗юТюЇтіАТЌХ№╝їУ┤ЪУййтЮЄУААТіђТю»Тў»СИЇтЈ»Тѕќу╝║уџётЁ│жћ«у╗ёС╗Хсђѓ...жђџУ┐ЄТи▒тЁЦтГдС╣аLVSуџёуЏИтЁ│ТќЄТАБ№╝їтдѓ"LVS.pdf"№╝їтЈ»С╗ЦУ┐ЏСИђТГЦС║єУДБтЁХУ»ду╗єжЁЇуй«тњїСй┐ућеТіђтиД№╝їТЈљтЇЄуйЉу╗юТюЇтіАуџёу«АуљєУЃйтіЏсђѓ

### LVS+Keepalived т«ъуј░жФўтЈ»ућеУ┤ЪУййтЮЄУАА ...у╗╝СИіТЅђУ┐░№╝їжђџУ┐ЄLVS+Keepalivedу╗ЊтљѕDRТеАтъІ№╝їтЈ»С╗ЦТъёт╗║тЄ║СИђтЦЌТЌбжФўТЋѕтЈѕуе│т«џуџёжФўтЈ»ућеУ┤ЪУййтЮЄУААу│╗у╗Ъ№╝їУ┐Ўт»╣С║јтцёуљєтцДжЄЈт╣ХтЈЉУ«┐жЌ«сђЂТЈљжФўТюЇтіАтЈ»жЮаТђДтњїућеТѕиСйЊжфїУЄ│тЁ│жЄЇУдЂсђѓ

LVS жђџтИИСй┐ућеСИЅуДЇТеАтъІТЮЦт«ъуј░У┤ЪУййтЮЄУАА№╝џNAT ТеАтъІсђЂDR ТеАтъІтњї TUN ТеАтъІсђѓТюгТќЄт░єУ»ду╗єС╗Іу╗Ї NAT тњї DR ТеАтъІ№╝їт╣Ху╗ЎтЄ║тЁиСйЊуџёжЁЇуй«уц║СЙІсђѓ #### СИЅсђЂNAT ТеАтъІ NAT (Network Address Translation) ТеАтъІТў»Тюђу«ђтЇЋуџё LVS ТъХТъёС╣І...

- **VS/NAT**№╝ѕУЎџТІЪТюЇтіАтЎежђџУ┐ЄуйЉу╗ютю░тЮђУйгТЇб№╝Ѕ№╝џжђѓтљѕС║јУЙЃт░ЈУДёТеАуџёжЏєуЙц№╝їТўЊС║јт«ъуј░тњїу«Ауљє№╝їСйєтЈ»УЃйтбътіажбЮтцќуџёуйЉу╗ют╗ХУ┐Ъсђѓ - **VS/TUN**№╝ѕУЎџТІЪТюЇтіАтЎежђџУ┐ЄIPжџДжЂЊ№╝Ѕ№╝џжђѓућеС║јтю░уљєСйЇуй«тѕєТЋБуџёТюЇтіАтЎежЏєуЙц№╝їтЈ»С╗ЦУиеУХіСИЇтљїуџёуЅЕуљє...

- **уйЉу╗ютю░тЮђУйгТЇб(Network Address Translation, NAT)**№╝џтюеУ┐ЎуДЇТеАт╝ЈСИІ№╝їLVSУ░Ѓт║дтЎет░єУ»иТ▒ѓТіЦТќЄуџёуЏ«ТаЄIPтю░тЮђтњїуФ»тЈБТћ╣СИ║тљјуФ»ТюЇтіАтЎеуџёIPтю░тЮђтњїуФ»тЈБ№╝їуёХтљјУйгтЈЉу╗ЎТюЇтіАтЎе№╝їУ┐ћтЏъТЌХтєЇУ┐ЏУАїтЈЇтљЉУйгТЇбсђѓNATТеАт╝Јт»╣уйЉу╗юуј»тбЃуџёУдЂТ▒ѓУЙЃ...

LVS уџётиЦСйюТеАт╝ЈСИ╗УдЂТюЅ 4 уДЇ№╝џDRсђЂNATсђЂTUNNEL тњї Full-NATсђѓСИІжЮбТѕЉС╗гТЮЦу«ђтЇЋС╗Іу╗ЇСИђСИІ DRсђЂNAT тњї Full-NAT ТеАт╝Јсђѓ 1сђЂDR ТеАт╝Ј У»иТ▒ѓућ▒ LVS ТјЦтЈЌ№╝їућ▒уюЪт«ъТЈљСЙЏТюЇтіАуџёТюЇтіАтЎе№╝ѕRealServer, RS№╝ЅуЏ┤ТјЦУ┐њтЏъу╗ЎућеТѕи№╝їУ┐њтЏъуџё...

жђџУ┐ЄтљѕуљєуџёТъХТъёУ«ЙУ«АтњїуГќуЋЦжЁЇуй«№╝їLVSСИЇС╗ЁТЈљжФўС║єТюЇтіАуџётЈ»ућеТђД№╝їУ┐ўТЈљтЇЄС║єу│╗у╗ЪуџёС╝Иу╝ЕТђДтњїТђДУЃйсђѓу╗ЊтљѕJavaТіђТю»№╝їт«ЃТъёт╗║С║єСИђСИфтЂЦтБ«сђЂуЂхТ┤╗уџёућхтЋєТюЇтіАтЪ║уАђУ«ЙТќй№╝їуА«С┐ЮС║єТиўт«Ют╣│тЈ░уџёуе│т«џУ┐љУАї№╝їСИ║ућеТѕиТЈљСЙЏТЌаСИГТќГуџёУ┤ГуЅЕСйЊжфїсђѓ

LVSтЪ║С║јOSIТеАтъІуџёуггтЏЏт▒ѓРђћРђћС╝аУЙЊт▒ѓ№╝їТћ»ТїЂTCPтњїUDPтЇЈУ««сђѓтЁХУйгтЈЉСИ╗УдЂжђџУ┐ЄСИцуДЇТќ╣т╝Ј№╝џIPтю░тЮђС┐«Тћ╣№╝ѕNATТеАт╝Ј№╝ЅтњїуЏ«ТаЄMACтю░тЮђС┐«Тћ╣№╝ѕDRТеАт╝Ј№╝Ѕсђѓ **LVSтюеуггтЏЏт▒ѓтЂџУ┤ЪУййтЮЄУААуџётјЪтЏа** 1. **СИЇтцёуљєHTTPтїЁ**№╝џLVSСИЇУДБТъљт║ћућет▒ѓуџё...

LVSТћ»ТїЂтцџуДЇтиЦСйюТеАт╝Ј№╝їтдѓ№╝џNAT№╝ѕуйЉу╗ютю░тЮђУйгТЇб№╝ЅсђЂIP Tunneling№╝ѕIPжџДжЂЊ№╝ЅсђЂDirect Routing№╝ѕуЏ┤ТјЦУи»ућ▒№╝ЅтњїDR№╝ѕуЏ┤ТјЦУи»ућ▒№╝ЅсђѓУ┐ЎС║ЏТеАт╝ЈтЈ»С╗ЦТа╣ТЇ«СИЇтљїуџёуйЉу╗юуј»тбЃтњїжюђТ▒ѓжђЅТІЕ№╝їт«ъуј░жФўТЋѕуџёУ┤ЪУййтѕєтЈЉсђѓLVSТЅІтєїСИГТќЄтіауЏ«тйЋуЅѕ.doc...

- т»╣С║јNATТеАтъІ№╝їуюЪт«ъТюЇтіАтЎеуџёуйЉтЁ│т║ћжЁЇуй«СИ║LVSУ░Ѓт║дтЎеуџётєЁжЃеТјЦтЈБтю░тЮђсђѓ жђџУ┐ЄС╗ЦСИіуЪЦУ»єуѓ╣уџёС╗Іу╗Ї№╝їТѕЉС╗гтЈ»С╗ЦуюІтѕ░т«ъуј░СИђСИфтЪ║С║јLVSуџёHTTPУ┤ЪУййУ░Ѓт║дтЎеСИЇС╗ЁжюђУдЂт»╣LVSтЈіУ┤ЪУййтЮЄУААтјЪуљєТюЅТи▒тЁЦС║єУДБ№╝їУ┐ўжюђУдЂтЁитцЄТюЇтіАтЎежЁЇуй«сђЂуйЉу╗ютЈѓТЋ░...

жђџУ┐Єт»╣ LVS тњї Keepalived уџёТи▒тЁЦС║єУДБ№╝їС╗ЦтЈітЁиСйЊуџёжЃеуй▓ТГЦжфцтњїТіђТю»у╗єУіѓуџётГдС╣а№╝їтЈ»С╗ЦтИ«тіЕ IT С║║тЉўТЏ┤тЦйтю░у«Ауљєтњїу╗┤ТіцУ┐ЎуДЇу▒╗тъІуџёу│╗у╗ЪТъХТъёсђѓТГцтцќ№╝їжђџУ┐Єт«ъУихТЊЇСйю№╝їУ┐ўтЈ»С╗ЦУ┐ЏСИђТГЦТјбу┤бтдѓСйЋС╝ўтїќтњїУ░ЃТЋ┤У»ЦТъХТъёС╗Цжђѓт║ћСИЇтљїуџёт║ћуће...

- **NAT№╝ѕNetwork Address Translation№╝ЅТќ╣т╝Ј**№╝џС╣ЪуД░СИ║IPС╝фУБЁ№╝їт«бТѕиуФ»СИјТюЇтіАтЎеС╣ІжЌ┤уџёжђџС┐АжђџУ┐ЄLVSУіѓуѓ╣№╝їLVSУіѓуѓ╣С┐«Тћ╣т«бТѕиуФ»уџёIPтю░тЮђтњїуФ»тЈБтЈи№╝їСй┐тЙЌТюЇтіАтЎеуюІтѕ░уџёУ»иТ▒ѓТ║љТў»LVSУіѓуѓ╣уџёIP№╝їУђїуюЪт«ъуџёТюЇтіАтЎеIPт»╣т«бТѕиуФ»Тў»жђЈТўј...