转http://blog.csdn.net/blade2001/article/details/9065985

先确定pid:

top

找到最消耗cpu的进程15495

再确定tid:

ps -mp 15495 -o THREAD,tid,time

找到最占用cpu的进程18448

printf "%x\n" 18448

4810

打印堆栈

jstack 15495 | grep 4810 -A 30

例如发现栈如下:

"regionserver60020-smallCompactions-1438827962552" daemon prio=10 tid=0x00007f4ce1903800 nid=0xe2a72 runnable [0x00007f443b8f6000]

java.lang.Thread.State: RUNNABLE

at com.hadoop.compression.lzo.LzoDecompressor.decompressBytesDirect(Native Method)

at com.hadoop.compression.lzo.LzoDecompressor.decompress(LzoDecompressor.java:315)

- locked <0x00007f450c42d820> (a com.hadoop.compression.lzo.LzoDecompressor)

at org.apache.hadoop.io.compress.BlockDecompressorStream.decompress(BlockDecompressorStream.java:88)

at org.apache.hadoop.io.compress.DecompressorStream.read(DecompressorStream.java:85)

at java.io.BufferedInputStream.read1(BufferedInputStream.java:273)

at java.io.BufferedInputStream.read(BufferedInputStream.java:334)

- locked <0x00007f4494423b70> (a java.io.BufferedInputStream)

at org.apache.hadoop.io.IOUtils.readFully(IOUtils.java:192)

at org.apache.hadoop.hbase.io.compress.Compression.decompress(Compression.java:439)

at org.apache.hadoop.hbase.io.encoding.HFileBlockDefaultDecodingContext.prepareDecoding(HFileBlockDefaultDecodingContext.java:91)

at org.apache.hadoop.hbase.io.hfile.HFileBlock$FSReaderV2.readBlockDataInternal(HFileBlock.java:1522)

at org.apache.hadoop.hbase.io.hfile.HFileBlock$FSReaderV2.readBlockData(HFileBlock.java:1314)

at org.apache.hadoop.hbase.io.hfile.HFileReaderV2.readBlock(HFileReaderV2.java:358)

at org.apache.hadoop.hbase.io.hfile.HFileReaderV2$AbstractScannerV2.readNextDataBlock(HFileReaderV2.java:610)

at org.apache.hadoop.hbase.io.hfile.HFileReaderV2$ScannerV2.next(HFileReaderV2.java:724)

at org.apache.hadoop.hbase.regionserver.StoreFileScanner.next(StoreFileScanner.java:136)

at org.apache.hadoop.hbase.regionserver.KeyValueHeap.next(KeyValueHeap.java:108)

at org.apache.hadoop.hbase.regionserver.StoreScanner.next(StoreScanner.java:507)

at org.apache.hadoop.hbase.regionserver.compactions.Compactor.performCompaction(Compactor.java:217)

at org.apache.hadoop.hbase.regionserver.compactions.DefaultCompactor.compact(DefaultCompactor.java:76)

at org.apache.hadoop.hbase.regionserver.DefaultStoreEngine$DefaultCompactionContext.compact(DefaultStoreEngine.java:109)

at org.apache.hadoop.hbase.regionserver.HStore.compact(HStore.java:1106)

at org.apache.hadoop.hbase.regionserver.HRegion.compact(HRegion.java:1482)

at org.apache.hadoop.hbase.regionserver.CompactSplitThread$CompactionRunner.run(CompactSplitThread.java:475)

at java.util.concurrent.ThreadPoolExecutor.runWorker(ThreadPoolExecutor.java:1145)

at java.util.concurrent.ThreadPoolExecutor$Worker.run(ThreadPoolExecutor.java:615)

at java.lang.Thread.run(Thread.java:745)

是读写hfile发生的错误,导致启动多个runnable

一个应用占用CPU很高,除了确实是计算密集型应用之外,通常原因都是出现了死循环。

(友情提示:本博文章欢迎转载,但请注明出处:hankchen,http://www.blogjava.net/hankchen)

以我们最近出现的一个实际故障为例,介绍怎么定位和解决这类问题。

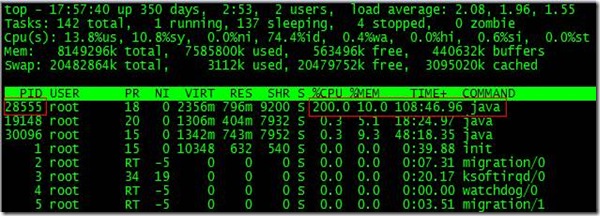

根据top命令,发现PID为28555的Java进程占用CPU高达200%,出现故障。

通过ps aux | grep PID命令,可以进一步确定是tomcat进程出现了问题。但是,怎么定位到具体线程或者代码呢?

首先显示线程列表:

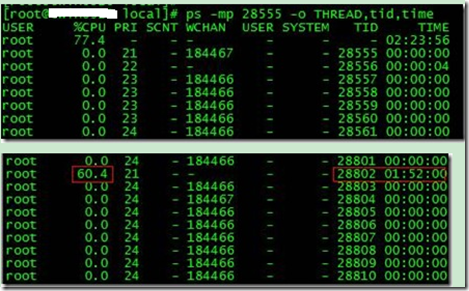

ps -mp pid -o THREAD,tid,time

找到了耗时最高的线程28802,占用CPU时间快两个小时了!

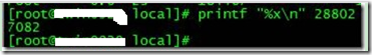

其次将需要的线程ID转换为16进制格式:

printf "%x\n" tid

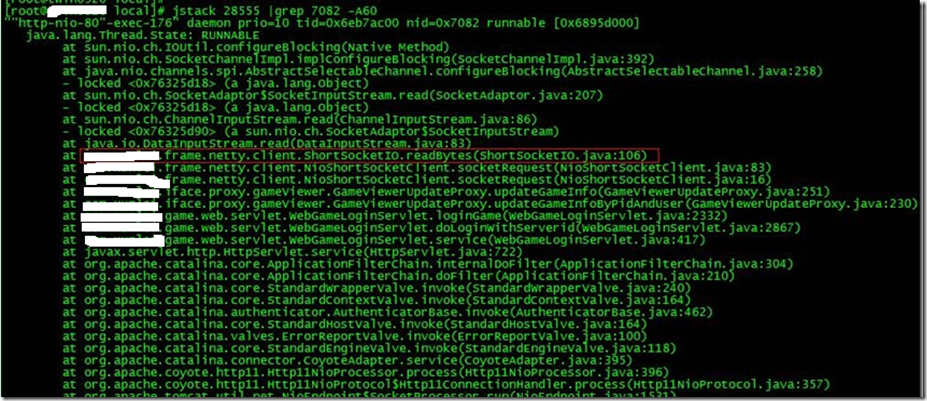

最后打印线程的堆栈信息:

jstack pid |grep tid -A 30

找到出现问题的代码了!

现在来分析下具体的代码:ShortSocketIO.readBytes(ShortSocketIO.java:106)

ShortSocketIO是应用封装的一个用短连接Socket通信的工具类。readBytes函数的代码如下:

public byte[] readBytes(int length) throws IOException {

if ((this.socket == null) || (!this.socket.isConnected())) {

throw new IOException("++++ attempting to read from closed socket");

}

byte[] result = null;

ByteArrayOutputStream bos = new ByteArrayOutputStream();

if (this.recIndex >= length) {

bos.write(this.recBuf, 0, length);

byte[] newBuf = new byte[this.recBufSize];

if (this.recIndex > length) {

System.arraycopy(this.recBuf, length, newBuf, 0, this.recIndex - length);

}

this.recBuf = newBuf;

this.recIndex -= length;

} else {

int totalread = length;

if (this.recIndex > 0) {

totalread -= this.recIndex;

bos.write(this.recBuf, 0, this.recIndex);

this.recBuf = new byte[this.recBufSize];

this.recIndex = 0;

}

int readCount = 0;

while (totalread > 0) {

if ((readCount = this.in.read(this.recBuf)) > 0) {

if (totalread > readCount) {

bos.write(this.recBuf, 0, readCount);

this.recBuf = new byte[this.recBufSize];

this.recIndex = 0;

} else {

bos.write(this.recBuf, 0, totalread);

byte[] newBuf = new byte[this.recBufSize];

System.arraycopy(this.recBuf, totalread, newBuf, 0, readCount - totalread);

this.recBuf = newBuf;

this.recIndex = (readCount - totalread);

}

totalread -= readCount;

}

}

}

问题就出在标红的代码部分。如果this.in.read()返回的数据小于等于0时,循环就一直进行下去了。而这种情况在网络拥塞的时候是可能发生的。

至于具体怎么修改就看业务逻辑应该怎么对待这种特殊情况了。

最后,总结下排查CPU故障的方法和技巧有哪些:

1、top命令:Linux命令。可以查看实时的CPU使用情况。也可以查看最近一段时间的CPU使用情况。

2、PS命令:Linux命令。强大的进程状态监控命令。可以查看进程以及进程中线程的当前CPU使用情况。属于当前状态的采样数据。

3、jstack:Java提供的命令。可以查看某个进程的当前线程栈运行情况。根据这个命令的输出可以定位某个进程的所有线程的当前运行状态、运行代码,以及是否死锁等等。

4、pstack:Linux命令。可以查看某个进程的当前线程栈运行情况。

(友情提示:本博文章欢迎转载,但请注明出处:hankchen,http://www.blogjava.net/hankchen)

相关推荐

本文档围绕Java线上故障排查提供了详尽的方案和知识点,覆盖了从问题定位到解决方案的多个方面。 首先,了解Java线上常见问题的分类是非常重要的。在生产环境中,问题可大致分为系统异常和业务异常两大类。系统异常...

Java线上故障排查是每个Java开发者或运维人员必备的技能之一,尤其在生产环境中,快速定位并解决问题至关重要。本文将深入探讨Java线上故障排查方案,帮助你掌握一系列实用的方法和技术。 一、日志分析 1. 日志级别...

### Java线上故障排查方案 #### 一、引言 在软件开发领域,处理生产环境中的问题是一项必备技能。生产环境中可能会遇到多种复杂的情况,比如代码bug、硬件故障、网络问题等,这些都可能导致应用程序无法正常运行。...

线上故障排查是IT运维中的重要环节,涉及到系统的稳定性和服务的连续性。本文主要讨论了四种常见的线上故障类型:CPU问题、频繁GC、上下文切换过多以及磁盘问题,并提供了相应的排查工具和方法。 首先,CPU异常是较...

本文将详细介绍一套线上故障排查的全面方案,涵盖CPU、磁盘、内存和网络四个关键层面。 首先,CPU异常是常见的故障类型。CPU使用率过高可能是由于业务逻辑中的死循环、频繁的垃圾回收(GC)或者上下文切换过于频繁...

Java运行时监控是Java开发和运维过程中至关重要的一个环节,它可以帮助我们实时了解应用程序的运行状态,及时发现并解决问题,确保系统的稳定性和性能。本文将深入探讨Java运行时监控的相关知识点,结合提供的压缩包...

Arthas的灵活性和强大功能使其成为Java开发者必备的工具之一,它能有效提升问题排查的效率,确保应用程序的稳定运行。通过熟练掌握Arthas,开发者可以在面对复杂问题时更加从容,及时解决线上故障,保障服务的高可用...

3. **CPU使用率监控**:VJTop可以实时监控Java应用的CPU使用率,帮助找出CPU占用过高的线程,分析其执行的代码,从而优化性能。 4. **方法耗时统计**:通过追踪方法调用耗时,VJTop能帮助开发者识别出性能瓶颈,...

基本的疑难排查步骤包括:执行 top 命令记录 CPU 使用率,执行 free 命令记录内存使用率,使用 ps 命令记录进程信息,使用 jstack 收集线程信息,使用 jstat 视图 Old 区占用率,使用 jmap 保留内存信息等。...

Arthas是一款强大的Java线上诊断工具,由Alibaba开源,它提供了多种功能,帮助开发者在不重启应用的情况下高效地解决线上问题。Arthas的使用可以极大提高问题定位和排查的效率,对于企业内部的运维和开发人员来说...

线上故障主要会包括 CPU、内存、磁盘以及网络问题,而大多数故障可能会包含不止一个层面的问题,所以进行排查时候尽量四个方面依次排查一遍。基本上出问题就是 df、free、top,然后依次 使用jstack、jmap,具体问题...

- **性能优化**:对应用进行性能分析,如内存泄漏检测、CPU占用率监控,提高应用响应速度和运行效率。 - **模块化开发**:实现模块化的代码结构,便于代码复用和后期维护。 - **集成第三方库**:集成并配置各种第...

#### 三、故障排查步骤 ##### 1. 获取故障进程ID - **工具**: `jps` - **功能**: `jps`(JVM Process Status Tool)是一个用来显示指定系统中所有HotSpot虚拟机进程的工具。 - **命令**: `jps -l -m` - `-l`: ...

3. 故障排查效率:培训开发人员快速定位和解决问题,减少故障持续时间。 4. 优先级排序:随着问题增多,确定优先级至关重要,关键问题需优先解决。 5. 性能监控:通过监控系统CPU、内存使用情况,及时发现并定位性能...

Java线程堆栈分析是排查性能瓶颈的重要手段之一,通过分析线程的状态、锁持有情况等信息,可以定位到可能的问题根源。 - **借助堆栈分析性能瓶颈** 结合实际案例,分享如何利用Java线程堆栈分析工具来诊断性能...