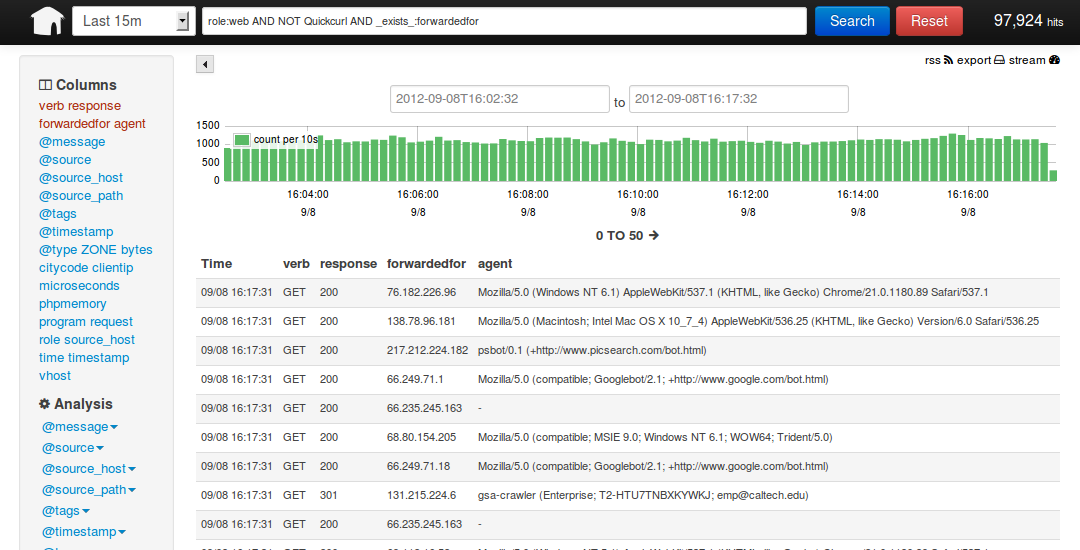

用Kibana和logstash快速搭建实时日志查询、收集与分析系统

- [192.168.233.128 root@nodec:~]

- # cd /soft/

- [192.168.233.128 root@nodec:/soft]

- # wget http://down1.chinaunix.net/distfiles/jdk-6u13-dlj-linux-i586.bin

- 从oracle下载实在是太慢了,从CU下载会快一些,如果需要最新版本请访问这里

- http://www.oracle.com/technetwork/java/javase/downloads/jdk7-downloads-1880260.html

- [192.168.233.128 root@nodec:/soft]

- # sh jdk-6u13-dlj-linux-i586.bin

- 输入yes 便开始安装了

- 安装完成后设置一下 JAVA_HOME

- [192.168.233.128 root@nodec:/soft/Kibana-0.2.0]

- # vim /etc/profile

- export JAVA_HOME=/usr/java

- export PATH=$JAVA_HOME/bin:$PATH

- export CLASSPATH=.:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar:$CLASSPATH

- 安装ruby 就比较简单了(Kibana需要ruby 1.8.7以上版本)

- [192.168.233.128 root@nodec:/soft]

- # yum install ruby rubygems

- ..... 安装内容省略

- 安装完成后用 rubygems 来安装bundler

- [192.168.233.128 root@nodec:/soft]

- # /usr/bin/gem install bundler

- .....

- ok 这样基本的环境就已经有了,下面就是安装kibana 和 logstash

- 其实logstash 就是一个java脚本,不需要安装... 下载即用

- [192.168.233.128 root@nodec:/soft]

- # wget http://logstash.objects.dreamhost.com/release/logstash-1.1.0-monolithic.jar

- 现在看看 这个脚本应该怎么去执行

- [192.168.233.128 root@nodec:/soft]

- # java -jar /soft/logstash-1.1.0-monolithic.jar -h

- No such command "-h"

- Available commands:

- -v

- -V

- --version

- agent

- web

- test

- 显然没有 -h 参数,不过列出了能用的参数,但是logstash的参数可不止这些,

- java -jar /soft/logstash-1.1.0-monolithic.jar agent --help

- 这些是在agent模式下的命令参数

- -f, --config CONFIGFILE

- Load the logstash config from a specific file, directory, or a wildcard. If given a directory or wildcard, config files will be read in order lexigraphically.

- -e CONFIGSTRING

- Use the given string as the configuration data. Same syntax as the config file. If not input is specified, 'stdin { type => stdin }' is default. If no output is specified, 'stdout { debug => true }}' is default.

- -w, --filterworks COUNT

- Run COUNT filter workers (default: 1)

- --watchdog-timeout TIMEOUT

- Set watchdog timeout value.

- -l, --log FILE

- Log to a given path. Default is to log to stdout

- -v

- Increase verbosity. There are multiple levels of verbosity available with '-vv' currently being the highest

- --pluginpath PLUGIN_PATH

- A colon-delimted path to find other logstash plugins in

- java -jar /soft/logstash-1.1.0-monolithic.jar web --help

- 下面的是在web界面的参数

- --log FILE

- Log to a given path. Default is stdout.

- --address ADDRESS

- Address on which to start webserver. Default is 0.0.0.0.

- --port PORT

- Port on which to start webserver. Default is 9292.

- -B, --elasticsearch-bind-host ADDRESS

- Address on which to bind elastic search node.

- -b, --backend URL

- The backend URL to use. Default is elasticsearch:/// (assumes multicast discovery). You can specify elasticsearch://[host][:port]/[clustername]

如果上面的这些命令都能执行正常的话就表示 logstash可以使用了,但要让他启动还需要一个配置文件

- [192.168.233.128 root@nodec:/soft]

- # vim redis.conf

- input {

- redis {

- host => '192.168.233.130'

- data_type => 'list'

- port => "6379"

- key => 'logstash:redis'

- type => 'redis-input'

- }

- }

- output {

- elasticsearch {

- embedded => true

- }

- }

解释一下 logstash的配置文件由 input filter output 等几个基本的部分组成,顾名思义 input 就是在那收集数据,output就是输出到哪,filter代表一个过滤规则意思是什么内容 会被收集。 上面这段是让 logstash 去192.168.233.130 这个redis服务器上去收集日志 redis端口为6379,key是 logstash:redis 类型为 redis-input ,(注意:这几个值必须跟logstash agent的 output 所对应),收集完成后输出到 elasticsearch ,embedded => true 的意思是使用logstash 内嵌的 elasticsearch。如果有独立的elasticsearch服务器,需要将 这条改为 host => 'elasticsearch的ip' port => 端口 好了,这个简单的配置文件可以让logstash开始启动了

- [192.168.233.128 root@nodec:/soft]

- # java -jar /soft/logstash-1.1.0-monolithic.jar agent -f /soft/redis.conf -- web --backend elasticsearch:///?local &

- [1] 5205

- ...这里要等待约5秒钟... 为什么?去问开发者吧

- [192.168.233.128 root@nodec:/soft]

- # I, [2013-03-19T03:23:10.749000 #5205] INFO -- : Using beta plugin 'redis'. For more information about plugin statuses, see http://logstash.net/docs/1.1.0/plugin-status {"timestamp":"2013-03-19T03:23:10.732000 -0700","message":"Using beta plugin 'redis'. For more information about plugin statuses, see http://logstash.net/docs/1.1.0/plugin-status ","level":"info"}

- file:/soft/logstash-1.1.0-monolithic.jar!/gems/rack-1.3.4/lib/rack/backports/uri/common_192.rb:53 warning: already initialized constant WFKV_

- Mizuno 0.5.0 (Jetty 8.0.y.z-SNAPSHOT) listening on 0.0.0.0:9292

- 解释一下 上面的命令 agent 代理模式 -f 指定配置文件 --web 其实是个分隔符等于又启动了一个命令,后面的参数就是开启一个web页面默认端口是9292,这个命令如果拆成两个就是这个样子

- java -jar /soft/logstash-1.1.0-monolithic.jar agent -f /soft/redis.conf &

- java -jar /soft/logstash-1.1.0-monolithic.jar web --backend elasticsearch:///?local & (其实如果用kibana来做web界面的话这一步完全可以省掉了)

好了,看到9292 端口启动就代表 启动成功了,检查一下

- [192.168.233.128 root@nodec:/soft]

- # lsof -i:9292

- COMMAND PID USER FD TYPE DEVICE SIZE NODE NAME

- java 5205 root 465u IPv4 130805 TCP *:armtechdaemon (LISTEN)

- 其实logstash还启动了一个端口9200,因为启动了内嵌的 elasticsearch,这个9200是 elasticsearch在监听

- [192.168.233.128 root@nodec:/soft]

- # lsof -i:9200

- COMMAND PID USER FD TYPE DEVICE SIZE NODE NAME

- java 5205 root 160u IPv4 130682 TCP *:wap-wsp (LISTEN)

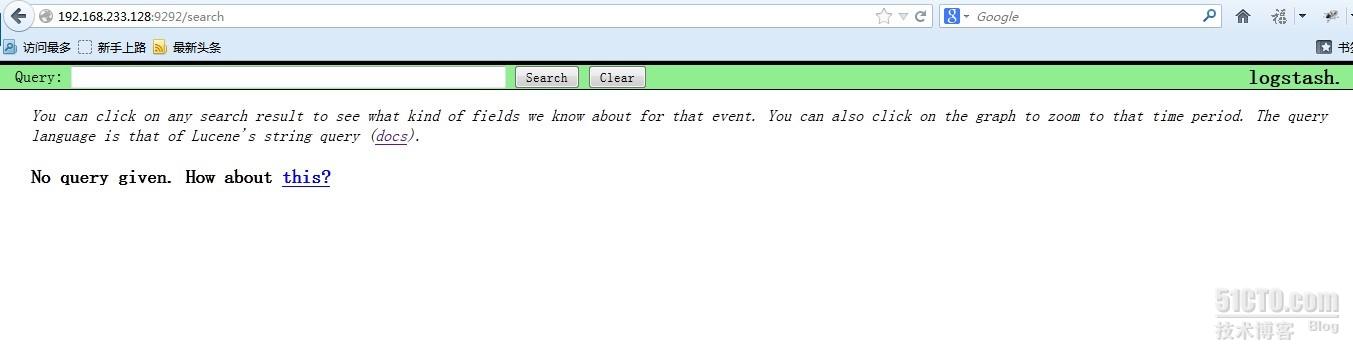

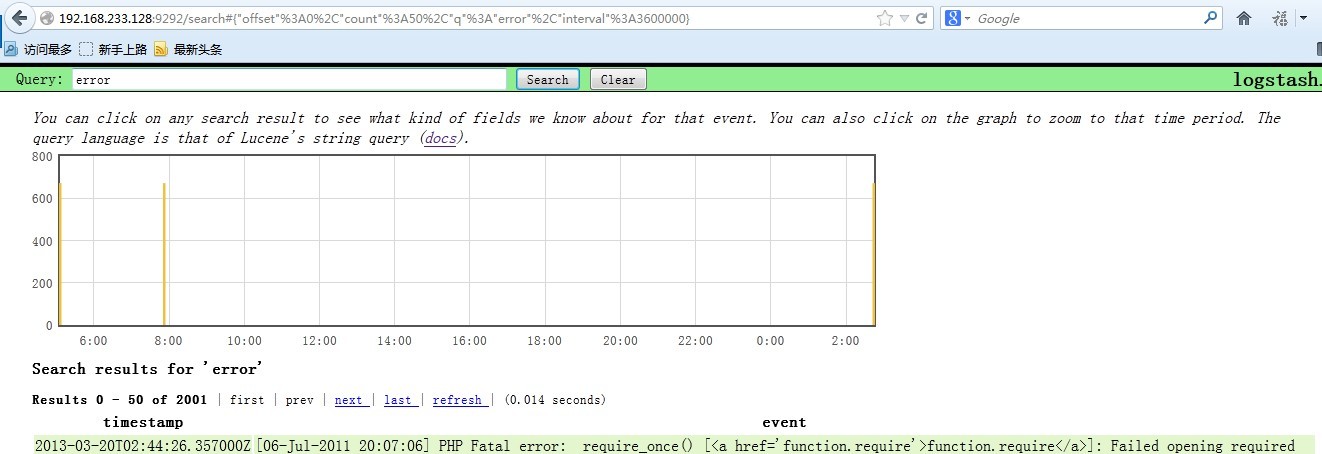

现在可以通过浏览器访问一下 http://192.168.233.128:9292 看看logstash是的页面是个什么样子

- [192.168.233.129 root@noded:~]

- # cd /soft/

- [192.168.233.129 root@noded:/soft]

- # wget http://down1.chinaunix.net/distfiles/jdk-6u13-dlj-linux-i586.bin

- [192.168.233.129 root@noded:/soft]

- # sh jdk-6u13-dlj-linux-i586.bin

- 设置 JAVA_HOME

- [192.168.233.129 root@noded:/soft]

- # vim /etc/profile

- export JAVA_HOME=/usr/java

- export PATH=$JAVA_HOME/bin:$PATH

- export CLASSPATH=.:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib/dt.jar:$CLASSPATH

- [192.168.233.129 root@noded:/soft]

- # yum install ruby

- 192.168.233.129 root@noded:/soft]

- # wget http://logstash.objects.dreamhost.com/release/logstash-1.1.0-monolithic.jar

- [192.168.233.129 root@noded:/soft]

- # vim redis.conf

- input {

- file {

- type => "producer"

- path => "/soft/apache.log"

- }

- file {

- type => "php-log"

- path => "/soft/php.log"

- }

- }

- filter {

- grep {

- match => [ "@message", "mysql|GET|error" ]

- }

- }

- output {

- redis {

- host => '192.168.233.130'

- data_type => 'list'

- key => 'logstash:redis'

- }

- }

- [192.168.233.129 root@noded:/soft]

- # java -jar /soft/logstash-1.1.0-monolithic.jar agent -f /soft/redis.conf &

- I, [2013-03-19T19:45:35.762000 #2721] INFO -- : Using beta plugin 'file'. For more information about plugin statuses, see http://logstash.net/docs/1.1.0/plugin-status {"timestamp":"2013-03-19T19:45:35.752000 -0700","message":"Using beta plugin 'file'. For more information about plugin statuses, see http://logstash.net/docs/1.1.0/plugin-status ","level":"info"}

- I, [2013-03-19T19:45:35.778000 #2721] INFO -- : Using beta plugin 'file'. For more information about plugin statuses, see http://logstash.net/docs/1.1.0/plugin-status {"timestamp":"2013-03-19T19:45:35.778000 -0700","message":"Using beta plugin 'file'. For more information about plugin statuses, see http://logstash.net/docs/1.1.0/plugin-status ","level":"info"}

- I, [2013-03-19T19:45:35.804000 #2721] INFO -- : Using beta plugin 'grep'. For more information about plugin statuses, see http://logstash.net/docs/1.1.0/plugin-status {"timestamp":"2013-03-19T19:45:35.803000 -0700","message":"Using beta plugin 'grep'. For more information about plugin statuses, see http://logstash.net/docs/1.1.0/plugin-status ","level":"info"}

- I, [2013-03-19T19:45:35.854000 #2721] INFO -- : Using beta plugin 'redis'. For more information about plugin statuses, see http://logstash.net/docs/1.1.0/plugin-status {"timestamp":"2013-03-19T19:45:35.853000 -0700","message":"Using beta plugin 'redis'. For more information about plugin statuses, see http://logstash.net/docs/1.1.0/plugin-status ","level":"info"}

- [192.168.233.130 root@nodea:/data/redis/etc]

- # lsof -i:6379

- COMMAND PID USER FD TYPE DEVICE SIZE NODE NAME

- redis-ser 2732 root 4u IPv4 7946 TCP *:6379 (LISTEN)

- redis-ser 2732 root 5u IPv4 7963 TCP localhost.localdomain:6379->localhost.localdomain:19214 (ESTABLISHED)

- java 2733 root 9u IPv4 7959 TCP localhost.localdomain:19214->localhost.localdomain:6379 (ESTABLISHED)

- 状态正常,端口处于监听状态,我用的是最简单的 配置,

- [192.168.233.130 root@nodea:/data/redis/etc]

- # vim redis.conf

- #this is the config file for redis

- pidfile /var/run/redis.pid

- port 6379

- timeout 0

- loglevel verbose

- logfile /data/redis/log/redis.log

- dbfilename dump.rdb

- dir /data/redis/db/

- vm-swap-file /tmp/redis.swap

- activerehashing yes

- 启动命令如下

- [192.168.233.130 root@nodea:/data/redis/etc]

- # redis-server /data/redis/etc/redis.conf &

- [192.168.233.130 root@nodea:/soft]

- # wget http://redis.googlecode.com/files/redis-2.4.14.tar.gz

- [192.168.233.130 root@nodea:/data/redis/etc]

- # make –j24

- [192.168.233.130 root@nodea:/data/redis/etc]

- # make install

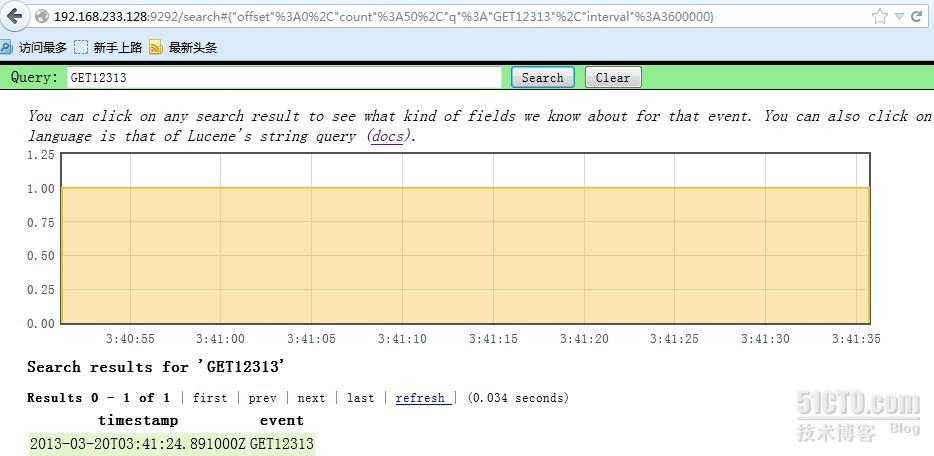

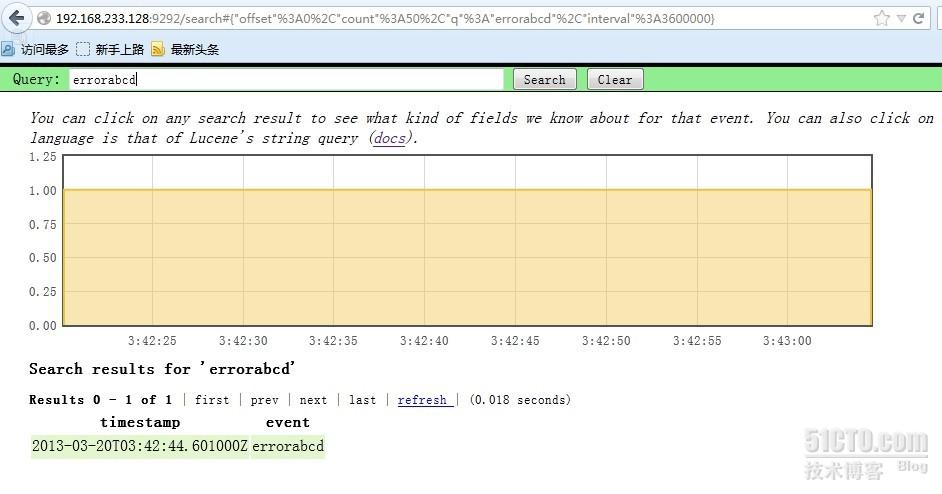

- [192.168.233.129 root@noded:/soft]

- # echo GET12313 >> apache.log

- [192.168.233.129 root@noded:/soft]

- # echo errorabcd >> apache.log

- [192.168.233.128 root@nodec:/soft]

- # tar xf Kibana-0.2.0.tar.gz

- [192.168.233.128 root@nodec:/soft]

- # cd Kibana-0.2.0

- [192.168.233.128 root@nodec:/soft/Kibana-0.2.0]

- # bundle install

- 直接安装就好了,非常简单,因为之前咱们已经安装好了 bundle

- 编辑配置文件,指定 elasticsearch 的位置

- [192.168.233.128 root@nodec:/soft/Kibana-0.2.0]

- # vim KibanaConfig.rb

- .....

- Elasticsearch = "localhost:9200"

- KibanaPort = 5601

- KibanaHost = '0.0.0.0'

- .....

- 主要是这几个参数

- 启动的话需要ruby

- [192.168.233.128 root@nodec:/soft/Kibana-0.2.0]

- # /usr/bin/ruby kibana.rb &

- [192.168.233.128 root@nodec:/soft/Kibana-0.2.0]

- # == Sinatra/1.3.5 has taken the stage on 5601 for development with backup from Thin

- >> Thin web server (v1.5.0 codename Knife)

- >> Maximum connections set to 1024

- >> Listening on 0.0.0.0:5601, CTRL+C to stop

- 如果ruby的东西都不缺的话,启动会很顺利,ok 现在看看5601端口的状态

- [192.168.233.128 root@nodec:/soft/Kibana-0.2.0]

- # lsof -i:5601

- COMMAND PID USER FD TYPE DEVICE SIZE NODE NAME

- ruby 3116 root 5u IPv4 28947 TCP *:esmagent (LISTEN)

相关推荐

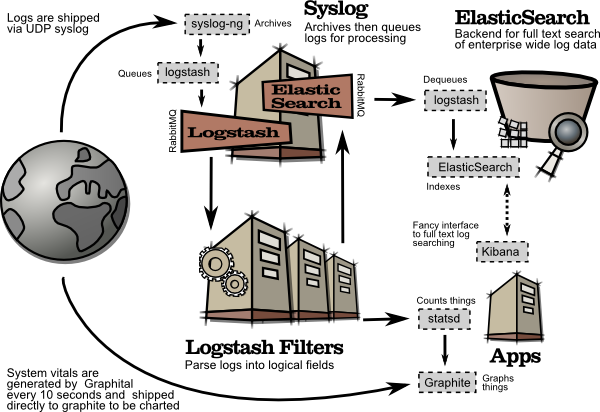

使用Kibana和Logstash搭建实时日志查询、收集与分析系统的基本步骤如下: 1. **安装与配置Logstash**:在服务器上部署Logstash,配置输入插件监听日志源,过滤插件处理日志格式,输出插件将数据发送到Elasticsearch...

在当今的IT架构中,日志管理与分析变得至关重要,由于日志数据量庞大且增长迅速,传统的日志处理手段往往难以满足实时性、高效性的需求。为了解决这一问题,ELK stack应运而生,它是由Elasticsearch、Logstash、...

ELK日志分析系统搭建与配置 ELK 日志分析系统是由 ElasticSearch、Logstash 和 Kibana 三个开源工具组成的,旨在解决日志集中化管理、信息查找、服务诊断和数据分析等问题。本文将指导用户搭建自己的 ELK 日志分析...

最后探讨了如何通过Logstash收集处理Nginx访问日志,并通过Kibana创建相关索引来查询展示数据。 适用人群:从事运维监控、日志管理的专业技术人员或是希望深入研究大数据采集分析平台搭建的技术爱好者。 使用场景及...

在搭建ELK环境时,使用虚拟化工具如Virtualbox与Vagrant可以极大地方便我们进行环境配置与管理。 **1.1 Virtualbox安装** - **安装步骤**: - 在宿主机上下载并安装Virtualbox。 - 安装完成后,打开Virtualbox...

ELK(Elasticsearch、Logstash和Kibana)组合提供了强大的日志收集、存储、搜索、分析和可视化功能。以下是关于这个主题的详细讲解。 首先,Elasticsearch是一个分布式、实时的搜索和分析引擎,它能够存储、搜索和...

ELK实时日志收集系统是目前业界常用的日志分析解决方案,由Elasticsearch、Logstash和Kibana三个主要组件构成。Elasticsearch是一个高效的分布式搜索引擎,它支持实时搜索、全文搜索及结构化搜索。Logstash是一个...

Logstash的灵活性使其成为构建日志管理和分析系统的关键组件之一。 #### Elasticsearch简介 Elasticsearch是一个基于Lucene的分布式搜索和分析引擎,它提供了一种简单高效的方式来存储、搜索和分析大规模数据集。...

4. 日志收集与分析:启动Logstash,开始收集日志。在Kibana中,可以创建视图和仪表板,以图形化方式展示日志数据。通过自定义搜索条件和过滤器,可以迅速定位问题,提升故障排查效率。 5. 扩展与优化:随着日志数据...

ELK(Elasticsearch, Logstash, Kibana)是一个流行的开源日志分析和可视化解决方案,广泛用于收集、解析、存储和展示各种日志数据。这个压缩包包含了ELK堆栈的主要组件,版本为7.6.1,适用于Linux x86_64架构。 **...

压缩包中的“项目源码”可能包含了使用ELK Stack搭建的具体应用示例或模板,这些源码可能涉及到配置文件、脚本、代码片段等,可以帮助用户更好地理解和实践ELK Stack的使用,例如日志收集的配置、Elasticsearch索引...

5. **实时监控与分析**:通过Kibana的仪表板,我们可以实时查看应用程序的运行状态,监控特定指标,如错误率、响应时间等。此外,Kibana还支持高级查询和过滤,帮助我们深入挖掘日志数据,找出潜在的问题和优化点。 ...

在7.6.2版本中,用户可以利用官方文档中的示例配置,快速搭建自己的日志处理系统。 **5. 整合Elastic生态** Logstash是Elastic Stack(又称ELK Stack,包括Elasticsearch、Logstash和Kibana)的关键组件,与...

通过 Logstash 处理日志数据,然后将其送入 Elasticsearch 存储,再利用 Kibana 进行可视化的分析和展示,可以有效地实现日志管理和监控。 在使用 "logstash-6.8.0.tar.gz" 压缩包时,首先需要解压文件,然后配置 ...

Kibana是一款强大的开源分析和可视化平台,专为与Elasticsearch协同工作而设计。它提供了丰富的数据探索、仪表板创建以及数据可视化的功能,帮助用户理解存储在Elasticsearch中的海量数据。Kibana 8.4.3是这个平台的...

ELK(Elasticsearch, Logstash, Kibana)日志收集系统是一种广泛使用的日志管理和分析解决方案。它能够高效地收集、解析、存储和展示应用程序及系统的日志数据,帮助运维人员监控系统状态,排查问题,进行数据分析。...

读者通过阅读这本书可以掌握到如何使用Logstash来收集、处理和分析系统日志、应用日志以及网络监控数据,进而更好地监控和维护系统的健康状态。书中还介绍了一些常见的排错技巧,以及如何通过Kibana控制台来可视化...