可扩展性

架构的可扩展性往往和并发是息息相关,没有并发的增长,也就没有必要做高可扩展性的架构,这里对可扩展性进行简单介绍一下,

常用的扩展手段有以下两种:

- Scale-up : 纵向扩展,通过替换为更好的机器和资源来实现伸缩,提升服务能力

- Scale-out : 横向扩展, 通过加节点(机器)来实现伸缩,提升服务能力

对于互联网的高并发应用来说,无疑Scale out才是出路,通过纵向的买更高端的机器一直是我们所避讳的问题,也不是长久之计,

在scale out的理论下,可扩展性的理想状态是什么?

可扩展性的理想状态

一个服务,当面临更高的并发的时候,能够通过简单增加机器来提升服务支撑的并发度,

且增加机器过程中对线上服务无影响(no down time),这就是可扩展性的理想状态!

架构的演变

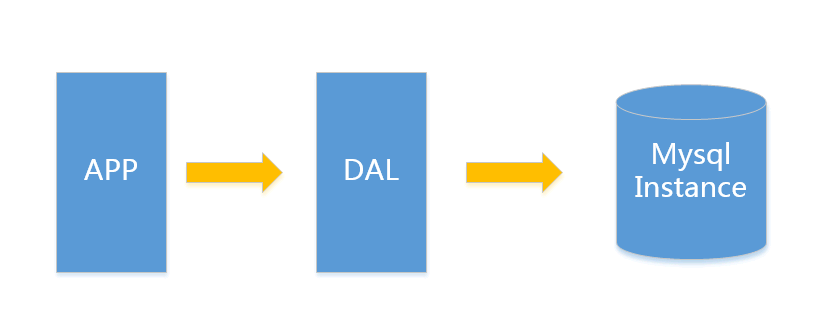

V1.0 简单网站架构

一个简单的小型网站或者应用背后的架构可以非常简单, 数据存储只需要一个mysql instance就能满足数据读取和写入需求(这里忽略掉了数据备份的实例),处于这个时间段的网站,一般会把所有的信息存到一个database instance里面。

在这样的架构下,我们来看看数据存储的瓶颈是什么?

- 数据量的总大小 一个机器放不下时

- 数据的索引(B+ Tree)一个机器的内存放不下时

- 访问量(读写混合) 一个实例不能承受时

只有当以上3件事情任何一件或多件满足时,我们才需要考虑往下一级演变。 从此我们可以看出,事实上对于很多小公司小应用,这种架构已经足够满足他们的需求了,初期数据量的准确评估是杜绝过度设计很重要的一环,毕竟没有人愿意为不可能发生的事情而浪费自己的精力。

例如:对于用户信息这类表 (3个索引),16G内存大概能放下2000W行数据的索引,简单的读和写混合访问量3000/s左右没有问题,你的应用场景是否?

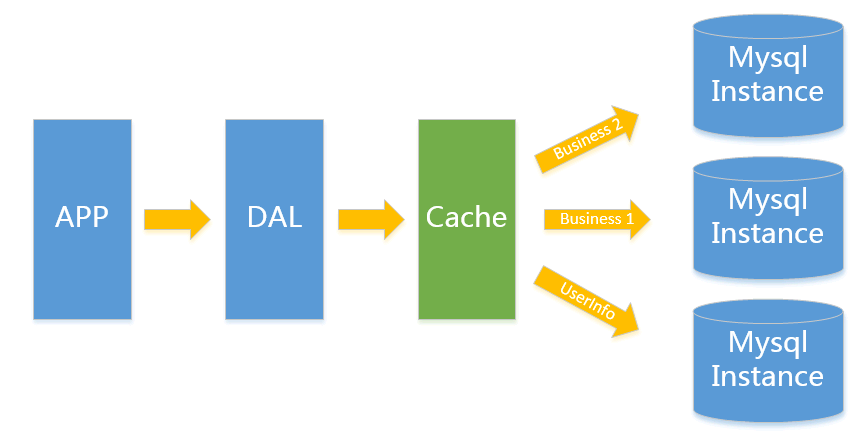

V2.0 垂直拆分

一般当V1.0 遇到瓶颈时,首先最简便的拆分方法就是垂直拆分。

何谓垂直?就是从业务角度来看,将关联性不强的数据拆分到不同的instance上,从而达到消除瓶颈的目标。

以图中的为例,将用户信息数据,和业务数据拆分到不同的三个实例上。对于重复读类型比较多的场景,我们还可以加一层cache,来减少对DB的压力。

在这样的架构下,我们来看看数据存储的瓶颈是什么?

- 单实例单业务 依然存在V1.0所述瓶颈

遇到瓶颈时可以考虑往本文更高V版本升级, 若是读请求导致达到性能瓶颈可以考虑往V3.0升级, 其他瓶颈考虑往V4.0升级

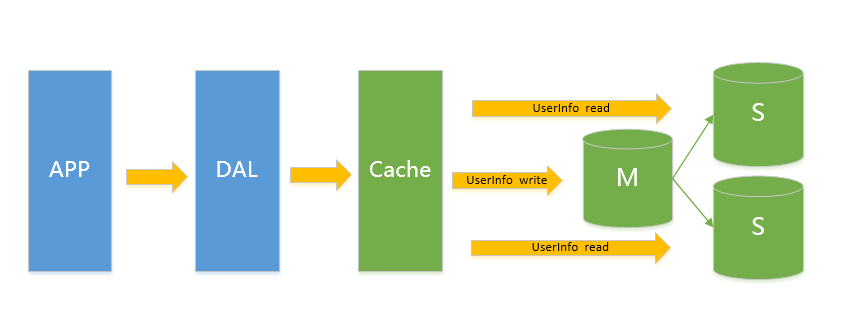

V3.0 主从架构

此类架构主要解决V2.0架构下的读问题,通过给Instance挂数据实时备份的思路来迁移读取的压力,在Mysql的场景下就是通过主从结构,主库抗写压力,通过从库来分担读压力,对于写少读多的应用,V3.0主从架构完全能够胜任

在这样的架构下,我们来看看数据存储的瓶颈是什么?

- 写入量主库不能承受

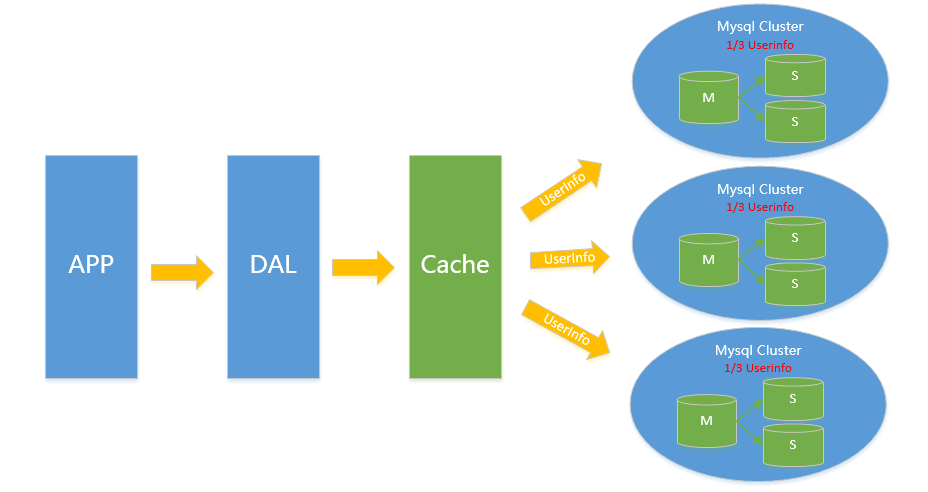

V4.0 水平拆分

对于V2.0 V3.0方案遇到瓶颈时,都可以通过水平拆分来解决,水平拆分和垂直拆分有较大区别,垂直拆分拆完的结果,在一个实例上是拥有全量数据的,而水平拆分之后,任何实例都只有全量的1/n的数据。

以下图Userinfo的拆分为例,将userinfo拆分为3个cluster,每个cluster持有总量的1/3数据,3个cluster数据的总和等于一份完整数据

(注:这里不再叫单个实例 而是叫一个cluster 代表包含主从的一个小mysql集群)

数据如何路由?

1)Range拆分

sharding key按连续区间段路由,一般用在有严格自增ID需求的场景上,

如Userid, Userid Range的小例子:以userid 3000W 为Range进行拆分 1号cluster userid 1-3000W / 2号cluster userid 3001W-6000W

2)List拆分

List拆分与Range拆分思路一样,都是通过给不同的sharding key来路由到不同的cluster,

但是具体方法有些不同,List主要用来做sharding key不是连续区间的序列落到一个cluster的情况,如以下场景:

假定有20个音像店,分布在4个有经销权的地区,如下表所示:

| 地区 | 商店ID |

| 北区 | 3, 5, 6, 9, 17 |

| 东区 | 1, 2, 10, 11, 19, 20 |

| 西区 | 4, 12, 13, 14, 18 |

| 中心区 | 7, 8, 15, 16 |

业务希望能够把一个地区的所有数据组织到一起来搜索,这种场景List拆分可以轻松搞定

3)Hash拆分

通过对sharding key 进行哈希的方式来进行拆分,常用的哈希方法有除余,字符串哈希等等。

除余如按userid%n 的值来决定数据读写哪个cluster,其他哈希类算法这里就不细展开讲了。

数据拆分后引入的问题?

数据水平拆分引入的问题主要是只能通过sharding key来读写操作,

例如以userid为sharding key的切分例子,读userid的详细信息时,一定需要先知道userid,这样才能推算出再哪个cluster进而进行查询,

假设我需要按username进行检索用户信息,需要引入额外的反向索引机制(类似HBASE二级索引),

如在redis上存储username->userid的映射,以username查询的例子变成了先通过查询username->userid,再通过userid查询相应的信息。

实际上这个做法很简单,但是我们不要忽略了一个额外的隐患,那就是数据不一致的隐患。

存储在redis里的username->userid和存储在mysql里的userid->username必须需要是一致的,这个保证起来很多时候是一件比较困难的事情,

举个例子来说,对于修改用户名这个场景,你需要同时修改redis和mysql,这两个东西是很难做到事务保证的,

如mysql操作成功 但是redis却操作失败了(分布式事务引入成本较高),

对于互联网应用来说,可用性是最重要的,一致性是其次,所以能够容忍小量的不一致出现。

毕竟从占比来说,这类的不一致的比例可以微乎其微到忽略不计(一般写更新也会采用mq来保证直到成功为止才停止重试操作)

在这样的架构下,我们来看看数据存储的瓶颈是什么?

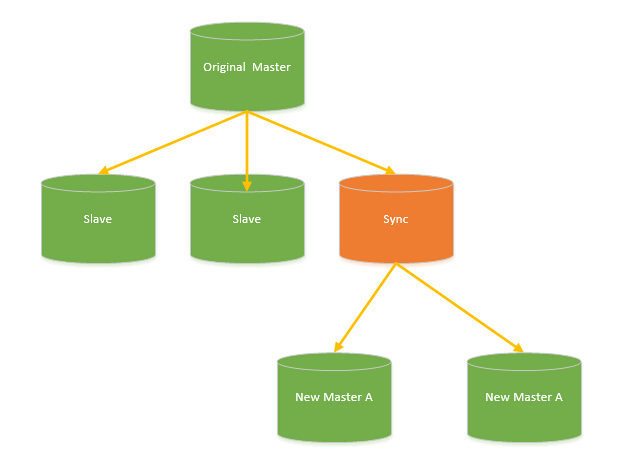

在这个拆分理念上搭建起来的架构,理论上不存在瓶颈(sharding key能确保各cluster流量相对均衡的前提下),不过确有一件恶心的事情,那就是cluster扩容的时候重做数据的成本,如我原来有3个 cluster,但是现在我的数据增长比较快,我需要6个cluster,那么我们需要将每个cluster 一拆为二,一般的做法是

- 摘下一个slave,停同步,

- 对写记录增量log(实现上可以业务方对写操作 多一次写持久化mq 或者mysql主创建trigger记录写 等等方式)

- 开始对静态slave做数据, 一拆为二

- 回放增量写入,直到追上的所有增量,与原cluster基本保持同步

- 写入切换,由原3 cluster 切换为6cluster

有没有类似飞机空中加油的感觉,这是一个脏活,累活,容易出问题的活,

为了避免这个,我们一般在最开始的时候,设计足够多的sharding cluster来防止可能的cluster扩容这件事情

V5.0 云计算(云数据库)

云计算现在是各大IT公司内部作为节约成本的一个突破口,

对于数据存储的mysql来说,如何让其成为一个saas(Software as a Service)是关键点。

在MS的官方文档中,把构建一个足够成熟的SaaS(MS简单列出了SaaS应用的4级成熟度)所面临的3个主要挑战:可配置性,可扩展性,多用户存储结构设计称为“three headed monster”。

可配置性和多用户存储结构设计在Mysql SaaS这个问题中并不是特别难办的一件事情,所以这里重点说一下可扩展性。

Mysql作为一个SaaS服务,在架构演变为V4.0之后,依赖良好的sharding key设计, 已经不再存在扩展性问题,只是他在面对扩容缩容时,有一些脏活需要干,而作为SaaS,并不能避免扩容缩容这个问题!

所以只要能把V4.0的脏活变成:

- 扩容缩容对前端APP透明(业务代码不需要任何改动)

- 扩容缩容全自动化且对在线服务无影响

那么他就拿到了作为Saas的门票

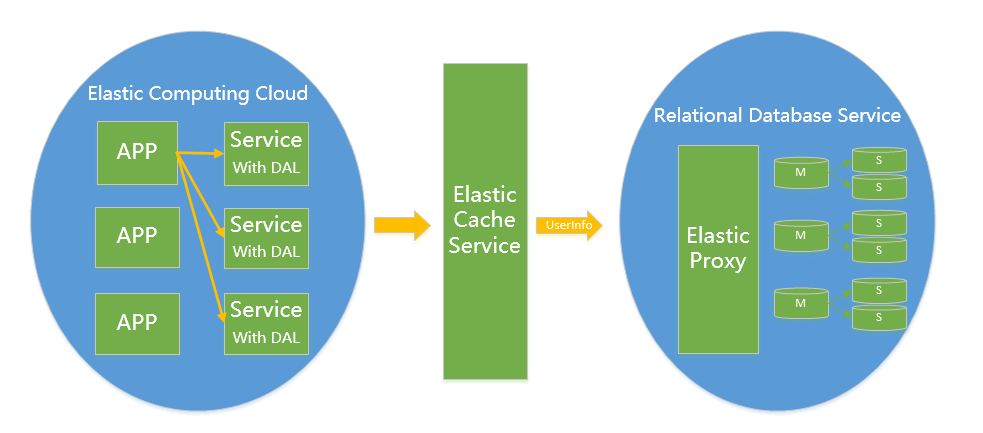

对于架构实现的关键点,需要满足对业务透明,扩容缩容对业务不需要任何改动,那么就必须 “eat our own dog food”,

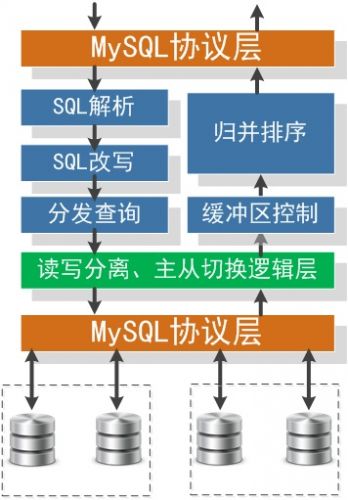

在你MySQL SaaS内部解决这个问题,一般的做法是我们需要引入一个Proxy,Proxy来解析sql协议,

按sharding key 来寻找cluster, 判断是读操作还是写操作来请求主 或者 从,这一切内部的细节都由proxy来屏蔽。

这里借淘宝的图来列举一下proxy需要干哪些事情

相关推荐

MySQL在大型网站的应用架构随着网站规模的扩大,其复杂性和挑战也随之增加,主要关注的是系统的可扩展性。可扩展性是指系统在面对高并发访问时,通过增加硬件资源或优化架构来提升服务能力的能力。通常有两种扩展...

【大型网站架构演变和知识体系】的探讨是一个深入的话题,涉及到互联网行业中网站设计与优化的关键环节。随着网站规模的增长,架构也需要不断演进以应对日益增大的访问压力和复杂的功能需求。以下是对这一主题的详细...

### 2018大型互联网架构演变历程:以淘宝为例 #### 一、背景与重要性 随着互联网行业的快速发展,大型互联网企业的系统架构也在不断进化和完善。这些变化不仅仅是技术层面的进步,更是对整个互联网产业发展方向的...

本文主要描述在网站的不同的并发访问量级下,Mysql架构的演变架构的可扩展性往往和并发是息息相关,没有并发的增长,也就没有必要做高可扩展性的架构,这里对可扩展性进行简单介绍一下,常用的扩展手段有以下两种...

《大型网站架构演变和知识体系》是一本深入探讨构建与优化大规模互联网应用的权威文档。在互联网行业快速发展的今天,大型网站的架构设计已经成为技术团队面临的重大挑战之一。本书全面覆盖了从初期的小型网站到应对...

### 从运维角度看中大型网站架构演变之路 随着互联网的发展,中大型网站面临的挑战日益增多,这不仅体现在用户数量的增长上,还体现在对系统稳定性和性能的要求上。本文旨在通过一个具体的案例,来探讨中大型网站...

本文将从初期、中期到现在的架构演变,详细介绍中大型网站架构的演变之路。 初期阶段: 1. 单台服务器部署:在最初阶段,网站通常部署在单台服务器上,运行所有服务,包括WEB服务器和数据库服务器。这种方式成本...

在网站初期,通常采用单体架构,所有功能模块都集成在一个应用中。这种架构简单易懂,但随着用户量的增长,维护和扩展变得困难,这就催生了分布式架构的出现。 分布式架构是大型网站演进的关键一步。它将单一应用...

大型网站后台架构的演变是一个复杂且持续的过程,随着网站用户量的增长和技术的发展,架构需要不断地进行优化和调整以满足更高的性能、稳定性和可扩展性需求。本文将探讨从小型网站到大型网站后台架构的演进过程,...

### 中大型网站架构演变之路 #### 一、初期架构阶段 在中大型网站的初始发展阶段,网站架构的设计主要关注于简单高效地满足基本需求。这一阶段主要包括以下几个方面: 1. **单台服务器部署**:在项目的初期阶段,...

5. **李智慧**:作为作者,李智慧在IT领域有着丰富的经验和深厚的理论功底,他的见解和实践经验对于理解和应用大型网站技术架构有很高的指导价值。他的著作往往结合实际问题,提供解决方案,帮助读者从理论到实践...

这些步骤反映了网站架构演变过程中的一些关键技术点和发展趋势。从最初的简单分离到后来的缓存优化,每一次进步都旨在提高网站的整体性能和用户体验。 #### 四、架构设计理论与原则 在构建大型网站架构时,还需要...

在架构演变的第二步,采取缓存处理是减少对网站访问、Web应用服务器请求、数据库查询和文件系统I/O操作的有效方法。缓存技术包括客户端(浏览器)缓存、前端页面缓存、页面片段缓存和本地数据缓存/数据库缓存等。...

在这个阶段,网站架构非常简单,所有的组件,包括应用服务器(如Tomcat、Jetty或Jboss)和数据库管理系统(如MySQL、SQL Server、Oracle),都部署在同一台服务器上。开发通常采用Java Web技术,如JSP/Servlet,或者...