转帖:http://mntms.iteye.com/blog/2063904

一致性哈希算法是分布式系统中常用的算法。比如,一个分布式的存储系统,要将数据存储到具体的节点上,如果采用普通的hash方法,将数据映射到具体的节点上,如key%N,key是数据的key,N是机器节点数,如果有一个机器加入或退出这个集群,则所有的数据映射都无效了,如果是持久化存储则要做数据迁移,如果是分布式缓存,则其他缓存就失效了。

因此,引入了一致性哈希算法:

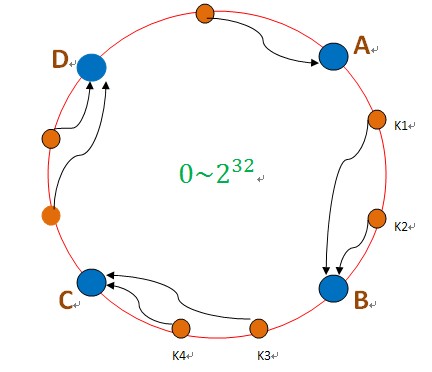

把数据用hash函数(如MD5),映射到一个很大的空间里,如图所示。数据的存储时,先得到一个hash值,对应到这个环中的每个位置,如k1对应到了图中所示的位置,然后沿顺时针找到一个机器节点B,将k1存储到B这个节点中。

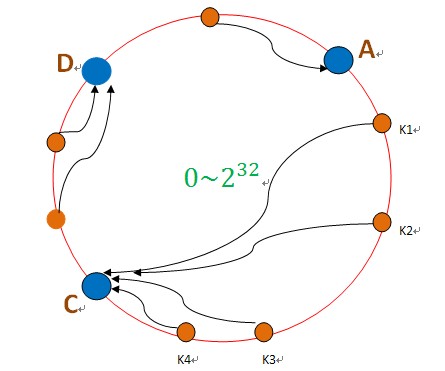

如果B节点宕机了,则B上的数据就会落到C节点上,如下图所示:

这样,只会影响C节点,对其他的节点A,D的数据不会造成影响。然而,这又会造成一个“雪崩”的情况,即C节点由于承担了B节点的数据,所以C节点的负载会变高,C节点很容易也宕机,这样依次下去,这样造成整个集群都挂了。

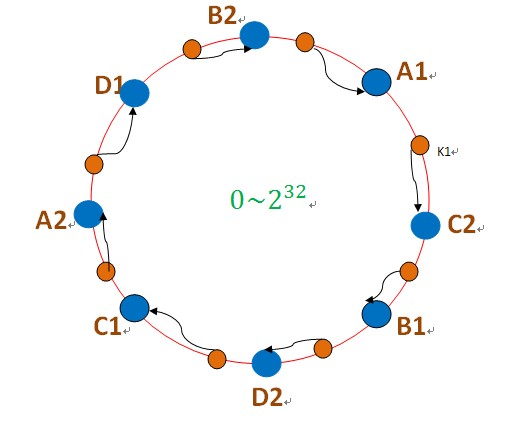

为此,引入了“虚拟节点”的概念:即把想象在这个环上有很多“虚拟节点”,数据的存储是沿着环的顺时针方向找一个虚拟节点,每个虚拟节点都会关联到一个真实节点,如下图所使用:

图中的A1、A2、B1、B2、C1、C2、D1、D2都是虚拟节点,机器A负载存储A1、A2的数据,机器B负载存储B1、B2的数据,机器C负载存储C1、C2的数据。由于这些虚拟节点数量很多,均匀分布,因此不会造成“雪崩”现象。

- public class Shard<S> { // S类封装了机器节点的信息 ,如name、password、ip、port等

- private TreeMap<Long, S> nodes; // 虚拟节点

- private List<S> shards; // 真实机器节点

- private final int NODE_NUM = 100; // 每个机器节点关联的虚拟节点个数

- public Shard(List<S> shards) {

- super();

- this.shards = shards;

- init();

- }

- private void init() { // 初始化一致性hash环

- nodes = new TreeMap<Long, S>();

- for (int i = 0; i != shards.size(); ++i) { // 每个真实机器节点都需要关联虚拟节点

- final S shardInfo = shards.get(i);

- for (int n = 0; n < NODE_NUM; n++)

- // 一个真实机器节点关联NODE_NUM个虚拟节点

- nodes.put(hash("SHARD-" + i + "-NODE-" + n), shardInfo);

- }

- }

- public S getShardInfo(String key) {

- SortedMap<Long, S> tail = nodes.tailMap(hash(key)); // 沿环的顺时针找到一个虚拟节点

- if (tail.size() == 0) {

- return nodes.get(nodes.firstKey());

- }

- return tail.get(tail.firstKey()); // 返回该虚拟节点对应的真实机器节点的信息

- }

- /**

- * MurMurHash算法,是非加密HASH算法,性能很高,

- * 比传统的CRC32,MD5,SHA-1(这两个算法都是加密HASH算法,复杂度本身就很高,带来的性能上的损害也不可避免)

- * 等HASH算法要快很多,而且据说这个算法的碰撞率很低.

- * http://murmurhash.googlepages.com/

- */

- private Long hash(String key) {

- ByteBuffer buf = ByteBuffer.wrap(key.getBytes());

- int seed = 0x1234ABCD;

- ByteOrder byteOrder = buf.order();

- buf.order(ByteOrder.LITTLE_ENDIAN);

- long m = 0xc6a4a7935bd1e995L;

- int r = 47;

- long h = seed ^ (buf.remaining() * m);

- long k;

- while (buf.remaining() >= 8) {

- k = buf.getLong();

- k *= m;

- k ^= k >>> r;

- k *= m;

- h ^= k;

- h *= m;

- }

- if (buf.remaining() > 0) {

- ByteBuffer finish = ByteBuffer.allocate(8).order(

- ByteOrder.LITTLE_ENDIAN);

- // for big-endian version, do this first:

- // finish.position(8-buf.remaining());

- finish.put(buf).rewind();

- h ^= finish.getLong();

- h *= m;

- }

- h ^= h >>> r;

- h *= m;

- h ^= h >>> r;

- buf.order(byteOrder);

- return h;

- }

- }

相关推荐

一致性哈希算法最初由麻省理工学院的K等人提出,并被广泛应用于分布式系统中,以解决节点动态变化时数据一致性问题。其核心思想是通过引入哈希环,将数据对象均匀分布在哈希环上的不同节点中,以此降低节点变更对...

一致性哈希算法是一种分布式哈希(Distributed Hash Table, DHT)技术,它解决了在分布式环境中数据分片和负载均衡的问题。在传统的哈希算法中,如果增加或减少服务器节点,会导致大量数据重新分配,而一致性哈希...

一致性哈希算法是一种在分布式系统中解决数据分片和负载均衡问题的算法,它主要解决了在动态添加或移除节点时,尽可能少地改变已经存在的数据分布。在云计算和大数据处理领域,一致性哈希被广泛应用,例如在分布式...

一致性哈希算法通过将哈希值空间组织成一个虚拟的环状结构,使得每个存储节点仅负责环上的一段区域,从而有效减少了节点变化时的数据迁移量。然而,一致性哈希算法也存在一些问题,比如在节点数量较少时,节点间的...

一致性哈希算法是一种分布式哈希(Distributed Hash Table, DHT)技术,旨在解决在分布式环境中数据分布不均匀的问题。Ketama算法是基于一致性哈希的一种优化实现,由Last.fm公司的Simon Willison提出,其目标是在...

一致性哈希算法是一种分布式哈希表(DHT)中用于解决数据分片和负载均衡问题的算法。在大型分布式系统中,例如缓存系统、分布式数据库等,一致性哈希能够确保当节点加入或离开时,尽可能少的数据需要迁移,从而保持...

本文针对这一问题,深入研究了一致性哈希算法在分布式数据库扩展中的应用,并提出了一种创新的扩展方法,旨在提高扩展效率,降低扩展成本,为大数据环境下的数据库管理带来新的优化方案。 一致性哈希算法最初由...

一致性哈希算法是一种在分布式系统中用于解决数据分发和负载均衡问题的算法。随着互联网技术的快速发展,分布式系统已经成为支撑大规模服务的关键技术之一。在分布式系统中,多个节点通过网络协同工作,提供高可用性...

### 一致性哈希算法及其在分布式系统中的应用 #### 摘要 一致性哈希算法是一种用于解决分布式系统中节点动态变化导致的数据重新分布问题的关键技术。它通过将哈希空间映射到一个循环的空间中,实现了数据节点的高效...

一致性哈希算法应用及优化是IT领域中分布式系统设计的核心技术之一,特别是在处理大规模数据分布与缓存系统中,其重要性不言而喻。本文将深入探讨一致性哈希算法的基本概念、工作原理以及在实际场景中的应用和优化...

一致性哈希算法作为解决这一问题的重要手段之一,近些年来得到了广泛关注和应用。 一致性哈希算法由David Karger等人在1997年提出,它是一种特殊的哈希算法,主要用于分布式系统中实现负载均衡。与传统的哈希算法...

一致性哈希算法

白话解析:一致性哈希算法1 一致性哈希算法是解决分布式缓存问题的解决方案。缓存服务器数量的变化会引起缓存的雪崩,导致整体系统压力过大而崩溃。为了解决这个问题,一致性哈希算法诞生了。 在了解一致性哈希...

一致性哈希算法(Consistent Hashing)是一种在分布式系统中实现负载均衡的算法,尤其在分布式缓存如Memcached和Redis等场景下广泛使用。它解决了传统哈希算法在节点增减时导致的大量数据迁移问题,提高了系统的可用...

#资源达人分享计划#

Mycat在处理大规模数据时,通过一致性哈希算法将数据均匀地分布到各个节点上,确保每个节点负责一部分数据,形成数据分片。当增加或减少节点时,一致性哈希可以保持数据分布的稳定性,降低对系统的影响。 三、Mycat...

一致性哈希算法的php版,希望能帮到phper了解一致性哈希

一致性哈希算法是一种在分布式系统中解决数据分发和负载均衡问题的算法,特别是在缓存系统如Memcached或Redis中广泛应用。它最早在1997年的论文《Consistent Hashing and Random Trees》中被提出,旨在克服传统哈希...