安装配置ant:下载

解压后配置环境变量ANT_HOME 同时将ANT_HOME/bin添加到PATH

安装配置mysql\

yum install mysql-server,安装完成后执行mysqladmin -u root password 'root';

grant all privileges on *.* to peter@'localhost' identified by 'peter' with grant option;

create database xdata;

use xdata;

create table test_datax(user_id int,user_name varchar(30));

insert into test_datax values(111, 'peterlee');

insert into test_datax values(111, 'peterlee');

insert

into test_datax values(111, 'peterlee');

安装配置hadoop

下载

配置core-site.xml hdfs-site.xml mapred-site.xml(最基本配置,网上一search一大把)

安装编译datax

从淘宝的开源svn上checkout一份代码

svn co http://code.taobao.org/svn/datax/trunkdatax

用当前系统hadoop中的hadoop-core-xxxx.jar 替换下面的jar包

在datax/rpm下面有spec文件,rpm打包的配置文件

rpmbuild --ba XXXXX.spec (例如,t_dp_datax_engine.spec)

按照datax官方编译文档安装

安装完成后

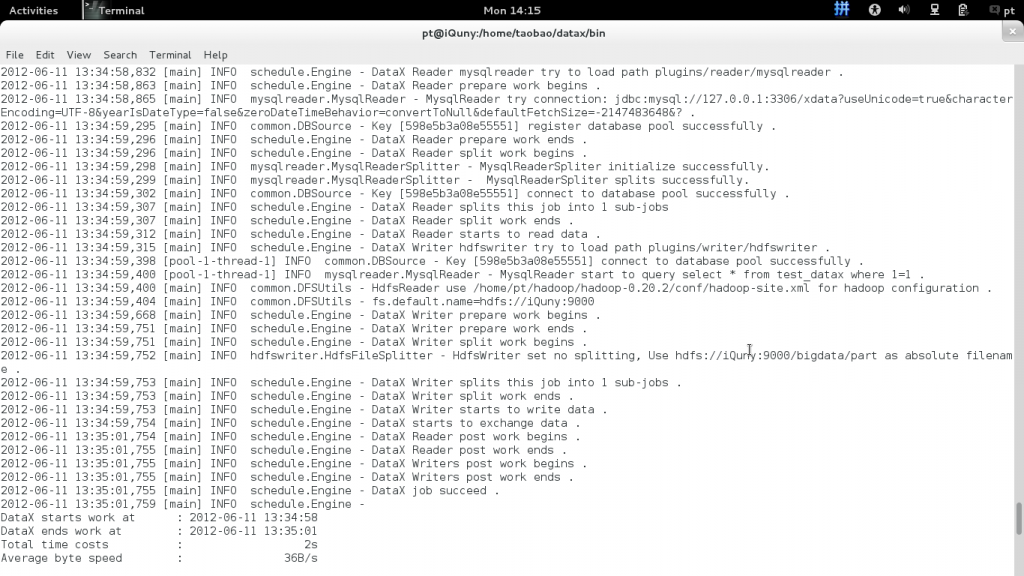

在datax/bin目录下执行 python datax.py -e true 生成一个job配置文件 XXXXXXXXXXXXXX.xml

ptyhon datax.py /home/peter/datax/jobs/XXXXXXXXXXX.xml

分享到:

相关推荐

标题中的“基于 DataX 开发的快速同步 MySQL 数据至 HDFS 上的工具”指的是一个利用 DataX 框架开发的实用程序,该程序能够高效地将存储在 MySQL 数据库中的数据迁移或实时同步到 Hadoop 分布式文件系统(HDFS)上。...

1.将Mysql中的数据迁移到Hdfs文件系统中,然后通过Hive加载HDFS文件系统中的数据值 2.将Hive中的数据迁移到指定Mysql数据库中 注意点: 1.数据迁移的过程中,由于hive的Null值存储为"\N",Mysql存储为NULL值,二者...

《DataX实现MySQL与HDFS之间的数据同步》 在大数据处理和分析的场景中,数据的迁移和同步是一项基础且重要的任务。DataX是阿里巴巴开源的一款高效、稳定、强大的数据同步工具,支持多种数据源之间的数据迁移。本文...

### DataX 数据从 Hive 导入 MySQL 数据缺失解决 #### 背景介绍 在大数据处理领域,Hive 和 MySQL 分别作为数据仓库与关系型数据库的重要组成部分,在数据流转过程中承担着关键角色。Hive 通常用于存储海量数据并...

mysql的null值通过datax抽取到hdfs,会变成引号,这不是我们所需要的,所以需要修改一下datax的源码

它旨在高效地同步多种异构数据源,如MySQL、Oracle、HDFS等,通过其强大的Reader和Writer插件体系,能够支持任意数据源类型的数据同步。DataX3.0的核心设计理念是将数据源的读取(Reader)和写入(Writer)抽象为...

在实训内容上,我们将利用DataX的两个插件:mysqlreader(MySQL读取器)和hdfswriter(HDFS写入器),来完成从MySQL到HDFS的数据迁移。具体操作分为以下几步: 1. **全量同步**:首先要确定源表,即需要同步的MySQL...

{ job: { setting: { speed: { channel: 1 }, errorLimit: { record: 0, percentage: 0.02 } }, content: [ { reader: {

《MySQL到HDFS增量同步实验手册》是针对大数据采集技术与应用的一份实践教程,主要讲解如何使用DataX工具将MySQL数据库中的数据增量同步至HDFS(Hadoop Distributed File System)。这一过程对于实时数据处理、大...

标题 "Datax实现增量同步数据到Postgres" 涉及到的是使用开源数据同步工具 Datax 进行数据迁移的场景,特别是针对从某个源数据库到PostgreSQL数据库的增量同步。Datax 是阿里巴巴开发的一款高效、稳定且强大的数据...

- **DataX**:作为数据同步工具,DataX在此实验中用于实现HDFS到MySQL的转换。 - **MySQL**:作为目标数据库,接收从HDFS同步过来的数据。 4. **实训内容**: 主要任务是配置和运行DataX的JSON配置文件,完成...

DataX支持多种数据源的读写操作,包括但不限于MySQL、Oracle、HDFS等。开发者可以根据实际需求编写配置文件,实现数据的高效传输。 ##### 3.1 MySQL到HDFS的数据同步 假设我们需要将MySQL数据库中的数据同步到HDFS...

阿里DataX 3.0 配置文件 DataX 是阿里巴巴集团内被广泛使用的离线数据同步工具/平台,实现包括 MySQL、Oracle、HDFS、Hive、OceanBase、HBase、OTS、ODPS 等各种异构数据源之间高效的数据同步功能。

DataX作为一个数据同步框架,其核心功能是实现各种数据源之间的数据导入导出,包括但不限于MySQL、Oracle、HDFS、HBase、TableStore(OTS)、MaxCompute(ODPS)、RDS等。它提供了丰富的插件支持,使得开发者可以...

该工具支持的数据源包括但不限于MySQL、Oracle、SqlServer、PostgreSQL、HDFS、Hive、Amazon DynamoDB (ADS)、HBase、Table Store (OTS)、MaxCompute (ODPS) 和 DRDS。 #### 特点与优势 DataX的特点主要体现在其...

本实验的主要目的是让学习者掌握使用DataX工具进行HDFS到MySQL的增量同步操作。DataX是阿里巴巴开源的数据同步框架,支持多种数据源之间的数据迁移,包括批量迁移和增量迁移。 **实训环境:** 实验环境基于Linux...

3. **读写插件**:DataX支持多种数据源的读取和写入,例如`mysqlreader`和`hdfswriter`分别代表从MySQL读取数据和将数据写入HDFS。插件配置包括表名、字段列表、分区策略等。 4. **任务详情**:JSON会定义需要同步...

DataX支持包括MySQL、Oracle、HDFS、HBase、TableStore(OTS)、MaxCompute(ODPS)、ADS等在内的多种数据源,具备高吞吐量、低延迟的特性,确保数据在不同系统间快速、准确地流动。 二、Azkaban概述 Azkaban是一个...

DataX是阿里巴巴开源的一款强大的异构数据源离线同步工具,它的主要目标是实现各种不同类型的数据源之间的稳定高效数据同步,包括关系型数据库(如MySQL、Oracle)、HDFS、Hive、ODPS、HBase、FTP等。DataX的设计...

例如,如果你正在从MySQL同步数据到HDFS,你需要分别配置MySQL和HDFS的数据源。这包括数据库的URL、用户名、密码、表名等信息。 3. **读取器(Reader)配置**:读取器是负责从数据源读取数据的组件。对于MySQL,...