وڈ’ن»¶

è¯è¯´Hadoop 1.0.2/src/contrib/eclipse-pluginهڈھوœ‰وڈ’ن»¶çڑ„و؛گن»£ç پ,è؟™é‡Œç»™ه‡؛ن¸€ن¸ھوˆ‘و‰“هŒ…ه¥½çڑ„ه¯¹ه؛”çڑ„Eclipseوڈ’ن»¶ï¼ڑ

ن¸‹è½½هœ°ه€

ن¸‹è½½هگژو‰”هˆ°eclipse/dropinsç›®ه½•ن¸‹هچ³هڈ¯ï¼Œه½“然eclipse/pluginsن¹ںوک¯هڈ¯ن»¥çڑ„,ه‰چ者و›´ن¸؛è½»ن¾؟,وژ¨èچگï¼›é‡چهگ¯Eclipse,هچ³هڈ¯هœ¨é€ڈ视ه›¾(Perspective)ن¸çœ‹هˆ°Map/Reduceم€‚

é…چç½®

点ه‡»è“色çڑ„ه°ڈè±،ه›¾و ‡ï¼Œو–°ه»؛ن¸€ن¸ھHadoopè؟وژ¥ï¼ڑ

و³¨و„ڈ,ن¸€ه®ڑè¦په،«ه†™و£ç،®ï¼Œن؟®و”¹ن؛†وںگن؛›ç«¯هڈ£ï¼Œن»¥هڈٹé»ک认è؟گè،Œçڑ„用وˆ·هگچç‰

ه…·ن½“çڑ„设置,هڈ¯è§پ

و£ه¸¸وƒ…ه†µن¸‹ï¼Œهڈ¯ن»¥هœ¨é،¹ç›®هŒ؛هںںهڈ¯ن»¥çœ‹هˆ°

è؟™و ·هڈ¯ن»¥و£ه¸¸çڑ„è؟›è،ŒHDFSهˆ†ه¸ƒه¼ڈو–‡ن»¶ç³»ç»ںçڑ„ç®،çگ†ï¼ڑن¸ٹن¼ ,هˆ 除ç‰و“چن½œم€‚

ن¸؛ن¸‹é¢وµ‹è¯•هپڑه‡†ه¤‡ï¼Œéœ€è¦په…ˆه»؛ن؛†ن¸€ن¸ھç›®ه½• user/root/input2,然هگژن¸ٹن¼ ن¸¤ن¸ھtxtو–‡ن»¶هˆ°و¤ç›®ه½•ï¼ڑ

intput1.txt ه¯¹ه؛”ه†…ه®¹ï¼ڑHello Hadoop Goodbye Hadoop

intput2.txt ه¯¹ه؛”ه†…ه®¹ï¼ڑHello World Bye World

HDFSçڑ„ه‡†ه¤‡ه·¥ن½œه¥½ن؛†ï¼Œن¸‹é¢هڈ¯ن»¥ه¼€ه§‹وµ‹è¯•ن؛†م€‚

Hadoopه·¥ç¨‹

و–°ه»؛ن¸€ن¸ھMap/Reduce Projectه·¥ç¨‹ï¼Œè®¾ه®ڑه¥½وœ¬هœ°çڑ„hadoopç›®ه½•

و–°ه»؛ن¸€ن¸ھوµ‹è¯•ç±»WordCountTestï¼ڑ

<script src="https://gist.github.com/2477347.js?file=WordCountTest.java"></script>

package com.hadoop.learn.test;

import java.io.IOException;

import java.util.StringTokenizer;

import org.apache.hadoop.conf.Configuration;

import org.apache.hadoop.fs.Path;

import org.apache.hadoop.io.IntWritable;

import org.apache.hadoop.io.Text;

import org.apache.hadoop.mapreduce.Job;

import org.apache.hadoop.mapreduce.Mapper;

import org.apache.hadoop.mapreduce.Reducer;

import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;

import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;

import org.apache.hadoop.util.GenericOptionsParser;

import org.apache.log4j.Logger;

/**

* è؟گè،Œوµ‹è¯•ç¨‹ه؛ڈ

*

* @author yongboy

* @date 2012-04-16

*/

public class WordCountTest {

private static final Logger log = Logger.getLogger(WordCountTest.class);

public static class TokenizerMapper extends

Mapper<Object, Text, Text, IntWritable> {

private final static IntWritable one = new IntWritable(1);

private Text word = new Text();

public void map(Object key, Text value, Context context)

throws IOException, InterruptedException {

log.info("Map key : " + key);

log.info("Map value : " + value);

StringTokenizer itr = new StringTokenizer(value.toString());

while (itr.hasMoreTokens()) {

String wordStr = itr.nextToken();

word.set(wordStr);

log.info("Map word : " + wordStr);

context.write(word, one);

}

}

}

public static class IntSumReducer extends

Reducer<Text, IntWritable, Text, IntWritable> {

private IntWritable result = new IntWritable();

public void reduce(Text key, Iterable<IntWritable> values,

Context context) throws IOException, InterruptedException {

log.info("Reduce key : " + key);

log.info("Reduce value : " + values);

int sum = 0;

for (IntWritable val : values) {

sum += val.get();

}

result.set(sum);

log.info("Reduce sum : " + sum);

context.write(key, result);

}

}

public static void main(String[] args) throws Exception {

Configuration conf = new Configuration();

String[] otherArgs = new GenericOptionsParser(conf, args)

.getRemainingArgs();

if (otherArgs.length != 2) {

System.err.println("Usage: WordCountTest <in> <out>");

System.exit(2);

}

Job job = new Job(conf, "word count");

job.setJarByClass(WordCountTest.class);

job.setMapperClass(TokenizerMapper.class);

job.setCombinerClass(IntSumReducer.class);

job.setReducerClass(IntSumReducer.class);

job.setOutputKeyClass(Text.class);

job.setOutputValueClass(IntWritable.class);

FileInputFormat.addInputPath(job, new Path(otherArgs[0]));

FileOutputFormat.setOutputPath(job, new Path(otherArgs[1]));

System.exit(job.waitForCompletion(true) ? 0 : 1);

}

}

هڈ³é”®ï¼Œé€‰و‹©â€œRun Configurationsâ€,ه¼¹ه‡؛çھ—هڈ£ï¼Œç‚¹ه‡»â€œArgumentsâ€é€‰é،¹هچ،,هœ¨â€œProgram argumetnsâ€ه¤„预ه…ˆè¾“ه…¥هڈ‚و•°:

hdfs://master:9000/user/root/input2 dfs://master:9000/user/root/output2

ه¤‡و³¨ï¼ڑهڈ‚و•°ن¸؛ن؛†هœ¨وœ¬هœ°è°ƒè¯•ن½؟用,而éçœںه®çژ¯ه¢ƒم€‚

然هگژ,点ه‡»â€œApplyâ€ï¼Œç„¶هگژ“Closeâ€م€‚çژ°هœ¨هڈ¯ن»¥هڈ³é”®ï¼Œé€‰و‹©â€œRun on Hadoopâ€ï¼Œè؟گè،Œم€‚

ن½†و¤و—¶ن¼ڑه‡؛çژ°ç±»ن¼¼ه¼‚ه¸¸ن؟،وپ¯ï¼ڑ

12/04/24 15:32:44 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

12/04/24 15:32:44 ERROR security.UserGroupInformation: PriviledgedActionException as:Administrator cause:java.io.IOException: Failed to set permissions of path: \tmp\hadoop-Administrator\mapred\staging\Administrator-519341271\.staging to 0700

Exception in thread "main" java.io.IOException: Failed to set permissions of path: \tmp\hadoop-Administrator\mapred\staging\Administrator-519341271\.staging to 0700

آ آ آ at org.apache.hadoop.fs.FileUtil.checkReturnValue(FileUtil.java:682)

آ آ آ at org.apache.hadoop.fs.FileUtil.setPermission(FileUtil.java:655)

آ آ آ at org.apache.hadoop.fs.RawLocalFileSystem.setPermission(RawLocalFileSystem.java:509)

آ آ آ at org.apache.hadoop.fs.RawLocalFileSystem.mkdirs(RawLocalFileSystem.java:344)

آ آ آ at org.apache.hadoop.fs.FilterFileSystem.mkdirs(FilterFileSystem.java:189)

آ آ آ at org.apache.hadoop.mapreduce.JobSubmissionFiles.getStagingDir(JobSubmissionFiles.java:116)

آ آ آ at org.apache.hadoop.mapred.JobClient$2.run(JobClient.java:856)

آ آ آ at org.apache.hadoop.mapred.JobClient$2.run(JobClient.java:850)

آ آ آ at java.security.AccessController.doPrivileged(Native Method)

آ آ آ at javax.security.auth.Subject.doAs(Subject.java:396)

آ آ آ at org.apache.hadoop.security.UserGroupInformation.doAs(UserGroupInformation.java:1093)

آ آ آ at org.apache.hadoop.mapred.JobClient.submitJobInternal(JobClient.java:850)

آ آ آ at org.apache.hadoop.mapreduce.Job.submit(Job.java:500)

آ آ آ at org.apache.hadoop.mapreduce.Job.waitForCompletion(Job.java:530)

آ آ آ at com.hadoop.learn.test.WordCountTest.main(WordCountTest.java:85)

è؟™ن¸ھوک¯Windowsن¸‹و–‡ن»¶وƒé™گé—®é¢ک,هœ¨Linuxن¸‹هڈ¯ن»¥و£ه¸¸è؟گè،Œï¼Œن¸چهکهœ¨è؟™و ·çڑ„é—®é¢کم€‚

解ه†³و–¹و³•وک¯ï¼Œن؟®و”¹/hadoop-1.0.2/src/core/org/apache/hadoop/fs/FileUtil.java里é¢çڑ„checkReturnValue,و³¨é‡ٹوژ‰هچ³هڈ¯ï¼ˆوœ‰ن؛›ç²—وڑ´ï¼Œهœ¨Windowن¸‹ï¼Œهڈ¯ن»¥ن¸چ用و£€وں¥ï¼‰ï¼ڑ

<script src="https://gist.github.com/2477544.js?file=FileUtil.java"></script>

......

آ آ private static void checkReturnValue(boolean rv, File p,

آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ FsPermission permission

آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ ) throws IOException {

آ آ آ آ /**

if (!rv) {

throw new IOException("Failed to set permissions of path: " + p +

" to " +

String.format("%04o", permission.toShort()));

}

**/

آ آ }

......

é‡چو–°ç¼–译و‰“هŒ…hadoop-core-1.0.2.jar,و›؟وچ¢وژ‰hadoop-1.0.2و ¹ç›®ه½•ن¸‹çڑ„hadoop-core-1.0.2.jarهچ³هڈ¯م€‚

è؟™é‡Œوڈگن¾›ن¸€ن»½ن؟®و”¹ç‰ˆçڑ„hadoop-core-1.0.2-modified.jarو–‡ن»¶ï¼Œو›؟وچ¢هژںhadoop-core-1.0.2.jarهچ³هڈ¯م€‚

و›؟وچ¢ن¹‹هگژ,هˆ·و–°é،¹ç›®ï¼Œè®¾ç½®ه¥½و£ç،®çڑ„jarهŒ…ن¾èµ–,çژ°هœ¨ه†چè؟گè،ŒWordCountTest,هچ³هڈ¯م€‚

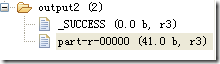

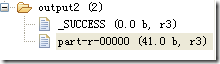

وˆگهٹںن¹‹هگژ,هœ¨Eclipseن¸‹هˆ·و–°HDFSç›®ه½•ï¼Œهڈ¯ن»¥çœ‹هˆ°ç”ںوˆگن؛†ouput2ç›®ه½•ï¼ڑ

点ه‡»â€œ part-r-00000â€و–‡ن»¶ï¼Œهڈ¯ن»¥çœ‹هˆ°وژ’ه؛ڈ结وœï¼ڑ

Byeآ آ آ 1

Goodbyeآ آ آ 1

Hadoopآ آ آ 2

Helloآ آ آ 2

Worldآ آ آ 2

ه—¯ï¼Œن¸€و ·هڈ¯ن»¥و£ه¸¸Debug调试该程ه؛ڈ,设置و–点(هڈ³é”® –> Debug As – > Java Application),هچ³هڈ¯ï¼ˆو¯ڈو¬،è؟گè،Œن¹‹ه‰چ,都需è¦پو”¶هˆ°هˆ 除输ه‡؛ç›®ه½•ï¼‰م€‚

هڈ¦ه¤–,该وڈ’ن»¶ن¼ڑهœ¨eclipseه¯¹ه؛”çڑ„workspace\.metadata\.plugins\org.apache.hadoop.eclipseن¸‹ï¼Œè‡ھهٹ¨ç”ںوˆگjarو–‡ن»¶ï¼Œن»¥هڈٹه…¶ن»–و–‡ن»¶ï¼ŒهŒ…و‹¬Haoopçڑ„ن¸€ن؛›ه…·ن½“é…چç½®ç‰م€‚

ه—¯ï¼Œو›´ه¤ڑ细èٹ‚,و…¢و…¢ن½“éھŒهگ§م€‚

éپ‡هˆ°çڑ„ه¼‚ه¸¸

org.apache.hadoop.ipc.RemoteException: org.apache.hadoop.hdfs.server.namenode.SafeModeException: Cannot create directory /user/root/output2/_temporary. Name node is in safe mode.

The ratio of reported blocks 0.5000 has not reached the threshold 0.9990. Safe mode will be turned off automatically.

آ آ آ at org.apache.hadoop.hdfs.server.namenode.FSNamesystem.mkdirsInternal(FSNamesystem.java:2055)

آ آ آ at org.apache.hadoop.hdfs.server.namenode.FSNamesystem.mkdirs(FSNamesystem.java:2029)

آ آ آ at org.apache.hadoop.hdfs.server.namenode.NameNode.mkdirs(NameNode.java:817)

آ آ آ at sun.reflect.NativeMethodAccessorImpl.invoke0(Native Method)

آ آ آ at sun.reflect.NativeMethodAccessorImpl.invoke(NativeMethodAccessorImpl.java:39)

آ آ آ at sun.reflect.DelegatingMethodAccessorImpl.invoke(DelegatingMethodAccessorImpl.java:25)

آ آ آ at java.lang.reflect.Method.invoke(Method.java:597)

آ آ آ at org.apache.hadoop.ipc.RPC$Server.call(RPC.java:563)

آ آ آ at org.apache.hadoop.ipc.Server$Handler$1.run(Server.java:1388)

آ آ آ at org.apache.hadoop.ipc.Server$Handler$1.run(Server.java:1384)

آ آ آ at java.security.AccessController.doPrivileged(Native Method)

آ آ آ at javax.security.auth.Subject.doAs(Subject.java:396)

آ آ آ at org.apache.hadoop.security.UserGroupInformation.doAs(UserGroupInformation.java:1093)

آ آ آ at org.apache.hadoop.ipc.Server$Handler.run(Server.java:1382)

هœ¨ن¸»èٹ‚点ه¤„,ه…³é—وژ‰ه®‰ه…¨و¨،ه¼ڈï¼ڑ

#bin/hadoop dfsadmin –safemode leave

ه¦‚ن½•و‰“هŒ…

ه°†هˆ›ه»؛çڑ„Map/Reduceé،¹ç›®و‰“هŒ…وˆگjarهŒ…,ه¾ˆç®€هچ•çڑ„ن؛‹وƒ…,و— 需ه¤ڑ言م€‚ن؟è¯پjarو–‡ن»¶çڑ„META-INF/MANIFEST.MFو–‡ن»¶ن¸هکهœ¨Main-Classوک ه°„ï¼ڑ

Main-Class: com.hadoop.learn.test.TestDriver

è‹¥ن½؟用هˆ°ç¬¬ن¸‰و–¹jarهŒ…,那ن¹ˆهœ¨MANIFEST.MFن¸ه¢هٹ Class-Pathه¥½ن؛†م€‚

هڈ¦ه¤–هڈ¯ن½؟用وڈ’ن»¶وڈگن¾›çڑ„MapReduce Driverهگ‘ه¯¼ï¼Œهڈ¯ن»¥ه¸®ه؟™وˆ‘ن»¬هœ¨Hadoopن¸è؟گè،Œï¼Œç›´وژ¥وŒ‡ه®ڑهˆ«هگچ,ه°¤ه…¶وک¯هŒ…هگ«ه¤ڑن¸ھMap/Reduceن½œن¸ڑو—¶ï¼Œه¾ˆوœ‰ç”¨م€‚

ن¸€ن¸ھMapReduce Driverهڈھè¦پهŒ…هگ«ن¸€ن¸ھmainه‡½و•°ï¼ŒوŒ‡ه®ڑهˆ«هگچï¼ڑ

<script src="https://gist.github.com/2498401.js?file=TestDriver.java"></script>

package com.hadoop.learn.test;

import org.apache.hadoop.util.ProgramDriver;

/**

*

* @author yongboy

* @time 2012-4-24

* @version 1.0

*/

public class TestDriver {

public static void main(String[] args) {

int exitCode = -1;

ProgramDriver pgd = new ProgramDriver();

try {

pgd.addClass("testcount", WordCountTest.class,

"A test map/reduce program that counts the words in the input files.");

pgd.driver(args);

exitCode = 0;

} catch (Throwable e) {

e.printStackTrace();

}

System.exit(exitCode);

}

}

è؟™é‡Œوœ‰ن¸€ن¸ھه°ڈوٹ€ه·§ï¼ŒMapReduce Driverç±»ن¸ٹé¢ï¼Œهڈ³é”®è؟گè،Œï¼ŒRun on Hadoop,ن¼ڑهœ¨Eclipseçڑ„workspace\.metadata\.plugins\org.apache.hadoop.eclipseç›®ه½•ن¸‹è‡ھهٹ¨ç”ںوˆگjarهŒ…,ن¸ٹن¼ هˆ°HDFS,وˆ–者è؟œç¨‹hadoopو ¹ç›®ه½•ن¸‹ï¼Œè؟گè،Œه®ƒ:

# bin/hadoop jar LearnHadoop_TestDriver.java-460881982912511899.jar testcount input2 output3

OK,وœ¬و–‡ç»“وںم€‚

هˆ†ن؛«هˆ°ï¼ڑ

相ه…³وژ¨èچگ

ن؛Œم€پHadoopه¦ن¹ 笔记ن¹‹ن؛”ï¼ڑن½؟用Eclipseوڈ’ن»¶ Eclipseوڈ’ن»¶وک¯ه¼€هڈ‘Hadoopه؛”用çڑ„é‡چè¦په·¥ه…·ï¼Œه®ƒوڈگن¾›ن؛†é›†وˆگçڑ„ه¼€هڈ‘çژ¯ه¢ƒï¼Œن½؟ه¾—ه¼€هڈ‘者هڈ¯ن»¥و›´و–¹ن¾؟هœ°ç¼–ه†™م€پ调试ه’Œè؟گè،ŒHadoop程ه؛ڈم€‚é€ڑè؟‡وڈ’ن»¶ï¼Œç”¨وˆ·هڈ¯ن»¥هˆ›ه»؛Hadoopé،¹ç›®ï¼Œç¼–ه†™MapReduce...

وœ¬ç¯‡ه¦ن¹ 笔记ن¸»è¦پن»‹ç»چن؛†ه¦‚ن½•هœ¨Eclipseن¸é…چç½®ه’Œç¼–译Hadoopé،¹ç›®م€‚ 首ه…ˆï¼Œوˆ‘ن»¬éœ€è¦پهˆ›ه»؛ن¸€ن¸ھو–°çڑ„Javaé،¹ç›®و¥ه¯¼ه…¥Hadoopçڑ„و؛گن»£ç پم€‚هœ¨Eclipseçڑ„Package Explorer视ه›¾ن¸ï¼Œé€ڑè؟‡هڈ³é”®é€‰و‹©â€œNew†-> “Java Projectâ€م€‚هœ¨ه¼¹ه‡؛...

5. **hadoopè؟œç¨‹è°ƒè¯•.txt** - و–‡ن»¶هگچوڑ—ç¤؛ن؛†ه¦‚ن½•è؟œç¨‹è°ƒè¯•Hadoop程ه؛ڈ,è؟™ه¯¹ن؛ژه¼€هڈ‘者هœ¨هˆ†ه¸ƒه¼ڈçژ¯ه¢ƒن¸è§£ه†³é—®é¢ک至ه…³é‡چè¦پ,هڈ¯èƒ½و¶µç›–ن؛†ن½؟用IDE(ه¦‚Eclipse)çڑ„è؟œç¨‹è°ƒè¯•é…چç½®ه’Œوٹ€ه·§م€‚ 6. **MRو‰§è،Œوµپ程笔记.txt** - MapReduce...

资و–™هڈ¯èƒ½و¶µç›–Zookeeperçڑ„选ن¸¾ç®—و³•م€پن¼ڑè¯ه’Œè§‚ه¯ں者و¨،ه¼ڈ,ن»¥هڈٹهœ¨Hadoopن¸ه¦‚ن½•ن½؟用Zookeeperو¥ن؟è¯پوœچهٹ،çڑ„é«کهڈ¯ç”¨و€§م€‚ وœ€هگژ,"ه¦‚ن½•وٹٹhadoopو؛گç په…³èپ”هˆ°eclipseه·¥ç¨‹ن¸"وک¯é’ˆه¯¹ه¼€هڈ‘者çڑ„ه†…ه®¹ï¼Œè¯´وکژه¦‚ن½•ه°†Hadoopçڑ„و؛گن»£ç په¯¼ه…¥...

Hadoopن¸ژHBaseه¦ن¹ 笔记 وœ¬و–‡و،£è®°ه½•ن؛†Hadoopه’ŒHBaseçڑ„ه¦ن¹ è؟‡ç¨‹ï¼ŒهŒ…و‹¬Hadoopçڑ„ه®‰è£…م€پHBaseçڑ„ه®‰è£…ه’Œهœ¨Eclipseن¸‹ه¼€هڈ‘HBaseçڑ„ه®è·µè؟‡ç¨‹م€‚è؟™ن؛›è®°ه½•و—¨هœ¨ن¸؛هˆه¦è€…وڈگن¾›وŒ‡ه¯¼ه’Œه¸®هٹ©م€‚ 1. Hadoopه®‰è£… Hadoopçڑ„ه®‰è£…需è¦په…ˆه®‰è£…...

وژ¥ن¸‹و¥ï¼Œم€ٹHadoopن¼ھهˆ†ه¸ƒو¨،ه¼ڈه®‰è£…笔记وˆگهٹں版وœ¬هœ¨windowsن¸‹çڑ„è™ڑو‹ںوœ؛ن½†وک¯é‡Œé¢و²،وœ‰windowsن¸‹çڑ„eclipseçڑ„é…چç½®.pdfم€‹è؟™ن»½و–‡و،£è¯¦ç»†è®°ه½•ن؛†هœ¨Windowsçژ¯ه¢ƒن¸‹ن½؟用è™ڑو‹ںوœ؛(ه¦‚VMwareوˆ–VirtualBox)ه®‰è£…Hadoopçڑ„و¥éھ¤ï¼Œç‰¹هˆ«وک¯ن¼ھ...

mavençڑ„ه®‰è£…م€پè·¯ه¾„é…چç½®م€پن؟®و”¹ه؛“و–‡ن»¶è·¯ه¾„ه’Œeclipseن¸çڑ„é…چ置,解ه†³Eclipseن½؟用Mavenن¸‹è½½و…¢çڑ„é—®é¢ک 1.3م€پهˆ›ه»؛ن¸€ن¸ھmavenه·¥ç¨‹HDFS 1.4م€پ ه¯¼ه…¥ç›¸ه؛”çڑ„ن¾èµ–هگو ‡هٹ و—¥ه؟—و·»هٹ junit junit RELEASE org.apache.logging....

ه¼€ه§‹ه¦ن¹ Hadoop,首ه…ˆوگه»؛ن؛†ن¸€ن¸‹ه¼€هڈ‘çژ¯ه¢ƒï¼Œوœ€ه¼€ه§‹وک¯هœ¨هچ•ç‹¬ç¼–ه†™Map-Reduce程ه؛ڈ,然هگژهœ¨ه‘½ن»¤è،Œç¼–译,ه†چé€ڑè؟‡hadoopه‘½ن»¤è؟گè،Œو‰“ه¥½çڑ„jarهŒ…,虽然ن¹ں能ه¤ںè؟گè،Œï¼Œن½†وک¯و€»و„ں觉è؟™و ·ç”¨èµ·و¥ه¾ˆé؛»çƒ¦ï¼Œو‰€ن»¥ن»ٹو™ڑهڈˆه°è¯•ن؛†ç›´وژ¥é€ڑè؟‡eclipse...

### Talendه¦ن¹ 笔记1—وœ¬هœ°و–‡ن»¶ن¸ٹن¼ HDFS #### ن¸€م€پTalend简ن»‹ن¸ژه؛”用هœ؛و™¯ Talendوک¯ن¸€و¬¾ه¼€و؛گçڑ„و•°وچ®é›†وˆگه·¥ه…·ï¼Œه®ƒوڈگن¾›ن؛†ن¸€ç³»هˆ—çڑ„و•°وچ®ه¤„çگ†هٹں能,هŒ…و‹¬و•°وچ®و¸…و´—م€پ转وچ¢ه’Œهٹ è½½ç‰م€‚Talendو”¯وŒپه¤ڑç§چو•°وچ®ه؛“ه’Œو–‡ن»¶و ¼ه¼ڈ,能ه¤ںو–¹ن¾؟...

- **Hadoopç”ںو€پç³»ç»ںن¸çڑ„هœ°ن½چ**ï¼ڑéڑڈç€ه¤§و•°وچ®ه¤„çگ†çڑ„需و±‚و—¥ç›ٹه¢é•؟,Hadoopه·²وˆگن¸؛ه¤§و•°وچ®ه¤„çگ†çڑ„و ‡ه‡†ه¹³هڈ°ن¹‹ن¸€م€‚而Scalaن½œن¸؛Sparkçڑ„ن¸»è¦په¼€هڈ‘è¯è¨€ï¼Œن¸چن»…ن¸ژHadoopç”ںو€پç³»ç»ںه®Œç¾ژèچهگˆï¼Œè€Œن¸”هœ¨وڈگن¾›é«کو•ˆو•°وچ®ه¤„çگ†èƒ½هٹ›çڑ„هگŒو—¶è؟کن؟وŒپن؛†...

م€گInfosysه¦ن¹ 笔记م€‘ Infosysوک¯ن¸€ه®¶ه…¨çگƒçں¥هگچçڑ„ه’¨è¯¢ه’Œوٹ€وœ¯وœچهٹ،ه…¬هڈ¸ï¼Œن»¥ه…¶هœ¨ن؟،وپ¯وٹ€وœ¯é¢†هںںçڑ„هˆ›و–°ه’Œè§£ه†³و–¹و،ˆè€Œé—»هگچم€‚هœ¨وœ¬و–‡ن¸ï¼Œوˆ‘ن»¬ه°†و·±ه…¥وژ¢è®¨Infosysçڑ„相ه…³وٹ€وœ¯هڈٹه…¶ه؛”用,هگŒو—¶ç»“هگˆâ€œو؛گç پâ€ه’Œâ€œه·¥ه…·â€è؟™ن¸¤ن¸ھو ‡ç¾ï¼Œه°†...

5. 软ن»¶ه¼€هڈ‘ه·¥ه…·ï¼ڑEclipseم€پIntelliJ IDEAç‰Java集وˆگه¼€هڈ‘çژ¯ه¢ƒï¼ˆIDE)وڈگن¾›ن؛†ه¼؛ه¤§çڑ„物èپ”网ه¼€هڈ‘و”¯وŒپ,هŒ…و‹¬ç،¬ن»¶و¨،و‹ںه™¨م€پ物èپ”网وڈ’ن»¶ç‰ï¼Œن½؟ه¾—ه¼€هڈ‘者هڈ¯ن»¥هœ¨و²،وœ‰ه®é™…设ه¤‡çڑ„وƒ…ه†µن¸‹è؟›è،Œن»£ç پç¼–ه†™ه’Œوµ‹è¯•م€‚ "ن»ژ0ه¼€ه§‹ç”¨Javaهپڑو™؛و…§...

Javaوک¯ن¸€ç§چه¹؟و³›ن½؟用çڑ„é¢هگ‘ه¯¹è±،çڑ„编程è¯è¨€ï¼Œç”±Sun Microsystems(çژ°ن¸؛Oracleه…¬هڈ¸çڑ„ن¸€éƒ¨هˆ†ï¼‰ن؛ژ1995ه¹´هڈ‘ه¸ƒم€‚..."Javaه¦ن¹ 笔记"è؟™ن¸ھهژ‹ç¼©هŒ…و–‡ن»¶ه؛”该هŒ…هگ«ن؛†ه…³ن؛ژè؟™ن؛›ن¸»é¢کçڑ„详细و•™ç¨‹ه’Œç¤؛ن¾‹ن»£ç پ,وک¯ن½ ه¦ن¹ Javaçڑ„ه¥½èµ„و؛گم€‚

6. **و•°وچ®هˆ†وگ**: و•°وچ®é¢„ه¤„çگ†م€پç»ںè®،هˆ†وگم€پو•°وچ®هڈ¯è§†هŒ–م€پوœ؛ه™¨ه¦ن¹ ç®—و³•ï¼ˆه¦‚ç؛؟و€§ه›ه½’م€په†³ç–و ‘م€پç¥ç»ڈ网络)ç‰ن¸»é¢کهڈ¯èƒ½هœ¨ç¬”è®°ن¸ه‡؛çژ°م€‚è؟™éƒ¨هˆ†ه†…ه®¹ه¯¹ن؛ژçگ†è§£ه’Œه؛”用و•°وچ®هˆ†وگوٹ€وœ¯è‡³ه…³é‡چè¦پم€‚ 7. **ه¼€هڈ‘ه·¥ه…·**: 笔记هڈ¯èƒ½è؟کن¼ڑو¶‰هڈٹ...

م€گJava编程è¯è¨€هں؛ç،€م€‘ Javaوک¯ن¸€ç§چه¹؟و³›ن½؟用çڑ„é¢هگ‘ه¯¹è±،çڑ„编程è¯è¨€ï¼Œç”±Sun Microsystems(çژ°ه·²è¢«Oracleو”¶è´ï¼‰ن؛ژ1995ه¹´وژ¨ه‡؛م€‚...هœ¨ه®é™…ه¼€هڈ‘è؟‡ç¨‹ن¸ï¼Œè؟کè¦په…³و³¨ç¤¾هŒ؛هٹ¨و€پ,ن؛†è§£و–°وٹ€وœ¯ه’Œو،†و¶ï¼Œن»¥ن¾؟ن¸چو–وڈگهچ‡è‡ھه·±çڑ„وٹ€èƒ½م€‚

1. Eclipseï¼ڑن¸€ن¸ھه¼€و؛گçڑ„IDE,و”¯وŒپه¤ڑç§چè¯è¨€ï¼Œه…·وœ‰ن¸°ه¯Œçڑ„وڈ’ن»¶ه’Œه¼؛ه¤§çڑ„调试هٹں能م€‚ 2. IntelliJ IDEAï¼ڑJetBrainsه…¬هڈ¸çڑ„و——舰ن؛§ه“پ,ن»¥ه…¶و™؛能ن»£ç پè،¥ه…¨ه’Œé«کو•ˆçڑ„ه¼€هڈ‘ن½“éھŒè€Œé—»هگچم€‚ 3. NetBeansï¼ڑهڈ¦ن¸€ن¸ھه¼€و؛گIDE,特هˆ«é€‚هگˆهˆه¦è€…...

ه› و¤ï¼Œè؟™ن¸ھهژ‹ç¼©هŒ…هڈ¯èƒ½هŒ…هگ«Manuelçڑ„ه¦ن¹ 笔记م€پن»£ç پç¤؛ن¾‹م€پ课ن»¶م€پوµ‹è¯•و–‡ن»¶وˆ–ه…¶ن»–ن¸ژJava编程相ه…³çڑ„资و؛گم€‚ و·±ه…¥ه¦ن¹ Java,وˆ‘ن»¬éœ€è¦پوژŒوڈ،ن»¥ن¸‹ه‡ ن¸ھه…³é”®çں¥è¯†ç‚¹ï¼ڑ 1. **هں؛ç،€è¯و³•**ï¼ڑهŒ…و‹¬هڈکé‡ڈم€پو•°وچ®ç±»ه‹م€پè؟گ算符م€پوژ§هˆ¶ç»“و„...