- ÌçÒÏ: 431695 ̘À

- ÌÏͨ:

- ÌËÒˆ: ÌñÝÍ°

-

ÌÓ¨ ÍÓÝ£

- Í ´Õ´ÍÍÛÂ (280)

- JavaÌ ¡Í¢ÌÌ₤ (40)

- JVM/Í ÍÙÌ´ÀÍ/Ò¯ð¥/ÌÕ (23)

- JavaͤӴÌÌ₤ (44)

- Ó°£Ó£ÌÑÌ (3)

- ÒÛƒÒÛÀÌ´ÀÍ¥ (2)

- ÕÓ´ÌÌ₤ (10)

- ÌÍÀÍ´Õ Ó§Û (3)

- ÓÀ˜ð£Ñ (8)

- linuxÌÌ₤ (21)

- javascript (17)

- webÌÌ₤ (9)

- Ó§Ó£ÕÒÛ₤ (10)

- ̯ÌÛͤ (35)

- ÌÓÇÂÍ¥Ì (4)

- ÒÝÒ₤Ù (5)

- ÓÌÇ£ÕÓ˜ (11)

- Ó£Ìç (7)

- ÌÒçÓÒÇÂ (11)

- Óʃð¥ÍÊÏÍÙÎ (20)

- ̓ÍÍÊÓÌÌ₤ (1)

- ÌÏÒ§ð¡ð¥Í (5)

ÓʃͤÓÍ

- ÌÓÒçÒÛ₤ ( 0)

- ÌÓÒÛ¤Í ( 1)

- ÌÓÕÛÓÙ ( 0)

ÍÙÌÀÈÍÓÝ£

- 2012-08 ( 1)

- 2012-06 ( 2)

- 2012-05 ( 2)

- ÌÇÍÊÍÙÌÀÈ...

Ì̯Ò₤ÒÛ¤

-

Glogoÿ¥

ÌË¥ð¡£Ì´Í˧ÿ¥ÌÍ´Ò₤Ո̴Óð£ÈÓ ÓÌÑÍÍӯ̯ͥÓð¡ð¡ˆÍÙÓ¤¢Ó´Í¿ÑÌýÀÌð¡ÓÇ ...

java ըͿÑÍ ReentrantLock -- Í₤ÕÍ ËÓÕ -

univasityÿ¥

ÌÒ¢ÍÒÏð¿Ò¨ÕÕð¤ÿ¥ÌÒ₤ð¡ð¡Í¯ÝÍ˧ð¡ð¥~~ ÓÌËÌÍÊˋÍÒÎÍÓçð¢ÀM ...

ADSLð¡Ó§ÕͤÎÌ Â Õ§Ì₤Í¡ÍñÕÕÌ¿ÓÓË¡ -

liuyuanhui0301ÿ¥

ô

java ըͿÑÍ ReentrantLock -- Í₤ÕÍ ËÓÕ -

dang_javaÿ¥

Íç.̓Í˧ÓÒ₤ÇÌÌÌÀÈ.

JXTAÌÌ₤ð¡Í¤Ó´ÍÍÝ -

helloqidiÿ¥

Ò¯ÂÒ¯Âÿ¥ÍÙÎð¿ ð¤

SQLð¡ÙexistsÍinÓͤͨ

ô ð¡ÓÇð£ËÌËÿ¥ÓÍ¯Í °ð¤raid5ð¡raid10ÓÌÏÒ§ð¿ð¤Ò¢Ì₤ÕÍ¡¡ÍÊÓÿ¥ÓҰ̓ÍÊð¤¤ÕÈ̢ͤð¤ÌçÒ₤̯ÌÛÿ¥ð§Ì₤ÿ¥Í¯Í¤Ò¯Ì₤Ò¯ÕÐÒ¢Õÿ¥ÌͯÝÒ¢ð¡ÊÓÏraidÓÍ Õ´Ò¢ÒÀÍÓÌËÍÌð¡ð¡ÿ¥Ìð£˜Í´ð£ð¿Ì Íçð¡Í¤Í§ÕÍÕ͈ð¡ÓÏraidÌ¿Í¥Ð

ô ô ð¡¤ð¤Ì¿ðƒ¢Í₤¿Ì₤ÿ¥ÌÒ¢ÕÌ¢ÍÌ ñÍÊÕˋÝÍ´Í´ÓÓÈÓÌËÍÍ₤¿Ì₤ÿ¥raid5ÕÌˋ3D+1PÓraidÌ¿ÌÀÿ¥raid10ÕÌˋ2D+2DÓRaidÌ¿ÌÀÿ¥ÍͨÍÎ̓ÿ¥

1ÐÍÛÍ ´ÌÏÌ¿ÕÂÓÌ₤Òƒ

Í ÑÍÛÍ´ÍÛÍ ´ÌÏÌ¿ÕÂÿ¥Í¢ÕÀ£ÒÇ´Óÿ¥Ò₤ÍÛÌ₤RAID10ÓÍÛÍ ´ÌÏÕ¨ð¤RAID5ÐÌð£˜ð¿Í₤ð£Ëð£ÓÛÍÓÍÌÌË̓ͤÐͧÓ1ÌÍÌÑÿ¥Í₤¿ð¤RAID10ÿ¥ÍˆÌͧÓ1Í₤¿Í¤ÓÕÒÝÀÓÌÍÿ¥ÌÍ₤¥ÒÇRAIDÍÊÝÌÐð§Ì₤Í₤¿ð¤RAID5ÿ¥Íˋð¡Ó3ÍÓð¡Ùÿ¥ð££ð§ð¡ÍÓÌ Õÿ¥Õ§Í¯Í₤¥ÒÇRAIDÍÊÝÌÐ

Í´ÌÂÍÊÓÌÑÍÿ¥RAID10ÌÂÍÊÓÕͤÎð¿Í¢¨ð¤RAID5Ð

2ÐÓˋ¤ÕÇÍˋÓ´ÓÓÌ₤Òƒ

RAID10ÓÍˋÓ´ÓÌ₤50%ÿ¥RAID5ÓÍˋÓ´ÓÌ₤75%ÐÓÀ˜Ó̯ÕÒÑÍÊÿ¥RAID5ÓÓˋ¤ÕÇÍˋÓ´ÓÒÑÕ¨Ð

3ÐÒ₤£ÍÌÏҧ̿ÕÂÓÌ₤Òƒ

ÕÈð¿ÿ¥Ìð£˜ÍÌÍÎð¡ð¡ð¡ˆÒ¢Ó´ÿ¥Ò₤£ÿ¥Ò¢Ó£ÙÍÿ¥Õ̤Íÿ¥ð§Ì₤ÿ¥Í´ð£Ó£Ò¢ð¡ð¡ˆÒ¢Ó´ð¿Íÿ¥ÌÕÒÎð£Ó£ð¡ð¡ˆÓ¿Í¨ÕÒÎÓÌÎÍ¢çÿ¥cacheÐô

cacheÌÌ₤ÌÒ¢Í Í¿Çÿ¥Í´ÓÈÓÍÙÍ´ÌÌ₤ð¡ÿ¥ÍÍÝÓÕÍ¡¡Ò¢

Õÿ¥ð§ð¡¤Õ¨Ó¨₤ÍÙÍ´ÿ¥cacheÍñýÓ£Ì₤ÌÇð¡ˆÍÙÍ´ÓÌ ¡Í¢ÌÍ´ÿ¥Í¯ÝÌ₤ð¡Ùð§Ó¨₤ÍÙÍ´ÿ¥ð¿Ì̓ÍÊÏÓcacheÍÙÍ´ÿ¥Í

̘ÌÓÛÍÓraidÍÀÿ¥ð¡Ò˜Õ§Í

ͨÌÍ Íÿ¥ÓÒ°Í ÓƒÍ

Óraid cacheÐô

ô ô ô ô ô ô cacheÓð¡£ÒÎð§Ó´Ì₤ð£ð¿ÍÂÿ¥ð§Ó¯Í´Ò₤£ð¡Íð¡Êð¡ˆð¡ÍÓÌ¿ÕÂÿ¥ÍÎÌð§ð¡¤Íÿ¥ð¡Ò˜ÍÙÍ´ÕçÍ͈ÒÎÌÝÍͯcacheͯÝÓÛÍÛÌð¤ÍÌð§ÿ¥Ìð£Ëÿ¥ÕçÍÓÍÌ₤ÕÍ¡¡Í¢¨ÕÓÿ¥Í´ÍcacheÓ̯ÌÛÓÏ₤ÓÇ₤ͯð¡ÍÛӴͤÎÿ¥ÕçÍÌÌ̯ÌÛÍñͯÓÈÓÿ¥Í₤ð£ËÍÛӯ̿ÕÓÍÍ

Ëÿ¥Ò°ð¤cache̯ÌÛÓð¢ÌÊÿ¥ð¡Ò˜Õ§ðƒÒçð¤ÕÓ¡ð¡ÓçÌÝ ÿ¥ÌÒ

Ì₤UPSÿ¥Ðô

ô ô ô ô ô ô cacheÓÒ₤£ð¡Ì ñð¡Í₤Í¢§ÒÏÿ¥Í ð¡¤ÍÎÌÒ₤£Ò§Í´cacheð¡Ùͧð¡ÙÓÒ₤ÿ¥Í¯ÍͯÓÈÓÓÍ₤£Õÿ¥Í ð¡¤ÓÈÓð£Í₤£ÕÍ¥ÍÏ̯ͯ̃ͯÌÛÿ¥ð¡Ò˜Õ§Í´6msð£Ëð¡ÿ¥ÒÒ¢ð¡ˆÌÑÕÇÿ¥Í₤¿ð¤ÕÈð¤Í₤ÕÍioÓͤӴÍ₤Ò§ð¡Ì₤ÍʈÓÌ°Ðð§Ì₤ÿ¥ÍÎÌcacheҧͧð¡Ùÿ¥ð¡Ò˜ÍͤÌÑÕÇÍÍ₤ð£ËÍ´1msð£ËÍ

Ðô

ô ô ô ô ô ô ð¡ÒÎÒ¢ñð¢ÀÍÙÍ´ÍÍÓiopsÿ¥Ì₤ÓÏÓio̯ÿ¥Ì¯ÌÛÿ¥ð£ð£˜Í₤Ò§Í

´Õ´Í´cacheͧð¡ÙÓͤÓÀð¡ÍͯÓÿ¥ð§Ì₤ÍÛÕ

ð¡ÿ¥ð§ Ócacheͧð¡ÙÓÍ₤ҧ͈Ì10%Ðô

ð£Ó£ÍÛcacheÿ¥Ìð£˜Í¯ÝÍ₤ð£ËÒÏÈÕraid5ð¡raid10Í´ð¡ÍÓÌ´ÀÍ¥ð¡ÿ¥ÍñËð§ÌÓÕÛÕÂð¤ÿ¥ÕÈð¿Ìð£˜ÌËÍͨÍÌð£Ëð¡ð¡ð¡ˆÕÛÕÂÐô

3.1ÐÒ₤£Ìð§

Í ð¡¤raid5ð¡raid10ÓÓÈÓÕ§Í₤ð£ËÌðƒÌÍÀÿ¥Ìð£Ëÿ¥Í´Ò₤£ð¡ÕÂð£ð£˜Í¤Ì˜Ì₤ÌýÀÌÍñÛͨÓÿ¥ÕÊÕÌ₤Ò₤£Ó̯ÌÛҧͧÝÍcacheͧð¡ÙÓÿ¥Í₤¥ÒÇͧð¡ÙÓð¡ð¡Ì ñÐ

3.2ÐÒ¢Ó£ÙÍ

Ò¢Ó£ÙÍÓÒ¢Ó´ÿ¥ð¡Ò˜ÒÀ´ÓʤÍÍ ËÒ¢Ó£ÙÓÍÊÏÌ¿ÕÓ̯ÌÛÿ¥ÍÎ͈ð§Ì¯ÌÛÌçÿ¥ÍƒÍÊÏÓÌð£ÑÓÙÓÙÿ¥Ò¢ð¡ˆÍÌð§Ò¢Ó´ÿ¥ÍÎÌÌÍcacheÍÙÍ´ÿ¥Í¿Ñð¡ÓÛÌ°ÌýÀÌÕÛÕÂÓÒ₤ÿ¥raid5Ì₤raid10ÓÒ°ð¥ÌÇÍ˧ð¡ð¤ÿ¥Ò¢ÕÒÎÍÍÛÍÙÍ´Ìð¡ÍÛÍÊÏͯÒÑ°ÍÊÓÍcacheÿ¥Òð¡ÒÛÀÓÛÌ ÀÕˆÓcpuð¡ð¥Í¤Ó¯ÓÑÕÂÿ¥ÐÍ ð¡¤Ò¢ð¡ˆÌÑÍÓÌ ÀÕˆÌ₤Í´cacheð¡ÙÍÛÌÿ¥ÍÎ4ÍÓÓraid5ÿ¥Í₤ð£ËÍ Í´Í ÍÙð¡ÙÒÛÀÓÛÍË§Ì ÀÕˆÿ¥ÍÌÑÍÍ Ë3ð¡ˆÌ¯ÌÛ+1ð¡ˆÌ ÀÕˆÐÒraid10͈ҧÍÌÑÍÍ Ë2ð¡ˆÌ¯ÌÛ+2ð¡ˆÕÓ¡Ð

ÍÎÿ¥4ÍÓÓraid5Í₤ð£ËÍ´ÍÌÑÕÇÍÍ

Ë1Ð2Ð3ͯcacheÿ¥Í¿Ñð¡Í´cacheÒÛÀÓÛÍË§Ì ÀÕˆð¿Íÿ¥ÌÒ¢ÕÍÍÛÌ₤6ÿ¥ÍÛÕ

ÓÌ ÀÕˆÒÛÀÓÛÍ¿Ñð¡Ì₤Ò¢Ì ñÓÿ¥ÌÒ¢Õð£

ð£

Ì₤ÍÒÛƒÿ¥ÿ¥ÍÌÑÌð¡ð¡ˆÌ¯ÌÛÍͯÓÈÓÐÒ4ÍÓÓraid10ð¡ÓÛÀcacheÌ₤ÍÎÍÙÍ´ÿ¥ÍÓÌÑÍÿ¥Õ§Ì₤ÍÌÑÍ2ð¡ˆÌ¯ÌÛð¡2ð¡ˆÕÓ¡Ðô

ð§Ì₤ÿ¥ÌÍÕÂð¿Ò₤ÇÒ¢ð¤ÿ¥ÍcacheÌ₤Í₤ð£ËÓ¥ÍÙÍÌð§Óÿ¥ÓÙͯð¡ÍÛÌÑÌÍÍͯÓÈÓÿ¥ð§Ì₤ÿ¥ÍÌð§ð¡Ì₤Ò₤£Ìð§ÿ¥Ò¢ð¡ˆÍÌ₤Ò¢Ìˋð¿ÒÎÍÓÓÿ¥ð¿Í¯ÝÌ₤Ò₤Çÿ¥ÌÍҧͯÓÈÓð¡ÓÍÒ¢Ì₤Õ¢Í

ð¡ð¤Óÿ¥ð¡Ò¢ÿ¥ÍÎÌð¡Ì₤Ò¢Ó£ÙÌÏÓÍ¥¤Ò¢Ó£ÙÍÿ¥ÍˆÒÎð¡ÒƒƒÍ¯ÓÈÓÓÍÌÕÿ¥ÍñÛͨէð¡Ì₤ÍʈÍÊÏÐô

3.3ÐÓΣÌÈÍ

Ò¢ÕÍ₤Ò§Ì₤ÌÕƒÓÒÏÈÿ¥ð§Ì₤ÿ¥ð¿Ì₤ÌÕÒÎÓÕ´Íÿ¥Ì¯ÌÛͤÿ¥ÍÎoracle ̯ÌÛͤÍÊÏÕ´ÍÌð§Í¯ÝÌ₤ÓΣÌÈÍÿ¥ÍÎÌ₤̘ÀÍð¡ð¡ˆÌ¯ÌÛÍÓ̯ÌÛÿ¥ÍÎ8Kÿ¥Ò̤ÌËÍ¢Ò§ÓÑÓÒçñÌËÌ₤Ò¢Ó£ÙÍÿ¥ð§Ì₤Í ð¡¤Ì₤̘ÀÍÓÕð¡ÍÊÿ¥ð¡ð¢Ò₤Ò§Ìñ£Ì£Àraid5Óð¡ð¡ˆÌÀÍ¡Îÿ¥ð¢Ò₤Ì₤Í¥ ÓÕ§Ò§ÍÍ Ëÿ¥ÿ¥Ìð£Ë̓ÍÊÌÑÍð¿Ì₤ÓΣÌÈÍÍ ËÐ

Ìð£˜ÍÌËð¡Íƒÿ¥ÍÍÛÒÎÌð¡ð¡ˆÌ¯ÍÙ2ÍÌ̯ÍÙ4ÿ¥ÕÈð¿Í₤¿ð¤raid5ÿ¥ÍÛÕ

ÍÓð¤4̘Àioÿ¥ô

ô ô ô ô ô ô Í

Ò₤£Í¤2ð¡Ì ÀÕˆ6ÿ¥Í₤Ò§ÍÓÒ₤£Í§ð¡Ùô

ô ô ô ô ô ô ÓÑÍÍ´cacheð¡ÙÒÛÀÓÛ̯ÓÌ ÀÕˆô

ô ô ô ô ô ô ÍÍ

Ë̯Ó̯ÍÙ4ð¡Ì¯ÓÌ ÀÕˆ8ô

Í₤¿ð¤raid10ÿ¥Ìð£˜Í₤ð£ËÓͯÿ¥ÍÌ ñÓÍð¡ˆÌð§ÿ¥ÌÓ£raid10͈ÕÒÎ2ð¡ˆioÿ¥Òraid5ÕÒÎ4ð¡ˆioÐð§Ì₤ÿ¥Ò¢ÕÌÍ¢§ÓËð¤raid5Í´ÕÈð¡Êð¡ˆÒ₤£Ìð§ÓÌÑÍÿ¥Ò¢Í₤Ò§ð¥ÍÓÒ₤£Í§ð¡ÙÌð§ÿ¥ð¿Í¯ÝÌ₤Ò₤Çÿ¥ÍÎÌÕÒÎÒ₤£ÍÓ̯ÌÛÍñýӣʹcacheð¡Ùÿ¥Í₤Ò§Ì₤ð¡ÕÒÎ4ð¡ˆioÓÿ¥ð¿Ò₤Ìð¤cacheÍ₤¿raid5 ÓÕÒÎÌÏÿ¥ð¡ð£

ð£

Ì₤ÒÛÀÓÛÌ ÀÕˆÕÒÎÿ¥Òð¡Í₤¿ÌÏÒ§ÓÌÍÓÝð¡¤ÕÒÎÐ̃ӣÌçÒ₤Ò¢ÿ¥Í´raid5ÓÕçÍð¡Ùÿ¥ÍÎÌÍ

°ÕÙÍcacheÿ¥raid5ÓÌÏҧͯÍñÛ̓ÍÊÍÐô

Ò¢Õÿ¥Í¿Ñð¡Ì₤Ò₤ÇcacheÍ₤¿raid10ͯÝð¡ÕÒÎð¤ÿ¥Í ð¡¤ÍÓ¥Íýÿ¥Ò₤£Í§ð¡ÙÓÙÿ¥Õ§Ì₤ÌÕ¨ÕͤÎÓÍ

°ÕÛÌÍ´ÿ¥ð¡Ò¢ÓÌ₤ÿ¥raid10Í₤¿cacheÓðƒÒçÌÏÌýÀÌraid5ÕÈð¿Ì̃ÒÍñýÐô

ͯҢÕÿ¥ÍÊÏÍÛÑͤͧð¿ÍÊÏÒÇÌÓ§ð¤raid5ð¡raid10ÓÍÓð¡ÍñÛͨð¤ÿ¥ð¡Ò˜ÌËÒ₤Çÿ¥ÒÝÀͯioÓ̯ÌÛͤÓÝ£ÍÌð§ÿ¥Í£¤ÒÛÛÕÓ´raid10ÿ¥ÒÍÊÏÍÌð£ÑÍÙÍ´ÿ¥Ì¯ÌÛð£Í¤ÿ¥Íð£Óˋ¤ÕÇÍˋÓ´ÓÒÏͤÎÿ¥Í₤ð£ËÕÓ´raid5Ð

3.4ÐÓÈÓÓIOPSÍ₤¿Ì₤

ô ô ô ô ô ô ô Ìð£˜ÍÍÛð¡ð¡ˆcaseÿ¥ð¡ÍÀͤӴÓIOPSÌ₤10000ÿ¥Ò₤£cacheͧð¡ÙÓÌ₤30%ÿ¥Ò₤£IOPSð¡¤60%ÿ¥ÍIOPSð¡¤40%ÿ¥ÓÈÓð¡ˆÌ¯ð¡¤120ÿ¥ÕÈð¿ÍͨÒÛÀÓÛÍ´RAID5ð¡RAID10ÓÌ Íçð¡ÿ¥Ì₤ð¡ˆÓÈÓÓIOPSð¡¤ÍÊͯÐ

ô ô ô RAID5:ô

ô ô ô 1. ÍÍÓÓIOPS = (10000*(1-0.3)*0.6 + 4 * (10000*0.4))/120ô

ô ô ô 2.ô ô ô ô ô ô ô ô ô ô ô ô ô = (4200 + 16000)/120ô

ô ô ô 3.ô ô ô ô ô ô ô ô ô ô ô ô ô = 168

ô ô ô Ò¢ÕÓ10000*(1-0.3)*0.6ÒÀ´ÓʤÌ₤Ò₤£ÓIOPSÿ¥Ì₤ðƒÌ₤0.6ÿ¥ÕÊÌcacheͧð¡Ùÿ¥ÍÛÕ ÍˆÌ4200ð¡ˆÒ₤£IOPSÐ

ô ô ô Ò4 * (10000*0.4) ÒÀ´ÓʤÍÓIOPSÿ¥Í ð¡¤Ì₤ð¡ð¡ˆÍÿ¥Í´RAID5ð¡Ùÿ¥ÍÛÕ ÍÓð¤4ð¡ˆioÿ¥Ìð£ËÍÓIOPSð¡¤16000ð¡ˆÐ

ô ô ô ð¡¤ð¤ÒÒRAID5Í´ÍÌð§ÓÌÑÍÿ¥ÕÈ2ð¡ˆÒ₤£Ìð§ð¿Í₤Ò§ÍÓͧð¡Ùÿ¥Ìð£ËÌÇÓýƒÓÀÛÓÒÛÀÓÛͤÒ₤Ëð¡¤ÿ¥ô

ô ô ô 1. ÍÍÓÓIOPS = (10000*(1-0.3)*0.6 + 2 * (10000*0.4)*(1-0.3) + 2 * (10000*0.4))/120ô

ô ô ô 2.ô ô ô ô ô ô ô ô ô ô ô ô ô = (4200 + 5600 + 8000)/120ô

ô ô ô 3.ô ô ô ô ô ô ô ô ô ô ô ô ô = 148

ô ô ô Ò¢Ì ñÌð£˜ÒÛÀÓÛͤÌËÍð¡ˆÓÓIOPSð¡¤148ð¡ˆÿ¥Í¤Ì˜ÒƒƒÍ¯ÓÈÓIOPSÌÕÿ¥Í´Ò¢ÓÏÌ Íçð¡ÿ¥ÓÈÓÓÍñËð§ÓÑÌÌ₤ÕÍ¡¡ð¡ÓÌ°ÓÐ

RAID10Í₤¿IOPSÌÏÒ§ÓͧÝÍô

ô ô ô 1. ÍÍÓÓIOPS = (10000*(1-0.3)*0.6 + 2 * (10000*0.4))/120ô

ô ô ô 2.ô ô ô ô ô ô ô ô ô ô ô ô ô = (4200 + 8000)/120ô

ô ô ô 3.ô ô ô ô ô ô ô ô ô ô ô ô ô = 102

ô ô ô Í₤ð£ËÓͯÿ¥Í ð¡¤RAID10Í₤¿ð¤ð¡ð¡ˆÍÌð§ÿ¥ÍˆÍÓ2̘Àioÿ¥Ìð£Ëÿ¥ÍÌ ñÓÍÍÿ¥ÍÌ ñÓÓÈÓÿ¥Ì₤ð¡ˆÓÓIOPS͈Ì102ð¡ˆÿ¥Ò¢Ò¢Ò¢ð§ð¤ÓÈÓÓÌÕIOPSÐ

ô ô ô Ò¢ÕÍͯÌð£˜Í ÍÒÛ´ÒÛ¤Ócaseð¡ÌËÿ¥Í´Ìð£˜Í ÍÕÓ´RAID5ÓÌÑÍÿ¥ÕÒ¢ÍÌÿ¥Ì₤ð¡ˆÓÈÓÓIOPSʹըͰ¯ÌÑÌÿ¥Í¢¨ÒƒƒÍ¯200ð¤ÿ¥Í₤¥ÒÇÍͤÕͤÎÍñ´Ì ÂÌ Ì₤ÐÌ¿Õ ÌRAID10ÿ¥Ì₤ð¡ˆÓÈÓÓIOPSÕͯ100ÍñÎÍ°ÿ¥ÍƒÍ˧ÓÕ¢Í ð¤Ò¢ð¡ˆÌÏÒ§ÕÛÕÂÐ

3.5Ðͯӣ

ô ô ô ͧÝÍÒ₤£Ì¯ÌÛÓÍ °ÕÛÍ ÓÇ Ì₤cacheͧð¡ÙÓÿ¥Í´Ò₤£Ì¯ÌÛÓÌ Íçð¡ÿ¥RAID5ð¡RAID10ÌÏҧ̘Ҥ¨ÌýÀÌÍʈÍÊÏÍñÛͨÐð§Ì₤Í₤¿ð¤Í̯ÌÛÓð¡ð¤Í¤Ó´ÿ¥Í¯ÊÍ ÑÌ₤ͯI/OÕÂÓ¿ÍÍ ËÓð¡ð¤Í¤Ó´ÿ¥ÍÛÍ ´ÌÏÒÎÌÝ̓ըÿ¥ð¡ÒÛÀÌ̘ÿ¥Í¯Ì¯ÌÛÕÕÂÓ¿ÍÍ ËÓÓ°£Ó£ÐÍÎð¥ð¡ERPÓð¤ÏÓ°£Ó£ÓÙÓÙÿ¥RAID10Ó¡Ì₤RAID5Í₤Ò§ð¤ÏÓÒƒÍÊÏÓÌÏÒ§ÍñÛÍ¥ÐÒÍÊÏÍÌð£ÑÍÙÍ´ÿ¥Ì¯ÌÛð£Í¤ÿ¥ÍÎÍ£ÓPACSÓ°£Ó£ÐÒÏÕÂÓ¥ÒƒÓ°£Ó£Íð£Óˋ¤ÕÇÍˋÓ´ÓÒÏͤÎÿ¥Í£¤ÒÛÛÕÓ´RAID5Ð

ô ô ô Ìð£˜ÓËÕÿ¥Í´ÍÙÍ´Ó°£Ó£ÓÕÒÇÙÒ¢Ó´ð¡Ùÿ¥ÍÍ̓̓ҧÍÊÌðƒÌ¥ð¤ÛÓÌÏÒ§Í̯ÿ¥ð§ÍÛÕ Ò¢ÒÀð¡Ùÿ¥Ò₤ËÓ°£Ó£ÓÍÛÕ ÌÏÒ§ÒÀ´Ó¯Í¿Ñð¡Ò§ÒƒƒÍ¯Ìð£˜ÌÌÌÓÓÑÌÿ¥ÕÈð¿Í´Ò¢ÒÀÓ₤ÍÂð¡ÙÍÙÍ´Ó°£Ó£ÓÍÛÕ ÌÏÒ§ÓˋÑÓ¨Í͈ð¤Ó₤ÒÍÓÑÕÂÓͧÝÍÍÂÿ¥

ô ô ô ô

ô ô ô ð¿Ìð£ËÒÎÍÍÊÏÍÛÑÌËÒÛ´ÒÛ¤Ò¢ð¡ˆÕÛÕÂÿ¥Ì₤Í ð¡¤Í´Ì˜ð¤¤ÓÍñËð§ð¡Ù̃Õͯð¡ð¡ˆÍÛÕ ÓCaseÿ¥Í´Ò¢ð¡ˆcaseð¡Ùÿ¥ð¡ð¡ˆÌÂÍÊÍÍ̓ÍÊÏÓstandbyÿ¥Ò¢Õð¡£ÒÎÌ₤Íÿ¥Òð¡Ì₤ͯioÓÍÿ¥ÿ¥ÕÓ´ð¤RAID5ÓÌ¿ÌÀÿ¥ÍÓ¯ÌÏҧ̓ÍñÛÿ¥ÍÌËÌ¿Õ Ìð¤RAID10ÿ¥Í¯Ý̓Í˧ÓÕ¢Í ð¤ÌÏÒ§ÓÕÛÕÂÐ

ô ô ô Í£¤ÒÛÛÍ´Õ Ò₤£Ì˜ÌÍÿ¥ÕÎÍ Õ Ò₤£Ì˜Ìð¡Ó₤ãô RAID5ÍRAID10ÿ¥ÍˆÓÏRAIDÕÍð§ ô ãÿ¥Í ð¡¤ÌÏÒ§ÓÑÕÂÓͤӯÿ¥Ì˜Ò¤¨ð¡RAIDÌ¿Í¥Ò¢Ì₤Ì̓ÍÊÏÍ °Ó°£ÿ¥ÍÌÑ̘ÌÌÏÒ§ÒÛ´ÒÛ¤ÓͤÓÀÿ¥Ì˜Ò¤¨Í£¤Ó¨Í´ð¡ÌÓð¡ð¤Ó£ÒÛ¤ð¿ð¡Ð

ô ô ô ÕçÍÓÓÑÕÂð¡£ÒÎð§Ó¯Í´2ð¡ˆÌ¿ÕÂÿ¥Í¡ÎÍÛ§ð¡IOPSÿ¥Íð§ÌÑÕÇð¥ ÒƒÓ̯ÌÛÕÿ¥ÍÍð§ÌÑÕÇÍÛÌÓI/O̯ÿ¥Ð

ô

ͧÝÍÍ¡ÎÍÛ§Óð¡£ÒÎÍ ÓÇ

ô ô ô ÍÙÍ´Ó°£Ó£ÓÍ¡ÎÍÛ§ð¡£ÒÎÍÍ°ð¤ÕçÍÓÌÌÑÿ¥Í Ó¤ÊÕÕÓÍÊÏͯÿ¥Ìð£˜ð£ÍÊˋÒÛ´ÒÛ¤ÓÕçÍð¡Ò˜Õ§Ì₤Í Ó¤ÊÕçÍÿ¥ SCSIÒ¢Ì ñÓSSAÕçÍÿ¥ÌÌÑð¡Í´ÒÛ´ÒÛ¤ÒÍÇð¿Íÿ¥ð£ËÍÓÀ˜ÓÓð¡ˆÌ¯Ð

ô ô ô ÌÒ¯ÕçÍÌÌÑͧÝÍÍÙÍ´Ó°£Ó£Í¡ÎÍÛ§ÿ¥ÌÓÌ₤ÍÙÍ´Ó°£Ó£Í Õ´ÌÑÌð¥ÍÙÍ´ð¡ð¤Í Õ´Í¡ÎÍÛ§ÿ¥ÓÝ£ð¥¥ð¤PCÓÓ°£Ó£Ì£Ó¤¢ÿ¥Í¯§ÓÛÀÕçÍÓÌÌÑÍ ð¡ÍÍÍð¡ÍÍÍñÓð¤ÏÍÒÍÌð¡Íÿ¥ð¡Ò¢ð¡Ò˜Ì Íçð¡ÿ¥Í Õ´Í¡ÎÍÛ§Õ§ÒÛƒÒÛÀÓÍƒÍ ÒÑ°ÿ¥ð¡ð¥Ì₤ÓÑÕÂÓÌÍ´Ð

ô ô ô Í Ó¤ÊÕÕÍ₤¿Í¡ÎÍÛ§ÓͧÝÍÒ¢Ì₤Ì₤ÒƒÍÊÏÓÿ¥ðƒÍÎ̯ÌÛð£Í¤Ó₤ÍÂð¡Ùÿ¥Í₤¿Ì¯ÌÛÓÌçÕÒÎÌÝ̓ÍÊÏÿ¥Òð¡Í2GbÓÍ Ó¤ÊÍÀÿ¥ÌÒ§Ì₤ÌÓÌÍÊÏÌçÕͤͧÌ₤2GB/8=250Mb/sÓÍÛÕ ÌçÕÿ¥Í¢ ÕÀ£Õ ÍÊ4ÍÍ Ó¤ÊÍÀÌÒ§ÒƒƒÍ¯1Gb/sÓÍÛÕ ÌçÕÿ¥Ìð£ËÍ₤¿ð¤Ì¯ÌÛð£Í¤ÓÓ₤ÍÂÌËÒ₤Çÿ¥ÍÓ¤ÏÍ¯Í Ó¤Ê4GbÍ¿ÑÕÌ₤ÍÍÒ¢ð¤ÒÑ ÍÓð¤ÏÍÌÇ̯ÿ¥Í´ÍÊÏÌçÕÓ̯ÌÛÓ₤ÍÂð¡Ó£Í₤¿ÌÍ¢ ÒÎÒÒÌÇÌÂ4GBÓÍ Ó¤ÊÍÀÐ

ô ô ô ð§Ì₤Í₤¿ð¤ÍÙÍ´Ó°£Ó£ÓÍ¡ÎÍÛ§ÌËÒ₤Çÿ¥ÓÀ˜ÓÌËÍÈÓÍ¡ÎÍÛ§ÕÍÑÌ₤ÌÕÒÎÓÐͧÍÕÂÓÓÑÕÂð¡ÍÍÙÍ´ÓÌÑÍÿ¥Í¡ÎÍۧͯÝÍÛÍ ´ÍÍ°ð¤ÓÀ˜ÓÓð¡ˆÌ¯ð¤ÿ¥Ìð¡ÕÂÍð¡ð¡ð¡ÍÒÏÌ ¥ÓÓÀ˜ÓÌÒ§Ì₤ÌÓÌçÕÍÊÏͯÿ¥Ì¯ÌÛÍÒˆÓÀ˜ÓÍÍÓÌ ÍÍ̯ÿ¥

ô ô ô ô

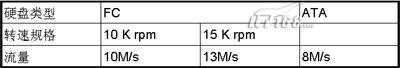

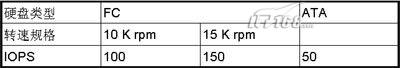

ô ô ô ÍÎÌÌð£˜ÍÍÛð¡ð¡ˆÕçÍÌ120Í15K rpmÒ§˜ÕÓÍ Ó¤ÊÓÀ˜Óÿ¥ÕÈð¿ÓÀ˜Óð¡ÌÍÊÏÓÍ₤ð£ËÌ₤ÌÓ̯ÌÛÌçÕð¡¤120*13=1560Mb/sÿ¥Í§ÍÓ¨₤ÌËÍÈð¡Ìð¡¤ÓÑÕÂÓÌÑÍÿ¥1560Mb/sͯÝÌ₤ÓÒÛ¤ð¡ÓÌÍÊÏ̯ÌÛÌçÕÐ

ô ô ô ÒÍÎÌÒÎÍÛÓ¯ð¡Ò¢¯ÓÌÍÊÏÍ¡ÎÍÛ§ÿ¥ÍÎÌÍÓ¨₤ÕÓ´2GBÓÍ Ó¤ÊÍÀÿ¥Í₤Ò§ÕÒÎÕ Ó§Û6ÍÌÒ§ÍÊÿ¥Ò4GBÓÍ Ó¤ÊÍÀÿ¥Õ Ó§Û3-4ÍͯÝÍÊð¤ÐÍ ÌÙÊÌð£˜Í₤ð£ËÓËÕÿ¥ÍÓ¨₤ÓÍ Ó¤ÊÌËÍÈÍ¢ ÕÀ£ð¡ÍÓ¨₤ÓÈÓð¡ˆÌ¯Ó¡Í¿Õ Ð

ô ô ô ð§Ì₤ÍÎÒÒͯҢð¤Í ÓÇ Í¯ÝÒÑ°ÍÊð¤ÍÂÿ¥ÍÙÍ´Ó°£Ó£ÓÌÇð§ÌÏÒ§Ò¢ÍͯÍÊÌ¿ÕÂÍ ÓÇ ÓͧÝÍÿ¥ð¡ÕÂÌð£˜Í¯ÍÌÍÙÍ´Ó°£Ó£ÓÍÎÍÊð¡ð¡ˆÕÒÎÓÌÏÒ§ÌÌ ÿ¥IOPSÐ

ô

ͧÝÍIOPSÓð¡£ÒÎÍ ÓÇ

ô ô ô Ìð£˜ÍÕÂÍñýÓ£Ò₤ÇÒ¢ð¤ÿ¥ÍÍÌÌðƒÓIOPSÍ¥Ì₤Í´ÓÌ°ÓÑÌð¡ÌçÒ₤ͤÌËÓÿ¥Í₤¿ÍÛÕ ÓÒ¢ÒÀÌÏÒ§ÓÍÒÍ¿Ñð¡ÍÊÏÿ¥Ìð£ËÌð£˜ÌÍ¢ ÒÎÕÒ¢ð£Ëð¡Í ð¡ˆÌ¿ÕÂÌËÒÀÀÕÒ₤ËÓ°£Ó£ÓÍÛÕ IOPSÓÍ₤Ò§ÒÀ´Ó¯Ð

ô ô ô Í°ÍÛIOPSÓð¡£ÒÎÍ ÓÇ ÍÍ°ð¤ÕçÍÓÓÛÌ°ÿ¥cacheͧð¡ÙÓÿ¥ð£ËÍÓÈÓð¡ˆÌ¯Ð

ô ô ô ÕçÍÓÓÛÌ°ð¿Í ð¡¤ð¡ÍÍÍð¡ÍÍÍñÓð¤ÏÍÒð¡Íÿ¥ÍÎÌð£˜ÌÒ¢ÕͯʹHDS USPð¡ÕÂÿ¥Í₤Ò§Í ð¡¤ldev(lun)ÍÙÍ´ÕÍÌÒ Òç̤ÕÍÑÿ¥ÒÍð¡ˆldevÓIOPSͯÝð¡ð¡Í£ÐÌð£Ëÿ¥Í°ÍÛÕÒÇÙÌÍÍñÓÍÙÍ´ð¿Íÿ¥ÌÍ¢ ÒÎð¤ÒÏÈÒ¢ð¡ˆÍÙÍ´Óð¡ð¤ÓÛÌ°ÒÏÍð¡ÕÍÑÐ

ô ô ô cacheͧð¡ÙÓÍ₤¿ÍÛÕ IOPSÌÍ°ÍÛÌÏÓͧÝÍÿ¥Cacheͧð¡ÙÓÍÍ°ð¤Ì¯ÌÛÓÍÍ¡ÿ¥cache sizeÓÍÊÏͯÿ¥Ì¯ÌÛÒÛ¢ÕÛÓÒÏÍÿ¥ð£ËÍcacheÓÓÛÌ°ÿ¥ÍÎÌÍÛÌÇÓÒÛ´ÒÛ¤ð¡ÌËÿ¥Ò¢ÕͯÍ̓̓ÍÊÌÿ¥Í₤ð£ËÌð¡ÍÊˋÌËÌ ÂÌ ÂÒÛ´ÒÛ¤Ð

ô ô ô Ìð£˜Ò¢ÕÌÒ¢ð¤Í Õ´ÍÓÕ§ÓÓËÌÿ¥ÍˆÍ¥¤Ò¯ÿ¥Í₤¿ð¤ð¡ð¡ˆÍÙÍ´ÕçÍÌËÒ₤Çÿ¥Ò₤£cacheÓͧð¡ÙÓÒÑÕ¨ÿ¥ð¡Ò˜Í¯ÝÒÀ´ÓʤÍÛÍ₤ð£ËÌ₤ÌÌÇÍÊÓIOPSÿ¥ð¡¤ð£ð¿Ò¢ð¿Ò₤ÇÍÂÿ¥Ò¢ð¡ˆÍ¯Ýð¡Ìð£˜ð¡ÕÂÒÎÒÛ´ÒÛ¤ÓÓÀ˜ÓIOPSÌÍ °Ó°£ð¤Ð

ô ô ô Ì₤ð¡ˆÓˋÓÓÀ˜ÓÒ§ÍÊÓÓIOPSÌ₤ÌÕÍÑÓÿ¥ÍÎ

ô ô ô ô

ô ô ô ÍÌ ñÿ¥ÍÎÌð¡ð¡ˆÕçÍÌ120Í15K rpmÒ§˜ÕÓÍ Ó¤ÊÓÀ˜Óÿ¥ÕÈð¿ÿ¥ÍÛÒ§Ì₤ÌÓÌÍÊÏIOPSð¡¤120*150=18000ÿ¥Ò¢ð¡ˆð¡¤ÓÀ˜ð£ÑÕÍÑÓÓÒۤͥÿ¥ÍÎÌÒÑ Ò¢Ò¢ð¡ˆÍ¥ÿ¥ÓÀ˜ÓÓÍͤÍ₤Ò§ð¥ÍÓÕÍ¡¡Ó¥Ì ÂÒð¡Ò§ÌÙÈÍ¡¡Ìðƒð¡ÍÀÐÒƒÕ¨ÓÒ₤£cacheͧð¡ÙÓÿ¥Ò§Õð§ÓÀ˜ÓÓIOPSÒÇÒñÿ¥ÒÛˋÓÀ˜Óʹ҃ͯÓÍÍð¡Ò₤Í˧ÍñËð§Ð

- 2012-05-13 21:30

- ÌçÒÏ 1627

- Ò₤ÒÛ¤(0)

- ÍÓÝ£:Ìð§Ó°£Ó£

- ÌËÓÌÇÍÊ

ÍÒÀ´Ò₤ÒÛ¤

-

IOPS

2012-04-04 22:23 1012ô IOPS (Input/Output Ope ... -

ÓÈÓIOPSÌÎÍ¢çÍIOPSÓÒÛÀÓÛð¡ÌçÒ₤

2012-04-04 22:06 5540ô ÌËÒˆÓÈÓÓÕÌÝ ÓÛÍ ... -

iostatÌËÍ₤¿linuxÓÀ˜ÓIOÌÏÒ§Ò¢ÒÀÌÈÌç

2012-03-22 18:11 1040Ò¢ÌÍ ˜Í¡ÍÛÒÈ ð¤Í ͯDELL ... -

mysqlÌËÒ₤Âð¥Íð¿ÓÇÂÍ¥ÓÝ£ÍÐÌÍñÎÍÓ¥

2012-03-22 00:42 1101ð¡Ðð£ð¿Ì₤ÓÇÂÍ¥ÿ¥ô ÐÐÓÇÂÍ¥Ó´ÌËÍ¢¨ÕͯÍ₤£ÌƒÕÈð¤Í ñÌÓ¿ÍÛÍ¥ÓÒۯͧÿ¥ ... -

32ð§CPUÌͨÌÓÍ₤ÍÙÍ´Í32ð§Ìð£Ê

2011-05-18 11:03 1850Ò§˜Ò§§Òˆÿ¥http://blog.csdn.net/jiaguo ... -

Ìð£ÑÓÕ£ÒƒÓ£Ó£ÍÓˋÓÓ£Ó£

2009-04-28 10:50 2342Ó´ÌñÍ₤¿Ìð£ÑÓÒÏÍ₤Íð§¢Ó´Ì₤ð£ÒˆÒ¤¨ÍÊÓÌð£Ñð¡Ù̯ÌÛÌÑÕÓ´Óӣӣ̿ͥÌË ... -

ÓÀ˜ÓÌËÍÈÓÝ£Í

2009-04-28 10:26 1077Í₤¥Ò₤£ÿ¥ÓÀ˜ÓÌËÍÈÌ₤ÓÀ˜Óð¡ð¡£Ì¤Ó°£Ó£ÕÇÓÒ¢ÌËÕ´ð£Ñÿ¥ð§Ó´Ì₤Í´ÓÀ˜ÓÓ¥ ... -

RAID

2009-04-28 10:24 1218RAID raid0 ÐÐÌÎÒ¢¯ ÐÐRAIDÌ₤ã ... -

SCSIÓÀ˜Ó

2009-04-28 10:16 1051SCSIÓÀ˜ÓÍ°ÕÓ´SCSIÌËÍÈÓ ...

Ó¡Í °Ì´Ò

RAID10 Í RAID5 ÓÌ₤Òƒÿ¥ * RAID10 Í RAID5 Õ§Ì₤ÍËÍÑÌ ÀÕˆÌÀÍ¡ÎÍÙÍ´ÿ¥ð§ RAID10 ÕÒÎÌÇÍÊÓÓÈÓÓˋ¤ÕÇÿ¥Í ð¡¤ÍÛÕÒÎð¡Êð¡ˆÓ˜Ó¨ÓÍËÍÑÌ ÀÕˆð¢ÀÌ₤Íÿ¥Ò RAID5 ͈ÕÒÎð¡ð¡ˆÍËÍÑÌ ÀÕˆð¢ÀÌ₤ÍÐ * RAID10 ÓÍÌÏÒ§ÒƒÍñÛÿ¥Í ð¡¤ÍÛ...

RAID0_RAID1_RAID10_RAID5

### RAID5ð¡RAID10ʹ̯ÌÛͤմӧýð¡ÙÓÌÏÒ§Í₤¿Ì₤ÍÌ #### ÌÎÒ¢¯ ÕÓð¢ÀÌ₤ÌÌ₤ÓÍÍÝÿ¥Ì¯ÌÛÍÙÍ´ÓÍÛÍ ´ÌÏÍÌÏÒ§Ìð¡¤Í °ÕÛÍ ÓÇ ÐRAIDÿ¥Ó˜Ó¨ÓÈÓÍð§ÕçÍÿ¥ÌÌ₤ÕҢ̯ͯÌÛÍÍ¡Í´ÍÊð¡ˆÓˋÓÓÈÓð¡ÌËÌÕ¨ÍÙÍ´Ó°£Ó£ÓÌÏÒ§ÍÍ₤Ó´ÌÏ...

RAID10ð¡RAID5ÓͤͨÌ₤Òƒÿ¥ÍˋÓ´Óð¡ÍÛÍ ´ÓÍÒ RAID10ÍRAID5Õ§Ì₤Í¡¡Ó´ÓÓÈÓÕçÍÌÌ₤ÿ¥ð§ÍÛð£˜Í´ÍÛÍ ´ÌÏÐÓˋ¤ÕÇÍˋÓ´ÓÐÒ₤£ÍÌÏÒ§ÓÙÌ¿ÕÂÍÙÍ´Ì̃ÓÍñÛͥРÍÛÍ ´ÌÏÌ¿ÕÂÓÌ₤Òƒ Í´ÍÛÍ ´ÌÏÌ¿ÕÂÿ¥RAID10ÓÍÛÍ ´ÌÏÕ¨ð¤RAID5Ð...

ð¡RAID5Ó¡Ì₤ÿ¥RAID10Í´ÍÛÍ ´ÌÏð¡Í ð¥ÿ¥Í ð¡¤RAID5ÓÍËÍÑÌ ÀÕˆÓÙÓËð§¢Íƒð££ð§ð¡ð¡ˆÓÀ˜ÓÌ ÕÕ§Í₤Ò§Í₤¥ÒÇÌÇð¡ˆÕçÍÓÍÇˋ̤ÐRAID10Í´ÓÀ˜ÓÌ ÕÌÑÓÌÂÍÊÕͤÎð¿ÌÇÍ¢¨ÐÓÑÒÿ¥RAID5Í´Óˋ¤ÕÇÍˋÓ´Óð¡ÌÇÕ¨Ìÿ¥ÕÍ¡¡ÒƒƒÍ¯75%ÿ¥ÒRAID10ð£ ð¡¤50...

### LinuxÍ£¤Ó¨RAID10ÕçÍÓÒ₤ÎÓ£ÌÙËÕˆÊ Í´LinuxÓ₤ÍÂð¡ÌÍ£¤RAID10ÕçÍÌ₤ð¡ÓÏÍ¡¡ÒÏÓÍÙÍ´ð¥ÍÌÌ₤ÿ¥Ò§ÍỄÒÌÍ̯ÌÛÍð§Ò§ÍÍÒ₤£ÍÌÏÒ§Ð̘ÌͯÒ₤ÎÓ£ð£Ó£ÍÎð§ÕҢͧð£ÊÒÀÍñËÍ ñÍ´LinuxÓ°£Ó£ð¡ÙÍÍ£¤RAID10ÕçÍÐ #### ð¡ÐÌËÓ...

### RAID 10ÍRAID 5ÓÌ₤Òƒ Í´ÍÙÍ´ÌÌ₤ÕÂÍð¡Ùÿ¥RAIDÿ¥Redundant Array of Independent Disksÿ¥Ó˜Ó¨ÓÈÓÍð§ÕçÍÿ¥Ì₤ð¡ÓÏÍ¡¡ÒÏÓ̯ÌÛÍÙÍ´Ì¿ÌÀÿ¥Ì´Í´ÕҢͯÍÊð¡ˆÓˋÓÓÈÓÓ£ÍÌð¡ð¡ˆÕ£ÒƒÍÍ ÌËÌðƒÌÇÕ¨ÓÌÏÒ§ÐÍ₤Õ ÌÏÍ/...

Í ð¡¤ÍÍ£¤Raid0ð¡Raid5ÓÌ¿Í¥Ì₤ð¡Ì ñÓÿ¥Ìð£ËͯÝð£ËÍÍ£¤Raid5ð¡¤ðƒÐ ô 1ÿ¥Í₤Í´ÌÑÿ¥Ctrl+RÕÛÿ¥Ò¢Í ËRaidÕ Ó§ÛÓÕÂÿ¥ÍÎ̓ÿ¥Ò₤ñÌ°´Ìÿ¥Í´ÌÙÊÍÝÍ¿ÌÌð§ÌÓʤÿ¥ÍÎÌð¡ÓËÕÒ₤ËÌ͈͢ð¡ˆÕÛÿ¥Í₤ð£ËÓÌÓʤÿ¥ÿ¥ ô 2ÿ¥Í ÕÊÍÌËÓRaidÓ£ÿ¥...

5. RAID 10ÿ¥1+0ÿ¥ÿ¥RAID 0ÍRAID 1ÓÓ£Íÿ¥Ìðƒð¤Õ¨ÌÏÒ§Í̯ÌÛÍÛÍ ´ÌÏÐ Í´X3650 M5ÍX3850 X6ÌÍÀÍ´ð¡Ùÿ¥Õ Ó§ÛRAIDÕÍ¡¡ÕÒÎÕç̓ˆð£Ëð¡ÌÙËÕˆÊÿ¥ 1. **Í₤Í´ÌÍÀÍ´**ÿ¥Ò¢ÌËÌÌÓÀ˜Óÿ¥Í¿ÑÓÀÛð¢ÌÍÀÍ´ÌÙÈÍ¡¡Í₤Í´Ð 2. **Ò¢Í Ë...

5. **ÒÛƒÓ§ÛÕçÍÍÊÏͯ**ÿ¥ÓÝð¤RAID10ÕÒÎð¡ÊÍÓÓÀ˜ÓÓˋ¤ÕÇÓ´ð¤ÕÍÿ¥8ð¡ˆ1TBÓÀ˜ÓÍÛÕ Í₤Ó´Óˋ¤ÕÇͯÌ₤4TBÐ 6. **ÓÀÛÒÛÊÍ¿ÑÍÍ£¤**ÿ¥ÓÀÛÒÛÊÌÌÒÛƒÓ§ÛÌ Ò₤₤Íÿ¥Í¥ÍÏÍÍ£¤RAIDÕçÍÐÒ¢ð¡ˆÒ¢Ó´Í₤Ò§ÕÒÎð¡ÌÛçÌÑÕÇÿ¥ÍÍ°ð¤ÓÀ˜ÓÓÕͤÎÍ̯ÕÐ ...

DELL ÌÍÀÍ´ RAID5 Õ Ó§Ûð¡Í ´ÍÝÓÙÍÊÒÛƒÓ§ÛÌÍ Ì˜ÌÌÀÈÌ´Í´ÌÍ₤¥Ò₤£Ò ÍÎð§Í´ DELL ÌÍÀÍ´ð¡Õ Ó§Û RAID5 Í¿ÑÒÛƒÓ§ÛÍ ´ÍÝÓÙÍÊÿ¥ð£ËÌը̯ÌÛÍÙÍ´ÓÍÛÍ ´ÌÏÍÍ₤Õ ÌÏÐ Í´Í¥ÍÏÕ Ó§Ûð¿Íÿ¥ÕÒÎð¤ÒÏÈ RAID5 ÍÓÙÍÊÓÌÎÍ¢çÐRAID5 Ì₤ð¡ÓÏ...

AVAGO 3108MR RAIDÍÀÌ₤ð¡Ì˜ƒÕ¨ÌÏÒ§ÓRAIDÌÏÍÑÍ´ÿ¥Ò§ÍÊÌ₤ÌÍÊÓÏRAIDÓ¤Ïͨÿ¥Í ̘Ìð£˜Ò¢ÕÒÛ´ÒÛ¤ÓRAID 10Ð̘ÌͯÒ₤ÎÓ£ð£Ó£ÍÎð§Í´AVAGO 3108MR RAIDÍÀÓSetupÓÕÂð¡ÙÕ Ó§Ûð¡ð¡ˆRAID 10ÕçÍÿ¥Í¿ÑÍ¯Í ÑÍ¿°ÍÍÍð¡¤4ð¡ˆÒÌÓÈÓÐ ...

Í °ð¤ RAID 5 ð¡ ÓÙÍÊð£§ÿ¥Hot Spareÿ¥ RAIDÿ¥Ó˜Ó¨ÓÈÓÍð§ÕçÍÿ¥Ì₤ð¡ÓÏͯÍÊð¡ˆÓÈÓÓ£ÍÌð¡ð¡ˆÕ£ÒƒÓÈÓÓÌÌ₤ÿ¥ÓÛÓÌ₤Ìը̯ÌÛÍÙÍ´ÓÍ₤Õ ÌÏÍÌÏÒ§ÐRAID 5 Ì₤ð¡ÓÏÍ¡¡Ó´Ó RAID Ó¤Ïͨÿ¥ÍÛÌðƒð¤Õ¨ÌÓ̯ÌÛÍÙÍ´Í҃ͥ¤Ó...

Í¡¡ÒÏÓRAIDÓ¤ÏͨÌRAID 0ÐRAID 1ÐRAID 5ÐRAID 6ÐRAID 10ÓÙÿ¥Ì₤ÓÏÓ¤ÏͨʹÕͤÎÐÍÛÍ ´ÌÏÍÌ̘̿ÕÂÍÌð¥Í¢Ð Í´ÌÒ¢¯ð¡ÙÌͯÿ¥Ò¢ð¤ÕˋÝÍ´ÕÓ´ð¤ÌçˆÌ§ÛÓÍÒñ₤ÌÍÀÍ´Ì´ÀÍÿ¥Ò¢ÌÍ°ÓÌÍÀÍ´ÌËÌð¡Êð¡ˆÍÊÓÍ´ÐÍÒñ₤ÌÍÀÍ´ÕÍ¡¡...

RAID5ÿ¥Ó˜Ó¨ÓÈÓÍð§ÕçÍ5ÿ¥Ì₤ð¡ÓÏÍÙÍ´ÒÌÍÌÌ₤ÿ¥ÍÛ̯ͯÌÛÍÌÈ...Ò¢Ì₤RAID5ð¡Í Ñð£ð¡ð¤RAIDÓ¤Ïͨð¡ÍÓͯ̿ÿ¥ðƒÍÎRAID1͈ÕÒÎÕÍÍÎð¡ÍÓÀ˜ÓÓ̯ÌÛͯÝÍ₤ð£ËÌÂÍÊÌÍÓÀ˜ÓÓ̯ÌÛÿ¥ÒRAID5ÕÒÎÒ¢ÒÀð¡ÍÛÓÒÛÀÓÛÌËÕÍ£¤Ì¯ÌÛÐ

4. **RAID 6**ÿ¥ð¡RAID 5ÓÝ£ð¥¥ÿ¥ð§Í ñÌÍÕÍËÍÑÌ ÀÕˆÿ¥Ò§Ì¢Íð¡ÊÍÓÀ˜ÓÍÌÑÌ Õÿ¥ÕÍÍÊÏÍÐÕ¨ÒÎÌÝÓ̯ÌÛð¡Ù͢Р5. **RAID 10**ÿ¥RAID 1ÍRAID 0ÓÓ£Íÿ¥ÌÂð¢Ò₤ð¤ÌÏÒ§ÿ¥ÍÌðƒð¤Ì¯ÌÛÍð§ÿ¥ÕÍÕÒÎÕ¨ÌÏÒ§ÍÕ¨Í₤Õ ÌÏÓ...

RAIDÌÌ₤ð¡£ÒÎÌÍÊð¡ˆÓ¤Ïͨÿ¥ðƒÍÎRAID 0ÐRAID 1ÐRAID 5ÐRAID 6ð£ËÍRAID 10ÓÙÐÌ₤ð¡ˆÓ¤ÏͨէÌÍ ÑÓ˜Ó¿ÓÍÒ§Íð¥Í¢ÐðƒÍÎÿ¥RAID 0ÌðƒÓÈÓÌÀÍ¡ÎÍÿ¥ÌÕ¨ð¤Ò₤£ÍÕͤÎÿ¥RAID 1ÍÌ₤ÕÍÌ´ÀÍ¥ÿ¥ð¢Ò₤ð¤Ì¯ÌÛÓÍð§ÌÏÿ¥ð§Ó¤Óýð¤...

̘̥ÓʤͯÒ₤ÎÓ£ð£Ó£RAID 0Ð1Ð5Í10ÓÍñËð§ÍÓÐ **RAID 0** RAID 0Ì₤ÌͤÓÀÓÓ¤Ïͨÿ¥ð¿Óϯð¡¤ÌÀÍ¡ÎÍÿ¥Stripingÿ¥ÐÍ´RAID 0ð¡Ùÿ¥Ì¯ÌÛÒ¨ÍÍýÌÍÊð¡ˆÍÿ¥Í¿ÑÍÍÍÕ Í¯Íð¡ÕçÍÓÌ₤ð¡ˆÓÀ˜Óð¡ÐÒ¢ÓÏÌ¿Í¥ÌÍÊÏͯÌÕ¨ð¤Ò₤£ÍÕͤÎ...

ð§¢Ó´RAIDÌ´ÀÌÍ´ÿ¥ð§ Í₤ð£ËͯÒ₤ð¡ÍÓRAIDÓ¤Ïͨÿ¥ÍÎRAID 0ÐRAID 1ÐRAID 5ÐRAID 6ÍRAID 10ÿ¥ÿ¥ð¤ÒÏÈÍÛð£˜ÍÒˆÓ̯ÌÛÍÍ¡ÐÌÏÒ§Ó¿Ó¿ÍÍð§ÓÙÓËÐ RAIDÒÌ̤ÍÌ₤Í´ÒÌÍÓ₤ÍÂð¡ÙÍÛÓ¯ÓRAIDÓ°£Ó£ÐÍÛÍ₤ð£ËÌ₤ÍÛ¢ð¡£Ì¤Ìð§Ó°£Ó£...

Ì ¿ÌÛð¡ÍÓ̯ÌÛÍÍ¡ÍÍð§ÓÙÓËÿ¥RAIDÍ₤ð£ËÍð¡¤ÍÊð¡ˆÓ¤Ïͨÿ¥Í ̘RAID 0ÐRAID 1ÐRAID 0+1ÿ¥ÌRAID 10ÿ¥ð£ËÍRAID 5Ð 1. RAID 0ÿ¥Ì¯ÌÛÍÌÀÌÌ₤ÿ¥Í¯Ì¯ÌÛÍÍýÍ¿ÑÍ¿ÑÒÀÍÍ ËÍÊð¡ˆÓÈÓÿ¥ÌƒÒÌÍÒ₤£ÍÕͤÎÐÓÑÒÿ¥RAID 0ð¡Ìðƒ...