- وµڈ览: 117648 و¬،

- و€§هˆ«:

- و¥è‡ھ: هŒ—ن؛¬

-

社هŒ؛版ه—

- وˆ‘çڑ„资讯 ( 0)

- وˆ‘çڑ„è®؛ه› ( 0)

- وˆ‘çڑ„é—®ç” ( 0)

هکو،£هˆ†ç±»

- 2020-02 ( 1)

- 2020-01 ( 45)

- 2019-12 ( 61)

- و›´ه¤ڑهکو،£...

وœ€و–°è¯„è®؛

é¥؟ن؛†ن¹ˆن؛¤ن»کن¸ه؟ƒè¯è¨€و ˆè½¬ه‹و€»ç»“

> ه‰چ言ï¼ڑ

> وœ¬و–‡ن»‹ç»چن؛†é¥؟ن؛†ن¹ˆن؛¤ن»کن¸ه؟ƒç”±pythonè¯è¨€و ˆè½¬وچ¢هˆ°javaè¯è¨€و ˆه¤§è‡´è؟‡ç¨‹,ن¸€و¥وک¯ه¯¹ه‰چو®µو—¶é—´çڑ„ه·¥ن½œهپڑن¸‹و€»ç»“,هڈ¦ه¤–ن¹ںوک¯وƒ³é€ڑè؟‡و¤و¬،و€»ç»“ن¸؛ه…¶ن»–ه؛”用وœچهٹ،转ه‹وڈگن¾›ن؛›ه€ں鉴م€‚ه†™çڑ„ن¸چه¥½ï¼Œو¬¢è؟ژو؟ç –م€‚

### 背و™¯

é¥؟ن؛†ن¹ˆه¹¶ه…¥éک؟里集ه›¢,ن¸؛ن؛†èƒ½é«کو•ˆن¸ژ集ه›¢ه†…部系ç»ںهچڈهگŒه¯¹وژ¥,هگŒو—¶و–¹ن¾؟هˆ©ç”¨é›†ه›¢ن¼کهٹ؟وٹ€وœ¯èµ„و؛گ,و›´ه¥½çڑ„èچه…¥éک؟里集ه›¢وٹ€وœ¯ç”ںو€پهœˆ,é¥؟ن؛†ن¹ˆن؛¤وک“ن¸هڈ°هœ¨ن¸ٹهچٹه¹´هگ¯هٹ¨ن؛†ن؛¤وک“领هںںçڑ„ه››ه¤§ه؛”用è¯è¨€و ˆè½¬ه‹é،¹ç›®ï¼Œن¸؛éک؟里集ه›¢وœ¬هœ°ç”ںو´»وœچهٹ،ه¹³هڈ°و‰“ه¥½وٹ€وœ¯ه¹³هڈ°هں؛ç،€هپڑه‡†ه¤‡م€‚هڈ¦ه¤–,éڑڈç€ن¸ڑهٹ،é‡ڈçڑ„و؟€ه¢,é¥؟ن؛†ن¹ˆه¹³هڈ°و”¯وŒپçڑ„ه“پç±»ن¸چن»…ن»…وک¯وœ€هˆçڑ„ه¤–هچ–هچ•ه“پ,و•´ن¸ھن؛¤وک“ن¸هڈ°ن¹ں需è¦پن¸€و¬،相ه¯¹ه¤§çڑ„é‡چو„و¥ه؟«é€ںه؛”ه¯¹ه¤چو‚ه¤ڑهڈکçڑ„ن¸ڑهٹ،需و±‚م€‚而وœ¬و–‡ن¸çڑ„ن؛¤ن»کن¸ه؟ƒهچ³وک¯é¥؟ن؛†ن¹ˆن؛¤وک“领هںںه››ه¤§ه؛”用ن¹‹ن¸€م€‚

### ه‡†ه¤‡

هœ¨ه¼€ه±•ç›¸ه…³ه·¥ن½œن¹‹ه‰چ,首ه…ˆه؟…é،»ه¾—و¸…و¥ڑوˆ‘ن»¬وک¯è¦په°†ن¸€ن¸ھç³»ç»ںن»ژن»€ن¹ˆو ·هڈکوˆگن»€ن¹ˆو ·ï¼Œو–°çڑ„ç³»ç»ں相较è€پçڑ„ç³»ç»ںهœ¨ه“ھن؛›و–¹é¢هپڑçڑ„و›´ه¥½ï¼ŒهگŒو—¶ه؟…é،»ن؟è¯پو–°è€پç³»ç»ںçڑ„و— ç¼هˆ‡وچ¢ï¼Œهپڑهˆ°ن¸ڑهٹ،و— و„ںن¸چه½±ه“چن؛¤وک“ç³»ç»ںçڑ„稳ه®ڑو€§م€‚

#### ç³»ç»ںن»·ه€¼

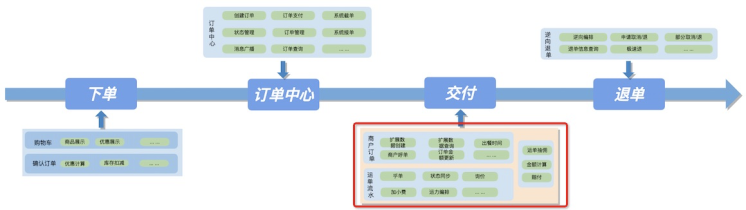

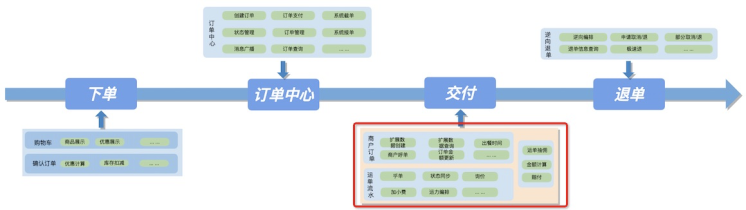

ه¤–هچ–订هچ•çڑ„ن¸ڑهٹ،特点وک¯é‡چن؛¤وک“,c端用وˆ·ن»ژن¸‹هچ•é€‰é¤گهˆ°éھ‘و‰‹ه®Œوˆگé¤گه“پن؛¤ن»کè؟‡ç¨‹ï¼Œç›®ه‰چه¤§éƒ¨هˆ†éƒ½èƒ½هœ¨هچٹه°ڈو—¶ه·¦هڈ³ه®Œوˆگ,ه¯¹هچ³و—¶é…چé€په®و—¶و€§è¦پو±‚较é«کم€‚و•´ن¸ھ订هچ•ن؛¤وک“è؟‡ç¨‹ه¤§è‡´هˆ’هˆ†ن¸؛:1.و·»هٹ è´ç‰©è½¦ç،®è®¤è®¢هچ•ï¼Œ2.订هچ•ç”ںوˆگهڈٹ订هچ•و”¯ن»ک,3.وژ¥هچ•هڈٹ订هچ•ن؛¤ن»ک,4.هڈ¯èƒ½çڑ„ه”®هگژ退هچ•م€‚而è¦پو›´ه¥½çڑ„وœچهٹ،用وˆ·ï¼Œه¯¹ه››ن¸ھç³»ç»ں稳ه®ڑçڑ„هچڈهگŒèƒ½هٹ›وڈگه‡؛ه¾ˆé«کçڑ„è¦پو±‚م€‚

ه¦‚ه‰چو–‡و‰€è؟°ï¼Œوˆ‘ن»¬çں¥éپ“ه±¥ç؛¦çژ¯èٹ‚ه¯¹ن؛¤وک“订هچ•çڑ„ن»·ه€¼وک¯ن»€ن¹ˆï¼Œهچ³وک¯ه°†ه¤–هچ–订هچ•ه¯¹ه؛”çڑ„é¤گه“پن؛¤ن»کهˆ°ç”¨وˆ·و‰‹ن¸ï¼Œوٹ€وœ¯ه±‚é¢ن¸ٹو¥è®²ï¼Œن؛¤ن»که¯¹ن؛¤وک“订هچ•ه±ڈ蔽ن؛†ن¸€هˆ‡ه…¶ن»–ه±¥ç؛¦ç»†èٹ‚,ن½؟订هچ•و›´ن¸“و³¨è®¢هچ•é¢†هںںن¸ڑهٹ،م€‚

#### ه†…و ¸هˆ†وگ

وژ¥ن¸‹و¥ï¼Œوˆ‘ن»¬ه†چè؟›ن¸€و¥è¯¦ç»†çڑ„ه‰–وگن¸‹è½¬ه‹ه‰چن؛¤ن»کç³»ç»ںو‰€و‰؟è½½çڑ„هٹں能م€‚

آ آ

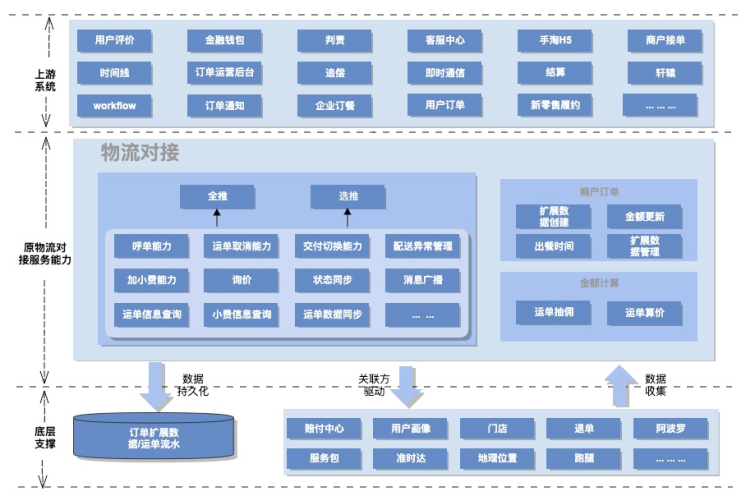

ه¦‚ن¸ٹه›¾و‰€ç¤؛,هژںن؛¤ن»که±¥ç؛¦é¢†هںںن¸هŒ…هگ«ن؛†ن¸‰ن¸ھ较ه¤§و؟ه—ï¼ڑ

* 1.订هچ•ه¯¹وژ¥è؟گهٹ›ç؛؟و¨،ه—

* 2.ه•†وˆ·è®¢هچ•ن؟،وپ¯و¨،ه—

* 3.部هˆ†é‡‘é¢è®،ç®—و¨،ه—

هڈ¯ن»¥çœ‹ه‡؛هژںç³»ç»ںو‰€و‰؟è½½هٹں能ه¹¶éçœںو£èپڑ焦هœ¨è®¢هچ•ن؛¤ن»کè؟‡ç¨‹م€‚و€ژن¹ˆهٹï¼ں转ه‹é‡چو„وک¯ن¸ھه¥‘وœ؛م€‚ه•†وˆ·è®¢هچ•ه›ه½’هˆ°è®¢هچ•ï¼Œé‡‘é¢è®،ç®—ن¸‹و²‰è‡³ç»“算,è؟™ن¸¤éƒ¨هˆ†çڑ„相ه…³è½¬ه‹é‡چو„è؟™é‡Œن¸چه†چèµکè؟°ï¼Œç›¸ه…³éƒ¨هˆ†ن¹ںه·²ç”±ه…„ه¼ںه›¢éکںه®Œوˆگم€‚ه…¶ه®هˆ°è؟™é‡Œن؛¤ن»که±¥ç؛¦ه؛”该ه…³و³¨çڑ„ه·²ç»ڈه¾ˆوکژوک¾ï¼ڑوٹٹه¤–هچ–订هچ•ç»™è؟گهٹ›ç؛؟,ن½؟ه…¶ه®Œوˆگن؛¤ن»که±¥ç؛¦م€‚

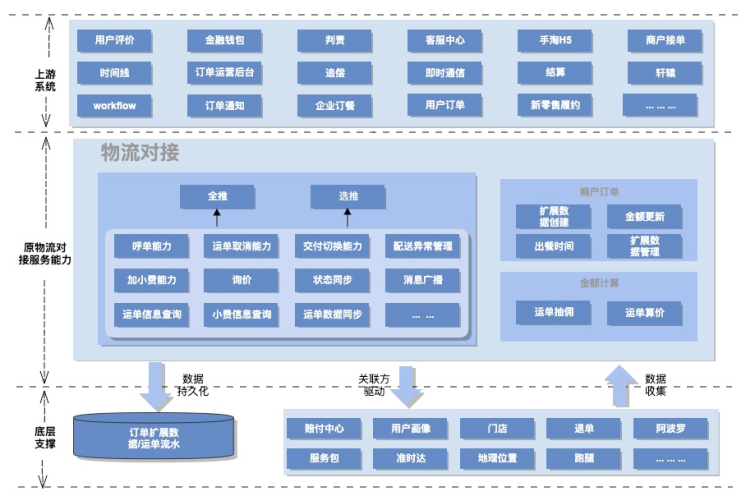

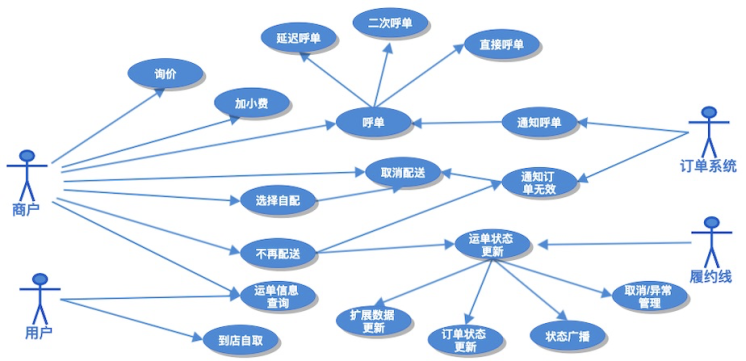

هں؛ن؛ژهˆڑو‰چوڈگهڈ–هگژçڑ„ن؛¤ن»که±¥ç؛¦و ¸ه؟ƒé¢†هںں,وˆ‘ن»¬ه¯¹ن¸»è¦پçڑ„هœ؛و™¯ç”¨ن¾‹è؟›è،Œن؛†è¯¦ç»†çڑ„و¢³çگ†م€‚ه¦‚ن¸‹ه›¾و‰€ç¤؛,هڈ¯ن»¥çœ‹هˆ°ï¼ڑ

* هڈ‚ن¸ژن؛¤ن»کè؟‡ç¨‹çڑ„ن¸»è¦پ角色وœ‰ه››ن¸ھ:

* 1.ه•†وˆ·

* 2.订هچ•

* 3.ه±¥ç؛¦è؟گهٹ›ç؛؟

* 4.用وˆ·

* ن؛¤ن»کوڈگن¾›çڑ„ن¸»è¦پو”¯و’‘能هٹ›وœ‰ï¼ڑ

* 1.ن¹ژهچ•ن؛¤ن»ک能هٹ›

* 2.è؟گهچ•çٹ¶و€پهگŒو¥èƒ½هٹ›

* 3.è؟گهچ•ن؟،وپ¯é€ڈه‡؛能هٹ›

* 4.ه±¥ç؛¦و–¹ه¼ڈهˆ‡وچ¢èƒ½هٹ›

* 5.è؟گهچ•çٹ¶و€په¹؟و’触达ن¸‹و¸¸èƒ½هٹ›ç‰م€‚

* 部هˆ†è؟گهچ•هڈ–و¶ˆوˆ–ه¼‚ه¸¸ç®،çگ†م€‚

ç³»ç»ںو ¸ه؟ƒç”¨ن¾‹هˆ†وگه¦‚ن¸‹ه›¾و‰€ç¤؛:

و›´è¯¦ç»†çڑ„ç³»ç»ں用ن¾‹و¢³çگ†وˆ–ç³»ç»ںن¸ٹن¸‹و¸¸ن؛¤ن؛’و—¶ه؛ڈè؟™é‡Œن¸چه†چن¸€ن¸€هˆ—ن¸¾ï¼Œéœ€è¦پ说وکژن¸€ç‚¹ï¼Œه½“ه¤§وµپé‡ڈç³»ç»ں转ه‹éپ‡هˆ°é‡چو„,è¦پوƒ³èµ°çڑ„ه¤ںè؟œه¤ں稳,ه‰چوœںçڑ„ن»”ç»†è°ƒç ”ه·¥ن½œهڈٹهٹں能ه¯¹é½گè؟‡ç¨‹éه¸¸é‡چè¦پم€‚特هˆ«وک¯ç”ںن؛§çژ¯ه¢ƒه·²ç»ڈè·‘ن؛†ه¥½ه‡ ه¹´و ¸ه؟ƒهٹں能系ç»ں,ه®é™…ن¸ڑهٹ،وƒ…ه†µé”™ç»¼ه¤چو‚م€‚ن¾‹ه¦‚è¦پ转ه‹é‡چو„ç³»ç»ںوژ¥هڈ£èƒ½هٹ›ï¼Œوژ¥هڈ£هگ«ن¹‰ï¼Œهœ؛و™¯ه؟…é،»éƒ½è¦پ详细وژŒوڈ،م€‚

### 设è®،

至و¤ï¼Œوˆ‘ن»¬çڑ„ç›®و ‡ه·²ç»ڈه¾ˆوکژç،®:1.è¯è¨€و ˆè½¬ه‹ï¼Œ2.è؟‡ç¨‹ن¸è¦په°†ن¸چه±ن؛ژن؛¤ن»کçڑ„ن¸œè¥؟ن»ژهژںç³»ç»ںن¸هˆ†ç¦»ه‡؛هژ»ï¼Œن½؟ه¾—ن؛¤ن»ک领هںںو›´ه¹²ه‡€م€‚结هگˆن؛¤ن»کوœھو¥هڈ¯èƒ½çڑ„هڈ‘ه±•و–¹هگ‘,ه…¶ن¸ن؛¤ن»ک能هٹ›هڈ¯ه¤چ用çڑ„,ه±¥ç؛¦è؟گهٹ›ç؛؟هڈ¯و‰©ه±•çڑ„م€‚è؟™ه¯¹و•´ن¸ھن؛¤ن»کهڈ¯ه؟«é€ںè؟ن»£ه¯¹وژ¥وڈگه‡؛ن؛†و›´é«کè¦پو±‚م€‚هڈ¦ه¤–,وˆ‘ن»¬ن¹ںهœ¨é¢†هںںه»؛و¨،设è®،و€وƒ³وŒ‡ه¯¼ن¸‹هپڑن؛†ن؛›ه®è·µه°è¯•ï¼Œن؛ژوک¯وœ‰ن؛†ن»¥ن¸‹و،†و¶ç»“و„م€‚

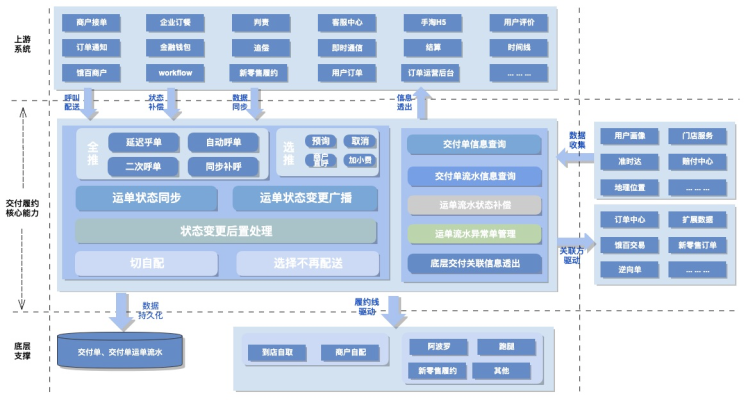

#### ç³»ç»ں设è®،

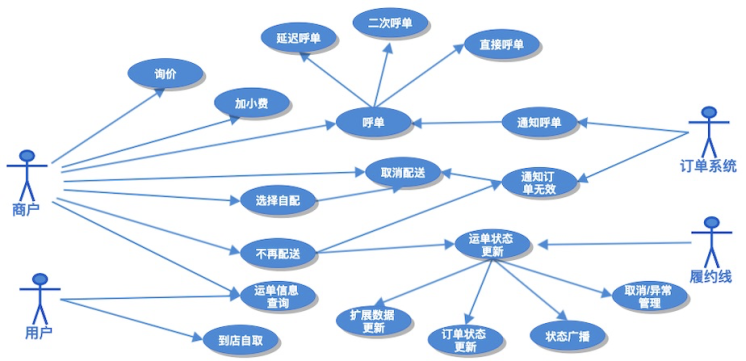

转ه‹وک¯وٹٹpythonو–¹è¨€è½¬وچ¢هˆ°javaو–¹è¨€ï¼Œن؛¤ن»کç³»ç»ںو ¸ه؟ƒèƒ½هٹ›ن¸چن¼ڑوœ‰هڈکهŒ–م€‚能هٹ›çڑ„ه¤چ用وک¯é€ڑè؟‡وژ¥هڈ£ç»´ه؛¦çڑ„وٹ½è±،èپڑهگˆن؛§ç”ں,ه±¥ç؛¦è؟گهٹ›ç؛؟能هٹ›هڈ¯و‰©ه±•é€ڑè؟‡هˆ©ç”¨ن¸ڑهٹ،و،†و¶و‰©ه±•ç‚¹ç‰¹و€§و»،足م€‚و‹†هˆ†هگژçڑ„ن¸ڑهٹ،و،†و¶ه؛”ه¦‚ن¸‹ه›¾و‰€ç¤؛ï¼ڑ

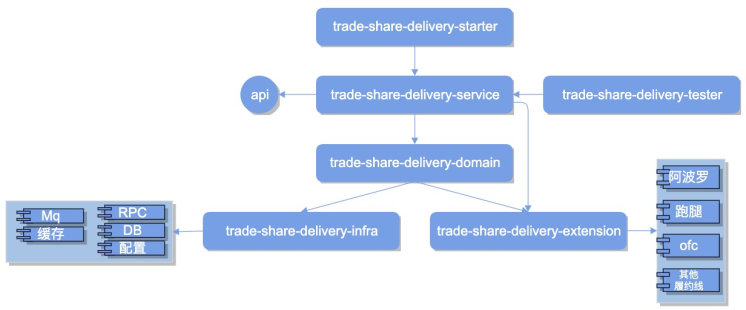

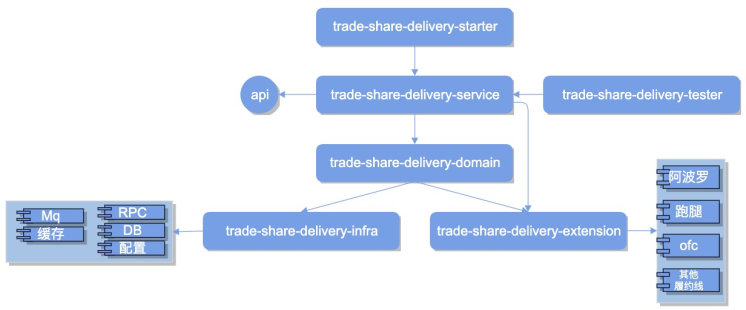

#### ç³»ç»ںو¶و„

ن¸ڑهٹ،و،†و¶ç»“هگˆه½“ه‰چé¥؟هœ؛هں؛ç،€ç»„ن»¶و”¯وŒپوˆ‘ن»¬ن¸چéڑ¾ç»™ه‡؛ن»¥ن¸‹ç³»ç»ںه†…部و¨،ه—هˆ’هˆ†ï¼ڑ

简هچ•ه¯¹هگ„组وˆگو¨،ه—هپڑ简è¦پ说وکژï¼ڑ

* apiï¼ڑه¤„ن؛ژن¸ڑهٹ،و،†و¶ن¸ن¸ٹو¸¸ç³»ç»ںوژ¥ه…¥ه±‚,ه¯¹ه¤–وڑ´و¼ڈه¥‘ç؛¦ه±ڈ蔽细èٹ‚,ه¯¹ه†…ه®ڑن¹‰ç³»ç»ں能هٹ›م€‚

* starterï¼ڑهگ¯هٹ¨é،¹ç›®

* serviceï¼ڑrpcوœچهٹ،وڑ´و¼ڈ

* domainï¼ڑو ¸ه؟ƒن¸ڑهٹ،能هٹ›ه®çژ°ï¼Œèپڑهگˆه±‚

* infraï¼ڑهں؛ç،€و•°وچ®و”¯و’‘能هٹ›ه±‚

* extensionï¼ڑه±¥ç؛¦èƒ½هٹ›و‰©ه±•ه±‚

* testerï¼ڑهچ•ه…ƒوµ‹è¯•هŒ…

هˆ°و¤ï¼Œوˆ‘ن»¬هڈ¯ن»¥وŒ‰ç…§è®¾è®،ن¸ژو—¢ه®ڑçڑ„è®،هˆ’و’¸ن»£ç پن؛†م€‚

> ه—¯ï¼Œن»£ç پو’¸ه®Œن؛†وµ‹ه®Œن؛†ï¼Œن»ژè°ƒç ”هˆ°ه¼€هڈ‘ه®Œوˆگهژ†و—¶ن¸¤ن¸ھهچٹوœˆï¼Œن»£ç پن»“ه؛“و€»è،Œو•°ç؛¦4.7wè،Œï¼Œوڈگن؛¤1000و¬،ه·¦هڈ³ï¼Œه®Œوˆگ63ن¸ھوژ¥هڈ£+16ن¸ھو¶ˆوپ¯و¶ˆè´¹ه…¥هڈ£è½¬ه‹è؟پ移,ه…±è®،وµ‹ه‡؛117+bug,وœںé—´وœ‰ه–œوœ‰ه؟§ï¼Œه¥‹وˆکن¸¤ç‚¹ه¤ڑوک¯ه¸¸و€پم€‚èپŒن¸ڑç”ںو¶¯ن¸وµ“é‡چçڑ„ن¸€ç¬”م€‚و¤و—¶ه°¤è®°èµ·ن¸ژ超ه“¥@邹超ه‘¨وœ«ن»£çگ†èپ”è°ƒن؛ژهŒ—14و¥¼ه°ڈ黑ه±‹ن¹‹ç•”,ه’Œوکژé¾™@ه¼ وکژé¾™ه¹¶è‚©ن½œوˆکه¯¹وژ¥وœچهٹ،وژ¥هڈ£ï¼Œè؟کوœ‰و™“و³¢@ن؟و™“و³¢ه‡Œو™¨ن¸€هگŒهژ‹وµ‹è§‚ه¯ںو€»ç»“é—®é¢ک第ن؛Œه¤©هˆ†وگهڈچ馈وڈگهچ‡ن¼کهŒ–,ه½“然è؟کوœ‰و°ه“¥@و±¤è‰¯و°çڑ„用ن¾‹è®¾è®،ه…¨é¢ن¸چه¤±ç»†èٹ‚م€په¯¹bugه¸¸ه¸¸ç©¶ه…¶و ¹وœ¬ï¼Œه¯¹ن»£ç پreview逻辑و ¸ه¯¹ن¸€ن¸ن¸چè‹ںوکژه¯ں秋و¯«م€‚ه‡،و¤ç§چç§چ,هژ†هژ†هœ¨ç›®م€‚ن¸€èµ·èµ°و¥ï¼Œçœںه؟ƒو„ںè°¢م€‚

> آ آ آ آ آ آ آ آ آ آ ------آ ن¸چç”±è‡ھن¸»çڑ„و„ںو¦‚ن¸‹آ آ ≧◇≦

### ه¹³ç¨³è؟‡و¸،

ن»£ç پو’¸ه®Œوµ‹ه®Œو‰چهپڑه¥½è½¬ه‹ه·¥ن½œçڑ„第ن¸€و¥ï¼Œه°†وµپé‡ڈ稳و¥ه¹³و»‘è؟‡و¸،هˆ°و–°çڑ„وœچهٹ،ن¸ï¼Œهپڑهˆ°ن¸ٹن¸‹و¸¸و— و„ںوک¯è½¬ه‹è؟‡ç¨‹ن¸é¢ن¸´çڑ„هڈ¦ن¸€ه¤§وŒ‘وˆکم€‚

说هˆ°è؟™é‡Œ,è¦پè¾¾هˆ°ç³»ç»ںçڑ„è¯è¨€è½¬ه‹ه‰چهگژçڑ„ه¹³ç¨³è؟‡و¸،ه…¶ه®وک¯هœ¨è¯´è½¬ه‹ه‰چهگژه¯¹وˆ‘ن»¬ç³»ç»ںçڑ„用وˆ·SLA(Service Level Agreement)وڈگن¾›ن¸€è‡´و€§çڑ„ن؟è¯پم€‚è؟™é‡Œه…ˆç®€هچ•èپٹèپٹç³»ç»ںوœچهٹ،çڑ„SLAم€‚

وœچهٹ،هڈ¯ç”¨و€§ç؛§هˆ«

وœچهٹ،و£ه¸¸è؟گè،Œو—¶é—´ç™¾هˆ†و¯”

ه¹´ه®•وœ؛و—¶é—´

و—¥ه®•وœ؛و—¶é—´

1

90%

36.5day

2.4 hour

2

99%

3.65day

14 min

3

99.9%

8.76day

86sec

4

99.99%

52.6min

8.6sec

5

99.999%

5.25min

0.86sec

6

99.9999%

31.5sec

8.6msec

ن¸ٹè،¨و ¼وک¯ن¸ڑç•Œوœچهٹ،é«کهڈ¯ç”¨çڑ„ه‡ ن¸ھç؛§هˆ«çڑ„è،،é‡ڈو ‡ه‡†ï¼Œن¾‹ه¦‚ï¼ڑوœچهٹ،هڈ¯ç”¨و€§وک¯3ن¸ھ9و—¶ï¼Œه…¨ه¹´ه®•وœ؛و—¶é•؟ç؛¦ن¸؛8.76ه¤©çڑ„ç»ںè®،و¦‚çژ‡م€‚هڈ¦ه¤–,وˆ‘ن»¬éœ€è¦پوکژç،®çڑ„وک¯ن¸چهگŒçڑ„ç³»ç»ں,ن¸چهگŒçڑ„هœ؛و™¯ن»¥هڈٹن¸چهگŒçڑ„用وˆ·è§„و¨،ه¯¹ç³»ç»ںهڈ¯ç”¨و€§è¦پو±‚وک¯ن¸چن¸€و ·çڑ„م€‚ه¦‚ï¼ڑوںگن؛›ن¸ڑهٹ،çڑ„و”¯ن»ک链路هœ؛و™¯هڈ¯èƒ½tpsن¸چوک¯ه¾ˆé«ک,ن½†وک¯ن½œن¸؛ن؛¤وک“çڑ„و ¸ه‹é“¾è·¯ه؟…é،»ه¾—ن؟è¯پé«کç؛§هˆ«çڑ„هڈ¯ç”¨و€§م€‚

و€ژن¹ˆن؟è¯پوˆ–者وڈگهچ‡ç³»ç»ںوœچهٹ،çڑ„SLAه‘¢ï¼ںهœ¨وکژç،®وˆ‘ن»¬ç›®و ‡هگژ,وژ¥ن¸‹و¥ه°±وک¯و‹†è§£ç›®و ‡é‡ڈهŒ–ç›®و ‡م€‚

> you cant measure it,you cant fix it and improve it.

ن¸€èˆ¬و¥è¯´ï¼Œه½±ه“چç³»ç»ںوœچهٹ،هڈ¯ç”¨و€§وœ‰ن¸¤ن¸ھé‡چè¦په› هگ:

* MTBFï¼ڑMean Time Between Failures,ç³»ç»ںوœچهٹ،ه¹³ه‡و•…éڑœو—¶é—´é—´éڑ”م€‚

* MTTRï¼ڑMean Time To Recover,ç³»ç»ںوœچهٹ،ه¹³ه‡و•…éڑœوپ¢ه¤چو—¶é—´و—¶é•؟م€‚

و‰€ن»¥ه¤§è‡´هڈ¯ن»¥ç®€هچ•ه½’ç؛³ن¸؛è؟™و ·çڑ„ن¸€ن¸ھه‡½و•°ه…³ç³»:

آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ

هڈ¯èƒ½و— و³•ç»™هˆ°ن¸€ن¸ھç²¾ç،®çڑ„و•°ه¦وڈڈè؟°ï¼Œن½†وک¯هڈ¯ن»¥هپڑه®ڑو€§çڑ„هˆ†وگ:وپ¢ه¤چو—¶é•؟ه› هگن¸ژç³»ç»ںهڈ¯ç”¨ه؛¦وˆگو£ç›¸ه…³ï¼Œو•…éڑœé—´éڑ”ه› هگن¸ژç³»ç»ںهڈ¯ç”¨ه؛¦وˆگ逆相ه…³م€‚ن¹ںهچ³ï¼ڑ**\_é—®é¢که‡؛çژ°و—¶وپ¢ه¤چو—¶é•؟è¦په°½هڈ¯èƒ½çڑ„çں,ه°½هڈ¯èƒ½é™چن½ژو•…éڑœé¢‘çژ‡ن»¥ه¢ه¤§و•…éڑœé—´éڑ”م€‚**

هں؛ن؛ژن»¥ن¸ٹçگ†è®؛,وˆ‘ن»¬هœ¨هپڑç³»ç»ںه¹³ç¨³è؟‡و¸،و— ç¼هˆ‡وچ¢و—¶ï¼Œو— è®؛资و؛گن½؟用,ن¸ڑهٹ،ه†…部逻辑ه®çژ°هڈٹçپ°ه؛¦و–¹و،ˆï¼Œوˆ‘ن»¬éƒ½éœ€è¦پç€çœ¼ن؛ژè؟™ن¸¤ن¸ھو–¹é¢م€‚وژ¥ن¸‹و¥وˆ‘ن»¬ه°†ن»ژè؟™ن¸¤ن¸ھ点ه‡؛هڈ‘هˆ†وگ转ه‹è؟‡ç¨‹هکهœ¨çڑ„وŒ‘وˆکهڈٹوˆ‘ن»¬çڑ„ه؛”ه¯¹و–¹ه¼ڈم€‚

#### ه؟«é€ںه“چه؛”,é™چن½ژوپ¢ه¤چو—¶é•؟

è¦پهپڑهˆ°وپ¢ه¤چو—¶é•؟ه°½هڈ¯èƒ½çڑ„çں,首ه…ˆوˆ‘ن»¬éœ€è¦پن؟è¯پهœ¨ه‰چوœںه‡؛çژ°é—®é¢کو—¶وµپé‡ڈهˆ‡وچ¢è؟‡ç¨‹ن¸وµپé‡ڈ规و¨،ه°½هڈ¯èƒ½çڑ„ه°ڈ,هچ³éœ€è¦پن¸€ن¸ھ相ه¯¹çڑ„هگˆçگ†çڑ„çپ°ه؛¦و¢¯ه؛¦و–¹و،ˆم€‚ه…¶و¬،ه½“é—®é¢که‡؛çژ°هگژوˆ‘门需è¦پ能立هچ³ه›هˆ‡هˆ°هژںç³»ç»ں,ن¸چ至ن؛ژهڈچه؛”è؟‡و…¢ه¯¼è‡´ه¤§é‡ڈه¢é‡ڈé—®é¢کن؛§ç”ں,هچ³éœ€è¦پن¸€ن¸ھه“چه؛”é«کو•ˆçڑ„ه¼€ه…³ه›و»ڑو–¹و،ˆم€‚ç”±ن؛ژ转ه‹è؟‡ç¨‹ن¸و¶‰هڈٹçڑ„وژ¥هڈ£ه’Œو¶ˆوپ¯و¶ˆè´¹ه…¥هڈ£è¾ƒه¤ڑ,هڈ¦ه¤–وˆ‘ن»¬è؟ک需è¦پ考虑هˆ°هگژوœںé—®é¢کوژ’éڑœه’Œه؟«é€ںه®ڑن½چçڑ„هڈ¯èƒ½è€—و—¶م€‚

* é’ˆه¯¹çپ°ه؛¦و¢¯ه؛¦هگˆçگ†هˆ¶ه®ڑ,و ¹وچ®ن¸ڑهٹ،特ه¾پ,ه¼€ه§‹éک¶و®µوˆ‘ن»¬é€‰و‹©ن؛†è¾ƒه†·é—¨هںژه¸‚(订هچ•é‡ڈ较ن½ژ)è؟›è،Œن؛†هگ„ن¸ھè؟گهٹ›و ‡ه“پن¸ڑهٹ،çڑ„逻辑éھŒè¯پم€‚و ‡ه“پéھŒè¯په®Œهگژ说وکژوˆ‘ن»¬و–°è؟پ移ه®çژ°çڑ„逻辑ه’Œهژںç³»ç»ںه…·وœ‰ن¸€è‡´و€§م€‚éڑڈهگژوˆ‘ن»¬و‹‰هڈ–ن؛†ه½“ه‰چ订هچ•هںژه¸‚هˆ†ه¸ƒï¼Œو ¹وچ®هںژه¸‚订هچ•هˆ†ه¸ƒهچ و¯”هˆ¶ه®ڑçپ°ه؛¦و¢¯ه؛¦ï¼Œç”±ه°ڈهˆ°ه¤§é€گو¥ه¢هٹ م€‚

* é’ˆه¯¹ه›هˆ‡éœ€è¦په“چه؛”é«کو•ˆï¼Œوˆ‘ن»¬ه؛”该وœ‰ن¸€ن¸ھو€»çڑ„ه¼€ه…³هڈ¯ن»¥وژ§هˆ¶وµپé‡ڈ,ه›هˆ‡ه؛”该وک¯ن¸€é”®وژ§هˆ¶çڑ„م€‚

* é’ˆه¯¹وژ’éڑœه؟«é€ںه®ڑن½چ,çپ°ه؛¦هچ•ç”ںه‘½ه‘¨وœںه†…çڑ„و“چن½œèƒ½هœ¨هچ•ه؛”用ه†…è‡ھé—هگˆï¼Œن¸چ至ن؛ژوژ’éڑœو—¶è؟ک需è¦پç،®è®¤çپ°ه؛¦هچ•وںگن¸ھçٹ¶و€پهˆ°ه؛•èµ°çڑ„هژںç³»ç»ںوœچهٹ،è؟کوک¯و–°ç³»ç»ںوœچهٹ،م€‚هڈ¦ه¤–وˆ‘ن»¬è؟که¸Œوœ›ï¼Œه†™و“چن½œçپ°ه؛¦ه’Œوں¥è¯¢çپ°ه؛¦èƒ½هچ•ç‹¬éڑ”离ه¼€ï¼Œç‰ه†™و•°وچ®ه®Œه…¨ن¸€è‡´çڑ„وƒ…ه†µن¸‹وˆ‘ن»¬ه†چه¼€هگ¯و–°و•°وچ®و–°وژ¥هڈ£وں¥çڑ„çپ°ه؛¦ï¼Œه°†é£ژ险وژ§هˆ¶هˆ°وœ€ن½ژم€‚

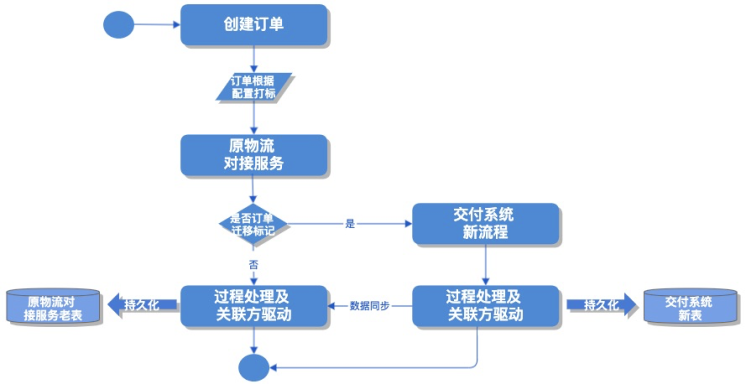

و‰€ن»¥وˆ‘ن»¬é‡‡ç”¨ن؛†ه¦‚ن¸‹çڑ„è€پç³»ç»ںوœچهٹ،ن»£çگ†و–¹و،ˆï¼ڑ

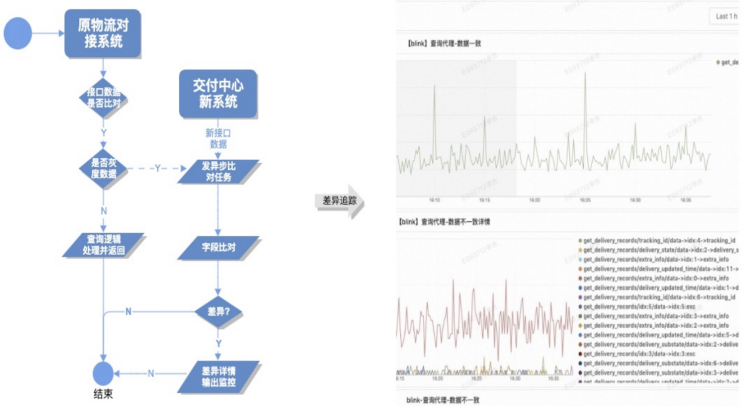

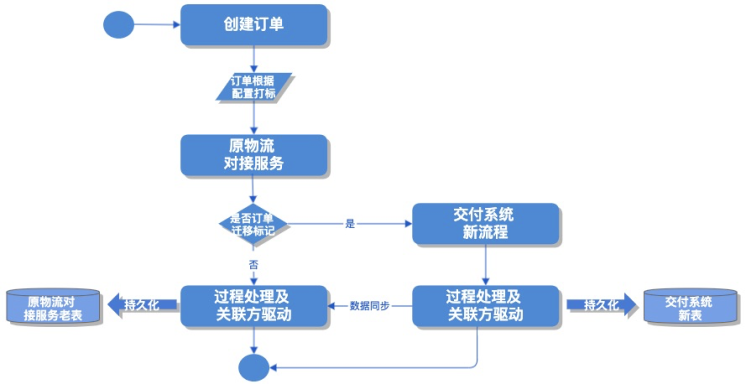

ه¦‚ن¸ٹه›¾و‰€ç¤؛,订هچ•ç³»ç»ںهˆ›ه»؛订هچ•و—¶و ¹وچ®و—¢ه®ڑçڑ„çپ°ه؛¦è®،هˆ’读هڈ–é…چ置给订هچ•و‰“و ‡ï¼Œçپ°ه؛¦è®،هˆ’هˆ†ن¸؛ه‰چوœںهˆ†و ‡ه“پ,门ه؛—ç»´ه؛¦éھŒè¯پ,هگژوœںوŒ‰هںژه¸‚订هچ•هˆ†ه¸ƒç»´ه؛¦é…چç½®م€‚è‹¥و–°ç³»ç»ںوœچهٹ،ه‡؛çژ°é—®é¢کهڈ¯ن¸€é”®هˆ‡وژ‰çپ°ه؛¦وµپé‡ڈ,و¢è،€ه¢é‡ڈé—®é¢کم€‚وژ¥ç€ï¼Œهژںن؛¤ن»کè€پوœچهٹ،识هˆ«و ‡è®°هپڑن»£çگ†è½¬هڈ‘,订هچ•ن¸چهکهœ¨è؟پ移و ‡è®°هˆ™هژںوµپ程و“چن½œه¤„çگ†,هگ¦هˆ™è½¬هڈ‘هˆ°و–°ن؛¤ن»کن¸ه؟ƒو–°وœچهٹ،و“چن½œه¤„çگ†ï¼Œç›¸ه؛”çڑ„و¶ˆوپ¯ç›‘هگ¬ه¤„çگ†هگŒو ·ن¹ںوک¯هڈ‚照订هچ•و ‡è®°ï¼Œè؟™و ·ن؟è¯پن؛†هگŒن¸€ن¸ھ订هچ•çڑ„ن؛¤ن»کè؟‡ç¨‹èƒ½هœ¨ن¸€ن¸ھه؛”用ن¸ه®Œوˆگ,وœ‰هˆ©ن؛ژهگژوœںه¤„çگ†وµپé‡ڈن¸ٹو¥هگژçڑ„ه؟«é€ںé—®é¢که®ڑن½چم€‚

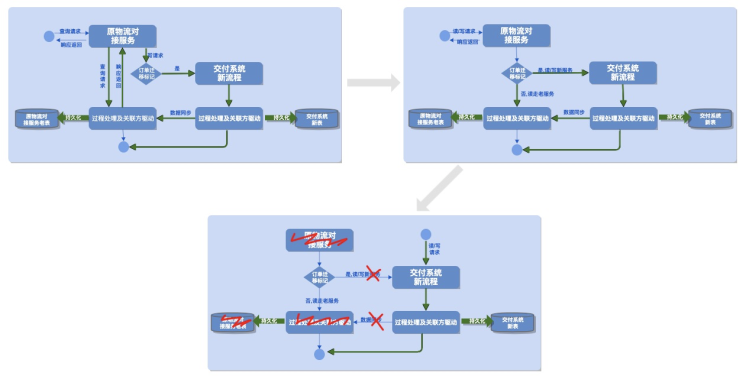

هڈ¦ه¤–,وˆ‘ن»¬çڑ„وژ¥هڈ£çپ°ه؛¦è؟‡ç¨‹وک¯ه†™ن¸ژوں¥هˆ†ç¦»çڑ„,و•´ن¸ھè؟پ移è؟‡ç¨‹ه¤§è‡´هˆ†ن¸؛ن¸‰ن¸ھéک¶و®µï¼Œه¦‚ن¸‹ه›¾و‰€ç¤؛ï¼ڑ

* 第ن¸€éک¶و®µ çپ°ه؛¦ه†™éک¶و®µ,çپ°ه؛¦ç–ç•¥:é¤گهژ…ç»´ه؛¦,هںژه¸‚ç»´ه؛¦ه°ڈ范ه›´çپ°ه؛¦,读وµپé‡ڈن»¥è€پوœچهٹ،ن¸؛ه‡†,é—®é¢که‡؛çژ°هڈٹو—¶هˆ‡وژ‰çپ°ه؛¦ه†™وµپé‡ڈ,逻辑ه›و»ڑ至è€پوœچهٹ،م€‚

* 第ن؛Œéک¶و®µ çپ°ه؛¦وں¥è¯¢éک¶و®µ,çپ°ه؛¦و ‡è®°وµپé‡ڈن»¥و–°وœچهٹ،ن¸؛ه‡†,éçپ°ه؛¦و ‡è®°ن»¥è€پوœچهٹ،é€ڈه‡؛ن¸؛ه‡†,çپ°ه؛¦ç–ç•¥:هگ„ن¸ھوں¥è¯¢وژ¥هڈ£وŒ‰ç…§ç™¾هˆ†و¯”é€گو¥ه¢هٹ çپ°ه؛¦هچ و¯”م€‚

* 第ن¸‰éک¶و®µ è؟پ移éک¶و®µ,ه®Œوˆگ读ه†™çپ°ه؛¦,هژںç³»ç»ںè€پوœچهٹ،هڈھوک¯ن»£çگ†çڑ„ن¸€ه±‚çڑ®,وژ¥ن¸‹و¥ه°±وک¯ن¸ٹو¸¸ç³»ç»ںè؟پ移هˆ°و–°وœچهٹ،,هژ»وژ‰ه¯¹هژںهژںç³»ç»ںوœچهٹ،çڑ„ن¾èµ–,è؟پ移ه®Œوˆگم€‚

#### وœ€ه¤§هٹھهٹ›é™چن½ژو•…éڑœé£ژ险

ه¹³ه‡و•…éڑœé—´éڑ”وک¯ن¸€ن¸ھهگژéھŒو—¶é•؟و•°وچ®ï¼Œè¦پهپڑهˆ°é—´éڑ”و—¶é•؟ه°½هڈ¯èƒ½çڑ„é•؟,و—¥ه¸¸é‡Œه°±éœ€هپڑه¥½هڈ‘ه¸ƒوژ§هˆ¶ï¼Œé£ژ险ه·،و£€هڈٹوŒپç»ç›‘وژ§ç‰ه·¥ن½œم€‚

1.هڈ‘ه¸ƒوژ§هˆ¶

转ه‹وœںé—´و–°ç³»ç»ںوœچهٹ،ه؟…é،»éپµه¾ھهڈ‘ه¸ƒsop,é¥؟هœ؛هڈ‘ه¸ƒsopه·²ç»ڈه½¢وˆگه…±è¯†ï¼Œوˆ‘ن»¬هڈھ需ن¸¥و ¼éپµه®ˆï¼Œè؟™é‡Œن¸چه†چèµکè؟°م€‚

2.é£ژ险ه·،و£€

* ç³»ç»ں逻辑و ¸ه¯¹ï¼Œه¤ڑن؛؛ه¤ڑو¬،code reviewم€‚

* هڈکو›´هڈ‘ه¸ƒه‰چن¸»ه¹²هœ؛و™¯è‡ھهٹ¨هŒ–用ن¾‹ه…¨é€ڑè؟‡م€‚

* ه‘¨وœںو€§هژ‹وµ‹م€‚

3.ه¤ڑه±‚و¬،وŒپç»ç›‘وژ§

* 部署وœ؛ه™¨ï¼Œç¼“هک集群,و¶ˆوپ¯éکںهˆ—,و•°وچ®ه؛“è،¨ç‰هں؛ç،€èµ„و؛گçڑ„هں؛ه‡†ç›‘وژ§م€‚

* ن¸ڑهٹ،و›²ç؛؟وˆگهٹںçژ‡ï¼Œو—¥هگŒو¯”,ه‘¨هگŒو¯”,و›²ç؛؟و³¢هٹ¨و¯”,هڈٹن¸»è¦پوژ¥هڈ£ه…¥هڈ£وµپé‡ڈهˆ°ن¸‹و¸¸ه‡؛هڈ£وµپé‡ڈ转وچ¢çژ‡ç›‘وژ§ï¼Œن¸ڑهٹ،ç³»ç»ںوˆگç†ںهگژè؟که؛”ه¯¹هگ„ن¸ھوœچهٹ،ه“چه؛”و—¶é—´وŒ‡و ‡هپڑ监وژ§ç‰م€‚

* ç³»ç»ںن¸ه¾ˆه¤ڑوƒ…ه†µن¸‹é‡چ试都وک¯ن»¥ه¼‚ه¸¸ن¸و–ن¸؛ن¾وچ®ï¼Œè؟™ه؟…然ن¼ڑه¯¹ç³»ç»ںه¼‚ه¸¸ç‚¹ه¸¦و¥è¾ƒه¤§çڑ„ه™ھéں³م€‚ن¸؛و¤وˆ‘ن»¬è؟ک需è¦پ细هŒ–هگ„ن¸ھن¸و–ه¼‚ه¸¸çڑ„و‰“点,وژ’除ن¸چه؟…è¦پçڑ„ه¹²و‰°م€‚

#### ن¸€è‡´و€§é—®é¢ک

转ه‹è؟‡ç¨‹ن¸وˆ‘ن»¬ه®é™…ن¸ٹهگŒو—¶هپڑن؛†و•°وچ®و¨،ه‹ن¼کهŒ–è؟پ移,ه¯¹ه¤–ن¸؛ن؛†ن؟è¯پو–°è€پç³»ç»ںè،Œن¸؛ه±و€§çڑ„ن¸€è‡´و€§ï¼Œوˆ‘ن»¬è؟کé¢ن¸´ن»¥ن¸‹ه‡ ن¸ھوŒ‘وˆکï¼ڑ

* çپ°ه؛¦و•°وچ®éœ€è¦پهڈŒه†™و–°è€پن؛¤ن»کç³»ç»ںه؛“è،¨ï¼Œه¦‚ن½•ن؟è¯پهڈŒن¾§ه؛•ه±‚و•°وچ®çڑ„ن¸€è‡´و€§ï¼ں

* ه؛•ه±‚و•°وچ®ن¸€è‡´ن¸چç‰ن؛ژه¯¹ه¤–وœچهٹ،وژ¥هڈ£و•°وچ®é€ڈه‡؛ن¸€è‡´ï¼ŒهڈŒن¾§وœچهٹ،ه؛”用ه±‚é¢و€ژن¹ˆن؟è¯پو•°وچ®çڑ„ن¸€è‡´و€§ï¼ں

* 订هچ•éک؟و³¢ç½—ه±¥ç؛¦ç؛؟ه’Œن؛¤ن»کçڑ„ن¸ٹن¸‹و¸¸و•°وچ®و•°وچ®وœ€ç»ˆن¸€è‡´و€§و€ژن¹ˆن؟è¯پو€ژن¹ˆéھŒè¯پï¼ں

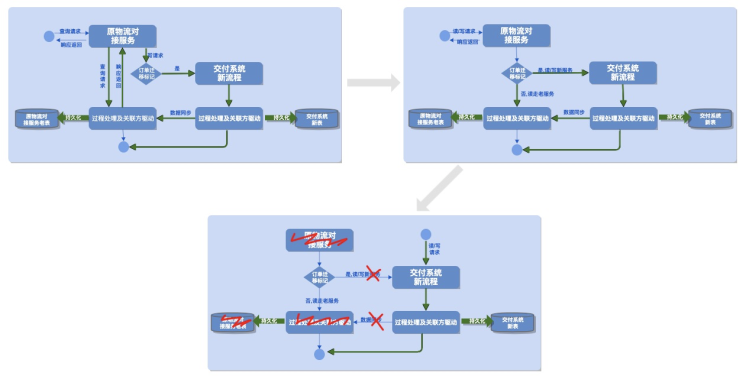

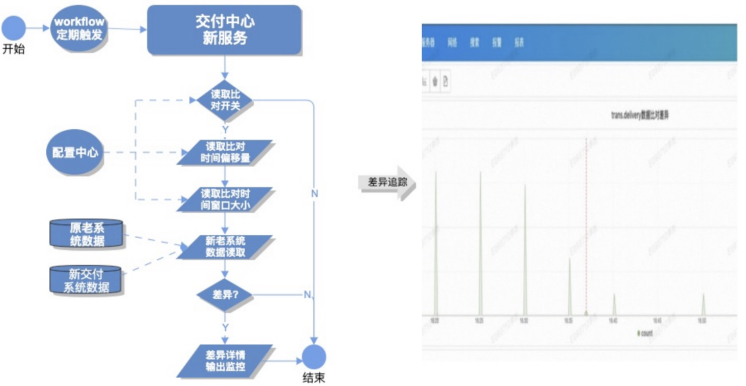

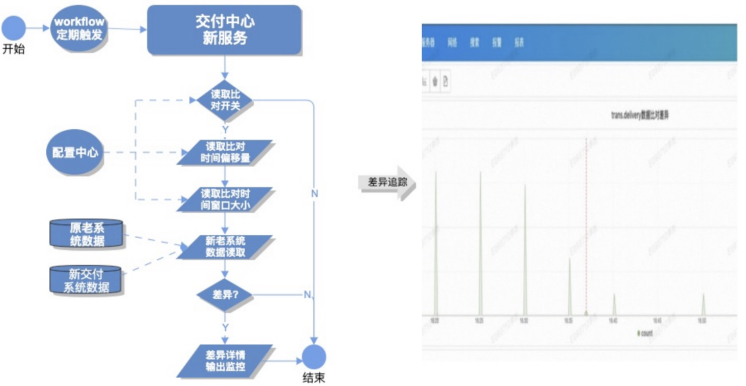

ن¸€è‡´و€§çڑ„ن؟è¯پ,هˆ«و— ن»–و³•ï¼Œهڈھ能é€ڑè؟‡و¯”ه¯¹و¥هپڑم€‚ن½†هœ¨هپڑو¯”ه¯¹çڑ„و—¶ه€™وˆ‘ن»¬è؟ک需è¦پ考虑هˆ°و¯”ه¯¹وœ¬è؛«هڈھوک¯وˆ‘ن»¬éھŒè¯پè؟پ移系ç»ںو£ç،®و€§هڈٹ稳ه®ڑو€§çڑ„ن¸€éƒ¨هˆ†ه±و—پ路,ه¹¶éç”ںن؛§çژ¯ه¢ƒçڑ„ه؟…é،»هٹں能م€‚هچ³وˆ‘ن»¬ه¾—考虑è؟™éƒ¨هˆ†هٹں能ه¯¹çژ°وœ‰ç³»ç»ںهڈ¯èƒ½é€ وˆگçڑ„هژ‹هٹ›م€‚è؟™éƒ¨هˆ†هژ‹هٹ›ه؛”该وک¯éڑڈç€ç³»ç»ںéھŒè¯په®Œو¯•وک¯هڈ¯ه¼€ه…³çڑ„,هژ‹هٹ›ه¤§ه°ڈه؛”éڑڈç³»ç»ںçڑ„è،¨çژ°هڈ¯éڑڈو—¶è°ƒèٹ‚م€‚ن¸چ至ن؛ژه› ن¸؛éھŒè¯پو‹–ه®ن؛†ç”ںن؛§ه؛”用م€‚و‰€ن»¥وˆ‘ن»¬ه¯¹و¯”ه¯¹çڑ„هں؛وœ¬è¦پو±‚وک¯ï¼ڑ能ن¸€é”®ه¼€ه…³ï¼Œهڈ¯ç›‘وژ§هڈ¯è؟½و؛¯م€‚除ن؛†è؟™ن؛›ه…±و€§ï¼Œه…·ن½“è؟که؛”هپڑهˆ°ن»¥ن¸‹ه‡ 点ï¼ڑ

* é’ˆه¯¹ه؛•ه±‚و•°وچ®و¯”ه¯¹ï¼ڑ

* و¯”ه¯¹ه؛”وک¯ه‡†ه®و—¶çڑ„,ه¦‚هڈھو¯”ه¯¹30هˆ†é’ںه‰چçڑ„و•°وچ®م€‚

* و¯”ه¯¹و•°وچ®وک¯هں؛ن؛ژو—¶é—´هڈ¯هˆ†و®µé‡‡و ·çڑ„,ه¦‚هڈھو¯”ه¯¹10هˆ†é’ںن»¥ه†…ن؛§ç”ںçڑ„و•°وچ®م€‚

* ن¸؛ن؛†و–¹ن¾؟وژ§هˆ¶ï¼Œو ¹وچ®وƒ…ه†µن»¥ن¸ٹç–ç•¥هڈˆهڈ¯ن»¥وک¯هڈٹو—¶è°ƒèٹ‚çڑ„م€‚هچ³ه‡†ه®و—¶هپڈ移é‡ڈهڈ¯è°ƒèٹ‚,هˆ†و®µé‡‡و ·çھ—هڈ£ه¤§ه°ڈهڈ¯è°ƒèٹ‚م€‚

ه…·ن½“ه®و–½و–¹و،ˆه¦‚ن¸‹ï¼ڑ

* é’ˆه¯¹ه؛”用ه±‚و•°وچ®و¯”ه¯¹ï¼ڑ

* ن»£çگ†ه±‚وژ¥و”¶è¯·و±‚هگژ,و¯”ه¯¹ه؛”وک¯ه¼‚و¥çڑ„,ن¸چه½±ه“چوژ¥هڈ£ه“چه؛”耗و—¶م€‚

* و¯”ه¯¹ç²’ه؛¦è¦په°ڈ,ه؛”细هŒ–هˆ°وژ¥هڈ£م€‚

* 识هˆ«çپ°ه؛¦و•°وچ®ï¼Œهڈھهپڑوœ‰و•ˆو¯”ه¯¹م€‚

ه…·ن½“ه®و–½و–¹و،ˆه¦‚ن¸‹ï¼ڑ

و— è®؛و•°وچ®ه±‚é¢è؟کوک¯وژ¥هڈ£ه±‚é¢ه‡؛çژ°و¯”ه¯¹ن¸چن¸€è‡´ï¼Œه؛”ç«‹هˆ»هژ»هˆ†وگوک¯ن»€ن¹ˆهژںه› ه¯¼è‡´ن¸چن¸€è‡´م€‚解ه†³و ¹ه› é€گو¥é™چه™ھ,هڈھ至و¯”ه¯¹ه·®ه¼‚هœ¨وˆ‘ن»¬è®¤ن¸؛هڈ¯وژ¥هڈ—çڑ„范ه›´ه†…م€‚

* é’ˆه¯¹ن¸ٹن¸‹و¸¸و•°وچ®وœ€ç»ˆن¸€è‡´و€§ï¼ڑ

* ه…¨é‡ڈو•°وچ®و ¸ه¯¹

* ن¸»ه¹²é“¾è·¯وœ€ç»ˆن¸€è‡´و€§و ¸ه¯¹

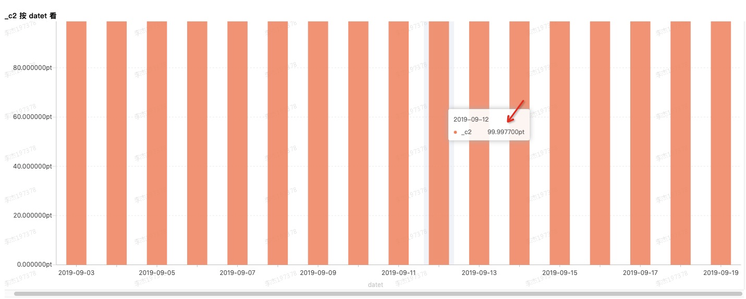

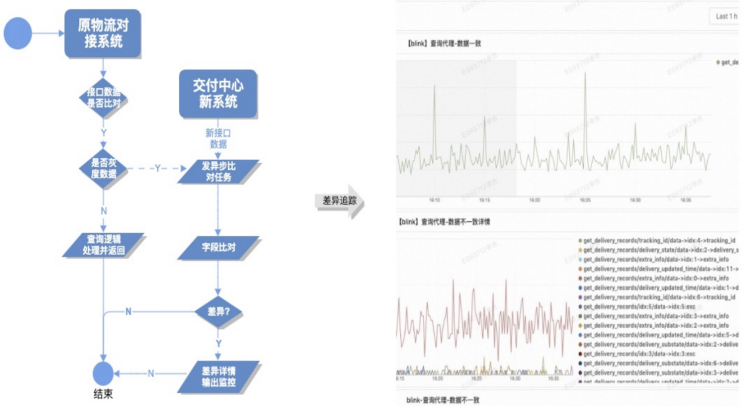

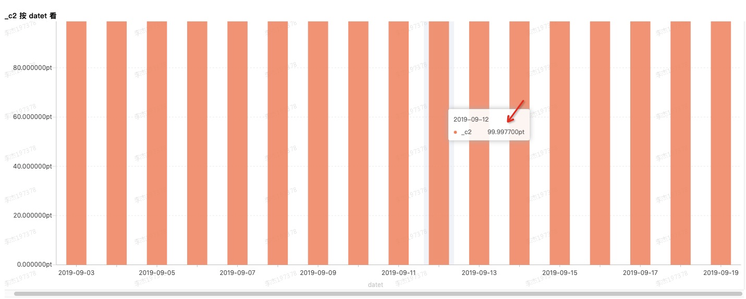

ç»ڈè؟‡و•°وچ®ه‡†ه®و—¶و¯”ه¯¹ï¼Œوژ¥هڈ£ه®و—¶ه¼‚و¥و¯”ه¯¹ï¼Œه…¶ه®هں؛وœ¬هڈ¯ن»¥ç،®è®¤و–°è€پç³»ç»ں能هٹ›è،Œن¸؛ه±و€§ه¯¹ç‰و€§م€‚然而稳ه®ڑه¤§ن؛ژن¸€هˆ‡ï¼Œè¦پ百هˆ†ç™¾ç،®ه®ڑè؟ک需è¦پt+1و•°وچ®و ¸éھŒم€‚هچ³ن»ژه…¨ه±€و•°وچ®è§’ه؛¦çœ‹و–°è€پç³»ç»ں转وچ¢çڑ„ه½±ه“چم€‚è؟™é‡Œن»¥ن¸»ه¹²é“¾è·¯ه‘¼هچ•ه¤ڑو—¥وˆگهٹںçژ‡ن¸؛ن¾‹هپڑ简è¦پ说وکژم€‚ه¦‚ن¸‹ه›¾و‰€ç¤؛,ه¤ڑو—¥ن¹ژهچ•وˆگهٹںçژ‡هں؛وœ¬هœ¨99.9977%ه·¦هڈ³ï¼Œهڈ¯ن»¥è®¤ن¸؛و–°è€پç³»ç»ںن»£çگ†هˆ‡وچ¢ن؛¤ن»کوˆگهٹںçژ‡هں؛وœ¬è،¨çژ°ç¨³ه®ڑم€‚

### وœھو¥

وˆھو¢و¤و–‡و”¥ه†™و—¶é—´ï¼Œé¥؟ن؛†ن¹ˆن؛¤ن»کن¸ه؟ƒه·²ç»ڈه®Œوˆگن؛†و•´ن¸ھç³»ç»ںçڑ„è¯è¨€è½¬وچ¢ï¼Œوµپé‡ڈن¹ںه·²ç»ڈ100%هˆ‡وچ¢ن»£çگ†هˆ°و–°ç³»ç»ں,ه¤„ن؛ژوµپé‡ڈهˆ‡وچ¢çڑ„第ن¸‰éک¶و®µم€‚结هگˆو—¥ه¸¸ç³»ç»ںç»´وٹ¤ن¸ژ需و±‚è؟ن»£ه®è·µï¼Œوˆ‘ن»¬ن»چ需è¦په†چن»¥ن¸‹ه‡ ن¸ھو–¹é¢è؟›è،Œو›´و·±ه…¥çڑ„و€è€ƒï¼ڑ

* 转ه‹è؟‡ç¨‹ن¸ن¸؛ن؛†هœ¨وک“وµ‹ï¼Œهڈ¯و ¸ه¯¹هگŒو—¶ن¸ژpythonçڑ„“é”و³•â€ه§؟هٹ؟و–—ن؛‰ن¸و‰¾ه¹³è،،,部هˆ†é€»è¾‘وک¯"ç؛¯ç؟»è¯‘"çڑ„,هگژوœںç»´وٹ¤è؟‡ç¨‹ه¾ˆç—›è‹¦ï¼Œو‰€ن»¥وˆ‘ن»¬éœ€è¦په‡ و¬،ن¸چه°ڈçڑ„é‡چو„و¥è¾¾هˆ°ن»£ç په±‚é¢çڑ„ه’Œè°گم€‚

* ن¸چو–监وژ§é™چه™ھ,وŒپç»ç»†هŒ–监وژ§ç²’ه؛¦ï¼Œç›‘وژ§وک¯وœچهٹ،稳ه®ڑهں؛çں³م€‚

* ن؛¤ن»کن¸ه؟ƒو•°وچ®ه¤§ç›که»؛设,ن»ژو•°وچ®ه±‚é¢é‡ڈهŒ–观وµ‹وˆ‘ن»¬çڑ„ن؛¤ن»کè´¨é‡ڈم€‚و•°وچ®é©±هٹ¨,و•°ه—è؟گèگ¥ن»ژو•°وچ®هŒ–و€ç»´ن¼کهŒ–وˆ‘ن»¬çڑ„وµپ程,وڈگé«کوˆ‘ن»¬çڑ„وœچهٹ،م€‚

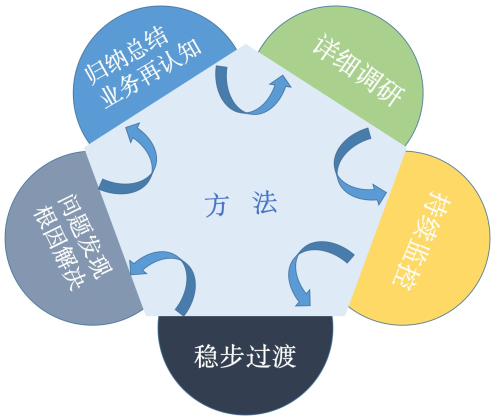

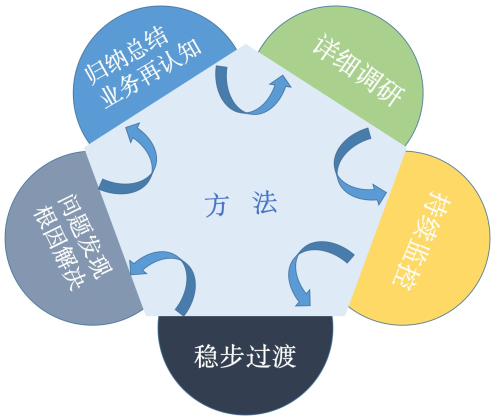

### و–¹و³•è®؛و²‰و·€

ه‡،و¤ن»¥ن¸ٹ,وœچهٹ،ç³»ç»ں转ه‹è؟پ移ه½’结ن؛ژه¼€هڈ‘者çگ†è§£ن¸ژ认çں¥ï¼Œé،¹ç›®çڑ„稳ه®ڑه®و–½ه½’结ن؛ژه¼€هڈ‘者ه¥—è·¯و–¹و³•è؟گ用م€‚هڈ¯ن»¥ç®€هچ•è؟›ن¸€و¥وڈگ炼ن¸؛ن»¥ن¸‹و–¹و³•è®؛ï¼ڑ

* è¯¦ç»†è°ƒç ”ï¼Œه®¢è§‚é—®é¢کهڈٹو»،足ن¸ڑهٹ،çڑ„ç³»ç»ںوک¯ه¤چو‚çڑ„ï¼Œè¯¦ç»†è°ƒç ”هپڑه¥½ه‡†ه¤‡وک¯ه؟…é،»çڑ„م€‚

* وŒپç»ç›‘وژ§ï¼Œو„ںçں¥ç³»ç»ںçڑ„è´¨é‡ڈوک¯وœچهٹ،è´¨é‡ڈه؛¦é‡ڈçڑ„第ن¸€و¥ï¼Œن¸چو–وŒپç»çڑ„监وژ§و‰چ能走çڑ„و›´ç¨³م€‚

* 稳و¥è؟‡و¸،,ن؛’èپ”网系ç»ںوœچهٹ،é«کهڈ¯ç”¨ç¨³ه®ڑن¸چه®¹ه•†é‡ڈم€‚

* é—®é¢کهڈ‘çژ°و ¹ه› 解ه†³ï¼Œه°ڈçڑ„é—®é¢کهڈ¯èƒ½éڑگè—ڈه¤§çڑ„bug,认çœںه¯¹ه¾…究ه…¶و ¹وœ¬ï¼Œه¤چç›ک->و€»ç»“->وڈگهچ‡م€‚

* ه½’ç؛³و€»ç»“ن¸ڑهٹ،ه†چ认çں¥م€‚

ه…³ن؛ژ认çں¥وڈگهچ‡çڑ„ه‡ ن¸ھه°ڈ点ï¼ڑ

* ه¯¹ن؛ژو¯ڈن¸€ن½چه·¥ç¨‹ه¸ˆï¼Œه¼€هڈ‘é«که¹¶هڈ‘ه¤§وµپé‡ڈç³»ç»ںوک¯وŒ‘وˆکن¹ںوک¯وœ؛éپ‡م€‚و—¶هˆ»ن؟وŒپè؟›هڈ–ه¦ن¹ ه؟ƒو€پ,ه¢ه¼؛è‡ھè؛«è½¯ç´ è´¨م€‚

* هˆ†ه¸ƒه¼ڈوƒ…ه†µن¸‹ï¼Œو‰؟认系ç»ںه¹¶éç»ه¯¹100%هڈ¯é ,و¯ڈن¸€ن¸ھçژ¯èٹ‚都è¦پ考虑“ه¤±è´¥â€ن؛†و€ژن¹ˆهٹ,ن¸چهگŒçڑ„هœ؛و™¯وˆ‘ن»¬éœ€è¦پهœ¨APه’ŒCPن¹‹é—´ن½œه‡؛وٹ‰و‹©م€‚ه¦‚هڈŒé“¾è·¯è°ƒç”¨ن؟è¯پهڈ¯é ,ه¼‚و¥é‡چ试ن؟è¯پé،؛ه؛ڈوœ€ç»ˆن¸€è‡´ç‰م€‚

* ه‡؛ن؛†é—®é¢که؟«é€ںوپ¢ه¤چوک¯ن¸ھو°¸وپ’çڑ„è¯é¢ک,و²،وœ‰â€œو€ژن¹ˆو ·â€œوœ€ه؟«هڈھوœ‰â€è؟™و ·â€و›´ه؟«م€‚ç²¾ه‡†ه®ڑن½چç«‹هچ³وپ¢ه¤چ,ه¦‚ن½•ه°†è؟™ن¸ھè؟‡ç¨‹è€—و—¶é™چهˆ°و›´ن½ژه€¼ه¾—و·±ه…¥و€è€ƒم€‚

**ن½œè€…ن؟،وپ¯ï¼ڑ**وژو°ï¼Œèٹ±هگچé،¹ه؛,ه½“ه‰چن¸»è¦پè´ںè´£é¥؟ن؛†ن¹ˆن؛¤ن»ک领هںںç³»ç»ںم€‚

[هژںو–‡é“¾وژ¥](https://yq.aliyun.com/articles/726315?utm_content=g_1000088284)

وœ¬و–‡ن¸؛ن؛‘و –社هŒ؛هژںهˆ›ه†…ه®¹ï¼Œوœھç»ڈه…پ许ن¸چه¾—转载م€‚

> وœ¬و–‡ن»‹ç»چن؛†é¥؟ن؛†ن¹ˆن؛¤ن»کن¸ه؟ƒç”±pythonè¯è¨€و ˆè½¬وچ¢هˆ°javaè¯è¨€و ˆه¤§è‡´è؟‡ç¨‹,ن¸€و¥وک¯ه¯¹ه‰چو®µو—¶é—´çڑ„ه·¥ن½œهپڑن¸‹و€»ç»“,هڈ¦ه¤–ن¹ںوک¯وƒ³é€ڑè؟‡و¤و¬،و€»ç»“ن¸؛ه…¶ن»–ه؛”用وœچهٹ،转ه‹وڈگن¾›ن؛›ه€ں鉴م€‚ه†™çڑ„ن¸چه¥½ï¼Œو¬¢è؟ژو؟ç –م€‚

### 背و™¯

é¥؟ن؛†ن¹ˆه¹¶ه…¥éک؟里集ه›¢,ن¸؛ن؛†èƒ½é«کو•ˆن¸ژ集ه›¢ه†…部系ç»ںهچڈهگŒه¯¹وژ¥,هگŒو—¶و–¹ن¾؟هˆ©ç”¨é›†ه›¢ن¼کهٹ؟وٹ€وœ¯èµ„و؛گ,و›´ه¥½çڑ„èچه…¥éک؟里集ه›¢وٹ€وœ¯ç”ںو€پهœˆ,é¥؟ن؛†ن¹ˆن؛¤وک“ن¸هڈ°هœ¨ن¸ٹهچٹه¹´هگ¯هٹ¨ن؛†ن؛¤وک“领هںںçڑ„ه››ه¤§ه؛”用è¯è¨€و ˆè½¬ه‹é،¹ç›®ï¼Œن¸؛éک؟里集ه›¢وœ¬هœ°ç”ںو´»وœچهٹ،ه¹³هڈ°و‰“ه¥½وٹ€وœ¯ه¹³هڈ°هں؛ç،€هپڑه‡†ه¤‡م€‚هڈ¦ه¤–,éڑڈç€ن¸ڑهٹ،é‡ڈçڑ„و؟€ه¢,é¥؟ن؛†ن¹ˆه¹³هڈ°و”¯وŒپçڑ„ه“پç±»ن¸چن»…ن»…وک¯وœ€هˆçڑ„ه¤–هچ–هچ•ه“پ,و•´ن¸ھن؛¤وک“ن¸هڈ°ن¹ں需è¦پن¸€و¬،相ه¯¹ه¤§çڑ„é‡چو„و¥ه؟«é€ںه؛”ه¯¹ه¤چو‚ه¤ڑهڈکçڑ„ن¸ڑهٹ،需و±‚م€‚而وœ¬و–‡ن¸çڑ„ن؛¤ن»کن¸ه؟ƒهچ³وک¯é¥؟ن؛†ن¹ˆن؛¤وک“领هںںه››ه¤§ه؛”用ن¹‹ن¸€م€‚

### ه‡†ه¤‡

هœ¨ه¼€ه±•ç›¸ه…³ه·¥ن½œن¹‹ه‰چ,首ه…ˆه؟…é،»ه¾—و¸…و¥ڑوˆ‘ن»¬وک¯è¦په°†ن¸€ن¸ھç³»ç»ںن»ژن»€ن¹ˆو ·هڈکوˆگن»€ن¹ˆو ·ï¼Œو–°çڑ„ç³»ç»ں相较è€پçڑ„ç³»ç»ںهœ¨ه“ھن؛›و–¹é¢هپڑçڑ„و›´ه¥½ï¼ŒهگŒو—¶ه؟…é،»ن؟è¯پو–°è€پç³»ç»ںçڑ„و— ç¼هˆ‡وچ¢ï¼Œهپڑهˆ°ن¸ڑهٹ،و— و„ںن¸چه½±ه“چن؛¤وک“ç³»ç»ںçڑ„稳ه®ڑو€§م€‚

#### ç³»ç»ںن»·ه€¼

ه¤–هچ–订هچ•çڑ„ن¸ڑهٹ،特点وک¯é‡چن؛¤وک“,c端用وˆ·ن»ژن¸‹هچ•é€‰é¤گهˆ°éھ‘و‰‹ه®Œوˆگé¤گه“پن؛¤ن»کè؟‡ç¨‹ï¼Œç›®ه‰چه¤§éƒ¨هˆ†éƒ½èƒ½هœ¨هچٹه°ڈو—¶ه·¦هڈ³ه®Œوˆگ,ه¯¹هچ³و—¶é…چé€په®و—¶و€§è¦پو±‚较é«کم€‚و•´ن¸ھ订هچ•ن؛¤وک“è؟‡ç¨‹ه¤§è‡´هˆ’هˆ†ن¸؛:1.و·»هٹ è´ç‰©è½¦ç،®è®¤è®¢هچ•ï¼Œ2.订هچ•ç”ںوˆگهڈٹ订هچ•و”¯ن»ک,3.وژ¥هچ•هڈٹ订هچ•ن؛¤ن»ک,4.هڈ¯èƒ½çڑ„ه”®هگژ退هچ•م€‚而è¦پو›´ه¥½çڑ„وœچهٹ،用وˆ·ï¼Œه¯¹ه››ن¸ھç³»ç»ں稳ه®ڑçڑ„هچڈهگŒèƒ½هٹ›وڈگه‡؛ه¾ˆé«کçڑ„è¦پو±‚م€‚

ه¦‚ه‰چو–‡و‰€è؟°ï¼Œوˆ‘ن»¬çں¥éپ“ه±¥ç؛¦çژ¯èٹ‚ه¯¹ن؛¤وک“订هچ•çڑ„ن»·ه€¼وک¯ن»€ن¹ˆï¼Œهچ³وک¯ه°†ه¤–هچ–订هچ•ه¯¹ه؛”çڑ„é¤گه“پن؛¤ن»کهˆ°ç”¨وˆ·و‰‹ن¸ï¼Œوٹ€وœ¯ه±‚é¢ن¸ٹو¥è®²ï¼Œن؛¤ن»که¯¹ن؛¤وک“订هچ•ه±ڈ蔽ن؛†ن¸€هˆ‡ه…¶ن»–ه±¥ç؛¦ç»†èٹ‚,ن½؟订هچ•و›´ن¸“و³¨è®¢هچ•é¢†هںںن¸ڑهٹ،م€‚

#### ه†…و ¸هˆ†وگ

وژ¥ن¸‹و¥ï¼Œوˆ‘ن»¬ه†چè؟›ن¸€و¥è¯¦ç»†çڑ„ه‰–وگن¸‹è½¬ه‹ه‰چن؛¤ن»کç³»ç»ںو‰€و‰؟è½½çڑ„هٹں能م€‚

آ آ

ه¦‚ن¸ٹه›¾و‰€ç¤؛,هژںن؛¤ن»که±¥ç؛¦é¢†هںںن¸هŒ…هگ«ن؛†ن¸‰ن¸ھ较ه¤§و؟ه—ï¼ڑ

* 1.订هچ•ه¯¹وژ¥è؟گهٹ›ç؛؟و¨،ه—

* 2.ه•†وˆ·è®¢هچ•ن؟،وپ¯و¨،ه—

* 3.部هˆ†é‡‘é¢è®،ç®—و¨،ه—

هڈ¯ن»¥çœ‹ه‡؛هژںç³»ç»ںو‰€و‰؟è½½هٹں能ه¹¶éçœںو£èپڑ焦هœ¨è®¢هچ•ن؛¤ن»کè؟‡ç¨‹م€‚و€ژن¹ˆهٹï¼ں转ه‹é‡چو„وک¯ن¸ھه¥‘وœ؛م€‚ه•†وˆ·è®¢هچ•ه›ه½’هˆ°è®¢هچ•ï¼Œé‡‘é¢è®،ç®—ن¸‹و²‰è‡³ç»“算,è؟™ن¸¤éƒ¨هˆ†çڑ„相ه…³è½¬ه‹é‡چو„è؟™é‡Œن¸چه†چèµکè؟°ï¼Œç›¸ه…³éƒ¨هˆ†ن¹ںه·²ç”±ه…„ه¼ںه›¢éکںه®Œوˆگم€‚ه…¶ه®هˆ°è؟™é‡Œن؛¤ن»که±¥ç؛¦ه؛”该ه…³و³¨çڑ„ه·²ç»ڈه¾ˆوکژوک¾ï¼ڑوٹٹه¤–هچ–订هچ•ç»™è؟گهٹ›ç؛؟,ن½؟ه…¶ه®Œوˆگن؛¤ن»که±¥ç؛¦م€‚

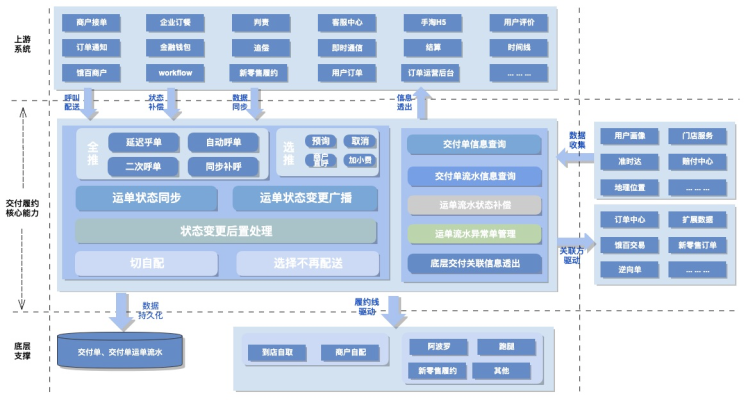

هں؛ن؛ژهˆڑو‰چوڈگهڈ–هگژçڑ„ن؛¤ن»که±¥ç؛¦و ¸ه؟ƒé¢†هںں,وˆ‘ن»¬ه¯¹ن¸»è¦پçڑ„هœ؛و™¯ç”¨ن¾‹è؟›è،Œن؛†è¯¦ç»†çڑ„و¢³çگ†م€‚ه¦‚ن¸‹ه›¾و‰€ç¤؛,هڈ¯ن»¥çœ‹هˆ°ï¼ڑ

* هڈ‚ن¸ژن؛¤ن»کè؟‡ç¨‹çڑ„ن¸»è¦پ角色وœ‰ه››ن¸ھ:

* 1.ه•†وˆ·

* 2.订هچ•

* 3.ه±¥ç؛¦è؟گهٹ›ç؛؟

* 4.用وˆ·

* ن؛¤ن»کوڈگن¾›çڑ„ن¸»è¦پو”¯و’‘能هٹ›وœ‰ï¼ڑ

* 1.ن¹ژهچ•ن؛¤ن»ک能هٹ›

* 2.è؟گهچ•çٹ¶و€پهگŒو¥èƒ½هٹ›

* 3.è؟گهچ•ن؟،وپ¯é€ڈه‡؛能هٹ›

* 4.ه±¥ç؛¦و–¹ه¼ڈهˆ‡وچ¢èƒ½هٹ›

* 5.è؟گهچ•çٹ¶و€په¹؟و’触达ن¸‹و¸¸èƒ½هٹ›ç‰م€‚

* 部هˆ†è؟گهچ•هڈ–و¶ˆوˆ–ه¼‚ه¸¸ç®،çگ†م€‚

ç³»ç»ںو ¸ه؟ƒç”¨ن¾‹هˆ†وگه¦‚ن¸‹ه›¾و‰€ç¤؛:

و›´è¯¦ç»†çڑ„ç³»ç»ں用ن¾‹و¢³çگ†وˆ–ç³»ç»ںن¸ٹن¸‹و¸¸ن؛¤ن؛’و—¶ه؛ڈè؟™é‡Œن¸چه†چن¸€ن¸€هˆ—ن¸¾ï¼Œéœ€è¦پ说وکژن¸€ç‚¹ï¼Œه½“ه¤§وµپé‡ڈç³»ç»ں转ه‹éپ‡هˆ°é‡چو„,è¦پوƒ³èµ°çڑ„ه¤ںè؟œه¤ں稳,ه‰چوœںçڑ„ن»”ç»†è°ƒç ”ه·¥ن½œهڈٹهٹں能ه¯¹é½گè؟‡ç¨‹éه¸¸é‡چè¦پم€‚特هˆ«وک¯ç”ںن؛§çژ¯ه¢ƒه·²ç»ڈè·‘ن؛†ه¥½ه‡ ه¹´و ¸ه؟ƒهٹں能系ç»ں,ه®é™…ن¸ڑهٹ،وƒ…ه†µé”™ç»¼ه¤چو‚م€‚ن¾‹ه¦‚è¦پ转ه‹é‡چو„ç³»ç»ںوژ¥هڈ£èƒ½هٹ›ï¼Œوژ¥هڈ£هگ«ن¹‰ï¼Œهœ؛و™¯ه؟…é،»éƒ½è¦پ详细وژŒوڈ،م€‚

### 设è®،

至و¤ï¼Œوˆ‘ن»¬çڑ„ç›®و ‡ه·²ç»ڈه¾ˆوکژç،®:1.è¯è¨€و ˆè½¬ه‹ï¼Œ2.è؟‡ç¨‹ن¸è¦په°†ن¸چه±ن؛ژن؛¤ن»کçڑ„ن¸œè¥؟ن»ژهژںç³»ç»ںن¸هˆ†ç¦»ه‡؛هژ»ï¼Œن½؟ه¾—ن؛¤ن»ک领هںںو›´ه¹²ه‡€م€‚结هگˆن؛¤ن»کوœھو¥هڈ¯èƒ½çڑ„هڈ‘ه±•و–¹هگ‘,ه…¶ن¸ن؛¤ن»ک能هٹ›هڈ¯ه¤چ用çڑ„,ه±¥ç؛¦è؟گهٹ›ç؛؟هڈ¯و‰©ه±•çڑ„م€‚è؟™ه¯¹و•´ن¸ھن؛¤ن»کهڈ¯ه؟«é€ںè؟ن»£ه¯¹وژ¥وڈگه‡؛ن؛†و›´é«کè¦پو±‚م€‚هڈ¦ه¤–,وˆ‘ن»¬ن¹ںهœ¨é¢†هںںه»؛و¨،设è®،و€وƒ³وŒ‡ه¯¼ن¸‹هپڑن؛†ن؛›ه®è·µه°è¯•ï¼Œن؛ژوک¯وœ‰ن؛†ن»¥ن¸‹و،†و¶ç»“و„م€‚

#### ç³»ç»ں设è®،

转ه‹وک¯وٹٹpythonو–¹è¨€è½¬وچ¢هˆ°javaو–¹è¨€ï¼Œن؛¤ن»کç³»ç»ںو ¸ه؟ƒèƒ½هٹ›ن¸چن¼ڑوœ‰هڈکهŒ–م€‚能هٹ›çڑ„ه¤چ用وک¯é€ڑè؟‡وژ¥هڈ£ç»´ه؛¦çڑ„وٹ½è±،èپڑهگˆن؛§ç”ں,ه±¥ç؛¦è؟گهٹ›ç؛؟能هٹ›هڈ¯و‰©ه±•é€ڑè؟‡هˆ©ç”¨ن¸ڑهٹ،و،†و¶و‰©ه±•ç‚¹ç‰¹و€§و»،足م€‚و‹†هˆ†هگژçڑ„ن¸ڑهٹ،و،†و¶ه؛”ه¦‚ن¸‹ه›¾و‰€ç¤؛ï¼ڑ

#### ç³»ç»ںو¶و„

ن¸ڑهٹ،و،†و¶ç»“هگˆه½“ه‰چé¥؟هœ؛هں؛ç،€ç»„ن»¶و”¯وŒپوˆ‘ن»¬ن¸چéڑ¾ç»™ه‡؛ن»¥ن¸‹ç³»ç»ںه†…部و¨،ه—هˆ’هˆ†ï¼ڑ

简هچ•ه¯¹هگ„组وˆگو¨،ه—هپڑ简è¦پ说وکژï¼ڑ

* apiï¼ڑه¤„ن؛ژن¸ڑهٹ،و،†و¶ن¸ن¸ٹو¸¸ç³»ç»ںوژ¥ه…¥ه±‚,ه¯¹ه¤–وڑ´و¼ڈه¥‘ç؛¦ه±ڈ蔽细èٹ‚,ه¯¹ه†…ه®ڑن¹‰ç³»ç»ں能هٹ›م€‚

* starterï¼ڑهگ¯هٹ¨é،¹ç›®

* serviceï¼ڑrpcوœچهٹ،وڑ´و¼ڈ

* domainï¼ڑو ¸ه؟ƒن¸ڑهٹ،能هٹ›ه®çژ°ï¼Œèپڑهگˆه±‚

* infraï¼ڑهں؛ç،€و•°وچ®و”¯و’‘能هٹ›ه±‚

* extensionï¼ڑه±¥ç؛¦èƒ½هٹ›و‰©ه±•ه±‚

* testerï¼ڑهچ•ه…ƒوµ‹è¯•هŒ…

هˆ°و¤ï¼Œوˆ‘ن»¬هڈ¯ن»¥وŒ‰ç…§è®¾è®،ن¸ژو—¢ه®ڑçڑ„è®،هˆ’و’¸ن»£ç پن؛†م€‚

> ه—¯ï¼Œن»£ç پو’¸ه®Œن؛†وµ‹ه®Œن؛†ï¼Œن»ژè°ƒç ”هˆ°ه¼€هڈ‘ه®Œوˆگهژ†و—¶ن¸¤ن¸ھهچٹوœˆï¼Œن»£ç پن»“ه؛“و€»è،Œو•°ç؛¦4.7wè،Œï¼Œوڈگن؛¤1000و¬،ه·¦هڈ³ï¼Œه®Œوˆگ63ن¸ھوژ¥هڈ£+16ن¸ھو¶ˆوپ¯و¶ˆè´¹ه…¥هڈ£è½¬ه‹è؟پ移,ه…±è®،وµ‹ه‡؛117+bug,وœںé—´وœ‰ه–œوœ‰ه؟§ï¼Œه¥‹وˆکن¸¤ç‚¹ه¤ڑوک¯ه¸¸و€پم€‚èپŒن¸ڑç”ںو¶¯ن¸وµ“é‡چçڑ„ن¸€ç¬”م€‚و¤و—¶ه°¤è®°èµ·ن¸ژ超ه“¥@邹超ه‘¨وœ«ن»£çگ†èپ”è°ƒن؛ژهŒ—14و¥¼ه°ڈ黑ه±‹ن¹‹ç•”,ه’Œوکژé¾™@ه¼ وکژé¾™ه¹¶è‚©ن½œوˆکه¯¹وژ¥وœچهٹ،وژ¥هڈ£ï¼Œè؟کوœ‰و™“و³¢@ن؟و™“و³¢ه‡Œو™¨ن¸€هگŒهژ‹وµ‹è§‚ه¯ںو€»ç»“é—®é¢ک第ن؛Œه¤©هˆ†وگهڈچ馈وڈگهچ‡ن¼کهŒ–,ه½“然è؟کوœ‰و°ه“¥@و±¤è‰¯و°çڑ„用ن¾‹è®¾è®،ه…¨é¢ن¸چه¤±ç»†èٹ‚م€په¯¹bugه¸¸ه¸¸ç©¶ه…¶و ¹وœ¬ï¼Œه¯¹ن»£ç پreview逻辑و ¸ه¯¹ن¸€ن¸ن¸چè‹ںوکژه¯ں秋و¯«م€‚ه‡،و¤ç§چç§چ,هژ†هژ†هœ¨ç›®م€‚ن¸€èµ·èµ°و¥ï¼Œçœںه؟ƒو„ںè°¢م€‚

> آ آ آ آ آ آ آ آ آ آ ------آ ن¸چç”±è‡ھن¸»çڑ„و„ںو¦‚ن¸‹آ آ ≧◇≦

### ه¹³ç¨³è؟‡و¸،

ن»£ç پو’¸ه®Œوµ‹ه®Œو‰چهپڑه¥½è½¬ه‹ه·¥ن½œçڑ„第ن¸€و¥ï¼Œه°†وµپé‡ڈ稳و¥ه¹³و»‘è؟‡و¸،هˆ°و–°çڑ„وœچهٹ،ن¸ï¼Œهپڑهˆ°ن¸ٹن¸‹و¸¸و— و„ںوک¯è½¬ه‹è؟‡ç¨‹ن¸é¢ن¸´çڑ„هڈ¦ن¸€ه¤§وŒ‘وˆکم€‚

说هˆ°è؟™é‡Œ,è¦پè¾¾هˆ°ç³»ç»ںçڑ„è¯è¨€è½¬ه‹ه‰چهگژçڑ„ه¹³ç¨³è؟‡و¸،ه…¶ه®وک¯هœ¨è¯´è½¬ه‹ه‰چهگژه¯¹وˆ‘ن»¬ç³»ç»ںçڑ„用وˆ·SLA(Service Level Agreement)وڈگن¾›ن¸€è‡´و€§çڑ„ن؟è¯پم€‚è؟™é‡Œه…ˆç®€هچ•èپٹèپٹç³»ç»ںوœچهٹ،çڑ„SLAم€‚

وœچهٹ،هڈ¯ç”¨و€§ç؛§هˆ«

وœچهٹ،و£ه¸¸è؟گè،Œو—¶é—´ç™¾هˆ†و¯”

ه¹´ه®•وœ؛و—¶é—´

و—¥ه®•وœ؛و—¶é—´

1

90%

36.5day

2.4 hour

2

99%

3.65day

14 min

3

99.9%

8.76day

86sec

4

99.99%

52.6min

8.6sec

5

99.999%

5.25min

0.86sec

6

99.9999%

31.5sec

8.6msec

ن¸ٹè،¨و ¼وک¯ن¸ڑç•Œوœچهٹ،é«کهڈ¯ç”¨çڑ„ه‡ ن¸ھç؛§هˆ«çڑ„è،،é‡ڈو ‡ه‡†ï¼Œن¾‹ه¦‚ï¼ڑوœچهٹ،هڈ¯ç”¨و€§وک¯3ن¸ھ9و—¶ï¼Œه…¨ه¹´ه®•وœ؛و—¶é•؟ç؛¦ن¸؛8.76ه¤©çڑ„ç»ںè®،و¦‚çژ‡م€‚هڈ¦ه¤–,وˆ‘ن»¬éœ€è¦پوکژç،®çڑ„وک¯ن¸چهگŒçڑ„ç³»ç»ں,ن¸چهگŒçڑ„هœ؛و™¯ن»¥هڈٹن¸چهگŒçڑ„用وˆ·è§„و¨،ه¯¹ç³»ç»ںهڈ¯ç”¨و€§è¦پو±‚وک¯ن¸چن¸€و ·çڑ„م€‚ه¦‚ï¼ڑوںگن؛›ن¸ڑهٹ،çڑ„و”¯ن»ک链路هœ؛و™¯هڈ¯èƒ½tpsن¸چوک¯ه¾ˆé«ک,ن½†وک¯ن½œن¸؛ن؛¤وک“çڑ„و ¸ه‹é“¾è·¯ه؟…é،»ه¾—ن؟è¯پé«کç؛§هˆ«çڑ„هڈ¯ç”¨و€§م€‚

و€ژن¹ˆن؟è¯پوˆ–者وڈگهچ‡ç³»ç»ںوœچهٹ،çڑ„SLAه‘¢ï¼ںهœ¨وکژç،®وˆ‘ن»¬ç›®و ‡هگژ,وژ¥ن¸‹و¥ه°±وک¯و‹†è§£ç›®و ‡é‡ڈهŒ–ç›®و ‡م€‚

> you cant measure it,you cant fix it and improve it.

ن¸€èˆ¬و¥è¯´ï¼Œه½±ه“چç³»ç»ںوœچهٹ،هڈ¯ç”¨و€§وœ‰ن¸¤ن¸ھé‡چè¦په› هگ:

* MTBFï¼ڑMean Time Between Failures,ç³»ç»ںوœچهٹ،ه¹³ه‡و•…éڑœو—¶é—´é—´éڑ”م€‚

* MTTRï¼ڑMean Time To Recover,ç³»ç»ںوœچهٹ،ه¹³ه‡و•…éڑœوپ¢ه¤چو—¶é—´و—¶é•؟م€‚

و‰€ن»¥ه¤§è‡´هڈ¯ن»¥ç®€هچ•ه½’ç؛³ن¸؛è؟™و ·çڑ„ن¸€ن¸ھه‡½و•°ه…³ç³»:

آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ آ

هڈ¯èƒ½و— و³•ç»™هˆ°ن¸€ن¸ھç²¾ç،®çڑ„و•°ه¦وڈڈè؟°ï¼Œن½†وک¯هڈ¯ن»¥هپڑه®ڑو€§çڑ„هˆ†وگ:وپ¢ه¤چو—¶é•؟ه› هگن¸ژç³»ç»ںهڈ¯ç”¨ه؛¦وˆگو£ç›¸ه…³ï¼Œو•…éڑœé—´éڑ”ه› هگن¸ژç³»ç»ںهڈ¯ç”¨ه؛¦وˆگ逆相ه…³م€‚ن¹ںهچ³ï¼ڑ**\_é—®é¢که‡؛çژ°و—¶وپ¢ه¤چو—¶é•؟è¦په°½هڈ¯èƒ½çڑ„çں,ه°½هڈ¯èƒ½é™چن½ژو•…éڑœé¢‘çژ‡ن»¥ه¢ه¤§و•…éڑœé—´éڑ”م€‚**

هں؛ن؛ژن»¥ن¸ٹçگ†è®؛,وˆ‘ن»¬هœ¨هپڑç³»ç»ںه¹³ç¨³è؟‡و¸،و— ç¼هˆ‡وچ¢و—¶ï¼Œو— è®؛资و؛گن½؟用,ن¸ڑهٹ،ه†…部逻辑ه®çژ°هڈٹçپ°ه؛¦و–¹و،ˆï¼Œوˆ‘ن»¬éƒ½éœ€è¦پç€çœ¼ن؛ژè؟™ن¸¤ن¸ھو–¹é¢م€‚وژ¥ن¸‹و¥وˆ‘ن»¬ه°†ن»ژè؟™ن¸¤ن¸ھ点ه‡؛هڈ‘هˆ†وگ转ه‹è؟‡ç¨‹هکهœ¨çڑ„وŒ‘وˆکهڈٹوˆ‘ن»¬çڑ„ه؛”ه¯¹و–¹ه¼ڈم€‚

#### ه؟«é€ںه“چه؛”,é™چن½ژوپ¢ه¤چو—¶é•؟

è¦پهپڑهˆ°وپ¢ه¤چو—¶é•؟ه°½هڈ¯èƒ½çڑ„çں,首ه…ˆوˆ‘ن»¬éœ€è¦پن؟è¯پهœ¨ه‰چوœںه‡؛çژ°é—®é¢کو—¶وµپé‡ڈهˆ‡وچ¢è؟‡ç¨‹ن¸وµپé‡ڈ规و¨،ه°½هڈ¯èƒ½çڑ„ه°ڈ,هچ³éœ€è¦پن¸€ن¸ھ相ه¯¹çڑ„هگˆçگ†çڑ„çپ°ه؛¦و¢¯ه؛¦و–¹و،ˆم€‚ه…¶و¬،ه½“é—®é¢که‡؛çژ°هگژوˆ‘门需è¦پ能立هچ³ه›هˆ‡هˆ°هژںç³»ç»ں,ن¸چ至ن؛ژهڈچه؛”è؟‡و…¢ه¯¼è‡´ه¤§é‡ڈه¢é‡ڈé—®é¢کن؛§ç”ں,هچ³éœ€è¦پن¸€ن¸ھه“چه؛”é«کو•ˆçڑ„ه¼€ه…³ه›و»ڑو–¹و،ˆم€‚ç”±ن؛ژ转ه‹è؟‡ç¨‹ن¸و¶‰هڈٹçڑ„وژ¥هڈ£ه’Œو¶ˆوپ¯و¶ˆè´¹ه…¥هڈ£è¾ƒه¤ڑ,هڈ¦ه¤–وˆ‘ن»¬è؟ک需è¦پ考虑هˆ°هگژوœںé—®é¢کوژ’éڑœه’Œه؟«é€ںه®ڑن½چçڑ„هڈ¯èƒ½è€—و—¶م€‚

* é’ˆه¯¹çپ°ه؛¦و¢¯ه؛¦هگˆçگ†هˆ¶ه®ڑ,و ¹وچ®ن¸ڑهٹ،特ه¾پ,ه¼€ه§‹éک¶و®µوˆ‘ن»¬é€‰و‹©ن؛†è¾ƒه†·é—¨هںژه¸‚(订هچ•é‡ڈ较ن½ژ)è؟›è،Œن؛†هگ„ن¸ھè؟گهٹ›و ‡ه“پن¸ڑهٹ،çڑ„逻辑éھŒè¯پم€‚و ‡ه“پéھŒè¯په®Œهگژ说وکژوˆ‘ن»¬و–°è؟پ移ه®çژ°çڑ„逻辑ه’Œهژںç³»ç»ںه…·وœ‰ن¸€è‡´و€§م€‚éڑڈهگژوˆ‘ن»¬و‹‰هڈ–ن؛†ه½“ه‰چ订هچ•هںژه¸‚هˆ†ه¸ƒï¼Œو ¹وچ®هںژه¸‚订هچ•هˆ†ه¸ƒهچ و¯”هˆ¶ه®ڑçپ°ه؛¦و¢¯ه؛¦ï¼Œç”±ه°ڈهˆ°ه¤§é€گو¥ه¢هٹ م€‚

* é’ˆه¯¹ه›هˆ‡éœ€è¦په“چه؛”é«کو•ˆï¼Œوˆ‘ن»¬ه؛”该وœ‰ن¸€ن¸ھو€»çڑ„ه¼€ه…³هڈ¯ن»¥وژ§هˆ¶وµپé‡ڈ,ه›هˆ‡ه؛”该وک¯ن¸€é”®وژ§هˆ¶çڑ„م€‚

* é’ˆه¯¹وژ’éڑœه؟«é€ںه®ڑن½چ,çپ°ه؛¦هچ•ç”ںه‘½ه‘¨وœںه†…çڑ„و“چن½œèƒ½هœ¨هچ•ه؛”用ه†…è‡ھé—هگˆï¼Œن¸چ至ن؛ژوژ’éڑœو—¶è؟ک需è¦پç،®è®¤çپ°ه؛¦هچ•وںگن¸ھçٹ¶و€پهˆ°ه؛•èµ°çڑ„هژںç³»ç»ںوœچهٹ،è؟کوک¯و–°ç³»ç»ںوœچهٹ،م€‚هڈ¦ه¤–وˆ‘ن»¬è؟که¸Œوœ›ï¼Œه†™و“چن½œçپ°ه؛¦ه’Œوں¥è¯¢çپ°ه؛¦èƒ½هچ•ç‹¬éڑ”离ه¼€ï¼Œç‰ه†™و•°وچ®ه®Œه…¨ن¸€è‡´çڑ„وƒ…ه†µن¸‹وˆ‘ن»¬ه†چه¼€هگ¯و–°و•°وچ®و–°وژ¥هڈ£وں¥çڑ„çپ°ه؛¦ï¼Œه°†é£ژ险وژ§هˆ¶هˆ°وœ€ن½ژم€‚

و‰€ن»¥وˆ‘ن»¬é‡‡ç”¨ن؛†ه¦‚ن¸‹çڑ„è€پç³»ç»ںوœچهٹ،ن»£çگ†و–¹و،ˆï¼ڑ

ه¦‚ن¸ٹه›¾و‰€ç¤؛,订هچ•ç³»ç»ںهˆ›ه»؛订هچ•و—¶و ¹وچ®و—¢ه®ڑçڑ„çپ°ه؛¦è®،هˆ’读هڈ–é…چ置给订هچ•و‰“و ‡ï¼Œçپ°ه؛¦è®،هˆ’هˆ†ن¸؛ه‰چوœںهˆ†و ‡ه“پ,门ه؛—ç»´ه؛¦éھŒè¯پ,هگژوœںوŒ‰هںژه¸‚订هچ•هˆ†ه¸ƒç»´ه؛¦é…چç½®م€‚è‹¥و–°ç³»ç»ںوœچهٹ،ه‡؛çژ°é—®é¢کهڈ¯ن¸€é”®هˆ‡وژ‰çپ°ه؛¦وµپé‡ڈ,و¢è،€ه¢é‡ڈé—®é¢کم€‚وژ¥ç€ï¼Œهژںن؛¤ن»کè€پوœچهٹ،识هˆ«و ‡è®°هپڑن»£çگ†è½¬هڈ‘,订هچ•ن¸چهکهœ¨è؟پ移و ‡è®°هˆ™هژںوµپ程و“چن½œه¤„çگ†,هگ¦هˆ™è½¬هڈ‘هˆ°و–°ن؛¤ن»کن¸ه؟ƒو–°وœچهٹ،و“چن½œه¤„çگ†ï¼Œç›¸ه؛”çڑ„و¶ˆوپ¯ç›‘هگ¬ه¤„çگ†هگŒو ·ن¹ںوک¯هڈ‚照订هچ•و ‡è®°ï¼Œè؟™و ·ن؟è¯پن؛†هگŒن¸€ن¸ھ订هچ•çڑ„ن؛¤ن»کè؟‡ç¨‹èƒ½هœ¨ن¸€ن¸ھه؛”用ن¸ه®Œوˆگ,وœ‰هˆ©ن؛ژهگژوœںه¤„çگ†وµپé‡ڈن¸ٹو¥هگژçڑ„ه؟«é€ںé—®é¢که®ڑن½چم€‚

هڈ¦ه¤–,وˆ‘ن»¬çڑ„وژ¥هڈ£çپ°ه؛¦è؟‡ç¨‹وک¯ه†™ن¸ژوں¥هˆ†ç¦»çڑ„,و•´ن¸ھè؟پ移è؟‡ç¨‹ه¤§è‡´هˆ†ن¸؛ن¸‰ن¸ھéک¶و®µï¼Œه¦‚ن¸‹ه›¾و‰€ç¤؛ï¼ڑ

* 第ن¸€éک¶و®µ çپ°ه؛¦ه†™éک¶و®µ,çپ°ه؛¦ç–ç•¥:é¤گهژ…ç»´ه؛¦,هںژه¸‚ç»´ه؛¦ه°ڈ范ه›´çپ°ه؛¦,读وµپé‡ڈن»¥è€پوœچهٹ،ن¸؛ه‡†,é—®é¢که‡؛çژ°هڈٹو—¶هˆ‡وژ‰çپ°ه؛¦ه†™وµپé‡ڈ,逻辑ه›و»ڑ至è€پوœچهٹ،م€‚

* 第ن؛Œéک¶و®µ çپ°ه؛¦وں¥è¯¢éک¶و®µ,çپ°ه؛¦و ‡è®°وµپé‡ڈن»¥و–°وœچهٹ،ن¸؛ه‡†,éçپ°ه؛¦و ‡è®°ن»¥è€پوœچهٹ،é€ڈه‡؛ن¸؛ه‡†,çپ°ه؛¦ç–ç•¥:هگ„ن¸ھوں¥è¯¢وژ¥هڈ£وŒ‰ç…§ç™¾هˆ†و¯”é€گو¥ه¢هٹ çپ°ه؛¦هچ و¯”م€‚

* 第ن¸‰éک¶و®µ è؟پ移éک¶و®µ,ه®Œوˆگ读ه†™çپ°ه؛¦,هژںç³»ç»ںè€پوœچهٹ،هڈھوک¯ن»£çگ†çڑ„ن¸€ه±‚çڑ®,وژ¥ن¸‹و¥ه°±وک¯ن¸ٹو¸¸ç³»ç»ںè؟پ移هˆ°و–°وœچهٹ،,هژ»وژ‰ه¯¹هژںهژںç³»ç»ںوœچهٹ،çڑ„ن¾èµ–,è؟پ移ه®Œوˆگم€‚

#### وœ€ه¤§هٹھهٹ›é™چن½ژو•…éڑœé£ژ险

ه¹³ه‡و•…éڑœé—´éڑ”وک¯ن¸€ن¸ھهگژéھŒو—¶é•؟و•°وچ®ï¼Œè¦پهپڑهˆ°é—´éڑ”و—¶é•؟ه°½هڈ¯èƒ½çڑ„é•؟,و—¥ه¸¸é‡Œه°±éœ€هپڑه¥½هڈ‘ه¸ƒوژ§هˆ¶ï¼Œé£ژ险ه·،و£€هڈٹوŒپç»ç›‘وژ§ç‰ه·¥ن½œم€‚

1.هڈ‘ه¸ƒوژ§هˆ¶

转ه‹وœںé—´و–°ç³»ç»ںوœچهٹ،ه؟…é،»éپµه¾ھهڈ‘ه¸ƒsop,é¥؟هœ؛هڈ‘ه¸ƒsopه·²ç»ڈه½¢وˆگه…±è¯†ï¼Œوˆ‘ن»¬هڈھ需ن¸¥و ¼éپµه®ˆï¼Œè؟™é‡Œن¸چه†چèµکè؟°م€‚

2.é£ژ险ه·،و£€

* ç³»ç»ں逻辑و ¸ه¯¹ï¼Œه¤ڑن؛؛ه¤ڑو¬،code reviewم€‚

* هڈکو›´هڈ‘ه¸ƒه‰چن¸»ه¹²هœ؛و™¯è‡ھهٹ¨هŒ–用ن¾‹ه…¨é€ڑè؟‡م€‚

* ه‘¨وœںو€§هژ‹وµ‹م€‚

3.ه¤ڑه±‚و¬،وŒپç»ç›‘وژ§

* 部署وœ؛ه™¨ï¼Œç¼“هک集群,و¶ˆوپ¯éکںهˆ—,و•°وچ®ه؛“è،¨ç‰هں؛ç،€èµ„و؛گçڑ„هں؛ه‡†ç›‘وژ§م€‚

* ن¸ڑهٹ،و›²ç؛؟وˆگهٹںçژ‡ï¼Œو—¥هگŒو¯”,ه‘¨هگŒو¯”,و›²ç؛؟و³¢هٹ¨و¯”,هڈٹن¸»è¦پوژ¥هڈ£ه…¥هڈ£وµپé‡ڈهˆ°ن¸‹و¸¸ه‡؛هڈ£وµپé‡ڈ转وچ¢çژ‡ç›‘وژ§ï¼Œن¸ڑهٹ،ç³»ç»ںوˆگç†ںهگژè؟که؛”ه¯¹هگ„ن¸ھوœچهٹ،ه“چه؛”و—¶é—´وŒ‡و ‡هپڑ监وژ§ç‰م€‚

* ç³»ç»ںن¸ه¾ˆه¤ڑوƒ…ه†µن¸‹é‡چ试都وک¯ن»¥ه¼‚ه¸¸ن¸و–ن¸؛ن¾وچ®ï¼Œè؟™ه؟…然ن¼ڑه¯¹ç³»ç»ںه¼‚ه¸¸ç‚¹ه¸¦و¥è¾ƒه¤§çڑ„ه™ھéں³م€‚ن¸؛و¤وˆ‘ن»¬è؟ک需è¦پ细هŒ–هگ„ن¸ھن¸و–ه¼‚ه¸¸çڑ„و‰“点,وژ’除ن¸چه؟…è¦پçڑ„ه¹²و‰°م€‚

#### ن¸€è‡´و€§é—®é¢ک

转ه‹è؟‡ç¨‹ن¸وˆ‘ن»¬ه®é™…ن¸ٹهگŒو—¶هپڑن؛†و•°وچ®و¨،ه‹ن¼کهŒ–è؟پ移,ه¯¹ه¤–ن¸؛ن؛†ن؟è¯پو–°è€پç³»ç»ںè،Œن¸؛ه±و€§çڑ„ن¸€è‡´و€§ï¼Œوˆ‘ن»¬è؟کé¢ن¸´ن»¥ن¸‹ه‡ ن¸ھوŒ‘وˆکï¼ڑ

* çپ°ه؛¦و•°وچ®éœ€è¦پهڈŒه†™و–°è€پن؛¤ن»کç³»ç»ںه؛“è،¨ï¼Œه¦‚ن½•ن؟è¯پهڈŒن¾§ه؛•ه±‚و•°وچ®çڑ„ن¸€è‡´و€§ï¼ں

* ه؛•ه±‚و•°وچ®ن¸€è‡´ن¸چç‰ن؛ژه¯¹ه¤–وœچهٹ،وژ¥هڈ£و•°وچ®é€ڈه‡؛ن¸€è‡´ï¼ŒهڈŒن¾§وœچهٹ،ه؛”用ه±‚é¢و€ژن¹ˆن؟è¯پو•°وچ®çڑ„ن¸€è‡´و€§ï¼ں

* 订هچ•éک؟و³¢ç½—ه±¥ç؛¦ç؛؟ه’Œن؛¤ن»کçڑ„ن¸ٹن¸‹و¸¸و•°وچ®و•°وچ®وœ€ç»ˆن¸€è‡´و€§و€ژن¹ˆن؟è¯پو€ژن¹ˆéھŒè¯پï¼ں

ن¸€è‡´و€§çڑ„ن؟è¯پ,هˆ«و— ن»–و³•ï¼Œهڈھ能é€ڑè؟‡و¯”ه¯¹و¥هپڑم€‚ن½†هœ¨هپڑو¯”ه¯¹çڑ„و—¶ه€™وˆ‘ن»¬è؟ک需è¦پ考虑هˆ°و¯”ه¯¹وœ¬è؛«هڈھوک¯وˆ‘ن»¬éھŒè¯پè؟پ移系ç»ںو£ç،®و€§هڈٹ稳ه®ڑو€§çڑ„ن¸€éƒ¨هˆ†ه±و—پ路,ه¹¶éç”ںن؛§çژ¯ه¢ƒçڑ„ه؟…é،»هٹں能م€‚هچ³وˆ‘ن»¬ه¾—考虑è؟™éƒ¨هˆ†هٹں能ه¯¹çژ°وœ‰ç³»ç»ںهڈ¯èƒ½é€ وˆگçڑ„هژ‹هٹ›م€‚è؟™éƒ¨هˆ†هژ‹هٹ›ه؛”该وک¯éڑڈç€ç³»ç»ںéھŒè¯په®Œو¯•وک¯هڈ¯ه¼€ه…³çڑ„,هژ‹هٹ›ه¤§ه°ڈه؛”éڑڈç³»ç»ںçڑ„è،¨çژ°هڈ¯éڑڈو—¶è°ƒèٹ‚م€‚ن¸چ至ن؛ژه› ن¸؛éھŒè¯پو‹–ه®ن؛†ç”ںن؛§ه؛”用م€‚و‰€ن»¥وˆ‘ن»¬ه¯¹و¯”ه¯¹çڑ„هں؛وœ¬è¦پو±‚وک¯ï¼ڑ能ن¸€é”®ه¼€ه…³ï¼Œهڈ¯ç›‘وژ§هڈ¯è؟½و؛¯م€‚除ن؛†è؟™ن؛›ه…±و€§ï¼Œه…·ن½“è؟که؛”هپڑهˆ°ن»¥ن¸‹ه‡ 点ï¼ڑ

* é’ˆه¯¹ه؛•ه±‚و•°وچ®و¯”ه¯¹ï¼ڑ

* و¯”ه¯¹ه؛”وک¯ه‡†ه®و—¶çڑ„,ه¦‚هڈھو¯”ه¯¹30هˆ†é’ںه‰چçڑ„و•°وچ®م€‚

* و¯”ه¯¹و•°وچ®وک¯هں؛ن؛ژو—¶é—´هڈ¯هˆ†و®µé‡‡و ·çڑ„,ه¦‚هڈھو¯”ه¯¹10هˆ†é’ںن»¥ه†…ن؛§ç”ںçڑ„و•°وچ®م€‚

* ن¸؛ن؛†و–¹ن¾؟وژ§هˆ¶ï¼Œو ¹وچ®وƒ…ه†µن»¥ن¸ٹç–ç•¥هڈˆهڈ¯ن»¥وک¯هڈٹو—¶è°ƒèٹ‚çڑ„م€‚هچ³ه‡†ه®و—¶هپڈ移é‡ڈهڈ¯è°ƒèٹ‚,هˆ†و®µé‡‡و ·çھ—هڈ£ه¤§ه°ڈهڈ¯è°ƒèٹ‚م€‚

ه…·ن½“ه®و–½و–¹و،ˆه¦‚ن¸‹ï¼ڑ

* é’ˆه¯¹ه؛”用ه±‚و•°وچ®و¯”ه¯¹ï¼ڑ

* ن»£çگ†ه±‚وژ¥و”¶è¯·و±‚هگژ,و¯”ه¯¹ه؛”وک¯ه¼‚و¥çڑ„,ن¸چه½±ه“چوژ¥هڈ£ه“چه؛”耗و—¶م€‚

* و¯”ه¯¹ç²’ه؛¦è¦په°ڈ,ه؛”细هŒ–هˆ°وژ¥هڈ£م€‚

* 识هˆ«çپ°ه؛¦و•°وچ®ï¼Œهڈھهپڑوœ‰و•ˆو¯”ه¯¹م€‚

ه…·ن½“ه®و–½و–¹و،ˆه¦‚ن¸‹ï¼ڑ

و— è®؛و•°وچ®ه±‚é¢è؟کوک¯وژ¥هڈ£ه±‚é¢ه‡؛çژ°و¯”ه¯¹ن¸چن¸€è‡´ï¼Œه؛”ç«‹هˆ»هژ»هˆ†وگوک¯ن»€ن¹ˆهژںه› ه¯¼è‡´ن¸چن¸€è‡´م€‚解ه†³و ¹ه› é€گو¥é™چه™ھ,هڈھ至و¯”ه¯¹ه·®ه¼‚هœ¨وˆ‘ن»¬è®¤ن¸؛هڈ¯وژ¥هڈ—çڑ„范ه›´ه†…م€‚

* é’ˆه¯¹ن¸ٹن¸‹و¸¸و•°وچ®وœ€ç»ˆن¸€è‡´و€§ï¼ڑ

* ه…¨é‡ڈو•°وچ®و ¸ه¯¹

* ن¸»ه¹²é“¾è·¯وœ€ç»ˆن¸€è‡´و€§و ¸ه¯¹

ç»ڈè؟‡و•°وچ®ه‡†ه®و—¶و¯”ه¯¹ï¼Œوژ¥هڈ£ه®و—¶ه¼‚و¥و¯”ه¯¹ï¼Œه…¶ه®هں؛وœ¬هڈ¯ن»¥ç،®è®¤و–°è€پç³»ç»ں能هٹ›è،Œن¸؛ه±و€§ه¯¹ç‰و€§م€‚然而稳ه®ڑه¤§ن؛ژن¸€هˆ‡ï¼Œè¦پ百هˆ†ç™¾ç،®ه®ڑè؟ک需è¦پt+1و•°وچ®و ¸éھŒم€‚هچ³ن»ژه…¨ه±€و•°وچ®è§’ه؛¦çœ‹و–°è€پç³»ç»ں转وچ¢çڑ„ه½±ه“چم€‚è؟™é‡Œن»¥ن¸»ه¹²é“¾è·¯ه‘¼هچ•ه¤ڑو—¥وˆگهٹںçژ‡ن¸؛ن¾‹هپڑ简è¦پ说وکژم€‚ه¦‚ن¸‹ه›¾و‰€ç¤؛,ه¤ڑو—¥ن¹ژهچ•وˆگهٹںçژ‡هں؛وœ¬هœ¨99.9977%ه·¦هڈ³ï¼Œهڈ¯ن»¥è®¤ن¸؛و–°è€پç³»ç»ںن»£çگ†هˆ‡وچ¢ن؛¤ن»کوˆگهٹںçژ‡هں؛وœ¬è،¨çژ°ç¨³ه®ڑم€‚

### وœھو¥

وˆھو¢و¤و–‡و”¥ه†™و—¶é—´ï¼Œé¥؟ن؛†ن¹ˆن؛¤ن»کن¸ه؟ƒه·²ç»ڈه®Œوˆگن؛†و•´ن¸ھç³»ç»ںçڑ„è¯è¨€è½¬وچ¢ï¼Œوµپé‡ڈن¹ںه·²ç»ڈ100%هˆ‡وچ¢ن»£çگ†هˆ°و–°ç³»ç»ں,ه¤„ن؛ژوµپé‡ڈهˆ‡وچ¢çڑ„第ن¸‰éک¶و®µم€‚结هگˆو—¥ه¸¸ç³»ç»ںç»´وٹ¤ن¸ژ需و±‚è؟ن»£ه®è·µï¼Œوˆ‘ن»¬ن»چ需è¦په†چن»¥ن¸‹ه‡ ن¸ھو–¹é¢è؟›è،Œو›´و·±ه…¥çڑ„و€è€ƒï¼ڑ

* 转ه‹è؟‡ç¨‹ن¸ن¸؛ن؛†هœ¨وک“وµ‹ï¼Œهڈ¯و ¸ه¯¹هگŒو—¶ن¸ژpythonçڑ„“é”و³•â€ه§؟هٹ؟و–—ن؛‰ن¸و‰¾ه¹³è،،,部هˆ†é€»è¾‘وک¯"ç؛¯ç؟»è¯‘"çڑ„,هگژوœںç»´وٹ¤è؟‡ç¨‹ه¾ˆç—›è‹¦ï¼Œو‰€ن»¥وˆ‘ن»¬éœ€è¦په‡ و¬،ن¸چه°ڈçڑ„é‡چو„و¥è¾¾هˆ°ن»£ç په±‚é¢çڑ„ه’Œè°گم€‚

* ن¸چو–监وژ§é™چه™ھ,وŒپç»ç»†هŒ–监وژ§ç²’ه؛¦ï¼Œç›‘وژ§وک¯وœچهٹ،稳ه®ڑهں؛çں³م€‚

* ن؛¤ن»کن¸ه؟ƒو•°وچ®ه¤§ç›که»؛设,ن»ژو•°وچ®ه±‚é¢é‡ڈهŒ–观وµ‹وˆ‘ن»¬çڑ„ن؛¤ن»کè´¨é‡ڈم€‚و•°وچ®é©±هٹ¨,و•°ه—è؟گèگ¥ن»ژو•°وچ®هŒ–و€ç»´ن¼کهŒ–وˆ‘ن»¬çڑ„وµپ程,وڈگé«کوˆ‘ن»¬çڑ„وœچهٹ،م€‚

### و–¹و³•è®؛و²‰و·€

ه‡،و¤ن»¥ن¸ٹ,وœچهٹ،ç³»ç»ں转ه‹è؟پ移ه½’结ن؛ژه¼€هڈ‘者çگ†è§£ن¸ژ认çں¥ï¼Œé،¹ç›®çڑ„稳ه®ڑه®و–½ه½’结ن؛ژه¼€هڈ‘者ه¥—è·¯و–¹و³•è؟گ用م€‚هڈ¯ن»¥ç®€هچ•è؟›ن¸€و¥وڈگ炼ن¸؛ن»¥ن¸‹و–¹و³•è®؛ï¼ڑ

* è¯¦ç»†è°ƒç ”ï¼Œه®¢è§‚é—®é¢کهڈٹو»،足ن¸ڑهٹ،çڑ„ç³»ç»ںوک¯ه¤چو‚çڑ„ï¼Œè¯¦ç»†è°ƒç ”هپڑه¥½ه‡†ه¤‡وک¯ه؟…é،»çڑ„م€‚

* وŒپç»ç›‘وژ§ï¼Œو„ںçں¥ç³»ç»ںçڑ„è´¨é‡ڈوک¯وœچهٹ،è´¨é‡ڈه؛¦é‡ڈçڑ„第ن¸€و¥ï¼Œن¸چو–وŒپç»çڑ„监وژ§و‰چ能走çڑ„و›´ç¨³م€‚

* 稳و¥è؟‡و¸،,ن؛’èپ”网系ç»ںوœچهٹ،é«کهڈ¯ç”¨ç¨³ه®ڑن¸چه®¹ه•†é‡ڈم€‚

* é—®é¢کهڈ‘çژ°و ¹ه› 解ه†³ï¼Œه°ڈçڑ„é—®é¢کهڈ¯èƒ½éڑگè—ڈه¤§çڑ„bug,认çœںه¯¹ه¾…究ه…¶و ¹وœ¬ï¼Œه¤چç›ک->و€»ç»“->وڈگهچ‡م€‚

* ه½’ç؛³و€»ç»“ن¸ڑهٹ،ه†چ认çں¥م€‚

ه…³ن؛ژ认çں¥وڈگهچ‡çڑ„ه‡ ن¸ھه°ڈ点ï¼ڑ

* ه¯¹ن؛ژو¯ڈن¸€ن½چه·¥ç¨‹ه¸ˆï¼Œه¼€هڈ‘é«که¹¶هڈ‘ه¤§وµپé‡ڈç³»ç»ںوک¯وŒ‘وˆکن¹ںوک¯وœ؛éپ‡م€‚و—¶هˆ»ن؟وŒپè؟›هڈ–ه¦ن¹ ه؟ƒو€پ,ه¢ه¼؛è‡ھè؛«è½¯ç´ è´¨م€‚

* هˆ†ه¸ƒه¼ڈوƒ…ه†µن¸‹ï¼Œو‰؟认系ç»ںه¹¶éç»ه¯¹100%هڈ¯é ,و¯ڈن¸€ن¸ھçژ¯èٹ‚都è¦پ考虑“ه¤±è´¥â€ن؛†و€ژن¹ˆهٹ,ن¸چهگŒçڑ„هœ؛و™¯وˆ‘ن»¬éœ€è¦پهœ¨APه’ŒCPن¹‹é—´ن½œه‡؛وٹ‰و‹©م€‚ه¦‚هڈŒé“¾è·¯è°ƒç”¨ن؟è¯پهڈ¯é ,ه¼‚و¥é‡چ试ن؟è¯پé،؛ه؛ڈوœ€ç»ˆن¸€è‡´ç‰م€‚

* ه‡؛ن؛†é—®é¢که؟«é€ںوپ¢ه¤چوک¯ن¸ھو°¸وپ’çڑ„è¯é¢ک,و²،وœ‰â€œو€ژن¹ˆو ·â€œوœ€ه؟«هڈھوœ‰â€è؟™و ·â€و›´ه؟«م€‚ç²¾ه‡†ه®ڑن½چç«‹هچ³وپ¢ه¤چ,ه¦‚ن½•ه°†è؟™ن¸ھè؟‡ç¨‹è€—و—¶é™چهˆ°و›´ن½ژه€¼ه¾—و·±ه…¥و€è€ƒم€‚

**ن½œè€…ن؟،وپ¯ï¼ڑ**وژو°ï¼Œèٹ±هگچé،¹ه؛,ه½“ه‰چن¸»è¦پè´ںè´£é¥؟ن؛†ن¹ˆن؛¤ن»ک领هںںç³»ç»ںم€‚

[هژںو–‡é“¾وژ¥](https://yq.aliyun.com/articles/726315?utm_content=g_1000088284)

وœ¬و–‡ن¸؛ن؛‘و –社هŒ؛هژںهˆ›ه†…ه®¹ï¼Œوœھç»ڈه…پ许ن¸چه¾—转载م€‚

- 2019-11-19 15:37

- وµڈ览 354

- 评è®؛(0)

- هˆ†ç±»:éوٹ€وœ¯

- وں¥çœ‹و›´ه¤ڑ

相ه…³وژ¨èچگ

و€»ç»“و¥è¯´ï¼Œ"é¥؟ن؛†ن¹ˆAxureه…ƒن»¶ه؛“.rar"وک¯ن¸€ن¸ھه¼؛ه¤§çڑ„设è®،资و؛گ,ه®ƒه°†Element UIçڑ„ن¼ک雅设è®،ه’Œوک“用و€§ه¸¦ه…¥ن؛†Axure,ن½؟ه¾—设è®،ه¸ˆهڈ¯ن»¥و›´ن¾؟وچ·هœ°هˆ›ه»؛ه‡؛符هگˆé¥؟ن؛†ن¹ˆه“پ牌و ‡ه‡†çڑ„é«کè´¨é‡ڈهژںه‹م€‚ه¯¹ن؛ژن»»ن½•ç†ںو‚‰Axureه¹¶éœ€è¦پ设è®،ç±»ن¼¼é¥؟ن؛†ن¹ˆ...

"é¥؟ن؛†ن¹ˆهگژهڈ°ç®،çگ†ç³»ç»ں"وک¯ن¸€ن¸ھهں؛ن؛ژJSPوٹ€وœ¯و„ه»؛çڑ„هœ¨ç؛؟订é¤گه¹³هڈ°çڑ„هگژهڈ°ç®،çگ†ç³»ç»ںم€‚è؟™ن¸ھç³»ç»ںن¸»è¦پ用ن؛ژç®،çگ†é¥؟ن؛†ن¹ˆه¹³هڈ°ن¸çڑ„ه•†ه®¶م€پ用وˆ·م€پé€پé¤گه‘کم€پèڈœهچ•م€پèڈœه“پن»¥هڈٹ评è®؛ç‰و ¸ه؟ƒن¸ڑهٹ،ه…ƒç´ ,وڈگن¾›ن؛†ه®Œو•´çڑ„و•°وچ®ه¢هˆ و”¹وں¥ï¼ˆCRUD)هٹں能,...

وٹ¥ه‘ٹو ‡é¢ک“2020-2021ن¸ه›½ه¤–هچ–è،Œن¸ڑهڈ‘ه±•هˆ†وگوٹ¥ه‘ٹâ€ن»¥هڈٹوڈڈè؟°ن¸وڈگهˆ°çڑ„“éک؟里و–°وœچهٹ،ç ”ç©¶ن¸ه؟ƒxé¥؟ن؛†ن¹ˆهں¹è®ه¦ن¹ ن¸ه؟ƒâ€وک¾ç¤؛,وœ¬وٹ¥ه‘ٹوک¯ç”±éک؟里系çڑ„ç ”ç©¶وœ؛و„ن¸ژé¥؟ن؛†ن¹ˆهگˆن½œهڈ‘ه¸ƒçڑ„,é‡چ点ه…³و³¨ن؛†2020至2021ه¹´وœںé—´ن¸ه›½ه¤–هچ–è،Œن¸ڑçڑ„هڈ‘ه±•...

é¥؟ن؛†ن¹ˆه•†ه®¶ه®¢وˆ·ç«¯وک¯é¥؟ن؛†ن¹ˆه•†ه®¶ن¸ه؟ƒوژ¨ه‡؛çڑ„pcه®¢وˆ·ç«¯ï¼ŒPC端版وœ¬ه…¨و–°ن¸ٹç؛؟ï¼پو›´ن¾؟وچ·çڑ„و“چن½œç•Œé¢ï¼Œو›´و¸…و™°çڑ„ç®،çگ†و¨،ه—,هٹ©هٹ›ه•†ه®¶é«کو•ˆوژ¥هچ•ï¼Œç”ںو„ڈ爆و£ڑن¹ں能轻و¾ه؛”ه¯¹ï¼Œé¥؟ن؛†ن¹ˆه•†ه®¶ç”¨وˆ·éه¸¸é€‚用,赶ه؟«ن¸‹è½½ن½؟用هگ§ï¼پ آ é¥؟ن؛†ن¹ˆ...

é€ڑè؟‡هˆ†وگè؟™ن¸ھو؛گç پ,وˆ‘ن»¬هڈ¯ن»¥و·±ه…¥ن؛†è§£é¥؟ن؛†ن¹ˆH5é،µé¢çڑ„و¶و„م€پوٹ€وœ¯و ˆن»¥هڈٹه®çژ°ç»†èٹ‚م€‚ هœ¨è؟™ن¸ھé،¹ç›®çڑ„و؛گن»£ç پن¸ï¼Œهڈ¯èƒ½ن¼ڑهŒ…هگ«ن»¥ن¸‹éƒ¨هˆ†ï¼ڑ 1. HTML و–‡ن»¶ï¼ڑه®ڑن¹‰é،µé¢ç»“و„ه’Œه†…ه®¹م€‚ 2. CSS و–‡ن»¶ï¼ڑè´ںè´£é،µé¢و ·ه¼ڈه’Œه¸ƒه±€ï¼Œهڈ¯èƒ½ن½؟用ن؛†CSS...

و€»ç»“èµ·و¥ï¼Œ"é¥؟ن؛†ن¹ˆه•†وˆ·و•°وچ®é‡‡é›†çˆ¬è™«"وک¯ن¸€ن¸ھهˆ©ç”¨Python爬虫وٹ€وœ¯ن»ژé¥؟ن؛†ن¹ˆه¹³هڈ°èژ·هڈ–ه•†وˆ·و•°وچ®çڑ„é،¹ç›®ï¼Œو¶‰هڈٹهˆ°و•°وچ®é‡‡é›†ه·¥ه…·çڑ„è؟گ用م€پو•°وچ®é›†çڑ„ç”ںوˆگن»¥هڈٹو•°وچ®çڑ„و½œهœ¨ه؛”用م€‚هœ¨ه®é™…و“چن½œن¸ï¼Œوˆ‘ن»¬éœ€è¦په…³و³¨هگˆو³•و€§ه’Œن¼¦çگ†é—®é¢ک,هگŒو—¶ه……هˆ†...

ه¾®ن؟،ه°ڈ程ه؛ڈ ن؛’èپ”网è،Œن¸ڑ ن»؟é¥؟ن؛†ن¹ˆ (و؛گن»£ç پ+وˆھه›¾ï¼‰ه¾®ن؟،ه°ڈ程ه؛ڈ ن؛’èپ”网è،Œن¸ڑ ن»؟é¥؟ن؛†ن¹ˆ (و؛گن»£ç پ+وˆھه›¾ï¼‰ه¾®ن؟،ه°ڈ程ه؛ڈ ن؛’èپ”网è،Œن¸ڑ ن»؟é¥؟ن؛†ن¹ˆ (و؛گن»£ç پ+وˆھه›¾ï¼‰ه¾®ن؟،ه°ڈ程ه؛ڈ ن؛’èپ”网è،Œن¸ڑ ن»؟é¥؟ن؛†ن¹ˆ (و؛گن»£ç پ+وˆھه›¾ï¼‰ه¾®ن؟،ه°ڈ程ه؛ڈ ...

首ه…ˆï¼Œوˆ‘ن»¬è¦پوکژ白,“é¥؟ن؛†ن¹ˆâ€ن½œن¸؛ن¸€ن¸ھوˆگهٹںçڑ„هœ¨ç؛؟ه¤–هچ–ه¹³هڈ°ï¼Œه…¶èƒŒهگژçڑ„وٹ€وœ¯و ˆه؟…然و¶µç›–ن؛†ه‰چ端用وˆ·ç•Œé¢م€پهگژ端وœچهٹ،م€پو•°وچ®ه؛“设è®،م€پ缓هکç–ç•¥م€پهˆ†ه¸ƒه¼ڈç³»ç»ںم€پو¶ˆوپ¯éکںهˆ—م€پè´ںè½½ه‡è،،ç‰ه¤ڑن¸ھو–¹é¢م€‚و؛گن»£ç پن¸هڈ¯èƒ½هŒ…هگ«ن»¥ن¸‹ه…³é”®çں¥è¯†ç‚¹ï¼ڑ...

1. è؟گè،Œ “é¥؟ن؛†ن¹ˆه‰چ端网é،µé،¹ç›®â€ ,و¼”ç¤؛é،µé¢و•ˆوœم€‚ 2. وœ¬é،¹ç›®هڈ‚ç…§ “é¥؟ن؛†ن¹ˆه®ک网网é،µç‰ˆâ€هˆ¶ن½œï¼Œو¼”ç¤؛é¥؟ن؛†ن¹ˆه®ک网و•ˆوœم€‚é¥؟ن؛†ن¹ˆç½‘é،µç‰ˆï¼ڑhttp://h5.ele.me/ 3. وœ¬é،¹ç›®ن¸çڑ„首é،µï¼Œه®Œه…¨وŒ‰ç…§â€œé¥؟ن؛†ن¹ˆç½‘é،µç‰ˆâ€ه®é™…و•ˆوœهˆ¶ن½œï¼Œ...

ه¾®ن؟،ه°ڈ程ه؛ڈو؛گç پ-ن»؟é¥؟ن؛†ن¹ˆ.zipه¾®ن؟،ه°ڈ程ه؛ڈو؛گç پ-ن»؟é¥؟ن؛†ن¹ˆ.zipه¾®ن؟،ه°ڈ程ه؛ڈو؛گç پ-ن»؟é¥؟ن؛†ن¹ˆ.zipه¾®ن؟،ه°ڈ程ه؛ڈو؛گç پ-ن»؟é¥؟ن؛†ن¹ˆ.zipه¾®ن؟،ه°ڈ程ه؛ڈو؛گç پ-ن»؟é¥؟ن؛†ن¹ˆ.zipه¾®ن؟،ه°ڈ程ه؛ڈو؛گç پ-ن»؟é¥؟ن؛†ن¹ˆ.zipه¾®ن؟،ه°ڈ程ه؛ڈو؛گç پ-ن»؟é¥؟ن؛†ن¹ˆ.zipه¾®ن؟،ه°ڈ程ه؛ڈ...

م€گé«کن»؟é¥؟ن؛†ن¹ˆçڑ„و؛گن»£ç پم€‘é،¹ç›®وک¯ن¸€ن¸ھ用ن؛ژه¦ن¹ ه’Œه®è·µçڑ„软ن»¶ه¼€هڈ‘ç¤؛ن¾‹ï¼Œه®ƒو¨،ن»؟ن؛†çœںه®çڑ„é¥؟ن؛†ن¹ˆه؛”用çڑ„هٹں能ه’Œç•Œé¢è®¾è®،م€‚è؟™ن¸ھé،¹ç›®ه¯¹ن؛ژهˆه¦è€…ه’Œوœ‰ç»ڈéھŒçڑ„ه¼€هڈ‘者و¥è¯´éƒ½وک¯ن¸€ن¸ھه¾ˆه¥½çڑ„ه¦ن¹ 资و؛گ,ه› ن¸؛ه®ƒو¶µç›–ن؛†ç§»هٹ¨ه؛”用ه¼€هڈ‘çڑ„ه¤ڑن¸ھه…³é”®...

2. **Material Design**ï¼ڑé¥؟ن؛†ن¹ˆApp采用ن؛†Googleçڑ„Material Design设è®،规范,è؟™وک¯ن¸€ç§چçژ°ن»£م€په“چه؛”ه¼ڈçڑ„用وˆ·ç•Œé¢è®¾è®،è¯è¨€ï¼Œن»؟é¥؟ن؛†ن¹ˆé،¹ç›®هڈ¯èƒ½ن¼ڑéپµه¾ھè؟™ن¸€è§„范و¥هˆ›ه»؛ç•Œé¢ه…ƒç´ م€‚ 3. **ه¸ƒه±€ç®،çگ†ه™¨ï¼ˆLayout Managers)**ï¼ڑ...

é¥؟ن؛†ن¹ˆ-5.4.ipa

م€گé¥؟ن؛†ن¹ˆè®¢é¤گ网é،¹ç›®é،µé¢م€‘وک¯ن¸€ن¸ھو¶µç›–ن؛†ه…¨و–¹ن½چé،µé¢ن»£ç پçڑ„é،¹ç›®ï¼Œو—¨هœ¨وڈگن¾›ن¸€ن¸ھه®Œو•´çڑ„هœ¨ç؛؟订é¤گه¹³هڈ°ن½“éھŒم€‚è؟™ن¸ھé،¹ç›®ن¸چن»…هŒ…هگ«ه¸¸è§„çڑ„هٹں能و€§é،µé¢ï¼Œه¦‚首é،µم€پé¤گهژ…هˆ—è،¨م€پèڈœه“په±•ç¤؛م€پè´ç‰©è½¦م€پ订هچ•ه¤„çگ†ç‰ï¼Œè؟ک特هˆ«هٹ ه…¥ن؛†404错误é،µé¢...

وœ¬و–‡ه°†è¯¦ç»†è®²è§£â€œه®Œو•´ç¾ژه›¢é¥؟ن؛†ن¹ˆه¤–هچ–ç؛¢هŒ…و؛گç پâ€è؟™ن¸€ن¸»é¢ک,ن¸»è¦پو¶µç›–ه¤–هچ–ç؛¢هŒ…و؛گç پم€پé¥؟ن؛†ن¹ˆç؛¢هŒ…و؛گç پم€په¤–هچ–ç؛¢هŒ…ه°ڈ程ه؛ڈو؛گç پن»¥هڈٹç¾ژه›¢ه¤–هچ–ç؛¢هŒ…و؛گç پçڑ„相ه…³çں¥è¯†ç‚¹م€‚ 首ه…ˆï¼Œوˆ‘ن»¬è¦پçگ†è§£و؛گç پçڑ„و¦‚ه؟µم€‚و؛گç پوک¯ç¨‹ه؛ڈه‘ک用é«کç؛§è¯è¨€ç¼–ه†™...

### é¥؟ن؛†ن¹ˆو¶و„هˆ†وگن¸ژه…³é”®وٹ€وœ¯ç‚¹ #### ن¸€م€په¼•è¨€ éڑڈç€ن؛’èپ”网وٹ€وœ¯çڑ„ه؟«é€ںهڈ‘ه±•ï¼Œé«که¹¶هڈ‘هœ؛و™¯ن¸‹çڑ„ç³»ç»ں设è®،وˆگن¸؛هگ„ه¤§ن؛’èپ”网ه…¬هڈ¸é¢ن¸´çڑ„é‡چè¦پوŒ‘وˆکن¹‹ن¸€م€‚é¥؟ن؛†ن¹ˆن½œن¸؛ه›½ه†…çں¥هگچçڑ„هœ¨ç؛؟ه¤–هچ–订é¤گه¹³هڈ°ï¼Œهœ¨ه¤„çگ†وµ·é‡ڈ用وˆ·è¯·و±‚و–¹é¢ç§¯ç´¯ن؛†...

ن»؟é¥؟ن؛†ن¹ˆه¤–هچ–و؛گç پç³»ç»ں集وˆگé¥؟ن؛†ن¹ˆم€پç¾ژه›¢م€پ百ه؛¦ç‰ه¤–هچ–ç³»ç»ںهٹں能ن¸؛ه•†ه®¶وڈگن¾›ه•†ه“په±•ç¤؛م€پو´»هٹ¨ن؟ƒé”€م€پن؛§ه“پè´ن¹°م€پ移هٹ¨و”¯ن»کç‰هٹں能,让用وˆ·ن؛«هڈ—è½»و¾م€پ简هچ•çڑ„è´ç‰©ن½“éھŒم€‚ه¸®هٹ©ه•†ه®¶ه؟«é€ںه»؛立移هٹ¨ه¸‚هœ؛,è؟…é€ںوٹ¢هچ هچƒن؛؟و‰‹وœ؛用وˆ·م€‚ ه؟«é€ں...

و؛گç پé€ڑه¸¸وŒ‡çڑ„وک¯ç¼–程è¯è¨€ç¼–ه†™çڑ„وœھç»ڈ编译çڑ„هژںه§‹ç¨‹ه؛ڈ,è؟™é‡Œè،¨ç¤؛çڑ„وک¯ç”¨ن؛ژهˆ›ه»؛ن¸€ن¸ھ订é¤گAPPçڑ„ه…¨éƒ¨ن»£ç پم€‚ م€گوڈڈè؟°هˆ†وگم€‘ï¼ڑ“ن»؟é¥؟ن؛†ن¹ˆè®¢é¤گAPPو؛گç پ,ه®Œو•´çڑ„و؛گç پهˆ†ن؛«ï¼Œهˆ†ن؛«ç»™و›´ه¤ڑ需è¦پçڑ„وœ‹هڈ‹م€‚â€è؟™هڈ¥è¯è¯´وکژè؟™ن»½èµ„و؛گوک¯ه®Œو•´çڑ„,...

م€گVue.js و،†و¶è¯¦è§£م€‘ Vue.js وک¯ن¸€ن¸ھè½»é‡ڈç؛§م€پé«کو€§èƒ½çڑ„ه‰چ端JavaScriptو،†و¶ï¼Œç”±ه°¤...é€ڑè؟‡ه¯¹"é¥؟ن؛†ن¹ˆه‰چ端و،ˆن¾‹و؛گç پ"çڑ„ه¦ن¹ ,ه¼€هڈ‘者ن¸چن»…能و·±ه…¥çگ†è§£Vueçڑ„هں؛وœ¬ç”¨و³•ï¼Œè؟ک能وژŒوڈ،ه¦‚ن½•هœ¨ه®é™…é،¹ç›®ن¸è؟گ用è؟™ن؛›وٹ€وœ¯ï¼Œوڈگهچ‡ه‰چ端ه¼€هڈ‘能هٹ›م€‚

é¥؟ن؛†ن¹ˆé¤گ饮ç®،çگ†ç³»ç»ں