ç³»هˆ—و–‡ç«

è،¨و ¼هکه‚¨ه¦‚ن½•ه®çژ°é«کهڈ¯é ه’Œé«کهڈ¯ç”¨

è،¨و ¼هکه‚¨ه¦‚ن½•ه®çژ°è·¨هŒ؛هںںçڑ„ه®¹çپ¾

ه‰چ言

وœ¬و–‡ن¼ڑن»‹ç»چن¸€و¬¾هˆ†ه¸ƒه¼ڈNoSQLه¦‚ن½•ه®çژ°و•°وچ®é«کهڈ¯é ه’Œوœچهٹ،é«کهڈ¯ç”¨ï¼Œè؟™وک¯ن¸€و¬¾ن؛‘ن¸ٹçڑ„NoSQLوœچهٹ،,هڈ«هپڑè،¨و ¼هکه‚¨م€‚ه¯¹ن؛ژهˆ†ه¸ƒه¼ڈNoSQL,ه¤§ه®¶هڈ¯èƒ½ن¼ڑوƒ³هˆ°ه¾ˆه¤ڑهگچه—,و¯”ه¦‚HBaseم€پCassandra,AWSçڑ„DynamoDBç‰ï¼Œè؟™ç±»NoSQLهœ¨è®¾è®،ن¹‹هˆه°±ن½œن¸؛ن¸€ن¸ھهˆ†ه¸ƒه¼ڈç³»ç»ںو”¯وŒپ超ه¤§è§„و¨،çڑ„و•°وچ®é‡ڈن¸ژه¹¶هڈ‘م€‚و¤ه¤–ه¤§ه®¶هڈ¯èƒ½è؟کن¼ڑوƒ³هˆ°MongoDBه’ŒRedis,è؟™ن¸¤ن¸ھن¹ںوڈگن¾›é›†ç¾¤هٹں能,ن½†وک¯ن¸€èˆ¬éœ€è¦پن؛؛ن¸؛çڑ„é…چç½®shardingه’Œه¤چهˆ¶é›†/ن¸»ن»ژç‰م€‚

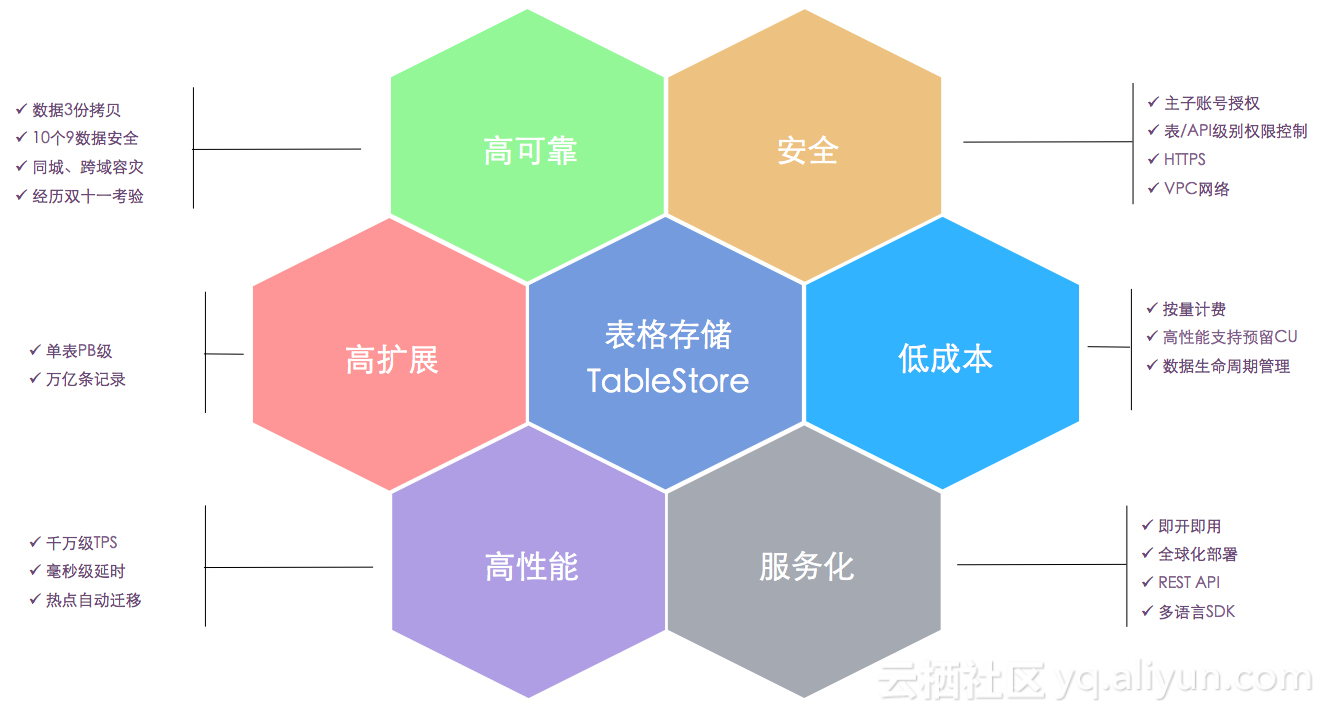

è،¨و ¼هکه‚¨وک¯éک؟里è‡ھن¸»ç ”هڈ‘çڑ„ن¸€و¬¾NoSQLوœچهٹ،,هœ¨و¶و„设è®،ن¸ٹهڈ‚考ن؛†googleçڑ„bigtableè®؛و–‡ï¼Œن¸ژن¸ٹè؟°çڑ„HBaseم€پCassandraم€پDynamoDBوœ‰ن¸€ن؛›ç›¸ن¼¼ن¹‹ه¤„م€‚è،¨و ¼هکه‚¨çڑ„ن¸€ن؛›هٹں能ن¼کهٹ؟هڈ¯ن»¥è§پن¸‹ه›¾م€‚

وœ¬و–‡ن¼ڑé‡چ点ن»‹ç»چè،¨و ¼هکه‚¨هœ¨é«کهڈ¯é ه’Œé«کهڈ¯ç”¨و–¹é¢çڑ„وٹ€وœ¯م€‚è،¨و ¼هکه‚¨وŒ‰ç…§11ن¸ھ9çڑ„و•°وچ®هڈ¯é و€§ه’Œ4ن¸ھ9çڑ„وœچهٹ،هڈ¯ç”¨و€§è؟›è،Œو ‡ه‡†è®¾è®،,ن½œن¸؛ن¸€و¬¾ن؛‘وœچهٹ،,وڈگن¾›10ن¸ھ9çڑ„هڈ¯é و€§ه’Œ3ن¸ھ9çڑ„هڈ¯ç”¨و€§SLAم€‚

ه®¹é”™م€پé«کهڈ¯é م€پé«کهڈ¯ç”¨

ه®¹é”™م€پé«کهڈ¯é م€پé«کهڈ¯ç”¨وک¯ç›¸ن؛’ه…³èپ”çڑ„ه‡ ن¸ھو¦‚ه؟µم€‚ه®¹é”™وک¯وŒ‡ç³»ç»ں能ه¤ںه؟«é€ںو£€وµ‹هˆ°è½¯ن»¶وˆ–ç،¬ن»¶çڑ„و•…éڑœه¹¶ه؟«é€ںن»ژو•…éڑœن¸وپ¢ه¤چçڑ„能هٹ›ï¼Œه®¹é”™çڑ„ن¸€èˆ¬ه®çژ°و–¹ه¼ڈوک¯ه†—ن½™ï¼Œه†—ن½™هڈ¯ن»¥ن؟éڑœن¸€ن»½هڈوژ‰ç³»ç»ںن¸چهڈ—ه½±ه“چم€‚é«کهڈ¯é وک¯è،،é‡ڈو•°وچ®ه®‰ه…¨و€§ï¼Œé«کهڈ¯ç”¨وک¯è،،é‡ڈç³»ç»ںçڑ„هڈ¯ç”¨و—¶é—´ï¼Œن¸€èˆ¬é«کهڈ¯é ه’Œé«کهڈ¯ç”¨çڑ„وŒ‡و ‡éƒ½ç”¨ه‡ ن¸ھ9و¥è،¨ç¤؛م€‚

ه†—ن½™هڈ¯ن»¥ه®çژ°ه®¹é”™ï¼Œهœ¨و•°وچ®ه±‚é¢ن¸€èˆ¬è،¨çژ°ن¸؛و•°وچ®وœ‰ه¤ڑن¸ھه‰¯وœ¬ï¼Œن»»و„ڈن¸€ن»½وچںهڈن¸چن¼ڑه½±ه“چو•°وچ®ه®Œو•´و€§ï¼Œهœ¨وœچهٹ،ه±‚é¢هڈ¯ن»¥è،¨çژ°ن¸؛وœ‰ه¤ڑن¸ھوœچهٹ،èٹ‚点,ن»»و„ڈن¸€ن¸ھèٹ‚点ه®•وœ؛هڈ¯ن»¥ه°†وœچهٹ،è؟پ移هˆ°هڈ¦ه¤–çڑ„èٹ‚点م€‚وœچهٹ،é«کهڈ¯ç”¨ن¼ڑن¾èµ–ن؛ژو•°وچ®é«کهڈ¯é ,ه› ن¸؛هپ‡ه¦‚و•°وچ®çڑ„ه®Œو•´و€§éƒ½و²،وœ‰ن؟éڑœï¼Œé‚£ن¹ˆè°ˆن¸چن¸ٹوœچهٹ،çڑ„هڈ¯ç”¨و€§م€‚

ه®¹é”™ç³»ç»ںه¹¶éن¸€ه®ڑوک¯é«کهڈ¯ç”¨çڑ„,é«کهڈ¯ç”¨è،،é‡ڈçڑ„وک¯ç³»ç»ںçڑ„هڈ¯ç”¨و—¶é—´ï¼Œهپ‡ه¦‚ç³»ç»ںن¸چو”¯وŒپçƒهچ‡ç؛§ï¼Œوˆ–者ن¸چو”¯وŒپهٹ¨و€پو‰©ç¼©ه®¹ç‰ï¼Œه°±éœ€è¦پهپœوœ؛è؟›è،Œè؟گç»´و“چن½œï¼Œè؟™ن¹ںوک¯ن¸چو»،足é«کهڈ¯ç”¨çڑ„م€‚

ن¸؛ن؛†èژ·ه¾—و›´é«کçڑ„هڈ¯ç”¨و€§ï¼Œهڈ¯ن»¥ه°†ن¸¤ه¥—ç³»ç»ںوˆ–者ه¤ڑه¥—ç³»ç»ں组وˆگن¸»ه¤‡ï¼Œوگه»؛ه®¹çپ¾ï¼Œه¸¸è§پçڑ„و¯”ه¦‚هگŒهںژهڈŒوœ؛وˆ؟هœ؛و™¯م€‚هگŒهںژهڈŒوœ؛وˆ؟é…چهگˆè‡ھهٹ¨هˆ‡وچ¢وˆ–者ه؟«é€ںçڑ„ن؛؛ه·¥هˆ‡وچ¢ï¼Œهڈ¯ن»¥ن½؟ç³»ç»ںè¾¾هˆ°و›´é«کçڑ„هڈ¯ç”¨و€§م€‚و¤ه¤–,ن¸ڑهٹ،هڈ¯ن»¥ه¯¹ه؛”用è؟›è،Œن¸€ن؛›ه¼¹و€§çڑ„و¶و„设è®،,هœ¨وںگن؛›وœچهٹ،ه‡؛çژ°ه¼‚ه¸¸و—¶هڈ¯ن»¥è‡ھهٹ¨é™چç؛§ï¼Œوڈگé«کن¸ڑهٹ،çڑ„هڈ¯ç”¨و€§م€‚

è،¨و ¼هکه‚¨ه¦‚ن½•ه®çژ°é«کهڈ¯é ه’Œé«کهڈ¯ç”¨

ن¼ ç»ںçڑ„MySQLن¸»ه¤‡هگŒو¥و–¹و،ˆï¼Œه½“ن¸»ه؛“ه‡؛çژ°و•…éڑœو—¶ï¼ŒHAو¨،ه—ن¼ڑه°†وœچهٹ،è؟پ移هˆ°ه¤‡ه؛“,ه®çژ°é«کهڈ¯ç”¨م€‚è؟™ç§چو–¹ه¼ڈهکهœ¨çڑ„é—®é¢که°±وک¯ï¼Œه¦‚وœè¦پن؟éڑœو•°وچ®çڑ„ه¼؛ن¸€è‡´ï¼Œé‚£ن¹ˆن¸€ه®ڑè¦پن¸»ه؛“ه’Œه¤‡ه؛“都ه†™ه…¥وˆگهٹںو‰چ能è؟”ه›ï¼Œهچ³وœ€ه¤§ن؟وٹ¤و¨،ه¼ڈم€‚ه¦‚وœه¤‡ه؛“ه‡؛çژ°ن¸چهڈ¯ç”¨ï¼Œن¸»ه؛“ه†™ه…¥ن¹ںن¼ڑه¤±è´¥ï¼Œو‰€ن»¥ه®é™…ن¸ٹهڈ¯ç”¨و€§ه’Œن¸€è‡´و€§و— و³•ه…¼ه¾—م€‚

هˆ†ه¸ƒه¼ڈç³»ç»ںن¸ï¼Œهچ•وœ؛و•…éڑœçژ‡ç›¸هگŒوƒ…ه†µن¸‹ï¼Œé›†ç¾¤ن¸هکهœ¨هچ•وœ؛و•…éڑœçڑ„و¦‚çژ‡éڑڈç€é›†ç¾¤è§„و¨،ه¢هٹ 而ه¢هٹ ,é«کهڈ¯é ه’Œé«کهڈ¯ç”¨وˆگن¸؛هˆ†ه¸ƒه¼ڈç³»ç»ںوœ€هں؛وœ¬çڑ„设è®،ç›®و ‡م€‚هˆ†ه¸ƒه¼ڈç³»ç»ںن¸ï¼Œه®çژ°و•°وچ®é«کهڈ¯é ه¾€ه¾€é€ڑè؟‡ه¤ڑه‰¯وœ¬هٹ Paxosç‰هˆ†ه¸ƒه¼ڈن¸€è‡´و€§ç®—و³•ï¼Œه®çژ°é«کهڈ¯ç”¨ن¸€èˆ¬وک¯ه®çژ°ه؟«é€ںçڑ„و•…éڑœè؟پ移وœ؛هˆ¶ï¼Œه®çژ°çƒهچ‡ç؛§ه’Œهٹ¨و€پçڑ„و‰©ç¼©ه®¹م€‚

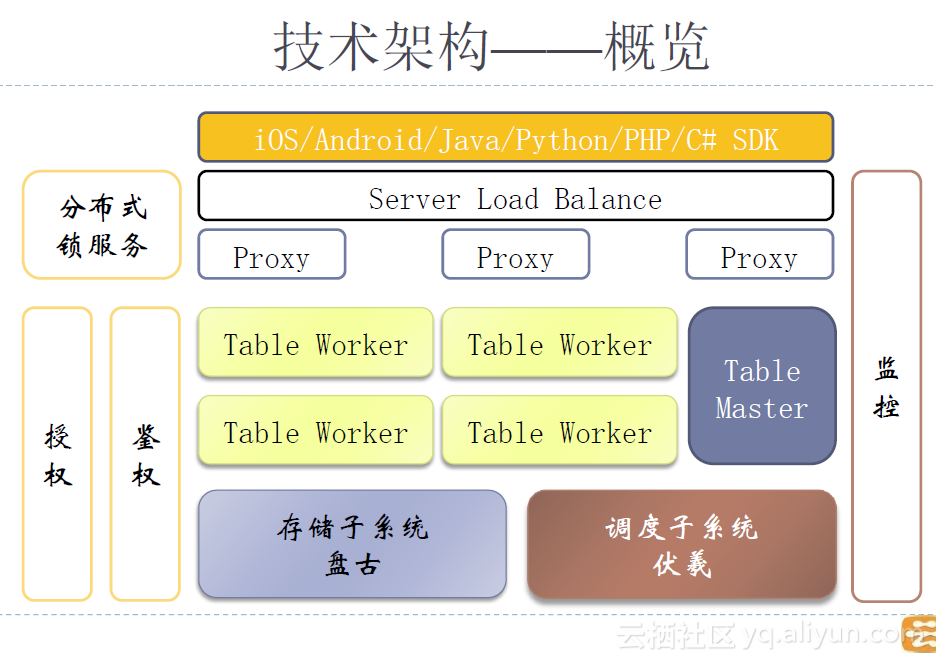

é‚£ن¹ˆè،¨و ¼هکه‚¨ه¦‚ن½•و¥ه®çژ°é«کهڈ¯é ه’Œé«کهڈ¯ç”¨ه‘¢ï¼Œوˆ‘ن»¬é¦–ه…ˆçœ‹ن¸‹é¢çڑ„و¶و„ه›¾ï¼ڑ

ه›¾ن¸çڑ„Table Workerن»£è،¨è،¨و ¼هکه‚¨çڑ„هگژ端وœچهٹ،èٹ‚点,هœ¨ه®ƒن¸‹ه±‚وœ‰ن¸€ن¸ھç³»ç»ںهڈ«هپڑç›کهڈ¤م€‚ç›کهڈ¤وک¯éک؟里è‡ھç ”çڑ„ن¸€و¬¾ه…ˆè؟›çڑ„هˆ†ه¸ƒه¼ڈهکه‚¨ç³»ç»ں,هˆ†ه¸ƒه¼ڈهکه‚¨وک¯ن¸€ç§چه…±ن؛«هکه‚¨ï¼ŒTable Workerçڑ„ن»»و„ڈن¸€ن¸ھèٹ‚点都هڈ¯ن»¥è®؟é—®ç›کهڈ¤ن¸çڑ„ن»»و„ڈن¸€ن¸ھو–‡ن»¶م€‚هگŒو—¶ï¼Œè؟™ن¹ںوک¯ن¸€ç§چهکه‚¨ن¸ژè®،ç®—هˆ†ç¦»çڑ„و¶و„م€‚

آ

| وˆ‘وœ‰ه‡ ه¼ éک؟里ن؛‘ه¹¸è؟گهˆ¸هˆ†ن؛«ç»™ن½ ,用هˆ¸è´ن¹°وˆ–者هچ‡ç؛§éک؟里ن؛‘相ه؛”ن؛§ه“پن¼ڑوœ‰ç‰¹وƒ وƒٹه–œه“¦ï¼پوٹٹوƒ³è¦پن¹°çڑ„ن؛§ه“پçڑ„ه¹¸è؟گهˆ¸éƒ½é¢†èµ°هگ§ï¼په؟«ن¸‹و‰‹ï¼Œé©¬ن¸ٹه°±è¦پوٹ¢ه…‰ن؛†م€‚ |

و•°وچ®é«کهڈ¯é

ç›کهڈ¤ن¼ڑن¸“و³¨ن؛ژ解ه†³ه¥½هˆ†ه¸ƒه¼ڈهکه‚¨é¢†هںںçڑ„é—®é¢ک,وœ€هں؛وœ¬çڑ„ه°±وک¯ن؟è¯پو•°وچ®é«کهڈ¯é ,ه¹¶ن¸”وڈگن¾›ه¼؛ن¸€è‡´و€§ن؟è¯پم€‚وˆ‘ن»¬ن½؟用ç›کهڈ¤و—¶é…چç½®ن؛†ن¸‰ن»½و•°وچ®ه‰¯وœ¬ï¼Œن»»و„ڈن¸€ن»½ه‰¯وœ¬ن¸¢ه¤±ن¸چن¼ڑه½±ه“چ读ه†™ه’Œو•°وچ®ه®Œو•´و€§م€‚هœ¨ه†™ه…¥و—¶ï¼Œç›کهڈ¤ن؟è¯پ至ه°‘ن¸¤ن»½ه†™وˆگهٹںهگژè؟”ه›ï¼Œه¹¶هœ¨هگژهڈ°ن؟®ه¤چهڈ¯èƒ½هکهœ¨çڑ„ن¸€ن»½ه‰¯وœ¬ه†™ه…¥ه¤±è´¥çڑ„وƒ…ه†µم€‚读هڈ–و—¶ï¼Œه¤§éƒ¨هˆ†وƒ…ه†µهڈھ需è¦پ读هڈ–ن¸€ن»½ه‰¯وœ¬هچ³هڈ¯م€‚

وœچهٹ،é«کهڈ¯ç”¨

1. è،¨و ¼هکه‚¨çڑ„و•°وچ®و¨،ه‹

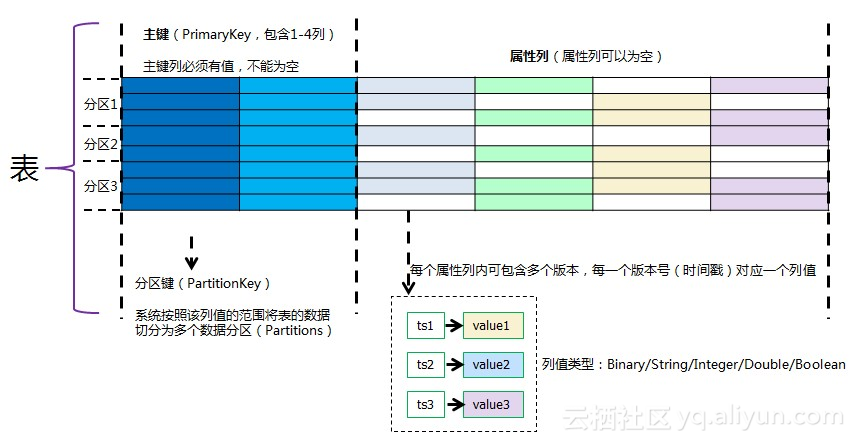

首ه…ˆوˆ‘ن»¬و¥çœ‹ن¸€ن¸‹è،¨و ¼هکه‚¨çڑ„و•°وچ®و¨،ه‹ï¼Œه¦‚ن¸‹ه›¾و‰€ç¤؛ï¼ڑ

è،¨و ¼هکه‚¨ن¸çڑ„ن¸€ه¼ è،¨ç”±ن¸€ç³»هˆ—è،Œç»„وˆگ,و¯ڈè،Œهˆ†ن¸؛ن¸»é”®ه’Œه±و€§هˆ—,ن¸»é”®هڈ¯ن»¥هŒ…هگ«ه¤ڑن¸ھن¸»é”®هˆ—,و¯”ه¦‚用ه¦‚ن¸‹و–¹ه¼ڈè،¨ç¤؛çڑ„ن¸€ن¸ھن¸»é”®ه°±هŒ…هگ«ن¸‰ن¸ھن¸»é”®هˆ—,ن¸‰هˆ—çڑ„ç±»ه‹éƒ½ن¸؛stringï¼ڑ

PrimaryKey(pk1:string, pk2: string, pk3: string)

第ن¸€هˆ—ن¸»é”®هˆ—ن½œن¸؛هˆ†ç‰‡é”®(Partition Key),ن¸ٹé¢çڑ„ن¾‹هگن¸هˆ†ç‰‡é”®ه°±وک¯pk1م€‚è،¨ن¸çڑ„و‰€وœ‰و•°وچ®ن¼ڑوŒ‰ç…§ن¸»é”®(هŒ…هگ«ن¸‰ن¸ھن¸»é”®هˆ—)è؟›è،Œوژ’ه؛ڈ,وŒ‰ç…§هˆ†ç‰‡é”®çڑ„范ه›´è؟›è،Œهˆ†ç‰‡م€‚ه½“ن¸€ن¸ھè،¨çڑ„و•°وچ®وˆ–者è®؟é—®é‡ڈè¶ٹو¥è¶ٹه¤ڑو—¶ï¼Œهˆ†ç‰‡ه°±ن¼ڑè؟›è،Œهˆ†è£‚,هپڑهٹ¨و€پçڑ„ه¼¹و€§و‰©ه±•ï¼Œن¸€ه¼ 较ه¤§و•°وچ®é‡ڈçڑ„è،¨ن¼ڑوœ‰ه‡ 百هˆ°ه‡ هچƒن¸ھهˆ†ç‰‡م€‚

ن¸؛ن»€ن¹ˆè¦پè؟™و ·è®¾è®،ï¼ں简هچ•و¥è¯´ï¼Œن¸€و–¹é¢و‰€وœ‰و•°وچ®وŒ‰ç…§ن¸»é”®وژ’ه؛ڈ,و•´ن¸ھè،¨ه°±هڈ¯ن»¥çœ‹ن½œن¸€ن¸ھه·¨ه¤§çڑ„SortedMap,هڈ¯ن»¥هœ¨ن»»و„ڈن¸»é”®هŒ؛é—´è؟›è،ŒèŒƒه›´وں¥è¯¢ï¼Œهڈ¦ن¸€و–¹é¢ç¬¬ن¸€هˆ—ن¸»é”®هˆ—وک¯هˆ†ç‰‡é”®ï¼Œو‰€وœ‰ç¬¬ن¸€هˆ—ن¸»é”®هˆ—相هگŒçڑ„و•°وچ®éƒ½هœ¨ن¸€ن¸ھهˆ†ç‰‡ن¸ï¼Œن¾؟ن؛ژهپڑهˆ†ç‰‡ه†…çڑ„هٹں能,و¯”ه¦‚è‡ھه¢هˆ—م€پهˆ†ç‰‡ه†…çڑ„ن؛‹هٹ،م€پLocalIndexç‰م€‚

ن¸؛ن»€ن¹ˆهˆ†ç‰‡é”®هڈ¯ن»¥هپڑوˆگsorted key,而ن¸چوک¯hash keyï¼ںè؟™وک¯ه› ن¸؛وˆ‘ن»¬ن½؟用ن؛†ه…±ن؛«هکه‚¨çڑ„能هٹ›ï¼Œه¯¹ن¸€ن¸ھهˆ†ç‰‡è؟›è،Œن¸چو–çڑ„هˆ‡هˆ†و—¶ï¼Œن¸چ需è¦پوگ¬è؟گو•°وچ®ï¼Œè€Œن¸”و•°وچ®وœ¬è؛«ه°±ه·²ç»ڈ被ç›کهڈ¤و‰“و•£ن؛†م€‚هپ‡ه¦‚و²،وœ‰ه…±ن؛«هکه‚¨ï¼Œه°±éœ€è¦پ考虑ه¦‚ن½•ه¤„çگ†و•°وچ®هˆ†ه¸ƒï¼Œو¯”ه¦‚ن½؟用ن¸€è‡´و€§hashç®—و³•ç‰ï¼Œهˆ†ç‰‡é”®ن¸€èˆ¬éƒ½وک¯hash key,ه°±ه¤±هژ»ن؛†ه…¨è،¨ن»»و„ڈن¸»é”®هŒ؛间范ه›´وں¥è¯¢çڑ„能هٹ›م€‚

2. é«کهڈ¯ç”¨ه®çژ°

é‚£ن¹ˆه›هˆ°و£é¢ک,ه¦‚ن½•و¥ه®çژ°وœچهٹ،é«کهڈ¯ç”¨ه‘¢ï¼ںهپ‡ه¦‚ن¸€ه¼ è،¨وœ‰100ن¸ھهˆ†ç‰‡ï¼Œè؟™ن؛›هˆ†ç‰‡ن¼ڑ被ن¸چهگŒçڑ„workerهٹ 载,ه½“ن¸€هڈ°workerوŒ‚وژ‰و—¶ï¼Œن¸ٹé¢çڑ„هˆ†ç‰‡ن¼ڑè‡ھهٹ¨è؟پ移هˆ°ه…¶ن»–هڈ¯ç”¨çڑ„workerن¸ٹم€‚ن¸€و–¹é¢ï¼Œهچ•هڈ°workerو•…éڑœهڈھن¼ڑه½±ه“چن¸€éƒ¨هˆ†هˆ†ç‰‡ï¼Œن¸چن¼ڑه½±ه“چه…¨éƒ¨هˆ†ç‰‡م€‚هڈ¦ن¸€و–¹é¢ï¼Œç”±ن؛ژوˆ‘ن»¬ن½؟用çڑ„وک¯ه…±ن؛«هکه‚¨ç›کهڈ¤ï¼Œن»»و„ڈن¸€هڈ°worker都هڈ¯ن»¥هٹ è½½ن»»و„ڈن¸€ن¸ھهˆ†ç‰‡ï¼Œè®،算资و؛گوک¯ن¸ژهکه‚¨èµ„و؛گهˆ†ç¦»çڑ„,è؟™ه°±هڈ¯ن»¥وٹٹfailoverè؟‡ç¨‹هپڑçڑ„éه¸¸ه؟«ï¼Œو¶و„ن¹ںو›´هٹ 简هچ•م€‚

ن¸ٹé¢è®²çڑ„وک¯و•…éڑœè؟پ移(failover),ه…¶ه®è؟™ç§چو¶و„ن¸‹ن¹ںهڈ¯ن»¥هپڑéه¸¸çپµو´»çڑ„è´ںè½½ه‡è،،(load balance)م€‚ه½“ن¸€ن¸ھهˆ†ç‰‡ن¸ٹçڑ„读ه†™هژ‹هٹ›è؟‡ه¤§و—¶ï¼Œهڈ¯ن»¥è؟…é€ںçڑ„ه°†ن¸€ن¸ھهˆ†ç‰‡هˆ‡هˆ†وˆگن¸¤ن¸ھوˆ–者و›´ه¤ڑن¸ھهˆ†ç‰‡ï¼Œهٹ è½½هˆ°ن¸چهگŒçڑ„Workerن¸ٹم€‚هˆ†ç‰‡هˆ‡هˆ†و—¶ن¸چ需è¦په°†çˆ¶هˆ†ç‰‡çڑ„و•°وچ®è؟پ移هˆ°هگهˆ†ç‰‡ن¸ï¼Œè€Œوک¯هœ¨هگهˆ†ç‰‡ن¸ه»؛立父هˆ†ç‰‡çڑ„و–‡ن»¶çڑ„link,هگژç»ه†چé€ڑè؟‡هگژهڈ°çڑ„compactionو¥ه°†و•°وچ®çœںو£هˆ‡هˆ†ه‡؛و¥ï¼Œو¶ˆé™¤linkم€‚ن¸€ن¸ھهˆ†ç‰‡هˆ‡هˆ†هگژهڈ¯ن»¥ç»§ç»هگ‘ن¸‹هˆ‡هˆ†ï¼Œو‰€وœ‰هˆ†ç‰‡ن¼ڑه‡و‘ٹهˆ°é›†ç¾¤çڑ„ن¸چهگŒWorkerن¸ٹ,ه……هˆ†هˆ©ç”¨é›†ç¾¤çڑ„CPUه’Œç½‘络资و؛گم€‚

3. è؟گç»´م€پهچ‡ç؛§م€پç،¬ن»¶و›´و–°

ن½œن¸؛ن¸€و¬¾ن؛‘وœچهٹ،,وœچهٹ،端çڑ„و—¥ه¸¸è؟گç»´م€پهچ‡ç؛§م€پç،¬ن»¶و›´و–°وچ¢ن»£ه¯¹ن؛ژ用وˆ·è€Œè¨€وک¯ه®Œه…¨é€ڈوکژçڑ„,è؟™ن؛›è؟گç»´و“چن½œن¹ں都ه؟…é،»وŒ‰ç…§é«کهڈ¯ç”¨و ‡ه‡†è؟›è،Œè®¾è®،م€‚هˆ†ه¸ƒه¼ڈç³»ç»ںçڑ„è؟گç»´وک¯ن¸€é،¹éه¸¸ه¤چو‚çڑ„ه·¥ن½œï¼Œهپ‡ه¦‚ن¸چن½؟用ن؛‘وœچهٹ،,è؟گç»´ه°†وک¯ن¸€é،¹ç¹پé‡چ而ن¸”é£ژ险وپé«کçڑ„ن؛‹وƒ…,هڈ¯èƒ½ç»ڈه¸¸ن¼ڑوœ‰هپœوœ؛هچ‡ç؛§ï¼Œè؟ک需è¦په¤„çگ†هگ„ç§چو•…éڑœم€‚هڈ¦ه¤–,وœ؛ه™¨ç،¬ن»¶ن¹ںهœ¨ن¸چو–و›´و–°وچ¢ن»£ï¼Œن؛‘وœچهٹ،ن¸؛ن؛†وڈگن¾›ç»™ç”¨وˆ·و›´ه¥½çڑ„و€§èƒ½ï¼Œن¼ڑن¸چو–و›´و–°و–°çڑ„ç،¬ن»¶ï¼Œه»؛设و›´ه¥½çڑ„网络م€‚وˆ‘ن»¬ç›¸ن؟،,ن½œن¸؛ن¸€و¬¾ن؛‘ن¸ٹçڑ„و•°وچ®ه؛“,هڈ¯ن»¥وڈگن¾›ç»™ç”¨وˆ·و›´ه¥½çڑ„و€§èƒ½ï¼Œو›´é«کçڑ„هڈ¯ç”¨و€§ه’Œو›´ه¥½çڑ„ن½؟用ن½“éھŒم€‚

آ

相ه…³وژ¨èچگ

è،¨و ¼هکه‚¨ï¼ˆTable Store)وک¯éک؟里ن؛‘وژ¨ه‡؛çڑ„ن¸€ç§چو— و¨،ه¼ڈçڑ„هˆ†ه¸ƒه¼ڈو•°وچ®هکه‚¨وœچهٹ،,ه®ƒهں؛ن؛ژه¤§è§„و¨،و•°وچ®ه¤„çگ†وٹ€وœ¯و„ه»؛,ه…·وœ‰é«کهڈ¯ç”¨و€§م€په¼؛ن¸€è‡´و€§ه’Œهڈ¯و‰©ه±•و€§م€‚ن½œن¸؛ن¸€و¬¾NoSQLو•°وچ®ه؛“,Table Storeوڈگن¾›ن؛†ن¸°ه¯Œçڑ„و•°وچ®و¨،ه‹ï¼Œو”¯وŒپوµ·é‡ڈو•°وچ®...

éک؟里ن؛‘è،¨و ¼هکه‚¨ï¼ˆهژںOTS,çژ°ن¸؛Table Store)وک¯ن¸€و¬¾هں؛ن؛ژهˆ†ه¸ƒه¼ڈé”®ه€¼هکه‚¨çڑ„NoSQLو•°وچ®ه؛“وœچهٹ،,ه®ƒوڈگن¾›ن؛†وµ·é‡ڈو•°وچ®çڑ„é«که¹¶هڈ‘م€پن½ژه»¶è؟ںهکه‚¨ه’Œو£€ç´¢èƒ½هٹ›م€‚ن½œن¸؛ن¸€و¬¾ه¼؛ه¤§çڑ„ن؛‘و•°وچ®ه؛“,Table Storeه°¤ه…¶é€‚هگˆه¤§è§„و¨،ن؛’èپ”网ه؛”用م€پ物èپ”网...

Table Storeوک¯ن¸€ç§چه¤§è§„و¨،م€پن½ژوˆگوœ¬م€پé«کهڈ¯ç”¨çڑ„و•°وچ®هکه‚¨وœچهٹ،,ه®ƒو”¯وŒپ结و„هŒ–و•°وچ®çڑ„هکه‚¨ï¼Œه¹¶ن¸؛وµ·é‡ڈو•°وچ®وڈگن¾›ن؛†é«کو•ˆçڑ„وں¥è¯¢ه’Œه¤„çگ†èƒ½هٹ›م€‚è؟™ن½؟ه¾—Table Storeوˆگن¸؛ن؛†ه¤„çگ†ه¤§و•°وچ®هœ؛و™¯ن¸‹çڑ„çگ†وƒ³é€‰و‹©ï¼Œو— è®؛وک¯ç”µه•†ه¹³هڈ°çڑ„ه•†ه“پن؟،وپ¯ç®،çگ†ï¼Œ...

综ن¸ٹ,éک؟里ن؛‘ن¸“وœ‰ن؛‘ن¼پن¸ڑ版V3.8.0çڑ„è،¨و ¼هکه‚¨وٹ€وœ¯وک¯é’ˆه¯¹ه¤§و•°وچ®و—¶ن»£çڑ„ن¸€ç§چه¼؛ه¤§è§£ه†³و–¹و،ˆï¼Œوڈگن¾›ن؛†é«کو€§èƒ½م€پé«کهڈ¯ç”¨ه’Œé«که؛¦هڈ¯و‰©ه±•çڑ„و•°وچ®هکه‚¨وœچهٹ،م€‚ن¼پن¸ڑهڈ¯ن»¥هˆ©ç”¨è؟™ن؛›ç‰¹و€§و„ه»؛é«کو•ˆم€پ稳ه®ڑçڑ„و•°وچ®ه¹³هڈ°ï¼Œن»¥é€‚ه؛”ه؟«é€ںهڈ‘ه±•çڑ„ن¸ڑهٹ،需و±‚م€‚

è،¨و ¼هکه‚¨وک¯éک؟里ن؛‘وڈگن¾›çڑ„ن¸€ç§چهˆ†ه¸ƒه¼ڈNoSQLو•°وچ®ه؛“وœچهٹ،,适用ن؛ژوµ·é‡ڈ结و„هŒ–و•°وچ®çڑ„هکه‚¨ه’Œوں¥è¯¢ï¼Œه…·وœ‰é«که¹¶هڈ‘م€پن½ژه»¶è؟ںم€پ稳ه®ڑهڈ¯é çڑ„特点م€‚ **1. ن؛§ه“پو¦‚è؟°** è،¨و ¼هکه‚¨Table Storeوک¯ن¸€ç§چه¤§è§„و¨،م€پن½ژوˆگوœ¬م€پé«کهڈ¯ç”¨çڑ„هœ¨ç؛؟و•°وچ®هکه‚¨...

è،¨و ¼هکه‚¨çڑ„è،¨ç»“و„çپµو´»ï¼Œو¯ڈè،Œçڑ„هˆ—و•°ه’Œç±»ه‹هڈ¯ن»¥ن¸چهگŒï¼Œو”¯وŒپIntegerم€پBooleanم€پDoubleم€پStringه’ŒBinaryç‰ه¤ڑç§چو•°وچ®ç±»ه‹م€‚ **è®،è´¹و¨،ه¼ڈ** TableStore采用وŒ‰é‡ڈن»کè´¹و¨،ه¼ڈ,و ¹وچ®ç”¨وˆ·é¢„ç•™ه’Œه®é™…ن½؟用çڑ„资و؛گè؟›è،Œè®،费,ه…¥é—¨وˆگوœ¬è¾ƒ...

é«کهڈ¯ç”¨é›†ç¾¤éƒ¨ç½²وک¯وŒ‡ن½؟用ه¤ڑن¸ھوœچهٹ،ه™¨و¥وڈگن¾›وœچهٹ،,ن»¥ç،®ن؟وœچهٹ،çڑ„هڈ¯ç”¨و€§ه’Œهڈ¯é و€§م€‚هœ¨è؟™ن¸ھو–‡و،£ن¸ï¼Œوˆ‘ن»¬ن½؟用ن¸‰هڈ°وœچهٹ،ه™¨و¥éƒ¨ç½² Neo4j é«کهڈ¯ç”¨é›†ç¾¤ï¼Œو¯ڈن¸ھوœچهٹ،ه™¨éƒ½وک¯ن¸€ن¸ھNeo4jèٹ‚点م€‚è؟™ç§چ结و„هڈ¯ن»¥وڈگن¾›é«کهڈ¯ç”¨و€§ه’Œهڈ¯é و€§ï¼Œéپ؟ه…چهچ•ç‚¹...

è،¨و ¼هکه‚¨çڑ„ن¸€ه¤§ن¼کهٹ؟هœ¨ن؛ژه…¶è‡ھهٹ¨ه¤„çگ†ه؛•ه±‚ç،¬ن»¶و•…éڑœه’Œé”™è¯¯ï¼Œوڈگن¾›é«کهڈ¯ç”¨و€§ï¼Œه¹¶ن¸”能و ¹وچ®éœ€و±‚è‡ھهٹ¨و‰©ه±•ï¼Œç”¨وˆ·هڈھ需وŒ‰ن½؟用资و؛گن»ک费,و— 需ه…³و³¨و•°وچ®ه؛“çڑ„ç®،çگ†ه’Œè؟گç»´م€‚و¤ه¤–,و•°وچ®ه…¨éƒ¨هکه‚¨هœ¨SSDن¸ï¼Œه¹¶وœ‰ه¤ڑé‡چه¤‡ن»½ï¼Œç،®ن؟ن؛†ه؟«é€ںè®؟é—®...

éک؟里ن؛‘ن¸“وœ‰ن؛‘ن¼پن¸ڑ版V3.7.1è،¨و ¼هکه‚¨ه¼€هڈ‘وŒ‡هچ—ن¸»è¦پو¶µç›–ن؛†è،¨و ¼هکه‚¨وœچهٹ،çڑ„ن½؟用ه’Œه¼€هڈ‘细èٹ‚,è؟™وک¯éک؟里ن؛‘ن¸؛ن¼پن¸ڑç؛§ç”¨وˆ·وڈگن¾›çڑ„ن¸€ن¸ھé«کهڈ¯ç”¨م€پé«کو€§èƒ½م€په¤§è§„و¨،م€پن½ژوˆگوœ¬çڑ„و•°وچ®هکه‚¨è§£ه†³و–¹و،ˆم€‚ن»¥ن¸‹وک¯ه¯¹è¯¥ه¼€هڈ‘وŒ‡هچ—ه†…ه®¹çڑ„详细解读ï¼ڑ 1....

- **é«کو€§èƒ½**ï¼ڑé€ڑè؟‡هˆ†ه¸ƒه¼ڈو¶و„ه’Œن¼کهŒ–çڑ„هکه‚¨ه¼•و“ژ,ه®çژ°é«کهگهگگé‡ڈه’Œن½ژه»¶è؟ںçڑ„读ه†™و€§èƒ½م€‚ - **é«کهڈ¯ç”¨و€§**ï¼ڑé€ڑè؟‡ه¤ڑه‰¯وœ¬وœ؛هˆ¶ن؟éڑœو•°وچ®çڑ„é«کهڈ¯ç”¨و€§ï¼Œهچ³ن½؟هœ¨éƒ¨هˆ†èٹ‚点و•…éڑœçڑ„وƒ…ه†µن¸‹ï¼Œن¹ں能ن؟è¯پوœچهٹ،çڑ„è؟ç»و€§م€‚ - **وک“用و€§**ï¼ڑ...

هœ¨ن؛§ه“پن¼کهٹ؟部هˆ†ï¼ŒTable Storeن؛§ه“پçڑ„ن¼کهٹ؟被و€»ç»“ن¸؛ه…ن¸ھو–¹é¢ï¼ڑé«کو€§èƒ½م€پé«کهڈ¯ç”¨و€§م€پé«کو‰©ه±•و€§م€پé«که®‰ه…¨و€§م€پن½ژوˆگوœ¬ه’Œçپµو´»و€§م€‚ هœ¨ن½؟用هœ؛و™¯éƒ¨هˆ†ï¼ŒTable Storeن؛§ه“پçڑ„ن½؟用هœ؛و™¯è¢«و€»ç»“ن¸؛ن؛”ن¸ھو–¹é¢ï¼ڑه®و—¶و•°وچ®ه¤„çگ†م€پو•°وچ®هˆ†وگم€پ物èپ”网...

2. é«کهڈ¯ç”¨و€§ï¼ڑTableStoreوڈگن¾›é«کهڈ¯ç”¨و€§ه’Œو•…éڑœه®¹é”™èƒ½هٹ›ï¼Œç،®ن؟و•°وچ®çڑ„ه®‰ه…¨ه’Œهڈ¯é و€§م€‚ 3. هڈ¯و‰©ه±•و€§ï¼ڑTableStoreو”¯وŒپو°´ه¹³و‰©ه±•ï¼Œèƒ½ه¤ںو»،足ن¼پن¸ڑن¸چو–ه¢é•؟çڑ„و•°وچ®هکه‚¨éœ€و±‚م€‚ 4. ه®‰ه…¨و€§ï¼ڑTableStoreوڈگن¾›ه¤ڑه±‚ه®‰ه…¨ن؟وٹ¤وœ؛هˆ¶ï¼Œç،®ن؟...

- **é«کهڈ¯ç”¨و€§**ï¼ڑè،¨و ¼هکه‚¨ه…·ه¤‡99.99%çڑ„وœچهٹ،هڈ¯ç”¨و€§ه’Œو•°وچ®وŒپن¹…و€§ï¼Œç،®ن؟ن¸ڑهٹ،è؟ç»و€§ه’Œو•°وچ®ه®‰ه…¨و€§م€‚ - **é«که¹¶هڈ‘و€§**ï¼ڑé€ڑè؟‡هˆ†ه¸ƒه¼ڈو¶و„,هڈ¯ن»¥ه¤„çگ†ه¤§è§„و¨،ه¹¶هڈ‘请و±‚,و»،足é«کوµپé‡ڈن¸ڑهٹ،需و±‚م€‚ - **ن½ژه»¶è؟ں**ï¼ڑن¼کهŒ–çڑ„هکه‚¨ه’Œو£€ç´¢...

TableStoreçڑ„特点هŒ…و‹¬é«کو€§èƒ½م€پهڈ¯و‰©ه±•م€پé«کهڈ¯ç”¨م€په®‰ه…¨هڈ¯é ç‰م€‚è؟™ن؛›ç‰¹ç‚¹ن½؟TableStore能ه¤ںو»،足ن¼پن¸ڑه¯¹ه¤§è§„و¨،و•°وچ®هکه‚¨ه’Œه¤„çگ†çڑ„需و±‚م€‚ ه…م€پTableStoreçڑ„ه؛”用هœ؛و™¯ TableStoreçڑ„ه؛”用هœ؛و™¯هŒ…و‹¬ه¤§è§„و¨،و•°وچ®هکه‚¨م€په®و—¶و•°وچ®ه¤„çگ†م€پ...

- **é«کهڈ¯ç”¨و€§**ï¼ڑè،¨و ¼هکه‚¨وڈگن¾›ن؛†99.99%çڑ„و•°وچ®وŒپن¹…هŒ–هڈ¯é و€§ï¼Œç،®ن؟ن¸ڑهٹ،è؟ç»و€§ه’Œو•°وچ®ه®‰ه…¨و€§م€‚ - **é«که¹¶هڈ‘**ï¼ڑ能ه¤ںه¤„çگ†و¯ڈ秒و•°ç™¾ن¸‡ç؛§هˆ«çڑ„请و±‚,و»،足é«که¹¶هڈ‘è®؟问需و±‚م€‚ - **ه¼¹و€§و‰©ه±•**ï¼ڑè‡ھهٹ¨و°´ه¹³و‰©ه±•ï¼Œو ¹وچ®ن¸ڑهٹ،需و±‚هٹ¨و€پ...

éک؟里ن؛‘è،¨و ¼هکه‚¨وœچهٹ،وک¯ن¸€و¬¾...综ن¸ٹ,éک؟里ن؛‘è،¨و ¼هکه‚¨وœچهٹ،وک¯é¢هگ‘ه¤§è§„و¨،结و„هŒ–و•°وچ®هœ؛و™¯çڑ„çگ†وƒ³é€‰و‹©ï¼Œه…¶çپµو´»çڑ„و•°وچ®و¨،ه‹م€پé«کهڈ¯ç”¨و€§ه’Œè‡ھهٹ¨هŒ–ç®،çگ†èƒ½هٹ›ï¼Œن½؟ه¾—ه¼€هڈ‘者هڈ¯ن»¥ن¸“و³¨ن؛ژن¸ڑهٹ،逻辑,而ن¸چ用è؟‡ه¤ڑ考虑ه؛•ه±‚هں؛ç،€è®¾و–½çڑ„è؟گç»´é—®é¢کم€‚

م€گè،¨و ¼هکه‚¨TableStoreن؛§ه“پ...综ن¸ٹو‰€è؟°ï¼Œéک؟里ن؛‘ن¸“وœ‰ن؛‘Enterprise版V3.5.0ن¸çڑ„è،¨و ¼هکه‚¨TableStoreوک¯ن¸€و¬¾ه¼؛ه¤§çڑ„و•°وچ®هکه‚¨è§£ه†³و–¹و،ˆï¼Œه®ƒç»“هگˆن؛†é«کهڈ¯ç”¨و€§م€پé«کو€§èƒ½ه’Œçپµو´»و€§ï¼Œو—¨هœ¨ه¸®هٹ©ن¼پن¸ڑè½»و¾ç®،çگ†ه’Œهˆ†وگوµ·é‡ڈو•°وچ®ï¼Œوڈگهچ‡ن¸ڑهٹ،و•ˆçژ‡م€‚

è،¨و ¼هکه‚¨Table Storeوک¯ن¸€ç§چNoSQLو•°وچ®ه؛“,و—¨هœ¨وڈگن¾›é«کو€§èƒ½م€پé«کهڈ¯ç”¨و€§çڑ„و•°وچ®هکه‚¨وœچهٹ،م€‚ه®ƒهڈ¯ن»¥و»،足ه¤§è§„و¨،و•°وچ®هکه‚¨ه’Œé«که¹¶هڈ‘读ه†™çڑ„需و±‚,适用ن؛ژهگ„ç§چه؛”用هœ؛و™¯ï¼Œن¾‹ه¦‚社ن؛¤هھ’ن½“م€پ电ه•†ه¹³هڈ°م€پ物وµپç³»ç»ںç‰م€‚ ه®ن¾‹ن»‹ç»چ وœ¬èٹ‚ه°†ن»‹ç»چ...